von Hans Hofmann-Reinecke

Die deutsche Regierung hat die Erzeugung von „Grünem Wasserstoff“ in Namibia als „strategisches Auslandprojekt“ mit zehn Milliarden Euro bedacht. Als strategischer Kunde für dieses Geschäft hatte einer der großen deutschen Energieversorger, RWE, sein Interesse für jährlich 300.000 Tonnen in Aussicht gestellt. Von diesem Plan hat sich der Konzern jetzt distanziert.

Her damit

Die deutsche Regierung hat in Namibia ein gigantisches Projekt gestartet, das einen wesentlichen Beitrag zur „Energiewende“ leisten soll. Man will dort „Grünen Wasserstoff“ (GH2) herstellen und nach Deutschland exportieren.

Wasserstoff ist der ideale Energieträger: Bei seiner Reaktion mit Sauerstoff wird sehr viel Energie frei – als Hitze oder aber auch direkt in Form von Elektrizität. Und das Allerbeste: Es entsteht kein unerwünschtes CO2, so wie beim Verbrennen von Kohle oder Erdgas in konventionellen Elektrizitätswerken. Das einzige Problem: es gibt keinen Wasserstoff auf unserem Planeten. Seine Affinität zu Sauerstoff hat dazu geführt, dass er fast nur in Form von Di-Wasserstoffoxid, vulgo „Wasser“ vorliegt.

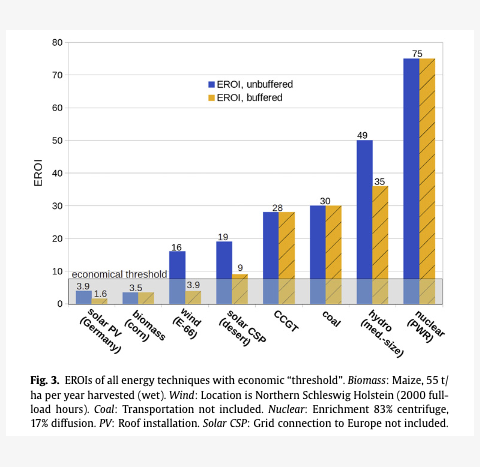

H2 läßt sich jedoch zurückgewinnen, indem man elektrischen Strom durch Wasser leitet und die H2O-Moleküle dabei in ihre Bestandteile spaltet. Dazu ist allerdings mehr elektrische Energie nötig, als man nachher wieder zurückbekommt. Natürlich muss der notwendige Strom bei diesem Prozess, genannt Elektrolyse, aus einem CO2 freien Kraftwerk kommen, sonst könnte man sich die Prozedur ja sparen, sonst bekäme man keinen grünen Wasserstoff.

Eine weite Reise

In Deutschland haben wir keinen Strom dafür übrig, wir müssen ja jetzt schon importieren. So entstand die Idee, in dünn besiedelten, aber windreichen Teilen der Erde, etwa in Namibia, ehemals „Deutsch-Südwestafrika“, Windgeneratoren zu installieren, um mit deren Hilfe H2 herzustellen. Der muss jetzt allerdings nach Deutschland gebracht werden. Transport per Schiff in Gasflaschen wäre zu ineffizient, denn Kompression und Kühlung kosten zu viel Energie. Man macht stattdessen aus dem nützlichen H2 und dem Stickstoff der Luft ein anderes Gas: Ammoniak (NH3). Das läßt sich verflüssigen und kann bei tiefer Temperatur per Tanker transportiert werden.

Am Ziel der Reise angekommen wird der Ammoniak wieder in seine Bestandteile zerlegt, der Wasserstoff wird in so genannten Brennstoffzellen zu Elektrizität verwandelt, die dann in unser Stromnetz eingespeist wird. Das ist eine weite Reise mit diversen Verwandlungen, die alle Energie kosten! Wie viel von dem ursprünglich aus Windkraft erzeugten Strom kommt dann noch bei uns an? Elektrolyse hat 55% Wirkungsgrad, Brennstoffzellen 40%, macht also insgesamt 22%. Die Umwandlung in Ammoniak und zurück haben wir jetzt nicht berücksichtigt, ebenso wenig die Energie für Kompression und Kühlung. Da bleiben vielleicht 15% übrig, wenn überhaupt. Und noch etwas: so richtig „grün“ ist die Sache jetzt nicht mehr, denn ein Tanker verbraucht von Afrika nach Deutschland gut und gerne seine 1.000 Tonnen Schweröl und pustet entsprechend viel CO2 in die Luft.

Kompetenz aus der Uckermark

Das ist keine gute Bilanz, weder technisch noch wirtschaftlich. Aber wenn es um die Rettung der Welt geht, dann darf die Logik nicht im Weg stehen. Am 26. Mai 2023 beauftragte die Regierung Namibias die Firma Hyphen mit der Projektentwicklung. Die Hyphen Hydrogen Energy (Pty) Ltd. ist eine in Namibia registrierte GmbH. Geschäftsführer ist der (weiße) Südafrikaner Marco Raffinetti. Mehrheitlicher Gesellschafter ist die deutsche Enertrag SE, daneben halten die britische Nicholas Holdings Ltd. und die Regierung Namibias Anteile. Enertrag ist im Besitz der beiden Deutschen Jörg Müller und Tilo Troike über deren Muttergesellschaft, die Uckerwerk Energietechnik GmbH in Schenkenberg in der Uckermark. Und wer soll das bezahlen? 2024 hat die Bundesregierung das Projekt von Hyphen im Rahmen ihrer Nationalen Wasserstoffstrategie als „strategisches Auslandsprojekt“ definiert und mit 10 Milliarden Dollar bedacht.

Wind aus dem Sperrgebiet

An der Küste. nahe der Stadt Lüderitz, nicht weit von der Grenze zu Südafrika, liegt das zu Kaiser Wilhelms Zeiten etablierte „Diamanten-Sperrgebiet“. Hier soll unter dem Namen „Tsau Khaeb“ eine Industrie entstehen, die dereinst 300.000 Tonnen H2 pro Jahr zu produziert.

Bei permanentem Betrieb wären das 34 Tonnen pro Stunde. Für eine Tonne H2 sind 48 Megawattstunden (Energie) erforderlich, die Windgeneratoren müssten dann also 34 x 48 = 1632 Megawattstunden pro Stunde = Megawatt liefern. Deutschlands 30.000 Windgeneratoren haben im Jahr 2023 pro Stück eine durchschnittliche Leistung von 0,433 MW erbracht. Für die erforderlichen 1.632 MW bräuchte man 3.769 Anlagen dieses Typs bei „deutschem Wind“. Der mag in Namibia stärker sein, aber mit weniger als 1.000 Generatoren käme man wohl auch hier nicht aus.

Aber außer Strom braucht man auch Wasser für die Elektrolyse. Bei diesem Durchsatz wären das 340.000 Liter pro Stunde; und das in der Wüste; und es muss Süßwasser sein, kein Meerwasser. Man bräuchte auch noch ein mittleres konventionelles Kraftwerk, um die Windgeneratoren anzuwerfen, denn die sind nicht „Schwarzstart-fähig“, sie brauchen erst einmal eine externe Stromquelle, um in Betrieb zu gehen.

Als ich im Juni 2024 in Lüderitz war, gab es, außer ein paar adretten Bürohäuschen noch nichts vom Projekt HYPHEN Tsau Khaeb zu sehen. Nach aktueller Planung soll „Phase 1“ Ende 2026 starten.

Ein Kunde weniger

Wichtiger Pfeiler für die Machbarkeit eines Unternehmens ist die Kundschaft. Im Dezember 2022 hatte Hyphen Hydrogen Energy mit einem der vier großen deutschen Energieversorger, RWE, ein „Memorandum of Understanding“ (MoU) unterzeichnet, nach dem RWE ab 2027 bis zu 300.000 Tonnen grünen Ammoniak pro Jahr von Hyphen abnehmen sollte (zur Einordnung: diese 300.000 Tonnen Ammoniak entsprechen nicht den oben erwähnten 300.000 Tonnen H2). Bestandteil des MoU war auch der Bau eines Terminals für grünen Ammoniak in Brunsbüttel. Ende September 2025 gab RWE nun offiziell bekannt, sich aus dem Projekt zurückzuziehen. Das MoU war ja kein verbindlicher Vertrag, sondern lediglich eine Absichtserklärung.

Als einer der Gründe für den Rückzug wird von RWE der Anspruch indigener Gruppen auf das Projektgelände genannt. Wirklich? Namibia hat eine Fläche von fast einer Million Quadratkilometern und weniger Einwohner als Berlin. Soll also ein kleines Stück Wüste einer Investition im Wege stehen, die fast dem jährlichen BIP des Landes entspricht?

Vielleicht hatte RWE seine Absichtserklärung damals lediglich als Gefälligkeit abgegeben, um das Projekt attraktiver zu machen und Hyphen bei der Finanzierung zu unterstützen. Aus gutem Grund hat RWE keinen verbindlichen Vertrag über die Abnahme von Ammoniak oder Wasserstoff unterzeichnet. Wie wird es weitergehen? Vermutlich fließt die Finanzierung durch Deutschland für das „strategische Auslandsprojekt“ ungestört weiter. Für die Milliarden lassen sich leichter Abnehmer finden als für den grünen Ammoniak.

Dieser Artikel erscheint auch im Blog des Autors Think-Again. Sein Bestseller Grün und Dumm, und andere seiner Bücher, sind bei Amazon erhältlich.