Von Gerhard Grasruck

Die Behauptung eines von Menschen verursachten Klimawandels basiert auf der Hypothese, dass Änderungen der Konzentration von Treibhausgasen in der Erdatmosphäre der dominante Faktor für klimatische Variabilität sind; dabei gilt das Kohlendioxid als entscheidend, dieses soll sozusagen der “Einstellknopf” für das Klima auf der Erde sein (Eigentlich ist das wichtigste Treibhausgas der Wasserdampf, da dieser aber im Gegensatz zum Kohlendioxid nur für kurze Zeit in der Atmosphäre verbleibt, bevor er wieder als Niederschlag ausfällt, wird eine Rolle für ihn als Auslöser für Klimaänderungen ausgeschlossen).[1] Daraus wird gefolgert, dass menschliche Emissionen von Kohlendioxid, welche dessen Konzentration in der Atmosphäre erhöhen, das Klima entscheidend beeinflussen.

Wie lässt sich diese Hypothese auf ihre Korrektheit überprüfen? Prinzipiell gibt es zwei Herangehensweisen: Man kann einerseits von den vermeintlichen Ursachen ausgehend untersuchen, ob der physikalische Mechanismus prinzipiell in der Lage ist, die behaupteten Auswirkungen zu produzieren. Umgekehrt kann man anhand des beobachteten Klimas empirisch überprüfen, ob Änderung der Konzentration von Treibhausgasen tatsächlich zu entsprechenden Klimaänderungen führen.

Fangen wir mit Letzterem an. Wenn die Treibhaus-Klimahypothese tatsächlich korrekt ist, so sollte dies leicht zu erkennen sein – die Temperatur auf der Erde müsste der Konzentration des Kohlendioxids folgen; Auf mehr Kohlendioxid muss eine Temperaturerhöhung folgen, auf weniger eine Temperatursenkung. Zu beachten ist dabei allerdings, dass die Kausalität auch andersherum verlaufen kann. Dass die Temperatur den Gehalt von Treibhausgasen in der Atmosphäre beeinflussen kann, ist leicht einzusehen. Insbesondere ist die Löslichkeit von Gasen in Wasser temperaturabhängig, wird es kälter so ist es in der Lage mehr Kohlendioxid zu lösen, bei Erwärmung wird Kohlendioxid ausgasen. Es ist also, wenn tatsächlich eine Korrelation existieren sollte, wichtig festzustellen. was zuerst kam.

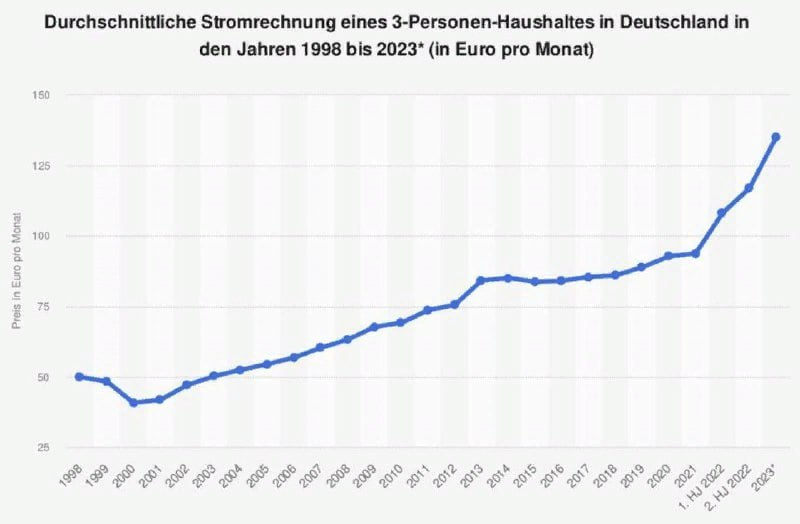

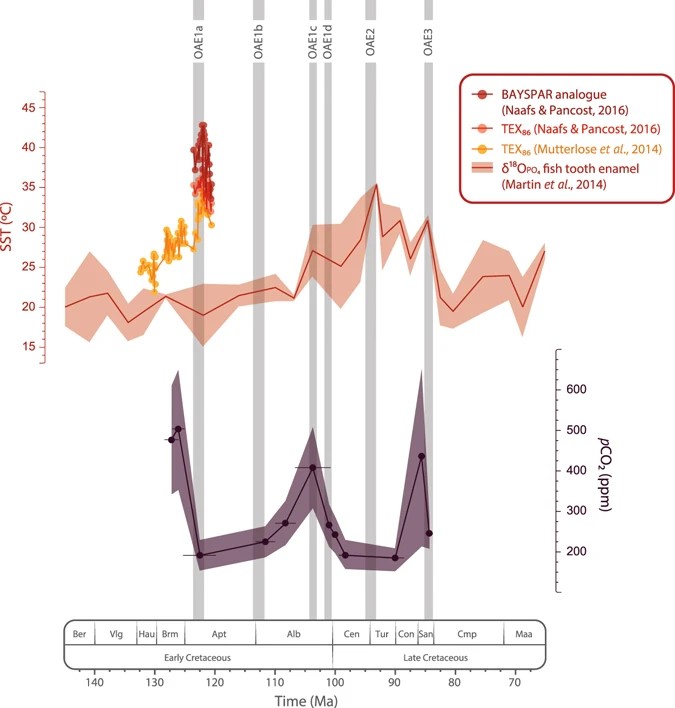

Um schon einmal dem Ergebnis vorzugreifen: Das Ergebnis ist für die Treibhaus-Klimahypothese denkbar ungünstig. Es ist deshalb nicht verwunderlich, dass man gerne viele Millionen Jahre in die fernere Klimavergangenheit schweift, wo über die damals herrschenden Kohlendioxidkonzentrationen extrem große Unsicherheiten herrschen und man so mehr Spielraum hat, es irgendwie passend hinzubiegen. Allerdings heißt dies auch, dass diese auf einem äußerst wackligen Datenfundament stehenden Hypothesen regelmäßig über den Haufen geworfen werden, wenn neuere Forschung die Werte korrigiert. So wird etwa gerne die von tropischen Temperaturen geprägte Kreidezeit, in welcher die Dinosaurier ihre Blüte erlebten, als Paradebeispiel für ein extremes Treibhausklima präsentiert. Neuere Untersuchungen mit verbesserten Methoden jedoch korrigieren die Kohlendioxid-Werte deutlich herunter auf ein Niveau, welches mit der heutigen von etwa 420 ppm (0,048 Prozent) vergleichbar ist, und der Verlauf zeigt im Allgemeinen keine Korrelation mit der Temperatur.[2]

Abbildung 1 Kohlendioxidkonzentration und Temperatur in der Kreidezeit (vor 145-66 Millionen Jahren) ii

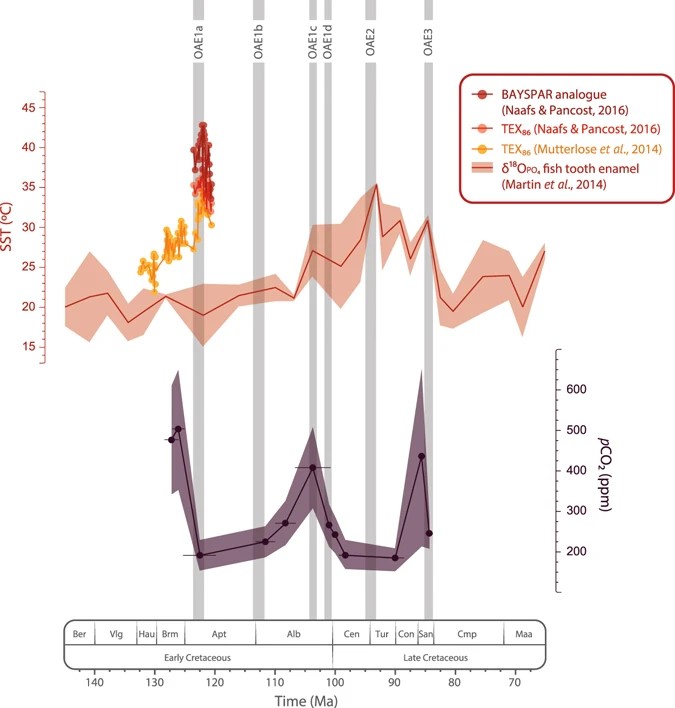

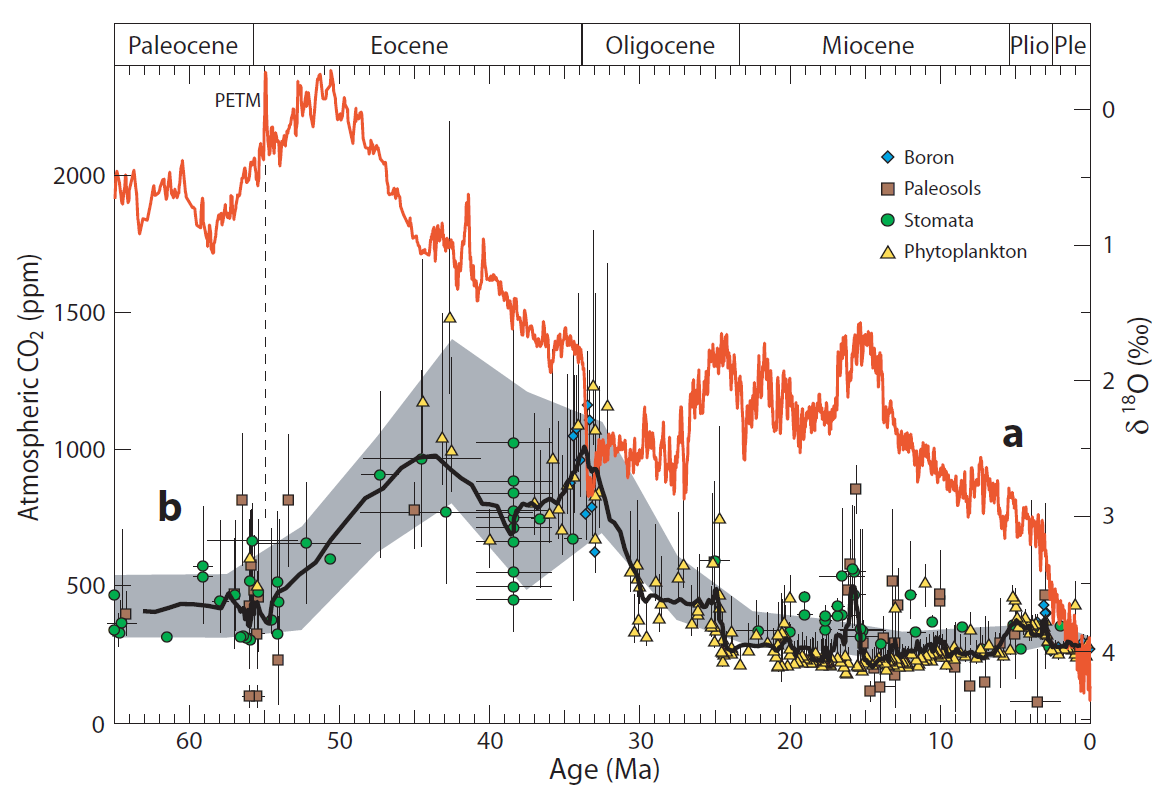

Die Widersprüche werden nicht weniger, wenn man die auf die Kreidezeit folgende Erdneuzeit betrachtet. So gab es von 48 Millionen – 34 Millionen Jahren einen starken Abfall der Durchschnittstemperatur um zunächst 5 Grad Celsius, dann als Abschluss noch einmal 2,5 Grad, als die Antarktis innerhalb von weniger als einer Millionen Jahren komplett vereiste. Die Kohlendioxidkonzentration zeigt keinen erkennbaren Zusammenhang: Sie steigt noch für mehrere Millionen Jahre an, nachdem die Temperatur bereits wieder fällt; sinkt dann etwas, bevor sie wieder ansteigt und fällt erst nachdem die Temperatur ihr Minimum erreicht hat wieder.[3]

Abbildung 2 Kohlendioxidkonzentration und Temperatur in der Erdneuzeit (ab vor 66 Millionen Jahren) iii

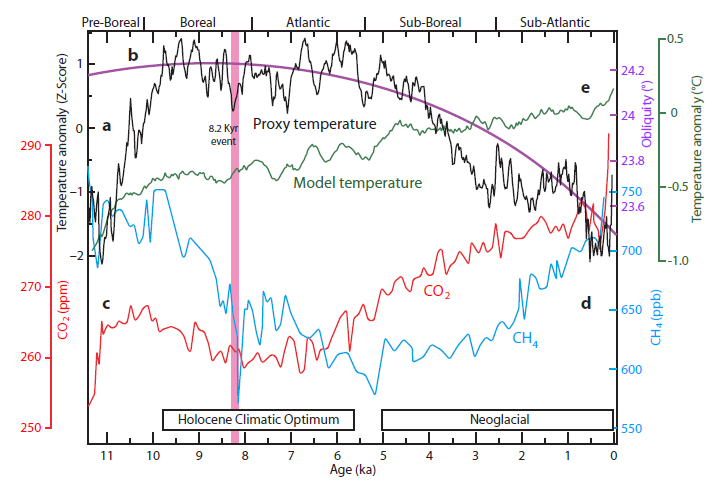

Besonders interessant wird es mit dem Anbruch des Pleistozäns vor 2,6 Millionen Jahren als eigentlichem Beginn des Eiszeitalters, als auch die Arktis vereiste. Dies löste den bis heute andauernden Wechsel von Kaltzeiten in welchen Gletscher in niedrigere Breiten vorstoßen und weite Teile der Erdoberfläche bedecken und Warm- oder Zwischeneiszeiten wie dem Holozän, in dem wir uns gerade befinden, aus. Die Treibhaus-Klimahypothese wurde ursprünglich vorgeschlagen, um genau diese Periode zu erklären. Aber ausgerechnet für die Wechsel von Warm- und Kaltzeiten in dieser Periode war es auch, für welche als erstes eine astronomische Ursache durch periodische Unregelmäßigkeiten in der Erdumlaufbahn aufgezeigt werden konnte. Man kann hier tatsächlich eine Korrelation zwischen Temperatur und Kohlendioxid beobachten – aber genau andersherum: zuerst kommt die Temperaturänderung, dann die Änderung in der Kohlendioxidkonzentration.[4] Auch die Verfechter der Treibhaus-Klimahypothese waren gezwungen, dies anzuerkennen; als Erklärungsversuch zogen sie sich auf die Behauptung zurück, dass die Kaltzeit zwar durch die Temperaturänderung ausgelöst, aber dann durch Kohlendioxid-Rückkopplung wesentlich verstärkt werden würde. Als Evidenz dafür haben sie aber außer ihren Klimamodellen nichts anzubieten.

Abbildung 3 Kohlendioxidkonzentration und Temperatur im Wechsel von Kalt- und Warmzeiten während der letzten 400.000 Jahre

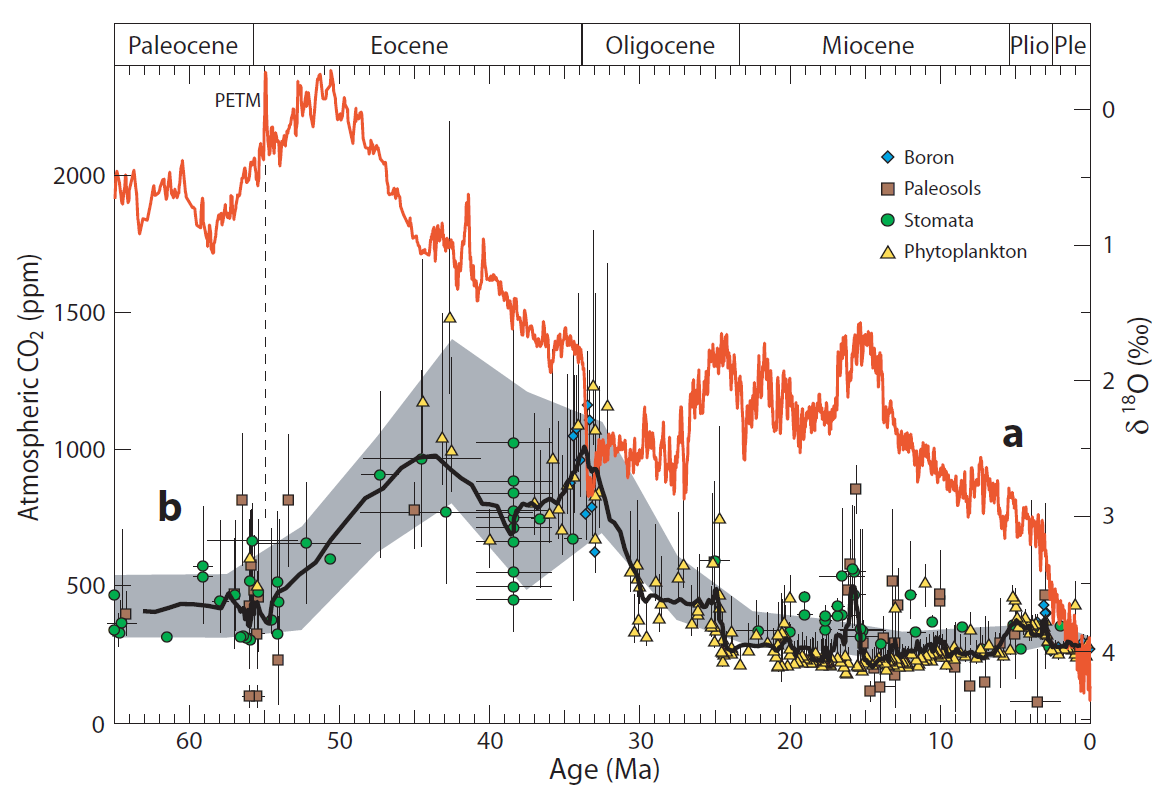

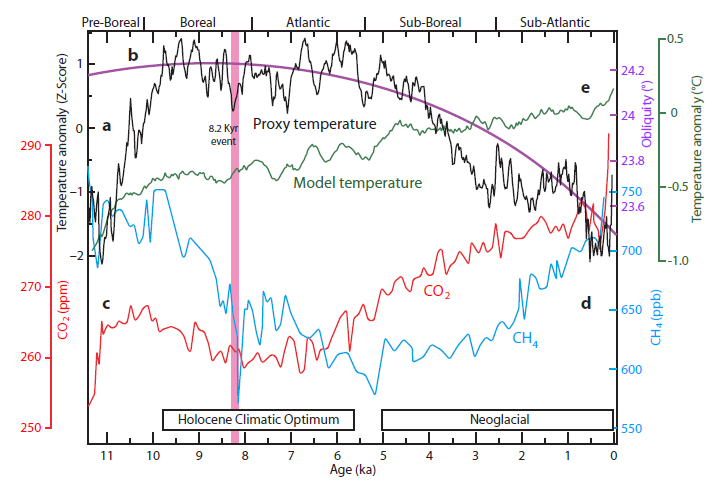

Auch seit dem Beginn des Holozäns, des aktuellen erdgeschichtlichen Zeitabschnitts, mit dem Ende der letzten Kaltzeit vor etwa 11.000 Jahren mangelt es nicht an klimatischer Variabilität; insbesondere lassen sich mehrere ausgeprägte Abkühlungsphasen feststellen, welche sich teilweise einschneidend auf die Entwicklung der Menschheit auswirkten – zuletzt die sogenannte “Kleine Eiszeit” von etwa Anfang des 14. bis Mitte des 19. Jahrhunderts. Gleichzeitig gab es jedoch bis zum Beginn des 20. Jahrhunderts nur geringfügige Änderungen in der Kohlendioxidkonzentration, welche auch noch keine Korrelation mit der Temperaturentwicklung erkennen lassen. Hier ist die Taktik der Verfechter des anthropogenen Klimawandels – insofern sie das ”Holozän-Dilemma”, wie es genannt wird,[5] nicht gleich völlig ignorieren – diese Klimaänderungen, welche vor dem Aufstieg des Klimawandel-Alarmismus allgemein anerkannt waren, aber nun nicht mehr sein dürfen, nach Möglichkeit herunterzuspielen. Ironischerweise werden sie damit selbst zu den „Klimawandel-Leugnern“ als die sie ihre Gegner gerne bezeichnen.

Abbildung4 Kohlendioxidkonzentration und Temperatur im Holozän (ab vor 11.000 Jahren) [6]

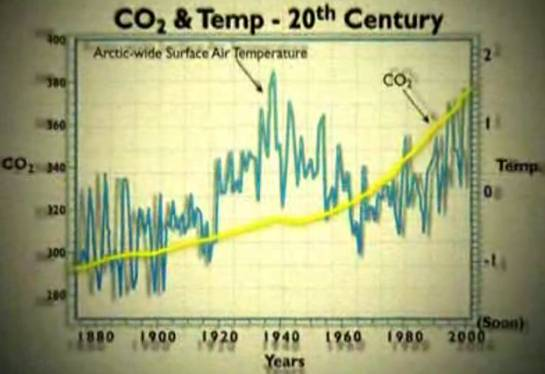

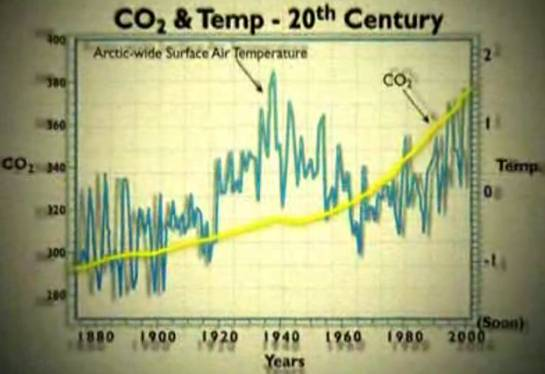

Auch im 20. Jahrhundert, wo sich der vermeintliche menschliche Einfluss auf das Klima doch so deutlich zeigen soll, sieht es keineswegs besser für die Treibhaus-Klimahypothese aus. Zwar stieg in der ersten Hälfte des 20. Jahrhunderts der Kohlendioxidgehalt und – zunächst – auch die Temperatur an, was frühe Anhänger der damals noch durchaus umstrittenen Treibhaus-Klimahypothese wie Guy Stewart Callendar als Beleg für deren Gültigkeit anführten.[7] 1956 proklamierte der kanadische Physiker Gilbert Plass, einer ihrer zu diesem Zeitpunkt wichtigsten Vertreter, selbstbewusst einen “Definitiven Test” für die Ursache von Klimaänderungen: Sei Kohlendioxid für klimatische Variabilität verantwortlich, so werde es eine weitere kontinuierliche Steigerung der Temperatur geben, sei hingegen der Einfluss der Sonnenaktivität ausschlaggebend, so sei für die nächsten paar Jahrzehnte eine Abkühlung zu erwarten.[8] Zweites trat ein – obwohl die Kohlendioxidkonzentration weiter anstieg, ging die Temperatur ab den fünfziger Jahren für etwa drei Jahrzehnte zurück, was in den siebziger Jahren zu apokalyptischen Warnungen vor einer neuen Eiszeit führte.

Abbildung 5 Kohlendioxidkonzentration und Temperatur im 20. Jahrhundert [9]

Bezeichnenderweise gab es bereits hier Versuche, den Klimawandel dem Menschen in die Schuhe zu schieben – für den Temperaturrückgang wurde die abkühlende Wirkung von in industriellen Emissionen enthaltenen Aerosolen verantwortlich gemacht.

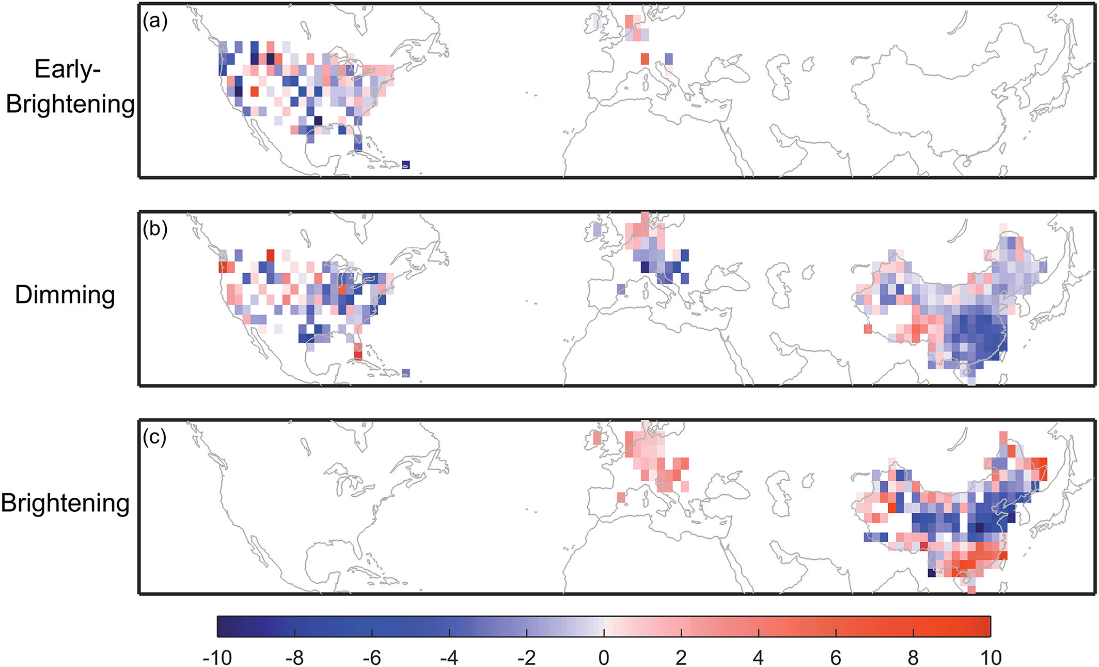

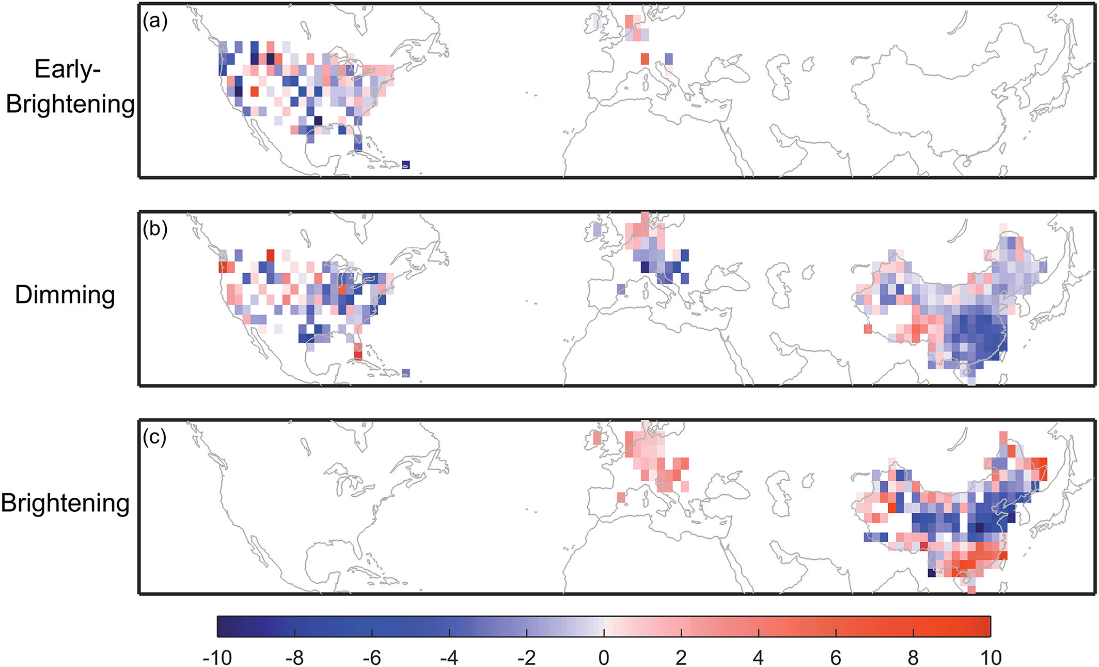

Diese Erklärung wird auch heute noch bemüht – zunächst sei die Wirkung des Kohlendioxids durch den ansteigenden Aerosolausstoß „verdeckt” worden, habe dann jedoch aufgrund von dessen Reduzierung durch bessere Filterung wieder die Oberhand gewonnen. Die Fakten stützen diese Hypothese jedoch keineswegs: Zwar lässt sich im 20. Jahrhundert in vielen Teilen Europas und Nordamerikas eine zunächst absinkende, dann wieder ansteigende Durchlässigkeit der Atmosphäre für die Sonneneinstrahlung feststellen. Jedoch ist diese Entwicklung, wie zu erwarten, nur von regionaler Bedeutung, selbst relativ nahe beieinanderliegende Gebiete können sehr unterschiedliche Trends aufweisen.[10] Zudem passt der Zeitpunkt der Trendumkehr ab Ende der achtziger Jahre hin zu wieder mehr Lichtdurchlässigkeit keineswegs zu der klimatischen Entwicklung, welche bereits Ende der siebziger Jahre wieder in eine Erwärmungsphase überging (Welche bekanntlich von einem entsprechenden Schwenk in der klimaalarmistischen Propaganda von Abkühlung auf Erwärmung begleitet war).

Abbildung 6 Trends der Entwicklung der Lichtdurchlässigkeit der Atmosphäre. Bild a bezieht sich auf den Zeitraum 1923–1950, b auf 1959–1989, 1950–1980 und 1952–1980 jeweils für China, Europa und die USA, c auf 1994–2010 für China und 1980–2009 für Europa. ix

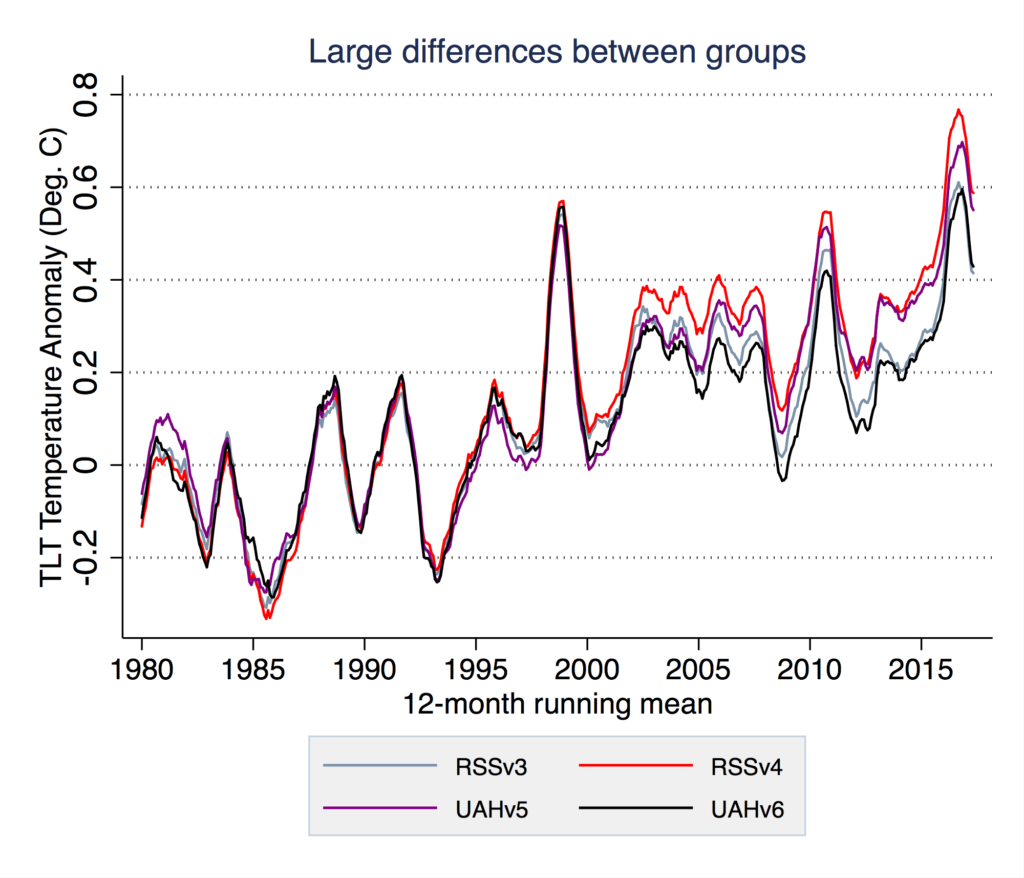

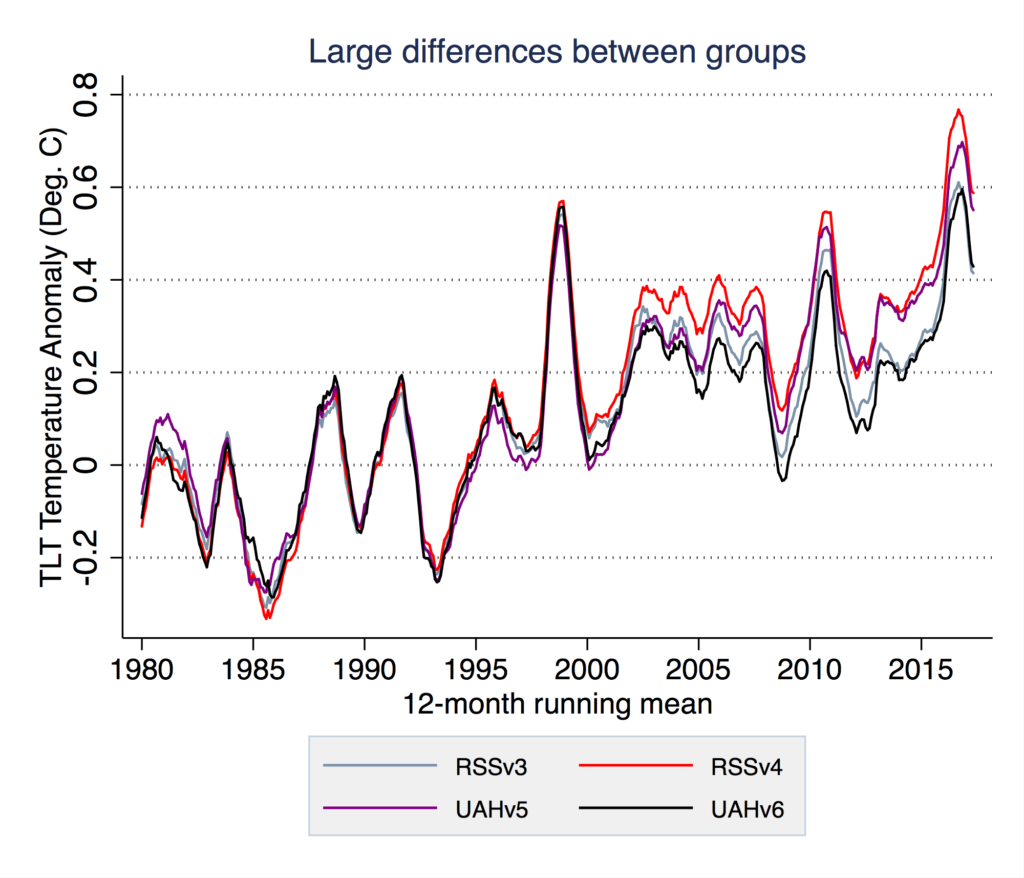

Wie ausgeprägt und wie kontinuierlich diese Erwärmung ist, bleibt unklar. Sie dauerte für die nächsten zwei Jahrzehnte an, danach stagnierte die Temperaturentwicklung; Nachdem diese “Pause” mehr als ein Jahrzehnt angedauert hatte, veränderte eine wissenschaftliche Arbeitsgruppe (RSS) die Kalibrierung der Satellitentemperaturdaten, um so nachträglich doch noch eine Erwärmung zu erzielen. Diese Interpretation wurde dann eilends als neuer, offizieller, Temperaturverlauf erklärt. Inwiefern sie korrekt ist, bleibt zweifelhaft – eine andere Arbeitsgruppe (UAH) korrigierte für denselben Zeitraum ihre Ergebnisse ganz im Gegenteil nach unten.[11]

Abbildung 7 Unterschiede in der Auswertung von Satellitentemperaturdaten der Teams von Remote Sensing Systems (RSS) und der University of Alabama Huntsville (UAH) x

Solche ”Überarbeitungen“ von Temperaturdaten sind auch für Bodenmessungen üblich. So wurden, um nur ein Beispiel zu nennen, von 1999 bis 2015 schrittweise die Temperaturdaten für Nordamerika so modifiziert, dass die Gegenwart anstatt der dreißiger Jahre als wärmste Periode seit dem Beginn des 20. Jahrhunderts erscheint.[12] Man muss bedenken, dass es dabei um Größenordnungen von Zehntel Grad geht – unter diesen Umständen ist es leicht möglich, den Daumen auf die Waage zu legen.

Abbildung 8 Veränderungen in der Interpretation der Temperaturdaten von Wetterstationen für das 20. Jahrhundert xi

Anhänger und Kritiker des Klimawandel-Alarmismus verwenden viel Zeit und Energie darauf, die Zulässigkeit dieser Manipulationen zu diskutieren. Allerdings kann man sich auch auf den Standpunkt stellen, dass das Thema nicht wirklich den zentralen Stellenwert hat, welchem ihm in der öffentlichen Diskussion beigemessen wird. Das Klima verändert sich ständig, es wird also zu jedem beliebigem Zeitpunkt wärmer oder kälter – selbst, wenn tatsächlich eine Erwärmung stattfinden würde, sagt das absolut gar nichts darüber aus, ob Treibhausgase dafür verantwortlich sind.

Entscheidend ist der kausale Zusammenhang. Und wie wir gesehen haben kann, erstens, von einer allgemeinen Korrelation zwischen Klima und Kohlendioxid keine Rede sein, und, zweitens, in den Fällen, wo ein Zusammenhang erkennbar ist, es die Temperaturänderung ist, die vor der Konzentrationsänderung kommt und nicht umgekehrt. Die gesamte Klimageschichte ist folglich nichts anderes als eine einzige vernichtende Widerlegung der Treibhaus-Klimahypothese; Ihre Verfechter müssen sich ständig neue Ad Hoc-Ausreden aus den Fingern saugen, um die Abweichungen von der tatsächlichen Entwicklung zu erklären. Auf sie kann man daher mit Fug und Recht den überstrapazierten Begriff Verschwörungstheoretiker anwenden: “Glaubt uns doch, der Mensch beeinflusst über Treibhausgase das Klima zu unserem Verderben, aber die Natur hat sich verschworen, diesen Zusammenhang zu verschleiern!”

Dies erklärt auch den zentralen Stellenwert, welchen die berühmt-berüchtigten Klimamodelle im Weltbild des anthropogenen Klimawandels einnehmen. Man behauptet, dass man mit ihrer Hilfe in der Lage sei, die Faktoren welche angeblich den Zusammenhang “verdecken” zu isolieren und so doch noch eine vermeintliche Steuerung des Klimas durch Treibhausgase plausibel machen zu können. Tatsächlich jedoch sind Klimamodelle, zumindest solche welche Treibhausgase als bestimmenden Faktor annehmen, völlig unfähig das reale Klima zu reproduzieren; die einzige Möglichkeit, diese auch nur halbwegs mit dem tatsächlich beobachteten Klima in Übereinstimmung zu bringen, ist, sie erst einmal zu ‘Tunen’, wie der Fachbegriff dafür heißt. Bei der “Modellierung” – insbesondere bei der Wolkenbildung – bestehen über die klimatischen Prozesse massive Unsicherheiten, welche nun einfach willkürlich so festgelegt werden, dass am Ende die tatsächlich beobachteten Klimadaten zumindest einigermaßen produziert werden. Es geht dabei wohlgemerkt nur um die Reproduktion von historischem Klima – wir reden noch nicht einmal von Vorhersagen. Ironischerweise werden durch die Klimamodellen daher, insofern man ihnen überhaupt irgendeine Aussagekraft zubilligt, die Treibhaus-Klimahypothese nicht nur nicht bestätigt, sondern, ganz im Gegenteil, widerlegt.[13]

Angesichts der Unfähigkeit der Treibhaus-Klimahypothese vergangenes Klima zu erklären, ist es nicht weiter verwunderlich, dass sie bei Vorhersagen erst recht scheitert. Ein grundlegendes Kriterium, welches eine legitime naturwissenschaftliche Theorie auszeichnet, ist ihre Falsifizierbarkeit. Sie macht klar definierte Vorhersagen, anhand deren Eintreten oder Ausbleiben ihre Korrektheit beurteilt werden kann. Das völlige Versagen der Treibhaus-Klimahypothese bei diesem Test wurde von ihren Adepten implizit zugegeben, als sie die “Klimaerwärmung” zu “Klimawandel” umbenannten; Egal ob heiß oder kalt, Überschwemmungen oder Dürren, alles kann als Klimawandel verkauft werden. Die Frage, mit welcher man jedem Klimawandel-Alarmisten in Verlegenheit bringen kann, ist daher: “Welches klimatische Ereignis würden sie als Widerlegung der Treibhaus-Klimahypothese – und damit eines menschlich verursachten Klimawandels – akzeptieren?”. Auf diese Frage kann es schon deshalb schwerlich eine Antwort geben, weil so ziemlich jede denkbare Widerlegung bereits geschehen ist.

Soweit die empirische Seite der Treibhaus-Klimahypothese. Keineswegs besser sieht es aus, wenn wir sie von der anderen Seite, von den physikalischen Ursachen her, angehen. Eine Verdopplung der Kohlendioxidkonzentration in der Atmosphäre (Bislang hat sich diese seit dem 19. Jahrhundert von 0,028 auf 0,042 Prozent erhöht, also um etwa die Hälfte) würde laut Weltklimarat IPCC zu einer Erhöhung des Strahlungsflusses um etwa 1 Prozent oder 3,7 Watt pro Quadratmeter führen. Die Verfechter der Treibhaus-Klimahypothese behaupten, dass ihre atmosphärischen Strahlungsmodelle korrekt sein müssen, da sie die von Satelliten gemessene Infrarotabstrahlung der Erde in das Weltall korrekt reproduzieren. Kunststück: Diese gemessene Infrarotabstrahlung ist genau der Parameter auf dessen Reproduktion die Modelle als allererstes “getunt” werden – bewiesen ist damit natürlich überhaupt nichts.

Aber, selbst wenn wir den Wert für einen Augenblick akzeptieren, wäre der Effekt minimal – an der Erdoberfläche mit einer Durchschnittstemperatur von 15 Grad Celsius würden dieser Einstrahlungserhöhung gemäß dem Stefan-Boltzmann-Gesetz eine Temperaturerhöhung von 0,7 Grad Celsius entsprechen, bezogen auf die radiative Obergrenze der Atmosphäre (in etwa 5-6 Kilometern Höhe und –18 Grad Celsius) wo die Abstrahlung in den Weltraum erfolgt, wären es 1 Grad Celsius. Die Höhe, in welcher der Energieeintrag vorwiegend stattfindet, verschiebt sich je nach Breitengrad, der globale Durchschnittswert liegt also irgendwo zwischen den 0,7 und 1 Grad Celsius.[14]

Nicht einmal Klimawandel-Alarmisten wagen zu behaupten, dass eine Temperaturerhöhung von weniger als 1 Grad Celsius zu schädlichen Auswirkungen führen würde. Deshalb sind sie gezwungen, in ihren Klima-”Modellen” eine erhebliche Verstärkung (etwa eine Verdreifachung) dieser Erwärmung durch positive Rückkopplungseffekte anzunehmen. In erster Linie sollen diese dadurch zustande kommen, dass die ursprüngliche Erwärmung zur Verdunstung von mehr Wasser führt, was, da Wasserdampf auch ein Treibhausgas ist, zu noch mehr Erwärmung führt und so weiter (Nebenbei bemerkt würde dies, weil der zusätzliche Wasserdampf ja als Niederschlag wieder herunterkommen muss, zu einem feuchteren Klima führen – Überschwemmungen lassen sich damit also vielleicht begründen, Dürrekatastrophen aber keineswegs.) Temperaturänderungen dämpfende negative Rückkopplungseffekte, insbesondere die Tatsache, dass mehr Wasserdampf zu mehr Wolken führt, welche überwiegend kühlend wirken, werden als von untergeordneter Bedeutung abgetan.

Diese hypothetische massive Verstärkung müsste dann aber natürlich nicht nur für Treibhausgase, sondern auch für andere Temperaturänderungen gelten. Aus den Annahmen der Treibhaus-Klimahypothese würde sich ein extrem instabiles Klima ergeben, was ihre Vertreter nicht nur nicht scheu sind zuzugeben, sondern, wie die schrillen Warnungen vor klimatischen “Kipppunkten” zeigen, sogar prominent in ihre alarmistische Propaganda integrieren.

Tatsächlich jedoch schaufeln sie sich damit ihr eigenes argumentatives Grab, denn unter diesen Umständen wird die relative Stabilität des irdischen Klimas schlichtweg unerklärlich. Es würde erfordern, dass der Atmosphäre über Milliarden von Jahren Erdgeschichte hinweg immer genau so viele Treibhausgase hinzugefügt oder entzogen wurden, um das Klima in einem für die Entwicklung von höherem Leben geeigneten Temperaturkorridor zu halten – eine schier unglaubliche Verkettung von Zufällen. Die schlichte Tatsache unserer Existenz ist ein schlagendes Argument gegen ein von destabilisierenden positiven Rückkopplungen geprägtes Klima und damit die Treibhaus-Klimahypothese. Ganz im Gegenteil weist alles darauf hin, dass im klimatischen System negative Rückkopplungen – also Dämpfung – dominieren.[15]

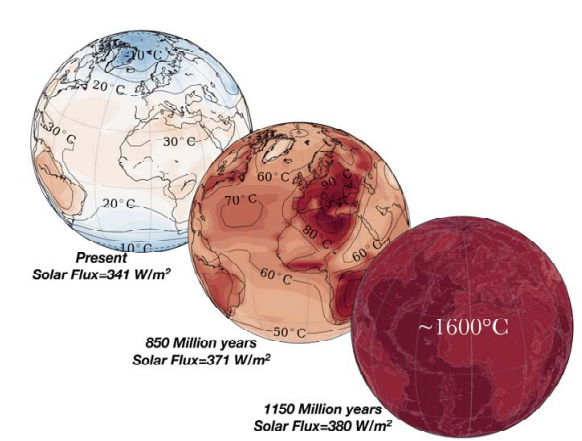

Ein besonders bemerkenswertes Indiz dafür ist das sogenannte “Paradox der frühen schwachen Sonne”: In der Frühzeit der Erdgeschichte war die Sonneneinstrahlung um etwa 30 Prozent schwächer als sie es heute ist. Eigentlich hätte die Erde in Eis gehüllt sein und dies für den längsten Teil ihrer Geschichte auch bleiben müssen. Tatsächlich jedoch war es sogar eher wärmer als heute – eine eindrucksvolle Demonstration der Fähigkeit des klimatischen Systems auch massive Änderungen des Energiehaushalts abzufedern.

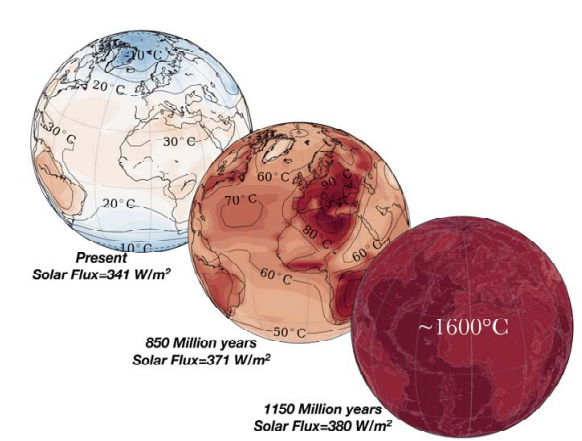

Sehr aufschlussreich ist es, diese Entwicklung in die Zukunft zu extrapolieren – denn hier wird unbekümmert genau das prophezeit, was in der Vergangenheit partout nicht eintreten wollte. Ein Klimamodell prognostiziert beispielsweise, dass die Erhöhung der Sonneneinstrahlung um 8 Prozent in 850 Millionen Jahren zu einer globalen Temperaturerhöhung um 40 Grad Celsius führen würde.[16] Nicht lange danach würde ein ungebremster Treibhaus-Temperatur-Rückkopplungszyklus ausgelöst, welcher innerhalb kurzer Zeit zum Verdampfen der Ozeane führen würde.

Abbildung 9 Temperaturentwicklung der Erde in der Zukunft auf Basis eines 3D-Klimamodells [17]

Die offensichtliche Frage ist: Welchen Grund gibt es anzunehmen, dass genau dieser jetzige Zeitpunkt der Erdgeschichte so magisch ist, dass die 30 Prozent Erhöhung der Sonneneinstrahlung der letzten viereinhalb Milliarden Jahre keinerlei erkennbaren Effekt hatten, aber für die nächsten 10 Prozent massive Temperaturerhöhungen bis hin zum Wegkochen der Ozeane prophezeit werden? Hierüber schweigen sich die Klimamodellierer geflissentlich aus und machen damit ein weiteres Mal klar, dass sie die klimatische Entwicklung auf der Erde trotz aller gegenteiligen Beteuerungen nicht erklären können.

Fazit: Das wichtigste Gegenargument zur Treibhaus-Klimahypothese ist das völlige Fehlen von Argumenten dafür – es gibt schlicht und ergreifend nichts zu widerlegen. Es mag unter Umständen angebracht sein, eine Hypothese, wenn sie einen Teil der beobachteten Fakten gut erklärt, nicht gleich aufzugeben, auch wenn sie augenscheinlich in einem anderen Aspekt nicht funktioniert; Aber im Falle der Treibhaus-Klimahypothese spricht buchstäblich alles dagegen.

Unter diesen Umständen wäre die einzig verbleibende Begründung, die Treibhaus-Klimahypothese nicht endgültig zu verwerfen, dass keine besseren Erklärungsansätze für klimatische Variabilität existieren würden. Das ist aber definitiv nicht der Fall – ganz im Gegenteil hat sich trotz der politisch motivierten Konzentration auf die Treibhaus-Klimahypothese ein Bild der tatsächlich klimabestimmenden Faktoren immer klarer herausgeschält: Für Zeiträume von Jahren bis Jahrzehnte sind vorwiegend interne Oszillationen des irdischen klimatischen Systems wie El Niño Ereignisse sowie gelegentlich bei Vulkanausbrüchen ausgestoßene Aerosole von Bedeutung. Über Jahrhunderte und Jahrtausende sind Zyklen der Sonnenaktivität dominant, während es über Zeiträume von zehn- bis hunderttausenden von Jahren es Veränderungen in der Achsenneigung und -orientierung der Erde und der Exzentrizität ihrer Bahn um die Sonne sind. Bei noch längeren Zeiträumen von Millionen von Jahren machen sich durch die Plattentektonik hervorgerufenen Änderungen in der Geographie der Erde bemerkbar. Für die Treibhaus-Klimahypothese bleibt hier schlichtweg kein Platz mehr.

- Dieser Ausdruck wurde sogar im Titel einer vermeintlich seriösen wissenschaftlichen Arbeit verwendet:Lacis et al. 2010, Atmospheric CO2: Principal control knob governing Earth’s temperature (nasa.gov) ↑

- CO2 and temperature decoupling at the million-year scale during the Cretaceous Greenhouse | Scientific Reports (nature.com) ↑

- Javier Vinós, Climate of the Past, Present and Future. A scientific debate, 2nd ed. Kapitel 9.3.4 Cenozoic climate. ↑

- Petit et al. 1999, Climate and atmospheric history of the past 420,000 years from the Vostok ice core, Antarctica ↑

- Liu et al 2014, The Holocene temperature conundrum, Kaufman, D.S., Broadman, E 2023, Revisiting the Holocene global temperature conundrum ↑

- Javier Vinós, Climate of the Past, Present and Future. A scientific debate, 2nd ed. Kapitel 4 Holocene Climatic Variability ↑

- G. S. Callendar 1938, The artificial production of carbon dioxide and its influence on temperature ↑

- Gilbert Plass 1956, The Carbon Dioxide Theory of Climatic Change ↑

- Confrontación entre las distintas teorías que explican las causas del calentamiento global ↑

- He, Y., Wang, K., Zhou, C., Wild, M. 2018, A Revisit of Global Dimming and Brightening Based on the Sunshine Duration Fig. 4 ↑

- Major correction to satellite data shows 140% faster warming since 1998 (carbonbrief.org) ↑

- If The Data Doesn’t Match The Theory – Change The Data – Climate Change Dispatch ↑

- Kritik an der Treibhaus-Klimawandelhypothese, Teil 1 Durch „Tuning“ zu passenden Modellen | EIKE – Europäisches Institut für Klima & Energie (eike-klima-energie.eu) ↑

- Sejas et al 2021, Understanding the Differences Between TOA and Surface Energy Budget Attributions of Surface Warming ↑

- Willis Eschenbach, Observational and theoretical evidence that cloud feedback decreases global warming ↑

- Leconte et al 2013, Increased insolation threshold for runaway greenhouse processes on Earth-like planets | Nature ↑

- When will the Earth lose its oceans? ↑

Über den Autor: Er ist Softwareentwickler, und immer wieder mit den Irrungen der Klima-Ideologie konfrontiert worden, so auch bei der Entwicklung von Solartechnik und Ladestationen für Elektroautos. Zur Zeit ist er bei einem namhaften deutschen Hersteller von Heizungstechnik beschäftigt; Wärmepumpen sind natürlich ein großes Thema, aber es deutet sich schon an, dass das nicht weniger ein Debakel zu werden droht.