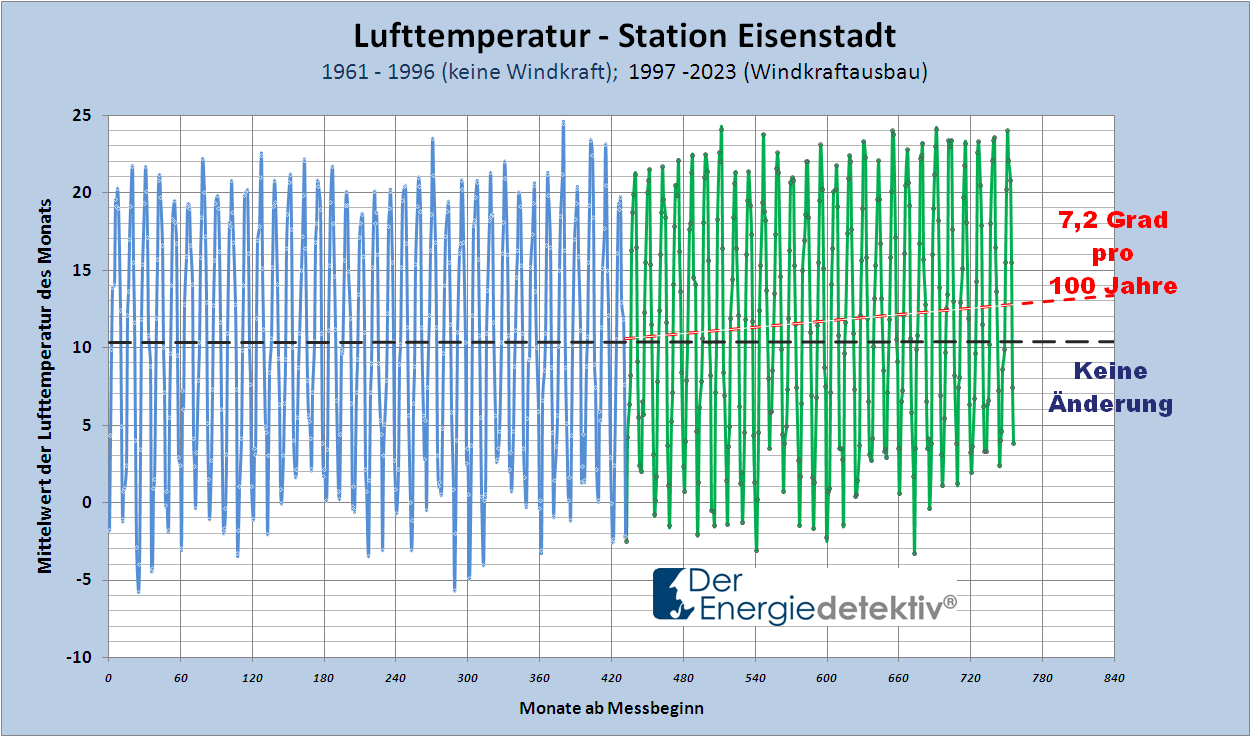

von Dr. Arthur Chudy, dr.arthur.chudy@t-online.de

Vorbemerkung: Man sollte nicht Begriffe wie „Klimaschutz“ als „unbegründete Floskel“ in den Raum stellen oder gar Investitionen mit Steuergeldern planen ohne Grundkenntnisse über die ursächlichen kausalen Zusammenhänge zu haben.

Daher wird in diesem Beitrag die Problematik des „menschengemachten Klimawandels“ und des „Klimaschutzes“ fundamental in Bezug zum Atmosphären-Biosphären-Rezyklierungssystem der Erde betrachtet, um die vorherrschenden gezielt zweckorientierten Irreführungen zu entkräften.

***************************************

Das Atmosphären-Biosphären-Rezyklierungssystem der Erde

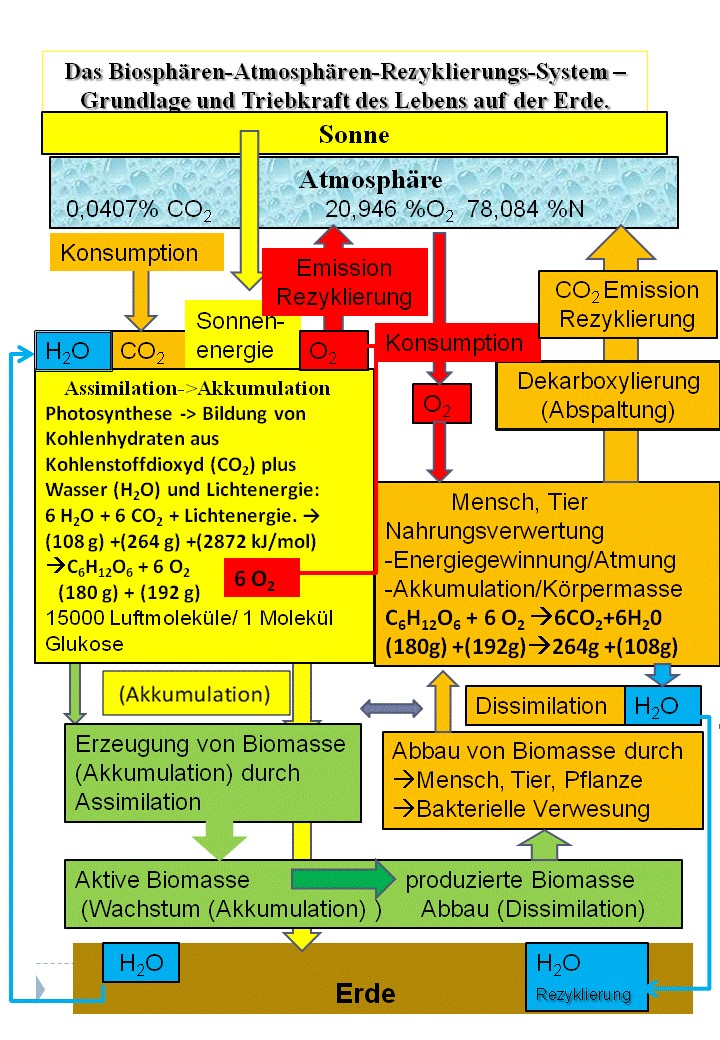

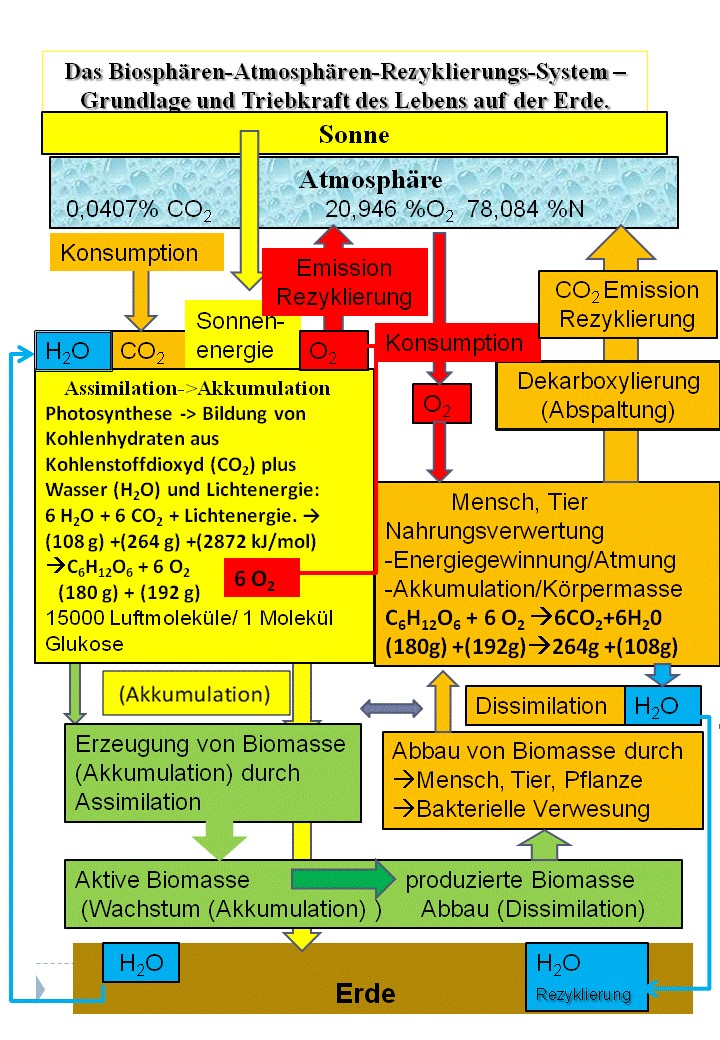

Die Erde ist ein Unikat im Weltall, dies insbesondere durch die Atmosphäre, mehr noch durch das einmalige Atmosphären-Biosphären-Rezyklierungssystem für Sauerstoff, Kohlendioxyd und Wasser, das das Leben auf der Erde ermöglicht und trägt (siehe Abbildung 1). Ein wesentliches Element ist der Kohlendioxydkreislauf (Abbildung 1).

Die einzige wesentliche Energiequelle für die Erde ist die Sonne, die je nach Strahlungsintensität (Warm- und Kaltzeiten) den Wärmehaushalt (Globaltemperatur) der Erde speist.

Die unterschiedlichen auch vom Grad der Neigung der Erdachse beeinflussten Einfallswinkel der Sonnenstrahlung führen zu großen klimatischen Unterschieden in den verschiedenen Erdregionen und werden in den Klimazonen erfasst und definiert.

Die Nutzung der Sonnenenergie erfolgt in zwei Richtungen – der physikalischen im Wärmehaushalt und der biogenen, im Wesentlichen durch die lebenden grünen Pflanzen bei der Assimilation.

Physikalische Nutzung der Sonnenenergie

Bei der physikalischen Nutzung geht es um das Gleichgewicht zwischen Erwärmung der Luft und der Erdoberfläche (Boden und Wasser) sowie der Rückstrahlung von der Erdoberfläche in die Atmosphäre als auch um Strahlung von Molekülen wie Wasser (H2O), Kohlendioxyd (CO2) und Methan (CH4), die Strahlungsenergie aufnehmen und in alle Richtungen, also auch zurück zur Erdoberfläche als Gegenstrahlung abgeben können. Das ist bei CO2 marginal, was sich allein angesichts der geringen Menge von 0,04 % atmosphärischem CO2 ergibt!

Den natürlichen Beweis dafür liefert der „Wüsteneffekt“. Die tagsüber von der Sonne bis über 30° C aufgeheizten Sande kühlen nachts bis zu Minusgraden bei gleichem CO2-Gehalt der Luft wie überall ab. Ursache sind die fehlenden Wassermoleküle in Form von Luftfeuchtigkeit und Wolken! Eine Erfahrung, die auch wir kennen. Bei sternklarem Himmel sinken die Nachtemperaturen wesentlich stärker ab als bei wolkenbehangenem Himmel.

Im Ergebnis finden diese physikalischen Vorgänge dann letztendlich summa summarum standortspezifisch in der Luft-, Boden- und Wassertemperatur ihren Niederschlag.

Abbildung 1: Atmosphären-Biosphären-Rezyklierungssystem Biogene Nutzung der Sonnenenergie

Die biogene Nutzung der Sonnenenergie erfolgt durch die grünen Pflanzen bei der Assimilation, der wichtigsten und einzigen elementaren Stoffproduktion (Biomasse) auf der Erde sowie im Bereich der Organismen (Mensch, Tier etc.) in der Aufrechterhaltung der Körpertemperatur als Voraussetzung für deren Funktionsfähigkeit.

Die Trägerstoffe des Lebens auf der Erde sind Kohlendioxyd (CO2), Sauerstoff (O2), Wasser (H2O) und der nicht-atmosphärische Stickstoff (N).

Bei der Assimilation werden durch grüne Pflanzen atmosphärisches Kohlendioxyd(6 CO2 = 264 g) plus Wasser (6 H2O = 108 g)) mit Hilfe der Sonnenenergie (2872 kJ/mol) zu Kohlenhydrat (Glukose (C6H12O6 = 180g )) als biogener Energieträger (Nährstoff) synthetisiert plus Sauerstoff (6O2= 192 g) in die Atmosphäre freigesetzt (0,727 t O2/t akkumuliertes atmosphärisches CO2), d.h. in der Menge rezykliert, die bei der Dissimilation (Abbau) zuvor verbraucht wurde bzw. später verbraucht wird. Dadurch wird der Sauerstoffgehalt der Atmosphäre aufrecht erhalten/reproduziert. Ohne diese Rezyklierung des Sauerstoffs würde das Leben auf der Erde „ersticken“.

Die produzierte Biomasse ist Vorleistung und wird in der Folge in der Dissimilation unter Verbrauch von atmosphärischem Sauerstoff auf zwei Wegen mit gleichem Endresultat, zur Gewinnung an biogener Energie in Organismen (Mensch, Tier etc.) oder bakteriell durch Verwesung, abgebaut. Unter Ausschluss/Fehlen von Sauerstoff erfolgt eine anaerobe Vergärung (Pansen der Wiederkäuer, intakte und „renaturierte“ Moore), wobei der naszierende zellgiftige Wasserstoff an Kohlenstoff zu Methan (CH4) gebunden und in die Atmosphäre als Schadstoff „entsorgt“ wird.

Dissimilation der Kohlenhydrate: (C6H12O6 = 180 g) plus Sauerstoff (Atmung) (6 O2 = 192 g) werden zur biogenen Energiegewinnung umgesetzt zu Kohlendioxyd (6 CO2 = 264 g) plus Wasser (6 H2O = 108 g). Das Kohlendioxyd entsteht nicht durch Oxydation von Kohlenstoff mit Sauerstoff, sondern wird im enzymatischen Prozess ohne Energiegewinn abgespalten (Dekarboxylierung) und in die Atmosphäre abgeführt, d. h. rezykliert als atmosphärisches CO2 als Träger- und Rohstoff für eine erneute Akkumulation in der Assimilation, d.h. für erneute Biomasseproduktion. Die biogene Energiegewinnung erfolgt ausschließlich durch die Oxydation von Wasserstoff und Sauerstoff zu Wasser. Damit wird das zur Stoffproduktion (Kohlenhydraten) verbrauchte Wasser rezykliert und an die Umwelt (Boden und Atmosphäre) abgeführt.

Damit erweisen sich im Atmosphären-Biosphären-Rezyklierungssysem Kohlendioxyd und Wasser als unzerstörbare und unendlich nutzbare (wiederverwendbare) Oxyde und Sauerstoff als unendlich nutzbares Element, d.h. als Trägerstoffe des Lebens (Lebenselixiere) ohne natürliche Verbrauchsverluste.

Es ist ein in sich geschlossenes Atmosphären-Biosphären- System mit voller Rezyklierung der Verbauchselemente.

Eine Steigerung des Umfangs und der Intensität dieser Kreislaufsysteme ist nur durch eine Veränderungen der Biomasseproduktion (Kalt- und Warmzeiten, Züchtung und Anbau ertragsreicher Kulturen) und im Sinne der Steigerung auch durch externe Zuführung von CO2 , wie aus der Verbrennung fossiler Energieträger, prinzipiell möglich und erstrebenswert.

Hieraus folgt, dass der atmosphärische CO2-Gehalt Ausdruck des Gleichgewichtes zwischen CO2Emission und CO2-Akkumulation (Assimilation) ist und damit die Intensität des CO2-Kreislaufs, die Höhe der Biomasseproduktion, reflektiert. Eine hohe Biomasseproduktion ist nur bei hoher CO2 Konzentration in der Atmosphäre möglich. Das ergibt sich daraus, dass die Aufnahme von Luft durch die Blattspalten der begrenzende Faktor ist. Bei 400 ppm CO2-Gehalt der Luft müssen die grünen Pflanzen 15.000 Liftmoleküle aufnehmen, um 6 Moleküle CO2 für die Synthese von einem Molekül Glukose heraus zu filtrieren. Hohe CO2-Gehalte erhöhen somit die Effizienz der Assimilation, führen zur Erhöhung der Grünmasseproduktion, der Erträge in der Land- und Forstwirtschaft.

Die Günmasseproduktion Ist direkt an den CO2-Gehalt der Atmosphäre gebunden, da grüne Pflanzen bei ca. 180 ppm CO2-Konzentration die Assimilation einstellen, was das Ende des Lebens auf der Erde bedeuten würde, d.h. dass das Leben auf der Erde auf der Differenz zwischen atmosphärischem CO2-Gehalt und 180 ppm, derzeit auf 235 ppm (415 – 180 = 235), beruht. Aus dieser Sucht betrachtet ist die Dekarbonisierung durch die damit angestrebte Reduzierung des CO2- Gehaltes der Atmosphäre und der daraus folgenden Reduzierung der Biomasseproduktion für die Weltwirtschaft und für die Nahrungsgüterproduktion zur menschenwürdigen Ernährung der wachsenden Weltbevölkerung kontraproduktiv.

Da der CO2-Kreislauf in der Atmosphäre nur in Richtung von Emission zur Akkumulation abläuft, ist die CO2-Emission der Impulsgeber, der Sende-Faktor, während die Assimilation/Akkumulation der Empfänger, der empfangende (passiv abhängige) Faktor ist, wird, egal woher das CO2 kommt, ob aus natürlichen Umsetzungen (Dissimilation) oder aus Verbrennung fossiler Energieträger, die CO2 Emission zum entscheidenden das Leben auf der Erde erhaltenden und mehrenden Faktor, zum wichtigsten Lebenselixier. Ohne CO2-Emissionen würde das Leben auf der Erde versiegen. Diese Rezyklierungsprozesse können im Hinblick auf die Höhe der Biomasseproduktion weitestgehend unbegrenzt hochgefahren werden, was z.B. durch Standortadaption, Agrartechnologie und Züchtung standortspezifischer ertragsreicher Kulturpflanzen „menschengemacht“ gelingt bzw. gelungen ist (Beispiel Getreideproduktion 1850 ca. 30 dt/ha und 20XX > 100 dt/ha) und natürlich für die Sicherung der Ernährung einer wachsenden Weltbevölkerung von außerordentlicher Wichtigkeit ist.

Folgerungen für den „menschengemachten“ Klimawandel?

Welche Folgerungen ergeben sich aus diesem Grundwissen für den „menschengemachten“ Klimawandel?

Die wichtigsten Fakten als Ausgangsbasis sind:

- Das unter den bekannten Planeten unikate Merkmal der Erde ist das Vorhandensein der Atmosphäre mit einem hohen Gehalt an Sauerstoff (O2) und einem vergleichsweise niedrigem Gehalt an Kohlendioxyd (CO2). Die Entstehung des Lebens auf der Erde beruht ursprünglich auf der Fähigkeit von Bakterien zum stofflichen Energiegewinn (Nährstoffe) Sauerstoff (O2) aus Wasser (H2O) und Kohlendioxyd (CO2) freizusetzen und in die Atmosphäre zu emittieren. Damit waren die wesentlichen Grundstoffe zur biologischen Evolution, die Entwicklung des Lebens (nach Darwin), und der Entwicklung der Artenvielfalt einschließlich des Menschen, in christlichem Sinne der „Schöpfung“ , gegeben.

2.Die Erde bezieht die Energie in Form von Strahlungen (Licht und Wärme) fast ausschließlich von der Sonne mit variabler Intensität, bedingt durch Sonnenzyklen und den interschiedlichen Einfallswinkeln zur Erdoberfläche und mit unterschiedlichen tektonischen Strukturen und Oberflächenmateriealien mit Differenzen in der Reflektion und Absorption (Wärmeaufnahmekapazität), was zu differenzierten standortspezifischen klimatischen Werten (Messdaten wie Temperatur, Luftfeuchtigkeit, Windstärke und –richtung usw. ) führt . Diese Daten kennzeichnen als Rückschau im 30-jährigen Mittel definitionsgemäß das Klima, gebietsweise differenziert, untergliedert in Klimazonen, Gebiete, Länder, Landschaften, Standorte.

3. Die Atmosphäre hat durch Ihre Fähigkeit Wasser in verschiedenen Aggregatzuständen (gasförmig Luftfeuchtigkeit, kondensiert als Wolken und Regen und Eiskristallen) im Zusammenwirken mit der Sonneneinstrahlung und Wolkenbildung, dem Aufbau verschiedener Druckverhältnisse (Hoch und Tief), der Luftbewegung (Wind, Sturm) und mit dem durch Stofftransfers gegebenen Aufbau elektrischer Ladungen (Blitz und Donner) ihre eigenen Gesetzmäßigkeiten, die in verschiedenen Gebieten und an den jeweiligen Standorten im täglichen Wettergeschehen ihren Niederschlag finden. Diese führen zu zeitlichen Wetterkonstellationen, die sich positiv für den Menschen und die Landschaft/Gebiet oder sich in Unwettern (Hurrikans) auswirken. So hat eine zufällige Wetterkonstellation wie im Ahrtal, wo sich wie vor ca. 100 Jahren eine von zwei angrenzenden Hochs eingekeilte Gewitterzelle feststehend über dem Talkessel total abregnete und schließlich zu der großen Katastrophe in den schutzlosen Ortschaften führte, nichts mit Klimawandel, noch einer Klimakatastrophe und erst recht schon gar nichts mit der CO2-Konzentration der Atmosphäre etwas zu tun.

4. Von grundlegender Bedeutung ist der durch physikalische Faktoren determinierte Wärmehaushalt der Erde durch die Schutz- und Dämpfungsfunktion der Atmosphäre für die Temperaturen des Bodens und der Luft im Bereich der Erdoberfläche. Das ist zugleich eine der Voraussetzungen für die Ermöglichung von Leben auf der Erde, weil physiologische Vorgänge an einen Temperaturbereich von +3 bis 40 °C (Flüssigphase des Wassers) gebunden sind. Dabei spielt die Reflektion der Wärmestrahlung von der durch die Sonneneinstrahlung erwärmten Erdoberfläche die entscheidende Rolle und nicht die von bestimmten Luft-Molekülen wie Wasser, Kohlendioxyd und Methan (Sensitivität) bewirkte „Gegenstrahlung“, d.h. die Reflektion der von der Erdoberfläche reflektierten Wärmestrahlung zurück zur Erde. Diese werden fälschlicherweise als Treibhausgase bezeichnet, weil die Atmosphäre im Gegensatz zu einem Treibhaus nach oben zum Weltraum offen ist und diese Moleküle fungieren nicht wie auf die Erde gerichtete „Hohlspiegel“, sondern geben die Wärmestrahlung in alle Richtungen von warm nach kalt ab. Dementsprechend kühlen die CO2– Moleküle die Atmosphäre in oberen Schichten ab.

Der Gegenstrahlungseffekt von den Spurengasen CO2 und CH4 ist im Gegensatz zum Wasser (Luftfeuchtigkeit, Wolken) aus zwei Gründen gering und zu vernachlässigen: Erstens allein aus quantitativen Gründen 0,04 % – 400 ppm = nur 400 CO2 –Moleküle in 1 Million Luftmolekülen (!) und zweitens wegen des bereits erreichten Sättigungseffekts, bedingt durch den logarithmischen Verlauf der Sensitivität in Abhängigkeit von der CO2 –Konzentration. Das verdeutlicht anschaulich der oben erwähnte „Wüsteneffekt“.

Fazit: Es gibt keine nennenswerte CO2-bedingte Erderwärmung und diese ist in den Wärmehaushalt der Atmosphäre/Erdoberfläche, d.h. in die Aufrechterhaltung einer erträglichen Temperatur des Lebensraumes von Flora und Fauna wie des Menschen positiv wirksam integriert.

Der anthropogene („menschengemachte“) Einfluss auf das Klima – Wirkung der Dekarbonisierung

Das Fazit, CO2 ist ohne Einfluss auf das Klima, gilt erst recht für die anthropogene Einspeisung von CO2 durch Verbrennung fossiler Energieträger zur Energiegewinnung, die, bezogen auf die Erdatmosphäre, weltweit nur im Bereich von jährlich 20 bis 25 ppm liegt. Dem Wesen nach handelt es sich hierbei um eine Rückführung von ursprünglich aus atmosphärischem CO2 stammendem, über Grünmasse akkumuliertem und vorwiegend über Inkohlung reduziertem (amorphem) und eingelagertem Kohlenstoff in den Atmosphären-Biosphären-Kohlenstoffkreislauf, d.h. um einen völlig natürlichen Prozess.

Die Dekarbonisierung ist bedeutungslos für den Wärmehaushalt der Atmosphäre, d. h. ob die Einspeisung von jährlich ca. 22 ppm nutzbringend für die Menschheit erfolgt oder durch Dekarbonisierung der Weltwirtschaft zum Schaden der Menschheit verhindert wird, hat so gut wie keinen Einfluss auf das sonnendeterminierte Weltklima, weder lokal noch global!.

Wer das Gegenteil behauptet, wie der IPCC und dessen Gefolgsleute, wie das Potsdam Institut für Klimafolgeforschung mit u.a. Edenhofer, für den sowieso Klimapolitik nicht der Rettung des Klimas sondern als Mittel zur Vermögensumverteilung dient, müssten beweisen,

- ob und wie 22 ppm weltweiter CO2- Emissionen fossiler Herkunft von 415 ppm CO2- Konzentration der Atmosphäre das sonnendeterminierte Erdklima/Wetter wesentlich – und das nur zum wunschgerecht Guten – beeinflussen können?

2. für Deutschland – welches Klima kann dann wie vom derzeitigen Anteil Deutschlands mit 0,46 ppm., d.h. mit 1 fossilen CO2-Molekül in 2,2 Millionen Luftmolekülen, durch zerstörerische Dekarbonisierung der deutschen Wirtschaft, durch Bestrafung der Bevölkerung mit Verboten von Öl/Gasheizungen und Verbrenner-Motoren, Tempolimit auf Autobahnen sowie durch Vernichtung eigener Wertschöpfungspotentiale und Energiequellen (AKW, Kohleausstieg) verändert werden?

Der Leiter des Klimarates der Bundesregierung, Prof. Henning, ist auf ein persönliches Anschreiben die Antwort auf diese Fragen schuldig geblieben.

Diese Beweise und Rechtfertigungen wird es und kann es nie objektiv-real geben!

Fundamentale Bedeutung des CO2-Gehaltes der Atmosphäre für die Biosphäre

Der für das Klima unbedeutende, für Umfang und Intensität der Biomasseproduktion aber sehr bedeutende CO2-Gehalt der Atmosphäre ist Ergebnis des sich unter dem Druck der CO2-Emission eingestellten Gleichgewichts zwischen CO2- Emission und CO2-Akkumulation, biogen durch Assimilation der Biosphäre und physikalisch durch Absorption/Resorption von Wasserflächen(Ozeane).

Die Erhöhung des CO2-Gehaltes kann in größerem Maßstabe nur durch eine erhöhte Sonnenaktivität/Sonneneinstrahlung, wie sie durch dementsprechende Warmzeiten gegeben ist und wie wir sie von 1850 an zu verzeichnen haben und erleben durften, erfolgen. Sie hat gegenwärtig ihr Höhen-Plateau erreicht und geht mit hoher Wahrscheinlichkeit in den nächsten 35 -40 Jahren in eine kleine Eiszeit über, wie es von den Forschern, die sich mit Sonnenzyklen und Sonnenflecken beschäftigen, glaubhaft prognostiziert wird.

Dieser Prozess läuft zeitlich und quantitativ wie folgt ab: Die höhere Wärme-/Lichteinstrahlung der Sonne als im wesentlichen einzige Wärmequelle führt zu höheren Temperaturen von Erdboden und erdbodennaher Atmosphäre und bei ausreichender Feuchtigkeit (Wasser) und anderen Wachstumsfaktoren zu höherer Biomasseproduktion, die im Folgejahr durch den Abbau derselben zu höherer CO2-Emission und zu höherer pflanzlicher Stoffproduktion durch höhere Effizienz der Assimilation führt. So steigt in Folge der Kohlenstoff (CO2)-Kreislauf an und durch einen gewissen CO2-Emissionsstau der CO2-Gehalt der Atmosphäre kontinuierlich – wie in der Mauna Loa –Messung sichtbar- an. Oder umgekehrt, führt die verringerte Sonneneinstrahlung bei Eiszeiten zu geringerer Biomasseproduktion/Erträgen in der Landwirtschaft (Hungersnöten!)/Forstwirtschaft und in der Folge zu erniedrigter CO2-Emission und niedrigerem CO2-Gehalt der Atmosphäre sowie reduzierter Effizienz der Assimilation.

Schlussfolgernd daraus ergibt sich, dass die Interpretation der Mann´schen Hockeyschlägerkurve, womit eine Abhängigkeit der Globaltemperatur vom CO2-Gehalt der Atmosphäre bewiesen werden sollte, wissentlich (oder unwissentlich) falsch ist. Es wurde schlichtweg bei der Interpretation der Mann´schen Hockeyschläger-Kurve die Ursache, die zeitlich vorausgehende Erderwärmung durch die

Sonne, mit der Wirkung, der höheren Biomasseproduktion und dem daraus resultierenden höheren CO2-Gehalt der Atmosphäre, vertauscht und dadurch fälschlich eine scheinbare Abhängigkeit der Globaltemperatur vom atmosphärischen CO2-Gehalt postuliert und unterstellt. Der CO2-Gehalt der Atmosphäre kann aber sachlogisch im Atmosphären-BiosphärenRezyklierungssystem nur die Folge und nicht die Ursache der Erderwärmung sein. Schlussfolgernd ergibt sich daraus:

Dekarbonisierung der Wirtschaft – kontraproduktiv, gegen die Interessen der Menschheit gerichtet. Das Konzept des IPCC, „menschengemachten“ Klimaschutz durch Dekarbonisierung der Wirtschaft als Klimaschutzmaßnahme zu erreichen, wie auch einen „menschengemachten“ Klimawandel als Folge der Nutzung fossiler Energieträger zu postulieren, ist wissenschaftlich unbegründet, d.h. ein Narrativ ist, das lediglich auf dem sektiererischen „Glaubensbekenntnis (einer Klimareligion) – CO2 ist klimaschädlich“ – basiert!

Dieses Narrativ vom „Menschengemachten Klimawandel“ wurde mit der Pariser Klimavereinbarung materialisiert (100 Milliarden-Klimafond) und dabei die Irreführung der Staatengemeinschaft derart auf die Spitze getrieben, dass weder für vorindustriell noch für das 2050-1,5°-2° C-Ziel eine absolute Globaltemperatur an- bzw. vorgegeben wurde, d.h. man verpflichtet die Staatengemeinschaft zu falschen wirtschaftschädigenden drastischen „Klimaschutzmaßnahmen“ für ein Inkognito-1,5 ° C bzw. 2 °C-Ziel, das jedwede Interpretation offen lässt.

CO2 , das im Atmosphären-Biosphären-Rezyklierungssystem keinen nennenswerten Einfluss auf das Klima (Erderwärmung) hat und haben kann, dient hierbei lediglich als ein willkommener Parameter, als ein Mittel zum Zweck (Zuchtrute für die irregeführten Massen), um den Industriestaaten, die fossile Energieträger als Energiebasis verwenden, parametrisiert Umweltschäden anzulasten und ein darauf basierendes weltweites Abzocke-System (CO2 Steuer, Klimafond) für die Industriestaaten zu etablieren (COP 28). Diese dahinterstehende Absicht nicht zu erkennen, sich ihr zu beugen, bezeugt, wie sagenhaft naiv oder gezielt beabsichtig die Klima-Politik der Selbstzerstörung der westlichen Welt derzeit ist?

Selbstkasteiung des Westens – Triumpf Chinas

Mit der Klimapolitik der Dekarbonisierung der Wirtschaft, der krampfhaften Reduzierung/Vermeidung von CO2-Emissionen nach dem Prinzip „koste was es wolle“, und insgessamt mit der Energiewende einseitig zu „erneuerbarer“ Energie (wetterabhängiger Wind- und Sonnenenergiegewinnung) betreibt der Westen eine unbegründete und auf das Klima total wirkungslose Selbstkasteiung ungeheuren Ausmaßes.

Unter der Fahne des „Klimaschutzes“ nehmen krampfhafte und kosten- und materialaufwendige CO2-Vermeidungsmaßnahmen schildbürgerlich-kuriose Formen der reinen Selbstbefriedigung an, wie z. B. die Abscheidung und unterirdische Verklappung von CO2 aus Verbrennungsprozessen als „Klimaschutzmaßnahme“. Das ist gewissermaßen sachlich die Spitze wirtschaftlichen Unsinns, kann aber andererseits durch die Dummheit von „Klimaschützern“ zur Erreichung einer illusionären „Klimaneutralität“ ein einträgliches Geschäft sein (Norwegen). Objektiv ist es eine wirkungs- und nutzlose Verschwendung von Kapital und Material, sowohl aus quantitativer und sachlicher Sicht die Inkarnation „menschengemachten“ Blödsinns.

Diese realitäts- und wissenschaftsferne Politik führt zum selbstverschuldeten Verlust von politischem Einfluss und ökonomischer Glaubwürdigkeit, letztendlich zum Untergang der westlichen Welt und damit der Forcierung des unaufhaltsamen Aufstiegs Chinas im Verbund mit Russland zur führenden Welt-, Wirtschafts- und Militärmacht. Denn im Gegensatz zum Westen baut China auf allen Gebieten die wohlstandsfördernde und investitionsvoraussetzende Energieerzeugung, ob fossil mit Kohle, Gas und Erdöl, oder mit Atomkraft oder soweit wie möglich und sinnvoll mit „erneuerbaren“ Energiequellen (Wind und Fotovoltaik) ungebremst von COP 28 aus. Sie wissen, dass unabhängige Verfügbarkeit von Energie Macht bedeutet!

Die wissenschaftliche Realität ist eine andere:

Im unikaten fantastischen Atmosphären-Biosphären-Rezyklierungssystem ist gerade die CO2- Emission die unverzichtbare eigentliche treibende Kraft (Triebkraft), egal woher sie kommt, ob biogen oder fossil, für die Erhaltung und Mehrung des Lebens auf der Erde. Es gibt folglich weder einen „menschengemachten Klimawandel“ durch Nutzung fossiler Energiequellen noch einen „menschengemachten Klimaschutz“ durch widersinnige kontraproduktive Dekarbonisierung der Wirtschaft. Somit gibt es auch keine „Klimaneutralität“, sondern nur eine kontraproduktive „CO2Emissions-Neutralität“ mit verheerenden Folgen für die Wirtschaft und den Wohlstand der Industriestaaten!

Sinnmachende Investitionen in witterungsunabhängige Energieversorgung (fossile und atomare) und Schutz vor klimatischen Auswirkungen

Sinn machen demgegenüber Investitionen in den vielfach vernachlässigten „Schutz vor und Anpassung an Auswirkungen des Klimas und vor möglichen unerwünschten Wetterkonstellationen“! Alle krampfhaften Maßnahmen zur Reduzierung bzw. Vermeidung von CO2-Emissionen – wie die teure und materiell kaum abzusichernde „grüne Wasserstoffwirtschaft“ , in überzogene Windkraft- und Fotovoltaikanlagen sind Fehlinvestitionen.

Als Zukunftsinvestitionen gelten Investitionen in

- eine angemessene und sinnvolle Nutzung der Möglichkeiten zur Erzeugung „erneuerbarer“ Energie

(Wind, Sonne, Wasserkraft und Biogas), in Sekundärposition vorrangig aber Investitionen in sichere witterungsunabhängige Energiegewinnung, d.h. in

- in die Nutzung eigener Energiequellen (Braunkohlenabbau, Fracking-Gasgewinnung)

- den Bau moderner (dezentralisierter) Kernspaltungs-, Kernfusions- und Atommüllverwertungs-AKW

(einschließlich der Verlängerung der Nutzung vorhandener AKW),

- moderne Gas-, Erdöl- und Kohlekraftwerke, Verbrennungsmotoren und Heizungsanlagen für

Fernwärme und Wärmekopplung mit Energieerzeugung sowie

- in die Erhöhung der Energieeffizienz und last not least

- in den Schutz vor Klimaauswirkungen/gefährlichen Wetterkonstellationen!

Das Klima kann nicht „menschengemacht“ geschützt werden. Das Klima sollte man der Sonne – wie seit Millionen von Jahren – überlassen.