Deutschlands Autoindustrie: Mord auf offener Straße? – Ein perfides Spiel mit Klimaangst und fiktiven Abgas-„Todesopfern“ (1)

Wer wissen will, wie perfide das Spiel ist, das unsere Politiker derzeit mit dem Recht des Bürgers auf individuelle Mobilität spielen, dem sei empfohlen, in der Mediathek des ZDF die um 19.00 Uhr ausgesandte „Heute“-Nachrichtensendung des ZDF vom 9.8.2017 anzusehen. Unter „Strategien gegen Luftverschmutzung“ wird das Beispiel Düsseldorfs vorgestellt, wo die Stadt die „grüne Welle“ mancherorts unterbricht. Damit sollen, so der Kommentar, die Autofahrer gezwungen werden, abzubremsen und neu anzufahren, obwohl das mehr Schadstoffe bedeutet. Dies sei „Verkehrserziehung in Richtung Zukunft“.

Mit überlegenem Lächeln erläutert anschließend Thomas Geisel, SPD-Oberbürgermeister der Stadt Düsseldorf, seine Motive zu dieser bewussten Erhöhung der Luftbelastung in seiner Stadt wie folgt: „Das mag jetzt unter Schadstoffgesichtspunkten an der einen individuellen Stelle nachteilig sein, aber insgesamt geht es natürlich darum, die Menschen zu motivieren, die Bahn zu benutzen eher als das Auto…“

Das wurde so nonchalant dahergesagt, dass man sich der Ungeheuerlichkeit dieser Aussagen im ersten Moment gar nicht bewusst wird. Hier erklärt ein Oberbürgermeister einer Landeshauptstadt, dessen Stadt von der DUH („Deutsche Umwelthilfe“, manchmal auch als Toyotas ’Ndrangheta bezeichnet) wegen zu hoher Abgaswerte verklagt wird, dass er bewusst Maßnahmen ergreift, welche diese Belastung noch ansteigen lassen. Dabei halten Spitzenvertreter seiner Partei zudem Schauermärchen über „zehntausend Tote durch Autoabgase jedes Jahr in Deutschland“ für glaubwürdig und fordern mit dieser Begründung Fahrverbote. Wenn ein SPD-Politiker zugleich willentlich eine Steigerung dieser Abgasbelastung herbeiführt, kann man vermuten, dass er hier bewusst Leben und Gesundheit von Bürgern gefährdet. Für Juristen dürfte die Frage von Interesse sein, ob hier die Staatsanwaltschaft aufgrund eines begründeten Anfangsverdachts von sich aus tätig werden müsste oder ob Bürger der Stadt Düsseldorf selbst Klage erheben sollten. Es scheint berechtigt, hier von einem Bubenstück der besonderen Art zu sprechen.

Interessanterweise gibt es auch aus Stuttgart Hinweise darauf, dass die grün geführte Stadtverwaltung dort zu ähnlichen „Tricks“ greift. In einem Kommentar zu einem Bericht im „Spiegel Online“ ist zu lesen, dass an einer besonders kritischen Messstelle (Am Neckartor) die Straße Richtung Fellbach von zwei auf eine Spur verengt wurde, um einen Fahrradstreifen anzulegen, so dass sich dort die Pendler aufstauen. Zudem gibt es dort jetzt eine Abzweigung zu einem neuen Einkaufszentrum, dessen Parkhaus jeden Samstag komplett voll ist. Und last but not least gibt es direkt neben dem Neckartor eine riesige Baustelle, bei der regelmäßig schwere Nutzfahrzeuge hin- und herfahren.

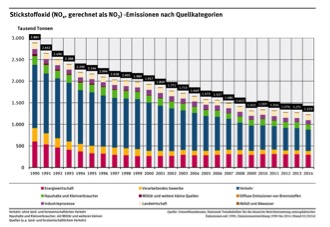

Die NOx-Emissionen des Straßenverkehrs in Deutschland sind seit 1990 sowohl absolut (von 1,46 auf 0,491 Mio. t) als auch prozentual (von 50,7 auf nur noch 40,1 %) zurückgegangen (Grafik: Umweltbundesamt)

Meister der Doppelzüngigkeit

Mit seiner Haltung steht der SPD-OB Geisel selbstverständlich nicht alleine da, sondern befindet sich, wie man so schön sagt, im Mainstream. Auch seine Art des „Nudging“, also des hinterhältigen Manipulierens, hat größere Vorbilder. Es gibt in Deutschland Politiker, die ihre Schulung in einer Zeit und einer Republik erhalten haben, in der Grenzwachen „Republikflüchtlingen“ in dem gutem Glauben in den Rücken geschossen haben, die Obrigkeit habe dies befohlen. Hinterher hieß es, dass ein solcher Schießbefehl niemals existiert haben soll. Eine solche Fähigkeit, Menschen zu manipulieren und sie zu Handlungen zu veranlassen, zu denen sie sich bei klarer Kenntnis der Sachlage vermutlich nicht bereitgefunden hätten, war schon eine Meisterleistung. Politiker, die diese Kunst in verantwortlicher Position des Regimes verinnerlicht haben, sind es gewohnt, ihre wahren Absichten zu verstecken und wenn möglich andere vorzuschieben, damit diese die Drecksarbeit machen. Wer sich in diesem Dschungel zurechtfinden will, muss lernen, dem gesprochenen oder geschriebenen Wort nicht blind zu vertrauen, zwischen den Zeilen zu lesen und vor allem die Fakten zu beachten.

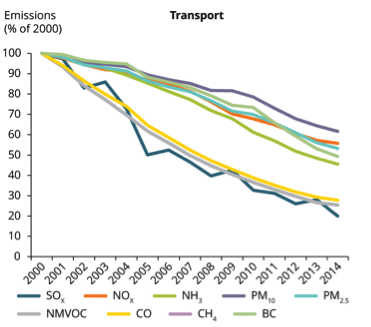

Der Rückgang der transportbedingten Schadstoffemissionen ist auch europaweit zu beobachten (Grafik: [THAL])

Das eigentliche Ziel heißt „Dekarbonisierung“

Die politische Elite, die Deutschland im Moment führt, hat sich voll und ganz dem Ziel der „Dekarbonisierung“ unserer Volkswirtschaft verschrieben. Dies ist eine der wesentlichsten Triebkräfte des Handelns insbesondere der Mehrheitsparteien, ein Ziel, an dem sie seit mindestens einem Jahrzehnt geduldig und mit allen ihr verfügbaren Mitteln und Methoden arbeiten. Autos, deren Verbrennungsmotoren fossiles CO2 ausstoßen, haben in diesem Weltbild keinen Platz. Entsprechende Aussagen tätigten maßgebliche PolitikerInnen bereits 2009: „Während die Autobranche mit der 63. IAA mühsam versucht aus der Krise zu fahren, fordert Bundeskanzlerin Merkel nichts geringeres als die Neuerfindung des Automobils“ und verlangte „von den deutschen Herstellern einen Entwicklungsschub hin zu umweltfreundlicheren Motoren“. Es gelte, „das Auto fast wieder neu zu erfinden, nämlich völlig neue Antriebstechnologien zu entwickeln“ [SUED]. Bereits damals gab es Planungen, bis 2020 mindestens eine Million Elektromobile auf deutsche Straßen zu bringen, die von höchster Stelle als „ehrgeizig, aber notwendig“ bezeichnet wurden. Da die Kfz-Hersteller sich jedoch halsstarrig zeigten, wurden im Rahmen einer Langfristplanung geeignete „erzieherische Maßnahmen“ auf den Weg gebracht. Die faulen Ausreden der unwilligen Automanager, dass es keine ausreichende Nachfrage nach E-Fahrzeugen gebe und der Markt von ihnen andere Fahrzeuge verlange, durften schließlich nicht ungestraft bleiben. Die Umsetzung der gewünschten „Erziehungsmaßnahmen“ erforderte jedoch die Ausarbeitung einer ausgeklügelten und langfristig angelegten Strategie.

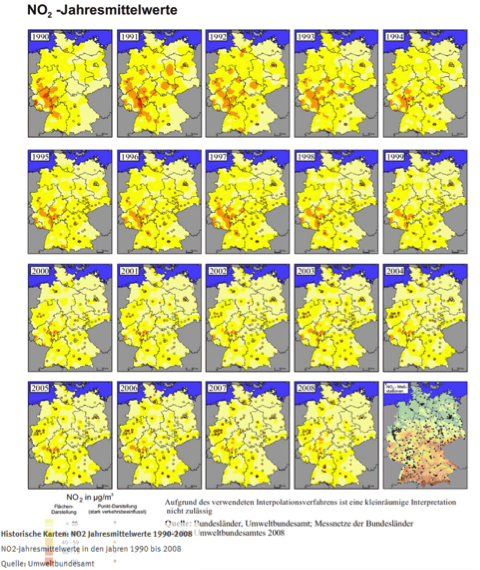

Die historischen Karten der NO2-Jahresmittelwerte in Deutschland belegen den ständigen Rückgang der NO2-Gehalte in der Luft (Grafik: Umweltbundesamt)

Grünlinke Traumwelten

Zum Leidwesen solcher „verantwortungsbewusster“ Politiker ist es im heutigen Deutschland jedoch schwieriger, die Bevölkerung zum „richtigen“ Konsumverhalten zu motivieren, als noch vor einigen Jahrzehnten im östlichen Deutschland. Dort konnte es solche Flausen der Untertanen erst gar nicht geben, weil es nur ein einziges Automodell gab, und selbst das konnte man nicht mal so eben kaufen. Aber die Politikerkaste ist flexibel und wächst mit ihren Aufgaben. Zunächst galt es, sich die Deutungshoheit zu sichern. Der Bevölkerung musste klargemacht werden, dass ganz Deutschland eine Art Naturparadies zu sein hat. Dabei wird einfach ausgeklammert, dass Zivilisation nicht nur Vorteile wie warme Wohnungen, Kleidung und Nahrung sowie Antibiotika und moderne Medizin ermöglicht, sondern unabdingbar auch gewisse Belastungen mit sich bringt. Dazu gehört die Beanspruchung durch körperliche Arbeit ebenso wie Beeinträchtigungen der Gesundheit durch Gift- und Reizstoffe sowie Schäden an Natur und Umwelt. Früher gab es in den westlichen Gesellschaften einen gewissen Grundkonsens darüber, dass man hier Kompromisse einzugehen hatte. Es galt, die zivilisatorisch gewünschten Vorteile nicht zu gefährden, dabei jedoch die zu akzeptierenden Nachteile auf ein vertretbares Minimum einzugrenzen. Heute geht dieser Konsens jedoch immer weiter verloren, insbesondere bei den großstädtischen Eliten. Hier tummeln sich alle möglichen grünen und linken Ideologien, welche dem Glauben anhängen, man habe ein Anrecht darauf, die Vorteile einer technologisch fortgeschrittenen Industriegesellschaft uneingeschränkt zu genießen, ohne dafür irgendwelche Kompromisse eingehen zu müssen. Diese moderne urbane Spaßgesellschaft wünscht sich eine Fahrradrepublik mit bedingungslosen Grundeinkommen und einer Umwelt wie in einem hochalpinen Luftkurort, ergänzt um eine schrankenlose Willkommenskultur für Wirtschaftsflüchtlinge aus jedem „failed state“ dieser Welt. Diese Ideologien werden von einem Großteil der Medien mit großer Verve unterstützt. Hierdurch erhalten sie einen überproportional großen Einfluss auf die öffentliche Meinung und damit auf die Politik.

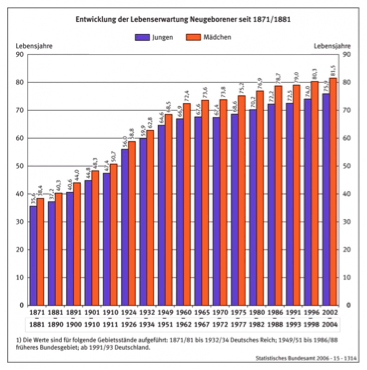

Die Lebenserwartung der deutschen Bevölkerung ist mit der Weiterentwicklung unserer technischen Zivilisation ständig gestiegen (Grafik: Statistisches Bundesamt)

Die beste Luft seit 100 Jahren

Die deutsche Bevölkerung atmet heute die beste Luft seit mindestens 100 Jahren. Früher gab es in den Häusern offene Kamine und Herde, geheizt wurde überwiegend mit Holz, dessen schädlicher Rauch karzinogene Substanzen in der Raumluft verteilte. Auch Kerzen sowie Petroleumlampen sind massive Quellen schädlicher Luftschadstoffe, denen die Bevölkerung tagein, tagaus ausgeliefert war. In den Städten und Industriegebieten gab es keinerlei Abgasbehandlung. Noch in den 60er Jahren kam es im Ruhrgebiet zu Todesfällen durch Smog, einer giftigen Mischung aus unbehandelten Abgasen (Ruß, Staub, SO2) und Nebel. Mit der Einführung entsprechender Gesetze und der Installation von Abgasbehandlungsanlagen hat sich die Qualität der Luft seither ständig und in erheblichem Umfang verbessert, wie sich anhand langjähriger Vergleiche des Umweltbundesamts unschwer dokumentieren lässt. Waran liegt es also, dass man derzeit von fast allen Parteien und aus allen Medien den Eindruck erhält, die Luft in unseren Städten werde durch gierige und rücksichtslose Automanager so verpestet, dass jährlich abertausende Menschen an den Folgen sterben. Es sei deshalb unausweichlich, dass man um der Volksgesundheit willen so schnell wie möglich ein Verbot von Verbrennermotoren anstreben müsse? Wobei der Diesel zwar derzeit die meisten Prügel abbekommt, der Benziner jedoch ebenfalls bereits zum Tode verurteilt wurde.

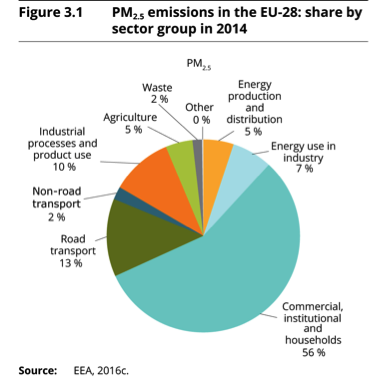

Auf europäischer Ebene ist der Straßentransport nur mit 13 % an der Emission des besonders kleinteiligen Feinstaubs PM2.5 beteiligt (Grafik: [THAL])

Verleumdungen statt Tatsachen

Wenn man sich die Vorwürfe gegen den Diesel, der im Moment als Sündenbock herhalten muss, einmal genauer ansieht, so stellt man fest, dass diesem Dinge unterstellt werden, die gar nicht den Tatsachen entsprechen. So wird in den Medien häufig suggeriert, dass Diesel-PKW Hauptquelle sowohl von Feinstaub als auch von Stickoxiden (NOx) seien und ihre Abgase Krebs sowie Lungen- und Kreislauferkrankungen auslösen würden. Dabei stimmt dies für Diesel-PKW spätestens ab der seit 2009 geltenden Schadstoffklasse Euro 5 nicht, weil sie seitdem mit einem Rußpartikelfilter ausgerüstet sein müssen. Der Diesel unterscheidet sich vom Benziner lediglich durch einen höheren Ausstoß von Stickstoffoxid (NO), das sich an der Atmosphäre dann zu Stickstoffdioxid (NO2) umwandelt. Über die Gesundheitsgefahr dieser Mischung, die unter dem Sammelbegriff NOx zusammengefasst wird, werden alle möglichen abstrusen Behauptungen in die Welt gesetzt. Dabei sind diese vergleichbar einfachen chemischen Substanzen der Wissenschaft seit gut 100 Jahren bekannt. Auch ihre gesundheitlichen Auswirkungen sind seit vielen Jahrzehnten immer wieder sorgfältig untersucht worden. In den Konzentrationen, in denen sie in der Atmosphäre unserer Städte vorkommen, sind sie höchstens lästig bis irritierend, keinesfalls aber gefährlich. Da sie auch an Arbeitsplätzen – z.B. im Bereich der chemischen Industrie – auftreten, wurden hierzu nach umfassenden Untersuchungen durch Fachgremien sogenannte MAK-Grenzwerte festgelegt. Diese MAK-Werte werden als unbedenklich für Gesunde eingestuft, selbst wenn diese dem Grenzwert über Jahre hinweg an 8 Stunden jeden Arbeitstags ausgesetzt sind. In Deutschland galt für NO2 noch 1994 ein MAK-Wert von 9 mg/m3 [NIEM], in der Schweiz sind es bis heute 6 mg/m3.

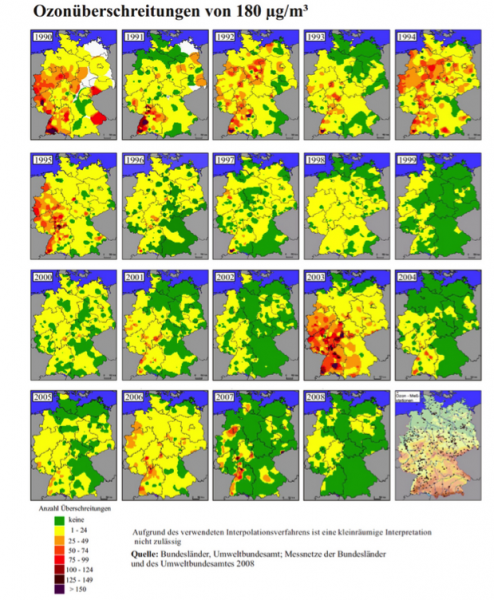

Die Anzahl der Überschreitung des Ozon-Grenzwerts von 180 µg/m3 ist seit Jahrzehnten rückläufig (Grafik: Umweltbundesamt)

Inzwischen wurde – vermutlich aufgrund von Pressionen linksgrüner politischer Kräfte – der MAK-Wert für NO2 in Deutschland drastisch um einen Faktor von fast 10 auf nur noch 0,950 mg/m3 heruntergesetzt. Für die beiden Einzelbestandteile gelten weiterhin auch separate MAK-Werte. Beim NO liegt dieser in Deutschland bei 0,63 mg/m3, in der Schweiz dagegen bei 3 mg/m3 [NOMA]. Die oft vertretene Ansicht, dass Asthma-Patienten und Menschen mit chronischer Bronchitis auf erhöhte NO2-Werte empfindlicher reagieren als Gesunde, wird in relevanten Datensammlungen zu den Gesundheitsrisiken nicht unterstützt [NO2GE]. Auch in den Empfehlungen des Wissenschaftlichen Komitees der EU für Grenzen beruflicher Exposition gegenüber NO2 [NOAEL] ist nachzulesen, dass trotz intensiver Überprüfung der Literatur keine eindeutigen Erkenntnisse bezüglich einer nachteiligen klinischen Wirkung von NO2 auf Personen mit Asthma, chronischen Lungenerkrankungen oder Bronchitis vorliegen. In der dort aufgeführten Literatur finden sich Studien über Bergarbeiter in einem Salzbergwerk. Diese waren Dieselabgasen (Ruß + NO + NO2) in Kombination mit den im Bergbau üblichen Belastungen (Staub) unter bergbautypischen körperlichen Belastungen bei NO2-Gehalten bis zu 7,6 mg/m3 ausgesetzt waren. Dabei konnte kein Zusammenhang mit Atembeschwerden oder Husten festgestellt werden.

Noch ungefährlicher als NO2 ist das NO, das im primären Dieselabgas den weit überwiegenden Anteil des NOx ausmacht. NO bewirkt keine Reizerscheinungen an den Schleimhäuten und ist zudem ebenso wie NO2 weder reproduktionstoxisch noch mutagen oder krebsauslösend [NOMA]. Es stellt sich daher die Frage, warum man überhaupt NOx-Werte (d.h. die Summe aus NO und NO2) heranzieht, statt lediglich den NO2-Gehalt zu bestimmen. Möglicherweise vor allem deshalb, weil die gemessenen Werte dadurch im „grünen“ Sinne aufgebläht werden und man leichter zu Grenzwertverletzungen kommt.

Fasst man das ungefährlichere NO mit NO2 zu NOx zusammen, so erhält man deutlich höhere Werte als bei reiner Betrachtung des NO (Grafiken: [UBA])

Konzentrierte Dieselabgase im Tierversuch

Dass die Abgase moderner Dieselfahrzeuge mit Feinstaubfilter bei weitem nicht so schädlich sind wie vielfach behauptet, wurde in den USA 2015 von McDonald et al. durch eine eingehende experimentelle Untersuchung an Ratten nachgewiesen [MCDO]. Hierbei wurden die Versuchstiere über Zeiträume von bis zu 30 Monaten für 16 Stunden am Tage und an 5 Tagen in der Woche in einer kontrollierten Abgasatmosphäre gehalten, die auf der höchsten Stufe einen NO2-Gehalt von 8,4 mg/m3 aufwies, das ist rund das neunfache des deutschen MAK-Werts. Dabei ergaben sich kaum Hinweise auf karzinogene Wirkungen. Selbst bei den höchsten Abgaskonzentrationen zeigten sich an den Lungen der Versuchstiere nur minimale bis leichte Schädigungen….

wird fortgesetzt…