Mit Diesel gegen den Großen Blackout

Einleitung

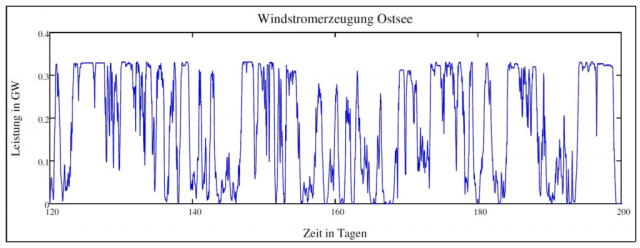

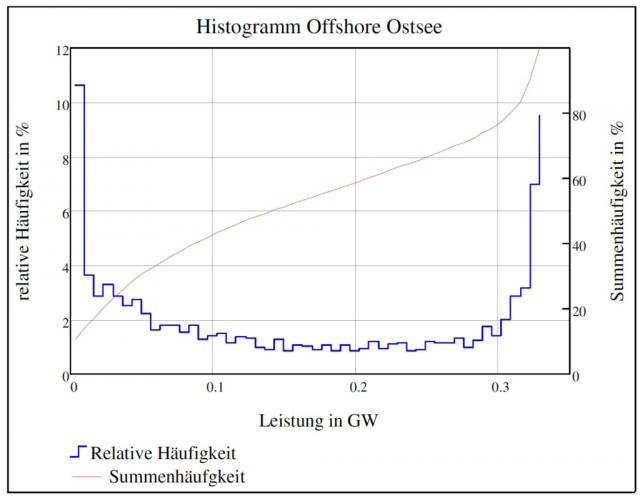

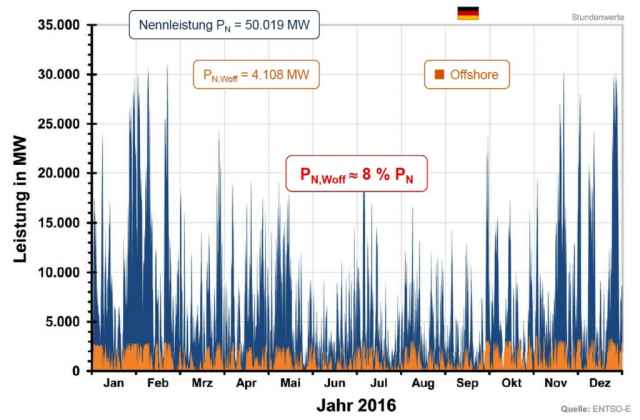

Vom Bundesamt für Bevölkerungsschutz und Katastrophenhilfe (BBK) hört man in der Regel sehr wenig. Die Zeiten, in denen man kleine Atombunker im Vorgarten bauen sollte, sind ja vorbei. Aber die zugehörige Anlage von Notvorräten ist dagegen keineswegs überflüssig geworden; diese Maßnahme erlebt gerade wieder eine Auferstehung. Nicht wegen einer Kriegsgefahr, aber wegen einer totalen, Wochen andauernden landesweiten Stromsperre, die uns jederzeit das Wetter einbringen kann, von dem ja die Stromversorgung Deutschlands nach dem Willen der Regierung in naher Zukunft weit überwiegend abhängen soll. Im neudeutschen Sprachgebrauch wird dieses Ereignis Blackout genannt. Eintreten kann es insbesondere durch eine sogenannte Dunkelflaute, die vornehmlich im Winter auftritt und die die gesamte Grünstromerzeugung auf winzige Reste reduziert – kein Wind und dazu tagsüber kaum und des Nachts sowieso keine Sonne.

Wenn dann im Bereich der einzig noch arbeitenden konventionellen Kraftwerke und/oder im Stromnetz technische Probleme eintreten, dann kommt die zum Schutz der Anlagen notwendige „Kaskade“ – eine Abschaltwelle, die eine Versorgungsregion nach der anderen abschaltet und am Ende Deutschland in Dunkelheit und Stillstand versinken lässt. Und das kann durchaus 2 bis 3 Wochen andauern – man braucht nur die Wetterkarte Europas im Wetterbericht zu betrachten und sich die Größe und Beständigkeit der riesigen, windarmen Hochdruckgebiete anzusehen (Lit.3).

In Erinnerung ist immer noch der damals nur Wetter-bedingte Zusammenbruch der Stromversorgung im Münsterland im November 2005, als unter Eis- und Windlasten zahlreiche Strommasten des dortigen Mittelspannungsnetzes zusammenbrachen – siehe Abb.1. 250.000 Personen und 20.000 Haushalte waren damals 5 Tage und z.T. noch länger ohne Strom. Das geschah noch bevor die sog. Energiewende im vollen Gang war , die die Abschaltung der sicheren Kernkraftwerke – die im Jahre 2011 begann – mit dem riesenhaften Ausbau der Windkraftanlagen und Solarpanels kombinierte, deren Überschuss-Strom insbesondere bei Starkwind das Netz überbeansprucht und damit die Blackout-Gefahr wesentlich erhöht.

Abb.1 kann leider aus Urheberschutzgründen nicht gezeigt werden: Von Eis- und Windlasten zerstörte Strommasten des Mittelspannungsnetzes im Münsterland im November 2005. Foto: dpa

Anfang Februar 2012 stand das gesamte europäische Verbundnetz kurz vor dem Zusammenbruch, als große Kälte und stark schwankende Solar- und Windenergie zusammentrafen: Es war zu diesem Zeitpunkt nur noch eine Reserve von 1.000 MW verfügbar – und bei einem Ausfall eines einzigen großen Kraftwerksblocks wäre es zu einem Totalausfall gekommen. Es kam nicht dazu, weshalb die Öffentlichkeit auch nicht viel von dieser Beinahe-Katastrophe erfuhr.

Die zuständige Bundesnetzagentur hat diese Gefahr abwechselnd hervorgehoben und auch wieder heruntergespielt. Klartext haben dagegen die Netzbetreiber und auch die für die Kraftwerkswirtschaft zuständige IG Bergbau, Chemie, Energie-Gewerkschaft IGBC – insbesondere deren Vorsitzender Michael Vassiliadis – gesprochen. Das geschah im Januar 2017:

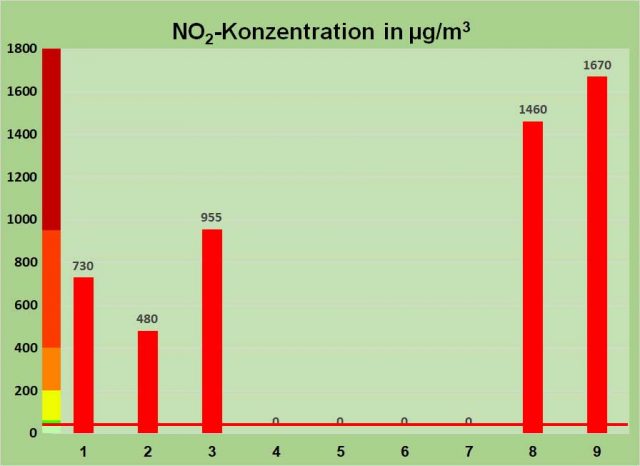

Der 24. Januar 2017 war wieder einer dieser Tage, an dem der Ernstfall – der völlige Zusammenbruch der deutschen Stromversorgung – gefährlich nahe kam. Dieser große Blackout wurde gerade noch vermieden, weil – laut Vassiliadis – Energieversorger „auch noch das letzte Reservekraftwerk heranzogen“ (Lit.1).

Nach dem Bericht von RP-Online führte Vassiliadis auf einer Veranstaltung in Haltern am See vor Journalisten aus, dass „der Zustand am 24. Januar kritisch wurde. Energieunternehmen und Netzbetreiber hätten an diesem Tage die Stromversorgung nur mit größter Mühe aufrechterhalten können.“ Denn die Deutschen forderten – wie an anderen Tagen auch – mehr als 80.000 MW Leistung ab. Vassiliadis: „Die Erneuerbaren konnten nicht einmal fünf Prozent davon bieten“.

Das Bundesamt für Bevölkerungsschutz und Katastrophenhilfe gibt 2017 Empfehlungen für den großen Stromausfall

Es hat ziemlich lange gedauert, bis sich dieses Bundesamt mit der inzwischen groß gewordenen Gefahr eines bundesweiten und länger andauernden Stromaufall befasst hat. (Lit. 4). Schließlich lag die sowohl ausgezeichnete wie auch erschreckende Studie des Technikfolgenabschätzungs-Büros des Bundestages TAB schon 6 Jahre vor. Immerhin wird sie in den Empfehlungen des BBK erwähnt. Jetzt also gibt es von dem zuständigen Bundesamt Empfehlungen, was im Ernstfalle zu tun wäre. Es sind Empfehlungen an die Bundesländer, die geeignete Maßnahmen zu ergreifen hätten – wenn sie das überhaupt können.

Schon eine erste Prüfung der BBK-Bewertungen und -Empfehlungen deckt ein entscheidendes Defizit der gesamten Arbeit auf: Dieser Leitfaden behandelt in der Tat ausschließlich die Bereitstellung von Treibstoff für die sog. „Kritischen Infrastrukturen“ (z.B. Krankenhäuser, Feuerwehr, Polizei, Notunterkünfte).

Es folgen Zitate aus diesem Bericht:

Nach der Einschätzung der Autoren erfordert bei einer Stadt mit einer halben Million Einwohnern eine Notversorgung 300.000 Liter Diesel pro Tag (etwa 11 Tankwagen).

– „Bis zur Wiederherstellung der Stromversorgung steht und fällt die Handlungsfähigkeit der Gefahrenabwehr und der kritischen Infrastrukturen mit einer stetigen und reibungslosen Treibstoffversorgung für Fahrzeuge und Notstromaggregate.“

Anm.: Das ist eine erstaunliche Reduzierung der gesamten Problematik – die im TAB-Bericht sehr überzeugend beschrieben wird – auf eine Versorgung einzelner Verbraucher („Kritische Infrastrukturen“) mit Diesel. Weiter wird ausgeführt:

– „Eine Auslagerung aus Tanklagern ist ohne Strom nicht möglich.“

– „Die Freigabe von Treibstoff-Kontingenten aus Tanklagern….ist im Normalfall über Systeme der Informationstechnik (IT) abgesichert.“

– „Auslagerungen sind immer zu dokumentieren…Dafür sind Buchungssysteme nötig, also von IT und Stromversorgung abhängig.“

– „Die Kommunikationsmöglichkeiten entlang der Logistikkette auf der „letzten Meile“ sollten aufrechterhalten werden können.“…

Selbst in diesen Aussagen wird klar, dass der Kommunikation und der IT eine ganz entscheidende Rolle zukommt. In der TAB-Studie ist der Ausfall der stromabhängigen Kommunikation ein entscheidender Faktor, der nach kurzer Zeit eine Katastrophe eintreten lässt. Die Empfehlungen des BBK an die Landesbehörden halten dazu allerdings eine böse Überraschung bereit: Man blendet dieses Problem weitgehend aus.

Zunächst heißt es in den BBK-Empfehlungen unter „Maßnahmen und Lösungen“:

– „Entscheidungen auf Kreisebene über Maßnahmen zur konkreten Priorisierung vor Ortund zur Lösung technischer und organisatorischer Probleme……

„Kooperationen schließen (Behörden – Betreiber von Tanklagern und Tankstellen),… „Abläufe vereinbaren,“…„Rechtslage muss bekannt sein.“…

Dann endlich ist von der Stromversorgung die Rede: „Geeignete Tanklager und Tankstellen zur Treibstoffversorgung bei Stromausfall auswählen und mit einer Notstromanlage versehen.“

Anm.: Ob das die Kreise tun, ob sie das dekretieren würden, ob sie das evtl. finanziell unterstützen wollen: Kein Wort dazu.

Dann geht es mit den Empfehlungen weiter: „Treibstoffbedarf grob ermitteln.“

„Zoll- und Eigentumsfragen.“ „Notfallplanung kann nur effektiv wirken, wenn in den bedarftragenden Einrichtungen bereits ein hoher Grad an Eigenvorsorge vorhanden ist.“

Anm.: Das heißt im Klartext: Wenn Ihr nicht bereits diesen hohen Grad an Eigenvorsorge (mit Notstromaggregaten) realisiert habt, dann wird es nicht funktionieren. Wir haben Euch gewarnt. Oder noch einfacher: Selber schuld !

In Kap.4 „Strategische Vorbereitungen in Bund, Land und Landkreisen“

folgt die entscheidende Einschränkung für die Empfehlungen: „Experten identifizierten die Kommunikationsfähigkeit und die Versorgung mit Treibstoffen bereits als Achillesferse“ (Lit. 6). „Die vorliegende Empfehlung greift das zweitgenannte Problem auf.“

Der mit dem Stromausfall verbundene weitgehende Ausfall der Kommunikation insbesondere zwischen den Bürgern einerseits und Behörden, Unternehmen und anderen Stellen andererseits und die damit verbundenen Folgen werden somit in dem BBK-Bericht einfach ausgeblendet.

Im TAB-Bericht dagegen werden die ernsten Konsequenzen dieses Ausfalls eingehend dargestellt.

Diese hier zu benennen und zu bewerten hätte aber zu einer Blamage geführt, weil man damit die schlimmen Folgen eines länger andauernden Blackouts und die tatsächliche Hilflosigkeit der staatlichen Stellen hätte zugeben müssen. Dass die hier erfolgte Beschränkung auf die Treibstoffversorgung das Urteil „Thema verfehlt“ für das Bundesamt bekräftigt, nimmt man in Kauf. Die vorgesetzte Oberbehörde, das Bundesinnenministerium, wäre ja über eine vollständige und ehrliche Behandlung dieses Themas alles andere als erfreut gewesen.

Weil der unweigerlich eintretende Ausfall der Kommunikation zwischen den Bürgern und allen öffentlichen und halbstaatlichen Stellen (Polizei, Feuerwehr, Ämter; auch Medien wie TV- und Radiosender) die im TAB-Bericht beschriebenen gravierenden Folgen hat, konzentrierten sich die BBK-Empfehlungen auf die wenigen, gewiss hilfreichen Notstromaggregate, die – sofern vorhanden – Treibstoff benötigen. Ab dieser Erkenntnis wird im Bericht nur noch darüber geschrieben, wie man diese, nur für wenige Abnehmer gedachte Treibstoffversorgung sicherstellen sollte.

Den Kreisbehörden wird allerdings empfohlen:

„Ferner sollte die Funktionsfähigkeit von Informationstechnik und Telekommunikation unbedingt gewährleistet werden.“

Das ist eine Leerformel, denn sie betrifft nicht die Kommunikationsfähigkeit der Bürger, sondern nur die Funktionsfähigkeit der unten genannten Stellen, mit denen kein Bürger bei Stromausfall kommunizieren kann – wie unten ausgeführt wird.

Unter der Überschrift „Priorisierung der Treibstoffverteilung“ werden dann vom BBK folgende vorzugsweise zu bedienenden Verbraucher genannt:

„Digitalfunk-Betreiber“, Telekommunikationsnetz-Betreiber“ und „überwiegend (!) öffentlich-rechtliche Medien“. Die privaten Medien – z.B. Privatradiosender – sind anscheinend nicht so wichtig.

Im Kapitel 7.3.3 des BBK-Berichts mit der Überschrift „Abstimmung von Abläufen in Notfallplänen“ wird schließlich- nach der Aufzählung einiger weniger wichtiger „Aspekte“ die ultimative Rettungs-Katze aus dem Sack gelassen:

„Die Kommunikationsmöglichkeiten bei Stromausfall (Satellitentelefone o.ä.)“.

Dazu wird im Kapitel 7.5.7 Krisenmanagement –Maßnahmen allgemein auf den Leitfaden des Bundesinnenministeriums BMI „Schutz kritischer Infrastrukturen. Risiko- und Krisenmanagement“ verwiesen, in dem u.a. zu lesen ist:

„Information der Bevölkerung“ (leider ohne zu sagen, wie das gehen soll –

und es geht ja auch nicht, denn Radioempfang, TV und Telefone

funktionieren nicht bei der Bevölkerung)

– „Gewährleistung der eigenen(!!) Kommunikationsfähigkeit

(Satellitentelefone: Muss geübt werden, Nummern müssen bekannt und

aktuell sein)“

Auch das im Kap. 8.3 des BBK-Berichtes als beispielhaft vorgestellte Expertennetzwerk von Michael Saupe des Verteilnetzbetreibers Mitteldeutsche Netzgesellschaft Strom mbH (MITNETZ STROM) hält die Verwendung von Satellitentelefonen für das am besten geeignete Kommunikationsmittel bei lange andauerndem Stromausfall.

Klarer konnte das Elend der Unmöglichkeit einer funktionierenden Kommunikation zwischen Bürgern und Ämtern, Behörden, Medien und weiteren „Akteuren“ nicht beschrieben werden.

Satellitentelefone besitzt kaum jemand. Sie sind unhandlich und teuer und kommen nur für Extremanwendungen (Weltumsegler, Bergsteiger, Wüsten-Exkursionen etc.) und für das Militär in Betracht. Ihre Benennung im obigen Zusammenhang zeigt nur eins: Ratlosigkeit.

Die gravierenden Defizite des BBK-Berichts

Die moderne Kommunikationstechnik versagt bei einem Stromausfall

Bis zu dieser Stelle des Berichts wird kein Wort darüber verloren, ob und ggf. wie die Bevölkerung überhaupt an Informationen über die Notfallmaßnahmen kommen kann. Das ist insofern auch konsequent, denn die Bürger haben bei einem Großen Blackout in der Tat keine Chance.

Die Gründe dafür sind simpel:

• Das Telefon-Festnetz ist tot. Früher – also vor 30 bis 40 Jahren – wurde das keineswegs altmodische analoge Telefon von posteigenen Batterien dauerhaft und sicher mit Strom versorgt und automatische, elektromechanische Leitungswähler in den Wählvermittlungsämtern der Post suchten selbsttätig funktionierende Telefonnetzverbindungen – und das funktionierte bestens auch bei einem totalen Zusammenbruch des öffentlichen Stromnetzes. Es stellte daher eine hervorragende Sicherheitstechnik dar, die selbst bei schweren Zerstörungen im Telefonnetz und in den Wählvermittlungsämtern noch funktionierte. Die mit dieser Technik realisierte hohe Redundanz gegen Störungen und Schäden war im Grunde eine tatsächlich hochmoderne und in Bezug auf ihre Funktionssicherheit unübertroffen optimale Lösung.

Das zeigte sich recht drastisch gegen Ende des Krieges am Beispiel des Kampfes um die Stadt Arnheim, deren Telefonnetz im Verlauf der Kämpfe immer mehr zerstört wurde, was jedoch nichts an der Möglichkeit veränderte, weiterhin in der Stadt Telefonate zu führen.

Diese geniale Sicherheitstechnik wurde durch die digitale Telefontechnik ersetzt, die jetzt aber leider völlig von der Stromversorgung durch das öffentliche Stromnetz abhängig ist. Und mit ihr ausfällt. Es ist nicht bekannt, dass das Bundesamt für Bevölkerungsschutz und Katastrophenhilfe gegen die Abschaffung der analogen Telefontechnik und deren Ersatz durch die heutige digitale Technik protestiert hätte. Anscheinend ist niemandem aufgefallen, dass damit ein unverzichtbares Element der Sicherheit abgeschafft wurde. Die neue Technik ist natürlich viel komfortabler – wenn der 230-Volt-Netzstrom da ist. Fällt er aus, ist die Kommunikation tot.

• Auch das Mobilfunk-Netz ist dann tot, denn die zahlreichen Sender dieser Funkzellen haben weder Batterien noch Notstromaggregate – und fallen zusammen mit dem Stromnetz aus.

Auch wenn die Bürger Batterien für ihre Mobiltelefone gehortet haben sollten: Es hilft ihnen nichts, denn die Zellen-Sender sind „tot“ und können Handy-Telefonate weder empfangen, noch weitervermitteln.

So hat der Modernisierungswahn eine der wichtigsten Sicherheitstechniken für die Bevölkerung eliminiert – und die zuständigen Ämter haben es nicht bemerkt. Jetzt werden verspätet und hektisch scheinbare Ersatzlösungen präsentiert, die leider nichts am Zusammenbruch der Kommunikation zwischen Bürgern und staatlichen bzw. halbstaatlichen Stellen ändern können, der im Falle eines großflächigen und länger andauernden Stromausfalls eintreten wird. Der TAB-Bericht schildert das ungeschminkt.

• Der Bericht des Bundesamtes BBK ist daher nichts anderes als eine Bankrotterklärung.

Das Büro für Technikfolgenabschätzung des Deutschen Bundestages TAB gab bereits 2011 einen unmissverständlichen Warnschuss ab

Welche Folgen ein länger andauernder Stromausfall haben würde, hatte das TAB schon im Jahre 2011 in einer 261 Seiten langen Studie mit dem Titel „Was bei einem Blackout geschieht“, veröffentlicht (Lit. 2).

Zitate aus der TAB-Studie

„Hinsichtlich der Informiertheit und der Einstellung der Bevölkerung ist ein erhebliches Defizit zu konstatieren. Den meisten Bürgern ist gar nicht klar, was ein großer Blackout bedeutet. Die Stromversorgung als kritische Infrastruktur ist für die Bevölkerung kein Thema, die Möglichkeit von Stromausfällen und die Folgen einer Unterbrechung der Stromversorgung werden ausgeblendet. Erlebte Stromausfälle werden meist schnell vergessen“.

„Aufgrund der Erfahrungen mit bisherigen nationalen und internationalen Stromausfällen sind erhebliche Schäden zu erwarten. Bisherige Stromausfälle dauerten höchstens einige Tage, einige verursachten jedoch geschätzte Kosten von mehreren Mrd. US-Dollar. Für den Fall eines mehrwöchigen Stromausfalls sind Schäden zu erwarten, die um Größenordnungen höher liegen.“

„Die Folgen eines großräumigen, langfristigen Stromausfalls für Informationstechnik und Telekommunikation müssen als dramatisch eingeschätzt werden. Telekommunikations- und Datendienste fallen teils sofort, spätestens aber nach wenigen Tagen aus.

Die für zentrale Kommunikationseinrichtungen vorgehaltenen Reservekapazitäten wie »Unterbrechungsfreie Stromversorgung« und Notstromaggregate sind nach wenigen Stunden oder Tagen erschöpft bzw. aufgrund ausgefallener Endgeräte wirkungslos.

Damit entfällt innerhalb sehr kurzer Zeit für die Bevölkerung die Möglichkeit zur aktiven und dialogischen Kommunikation mittels Telefonie und Internet.“

„Im Sektor »Transport und Verkehr« fallen die elektrisch betriebenen Elemente der Verkehrsträger Straße, Schiene, Luft und Wasser sofort oder nach wenigen Stunden aus. Zu Brennpunkten werden der abrupte Stillstand des Schienenverkehrs und die Blockaden des motorisierten Individual- und öffentlichen Personennahverkehrs in dichtbesiedelten Gebieten….Der Straßenverkehr ist unmittelbar nach dem Stromausfall besonders in großen Städten chaotisch. Kreuzungen ebenso wie zahlreiche Tunnel und Schrankenanlagen sind blockiert, es bilden sich lange Staus. Es ereignen sich zahlreiche Unfälle, auch mit Verletzten und Todesopfern. Rettungsdienste und Einsatzkräfte haben erhebliche Schwierigkeiten, ihren Aufgaben, wie Versorgung und Transport von Verletzten oder Bekämpfung von Bränden, gerecht zu werden. Durch den Ausfall der meisten Tankstellen bleiben zunehmend Fahrzeuge liegen, der motorisierte Individualverkehr nimmt nach den ersten 24 Stunden stark ab. Der Öffentliche Personennahverkehr ÖPNV kann wegen knappen Treibstoffs allenfalls rudimentär aufrechterhalten werden.“

(Anm.: Der schienengebundene, elektrische ÖPNV fällt sofort aus. Die neuerdings eingeführten rein elektrisch angetriebenen Omnibusse bleiben mangels Auflademöglichkeit ihrer Batterie ebenfalls liegen.)

„Im Bereich der Wasserversorgung wird elektrische Energie in der Wasserförderung,

-aufbereitung und -verteilung benötigt. Besonders kritisch für die Gewährleistung der jeweiligen Funktion sind elektrisch betriebene Pumpen. Fallen diese aus, ist die Grundwasserförderung nicht mehr möglich, die Gewinnung von Wasser aus Oberflächengewässern zumindest stark beeinträchtigt…. Höher gelegene Gebiete können gar nicht mehr versorgt werden.

Eine Unterbrechung der Wasserversorgung wirkt sich umfassend auf das häusliche Leben aus: Die gewohnte Körperpflege ist nicht durchführbar; für die Mehrzahl der Haushalte gibt es kein warmes Wasser. Das Zubereiten von Speisen und Getränken ist nur reduziert möglich, und die Toilettenspülung funktioniert nicht. Mit fortschreitender Dauer des Ausfalls ist mit einer Verschärfung der Probleme zu rechnen.“

„Da als Folge der reduzierten oder ausgefallenen Wasserversorgung die Brandbekämpfung beeinträchtigt ist, besteht insbesondere in Städten wegen der hohen Besiedelungsdichte die Gefahr der Brandausbreitung auf Häuserblöcke und möglicherweise sogar auf ganze Stadtteile.“

„Als Folge des Stromausfalls ist die Versorgung mit Lebensmitteln erheblich gestört; deren bedarfsgerechte Bereitstellung und Verteilung unter der Bevölkerung werden vorrangige Aufgaben der Behörden. Von ihrer erfolgreichen Bewältigung hängt nicht nur das Überleben zahlreicher Menschen ab, sondern auch die Aufrechterhaltung der öffentlichen Ordnung.

Die weiterverarbeitende Lebensmittelindustrie fällt zumeist sofort aus, sodass die Belieferung der Lager des Handels unterbrochen wird.

Trotz größter Anstrengungen kann aber mit hoher Wahrscheinlichkeit die flächendeckende und bedarfsgerechte Verteilung der Lebensmittellieferungen nur ungenügend gewährleistet werden. Eine Kommunikation über Vorrat und Bedarf zwischen Zentrale, Lager und Filiale ist wegen des Ausfalls der Telekommunikationsverbindungen erheblich erschwert.“

„Nahezu alle Einrichtungen der medizinischen und pharmazeutischen Versorgung der Bevölkerung sind von Elektrizität unmittelbar abhängig. Das dezentral und hocharbeitsteilig organisierte Gesundheitswesen kann den Folgen eines Stromausfalls daher nur kurz widerstehen. Innerhalb einer Woche verschärft sich die Situation derart, dass selbst bei einem intensiven Einsatz regionaler Hilfskapazitäten vom weitgehenden Zusammenbrechen der medizinischen und pharmazeutischen Versorgung auszugehen ist. Bereits nach 24 Stunden ist die Funktionsfähigkeit des Gesundheitswesens erheblich beeinträchtigt. Krankenhäuser können mithilfe von Notstromanlagen noch einen eingeschränkten Betrieb aufrechterhalten, Dialysezentren sowie Alten- und Pflegeheime aber müssen zumindest teilweise geräumt werden und Funktionsbereiche schließen. Die meisten Arztpraxen und Apotheken können ohne Strom nicht mehr weiterarbeiten und werden geschlossen.

Arzneimittel werden im Verlauf der ersten Woche zunehmend knapper, da die Produktion und der Vertrieb pharmazeutischer Produkte im vom Stromausfall betroffenen Gebiet nicht mehr möglich sind. Insbesondere verderbliche Arzneimittel sind, wenn überhaupt, nur noch in Krankenhäusern zu beziehen. Dramatisch wirken sich Engpässe bei Insulin, Blutkonserven und Dialysierflüssigkeiten aus.“

„Dieser dezentral strukturierte Sektor ist schon nach wenigen Tagen mit der eigenständigen Bewältigung der Folgen des Stromausfalls überfordert. Die Leistungsfähigkeit des Gesundheitswesens wird nicht nur durch die zunehmende Erschöpfung der internen Kapazitäten, sondern auch durch Ausfälle anderer Kritischer Infrastrukturen reduziert. Defizite bei der Versorgung, beispielsweise mit Wasser, Lebensmitteln, Kommunikationsdienstleistungen und Transportdienstleistungen, verstärken die Einbrüche bei Umfang und Qualität der medizinischen Versorgung. Die Rettungsdienste können nur noch begrenzt für Transport- und Evakuierungseinsätze eingesetzt werden.“

„Der Zusammenbruch der in Krankenhäusern konzentrierten Versorgung droht. Einige Krankenhäuser können zunächst eine reduzierte Handlungsfähigkeit bewahren und sind dadurch zentrale Knotenpunkte der medizinischen Versorgung.“

„Spätestens am Ende der ersten Woche wäre eine Katastrophe zu erwarten, d.h. die gesundheitliche Schädigung bzw. der Tod sehr vieler Menschen sowie eine mit lokal bzw. regional verfügbaren Mitteln und personellen Kapazitäten nicht mehr zu bewältigende Problemlage.“

„Bricht die Stromversorgung zusammen, sind alltägliche Handlungen infrage gestellt und gewohnte Kommunikationswege größtenteils unbrauchbar. Stockt die Versorgung, fehlen Informationen und beginnt die öffentliche Ordnung zusammenzubrechen, entstehen Ohnmachtsgefühle und Stress.

Einer dialogischen Krisenkommunikation mit der Bevölkerung wird durch die Ausfälle im Sektor »Informationstechnik und Telekommunikation weitgehend der Boden entzogen.“

„Verhalten der Bevölkerung

Die Auswirkungen können sehr verschieden sein: Von vermehrter Bereitschaft zur gegenseitigen Hilfe bis zu einem „Zurückfallen hinter die Normen des gesellschaftlichen Zusammenlebens“. (Anm.: So formulieren die Autoren zurückhaltend – gemeint sind vermutlich Plünderungen und Schlimmeres.)

„Finanzielle und soziale Kosten

Bei einem Deutschland-weiten Stromausfall im Winter entsteht ein wirtschaftlicher Schaden von 0,6 bis 1,3 Milliarden Euro – pro Stunde. Täglich also 20 – 30 Mrd. €.“

(Anm.: Keine Angaben findet man in der Studie zu den Opfern; diese abzuschätzen dürfte sehr schwer sein. Man muss davon ausgehen, dass durch vermehrte Unfälle, unzureichende Rettungsmaßnahmen, Ausfall lebenserhaltender Systeme, Brände oder öffentliche Unruhen zahlreiche Todesfälle eintreten würden.)

Die Autoren der TAB-Studie resümieren:

„FAZIT: Wie die zuvor dargestellten Ergebnisse haben auch die weiteren Folgenanalysen des TAB gezeigt, dass bereits nach wenigen Tagen im betroffenen Gebiet die flächendeckende und bedarfsgerechte Versorgung der Bevölkerung mit (lebens)notwendigen Gütern und Dienstleistungen nicht mehr sicherzustellen ist. Die öffentliche Sicherheit ist gefährdet, der grundgesetzlich verankerten Schutzpflicht für Leib und Leben seiner Bürger kann der Staat nicht mehr gerecht werden. Die Wahrscheinlichkeit eines langandauernden und das Gebiet mehrerer Bundesländer betreffenden Stromausfalls mag gering sein. Träte dieser Fall aber ein, kämen die dadurch ausgelösten Folgen einer nationalen Katastrophe gleich. Diese wäre selbst durch eine Mobilisierung aller internen und externen Kräfte und Ressourcen nicht »beherrschbar«, allenfalls zu mildern“.

(Ende der Zitate aus der TAB-Studie)

Diese TAB-Studie wird im Bericht des Bundesamtes zitiert. Die zahlreichen Abläufe in den verschiedenen Sektoren, die zusammen nach einer Woche zu einer Katastrophe mit zahlreichen Todesfällen führen würden, werden jedoch „ausgeblendet“ – s.o.).

Bewertung

Die Möglichkeit, dass ein länger andauernder vollständiger Zusammenbruch der Stromversorgung eintritt, wird mit jedem Jahr wahrscheinlicher. Bereits die bisher eingetretenen Beinahe-Blackouts wurden nur durch die Professionalität der Netzbetreiber, verbunden mit Glück bei ihren Rettungsmaßnahmen noch nicht zu nationalen Katastrophen.

Die Abschaltung auch der letzten heute noch laufenden Kernkraftwerken wird diese Gefahr noch erheblich vergrößern.

Was jetzt das Bundesamt für Bevölkerungsschutz und Katastrophenhilfe 6 ½ Jahre nach der Veröffentlichung des erschreckenden TAB-Berichtes als seine Empfehlungen für die Länderbehörden vorlegte, ist in jeder Hinsicht unzureichend.

o Der TAB-Bericht wird zwar erwähnt, aber das darin eingehend beschriebene Kernproblem des Zusammenbruchs der Kommunikation – insbesondere der zwischen Bürgern und den Behörden und Medien – und dessen Folgen wird ausgeklammert. Eine Begründung dafür wird nicht gegeben.

Man kann daraus nur schlußfolgern, dass ein Eingehen auf die im TAB-Bericht beschriebenen Folgen eines langandauernden Stromausfalls die mittlerweile sensibilisierte Öffentlichkeit sehr erschrecken würde – weshalb man nichts dazu sagt.

o Die hauptsächliche vom BBK behandelte Maßnahme ist die Versorgung von „kritischen Infrastrukturen“ mit Treibstoff, damit diese ihre – weitestgehend nicht vorhandenen – Notstromaggregate betreiben können.

o Diese Treibstoffversorgung würde allenfalls vorübergehend in Krankenhäusern eine größere menschliche Katastrophe verzögern. Zu einer Information der Bevölkerung und einer Kommunikation der Bürger mit Behörden, Medien, Polizei, Feuerwehr, Krankenhäusern und Pflegeheimen könnte sie nichts beitragen. Im TAB-Bericht ist nachzulesen, welche Folgen gerade dieses Versagen hätte.

o Ob jetzt alle angesprochenen Bundesländer ihre „kritischen Infrastrukturen“ mit Notstromaggregaten ausrüsten werden, ist zumindest zweifelhaft. In der Öffentlichkeit würde das als Eingeständnis der Blackoutgefahr gewertet. Ferner fehlt es vermutlich am Geld.

o Der mehrfache Verweis auf die Verwendung von Satellitentelefonen ist nur ein Schutzargument und eine Leerformel: Es ist ein praxisferner und deshalb unbrauchbarer Vorschlag.

o Der BBK-Bericht beweist nur eine Tatsache: Die Bundesregierung fürchtet den Großen Blackout, den ihre Energiepolitik provoziert; sie kennt die Folgen und sie möchte nicht, dass diese zu einem Thema in der Öffentlichkeit werden.

o Bis hierher war alles bitterer Ernst. Aber es gibt doch die Möglichkeit, selbst fürchterliche Ereignisse etwas sympathischer zu machen:

Weil Blackouts mittlerweile in Deutschland allein durch das Wetter verursacht werden, wäre der Deutsche Wetterdienst DWD für sie zuständig. Dieser sollte den Dunkelflaute-Blackouts ebenso wie auch anderen prominenten Wetterereignissen einen Namen geben.

Vorschlag für den nächsten Beinahe- oder Totalblackout: Angela.

Literatur : Quellen

(1): C.Longin und M.Plück: „Deutsches Stromnetz schrammt am Blackout

vorbei, 27.2.2017; RP-Online;

http://www.rponline.de/wirtschaft/unternehmen/deutsches-stromnetz-

schrammt-am- blackout-vorbei-aid-1.6636489

(2): Thomas Petermann, Harald Bradtke, Arne Lüllmann, Maik Poetzsch, Ulrich

Riehm: „Gefährdung und Verletzbarkeit moderner Gesellschaften – am Beispiel

eines großräumigen und langandauernden Ausfalls der Stromversorgung“,

17.5.2011; Arbeitsbericht Nr. 141;

Publikation: „Was bei einem Blackout geschieht“, Studie des Büros für

Technikfolgenabschätzung beim Deutschen Bundestag, Bd. 33, 2011, Verlag

edition sigma, Berlin, ISBN 9783836081337, Volltext:

http://www.tab-beim-bundestag.de/de/pdf/publikationen/berichte/TAB-Arbeitsbericht- ab141.pdf

(3): Günter Keil: „Am Ende der Energiewende-Sackgasse lauert das Dunkelflaute-

Gespenst“, 14.9.2014;

https://www.eike-klima-energie.eu/2014/09/14/am-ende-der-energiewende-

sackgasse-lauert-das-dunkelflaute-gespenst/

(4): Bundesamt für Bevölkerungsschutz und Katastrophenhilfe (BBK):

„Treibstoffversorgung bei Stromausfall“, Band 18 von „Praxis im

Bevölkerungsschutz“; 14.12.2017,

www.bbk.bund.de/sharedDocs/Pressemitteilungen/BBK/DE/2017/PM_Treibstoff_

Stromausfall.html

(5): „MitNetzStrom (2014)“: Ergebnisse der Workshop-Reihe Krisenmanagement.

Empfehlungen und Beispiele zur Gewährleistung der Kommunikation und

Treibstoffversorgung bei einem länger andauernden großflächigen Stromausfall.

Halle (Saale)