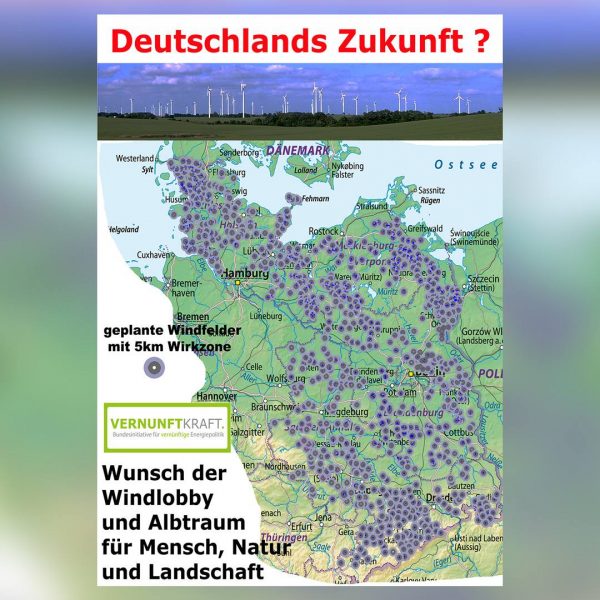

Diesel-Verteufelung: Krieg gegen das eigene Volk Diesel: Die Lückenmedien im Glashaus (11)

Bild 1 (oben). Der Blick „unter die Haube“ eines älteren V8-Dieselmotors offenbart die komplexe Technologie dieser energieeffizienten Kraftpakete

In den bisherigen Teilen dieses Aufsatzes wurde nachgewiesen, dass die NO2-Belastung der Luft in ganz Deutschland und auch an den sogenannten „Hotspots“ in den Städten auf im Prinzip unbedeutende Werte zurückgegangen ist. Wichtiger Grund hierfür ist die stetige Ablösung älterer durch jüngere Fahrzeuge mit besseren Abgasbehandlungssystemen. Dieser Trend wird sich auch in den nächsten Jahren fortsetzen. Auch wurde aufgedeckt, wie fragwürdig die Messmethoden sind und welche Tricks und Manipulationen zum Einsatz kommen. Im dritten Teil wurden die teils grotesk übertriebenen Behauptungen über die gesundheitlichen Auswirkungen von Stickstoffdioxid sowie die offensichtliche Parteilichkeit sowohl der öffentlich-rechtlichen Medien als auch industriefeindlicher Behörden behandelt. Im vierten Teil wurde festgestellt, dass das Auto auch in der Stadt der Zukunft unverzichtbar bleibt und Elektromobilität zurzeit nicht realisierbar ist. Außerdem wurden Widersprüche in den Aussagen des Umweltbundesamtes beleuchtet und anrüchige Querverbindungen zwischen der Deutschen Umwelthilfe sowie Ministerien und Behörden thematisiert. Im fünften Teil wurde gezeigt, dass an der angeblichen Gesundheitsgefährdung selbst durch geringste NO2-Konzentrationen nichts dran ist und die Horror-Stories über zigtausende Tote durch Dieselabgase nicht wissenschaftlich fundiert sind. Zahlreiche Studien basieren sogar auf gefälschten Zahlenwerten. Im sechsten Teil wurden grobe Mängel bei den Studien der US-Umweltschutzbehörde EPA und der WHO dargelegt, mit denen behauptete Gesundheitsgefahren von Stickoxiden „belegt“ werden sollen. Im siebten Teil wird anhand von umfassenden Abgasuntersuchungen in bayrischen Großstädten nachgewiesen, dass selbst an den „Brennpunkten“ des Abgasgeschehens keinerlei Gründe für Fahrverbote für Diesel-PKW vorliegen. Anschließend wurde im achten Teil nachgewiesen, dass die Grenzwertüberschreitungen der Luft punktuell extrem beschränkt sind und der Anteil der betroffenen Bewohner selbst an den Brennpunkten im Zehntel-Promille-Bereich liegt.

Bild 2. Einige der typischen Horrormeldungen in den Medien zum Thema Diesel-Abgase

Der neunte Teil zeigte, wie gering die Beaufschlagung der Anwohner einer Straße mit über dem Grenzwert liegenden NO2-Konzentrationen in Wirklichkeit ist. Im zehnten Teil wurde gezeigt, dass die NO2-Beaufschlagung im eigenen Wohnbereich teilweise sehr viel höher liegt als selbst an den am stärksten befrachteten Brennpunkten des Autoverkehrs. Im vorliegenden elften Teil werfen wir einen kritischen Blick auf die Glaubwürdigkeit einiger Epidemiologinnen, die sich in Deutschland als Anti-Diesel-Aktivistinnen hervortun.

Eine unbequeme Wahrheit….

Im Juni 2017 erschien der Bericht des ein Jahr zuvor eingesetzten Diesel-Untersuchungsausschusses, in dessen Verlauf Abgeordnete der im Bundestag vertretenen Parteien Stellungnahmen und Eingaben der vom Thema betroffenen gesellschaftlichen Kräfte sowie einer Reihe führender Wissenschaftler angehört und bewertet hatten. Zu diesen Wissenschaftlern gehörten auch führende Mediziner und Epidemiologen. In seinem abschließenden Bericht hält der Ausschuss auf den Seiten 491 ff u.a. folgende entscheidenden Aussagen fest:

– In Deutschland bestehen keine toxikologisch bedenklichen NO2-Werte in öffentlich zugänglichen Bereichen.

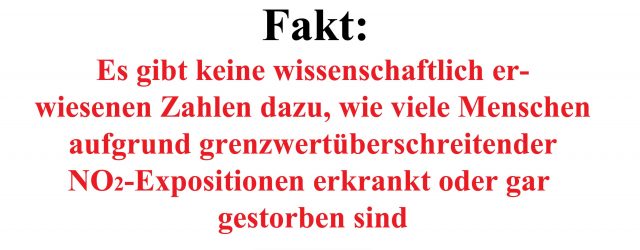

– Es gibt keine wissenschaftlich erwiesenen Zahlen dazu, wie viele Menschen aufgrund grenzwertüberschreitender NO2-Expositionen erkrankt oder gar gestorben sind, Bild 3.

Bild 3. Nach intensiver Recherche kam der Diesel-Untersuchungsausschuss des deutschen Bundestages zu dem Schluss, dass die Meldungen über Tote durch Dieselabgase unbegründet sind [BUTA]

…führte zu wütenden Protesten

Wie bereits in früheren Teilen dieser Untersuchung ausgeführt, gibt es zu diesem Thema gegensätzliche Haltungen von Medizinern bzw. Toxikologen einerseits und Epidemiologen andererseits. Erstere stützen sich auf durch Tests klar nachgewiesene Ursache-Wirkungsbeziehungen, während Epidemiologen statistische Untersuchungen an größeren Bevölkerungsgruppen durchführen, um auf diese Weise Hinweise auf Gesundheitsgefährdungen zu erhalten. Bei dieser Methodik sollte man jedoch die Voraussetzungen der Untersuchung sehr penibel auf mögliche Stör- und Quereinflüsse hin abprüfen und die Grundlagen der statistischen Auswertung beherrschen.

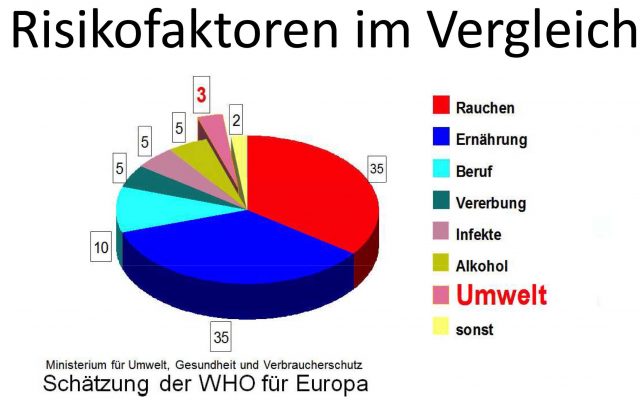

Bild 4. Vergleich gesundheitlicher Risikofaktoren. Man beachte, dass unter „Umwelt“ eine Vielzahl unterschiedlicher Faktoren zusammengefasst ist, von denen NO2 lediglich einen (eher unbedeutenden) Anteil ausmacht (Ministerium f. Umwelt, Gesundheit + Verbraucherschutz)

Unsaubere Arbeitsweise führt sonst zu Scheinkorrelationen [SCHKO] und damit zu falschen Schlüssen. Der wichtigste Fehler liegt in der Regel darin, dass die Abgrenzung der Einflüsse bei der Auswahl der untersuchten Gruppen („Kohorten“) nicht sauber durchgeführt wird.

Bereits in früheren Folgen dieser Artikelserie wurde darauf hingewiesen, dass ein erheblicher Teil der von Epidemiologen präsentierten Studien über den Zusammenhang von NO2-Emissionen und Gesundheitsbeeinträchtigungen wegen methodischer Fehler als nicht vertrauenswürdig eingestuft werden sollte [RUHR5, RUHR6RUHR5]. Teilweise wurde sogar offen gefälscht, um Fördergelder zu erhalten [DUKE]. Dies gilt auch für die Studien, die in zusammenfassenden Dokumentationen der US-amerikanischen Umweltschutzbehörde EPA [EPA] sowie der Weltgesundheitsorganisation WHO [WHO2] aufgeführt werden.

Profiteure des Abgas-Alarmismus

In den letzten Jahren hat sich in den westlichen Nationen sowie im Dunstkreis der WHO ein Filz aus universitären und „ökologischen“ – also im Prinzip kommerziellen – Institutionen herausgebildet, die davon abhängen, dass staatliche Stellen sie mit immer neuen Forschungsaufträgen u.a. zu Abgasthemen alimentieren. Das hat zur Ausbildung von Abhängigkeiten geführt und damit zu einer „Marktsicherung“-Haltung geführt. Den beteiligten Instituten ist schließlich klar, dass die Nachfrage nach ihren Forschungsdienstleistungen zurückgehen würde, falls in der Öffentlichkeit der Eindruck entstehen würde, dass die Gefahr von Auto- und insbesondere Dieselabgasen nicht gar so groß ist wie vielfach behauptet.

Deshalb nimmt es nicht wunder, dass manche Exponenten aus diesem Umfeld sich auch in Deutschland als „Anti-Diesel-Aktivisten“ hervortun. Schließlich waren das von Trittin mit grünlinken Parteigängern gespickte Umweltministerium samt des ihm unterstellten Umweltbundesamtes wesentliche Auftraggeber. Drei der profiliertesten dieser Aktivistinnen nahmen das Ergebnis des Diesel-Untersuchungsausschusses zum Anlass, hierzu eine geharnischten Protestnote [EPIDE] veröffentlichen zu lassen.

Unter dem Deckmantel „der Wissenschaft“…

Entlarvend ist bereits der einleitende Satz nach der Zwischenüberschrift „Widerspruch aus der Wissenschaft“: „Nicht nur bei den Linken und Grünen, die der Regierung Versagen vorwerfen, stößt der Bericht auf Kritik. Auch Experten aus den Bereichen Luftverschmutzung und Gesundheit widersprechen den Schlussfolgerungen des Berliner Diesel-Untersuchungsausschusses“. Damit haben sich sowohl das sogenannte Hauptstadtnetzwerk als auch besagte Akademikerinnen bereits bezüglich ihrer ideologischen Positionen eindeutig positioniert. Dass man sich dabei nicht scheut, auch verbal grobes Geschütz aufzufahren, dokumentiert sich in dem einleitenden Absatz: „Der Diesel-Untersuchungsausschuss will keine tödlichen Gefahren von Diesel-Abgaben gefunden haben. Wissenschaftler halten das für absurd“. Eine solche Aussage in diesem Zusammenhang lässt einiges an Chuzpe erkennen, haben doch vor dem Untersuchungsausschuss mehrere hochrangige Experten auf dem Gebiet ausgesagt. Auch gibt es in Deutschland mit der MAK-Kommission und dem Ausschuss für Innenraumrichtwerte gleich zwei hochkarätig besetzte Expertengremien, die zu anderen Schlussfolgerungen kommen. Auch in den USA hat das EPA erst im letzten Jahr bekräftigt, dass es NO2-Konzentrationen unterhalb von 100 µg/m3 für gesundheitlich völlig unbedenklich hält [NAAQS].

Bild 5. Zitat aus dem Bericht des Bundestags-Untersuchungsausschusses zur Dieselaffäre. Prof. Dr. med. Helmut Greim war Leiter des Instituts für Toxikologie und Umwelthygiene der TU München und langjähriger Vorsitzender der MAK-Kommission (Quelle: [BUTA])

…wird Wissenschaft missbraucht

Der Bericht des Untersuchungsausschusses, so die Stellungnahme der drei Akademikerinnen, habe „eine ganze Reihe wichtiger, weltweiter Studien, ignoriert“. Diese Aussage ist gleichbedeutend mit einem Frontalangriff gegen eine Vielzahl anderer Wissenschaftler auf dem Gebiet, darunter renommierte Vertreter der Toxikologie oder der Lungenheilkunde, denen man vorwirft, sie seien bezüglich des Standes der Wissenschaft und Forschung nicht ausreichend informiert.

Bild 6. Auszug aus einer privaten Mail eines Pathologieprofessors an Prof. Dr. Thomas Koch [KOCH]

Und dann lassen die Damen die Katze aus dem Sack, indem sie behaupten: „Epidemiologische Befunde belegen negative gesundheitliche Wirkungen von Stickstoffdioxid bereits bei Konzentrationen von 20 µg/m3 im Jahresmittel oder darunter. Stickoxide haben auch als Vorläufer von Feinstaub und Ozon gesundheitliche Relevanz.“ Damit verlässt das Trio jeglichen „Konsens der Wissenschaft“ ihres Fachgebiets, denn diese Hypothese geht über alles, was WHO und EPA, die EU und selbst das UBA für unbedenklich halten, weit hinaus. Die drei Damen repräsentieren keinesfalls mehr die Positionen „der Wissenschaft“, sondern vertreten eine Extremposition, die man auch als sektiererisch charakterisieren könnte.

Bild 7. Prof. Dr. Andrea Hartwig, Geschäftsführende Direktorin des Instituts für Angewandte Biowissenschaften (IAB) und Leitung der Abteilung Lebensmittelchemie und Toxikologie beim Karlsruhe Institut für Technik, Mitglied und seit 2007 Vorsitzende der MAK-Kommission, Mitglied in zahlreichen nationalen wie auch internationalen Beratergremien ([HARTW])

Nun ist es das gute Recht jedes Wissenschaftlers, eine von der Mehrheit abweichende These zu vertreten. Berufskollegen jedoch so massiv Ignoranz, Absurdität und unzureichende Kenntnis des Stands der Wissenschaft vorzuwerfen, entspricht nicht so ganz der feinen englischen Art. Die Damen dürfen sich daher nicht darüber beschweren, wenn ihre Hypothese im Folgenden ebenfalls einer kritischen Prüfung unterzogen wird.

Wie beeinflusst die NO2-Befrachtung der Luft im Freien die Lebensdauer?

Die Europäische Umweltagentur EEA behauptet, dass Stickoxide in deutschen Großstädten angeblich jährlich über 10.000 Tote verursachen. Prof. Hoffmann hält diese Studie laut Aussage in einem Interview mit der Landesrundfunkanstalt Berlin-Brandenburg „unterm Strich für seriös“ [RBBHO]. Sie basiere „auf solider Wissenschaft“. Zur nächsten Frage über Stickoxidmesswerte an verkehrsreichen Straßen sagte sie: „Im Mittel leben wir alle durch die Belastung durch Feinstaub und Stickoxide zehn Monate kürzer….Wer mit…einer gesunden Lebensweise im Grünen lebt, hat aber im statistischen Durchschnitt ein längeres Leben“. Der „kleine Trick“ bei dieser Aussage bestand übrigens darin, dass sie hier Feinstaub – den moderne Dieselmotoren dank ihres Rußpartikelfilter gar nicht erst ausstoßen – und NO2 zusammenwürfelte. Allein schon diese Argumentationsweise lässt Rückschlüsse auf die Integrität und wissenschaftliche Seriosität von Prof. Hoffmann zu. Deshalb wollen wir uns diese Aussage einmal am Beispiel Deutschlands ansehen.

Bild 8. Zitat aus dem Bericht des Bundestags-Untersuchungsausschusses zur Dieselaffäre. Prof. Dr. Peters ist Direktorin des Instituts Epidemiologie II am Helmholtz Zentrum München (Quelle: [BUTA])

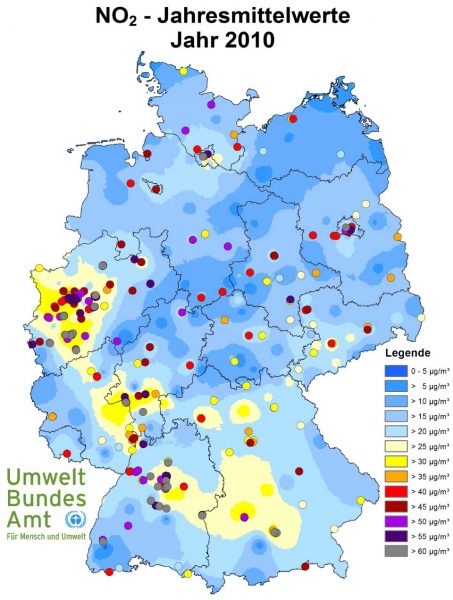

Für die Überprüfung der Hypothese von Prof. Hoffmann ist es am naheliegendsten, die Lebenserwartung von Bevölkerungsgruppen zu vergleichen, die in Gegenden mit unterschiedliche hohen Abgasimmissionen (und somit auch NO2-Gehalten) leben. Als Datenbasis nehmen wir die vom UBA erstellte Deutschlandkarte mit den NO2-Jahremittelwerten für das Jahr 2010 (Bild 6), da für diesen Zeitpunkt auch regionale Daten zur Lebenserwartung der Bevölkerung verfügbar sind.

Bild 9. Vom Umweltbundesamt erstellte Karte mit den 2010 in Deutschland gemessenen Jahresmittelwerten der NO2-Konzentrationen (Grafik: UBA)

In Deutschland wurden 2010 NO2-Jahresmittelwerte zwischen etwa 3-10 µg/m3 in ländlichen Regionen und 90-100 µg/m3 in einigen Großstadt-Hotspots gemessen. Die Farbverteilung auf der Karte weist Mecklenburg-Vorpommern als die am wenigsten durch Abgase belastete deutsche Region aus. Hier sollte man bei Gültigkeit der Hypothese auch die höchsten Lebenserwartungen finden, während die Städter in den industriellen Ballungszentren des Westens – Nordrhein-Westfalen, Rhein-Main-Region sowie der Industriegürtel von Stuttgart bis München – erheblich schlechtere Luft atmen müssen. Die ausgewiesenen NO2-Gehalte sind gleichzeitig auch ein Indikator für alle anderen Abgasbestandteile wie z.B. Feinstaub. Zwischen Regionen mit hohen Abgaswerten und Mecklenburg-Vorpommern müsste sich demnach ein deutliches Gefälle der Lebenserwartung nachweisen lassen. In die Auswertung wurden alle Regionen von Mecklenburg-Vorpommern – Städte ebenso wie ländliche Regionen – sowie das „deckigste Dutzend“ der am stärksten mit NO2 befrachteten westdeutschen Großstädte einbezogen, Bild 10.

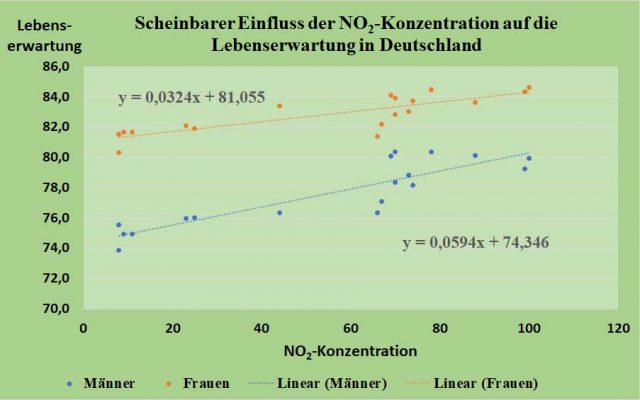

Bild 10. Einfluss der NO2-Jahresmittelwerte der Luft im Freien auf die Lebenserwartung bei Geburt (e0) für Mecklenburg-Vorpommern sowie das „dreckigste Dutzend“ der deutschen Großstädte (Daten: [UBA, LEBE])

Die Auswertung zeigt jedoch das völlige Gegenteil: Statt mit zunehmender Abgasbelastung abzunehmen, steigt die Lebenserwartung sogar an. Sowohl Männer als auch Frauen leben offensichtlich dort deutlich länger, wo die Luft am stärksten mit Abgasen und NO2 befrachtet ist. Die Steigung der linearen Funktion, die angibt, um wieviele Lebensjahre man in belasteter Luft pro zusätzlichem µg/m3 NO2 länger leben dürfte, liegt für Männer bei +0,059 Lebensjahren pro zusätzlichem µg NO2/m3. Bei Frauen ist er etwas niedriger und erreicht lediglich +0,032 Lebensjahre pro zusätzlichem µg NO2/m3.

Anders ausgedrückt bedeutet dies, dass ein Mann in München oder Stuttgart ein um rund fünf Jahre längeres Leben erwarten darf als jemand, der in ländlichen Regionen in MP wie Göhlen, Löcknitz oder Gülzow wohnt. Bei Frauen ist der Unterschied geringer, doch erfreuen auch sie sich einer um fast drei Lebensjahre längeren Lebenserwartung.

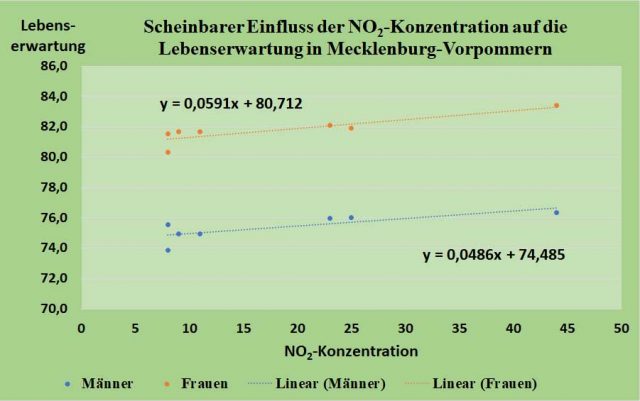

Angesichts dieses Ergebnisses kann man natürlich argumentieren, dieser offensichtliche Widerspruch habe andere Ursachen, beispielsweise negative Einflüsse aus den Mangeljahren in der DDR-Zeit bei den Einwohnern von Mecklenburg-Vorpommern. Um dies zu überprüfen, wurde die gleiche statistische Auswertung ausschließlich für dieses Bundesland durchgeführt, Bild 11.

Bild 11. Einfluss der NO2-Jahresmittelwerte der Luft im Freien auf die Lebenserwartung bei Geburt (e0) für unterschiedliche Wohnorte innerhalb von Mecklenburg-Vorpommern (Daten: (Daten: [UBA, LEBE])

Innerhalb von Mecklenburg-Vorpommern mit seinen deutlich kleineren Städten in einem ansonsten weitgehend ländlich geprägten Umfeld sind die absoluten Unterschiede mit einer Spanne von 8 bis 44 µg/m3 NO2 natürlich erheblich geringer. Dennoch bleibt nicht nur der grundlegende Trend erhalten, auch die Faktoren passen sowohl bei Männern (+0,0496 Lebensjahre pro zusätzlichem µg NO2/m3) als auch bei Frauen (+0,059 Lebensjahre pro zusätzlichem µg NO2/m3) erstaunlich gut zu denen aus der Analyse für die gesamte BRD. Auch in Mecklenburg-Vorpommern lebt man in „dreckiger“, abgasbeladener Stadtluft erkennbar länger als beim ständigen Genuss reiner Landluft.

Die Hypothese zerschellt an der Realität

Diese auf die Schnelle durchgeführte Untersuchung ist zugegebenermaßen recht grob, weshalb in den Grafiken auch ausdrücklich von einem scheinbaren Einfluss die Rede ist. Kein vernünftiger Mensch würde behaupten, dass das Einatmen von Abgasen der Gesundheit zuträglich ist. Es schadet aber ganz offensichtlich bei weitem nicht in dem Umfang, wie es die meisten Medien unterstellen. Unrühmliches aber leider nicht einziges Beispiel ist der Starreporter Jürgen Döschner mit seiner Behauptung: „Deutsche Automafia vergast jedes Jahr 10.000 Unschuldige“ [DOESCH].

Wie auch immer man die Ergebnisse der Analyse interpretieren mag, es bleibt als Tatsache, dass die Hypothese der EEA sowie Prof. Hoffmann schon bei diesem grundlegenden Faktencheck nicht gut davonkommt. Das Vorzeichen stimmt nun einmal nicht, und das ist ein gravierender Mangel, denn es bedeutet zumeist, dass die Hypothese selbst durch aufwendiges Modellieren, Herumrechnen und Simulieren nur zu retten wäre, wenn sich die Effekte sehr scharf trennen ließen. Die entsprechenden Nachweise sind in der Praxis kaum zu erbringen, Bild 12.

Bild 12. Dr. med. Tillmann Jahn, Oberarzt der Klinik für Thoraxchirurgie der St. Vincentius-Kliniken Karlsruhe (Quelle: [JAHN])

Das ist auch nicht verwunderlich, denn andere Faktoren – insbesondere die sozioökonomische Situation – haben offensichtlich eine viel stärkere Auswirkung als Autoabgase. Diese dominierenden Einflüsse auf die Lebensdauer sind seit langem bekannt und bestens dokumentiert: Rauchen, Fettleibigkeit, Bluthochdruck, Diabetes und Bewegungsmangel, siehe auch Bild 4. Diese sind wiederum eng mit der sozioökonomischen Situation verknüpft. Das präzise Herausfiltern einer – wenn überhaupt – dann ziemlich schwachen Einflussgröße wie Autoabgase setzt eine äußerst sorgfältige Selektion der untersuchten Personengruppen voraus. Im Prinzip müssten alle relevanten Faktoren wie das individuelle Verhalten sowie die tatsächliche Jahresbelastung mit allen relevanten Lungenschadstoffen (Innen- und Außenluft) am Wohnort wie auch am Arbeitsplatz ganzheitlich, langzeitig und mit engem Zeitraster untersucht werden. Eine exakte getrennte Erfassung von NO2 und anderen Faktoren wie Feinstaub wären unabdingbar. Dies ist bei den weitaus meisten epidemiologischen Studien nicht der Fall. Wird die Statistik jedoch mit Kuddelmuddel statt mit sauber getrennten Eingangsdaten betrieben, so kommt es zu „mathematischen Zombiezahlen“ wie in den Berechnungen der Europäischen Umweltagentur.

Bild 13. Prof. Dr. med. Helmut Greim war Leiter des Instituts für Toxikologie und Umwelthygiene der TU München und langjähriger Vorsitzender der MAK-Kommission (Quelle: [GREIM])

Dieser grundlegende Mangel kann auch durch sogenannte Metaanalysen – die Zusammenfassung und statistische Untersuchung der Ergebnisse zahlreicher unterschiedlicher Studien – nicht behoben werden. Die allzu häufig unsaubere Trennung der Einflussfaktoren ist ein entscheidender und nicht mehr zu korrigierender Mangel. Unter US-Wissenschaftlern gibt es hierzu eine kurze und sehr treffende Charakterisierung: Shit in, shit out. Auf eine Übersetzung sei hier verzichtet.

Eine wissenschaftliche Selbstdemontage…

Die Position der drei Epidemiologinnen um Prof. Hoffmann kann somit als auch unter Medizinern kaum glaubwürdig eingestuft werden. Umso verwunderlicher ist es, dass sie dennoch mit derartiger Verve an die Öffentlichkeit drängen und zugleich Fachkollegen derart heftig und teils unter der Gürtellinie („absurd“) attackieren. Zudem nutzen sie die gleichen PR-Netzwerke ökosozialistisch geprägter Journalisten wie die Autofeinde von der Deutschen Umwelthilfe, um sich wo immer möglich als „Stimme der Wissenschaft“ zu gerieren. Statt wie unter Wissenschaftlern üblich ihre Positionen im Rahmen von Veröffentlichungen und Tagungsvorträgen zu vertreten, bevorzugt Fr. Prof. Hoffmann augenscheinlich das Megaphon der Medien. Leider zeigt die Erfahrung, dass man damit in unserer mediendominierten Öffentlichkeit leichter Karriere machen kann als mit seriöser wissenschaftlicher Betätigung: „Wer lauter schreit, bekommt leider Recht“. Insbesondere der RBB fällt dadurch auf, dass er Prof. Hoffmann ungeachtet ihrer eindeutig nicht repräsentativen Positionen in Sendungen bzw. Interviews als einzige „Vertreterin der Wissenschaft“ zu Wort kommen lässt. Im Prinzip wäre dies ein Fall für den Rundfunkrat.

Das traurige an dieser unangemessenen und den Gepflogenheiten der Wissenschaft widersprechenden Verhaltensweise ist, dass dies auf Dauer nachteilige Auswirkungen auf das gesamte Fachgebiet haben dürfte. Dabei besteht an der Notwendigkeit epidemiologischer Forschung an sich keinerlei Zweifel, sofern sie wissenschaftlichen Kriterien genügt. Nimmt jedoch die wissenschaftliche Reputation des Fachgebiets durch die beschriebenen Eskapaden Schaden, so kann sich dies nachteilig auch auf die Bereitschaft zur Forschungsförderung auswirken.

Fakten und „Faktenfinder“

Die hier dargelegten Probleme wurden bisher von den Medien ignoriert. Stattdessen hat man sich dort einen regelrechten Wettbewerb in der Frage geliefert, wer am tollsten auf den Dieselmotor und die Individualmobilität eindreschen konnte, wie sich ja auch kürzlich bei der perfiden Diffamierungskampagne gegen Wissenschaftler der medizinischen Fakultät an der RWTH Aachen gezeigt hat.

Bisher hat man sich dort alles andere als kritisch-investigativ mit dem Thema NO2-Belastung des Bürgers beschäftigt. Stattdessen übernimmt man einfach die Positionen von Hendricks und dem UBA, als seien deren Ansichten der Weisheit letzter Schluss. Eine eigenständige kritische Wertung von Daten und Hintergründen ist nicht einmal in Ansätzen erkennbar. Dies bestätigt die bereits bisher gemachte Erfahrung, dass die Mehrzahl der Medien – allen voran die Fernsehanstalten ARD, ZDF und ihre Landesdependancen – beim sogenannten „Diesel-Skandal“ einseitig, parteiisch und irreführend berichtet. Statt um Ausgewogenheit und Sorgfalt bemüht man sich offenkundig eher darum, das Thema so darzustellen, wie bestimmte Bundesbehörden sowie die etablierten Parteien es gerne haben möchten. Abweichende Meinungen von Fachleuten, Medien, Journalisten oder Bloggern werden ignoriert. So leistet man dem ideologischen Ziel der Deindustrialisierung Deutschlands durch „Dekarbonisierung der Volkswirtschaft“ Vorschub. Der Diesel ist dabei nur das erste Opfer. Die Vernichtung der deutschen Automobilindustrie wird anschließend auch beim Benziner weitergehen, und zwar alternativlos. Die jetzt wohl unausweichliche „GroKo“ ist für Deutschland ein sehr schlechtes Omen.

Fred F. Mueller

Demnächst folgt Teil 12

Quellen

[BUTA] Drucksache 18/12900 – 492 – Deutscher Bundestag – 18. Wahlperiode

[DOESCH] https://www.welt.de/vermischtes/article167196737/Am-Ende-loescht-der-ARD-Reporter-den-geschmacklosen-Tweet.html

[DUKE] http://dailycaller.com/2017/07/03/epa-funded-research-lab-accused-of-fabricating-data-on-respiratory-illnesses/

[EPA] https://www.epa.gov/isa/integrated-science-assessment-isa-nitrogen-dioxide-health-criteria

[EPIDE] https://www.gesundheitsstadt-berlin.de/wissenschaftler-widersprechen-berliner-diesel-untersuchungsausschuss-11501/

[FAKT] http://faktenfinder.tagesschau.de/inland/stickstoffdioxid-111.html

[GREIM] https://m.focus.de/finanzen/karriere/berufsleben/dieselpanik-wegen-grenzwertluege-politik-ignoriert-zweifel-am-grenzwert-40-mikrogramm_id_7378545.html

[HARTW] http://www.dfg.de/download/pdf/dfg_magazin/forschungspolitik/gesundheitsschutz/cv_hartwig_de.pdf

[JAHN] Jahn, T.: Vortrag Wunderwerk Lunge – eine Analyse der Gefährdungspotentiale. Tagung Motorische Stickoxidbildung NOx, Ettlingen. 2018

[KOCH] https://www.ifkm.kit.edu/downloads/Focus_Antworten_v2.0.pdf

[LEBE] http://www.lebenserwartung.info/index-Dateien/regdiff.htm

[NAAQS] https://www.epa.gov/no2-pollution/primary-national-ambient-air-quality-standards-naaqs-nitrogen-dioxide

[RBBHO] https://www.rbb24.de/politik/thema/2017/abgasalarm/beitraege/interview-umweltmedizinerin-barbara-hoffmann.html

[RUHR5] http://ruhrkultour.de/diesel-verteufelung-krieg-gegen-das-eigene-volk/

[RUHR6] http://ruhrkultour.de/die-lueckenmedien-im-glashaus-6/

[SCHKO] https://scheinkorrelation.jimdo.com/

[UBA] https://www.umweltbundesamt.de

[WHO2] http://www.euro.who.int/en/health-topics/environment-and-health/air-quality/publications/2013/review-of-evidence-on-health-aspects-of-air-pollution-revihaap-project-final-technical-report