Generisches Statement zum Stand der Klimaforschung in Hinblick auf die Belastbarkeit der CO2-Modellierungsvorhersagen und der daraus gezogenen wissenschaftlichen und politischen Schlussfolgerungen[1]“

Dr. rer nat Philipp Lengsfeld, re:look climate gGmbH

Dipl-Ing Michael Limburg, EIKE

Hauptproblem: Die wissenschaftliche Begründung für die Forderung nach Dekarbonisierung – CO2-These basiert nur auf Modellierungen und ist als Haupterklärung vermutlich falsch

Die wissenschaftliche Großkontroverse „Klima“ fängt schon bei der Bezeichnung an: Durch die Bezeichnung als „menschgemachter Klimawandel“ (anthropogenic global warming, AGW) wird die hier in Rede stehende CO2-Hypothese schon inhaltlich vorgeprägt. Eigentlich müsste sie gemäß des wissenschaftlichen Kerns im Deutschen korrekterweise „Durch von Menschen eingebrachte zusätzliche Treibhausgase verursachte zusätzliche Erderwärmung“ heißen – zur wissenschaftlich-argumentativen Vereinfachung benutzen wir in diesem Papier den Terminus CO2-Erdwärmungs-These.

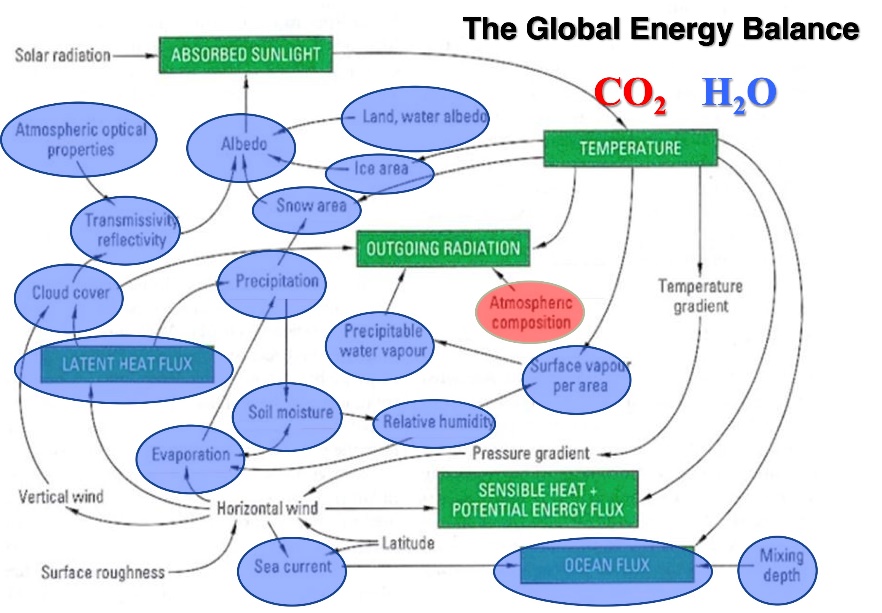

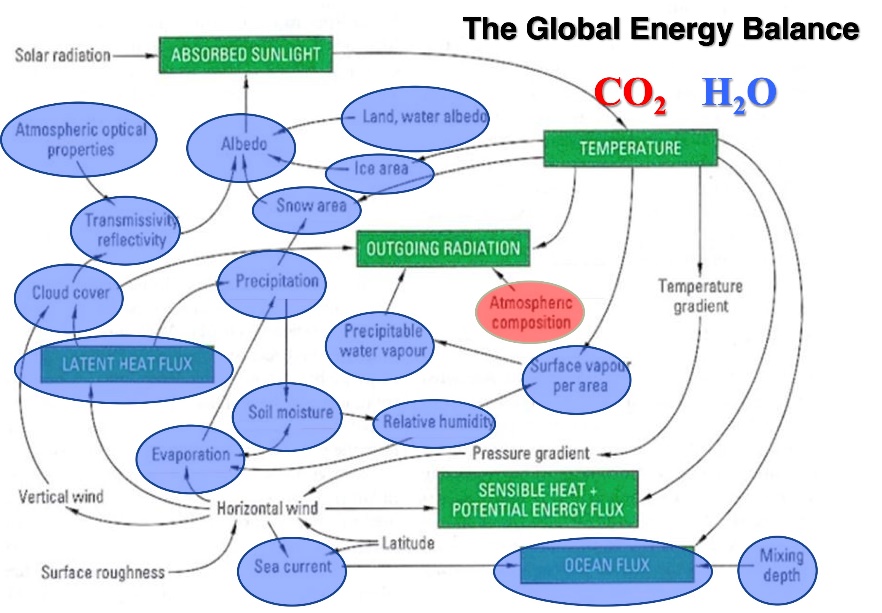

Die CO2-Erdwärmungs-These ist ein rein Modell-basiertes Konstrukt. Die Modelle fußen auf Annahmen, die im Kern von den komplizierten, mindestens 18 Grob-Prozessen, die an einem Energiegleichgewicht der Atmosphäre beteiligt sind und die alle mit und untereinander in Wechselwirkung stehen, überdies in Zeitskalen von wenigen Tagen bis > 100.000 Jahren (im Anhang befindet sich in Abb. 1 eine Übersicht), nur einen einzigen, nämlich die atmosphärische Zusammensetzung und darin wieder den CO2 Anteil[2] als Hauptmechanismus (Treibhausgas-Annahme) voraussetzen, der dann in den komplexen mathematischen Klimamodellen zu Erwärmungsszenarien gerechnet wird.

Abb. 1: Qualitative Darstellen der Hauptprozesse der atmosphärischen Energiebilanz nach W.Soon

Alle momentanen Modelle leiden aus unserer Sicht an dieser fundamentalen Schwäche: Der angenommene zentrale Einfluss des CO2 geht als Hauptmechanismus in die Modellierung ein und damit wird über die Annahme der Modellierung schon deren Ergebnis vorweggenommen. Das ist ein Zirkelschluss.

Und das auch unabhängig von der Frage, ob der zu Grunde liegenden Mechanismus „Treibhaus-Effekt“ und dessen abgeleitete Konsequenz „Zunahme des Treibhaus-Effekts bei Zunahme der Treibhausgaskonzentration“ im Kern korrekt ist oder nicht. Wir können für die hier vorgelegte Argumentation durchaus annehmen, dass ein merkbarer temperature forcing effect bei Verdoppelung des CO2-Gehalts in der Luft existiert, obwohl wir schon anmerken, dass es ernstzunehmende wissenschaftliche Positionen gibt, die sagen, dass ein Treibhaus-Effekt für die Erklärung der Grunddaten des Weltklimas, insbesondere der globalen Mitteltemperatur nicht notwendig ist.

Unser Hauptkritikpunkt ist ganz eindeutig, dass während der Einfluss des CO2 über verschiedene diverse Szenarien (RCP2.6-RCP8.5) variiert wird, mit teilweise hanebüchenen sozio-ökonomischen Annahmen, werden andere (meist natürliche) Klimamechanismen wenig oder gar nicht in der momentanen Modellierung beachtet. Auf diese Weise entsteht zu einem komplexen Thema eine total verengte Diskussion, die sich praktisch nur noch um CO2-Anteile dreht.

CO2-Thesen Dramatik zerfällt bei normaler Verweildauer von CO2 in der Atmosphäre

Aus unserer Sicht ist darüber hinaus eine der zentralen Kernschwächen der CO2-Modellierungen die angenommene lange Retentionszeit für CO2 in der Atmosphäre – die momentan akzeptierte Denkschule ist das sogenannte Berner Modell. Durch eine angeblich sehr lange Verweildauer von Teilen des CO2 in der Atmosphäre (in der Kommunikation werden gerne drastische Vokabeln, wie „Endlagerung“ oder „Verklappung“ von CO2 in der Atmosphäre bemüht) ergibt sich bei konstanter weiterer Emission ein exponentieller Anstieg des CO2 in der Atmosphäre – je nach Feintuning prognostizierten die Wissenschaftler vom „Berner Modell“ eine CO2-Konzentration von 1000ppm in der Atmosphäre im Jahr 2100. Das wäre ein 2.5-fach höherer Wert als heute (420 ppm) und der dreifache Wert des CO2-Niveaus der Nachkriegszeit. Die Retentionsannahmen des Berner Modell werden in der Wissenschaft kontrovers diskutiert – die entgegengesetzte, einfache Annahme, die sich auch mit Messdaten aus französischen Atomtests deckt, geht von einer Halbwertszeit des CO2 in der Atmosphäre von 25-40 Jahren aus – in diesen Rechnungen sättigt sich die CO2-Konzentration bei gleicher anthropogener Emission im Jahre 2100 bei z.B. 500 ppm (Abb. 2 im Anhang verdeutlicht diesen Effekt im direkten Vergleich).

Zwischen diesen beiden Extremannahmen gibt es diverse Schattierungen gemäß Annahmen der Senken und ihrer Leistungen, deren prognostizierte CO2-Anstiege dann natürlich ebenfalls zwischen diesen beiden Extremvarianten liegen.

Selbstredend verändern sich die Erwärmungsprognosen der Modellierungen in den unterschiedlichen Szenarien drastisch, selbst wenn alles andere unverändert bleibt.

Erstes Fazit:

Die CO2-These ist ein Ergebnis von Modellierungen, deren Output schon über den Input festgelegt wurde. Das ist ein Zirkelschluss. Und für Modellierung von Klima absolut unterkomplex.

Abb. 2: CO2-Projektionen gemäß verschiedener Modellannahmen führen im Jahr 2100 zu völlig unterschiedlichen Ergebnissen.

Aber selbst, wenn man alle anderen Annahmen akzeptiert (was wir definitiv nicht tun), bleibt von der CO2-Erwärmung wenig bis nichts, wenn die „Endlagerung“s-Annahme des Berner Modells sich als falsch erweisen sollte (wovon wir fest überzeugt sind). Die CO2-Thesen Dramatik fällt bei normaler Verweildauer von CO2 in der Atmosphäre praktisch in sich zusammen.

Unteraspekt: Anteil des menschlichen CO2 am Anstieg der Keeling-Kurve

Ein großer Verdienst der Klimaforschung der letzten Jahrzehnte ist die systematische Erhebung des CO2-Gehalts in der Atmosphäre vor allem durch die Messstation in Mauna Loa, Hawai, die sogenannte Keeling-Kurve – seit Beginn der Messung 1958 ist der CO2-Gehalt in der Atmosphäre von 315 ppm auf momentan 425 ppm gestiegen – ein ca. 100 ppm-Anstieg in 70 Jahren.

Gemäß der momentan akzeptierten Lehrmeinung wird angenommen, dass praktisch der gesamte Anstieg der Keeling-Kurve seit Start der Messungen menschengemacht sei (also durch die Verbrennung fossiler Brennstoffe verursacht wird). Auch diese These wird aber in Frage gestellt. So vermutet unter anderem der deutsche Wissenschaftler Hermann Harde, dass der Anteil des durch die Menschen in die Atmosphäre eingebrachten CO2 am Anstieg der Keeling-Kurve maximal bei 5 Prozent liegt.

Dass sich der unbestrittene Einbruch in der CO2-Emission im Zuge der globalen Covid-Krise nicht wirklich in der Keeling-Kurve abbildet, ist ein weiterer Hinweis, dass der Anteil der anthropogenen Emission am Keeling-Kurven-Verlauf überschaubar sein dürfte.

Abb. 3: Meyers Konversationslexikon 4. Auflage, 1885-1890. 2. Band: Atlantis – Blatthornkäfer, S.12

Und wie sehr viele Lehrsätze in der momentanen Klimaforschung ist auch diese vermeintliche Gewissheit überhaupt nicht gesichert: Sind die CO2-Werte der Neuzeit (310-450 ppm) im Vergleich zum z.B. dem 19 Jahrhundert überhaupt erhöht? Die Enceclopedia Britannica, aber auch Meyers Konversationslexikon listeten Ende des 19. Jahrhunderts bereits CO2 Anteile von rd. 400 ppm auf mit einer Schwankungsbreite von 370 bis 620 ppm (ein entsprechender Beleg ist im Anhang als Abbildung 3 angefügt).

Die momentane Lehrmeinung postuliert stattdessen, dass der Neuzeit-CO2-Wert drastisch oberhalb eines CO2-Korridors der letzten 800 tausend Jahre läge und versucht die CO2-These mit einer konstruierten CO2-Hockeyschlägerkurve glaubhafter zu machen. Dabei handelt es sich um eine Aneinanderreihung von Datensätzen aus Eisbohrkernen für die Paleodaten, Übergangsdaten und aktuellen Messdaten. Wir beschäftigen uns mit dieser Hockeyschlägerkurve weiter unten etwas ausführlicher, postulieren aber, dass deren Belastbarkeit massiv angezweifelt werden muss.

Zweites Zwischenfazit:

Obwohl sich alles um CO2 dreht ist, sind viele fundamentale Fragen, wie die Retentionszeit, der Vergleich zu Paleodaten oder auch der Anteil der fossilen Verbrennung an dem in den letzten 70 Jahren gemessenen CO2-Anstieg in der Atmosphäre überraschend unklar.

Echte CO2-Thesen Dramatik entsteht durch Kopplung mit feedback und Kipppunkten

Die wahre Dramatik der CO2-Szenarien ergibt sich durch die Hinzunahme von diversen feed back-Verstärkungsmechanismen (vor allem über Wasserdampf, einem wesentlich potenteren Treibhausgas, als das CO2) und durch die Kombination mit den sogenannten Klima-Kipppunkten.

Ein zentraler Beitrag der deutschen Klimaforschung, insbesondere des eigens für die Thematik gegründeten PIK, dem Potsdamer Institut für Klimafolgenforschung ist die Einbringung des Konzepts „Kipppunkte“ in die internationale Klimadiskussion – „Kipppunkte“ sind hier irreversible dramatische Prozesse, die theoretisch durch steigenden Global- Temperaturen ausgelöst werden könnten. Diese Kipppunktszenarien haben dramatische Wirkung. Zum Beispiel im Szenario „Schmelzen des Grönland-Eises“ oder „Schmelzen signifikanter Teile des antarktischen Eisschilds“ führt zu bekannten Meeresanstiegs-Schreckensszenarien – 1986 „prophezeite“ der Spiegel basierend auf einem vermutlich fehlinterpretierten Thesenpapier des Arbeitskreises Energie der Deutschen Physikalischen Gesellschaft: Im Jahr 2040 sind wichtige Metropolen, wie New York, Rom, Hamburg vom Meer verschlungen.

Wir haben also eine Dreifach-Steigerung in den Modeliierungs-Schreckensszenarien: Mit extremen sozio-ökonomischen Maßnahmen wird der Treibhausausstoß hochgerechnet, durch Schärfung der feedback-Effekte wird der Temperaturanstieg der Modelle forciert und schlussendlich wird mit der Kombination mit Kipppunkt-Szenarien eine absolut düsteres Zukunftsbild gemalt. „hot house earth“/“Heißzeit“ nennen das PIK und ihre engsten Miststreiter diese Art Endzeitszenarien.

Zum Glück gibt es auch in der deutschen Wissenschaft besonnenere Stimmen: Prof. Jochem Marotzke, Direktor des Hamburger Max-Planck-Institut für Meteorologie und in dieser Position einer der wichtigsten Klimaforscher des Landes hat sich jedenfalls mehrfach deutlich gegen die Überbetonung des Themas Kipppunkte positioniert.

Aus unserer Sicht handelt es sich bei den Klima-Kipppunkten um sehr geschickte Wissenschaftsangstmache praktisch ohne Relevanz, ganz sicher nicht für einen sinnvollen wissenschafts-politischen Referenzrahmen von 75 Jahren, also bis 2100.

Zwischenfazit CO2-These:

Die CO2-These ist eine rein Modell gestützte Konstruktion, die ein Zirkelschluss ist (es wird das als Voraussetzung in die Modellierung reingesteckt, was dann als Ergebnis rausmodelliert wird). Trotz jahrelanger Forschungen sind fundamentale Basics (z.B. Retentionszeit, Anteil des Menschen am Anstieg der Neuzeit, Vergleich zu Paleodaten) viel unklarer, als in der Öffentlichkeit angenommen.

Die eh schon aufgebauschte Dramatik der CO2-Szenarien entsteht vor allem durch die Kipppunkte- Ergänzung (die nicht Teil der Modellierungen sind) – letztlich ist die CO2-Weltungergangs-These ein Angst-Modellierungs-Turm auf extrem wackeligen Grundbausteinen – auch nur ein loser Stein darin lässt alles in sich zusammenfallen. Und das ist im Kern eine sehr gute Nachricht.

Schlussfolgerung für „Dekarbonisierung“s-Strategien: Mitigation hinfällig

Es gibt aus unserer Sicht keine Rechtfertigung für eine Dekarbonisierungspolitik. Die sogenannte „Mitigation“s-Strategie ist insgesamt hinfällig.

Konkret ist das Konzept der „Carbon-Budgets“ (angeblich noch verbleibenden Restmenge an CO2, die noch in die Atmosphäre kommen kann damit die politisch vorgegebenen Erwärmungswerte nicht überschritten werden) hinfällig. Die dazugehörigen Doomsday-Uhren, welche die verbleibende Zeit bis zur Erschöpfung des „Carbon-Budgets“ runterzählen („time left until CO2 budget is depleted“, z.B. des MCC Berlin) und Stand Dezember 2024 für das sogenannte 1.5°C-Ziel momentan noch ca. 4,5 Jahre ausweisen, können getrost abgestellt werden.

CO2-Senkungsziele, CO2-Steuern, CO2-Zertifikatsmodelle sind ohne wissenschaftlichen und damit letztlich auch politischen Gegenwert und müssen umgehend eingestampft werden.

Die technisch schon ausgereifte CCS-Technik (CO2-Abscheidung z.B. bei Kohleverbrennung und deren „Endlagerung“) ist weder notwendig noch zielführend und darf politisch nicht weiterverfolgt werden.

Attributionsforschung ohne Basis

Eine aktuelle Spielwiese der Klimamodellierung und der Klimawissenschaftspolitik ist die sogenannte Attributionsforschung, in welcher versucht wird, den Anteil von CO2 (und damit z.B. eine historische Schuld von Hauptemittenten der letzten 100 Jahre) an regionalen Wetterkatastrophen zu extrahieren – selbstredend bleibt von einer Attribution in der Jetztzeit nichts übrig, wenn sich die CO2-Modell-Katastrophenszenarien der Zukunft in Luft auflösen.

Intervention/Geoengineering ungerechtfertigt und brandgefährlich

Wenn es für „Dekarbonisierung“ und Mitigation keine Rechtfertigung gibt, dann sind die noch viel extremeren „Intervention“s-Strategien („Geoengineering“), insbesondere die Entnahme von CO2 aus der Luft und jegliche Abscheide- und Einlagerungstechniken unnötig und falsch. Alle diese Konzepte sind nicht nur unbezahlbar, sondern bergen massive Risiken für nicht intendierte negative Effekte.

Anpassung, „Adaptation“ ist die richtige Klima-Strategie

Anpassung, „Adaptation“, eine kluge „wait-and-see-and-better-understand-and-prepare-where-necessary“-Strategie ist dagegen absolut sinnvoll und zeitgemäß. Anpassun, „Adaptation“ ist die richtige „Klima“-Strategie – in jedem Land, in jeder Region.

Nebenaspekt-Probleme:

T-Hockeyschlägerkurve ohne Substanz

Michael Mann und Mitarbeiter sind die Urheber der wohl bekanntesten Klima-Hockeyschlägerkurve – über den Zeitraum der vergangenen 1000 Jahre (später 2000 Jahre) wurden Temperaturproxies von dieser Arbeitsgruppe so zusammengestellt und mit aktuellen Messdaten kombiniert, so dass der Eindruck eines dramatischen Hockeyschlägerverlaufs entsteht – der T-Verlauf ist über Hunderte Jahre konstant (bzw. sogar leicht fallend), um dann mit der Industrialisierung dramatisch anzusteigen – quasi die Visualisierung der CO2-Erwärmungsthese – die zwischenzeitlich sehr berühmte Grafik zierte auch mal das Deckblatt eines IPCC-Berichts (TAR 2001).

Mittlerweile ist diese aus der Club-of-Rome-Schule übernommene Mann-Hockeyschlägerkurve völlig entzaubert – ohne aktuelle Temperaturmessungen würde es überhaupt keinen auffälligen Verlauf geben.

Nebennebenaspekt: Mit der Hinfälligkeit der Hockeyschläger-Originalkurven entfällt natürlich auch jegliche Dramatik bei den einige Jahre sehr beliebten Kult-T-Stripes (ein solcher T-Stripe ziert wohl immer noch den Hauptbahnhof von Cottbus). Auch die Temperaturstreifen auf Straßenbahnen und Kaffeetassen können getrost eingemottet werden.

CO2-Hockeyschlägerkurve unüberprüft

Es gibt eine ähnlich dramatisch aussehende Hockeyschlägerkurve für den CO2-Anstieg, allerdings basierend auf ganz anderen Daten und von Auswertungen anderer Gruppen – auch hier ergibt sich der Hockeyschlägerverlauf nur durch die Kombination verschiedener Datensätze aus völlig unterschiedlichen Quellen (Eisbohrkernen, kombiniert mit Firneis, kombiniert mit Atmosphärendaten) – diese CO2-Kurve ist aus unserer Sicht unzulässig, weil hier die Datensätze verschiedener Herkunft zusammengespleist wurden.

Es gibt aber auch an den Eisbohrkernmessungen aus der Antarktis (und in Grönland) massive wissenschaftliche Kritik, die aber, vielleicht weil sie schon länger zurück liegt, aus der momentanen Diskussion fast komplett verschwunden zu sein scheint. So zeigte bspw. Jaworowski um 1992, dass ca. 20 Prozesse biologischer, chemischer und physikalischer Art den CO2 Gehalt in den Eisbohrkern-Proben dauerhaft beeinträchtigen. Jaworowski äußert gut unterlegte Zweifel an den grundsätzlichen Charakteristika der CO2-Eisbohrkerndaten, insbesondere an den Absolutwerten (Schwankungen in den letzten 800.000 Jahren immer nur zwischen 180 und 280 ppm) und anderen Kerncharakteristika.

Es ist mehr als unwahrscheinlich, dass der dramatische CO2-Kurven-Hockeyschlägerverlauf einer kritischen Überprüfung Stand hält.

Klima hat sich immer gewandelt

Was wie eine Banalität klingt und deshalb angstkommunikatorisch leicht skandalisiert werden kann, ist aus unserer Sicht die wissenschaftliche Wahrheit: Das Klima auf der Erde hat sich immer verändert, es gab Temperatur- und CO2-Veränderungen. Es ist nicht nur alles andere als eindeutig, sondern aus unserer Sicht sogar ziemlich wahrscheinlich, dass wir in den letzten 100 Jahren überhaupt keine irgendwie ungewöhnliche Entwicklung von Temperatur oder CO2 beobachten.

Für die Zahl der Extremwetterereignisse ist dies ja längst belegt – es hat hier keinen signifikanten Trend in den letzten Jahrzehnten gegeben.

Es gibt keinen Klima-„Konsens“ in der Wissenschaft

Eine geschickt konstruierte Fata Morgana ist der sogenannte Klima-„Konsens“.

Braucht Wissenschaft für den Erkenntnisfortschritt überhaupt einen „Konsens“? Eher im Gegenteil, etablierte Lehrmeinungen werden von disruptiver wissenschaftlicher Erkenntnisgewinnung immer wieder in Frage gestellt und müssen sich immer wieder neu bewähren – deshalb ist die Konstruierung eines vermeintlichen „Konsens“ aus unserer Sicht eine wissenschafts-kommunikative und wissenschafts-politisch ziemlich fragwürdige Aktion.

Eine Wissenschaft im „Konsens“ ist für uns eine tote Wissenschaft. Die Lehrmeinung verkommt zu einer Dogmatik und Ideologie oder im extremsten Falle zu einer (Ersatz-)Religion. Wir scheinen davon bei „Klima“ nicht mehr weit entfernt: Die Öffentlichkeit und die Wissenschaft sollen die CO2-Thesen „glauben“, Wissenschaftler, die einer normalen wissenschaftlichen Aufgabe nachgehen, nämlich der konstanten Herausforderung der jeweils etablierten Lehrmeinung, werden als „Leugner“ diffamiert. Wer als Wissenschaftler echte Fakten und Daten „leugnet“, ist kein Wissenschaftler – der Vorwurf der „Leugnung“ ist letztlich ein Anschlag auf die Wissenschafts- und Forschungsfreiheit.

Aber egal ob man einen „Konsens“ überhaupt braucht: In jedem Falle gibt es einen Klima-„Konsens“ in der Wissenschaft nicht: Sowohl der geschickt über die Analyse von Abstrakts wissenschaftlicher Veröffentlichungen konstruierte Oreskes-Cook-Konsens (das ist der berühmte 97.1%, mittlerweile 99%-Konsens) ist substanzlos, als auch der eher uninspirierte „Konsens“ der mittels Suggestivfragen-„Surveys“ und geschickter Filterung daneben gestellt wurde.

Dass der IPCC als politisch kreiertes Gremium von selektiv berufenen Wissenschaftlern keinen „Konsens“ ermitteln kann, ist dagegen selbsterklärend. Wer trotzdem darauf besteht, dass der IPCC einen „Konsens“ repräsentiert erliegt dem nächsten Zirkelschluss, denn das explizite Mandat des IPCC war und ist es, den anthropogenen Klimawandel zu analysieren.[3]

Rolle der Industrie heillos überzogen (Behauptung systematischer Desinformationskampagnen)

Auch die angebliche jahrzehntelange Desinformationskampagne der Ölindustrie ist im Kern eine geschickte Konstruktion der gleichen Arbeitsgruppe, die auch Urheber des Klima-„Konsens“-Claims ist („#exxonknew“). Diese konstruierte Kampagne gab es so nicht.

Eine Zögerlichkeit und Unsicherheit von Industrie im Umgang mit NGO-Vorwürfen und Kampagnen und einem sich plötzlich massiv gegen sie wendenden gesellschaftlichen und politischen Klima und ein gerade in der Vergangenheit stark ausgeprägter Hang zur Intransparenz und Schönfärberei ist dagegen ein Charakteristikum von Industrie alter Prägung und triff sicherlich auch auf die „fossile“ Industrie der Vergangenheit zu. Leider kann dieser Mechanismus momentan auch wieder massiv bei der PV- und Windindustrie beobachtet werden. Moderne Industrie ist transparent, compliant, unterstützt und fördert gute Wissenschaft und hoffentlich auch vernünftige Regulatorik.

Was es aber auf jeden Fall gab, war der Club of Rome und sein sehr wirkmächtiger „Grenzen des Wachstums“-Angst-Untergangs-Modellierungen-Klassiker (Träger des Friedenspreises des Deutschen Buchhandels 1973).

Und es gab und gibt jahrzehntelangen, systematischen Aktivismus von Teilen der Wissenschaft (ein prominentes Beispiel sind die Professoren Schellnhuber und Rahmstorf vom PIK) und massive, mittlerweile gesamtgesellschaftliche kommunikative Propaganda, insbesondere von Seiten der Grünen/Linken und der Wind und Solarindustrie.

Es gibt anthropogene Einflüsse auf Wetter und Klima, die aber regional wirken

Es ist völlig unstrittig, dass es anthropogene, lokale, regionale Klima- und Wetteränderungen gibt und gab. Eine berühmtes Lernbeispiel ist die Katastrophe durch die Zerstörung des Aralsees (eines Binnenmeers) durch exzessive Wasserbewirtschaftung der anliegenden Wüstengebiete in Usbekistan (Baumwolle) und Kasachstan (Reis) in der Sowjetzeit, die auch zu einer massiven Änderung des regionalen Klimas führte.

Auch in Mitteleuropa haben wir durch massive Änderungen in Luftverschmutzung Einflüsse auf das Wetter: Waren die 50-80iger Jahren durch massive Smogereignisse gekennzeichnet, so hat die Reduzierung der Luftverschmutzung zu einem massiven Anstieg der Sonnenstunden geführt – dies in Kombination mit massiver Landnutzung (z.B. urbane Räume, Straßen- und Autobahninfrastruktur, aber neuerdings auch riesige Solarfelder) hat durchaus erheblichen Anteil daran, dass es in Deutschland in den letzten Jahren lokal wärmer geworden ist.

Wichtig ist auch der Urban Heat Island Effekt, der recht gut erforscht ist. Auf Grund des globalen Bevölkerungsanstiegs und der starken Urbanisierung kam es zu einem massiven Anstieg der Zahl lokaler Wärmeinseln in deren Zentren teilweise deutlich erhöhte Temperaturen herrschen. Da inzwischen ca. 50 % der heute mehr als 8 Mrd Menschen in urbanen Räumen leben, beeinflusst, bzw. erschwert dieser Effekt auch massiv die systematische Dokumentation der Temperatur in der nicht vom Menschen massiv überformten Natur der jeweiligen Region.

Einfluss auf regionales Wetter- und Klima durch massiven Windkraftaufbau?

Keine Energieerzeugung ist ohne Nebeneffekt („keine Wirkung ohne Nebenwirkung“) – es gibt deshalb keine „grüne“ Energie.

Auch die sehr flächenintensiven, ineffizienten PV- und Windkraftanlagen haben Einfluss auf die lokale Umgebung – im Falle von Wind ist dieser Effekt in Europa aus unserer Sicht noch völlig unterbewertet – das massive Ernten von Wind führt zu lokalen und regionalen Windabnahmen, deren Wetter- und Klimafolgen (z.B. lokale, regionale Dürre oder auch Starkregenereignisse) momentan noch viel zu wenig beachtet werden – aber mit relativ wenig Aufwand modelliert werden könnten.

Für ganz besonders Ängstliche: „Adaptation“ ist anderes Wort für klugen Katastrophenschutz

Für Staaten oder Staatengemeinschaften, die immer noch an ein Restrisiko „Erderwärmung“ „glauben“ empfiehlt sich die konsequente Anwendung der generische Strategie der Anpassung, die folgende fundamentale Aspekte aufweist: Adaptation ist (nach S. Koonin)

- Effektiv (weil auf die jeweilige Situation -örtlich u zeitlich- angepasst)

- Agnostisch (es ist egal ob Klimaänderung menschgemacht oder natürlich ist)

- Proportional (z.B. höhere Dämme in konkret gefährdeten Gebieten)

- Lokal

- Autonom (es kann unabhängig von anderen Maßnahmen passieren)

Klimaforschung sollte sich fokussieren

Klimaforschung ist momentan massiv überfördert. Wirklich gute regionale und lokale Wettervorhersagemodelle sind wissenschaftlich und gesellschaftlich relevant, müssen aber alle natürlichen und anthropogenen Einflüsse abbilden (z.B. exzessiven Windausbau). Grundlagenforschung zu Klimafragen ist genauso interessant und relevant wie jede andere Grundlagenforschung.

Anhang:

Abb. 1: Qualitative Darstellen der Hauptprozesse der atmosphärischen Energiebilanz nach W.Soon

Abb. 2: CO2-Projektionen gemäß verschiedener Modellannahmen führen im Jahr 2100 zu völlig unterschiedlichen Ergebnissen.

Abb. 3: Meyers Konversationslexikon 4. Auflage, 1885-1890. 2. Band: Atlantis – Blatthornkäfer, S.12

- Dieses Papier ist ein forschungspolitisches Thesenpapier und verzichtet bewusst auf komplette Referenzen – alle Quellen sind für die Fachleute identifizierbar und überprüfbar ↑

- Weitere Treibhausgase werden in dieser Diskussion als CO2-Äquivalent behandelt und nicht in Tiefe separat diskutiert. ↑

- “The role of the IPCC is to assess on a comprehensive, objective, open and transparent basis the scientific, technical and socio-economic information relevant to understanding the scientific basis of risk of human-induced climate change, its potential impacts and options for adaptation and mitigation.” (PRINCIPLES GOVERNING IPCC WORK, approved 1998, last amended 2013) ↑