Uli Weber

Von UN und IPCC über Politik, Medien, zehntausende GONGOs, MINT- und MINT-ferne Wissenschaften, Kirchen aller Konfessionen sowie demokratische Institutionen bis hin zum Bundesverfassungsgericht ist man einhellig der Meinung, die Welt würde verglühen, wenn der Mensch weiterhin fossile Energieträger zur Aufrechterhaltung seiner industriellen Kultur verwendet, weil er damit den CO2-getriebenen „natürlichen atmosphärischen Treibhauseffekt“ verstärken würde. Wenn Kirchen und Wissenschaft an einem Strang ziehen, muss man sehr vorsichtig sein. Und wenn dann noch ein hohes Gericht dazu kommt, dann beginnt der alte Galileo schon mal vorsichtshalber im Grab zu rotieren. Also fangen wir mal ganz von vorne an. Der sogenannte „natürliche atmosphärische Treibhauseffekt“ soll durch sogenannte Infrarot-aktive Gase die Abstrahlung unserer Erde behindern und so die vorgeblich „natürliche“ Temperatur um 33 Grad auf die gemessene Durchschnittstemperatur erhöhen. Schon mit dem Begriff „atmosphärischer Treibhauseffekt“ entfernt man sich aber von der seriösen Physik, wie die nachstehende Abbildung beweist:

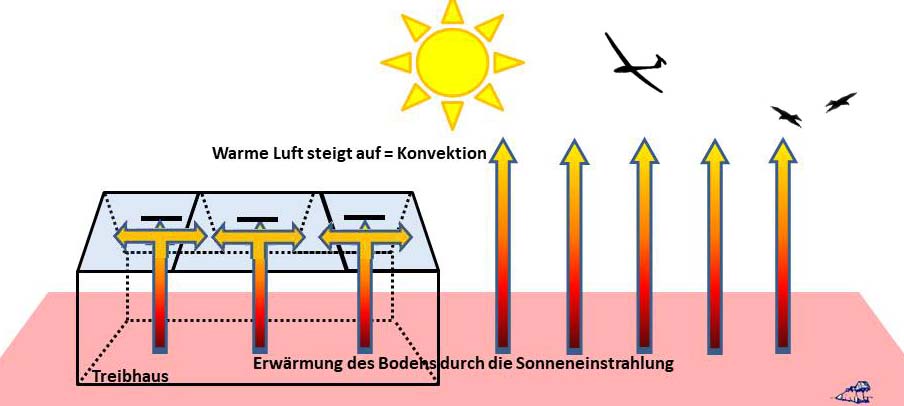

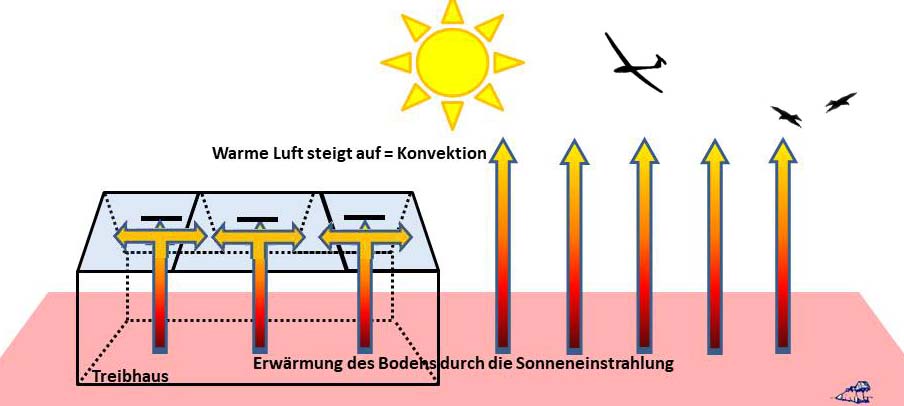

Abbildung 1: Die Unterbrechung des konvektiven Luftaustauschs in einem Treibhaus

Die Sonne erwärmt die Erdoberfläche – und natürlich auch den Boden eines Treibhauses. Das Glasdach dieses Treibhauses verhindert nun aber ganz profan das Abfließen von Wärme durch das Aufsteigen warmer Luft, und deshalb ist es im Treibhaus wärmer als in seiner Umgebung. Dieses Aufsteigen warmer und deshalb leichterer Luft hilft in freier Wildbahn den Greifvögeln und Segelfliegern, weite Strecken ohne Kraftanstrengung beziehungsweise eigenen Antrieb zurückzulegen. Konvektion ist also ein von der Schwerkraft angetriebener Materietransport und hat überhaupt nichts mit Strahlung zu tun. Denn der Treibhauseffekt erzeugt physikalisch nicht etwa zusätzliche Wärme, sondern verhindert lediglich das Abfließen von bereits erzeugter Wärme. Die Nationale deutsche Akademie der Wissenschaften Leopoldina erklärt nun den ominösen atmosphärischen Treibhauseffekt in ihrem „Factsheet“ nun folgendermaßen, Zitat:

„Der Treibhauseffekt: Eine einfache Energiebilanz bestimmt die Temperatur auf der Erde

- Der Schlüssel zum naturwissenschaftlichen Verständnis der menschengemachten globalen Erwärmung liegt in der Energiebilanz unseres Planeten und der Physik des Treibhauseffekts.

- Die Sonneneinstrahlung trifft auf die Erde, ein Drittel dieser Strahlung wird reflektiert, der Rest aufgenommen. Die Erde strahlt langwellige Wärmestrahlung ab und gleicht dadurch die von der Sonne kommende kurzwellige Strahlung aus (stabiles Klima).

- Wasserdampf, Kohlendioxid- und Methan-Moleküle in der Atmosphäre behindern die Abstrahlung von Wärme von der Erdoberfläche und strahlen einen Teil davon wieder zurück. Ohne diesen natürlichen Treibhauseffekt läge die globale Durchschnittstemperatur nicht bei rund 14°C, sondern bei −18 °C. Leben wäre dann nicht möglich.

- Durch die Verbrennung fossiler Stoffe hat sich die Konzentration von Kohlendioxid in der Atmosphäre erhöht. Dadurch wird mehr Wärme auf die Erde zurückgestrahlt. Die Temperatur an der Erdoberfläche und in der unteren Atmosphäre erhöht sich.

- Der durch den Menschen verursachte Treibhauseffekt verändert die Energiebilanz der Erde und hat zu einem Überschuss des Energieflusses von 0,6 Watt/m2 geführt.

- Rückstände der Verbrennung fossiler Stoffe in der Atmosphäre (Aerosole) haben jedoch gleichzeitig einen kühlenden Effekt.“

Und das nachstehende Faktor4-Bildchen für „die Energiebilanz der Erde“ soll diese Zusammenhänge offenbar erklären – mag ja sein, dass die aktuell geehrten Gelehrten der Leopoldina den Unterschied zwischen Energie und Leistung noch nicht ganz verstanden haben. Von ihren mehr als 7.000 ernannten Mitgliedern hebt die Leopoldina Marie Curie, Charles Darwin, Albert Einstein, Johann Wolfgang von Goethe, Alexander von Humboldt, Justus von Liebig und Max Planck besonders hervor. Zumindest die Herren Einstein und Planck wären sicherlich mit der Erklärung überfordert, wie denn aus einer absorbierten solaren Strahlungsleistung von 160 W/m² an den Hauptsätzen der Thermodynamik vorbei eine Oberflächenabstrahlung von 398 W/m² entstehen sollte – und eine ominöse „Gegenstrahlung“ von 342 W/m² bringt diese fehlerhafte Physik auch nicht in Ordnung. Das Paradoxon dieser „Gegenstrahlung“, die selbst erst ihre eigenen Entstehung bewirkt, hatte ich als „paranormalen Chuck-Norris-Kreisprozess“ in diesem Artikel ausführlich aufgedröselt.

Abbildung 2 (Leopoldina): „Der Klimawandel bringt die Energiebilanz der Erde aus dem Gleichgewicht“ (in Watt pro Quadratmeter), Bildunterschrift: „Wie kommt es zum Klimawandel? Die Erwärmung der Atmosphäre entsteht dann, wenn die Rückstrahlung der Sonnenenergie durch die Erhöhung der Konzentrationen der Treibhausgase reduziert wird. Die Erhöhung der Konzentrationen der Treibhausgase bewirkt eine Abstrahlung aus größerer Höhe der Atmosphäre, wo es kälter ist. Dadurch gelangt weniger Wärmestrahlung zurück in den Weltraum. Den Überschuss an Energie messen wir als Erwärmung der Erdoberfläche und der unteren Atmosphäre. Die in Klammern angegebenen Zahlen geben den Unsicherheitsbereich an.“

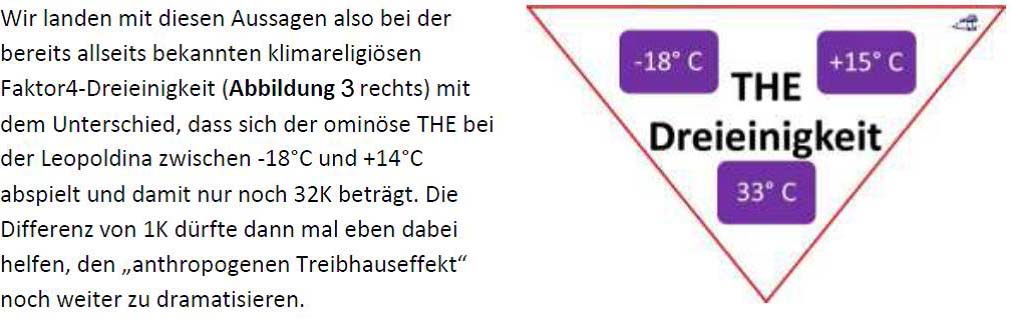

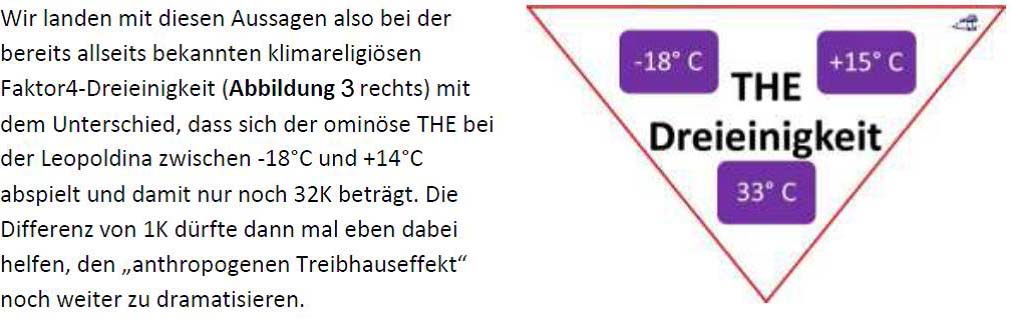

Wir können dem „Factsheet“ der hoch wissenschaftlichen Leopoldina also schon mal folgende „harten“ physikalischen Informationen über diesen natürlichen Treibhauseffekt (THE) entnehmen:

- Die Erde erhält (340-100=) 240 W/m² temperaturwirksame Sonneneinstrahlung.

- Ohne den THE läge die globale Durchschnittstemperatur bei −18 °C.

- Erst der THE erhöht die Durchschnittstemperatur der Erde um 32K auf 14°C.

So, und jetzt schauen wir uns die wirklichen geometrischen Verhältnisse auf der sonnenbestrahlten Erde mit den originären Eckpunkten einmal genauer an:

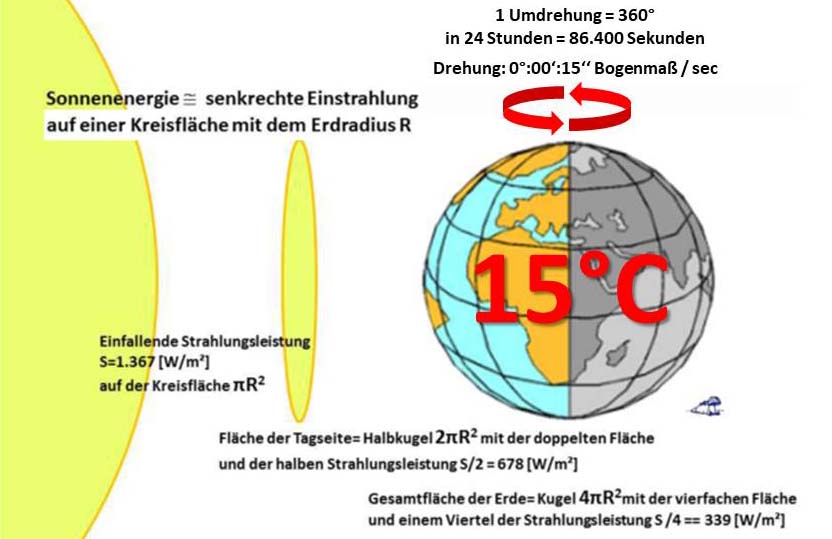

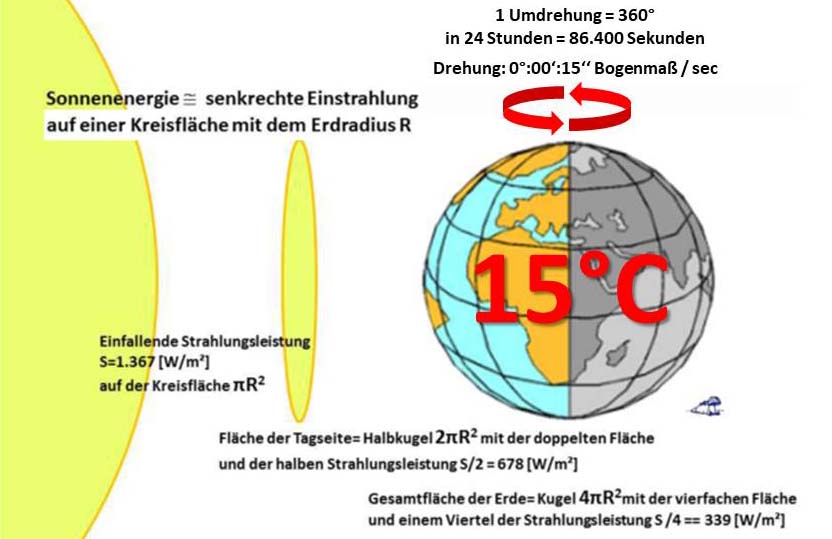

Abbildung 4: Die geometrischen Verhältnisse auf der sonnenbestrahlten Erde im Äquinoktium mit der sogenannten „gemessenen globalen NST“, die beim Faktor4-Modell einen THE erfordert

Das Flächenverhältnis zwischen der auf einer Kreisfläche mit dem Erdradius einfallenden Sonneneinstrahlung, der Tagseite der Erde und ihrer Gesamtfläche beträgt [1:2:4]. Und jetzt erkennen wir auch sofort den alten Feind des Stefan-Boltzmann-Gesetzes, nämlich die globale Mittelung der Sonneneinstrahlung mittels des ominösen Faktors „4“. Denn es ist intellektuell schon ziemlich abgedreht, einen linearen Durchschnittswert über Tag und Nacht mathematisch in einer physikalischen T^4-Beziehung zu verwursten und damit dann auch noch einen weltbewegenden Klimaalarm anzuzetteln.

Die Sonneneinstrahlung auf unserer Erde ist von der Tageszeit, der Jahreszeit und von der geografischen Breite abhängig, wird aber als eindimensionaler Durchschnitt dargestellt:

Im Klimawahn berechnet man die Kreisfläche der einfallenden Sonnenstrahlung in Quadratmetern, multipliziert diese mit der Solarkonstanten sowie den 86.400 Sekunden des 24h-Tages und erhält eine Energiemenge in Joule. Diese teilt man dann wiederum durch die 86.400 Sekunden des 24h-Tages und die Gesamtfläche der Erde in Quadratmetern und – schwuppdiwupp – behauptet man, mit dieser Viertelung der Solarkonstanten auf 340 W/m² sogar die Erddrehung berücksichtigt zu haben. Die Klimakirche multipliziert also mit und dividiert durch 86.400 Sekunden, und das ergibt erstaunlicherweise gar keine Veränderung. Und auch die Multiplikation mit 10^6 von qkm auf qm bei Kreisfläche und Erdoberfläche ergibt keinerlei Veränderung des originären Flächenverhältnisses von 1:4; es bleibt einfach beim Faktor4. Denn wie man es auch dreht und wendet, im Grunde teilt man die Solarkonstante einfach nur durch den ominösen Faktor4 und berücksichtigt dabei überhaupt nichts.

ERKENNTNIS: Bei der Faktor4-Mittelung vergeht der Unterschied zwischen Tag und Nacht in einem Einheitsgrau. Denn man kann jede Formel durch eine Multiplikation mit X/X „aufpeppen“, ohne dass sich das Ergebnis verändert. Ob man also eine Berechnung erst mit einer beliebigen Anzahl von Sekunden multipliziert und dann wieder durch dieselbe Zahl teilt oder in China platzt ein Sack Reis, das ist völlig egal und ändert gar nichts am Ergebnis – außer dass man damit dreist über die Tatsache hinwegtäuschen kann, die Solarkonstante nicht nur über die sonnenbeschienene Tagseite, sondern auch gleich noch über die dunkle Nachtseite der Erde mitgemittelt zu haben.

Und erst dieser Umstand schafft dann den Raum für einen sogenannten „natürlichen atmosphärischen Treibhauseffekt“ von 155 W/m² als Korrekturfaktor gegenüber der gemessenen Realität. Selbstverständlich können Sie diesen antiwissenschaftlichen Hokuspokus auch mit den Sekunden für ein ganzes Jahr machen und behaupten, damit die Jahreszeiten berücksichtigt zu haben, oder, noch anspruchsvoller, Sie nehmen die WMO-Klimadefinition von 30 Jahren und haben damit sogar das Weltklima berücksichtigt (Sarc aus). Die Klimakirche vereinheitlicht also eben mal eindimensional über Tag und Nacht, Sommer und Winter sowie alle Klimazonen unserer Erde durch eine Viertelung der Solarkonstanten. Eine solchermaßen fehlerhaft „berechnete Normaltemperatur“ unserer Erde ignoriert eine Menge Phänomene, die uns realphysikalisch eigentlich lieb und teuer sein sollten:

- Den regelmäßigen Wechsel von Tag und Nacht.

- Den regelmäßigen Wechsel der Jahreszeiten.

- Die höchst unterschiedlichen natürlichen Klimate auf unserer Erde.

Die genannten Unterschiede lässt eine eindimensionale „globale Durchschnittstemperatur“ von 15°C, die vorgeblich auf einem konstanten THE von 33K beruht, nämlich einfach verschwinden – und in der weiteren Betrachtung der Klimakirche spielen all diese zyklisch solar gesteuerten Phänomene dann auch überhaupt keine Rolle mehr; denn man fokussiert da lieber auf das menschengemachte CO2.

In keiner einzelnen Sekunde der Sonneneinstrahlung spielt die Erdrotation irgendeine Rolle. Der sogenannte „natürliche atmosphärische Treibhauseffekt“ ist lediglich ein frei erfundener eindimensionaler Korrekturwert, der eine missbräuchliche lineare Tag&Nacht-Durchschnittsberechnung mit dem Stefan-Boltzmann-Gesetz an die gemessene und durchschnittsverwurstete Realität anpasst. Von der ominösen „globalen Durchschnittstemperatur“ führt daher kein Weg mehr zurück in die solar gesteuerte Realität, sondern er führt direkt in den selbstzerstörerischen CO2-Klimawahn.

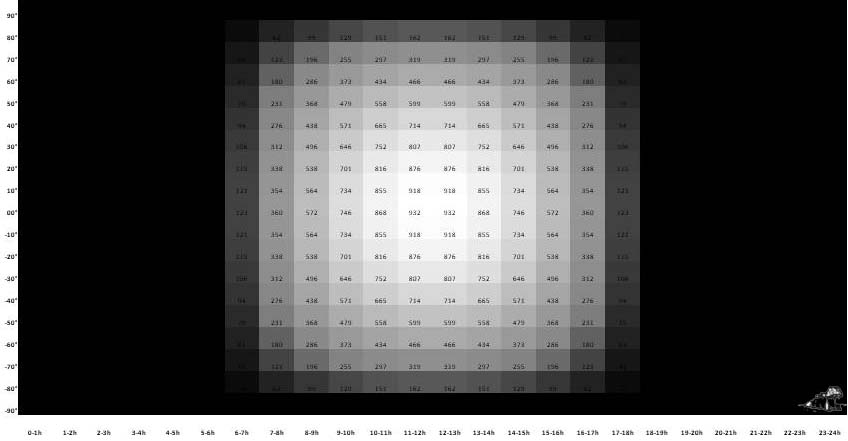

Selbstverständlich werden wir trotzdem mit panikerzeugenden Veränderungen charakteristischer Klimaeigenschaften bombardiert: Die polaren Gletscher werden weniger, die Wüsten dagegen mehr, die tropischen Regenwälder brennen und der Meeresspiegel frisst Inseln und Hafenstädte. Wenn wir uns jetzt einmal die tatsächliche Sonneneinstrahlung über 24 Stunden im Äquinoktium ansehen, dann können wir eine einheitliche Tag&Nacht-Verteilung über alle Breitenkreise erkennen, wobei der jeweilige Halbstundenwert als Mittelwert für das angegebene Zeitfenster aufgetragen wurde:

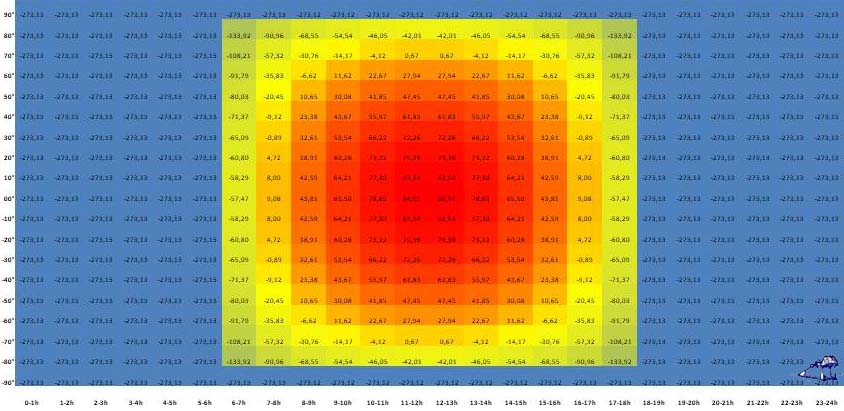

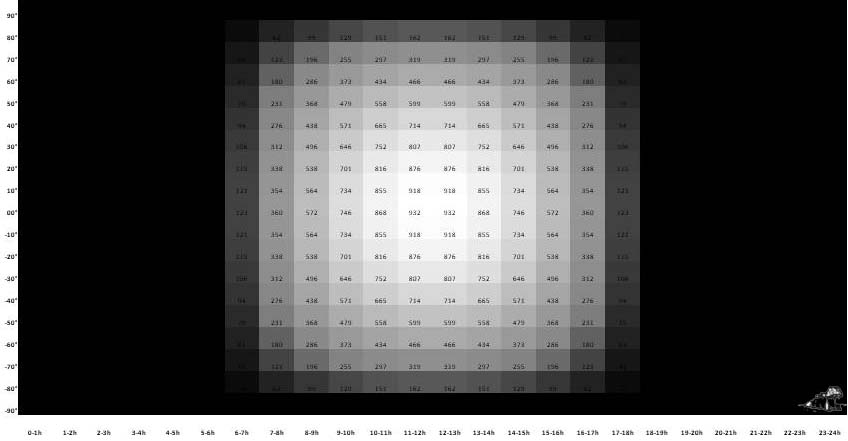

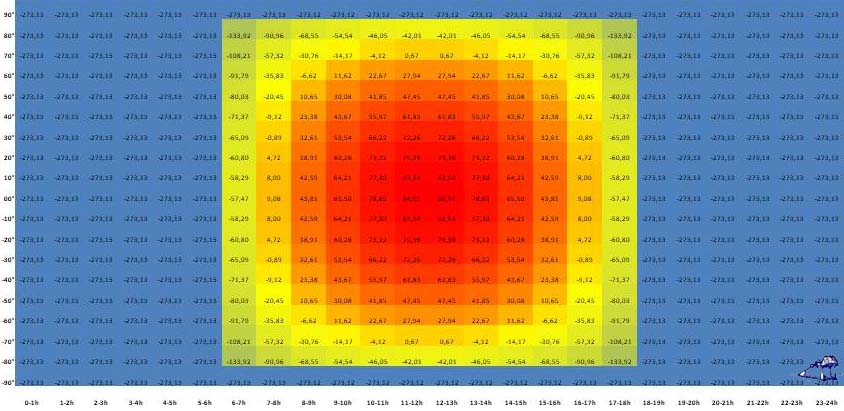

Abbildung 5: Die Netto-Strahlungsleistung in W/m² für alle Breitenkreise von 90°N bis 90°S über 24 Stunden im Äquinoktium mit 12:00 Uhr=Sonnenstand im Zenit

Diese und die nachfolgende Abbildung sind farbcodierte Excel-Tabellen. Am linken Rand ist jeweils die geografische Breite von 90°N bis 90°S aufgetragen und horizontal die Stundenintervalle des 24h-Tages, die eine ebene 360°-Projektion der Erde repräsentieren. Als Durchschnittswerte für die Stundenintervalle sind jeweils die Halbstundenwerte angegeben.

Über den Tagesverlauf (6h-18h) verändert sich die örtliche solare Strahlungsleistung (bei einem Sonnenstand im Zenit um 12:00 Uhr) in Abhängigkeit vom örtlichen Azimut und Zenitwinkel – und nachts (18h-6h) ist es dann stockdunkel. Auch das generelle Absinken der solaren Strahlungsleistung zu den Polen hin (hier: nach oben und unten) ist in dieser Abbildung deutlich zu erkennen. Die Erwärmung unserer Erde ist nun mal ein solarer Echtzeitvorgang, denn es erwärmt an jedem Ort immer nur die augenblickliche Sonneneinstrahlung – und nachts ist’s dort halt dunkel!

So, und jetzt machen wir mal die Faktor4-Probe: Wir addieren die hier dargestellte und von einer Kreisfläche einfallende solare Strahlungsleistung über die 86.400 Sekunden des 24h-Tages auf, teilen die solare Einstrahlungsfläche durch die Gesamtfläche der Erde und rechnen dann wieder auf eine Sekunde zurück. Und siehe da, die gesamte Tag&Nacht-Fläche der Grafik inklusive der Nachtseite wird mit einer Nettoeinstrahlung von 235W/m² mittelgrau, denn es kommt dabei genau der ominöse Faktor4 heraus. Und zwar ist es ganz egal, ob Sie über eine Sekunde, eine Minute, eine Stunde, einen Tag oder eine Woche mitteln. Und deshalb gibt es auch zwischen dem Faktor4-THE-Modell und der Realität auf unserer Erde überhaupt keine Verbindung. Nichts, aber auch gar nichts am THE-Modell weist auf eine Breitenabhängigkeit oder gar eine Tag/Nacht-Abhängigkeit der örtlichen solaren Einstrahlung hin. Dagegen zeichnet das aus der solaren Nettostrahlungsleistung abgeleitete S-B-Temperaturäquivalent für alle Breitenkreise von 90°N bis 90°S die Abhängigkeit der terrestrischen Temperaturgenese von Tageszeit und geografischer Breite deutlich nach:

Abbildung 6: Das S-B-Temperaturäquivalent in °C aus der Netto-Sonneneinstrahlung für alle Breitenkreise von 90°N bis 90°S über 24 Stunden im Äquinoktium

(Wert für Std:30 als Mittelwert für Std-Std+1 mit 12:00 Uhr= Sonnenstand im Zenit)

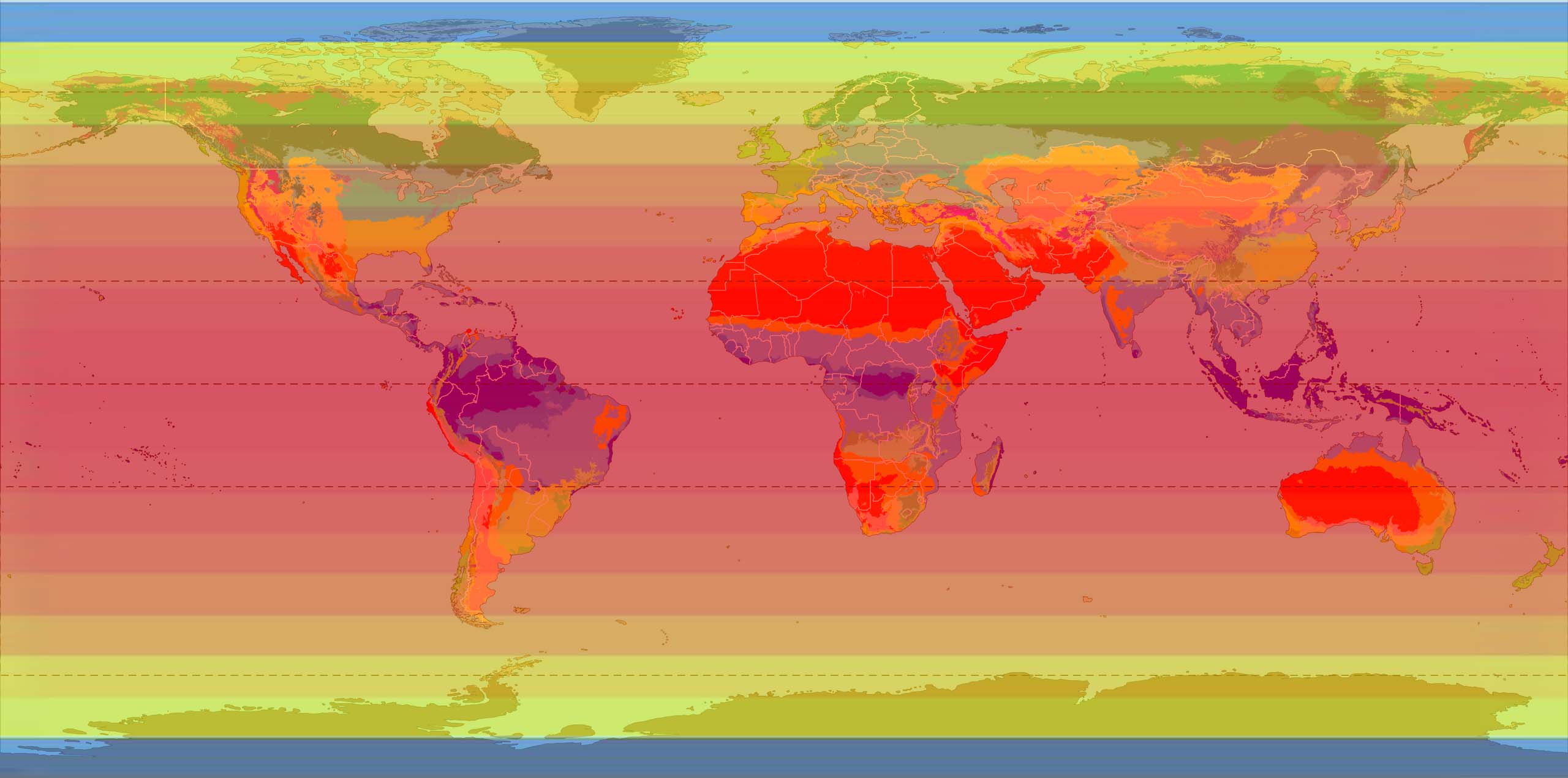

Um es von vorn herein nochmal ganz deutlich zu machen: Das hier dargestellte S-B-Temperaturäquivalent wird nirgendwo auf unserer Erde tatsächlich erreicht. Vielmehr wird sofort mit Beginn der örtlichen Erwärmung ständig Wärme in die globalen Zirkulationssysteme abgeleitet, überwiegend durch Konvektion und Verdunstung. Wasser und Wasserdampf spielen hier eine überragende Rolle. Während die Temperatur in den Tropen über 24h nur schwach um die 30°C schwankt, können die Temperaturen in Wüstengebieten tagsüber gerne mal über 50°C ansteigen, um nachts auf einstellige Werte zurückzufallen. Und in der Polarnacht fällt die Ortstemperatur nicht etwa auf Minuswerte jenseits 200°C, sondern sie wird durch die Wärmezufuhr aus den globalen Zirkulationen deutlich oberhalb von minus 100°C gehalten. Wie die nachfolgende Abbildung beweist, reicht bereits die einfache Berechnung des breitenabhängigen S-B-Temperaturäquivalents aus, um ganz grob die geografischen Klimazonen nach Köppen und Geiger nachzuzeichnen:

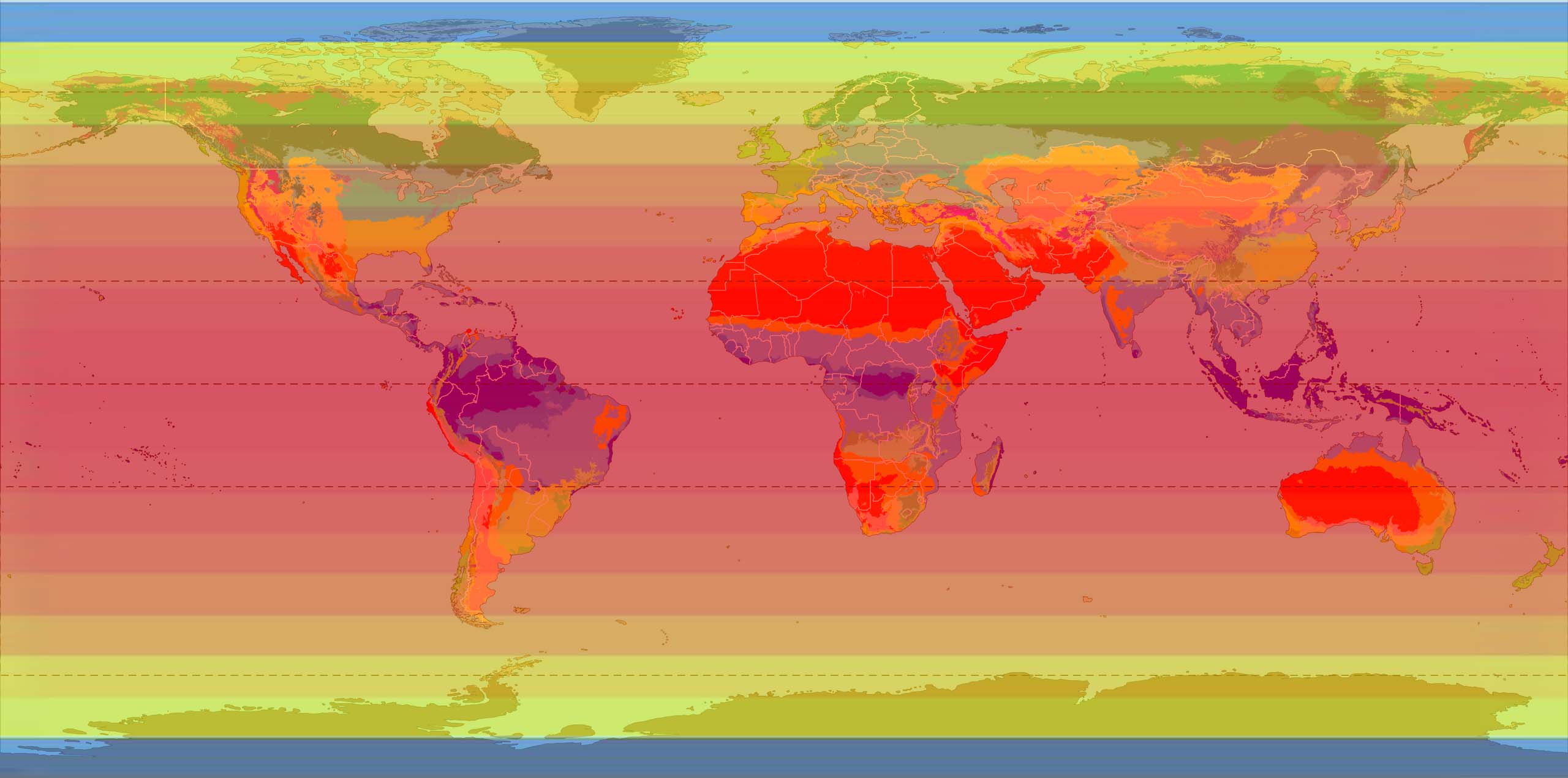

Abbildung 7: „Present and future Köppen-Geiger climate classification maps at 1-km resolution“

Quelle: Wikipedia aus Nature Scientific Data – DOI:10.1038/sdata.2018.214

Mit Overlay S-B-Temperaturäquivalent in °C aus der Netto-Sonneneinstrahlung für alle Breitenkreise von 90°N bis 90°S zwischen 11-13h im Äquinoktium (12:00 Uhr= Sonnenstand im Zenit)

Bereits das einfache Bild der breitenabhängigen solaren Einstrahlung im Äquinoktium als Overlay des mittäglichen S-B-Temperaturäquivalents ist in der Lage, die geografischen Klimazonen unserer Erde ganz grob nachzuzeichnen. Für das eindimensionale Faktor4-THE-Modell sind dagegen keinerlei Grafiken mit globalen Verteilungen bekannt. Vielmehr gilt die physikalisch fehlerhaft gemittelte temperaturwirksame solare Durchschnittsstrahlungsleistung von 235 W/m² sogar eindimensional für die Polarnacht der Winterhemisphäre – was für ein pseudowissenschaftlicher Riesenbullfisch.

Wie wir also gesehen haben, leitet sich die ominöse „natürliche“ Temperatur der Erde von -18°C aus einer mathematischen Fehlanwendung des physikalischen S-B-Gesetzes her. Diese fehlerhafte globale Durchschnittsberechnung für die Sonneneinstrahlung kann daher weder Tag und Nacht, noch die Jahreszeiten oder gar die Klimazonen unserer Erde abbilden, sondern vereinheitlicht das alles einfach zu einem eindimensionalen orwell’schen Einheitsbrei: Tag ist Nacht, die Jahreszeiten sind alle gleich und Polkappen, Wüsten und tropische Regenwälder unterscheiden sich klimatisch überhaupt nicht voneinander. Erst mit einer hemisphärischen Betrachtung eröffnet sich der Bezug zur Realität. So übersteigt die tatsächliche örtliche solare Strahlungsleistung in den Tropen den fehlerhaften globalen Faktor4-Durchschnitt um ein Vielfaches. Dort in den Tropen, dem Klimamotor unserer Erde, erreicht das S-B-Temperaturäquivalent leicht über 80°C, was bei einer real um 30°C schwankenden Ortstemperatur in der Spitze zu einem Abfluss von etwa 460 Joule pro Quadratmeter und Sekunde in die globalen Zirkulationen führt. Einen Abgleich zwischen dem fehlerhaften Faktor4-THE-Modell und meinem hemisphärischen Konvektionsmodell finden Sie am Ende dieses Artikels.

Im Verlauf eines 24h-Tages im Äquinoktium wird die Erde während ihrer 360° Grad Drehung einmal vollständig beleuchtet und bleibt gleichzeitig im selben Zeitraum, um 180 Grad (=12 Stunden) verschoben, völlig dunkel, wenn wir einmal von Streulicht absehen:

Wenn wir nämlich die Erddrehung aus der Sonnenperspektive mit 12:00 Uhr „Sonnenzeit“ für den senkrechten äquatorialen Sonnenstand betrachten, dann dreht sich die Erde unter der Sonneneinstrahlung kontinuierlich nach Osten weg. Aber in jeder Sekunde des 24h-Tages ist immer eine Hemisphäre beleuchtet und eine dunkel, auf der beleuchteten Hemisphäre herrscht Tageslicht und auf der gegenüber liegenden Hemisphäre herrscht Nacht. Infolge der Umdrehung unserer Erde um ihre Achse leiten sich daraus im Äquinoktium im Verlauf von 24 Stunden zwei völlig unterschiedlich beleuchtete Flächen her:

Fläche [Tag]: Im Verlauf von 24 Stunden dreht sich die Erde einmal komplett unter der Sonneneinstrahlung hindurch, was in Summe zu einer nacheinander vollständig beleuchteten Erdoberfläche führt.

Fläche [Nacht]: Die der Sonne abgewandte dunkle Hälfte der Erde wandert, um 180° gegen die Tagfläche versetzt, in 24 Stunden ebenfalls nacheinander über die gesamte Erdoberfläche.

Im Ergebnis müssen wir also für den 24h-Tag auf der Erde die Fläche [Tag] und die Fläche [Nacht] unterscheiden und gesondert betrachten. Dem Grunde nach stehen sich zwei ganz unterschiedliche Betrachtungsweisen für die Sonneneinstrahlung auf unserer Erde unvereinbar gegenüber, eine realistische Darstellung von Tag & Nacht und eine völlig falsche, weil eindimensionale globale Faktor4-Mittelung. Denn bei einer solchen Betrachtung zählt im wahrsten Sinne des Wortes nur die Physik der allerersten Sekunde – alles andere kürzt sich nämlich rechnerisch wieder gegeneinander heraus:

Das Faktor4-Modell (@4 PI R²): Die Klimakirche hat nun nicht einmal die Flächen [Tag] und [Nacht] gemittelt, was zumindest die Breitenabhängigkeit der solaren Einstrahlung erhalten und damit auch ein breitenabhängiges Hilfskonstrukt THE begründet hätte. Der Faktor4-Trick besteht vielmehr darin, die auf der Tagseite der Erde einfallende Sonnenstrahlung ganz platt und gleichmäßig über die gesamte Erdoberfläche zu verteilen. Und dabei werden dann eben mal sämtliche astronomischen Gesetzmäßigkeiten der Rotation unserer Erde und deren Bewegung um die Sonne vernichtet:

- Der regelmäßige Wechsel von Tag und Nacht.

- Der regelmäßige Wechsel der Jahreszeiten.

- Die breitenabhängigen natürlichen Klimate unserer Erde.

=> Das Faktor4-Modell mittelt also die einfallende Sonnenstrahlung über die Gesamtfläche der Erde zu einer eindimensionalen 24h-Halbdunkelfläche. Dieser Vorgang stellt eine völlige Negierung der vorliegenden geometrischen und astronomischen Verhältnisse dar; denn von Vereinfachung kann man hier wirklich nicht mehr sprechen. Trotzdem, oder vielmehr gerade deshalb, sind diese eindimensionalen Werte für die solare Strahlungsleistung, die „natürliche“ Durchschnittstemperatur und den sogenannten „natürlichen atmosphärischen Treibhauseffekt“ für einen MINT-fernen Nachrichtenverbraucher mit abgeschlossener Grundschulausbildung völlig plausibel und nachvollziehbar. Es ist also eine hervorragende Missionierungsleistung der Klimakirche, den variablen Beleuchtungseffekt bei einer komplexen Planetenbewegung in leicht verständliche eindimensionale Glaubenswerte umgewandelt zu haben.

Das hemisphärische Modell (vereinfacht: @2 PI R²): Die auf der Tagseite der Erde einfallende Sonnenstrahlung wird breitenabhängig korrekt nach Azimut und Zenitwinkel für jede individuellen Ortslage berechnet. Und wenn die Sonne nicht scheint (Nachtseite), dann ist‘s halt dunkel.

=> Im hemisphärischen Modell bestehen die beiden 24h-Flächen [Tag] und [Nacht] gleichberechtigt nebeneinander. Dieses Modell ist daher in der Lage, den regelmäßigen Wechsel von Tag und Nacht, den Wechsel der Jahreszeiten sowie grob die breitenabhängigen Klimate unserer Erde darzustellen:

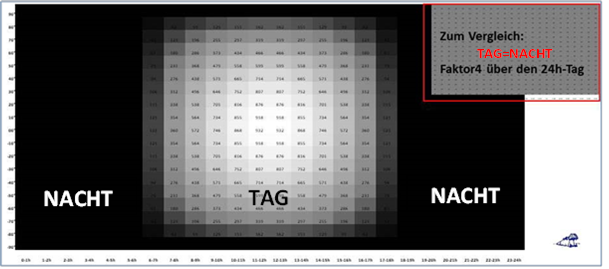

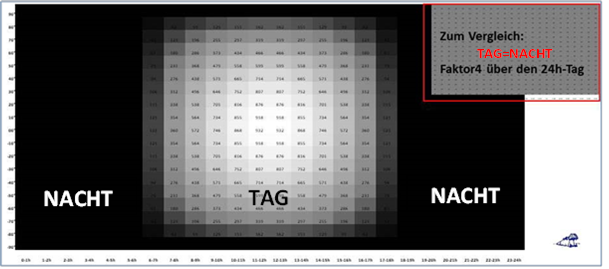

Abbildung 8: Die Netto-Strahlungsleistung in W/m² für alle Breitenkreise von 90°N bis 90°S über 24 Stunden im Äquinoktium mit 12:00 Uhr= Sonnenstand im Zenit

Oben rechts: Die aus dem Faktor4 abgeleitete 24h-Halbdunkelfläche der Erde zum Vergleich

Der Faktor4 für die Verteilung der solaren Einstrahlung auf die gesamte Erdoberfläche vermischt also Tag & Nacht über alle geografischen Breiten und macht unsere Erde damit zu einer Halbdunkelwelt mit einer antiphysikalischen „natürlichen Temperatur“, die im Abgleich mit der Realität sogar noch einen sogenannten „natürlichen atmosphärischen Treibhauseffekt“ als artifiziellen Korrekturwert erfordert. Die übliche finale Ausrede der Klimakirche, diese ominöse Temperatur durch ein religionsstiftendes „Reverse Engineering“ aus der terrestrischen Abstrahlung hergeleitet haben zu wollen, ist physikalisch ebenfalls nur notdürftiges Klimagefasel. Denn eine solche Herleitung ignoriert über die vorstehende Kritik hinaus sogar noch die natürliche Abfolge der solar induzierten Temperaturgenese auf unserer Erde [Einstrahlung -> Temperaturgenese -> Abstrahlung] und damit die materiebedingte natürliche Umkehrung der Vektorrichtung zwischen Einstrahlung und Abstrahlung. Wie man unschwer erkennen kann, findet die terrestrische Temperaturgenese zwischen Einstrahlung und Abstrahlung statt. Die Berechnung einer „natürlichen“ Temperatur aus der Abstrahlung unserer Erde ist demnach eine THE-erzeugende antiphysikalische Übersprunghandlung.

Am Ende stehen wir damit vor einer vorsätzlichen Inversion des Lebens auf unserer Erde, denn der Homo climaticus hat den Klimaeinfluss unseres Zentralgestirns willkürlich marginalisiert und verleumdet stattdessen das Photosynthesegas allen Lebens als Beelzebub der Selbstverbrennung. Die sogenannte Klimakatastrophe ist also tatsächlich menschengemacht. Erst durch das auf Grundschulniveau reduzierte Tag=Nacht-Faktor4-Beleuchtungsmodell unserer Erde, das einen eindimensionalen THE als artifiziellen Korrekturfaktor benötigt, hat der Mensch selber die religiöse Grundlage für diese imaginäre CO2-Bedrohung erschaffen. Und wir versuchen jetzt gerade verzweifelt, unseren höchstrichterlich bestätigten Einfluss auf diese menschengemachte THE-Erfindung zu unterbinden, indem wir unsere industrielle Lebensgrundlage und die Zukunft unserer Nachkommen zerstören…

Weitere Informationen: Die korrekte Berechnung für die Durchschnittstemperatur der Taghemisphäre unserer Erde wird in dem Artikel „Anmerkungen zur hemisphärischen Mittelwertbildung mit dem Stefan-Boltzmann-Gesetz“ vorgestellt. Den Grund, weshalb die durch den Faktor4 „globalisierte“ Sonneneinstrahlung physikalisch gar nicht in der Lage ist, die gemessenen Temperaturen auf der Erde darzustellen, hatte ich in dem Artikel „Kelvin allein zu Haus: Der Unterschied zwischen zwei Watt ist deren Umgebungstemperatur“ ausführlich beschrieben. Die im THE-Paradigma ungelöste Problematik zwischen den Vektorrichtungen von Einstrahlung und Abstrahlung wird in dem Artikel „Zeigt der Poynting-Vektor auf „Mittelerde“ oder auf die sogenannte ‚Abstrahlungshöhe‘?“ beleuchtet. Und die Aufrechterhaltung der Nachttemperatur durch den Wärmeinhalt der globalen ozeanischen Zirkulationen wird in dem Artikel „Die sogenannte ‚gemessene globale Durchschnittstemperatur‘ wird von den Ozeanen bestimmt“ erläutert. Einen Wegweiser durch meine hemisphärischen EIKE-Artikel hatte ich in „BACK TO EARTH…“ zusammengefasst.

PS: Bevor sich jetzt die üblichen Verdächtigen ganz furchtbar aufregen bitte ich diese um eine Erklärung, wie denn die durchschnittliche globale temperaturwirksame Solarleistung, nach unterschiedlichen Quellen 235-240 W/m², eigentlich in die Polarnacht kommt – vielleicht in lichtundurchlässig verspiegelten Spezialcontainern der Marke Schilda?

Und der abgedrehte Modefuzzi möge mir bloß mit seinen Wintermänteln vom Leibe bleiben und sich darauf beschränken, meine EIKE-Beiträge für die Klimainquisition zu zählen und zu dokumentieren…