Ein spanischer Blackout und die deutsche Systemsicherheit

Die vier deutschen Übertragungsnetzbetreiber legten im Juli einen so genannten Systemstabilitätsbericht vor. In ihm sind Handlungsempfehlungen genannt, die teils dringend sind. Der „Iberoout“, der große Stromausfall vom 28. April auf der iberischen Halbinsel, hat den Bericht offenbar geprägt.

von Frank Hennig

Der so genannte „Iberoout“ vom 28. April 2025 hat viel Aufmerksamkeit erregt, Diskussionen ausgelöst und er wird Folgen bei den europäischen Netzbetreibern haben. Zunächst: War es überhaupt ein Blackout? Die Rede ist auch von einem großen Stromausfall oder einem Schwarzfall. Nach gängiger Lesart muss ein Stromausfall länger andauern (ein bis mehrere Tage) und regional übergreifend sein, um als Blackout bezeichnet werden zu können. Nach knapp 16 Stunden waren hier alle Verbraucher wieder versorgt, aber räumlich war die Wirkung beträchtlich in Form des kompletten Territoriums Spaniens und Portugals und eines kleinen Teils des französischen Netzes. Angesichts dessen scheint mir die Einordnung als Blackout möglich.

Spanien war bisher vorbildlich oder übermütig, je nach Sichtweise, im Ausbau von Wind und Photovoltaik (PV) und strebt ehrgeizig in die Dekarbonisierung. Über Jahre hinweg stieg die Einspeisung von Wind- und Solarstrom stark an auf Kosten konventioneller Kraftwerksleistung. War dies einer der Gründe für diesen Blackout?

Der ziemlich komplizierte Ablauf des Netzbetriebes bis zum Ausfall und danach ist im Auswertungsbericht der ENTSO-E, des Dachverbandes der europäischen Netzbetreiber, nachlesbar. Hier eine kurze, stark vereinfachte Zusammenfassung:

28. April, 12:33 Uhr

Am 28. April 2025 traten bereits ab etwa 10:30 Uhr stärkere Spannungsschwankungen im spanischen Netz auf, die zunächst korrigiert werden konnten. Ab etwa 12:00 Uhr wiederholten sich diese und nahmen zu. Es gab Langzeit-Pendelungen durch das ganze europäische Netz, sie schwappten in abgeschwächter Form bis ans andere Ende des „Stromsees“ nach Litauen. Später kam es zur Trennung des spanischen vom französischen Netz, dadurch war die Regelfähigkeit auf der iberischen Halbinsel stark eingeschränkt und die n-1-Sicherheit (bei Ausfall eines Netzelements müssen alle Kunden trotzdem versorgt werden können) war nicht mehr gegeben. Nach 12:33 Uhr kollabierte das Netz innerhalb weniger Sekunden.

Eine Fehlfunktion eines Wechselrichters in einer PV-Großanlage in Bajadoz hatte zusammen mit anderen Faktoren zu Spannungsspitzen geführt, der Ausfall von weiteren Erzeugungsanlagen war die Folge. Das Stromüberangebot im Netz führte zu Überspannung, Erzeuger fielen aus, es kam zur Unterfrequenz und Sicherheitsabschaltungen bei Erzeugern und Verbrauchern.

Dieser Wechselrichter im Verbund mit anderen Störfaktoren war sozusagen der erste Dominostein, der fiel, oder der Tropfen, der das Fass zum Überlaufen brachte. Innerhalb weniger Sekunden waren ganz Spanien und Portugal stromlos.

In dieser unklaren Situation wurde medial schnell aus der Hüfte geschossen. Atmosphärische Störungen könnten Einfluss gehabt haben oder Putin sei schuld, in dieser Zeit ohnehin der Universalschuldige. Das alles erwies sich schon nach kurzer Zeit als falsch. Der Einfluss des großen PV-Anteils im Netz wurde thematisiert, die Wechselrichter mit ihrem Beitrag zu Oberschwingungen seien schuld. Die PV-Fans verwiesen schnell auf die Netzbetreiber, die nicht ordnungsgemäß reagiert hätten (was nicht ganz falsch ist). Und außerdem – ätsch – hätten die „Atomkraftwerke“ wohl auch nicht helfen können.

Ohne in die Details zu gehen, gilt als gesichert, dass der Anteil regelbarer Kraftwerksleistung und der Anlagen mit Blindleistungskompensation zu niedrig war. Nur etwa 25 Prozent des Stroms kam aus konventionellen Kraftwerksanlagen mit rotierenden Massen, 75 Prozent aus kaum regelbarer natürlicher Zufallseinspeisung.

Insbesondere die PV-Einspeisung erfolgt in die unteren Spannungsebenen, aber die Blindleistung und damit die Spannung wird über die Höchstspannungsebene geregelt. Der Frequenzausgleich war über eine zu niedrige Momentanreserve (Schwungmassen) unzureichend, die restliche regelbare Kraftwerksleistung zu gering. Ausländische Hilfe war nur begrenzt möglich, es gibt nur Interkonnektoren (grenzüberschreitende Verbindungsleitungen) in drei Länder – Frankreich, Portugal und Marokko. Eine davon, nach Frankreich, stand zudem nicht mehr zur Verfügung.

Als Fazit kann man zusammenfassen:

Das System hatte seine Regelfähigkeit verloren.

In den Wochen danach war zu beobachten, dass der „dargebotsunabhängige“ Anteil von Strom aus konventionellen Kraftwerken von den Netzbetreibern in Spanien bei etwa 40 Prozent gehalten wurde.

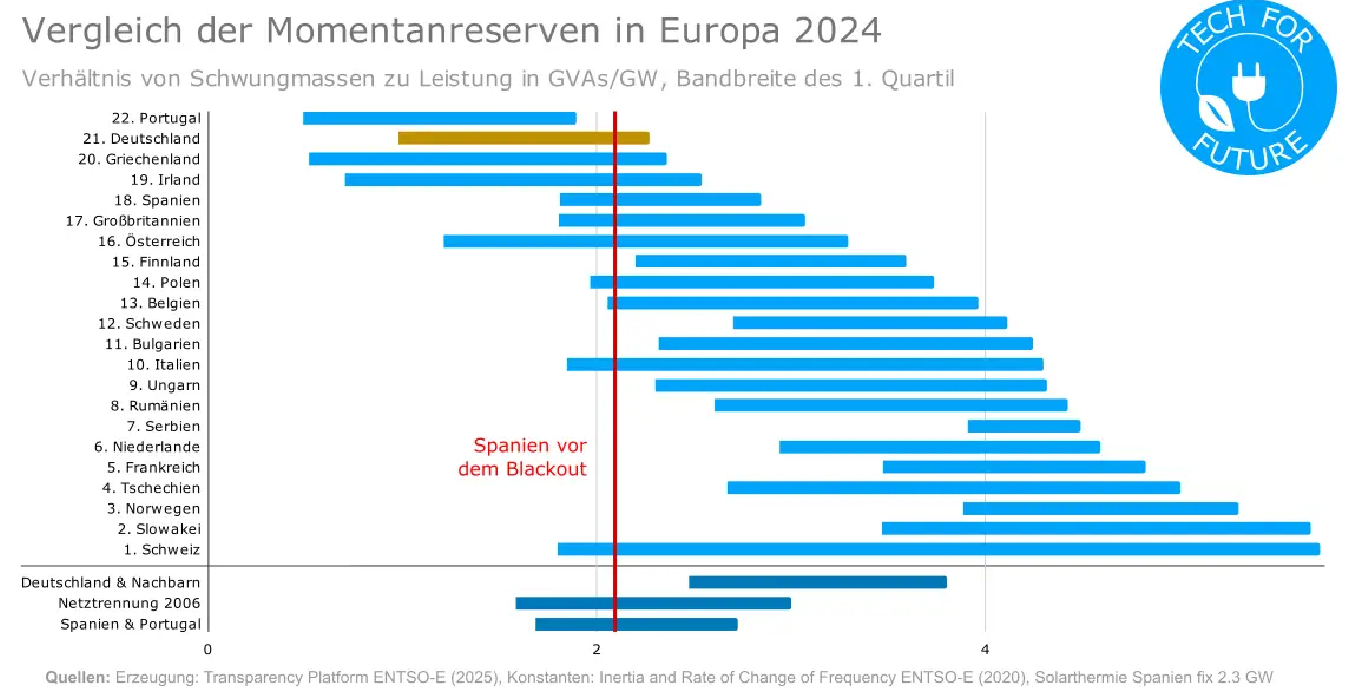

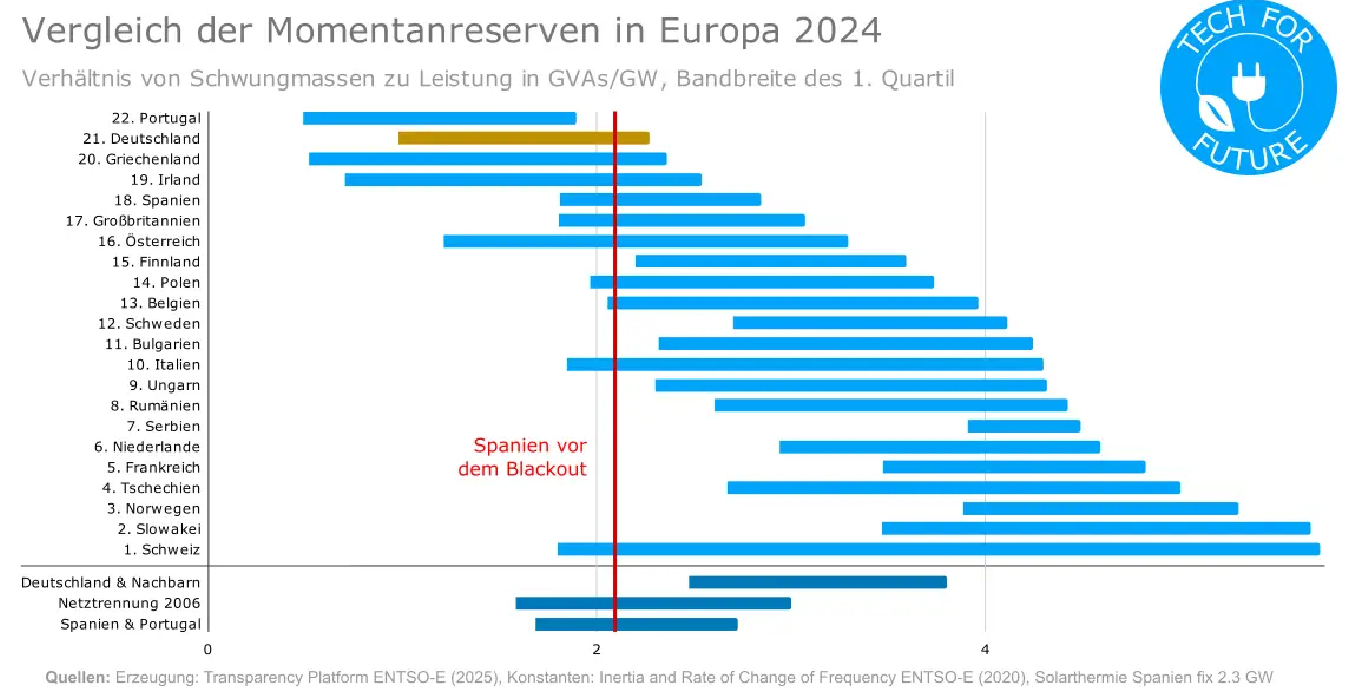

Kann ein solches Ereignis auch bei uns auftreten? Prinzipiell ja, denn auch bei uns ist die Momentanreserve gesunken und im internationalen Vergleich niedrig:

Quelle: TechForFuture, Florian Blümm

Quelle: TechForFuture, Florian Blümm

Was uns aber vom spanischen Netz unterscheidet, ist die enge Einbindung ins mitteleuropäische Netz über knapp 30 Interkonnektoren. Zudem sind unsere direkten Nachbarn (Frankreich, Schweiz, Polen, Tschechien) mit großen Momentanreserven am Netz, wovon wir generell bei der Versorgungssicherheit partizipieren können, oder, um es deutlicher zu sagen – schmarotzen.

Die Frage, ob der Iberoout in Deutschland eine neue Bewertung der Lage auslöst, ließ TE folgende Presseanfrage an die Bundesnetzagentur (BNA) stellen:

„Sieht die BNA die Notwendigkeit einer Begrenzung des Anteils fluktuierender Einspeisung ins Netz (PV- und Windstrom) resp. sieht die BNA eine mindestens erforderliche Bereitstellung von regelbarer Leistung aus rotierenden Massen mit entsprechender Möglichkeit, SDL bereitzustellen (in prozentualem Anteil oder als Leistungsangabe in GW bzw. GVA)? Welchen Anteil an Strom aus dargebotsunabhängiger Stromeinspeisung ins Netz sehen Sie als notwendig an?“

Die Antwort lautete wie folgt:

„Zur Gewährleistung der Systemstabilität bedarf es eines Zusammenspiels unterschiedlicher Instrumente. Dazu werden zusätzliche Netzwerkelemente wie beispielsweise rotierende Phasenschieber, neue Erzeuger (Erneuerbare-Energien-Anlagen oder Kraftwerke) und Batteriespeicher mit systemstabilisierenden Eigenschaften zählen.“

Das war im Grunde keine Antwort sondern aus der rechten unteren Schublade eines Praktikantenschreibtisches im Vorzimmer gezogen. Neue Erzeuger in Form von „Erneuerbare-Energien-Anlagen“ wie Wind und PV stabilisieren nicht das System, sondern bewirken das Gegenteil, indem sie permanent Schwankungen eintragen. Deshalb unterscheidet die BNA selbst nach dargebotsabhängiger und nicht dargebotsabhängiger Stromeinspeisung. „Erneuerbare“ in einen Topf mit (regelbaren) Kraftwerken zu werfen, könnte man Windkraft-Propagandisten durchgehen lassen, nicht aber einer Behörde, die sich professionell mit dem System befassen und Zusammenhänge verstehen sollte.

Der Systemstabilitätsbericht

Aber vor diesem aktuellen Hintergrund entstand die aktuelle Einschätzung der deutschen Systemstabilität. Nach Paragraf 12i des Energiewirtschaftsgesetzes (EnWG) ist durch die vier Übertragungsnetzbetreiber (ÜNB) erstmalig 2025 und danach zweijährig ein Systemstabilitätsbericht zu erstellen, danach gibt die Regulierungsbehörde (BNA) eine Bewertung ab. Der Bericht wie auch die Bewertung liegen nunmehr vor. Auch wenn zum Zeitpunkt der Berichtserstellung die Auswertung der ENTSO-E zum Iberoout noch nicht vorlag, stehen der Bericht und die Bewertung durch die Behörde offensichtlich unter dem Eindruck des spanischen 28. April.

Durch die BNA wurden in der Bewertung für das deutsche System insgesamt 37 „erhebliche Handlungsbedarfe“ identifiziert mit entsprechenden Handlungsempfehlungen, die zum Teil einen „kollektiven Handlungsdruck“ erzeugen und prioritär zu behandeln seien. Es geht um die Weiterentwicklung der Netzsicherheitsprozesse, um die transiente Stabilität im untersuchten Szenario der Langfristanalyse für das Jahr 2030. Für eine Vielzahl von Fehlersituationen sei diese Stabilität nicht gegeben. Nur durch massive Anstrengungen im Bereich der identifizierten Gegenmaßnahmen könne diese Situation verbessert werden.

Dringend seien Maßnahmen zur Spannungs- und Frequenzstabilisierung notwendig, also zur Bereitstellung von Blindleistung und großer Momentanreserven. Dies erfolgte bisher (kostenlos) durch konventionelle Kraftwerke, nun braucht es – welch Überraschung – Ersatz.

Volt statt Watt

Die Spannungshaltung ist eine der beiden Achillesfersen im Netz, ihre Nichtbeherrschung ging dem Ausfall in Spanien voraus. Um den Sollwert zu halten, ist die Blindleistung so zu regeln, dass die Schwankungen durch die Verbraucher ausgeglichen werden. Das geschah und geschieht bisher vor allem über die Stufenschaltwerke großer (Kraftwerks-)Transformatoren. Mit deren Reduzierung werden verschiedene über die Netzentgelte zu finanzierende technische Anlagen nötig wie STATCOM-Anlagen, die in den Schaltanlagen der Netzbetreiber installiert werden. In gewissem Umfang können auch Wechselrichter von PV-Anlagen nachts zur Spannungsregelung beitragen.

Nötig werden auch als Motoren im Netz mitlaufende Generatoren mit gekuppelten Schwungmassen, die die Blindleistungsregelung und die Momentanreserve absichern sollen.

Rotierende Massen als Bügeleisen

Die stabile Netzfrequenz, der maßgebende Parameter für das ausgeglichene Verhältnis aus Produktion und Verbrauch, ist das Rückgrat der Stromversorgung in einem Drehstromnetz. Offensichtlich gibt es viel Unwissen über die geringe zulässige Schwankungsbreite.

Nur zwischen 49,8 und 50,2 Hertz darf die Frequenz schwanken, dazu ein bildlicher Vergleich: Als Autofahrer stünde die Aufgabe, die Motordrehzahl bei 3.000 Umdrehungen pro Minute zu halten, abweichen dürfte man dann nur von 2.988 bis 3.012. Dann wäre ein sehr sensibler Gasfuß vonnöten und im Netz geht es wie auf der Straße nicht nur geradeaus. Kurven und Berge durch wechselnden Bedarf, vor allem schwankenden Wind gibt es jede Menge. Man kann die Arbeit der Kolleginnen und Kollegen in den Netzleitstellen nicht hoch genug würdigen.

Die BNA fordert nun, in den Technischen Anschlussregeln Mindestanforderungen zur Erbringung von Momentanreserve festzuschreiben (da war TE mit der Presseanfrage etwas der Behörde voraus). Diese Reserve kann im Wesentlichen nur durch konventionelle Kraftwerke mit rotierenden Massen geliefert werden, auch wenn einige Windkraftanlagen über ihre Wechselrichter Strom netzbildend einspeisen können, den nötigen Wind vorausgesetzt.

Die BNA legt in ihrer Bewertung gleichermaßen fest, zunächst dringlich alle Daten zum Netzbetrieb zu erfassen. Offensichtlich war dies bisher nur unzureichend der Fall. Mit dem weiteren Ausbau der PV werde die Marktintegration an Grenzen stoßen, also nicht mehr möglich sein. Zu viele Akteure hätten bisher keine hinreichenden Anreize, ihre Einspeisung an Marktsignalen zu orientieren.

Das ist der eigentliche Knackpunkt, verursacht durch ein anarchisches Erneuerbare Energien Gesetz (EEG) aus dem Jahr 2000. Es gehört abgeschafft oder in der Art reformiert, dass sich die inzwischen großen Kapazitäten an Wind- und PV-Erzeugern netzdienlich verhalten müssen und es kein Geld mehr gibt für Produktion zur falschen Zeit.

Stromversorgung im Großversuch

Die Politik mehrerer Bundesregierungen förderte seit Jahrzehnten den maximierten, aber unkoordinierten Ausbau der „Erneuerbaren“. Wirtschaftsministerin Reiche (CDU) hat nun eine Studie in Auftrag gegeben, um zunächst den Stand der „Wende“ zu ermitteln. Das hatte ihr Vorgänger Habeck trotz Festlegung im Paragrafen 54 des Kohleverstromungsbeendigungsgesetzes (KVBG) nicht geschafft oder nicht schaffen wollen.

Netzbetreiber, Wissenschaftler und andere Fachkundige, die sich warnend zum Thema äußerten, wurden oft in billigster Manier als Fortschrittsfeinde, Klimaleugner oder Kohlelobbyisten denunziert. Dabei gibt es in Deutschland schon lange keine Kohle- oder Atomlobby mehr. Aufschlussreich ist, wer sich an dieser Diskussion zur Netzstabilität nicht beteiligt. Von Agora-Energiewende oder dem DIW mit Multi-Spezialistin Frau Professor Kemfert habe ich bisher Begriffe wie Blindleistung und Momentanreserve nicht vernommen. Frau Kemfert geht bekanntlich davon aus, dass Moleküle im Netz fließen.

Viele kleinteilige Maßnahmen fordert die BNA in ihrer Bewertung des ÜNB-Berichts. Die wirksamste und sicherste Handlungsempfehlung wäre ein Moratorium des Ausbaus an PV- und Windkraftanlagen, bis die vorgeschlagenen Empfehlungen umgesetzt sind und der Netzausbau aufgeholt hat.

Auch hieran zeigt sich, dass diese deutschnationale Energiewende keinen Masterplan hat. Denn dann wäre die jetzige Sitaution vorhergesehen worden und es würde nicht einen plötzlichen „kollektiven Handlungsdruck“ geben.

Um nicht zugeben zu müssen, dass die Energiewende keinem übergreifenden Plan folgt, werden verschleiernde Formulierungen bemüht. Die Bezeichnung der Energiewende als „unserer Mondlandung“ ist grundsätzlich falsch. Die Amerikaner gaben bezogen auf heutige Preise etwa 120 Milliarden Dollar dafür aus, danach war das Projekt erledigt. Die Energiewende kostete uns bisher mindestens 600 Milliarden Euro und die Skala ist nach oben offen. Allein der Netzausbau bis 2030 erfordere einen „mittleren dreistelligen Milliardenbetrag“.

Die Energiewende sei unser „Jahrhundertprojekt“. Auch das ist falsch, denn es wird nicht nach Projektstruktur gearbeitet. Diese sieht regelmäßiges Monitoring der durchgeführten Maßnahmen vor, was Ministerin Reiche nun offenbar erstmalig veranlasst.

Näher an der Wahrheit liegt Professor Fratzscher vom DIW, der in seinem Buch „Die Deutschland-Illusion“ schon 2015 sinngemäß schrieb, dass allen klar sein müsse, dass es sich bei der Energiewende um ein Experiment handle. Christoph Frei, der damalige Generalsekretär des Weltenergierates, sprach von Deutschland als dem größten Freiluftlaboratorium auf dem Energiesektor.

Sicher ist, dass die Mehrheit der Bevölkerung nicht Teilnehmer eines energiewirtschaftlichen Großexperiments sein will, sondern eine Energieversorgung nach dem Grundsatz des Paragrafen 1 des EnWG und des energiepolitischen Zieldreiecks bevorzugt. Anstelle Experimente im Labor durchzuführen, gingen und gehen mehrere Bundesregierungen „voll ins Risiko – und vielleicht gelingt es ja auch“ (Robert Habeck). Was passiert, wenn es nicht gelingt, darüber hat man sich offenbar keine Gedanken gemacht. Nach einem bereits gescheiterten realsozialistischen Experiment auf deutschen Boden haben die Menschen im Land wenig Neigung, die Laborratten für grüne Klimafantasien sein zu wollen.

Inzwischen geht der Test weiter, wie viele Schwankungen unser Netz noch ertragen kann, ohne dass Spannung und Frequenz aus dem Ruder laufen. Wir werden es irgendwann wissen, wenn sich Politik nicht ändert.

Der Beitrag erschien zuerst bei TE hier

Quelle: TechForFuture, Florian Blümm

Quelle: TechForFuture, Florian Blümm