Offshore-Windkraft: Eine Branche im Niedergang

Geplatzte Auktionen, verschobene Baustarts, gestoppte Investitionen: Von der Windenergie auf dem Meer gibt es derzeit fast nur schlechte Meldungen. Es besteht kaum Hoffnung, dass sich daran viel ändert. Ohne Offshore-Windkraft aber steht die Energiewende vor dem Aus.

Von Peter Panther

Die Pläne Europa, was den Ausbau der Offshore-Windkraft angeht, sind atemberaubend. Bis 2030 soll alleine in der Nordsee eine Nennleistung von 120 Gigawatt installiert sein. Bis 2050 sollen es sogar 300 Gigawatt sein, das entspricht der Leistung von 300 grossen Atomkraftwerken. Heute sind allerdings erst 30 Gigawatt aufgestellt. Deutschland will dabei die Windkraft in seinen Gewässern bis 2030 auf 30 Gigawatt und bis 2045 auf 70 Gigawatt ausbauen. Verglichen mit den heute vorhandenen 9,2 Gigawatt klafft eine riesige Lücke.

Die hochtrabenden Pläne kommen nicht von ungefähr: Offshore-Windkraft ist für das Gelingen der sogenannten Energiewende existenziell. Anlagen auf dem Meer liefern im Vergleich zu ihren Pendants an Land wenigstens einigermassen zuverlässig Strom. Für die Versorgung im Winter, wenn die Photovoltaik weitgehend ausfällt, ist sie unentbehrlich. Zudem lassen sich Offshore-Windparks mangels Anwohner leichter verwirklichen: Opposition dagegen gibt es meist nur wenig. Ohne Windenergie auf dem Meer ist die Umstellung der Stromversorgung auf sogenannt erneuerbare Quellen schlicht unmöglich.

Doch wer die Schlagzeilen der letzten ein bis zwei Jahre verfolgt hat, merkt: Da läuft gerade ziemlich viel schief mit der Offshore-Windkraft. Das jüngste Beispiel ist die gescheiterte Auktion für zwei Windpark-Gebiete in der Nordsee Anfang August: Es ging erstmals in der Geschichte Deutschlands kein einziges Angebot von Investoren ein.

Kenner der Branche sind nicht überrascht

Bereits im Juni diesen Jahres war eine deutsche Ausschreibung beinahe gescheitert: Es meldeten sich gerade einmal zwei Bieter. Karina Würtz, Chefin der Stiftung Offshore-Windenergie, warnte damals vor einem Scheitern der deutschen Ausbauziele. Sie blickte wohl auch auf Dänemark. Denn dort war bereits im Dezember 2024 eine Auktion ergebnislos verlaufen. Es handelte sich mit rund drei Gigawatt um die bislang grösste Offshore-Ausschreibung in der Geschichte des Landes. Doch niemand wollte in Dänemark mehr investieren.

Kenner der Branche sind alles andere als überrascht über das mangelnde Interesse. Denn in den letzten ein bis zwei Jahren sind die Kosten für den Bau und Betrieb von Windrädern auf dem Meer um bis zu 60 Prozent gestiegen. Zum einen sind dafür hohe Zinsen verantwortlich, zum anderen verteuerte Rohmaterialien wie Stahl und Kupfer sowie stark gestiegene Arbeitskosten.

Um angesichts dieser Kostenexplosion noch gewinnbringend Offshore-Windparks bauen zu können, müssten die Staaten fette Subventionen in Aussicht stellen. Einige Jahre lang war das anders, da konnten Windparks auf dem Meer auch ohne öffentliche Beihilfen realisiert werden. Doch die goldenen Zeiten, die für eine relativ kurze Zeit herrschten, sind vorüber. Aber bei vielen Ausschreibungen sind die neuesten Entwicklungen noch nicht berücksichtigt – mit dem Resultat, dass die Bedingungen so unattraktiv sind, dass kaum mehr ein Investor ein Angebot macht.

Schlechte Meldungen aus Grossbritannien, Belgien, Niederlande, etc.

Es ist gut möglich, dass die staatlichen Regulatoren bald nachziehen, die Bedingungen ihrer Auktionen anpassen und die notwendigen Subventionen in Aussicht stellen. Dass sich damit aber die tiefe Krise, in der die Offshore-Windbranche steckt, überwinden lässt, ist zu bezweifeln. Denn auch sonst trafen in letzter Zeit fast nur schlechte Nachrichten aus diesem Energiebereich ein.

Bereits im Sommer 2023 stoppte der schwedische Energiekonzern Vattenfall die Planung des Windparks Norfolk Boreas vor der Küste Englands. Im letzten Mai stellte der Windkraft-Erbauer Ørsted auch die Entwicklung des riesigen Windparks Hornsea 4 (2,4 Gigawatt) in Grossbritannien vorläufig ein.

In den Niederlanden wurde im November das Ausschreibungsverfahren für den Windpark Nederwiek IB (als Teil eines grösseren Projekts) zurückgestellt. In Belgien kostet die Fertigstellung des Windpark-Projekts «Princess Elisabeth» statt 2,2 nun sieben Milliarden Euro. Entsprechend wurden die Arbeiten im Januar 2025 gestoppt. Man rechnet nun damit, dass sich die Inbetriebnahme um mindestens drei Jahre verzögert. Auch in Frankreich, das nur vergleichsweise bescheidene Offshore-Pläne hat, hapert es: Im letzten Juli gab der französische Energiekonzern EDF bekannt, dass der Windpark Calvados im Rahmen des Normandie-Projekts erst 2027 statt schon dieses Jahr ans Netz geht.

Vor allem in Deutschland gibt es neben den erwähnten Kostensteigerungen eine Reihe weiterer ungünstiger Entwicklung, die das Geschäft mit der Offshore-Windenergie vermiesen: Zum einen sind bei Fertigstellung der Windräder die Netzanschlüsse oftmals nicht bereit. So kann etwa der Windpark Borkum Riffgrund 3 deswegen erst im ersten Quartal 2026 statt wie beabsichtigt schon Ende 2025 Strom liefern.

«Windklau» als zusätzliches Problem

Zum anderen kannibalisiert sich die Energiewende selber: Weil es wegen den Millionen von Photovoltaik-Anlagen und Zehntausenden von Windrädern immer häufiger Phasen mit negativen Strompreisen am Markt gibt, können sich Betreiber zusätzlicher Windanlagen auf dem Meer nicht sicher sein, ob sie mit ihrer Elektrizität auch kostendeckende Erlöse erzielen können.

Dazu kommt ein Problem, dass sich insbesondere in der Nordsee immer häufiger zeigt: Viele Anlagen stehen viel zu dicht beieinander, sodass sie sich gegenseitig den Wind wegnehmen. Entsprechend müssen die Betreiber von Windparks ihre Ertragserwartungen gegen unten korrigieren. Eben erst machte deswegen ein Streit Schlagzeilen: Die Niederlande werfen Belgien vor, mit ihren Anlagen in der Nordsee «Winddiebstahl» zu begehen und den eigenen Rädern den Wind wegzunehmen.

Aus ganz anderen Gründen ist auch die schwedische Offshore-Windkraft in grossen Problemen: Im letzten November hat die Regierung des Landes 13 von 14 geplanten Projekten in der Ostsee gestoppt. Die schwedische Armee hatte beanstandet, dass Offshore-Windanlagen die Überwachung mittels Radar und Unterwassersensoren stören könne – was die Regierung mit Blick auf mögliche militärische Konflikte mit Russland als nicht hinnehmbar erachtete.

Die erwähnten schlechten Meldungen sind wohlverstanden keine Einzelfälle. Denn die offizielle Statistik spricht eine klare Sprache: Während 2023 EU-weit noch drei Gigawatt an neuer Offshore-Windkraftleistung installiert worden waren, kam man 2024 mit 1,4 Gigawatt gerade noch auf knapp die Hälfte.

Weiterer Sargnagel für die deutsche Energiepolitik

Alles spricht dafür, dass die zeitweilig schönen Zeiten in der Offshore-Windbranche vorüber sind. Denn die Margen in diesem Geschäft fallen immer tiefer. Windräder auf dem Meer zu bauen, war schon immer ein Nischengeschäft. Jetzt wird diese Nische noch enger. Damit wird auch klar, dass die hochtrabenden europäischen Pläne wohl Makulatur sind. Die gigantischen Ausbauziele entsprangen Fantasievorstellungen.

Während Fachleute den britischen Planern noch ausreichend Realitätssinn zugestehen, sehen sie insbesondere für Deutschland schwarz: Denn hier orientiert man sich in Sachen Stromversorgung schon seit längerem nicht mehr an physikalischen und ökonomischen Fakten. Die Schwierigkeiten der Offshore-Branche sind nur ein weiterer Sargnagel für die deutsche Energiepolitik.

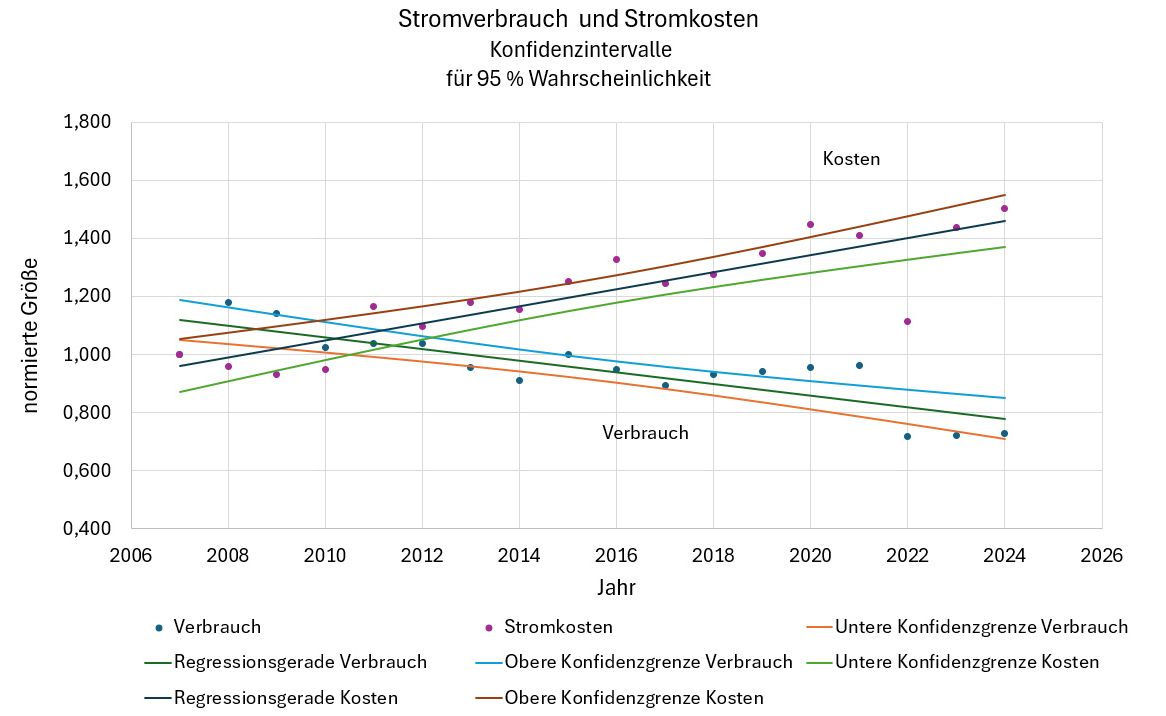

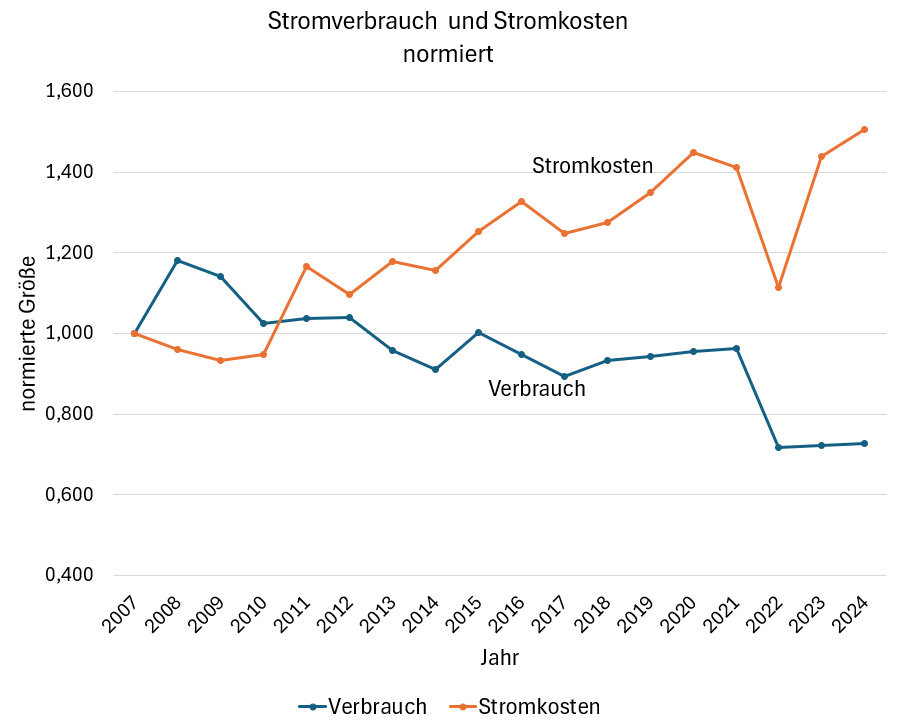

Bild 1 Verlauf von Verbrauch und Stromkosten, normiert auf das Jahr 2007

Bild 1 Verlauf von Verbrauch und Stromkosten, normiert auf das Jahr 2007