Tropische Nächte machen die Hamburger ganz wirr im Kopf

Der jüngste „Hamburger Klimaentscheid“ wird der alten Hansestadt einen würdigen Platz neben den weltweit führenden Städten Schilda und Jerewan mit seiner berühmten Radiostation sichern.

Von Manfred Haferburg

Die Freie und Hansestadt Hamburg ist als Stadtstaat ein Land der Bundesrepublik Deutschland und mit knapp zwei Millionen Einwohnern der zweitgrößte Stadtstaat der Bundesrepublik. Hamburg blickt auf eine traditionsreiche Geschichte als Hafenstadt zurück und sieht sich mit seinem großen Umschlaghafen als „Tor zur Welt“. Speicherstadt und Kontorhausviertel sind Teil des UNESCO-Weltkulturerbes. Die Stadt freut sich, mit der Reeperbahn die „sündigste Meile der Welt“ zu haben. Gleich um die Ecke liegen die womöglich noch sündigeren 100 Meter der Herbertstraße. Hamburg ist auch stolz auf seine „Elbphilharmonie“, die durch Verdoppelung ihrer Bauzeit und Verzehnfachung ihrer Baukosten schon vor ihrer Inbetriebnahme große Berühmtheit erlangte. Doch nun wird wohl der „Hamburger Klimaentscheid“ der alten Hansestadt einen würdigen Platz neben den weltweit führenden Städten Schilda und Jerewan mit seiner berühmten Radiostation sichern.

Der Hamburger Klimaentscheid, offiziell „Hamburger Zukunftsentscheid“, war ein Volksentscheid am 12. Oktober 2025, bei dem die Hamburger über eine Verschärfung des Klimaschutzgesetzes abstimmten. Die Volksentscheid-Initiative forderte: Klimaneutralität bis 2040 (statt bisher 2045), Verbindliche jährliche CO2-Minderungsziele und Sozialverträglichkeit aller Klimaschutzmaßnahmen. Der Klimaentscheid war initiiert von Fridays for Future Hamburg, NABU, ver.di und dem Mieterverein Hamburg und wurde unterstützt von über 160 Organisationen, darunter FC St. Pauli, Greenpeace und BUND. Über 106.000 gültige Unterschriften wurden für das Volksbegehren gesammelt.

Die Wahlbeteiligung entsprach rund 535.000 Abstimmenden von insgesamt etwa 1,32 Millionen Wahlberechtigten. 455.387 Stimmen wurden per Briefwahl abgegeben, und nur 80.261 Hamburger gingen am Wahltag in die Abstimmungsstellen.

Geschätzte 200 neue Beamtenstellen

Tja, liebe vergnügungssüchtige Hamburger, jetzt habt Ihr den grünen Salat. Weniger als jeder zweite Hamburger nahm überhaupt am Entscheid teil, der Rest ging lieber zum „Rendezvous der Träume. Surrealismus und deutsche Romantik“, einer Ausstellung in der Hamburger Kunsthalle. Oder zur Vernissage zeitgenössischer Kunst mit biologischen Anklängen: „VIELSCHICHTIG – Zellen · Gewebe · Struktur“. Manche gingen zur Comedy-Show mit dem Entertainer Mario Barth oder zum Benne Singer-Songwriter-Konzert mit emotionalen Texten, oder gar zum Bigband „Operation Grand Slam“, mit Jazz- und Swing-Klängen vom Feinsten, oder zum Chorkonzert „Music be the food of LOVE“ – Eintritt frei. Man konnte auch zu OLIVIAS WILDEN JUNGS – Party Special auf der großen Freiheit mit Strip-Show und Lounge für Frauen gehen – ideal für Junggesellinnenabschiede, zur Mamma Mia Party, dem ABBA-Feeling mit ausgelassener Tanzstimmung pilgern. Das klingt alles verlockend, man muss auch Prioritäten setzen können. So lag dann auch die Wahlbeteiligung bei eher mageren 40,6 Prozent.

Das Ergebnis überraschte selbst die Initiatoren: 53,2 Prozent Ja-Stimmen. Das notwendige Zustimmungsquorum von 20 Prozent wurde überschritten und das neue Gesetz – „Das tritt nach meiner Kenntnis… ist das sofort… unverzüglich“ in Kraft, hätte Günter Schabowski gesagt und einen Monat nach der Abstimmung gemeint. Die Folgen für die Freie und Hansestadt werden dem Anlass des Schabowski-Zitats durchaus vergleichbar sein. Denn das Ergebnis beinhaltet verheerende Ziele.

Ab sofort ist es per Gesetz in Hamburg erforderlich, den CO2-Ausstoß um 70 Prozent bis 2030 und um 98 Prozent bis 2040 zu senken. Es sind Jahresemissionsmengen und Sektorenziele einzuführen und jährliche Schätzbilanzen zur Kontrolle der Zielerreichung durchzuführen. Dazu werden geschätzte 200 neue Beamtenstellen benötigt.

Hamburg haarscharf in der Linkskurve

Hamburgs Geschicke werden von einem SPD-Oberbürgermeister namens Peter Tschentscher geführt, der in einer Koalition mit den Grünen die Geschicke der einst so stolzen Hansestadt lenkt. Die Wahlergebnisse der SPD haben sich zwar seit dem Jahr 2000 bis zur Wahl 2025 auf 22,7 Prozent halbiert, die CDU hat ein Drittel der Hamburger Wähler auf nunmehr 20,7 Prozent verloren. Die Grünen hingegen haben sich im selben Zeitraum auf 19,3 Prozent fast verdoppelt. Die Linke hat sich im selben Zeitraum von zwei auf 14,5 Prozent versiebenfacht. SPD-Linke, Grüne und Linke haben großen Einfluss in Hamburg, das einen ziemlichen Linkskurs eingeschlagen hat. Auch der Einfluss der überwiegend linken Medien ist nicht zu unterschätzen.

Hamburg gilt als einer der bedeutendsten Medienstandorte Deutschlands mit einer wirtschaftlich starken Medienlandschaft. Der Norddeutsche Rundfunk (NDR) hat seinen Hauptsitz in Hamburg und produziert u.a. die Tagesschau, Tagesthemen und das Hamburg Journal. Auch das ZDF und DeutschlandRadio betreiben Landesstudios in Hamburg. Spiegel, Zeit und TAZ-Nord sind in Hamburg zu Hause. Auch Luisa Neubauer, das deutsche Gesicht von „Fridays for future“, lebt in Hamburg. Sie engagiert sich stark für Klimaschutzprojekte und war eine zentrale Figur beim Hamburger „Zukunftsentscheid“ zur Klimaneutralität bis 2040. Auch die üblichen Verdächtigen wie BUND, NABU, ver.di, und die Hamburger Kunsthalle und Kulturszene machten an der Spitze mit. Lustigerweise trieben bei der Entscheidung der Mieterbund sowie der FC St. Pauli ebenfalls gegen die ureigensten Interessen ihrer Mitglieder ihr Unwesen.

Seit 2011 führt Hamburg den Titel „Umwelthauptstadt Europas“. Die Hamburger fürchten sich zunehmend vor dem Klimawandel, beklagen eine zunehmende Zahl von Sommertagen und tropischen Nächten und ihren Auswirkungen auf die Konzentrationsfähigkeit der Stadtbevölkerung. Auch haben sich die Hamburger einreden lassen, dass der Meeresspiegel bis zum Jahr 2100 um 1,5 Meter ansteigt. Das sind, wenn ich richtig rechne, ganze zwei Zentimeter pro Jahr und man müsste es eigentlich mit einem Zollstock nachmessen können. Da kann es schon mal vorkommen, dass man verschreckt das funkelnagelneue Großkraftwerk Moorburg abschaltet und vorsorglich in die Luft sprengt, eine Tragikomödie, die wir hier auf der Achse in dem Beitrag „Im Sumpf von Moorburg“ beschrieben haben.

Da wollen wir mal den von den tropischen Sommernächten konfusen Hamburgern etwas in praktische Sprache übersetzen, wozu sie sich selbst da gerade gesetzlich verpflichtet haben, was also „unverzüglich – ab sofort“ gerichtlich einklagbar ist.

In Hamburg wird gerade die Aufklärung rückabgewickelt

Fangen wir mit der Zeitskala im Jahr 2030 an, was ja sehr überschaubar ist. In etwa vier Jahren muss! Hamburg jetzt seinen Kohlendioxid-Ausstoß um 70 Prozent verringern.

Wer erzeugt in Hamburg eigentlich wie viel CO2? Den Löwenanteil davon macht die Industrie (Raffinerien, Metallverarbeitung, Chemie) mit 30 Prozent aus. Dann folgen die privaten Haushalte (Heizung und Strom) 25 Prozent, dann Gewerbe (Handel, Dienstleistung, Büro, Gastronomie) mit 20 Prozent, dann der Verkehr (PKW, LKW, Hafenlogistik, Luftverkehr) 20 Prozent und zuletzt die Sonstigen (Abfall, Müllverbrennung, Kläranlagen und Tierhaltung) mit fünf Prozent.

Davon soll in vier (4) Jahren jeder Sektor 70 Prozent einsparen. Und der normale Hamburger Bürger ist ja mit fast allen Gebieten verquickt. Und in 15 Jahren soll alles CO2 verbannt sein. Per Gesetz, auch wenn das physikalisch unmöglich ist. In Hamburg werden gerade Gesetze gemacht, die den Naturgesetzen widersprechen. Viel Glück dabei.

Was bedeutet das für die Hamburger?

Was nun folgt, werden viele nicht glauben. Nicht glauben wollen. Es ist einfach zu verrückt. Aber die Ungläubigen sollten die Geschichte „Im Sumpf von Moorburg“ lesen. Das hat auch niemand für möglich gehalten. Und es ist doch geschehen.

Die Umsetzung der Ergebnisse des Hamburger Klimaentscheids bedeutet für den durchschnittlichen Hamburger Haushalt in den nächsten vier bis vierzehn Jahren: Abschaffung des PKW mit Verbrenner, Kauf eines Elektroautos, Umbau der Heizung auf Wärmepumpe oder Mieterhöhung um drei bis vier Euro pro Quadratmeter, das sind so 350 Euro pro Monat höhere Mietkosten für eine durchschnittliche Wohnung. Dazu kommt die Unbezahlbarkeit des Stroms, für viele Verlust des Arbeitsplatzes. Warum? Weil viele Arbeitsplätze verschwinden. Sie können dann aber Rikscha-Fahrer werden. Oder Lastenfahrradführer. Oder CO2-Kontrolleur.

Die Waren des täglichen Bedarfs werden unbezahlbar. Weil Brötchen dann mit teurem Strom oder noch teurerem Wasserstoff gebacken werden. Und Fleisch wegen des Schweinefurzes oder des Kuhrülpsers verboten ist. Modische Kleidung? Zu viel CO2! Urlaub? Fliegen geht nicht – CO2. Höchstens eine Wanderung ins renaturierte ehemalige Hafengebiet. Und krank sollten sie lieber nicht werden. Sie wissen schon – Arznei aus der Chemie? Nee, die ist weg. Dieselnotstrom im Krankenhaus bei Blackout? Diesel verboten, Wasserstoff knapp und zu teuer.

Im Industriebereich müssen die Raffinerien, die chemische Industrie und Metallurgie aus Hamburg verschwinden, denn Wasserstoff wird es nicht geben oder er ist mit Wirkungsgraden von 15 bis 18 Prozent nicht bezahlbar. Auch der Hamburger Hafen muss abgewickelt werden. Vielleicht wird es ja ein schöner Yachthafen für Ausländer? Oder ein schönes renaturiertes Moorgebiet?

Der gesamte Verkehrsbereich muss umgestellt werden – beim Lieferverkehr auf Lastenräder, im Personenverkehr auf Rikschas, beim Fernverkehr auf indische Bahn-Verhältnisse. Müll kann nicht mehr abgeholt und schon gar nicht verbrannt werden. Es wird aber auch kaum noch welcher entstehen, weil es nichts mehr zu kaufen gibt. Dosen- und Flaschenpfand wird obsolet, weil es keine Blechdosen und Plastikflaschen mehr gibt. Und damit entfallen auch solche genialen Ideen wie an Plastikflaschen unlösbar angebrachte Schraubdeckel.

Da bleiben keine grünen Wünsche unerfüllt. Und genau deshalb wird die Umsetzung dieses Irrsinns auch nicht zu Ende geführt, weil die Hamburger rebellieren werden, wenn sie erst mal merken, dass sie auf dem besten Wege sind, ihre Existenzen zu zerstören. Dann merken sie nämlich auch, dass Klimaschutz und sozialverträglich nicht zusammenpassen. Der Staat hat kein Geld, das er verteilen kann, es sei denn, er hat es jemandem weggenommen. Es bleibt ein ehernes Gesetz: „irgendwann geht den Sozis immer das Geld der anderen aus“. Das gilt auch in der Freien- und Hansestadt Hamburg.

Die Frage ist nur, was wurde bis zum Abbruch des Klimairrsinns alles schon nachhaltig zerstört. Man betrachte nur die Energiewende, bei der der Point of no return schon überschritten ist.

Was nützt es der Welt, wenn Hamburg Harakiri begeht?

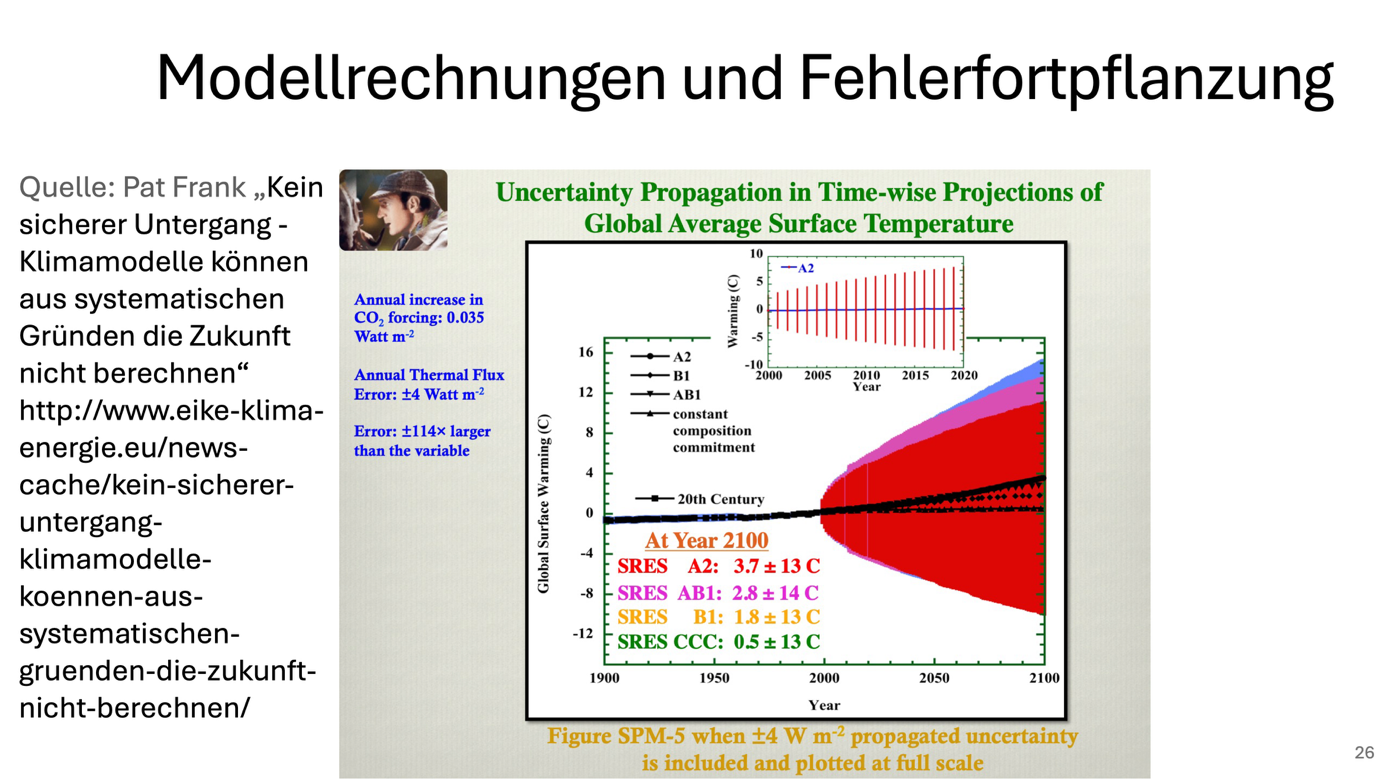

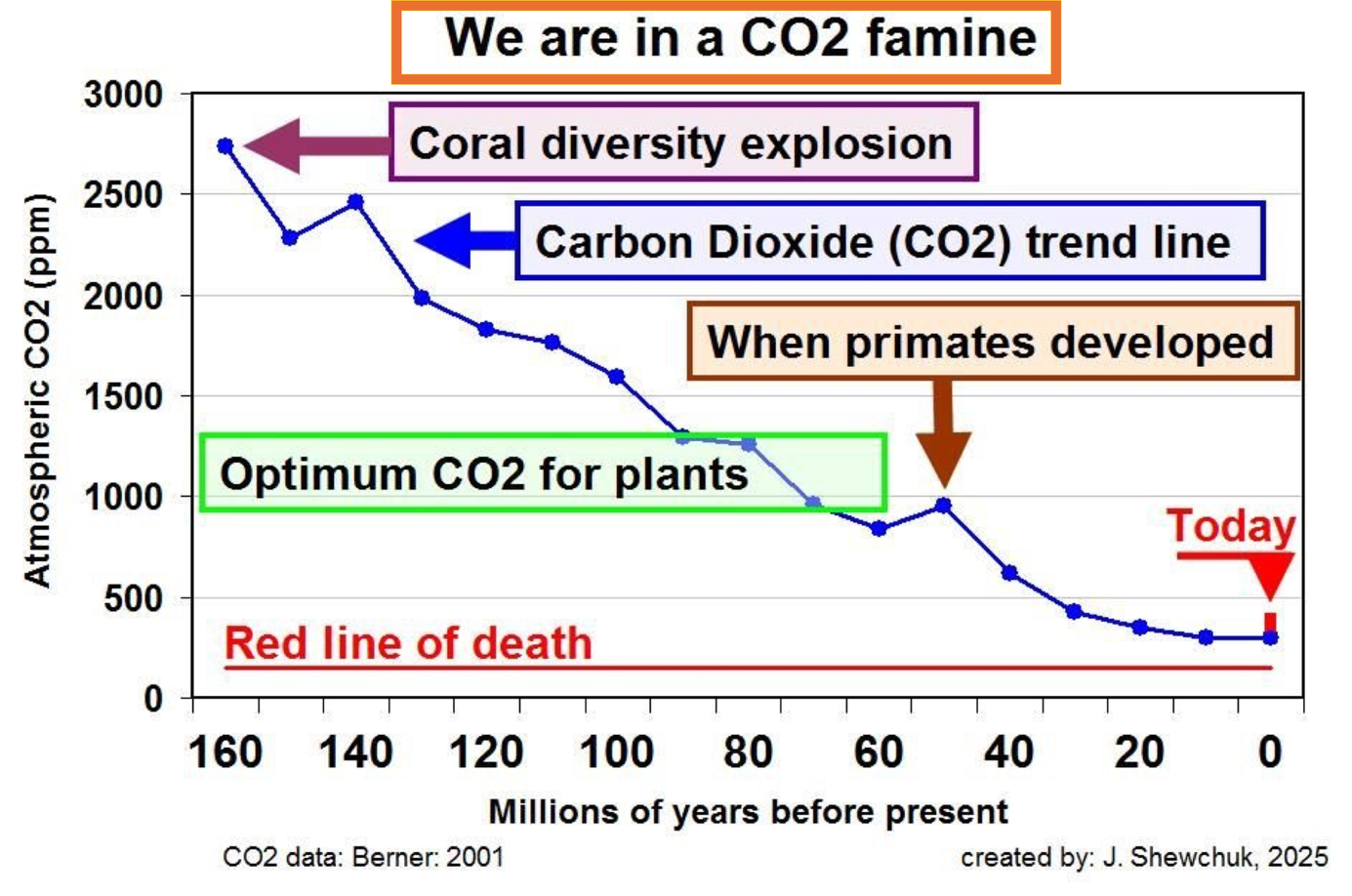

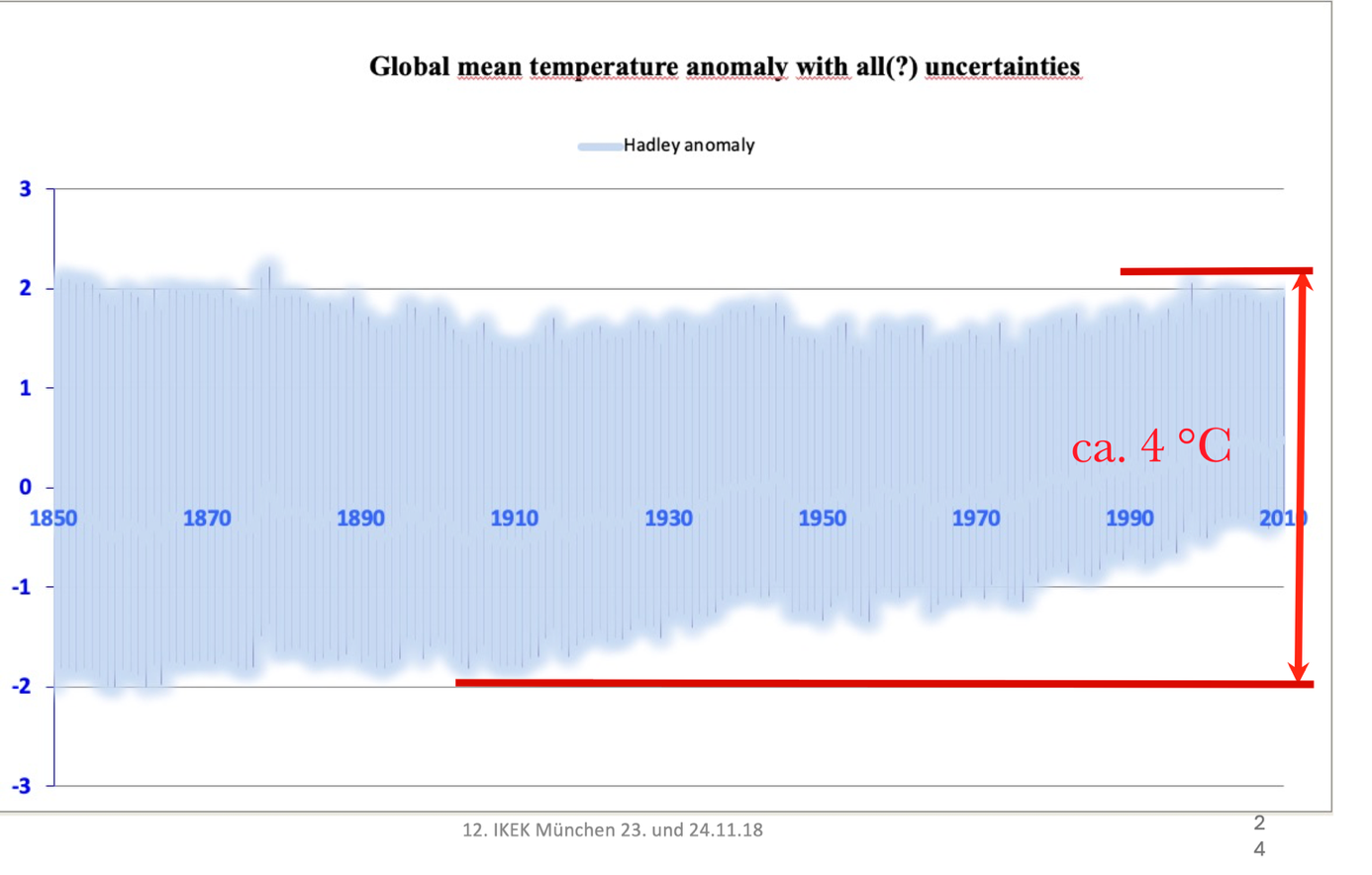

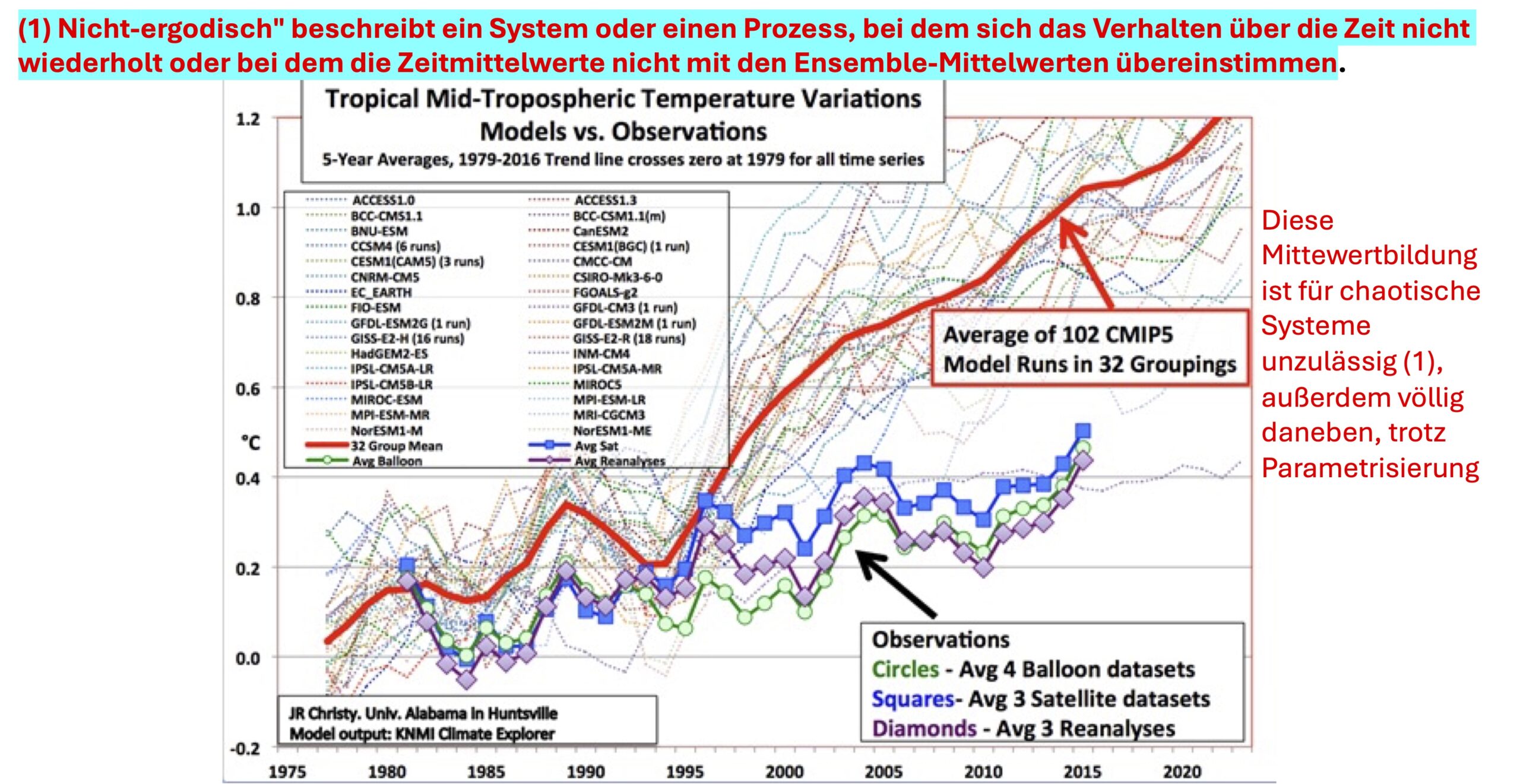

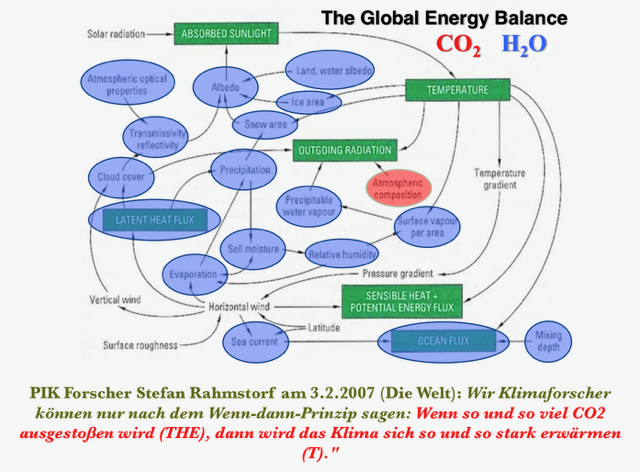

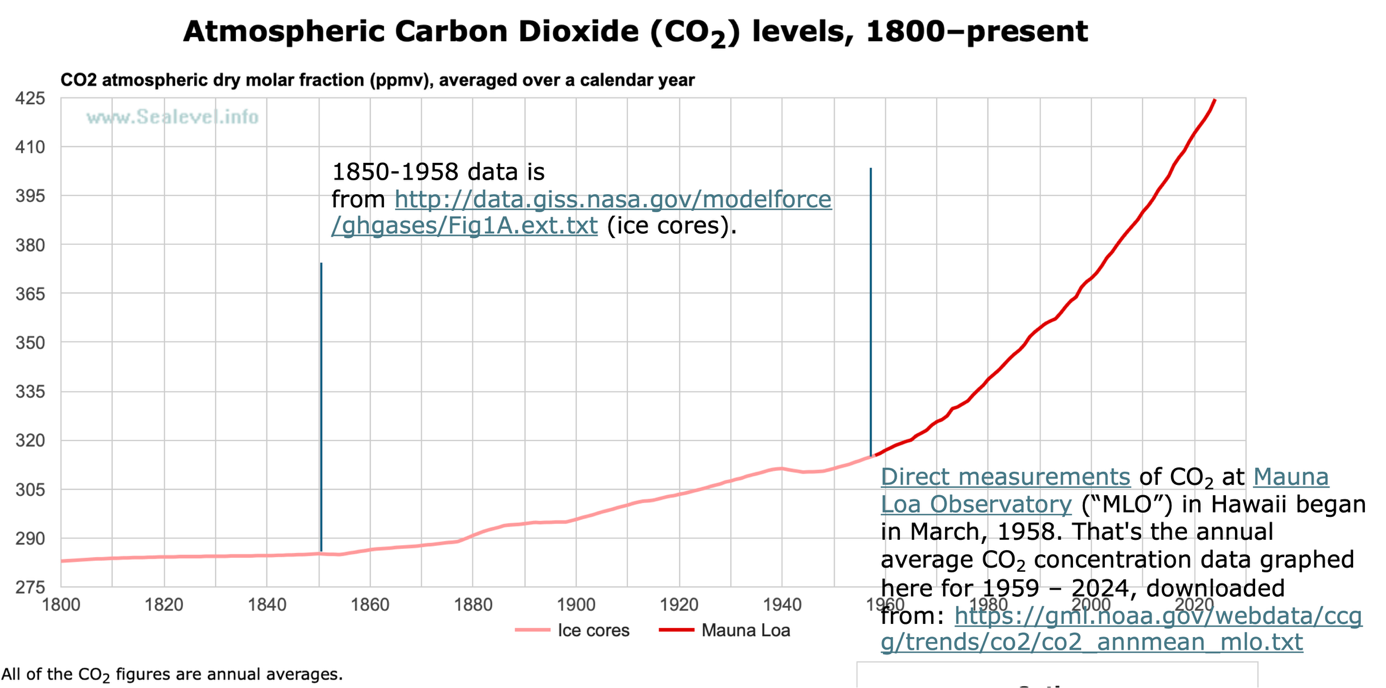

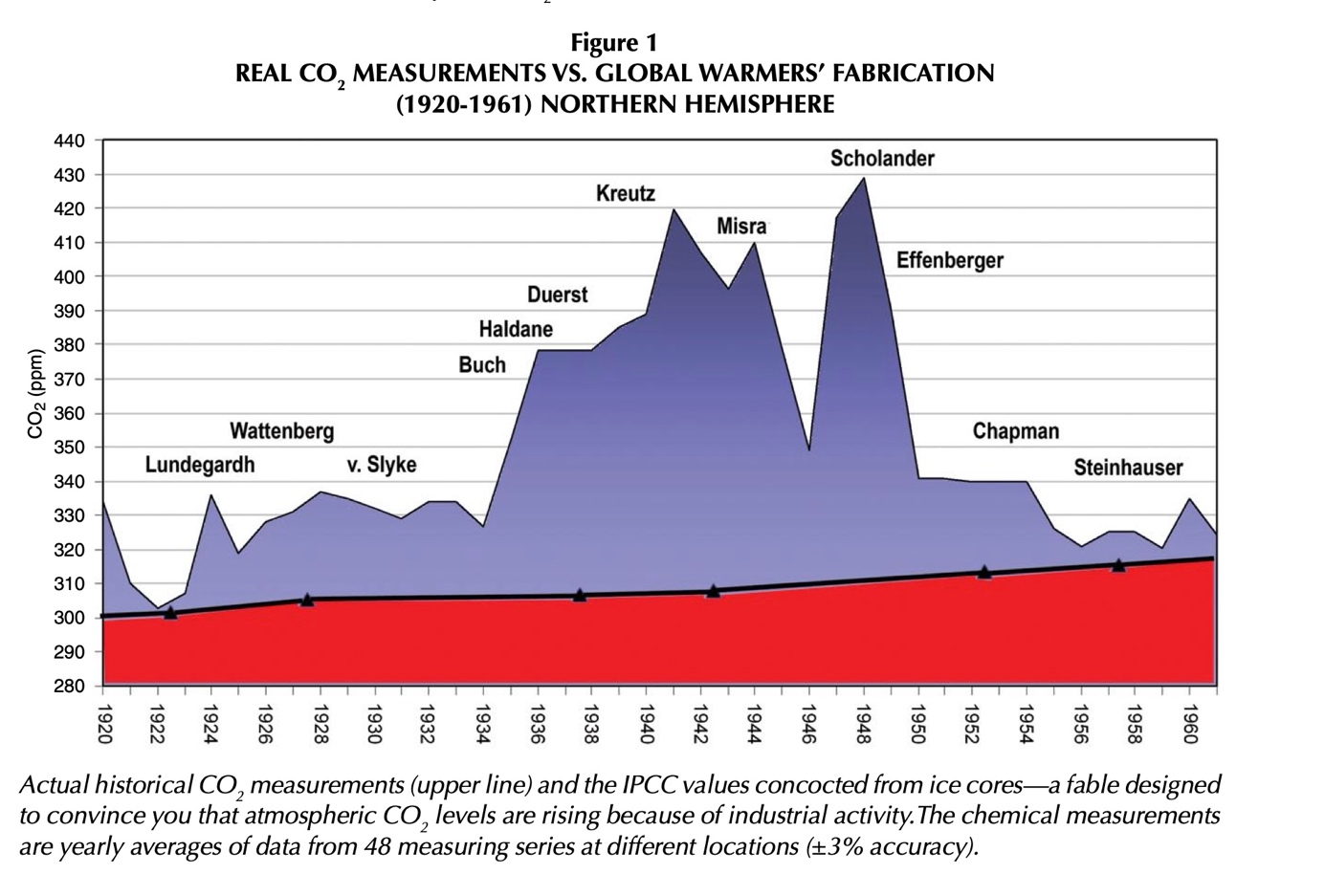

Eine weitere ketzerische Frage stellt sich: Ist „menschgemachtes Kohlendioxid“ wirklich ein Treiber des Weltklimas, das sich seit Äonen auch ohne Menschen ständig ändert? Oder ist es wahr, was Trump sagt: Der menschgemachte Klimawandel ist nur ein Betrug, mit dem ein Geldumschaufelbagger Unsummen aus den Gärten kleiner Leute in die Schatzkammern einiger Oligarchen befördert? Stimmt es, dass es selbst in Europa mittels der „Erneuerbaren“ ein paar Millionäre zu Milliardären gebracht haben?

Selbst wenn die Theorie vom menschgemachten Klimawandel stimmen würde, nützt der Klimaschutz-Selbstmord der Stadt Hamburg in irgend einer Weise dem Weltklima? Kurze Antwort: nichts, rien, nothing, nada, nitschewo, کچھ نہیں, 什麼都沒有, कुछ नहीं, hakuna kitu…. Europa erzeugt heute sechs Prozent des weltweiten CO2-Ausstoßes. Deutschland ungefähr 1,6 Prozent. Hamburg etwa 0,0275 Prozent. Noch Fragen?

Dröhnende Stille im Saal. „Doch, es bringt etwas!“ Ein Ruf von Luisa, der Luisa von der „Fridays for Future“-Fraktion, schneidet durch die Stille. Sie läuft nach vorn und schnappt sich das Mikrofon vom Rednerpult. „Doch, es bringt uns etwas! Wir ziehen die CO2 Ziele um 10 Jahre vor. Das vermindert den Anstieg des Hamburger Meeresspiegels um 20 cm! Ist das nichts? Die ganze CO2 emittierende Welt muss ihre Deiche bis 2100 um 150 cm erhöhen, das kostet! Wir hier in Hamburg aber, müssen die Deiche nur um 130 cm erhöhen, weil wir ja die Klimaziele zehn Jahre früher erreicht haben. 20 cm weniger Meeresspiegelanstieg, als die anderen. Wenn die anderen sehen, dass der Meeresspiegel bei uns weniger ansteigt, dann werden sie begreifen, das Klimaschutz wirkt und sinnvoll ist. Wir sind dann ein Vorbild für die Welt“.

Spricht’s und klebt sich zwecks Unterstreichung der Bedeutung ihrer Aussage mit Sekundenkleber am schönen hölzernen Rednerpult fest, das noch aus der Vor-Klimazeit stammt. Doch im Hintergrund taucht schon der Hausmeister mit der Laubsäge auf, um Luisa schonend vom Rednerpult zu lösen. Alles wird gut. Auch in Hamburg.

Manfred Haferburg wurde 1948 im ostdeutschen Querfurt geboren. Er studierte an der TU Dresden Kernenergetik. Im KUUUK-Verlag veröffentlichte er seinen auf Tatsachen beruhenden Roman „Wohn-Haft“ mit einem Vorwort von Wolf Biermann.

Der Beitrag erschien zuerst bei ACHGUT hier