Der nächste Heizungs-Schlag

Wer glaubte oder hoffte, mit Habecks Abgang sei der Spuk des „Heizungsgesetzes“ vergangen, hat sich gründlich getäuscht. Jetzt ist der nächste Irrsinn in Arbeit, die „Dekarbonisierung der Fernwärme“.

von Dr. Klaus-Dieter Humpich

Was für den Marxisten die „Klassenfrage“, ist für die CDU/CSU – und alle anderen Anhänger von UnsereDemokratie – der „menschengemachte Klimawandel“. Beides Irrlehren, die lediglich dem eigenen Machterhalt dienen. Schien nun der „Grüne Wasserstoff“ gerade als unverkäuflich, ist der nächste Irrsinn in Arbeit, die „Dekarbonisierung der Fernwärme“.

Fernwärme – der Transport von einer Zentrale zu den Wohnhäusern – ist beileibe kein neuer Gedanke. Es begann in den USA schon am Ende des 19. Jahrhunderts. Damals war der Transport der Kohle (Heizöl und Erdgas gab es noch nicht) und Asche das unmittelbare Problem. In Chicago hatte man sogar eine eigene U-Bahn für diesen Zeck unterhalten. Der Transport von heißem Wasser bzw. Dampf war die weitaus elegantere Lösung. Außerdem führte die kontrollierte Verbrennung in einer zentralen Kesselanlage gegenüber zahlreichen einzelnen Feuerstätten zu einer erhebliche Verbesserung der Luftqualität.

In den 1920er Jahren ging man in Berlin, Hamburg, München usw. noch einen Schritt weiter: Da auch der Stromverbrauch in den wachsenden Städten zunahm, baute man Kraftwerke in deren Nähe. Dort wurde die Abwärme der Stromerzeugung in das örtliche Fernwärmenetz eingespeist. Damit war das non plus ultra der „Energieerzeugung“ erreicht. Durch ständige Nachrüstung der Kraftwerke mit Abgasreinigungsanlagen waren bald die Abgase sauberer als die angesaugte Stadtluft. Kohle war ein heimischer Rohstoff und ließ sich für Monate bevorraten.

Für kleinere Städte kamen BHKW (Blockheizkraftwerke) auf der Basis von Motoren oder Gasturbinen infrage. Allerdings erfordern diese Heizöl oder Erdgas als Brennstoff. Üblich ist auch das Einsammeln von Abwärme aus der Müllverbrennung und manchen industriellen Prozessen (Chemie, Stahl etc.). Ausschlaggebend für die notwenigen Investitionen und die Technik ist die Vorlauftemperatur im Netz. Einerseits kann man um so mehr Wärmequellen mitnehmen, desto geringer die Temperatur ist, andererseits werden die notwendigen Rohre dicker und die Investitionen steigen.

Als sinnvoll haben sich maximale Temperaturen (am kältesten Tag) von 110°C bei reiner Heizung und 150°C für eine eventuelle Kälteerzeugung (Klimaanlagen) seit Jahrzehnten bewährt. Niedrigere Temperaturen werden zwar immer wieder vorgeschlagen, sind aber weder wirtschaftlich noch praktikabel. Geradezu albern ist die Abwärmenutzung von Rechenzentren. Die Computer fordern möglichst geringe Temperaturen zur Leistungssteigerung. Solch geringe Temperaturen könnte man höchstens in einem angrenzenden Neubau (Fußboden- und Wandheizung) verwenden.

Ein weiterer technischer Zombie ist die Erdwärmenutzung in Deutschland – immer wieder neu verkauft, aber auch immer wieder stillgelegt. Ebenso die geliebte „Großwärmepumpe“. Damit sie nicht zur rein elektrischen Heizung degeneriert, braucht sie eine Wärmequelle mit möglichst hoher Temperatur im Winter (Meer, Fluss, See) und möglichst milde Winter (geringe Vorlauftemperaturen).

Der nächste Weg in den Ruin

Wenn man die Studie zur Preisregulierung von Fernwärme des Bundesministeriums für Wirtschaft und Energie liest, kann einem nur angst und bange werden. Sie beginnt mit dem Glaubensbekenntnis „Deutschland hat sich das Ziel gesetzt, bis 2045 klimaneutral zu werden.“ Warum und wieso bis 2045, wird nicht erklärt. Aber es wird messerscharf gefolgert: „Bis 2045 soll sich demnach die Zahl der Fernwärmeanschlüsse in Deutschland in etwa verdreifachen. Das geht mit enorm hohen Investitionen einher.“ Eigentlich ist damit schon alles gesagt. Ein Wachstum um 300 Prozent in nur zwanzig Jahren bei einer ausgereiften Technik ist mehr als unwahrscheinlich – auf jeden Fall aber unwirtschaftlich, sonst wäre es schon lange geschehen.

Allerdings gibt es einen entscheidenden Unterschied zu den Träumen vom „grünem Stahl“: Die Stahlindustrie kann abwandern, wir nicht. Hier findet ganz unverschämt ein Angriff auf unsere Portemonnaies statt. Wer nicht zahlen kann, wird zwangsgeräumt! So ist das halt im schönsten Deutschland aller Zeiten.

„Insbesondere der Ausbau der Fernwärmenetze sollte deshalb weiterhin durch öffentliche Mittel unterstützt werden, da die Abschreibungs- und Nutzungszeiträume den Finanzierungszeitraum bei Weitem überschreiten. Würden sämtliche Investitionskosten vollständig an die jeweiligen Netzkundinnen und -künden weitergegeben, würde das die Bezahlbarkeit der Wärmeversorgung für einen wesentlichen Teil der Haushalts- und Gewerbekunden stark gefährden.“

Wie weit sich diese Regierung schon von der Marktwirtschaft entfernt hat, hätte man uns nicht deutlicher mitteilen können. „Öffentliche Mittel“ müssten auch vorher durch Enteignung von uns allen eingetrieben werden. Auch im 3. Sozialismus hintereinander wird mit Sicherheit kein Geld auf Bäumen wachsen. Typen wie Klingbeil haben auf alles die immer gleiche Antwort: „Aufgrund der absehbar hohen notwendigen Investitionen sind neue Finanzierungsmöglichkeiten für die Fernwärmetransformation zu prüfen, um sozialverträgliche Fernwärmepreise zu ermöglichen.“ Noch mehr Staatsverschuldung, damit die Party (kurzfristig) weiterlaufen kann? Leute, diesmal gibt es kein Beitrittsgebiet. Diesmal wird die Suppe allein ausgelöffelt.

In Deutschland werden derzeit mehr als zwei Drittel der Fernwärme aus Kohle und Erdgas erzeugt. Weniger als 30 Prozent aus Biomasse und Abwärme. Wie leichtfertig in UnsereDemokratie Gesetze zusammengeschustert werden, zeigt der §29 des Wärmeplanungsgesetzes, in dem ein Anteil von „mindestens 30 Prozent aus erneuerbaren Energien, unvermeidbarer Abwärme oder einer Kombination“ bis zum 1. Januar 2030 bzw. mindestens 80 Prozent bis 2040 vorgeschrieben wird. Wo sollen denn in so kurzer Zeit die Biomasse, die Flüsse etc. bereitgestellt werden? Gar nicht von den nötigen Kesseln und Wärmepumpen zu reden. Ganz nebenbei wäre das auch das Ende der Kraft-Wärme-Kopplung in Deutschland.

Wie viel Ideologie und Wunschdenken vorausgesetzt werden muss, steht im Klimaschutzgesetz. Danach muss die Jahresemissionsmenge von 118 Millionen Tonnen CO2 im Jahr 2020 auf 70 Millionen Tonnen 2030 bei den Gebäuden gesenkt werden. Wir erschaffen uns also in den nächsten fünf Jahren völlig neue Städte, um das Ziel einer Absenkung auf 59 Prozent zu erreichen. Gleichzeitig wollen sie auch noch 400.000 Wohnungen pro Jahr zusätzlich bauen. Respekt, solche Fünf-Jahres-Pläne hätte sich nicht einmal Erich Honecker getraut.

Der Finanzbedarf

Die Studie geht davon aus, dass bis 2045 die Zahl der angeschlossenen Wohngebäude um 177 Prozent von 1,3 Millionen auf 3,6 Millionen ansteigt. Dadurch soll die Wärmenachfrage (nur) um 51 Prozent zunehmen, denn vorher werden ja alle Gebäude saniert. Wunschdenken auch hier. Der Investitionsbedarf wird hierfür mit 43,5 Milliarden Euro bis 2030 und weiteren 74 Milliarden Euro bis 2045 abgeschätzt. 60 Prozent der Investitionen sollen dabei auf das Rohrnetz und 40 Prozent auf „klimafreundliche Erzeugungsanlagen“ entfallen. Hinzu kommen natürlich noch die Modernisierungskosten für die Mieter. Absehbar würden die Nebenkosten die eigentliche Miete drastisch übersteigen. Werden wir also ein Volk von Obdachlosen?

Wie immer erschallt der Ruf nach Subventionen. Diesmal gleich in vier Modulen:

- Transformationspläne und Machbarkeitsstudien,

- Systemische Förderung für Neubau und Bestandsnetze,

- Einzelmaßnahmen und

- Betriebskostenförderung

Für all das sollen knapp 3 Milliarden Euro im Haushalt 2026 zur Verfügung gestellt werden.

Wie es die Anderen machen

Kein Fernwärmenetz kann ad hoc ausgebaut werden. In unseren Städten sind die Straßen bereits voll mit Leitungen. Jede zusätzliche Leitung erfordert umfangreiche Planung, Abstimmung mit anderen Versorgern und Umverlegungen. Allein die Kosten für den Straßenbau sind nur vertretbar, wenn ohnehin eine Sanierung ansteht. Private Unternehmen haben deshalb immer einen stetigen Ausbau ihrer Netze vorgenommen. Jede Investition muss sich rechnen. Kommunale Betriebe setzen meist auf eine Mischkalkulation. Geht die Kalkulation nicht auf, muss halt der Steuerzahler ran. Oft auch in der Form erhöhter Abgaben (z.B. Parkgebühren, Müllabfuhr usw.).

Interessant ist auch ein Blick ins Ausland. Dort ist man oft viel weiter, weil man mit dem Ausbau spätestens nach der Ölkrise 1976 angefangen hat. Meistens hat man auch nicht nur auf Erdgas als Energieträger gesetzt. Gerade in „den fünf neuen Ländern“ hat man mit großem Aufwand flächendeckend ein Gasnetz neu aufgebaut, welches man nun wieder abreißen will. In den Ländern, in denen man konsequent bei Kohle geblieben ist, hat man jetzt einen gewissen Vorteil. Man geht die Umstellung (direkt) auf Kernenergie an. So sind z.B. in den skandinavischen Ländern kleine Heizreaktoren in Vorbereitung. Sie verbinden ideal Versorgungssicherheit, Umweltschutz und Kosten miteinander.

Dr. Klaus-Dieter Humpich studierte Maschinenbau und Energie- und Verfahrenstechnik mit Schwerpunkt Kerntechnik, bevor er zehn Jahre am Institut für Kerntechnik in der Technischen Universität Berlin arbeitete. Seit 20 Jahren ist er freiberuflich im Bereich Energietechnik tätig. Dieser Beitrag erschien zuerst auf seinem Blog.

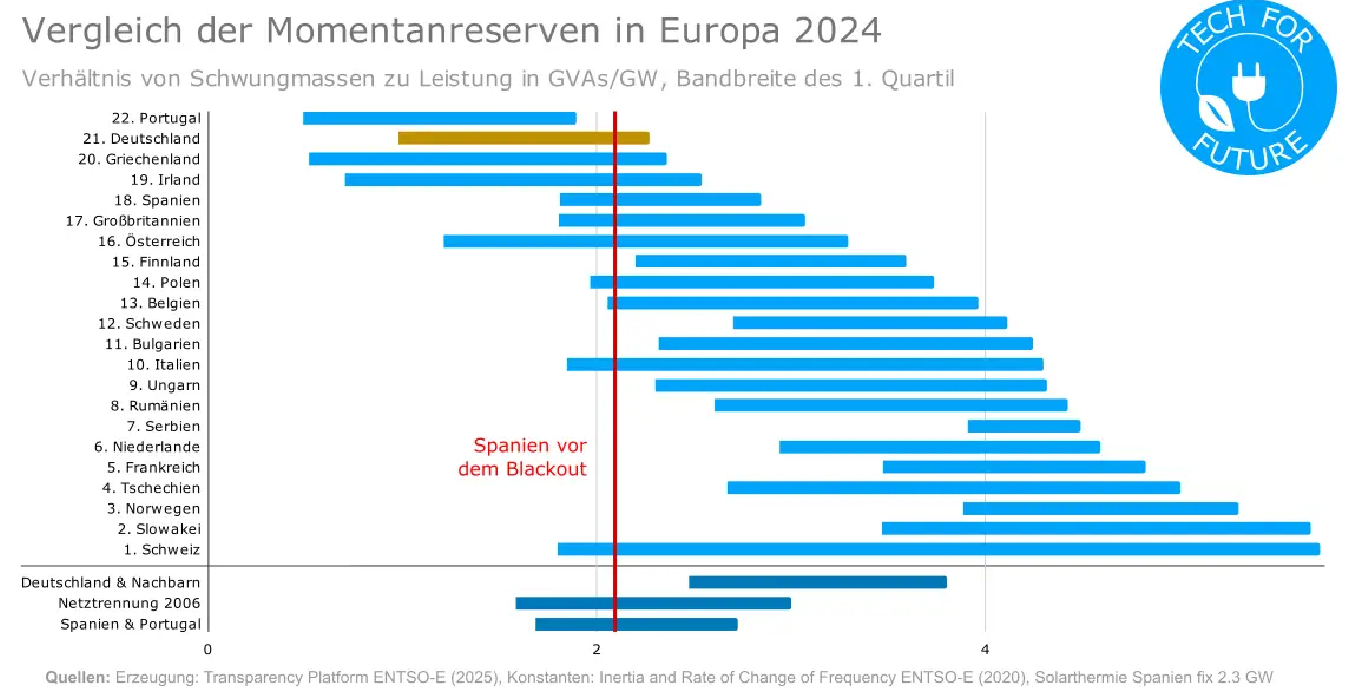

Quelle: TechForFuture, Florian Blümm

Quelle: TechForFuture, Florian Blümm