118 neue Gaskraftwerke bis 2035 nötig: Bundesnetzagentur alarmiert über fehlende Kapazitäten

Um Deutschlands Stromversorgung auch in Zukunft sicherzustellen, sind viele neue steuerbare Kraftwerke nötig. Das steht im neuen Bericht zur Versorgungssicherheit der Bundesnetzagentur. Der Bedarf ist gewaltig und vermutlich dennoch nicht ausreichend.

von Maurice Forgeng

Um Deutschlands Stromversorgung auch in Zukunft sicherzustellen, sind viele neue steuerbare Kraftwerke nötig. Das steht im neuen Bericht zur Versorgungssicherheit der Bundesnetzagentur. Der Bedarf ist gewaltig und vermutlich dennoch nicht ausreichend.

Laut Bundesnetzagentur sollen Gaskraftwerke in Deutschland künftig die Versorgungssicherheit garantieren.

In Kürze:

- Die Bundesnetzagentur veröffentlichte Anfang September den Bericht zur Versorgungssicherheit.

- Die binnen zehn Jahren erforderlichen bis zu 35,5 Gigawatt Reservekapazität entsprechen einem neuen Gaskraftwerk pro Monat.

- Ein Solarverband kritisiert, dass Potenziale von Batterieparks nicht ausreichend erwähnt wurden, und fordert die Überarbeitung des Berichts.

- Der aktuelle Systemstabilitätsbericht der Übertragungsnetzbetreiber zeigt seinerseits, wie viele Aspekte im Stromnetz „nicht ausgereift“ sind.

- Erneut wird ein Kapazitätsmechanismus genannt, der bereits mit einer neuen Stromsteuer in Verbindung gebracht wurde.

Wie stabil ist das deutsche Stromnetz im Rahmen der Energiewende?

Dieser Frage hat sich die Bundesnetzagentur mit dem Bericht zu Stand und Entwicklung der Versorgungssicherheit im Bereich der Versorgung mit Elektrizität gewidmet. Im Juni 2025 erschien dazu auch der Systemstabilitätsbericht der deutschen Übertragungsnetzbetreiber TenneT, 50 Hertz, Ampiron und TransnetBW.

Riesige neue Kraftwerkskapazitäten benötigt

Das am 3. September 2025 erschienene Monitoring der Bundesnetzagenturanalysiert die Entwicklung im Stromsystem bis zum Jahr 2035. Klaus Müller, Präsident der Bundesnetzagentur, teilte zusammenfassend dazu mit:

„Die Stromversorgung ist auch in Zukunft sicher, wenn zusätzliche steuerbare Kapazitäten errichtet werden.“

Damit teilte der Bundesnetzagentur-Chef klar mit, dass das deutsche Stromsystem dringend mehr grundlastfähige Kraftwerke benötigt. Diese müssen auch dann Strom liefern können, wenn die Windkraft und Photovoltaik aufgrund schlechter Wetterbedingungen zu wenig Strom bereitstellen. Da die aktuelle Regierung am Atomausstieg festhält und die Kohlekraftwerke ebenfalls bis spätestens 2038 vom Netz gehen sollen, bleibt nur die Verstromung von Erdgas.

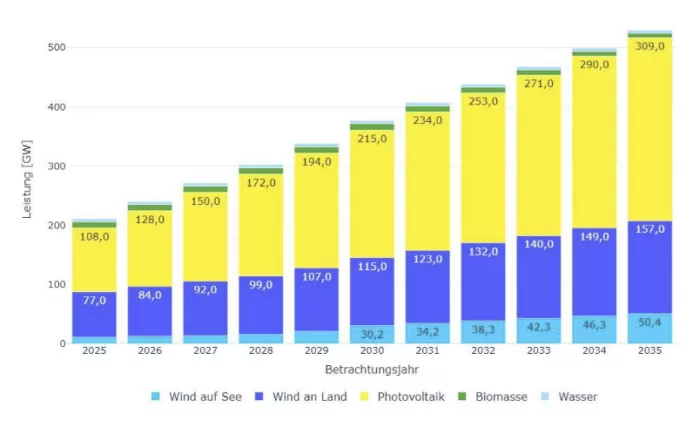

Konkret müssen laut der Energiebehörde bis 2035 zusätzliche Reservekraftwerke mit bis zu 22,4 Gigawatt (GW) elektrischer Leistung entstanden sein, sofern das Zielszenario eintritt. In diesem werde Deutschland künftig alle energiewirtschaftlichen und energiepolitischen Ziele erreichen.

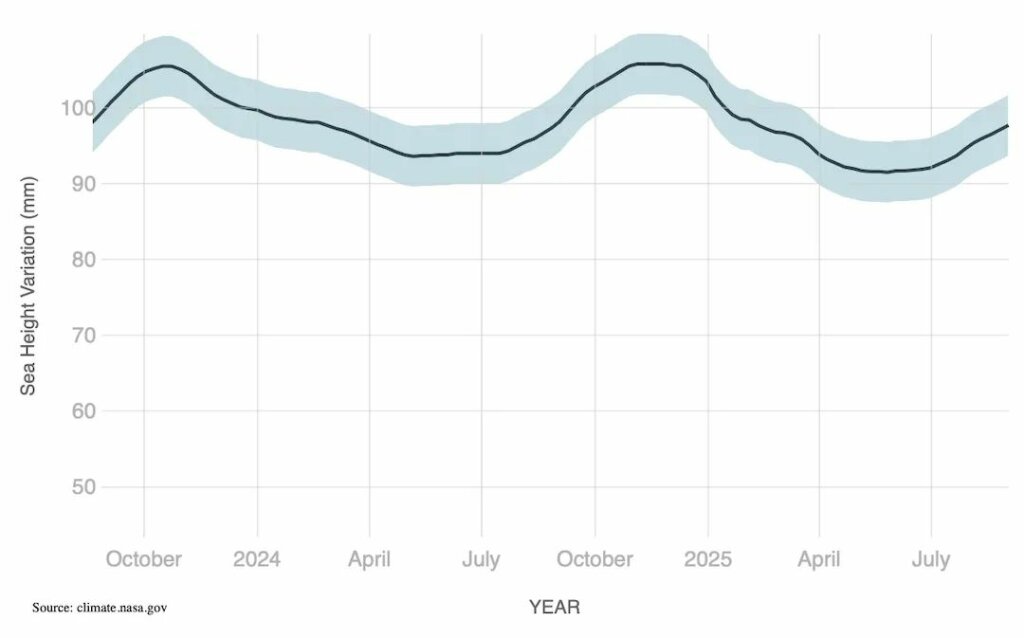

Ausbauziele der installierten Leistung von hauptsächlich Wind- und Photovoltaikanlagen in Deutschland (interpoliert).

Foto: Bundesnetzagentur

Neben dem starken Ausbau von Wind und Solar beinhalten diese „hohe Flexibilitätspotentiale bei neuen Verbrauchern“ ebenso wie Wärmepumpen, Stromspeicher, Elektroautos oder Elektrolyseure. Die Bundesnetzagentur nennt zudem die Installation geeigneter Messsysteme. Für E-Autos ist in diesem Rahmen angedacht, dass sie ihren Strom dem Netz in Mangelzeiten teilweise zur Verfügung stellen. Auch die Industrie solle ihren Stromverbrauch flexibel anpassen, ihn also bei Strommangel herunterfahren.

Falls die Zubauziele verfehlt werden und die Flexibilität zu gering ausfällt, hat die Bundesnetzagentur zusätzlich das Szenario „verzögerte Energiewende“ errechnet. Dabei wären steuerbare Kapazitäten von bis zu 35,5 GW nötig. Da ein einfaches Gasturbinenkraftwerk im Schnitt rund 300 Megawatt (MW) an Leistung bringen kann, wären dafür 118 Gaskraftwerke nötig. Selbst beim Zielszenario wären noch 75 solcher Kraftwerke nötig.

Beachtenswert ist zudem, dass die Ausbauziele in Deutschland im Jahr 2035 mehr als 500 GW an installierter Leistung durch „erneuerbare“ Energien vorsehen. Trotz der erheblichen Überkapazität der Erneuerbaren fordert die Energiebehörde damit, dass neue Grundlastkraftwerke ein Drittel bis über die Hälfte des jetzigen Strombedarfs decken können müssen.

Bereits berücksichtigt hat die Energiebehörde in ihrer Rechnung geplante Stilllegungen bestehender Kraftwerke. Würde keines der bestehenden Kraftwerke stillgelegt werden, wären im Zielszenario noch 42 und bei der „verzögerten Energiewende“ 85 der genannten Gaskraftwerke nötig.

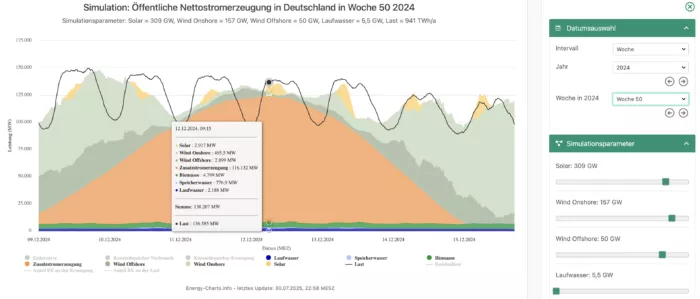

Zugleich gibt die Behörde für das Jahr 2035 einen Jahresstromverbrauch von 941 Terawattstunden an, also fast das Doppelte wie aktuell.

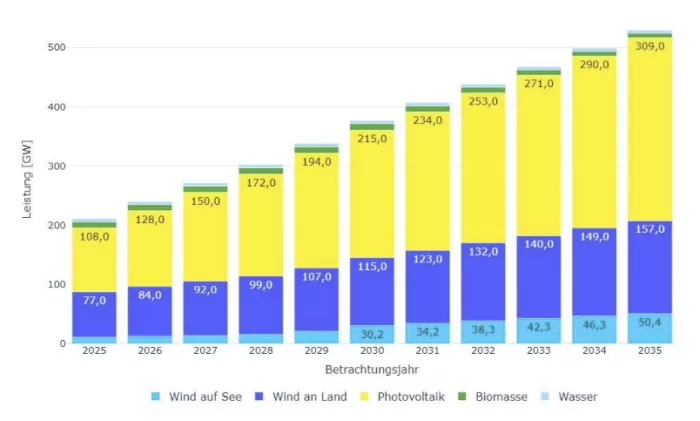

Ereignet sich dann eine Dunkelfraute, also das Fehlen von Wind und Sonnen, wie vom 11. bis 14. Dezember 2024 wäre laut der Simulation des Portals „Energy Charts“die Zusatzstromerzeugung bei Weitem nicht ausreichend. Auch bei Erreichen der Ausbauziele wären in diesem Fall bis über 116 GW steuerbare Kapazität nötig.

Simulierte Stromerzeugung für Deutschland mit den geplanten Windkraft- und Solarwerten und der von der Behörde geschätzte Jahresstromverbrauch von 941 Terawattstunden. Als Relevanz dienen die Wind- und Solarwerte von Kalenderwoche 50 aus dem Jahr 2024.

Foto: Bildschirmfoto/energy-charts.info/Fraunhofer ISE

Verzögerte Energiewende wahrscheinlicher?

Wahrscheinlicher dürfte jedoch das Eintreten des Szenarios „verzögerte Energiewende“ sein. Wie Bundeswirtschaftsministerin Katherina Reiche (CDU) bereits angekündigt hat, will sie Betreiber von Windkraft- und Solaranlagen künftig mehr zur Verantwortung ziehen, indem sie sich beispielsweise an den Netzausbaukosten beteiligen sollen. Das könnte die Attraktivität dieser „erneuerbaren“ Kraftwerke spürbar reduzieren und den bisweilen gut laufenden Ausbau abbremsen.

Zudem soll in Kürze das Ergebnis der Prüfung der deutschen Energiewende folgen. Wie Reiche bereits andeutete, müsse sich der Zubau der „Erneuerbaren“ am Netz orientieren und nicht umgekehrt. Das lässt vermuten, dass die Regierung den Fokus bald weniger auf den Zubau der Erneuerbaren und mehr auf den Netzausbau legt, um die Versorgungssicherheit zu erhöhen.

Die Versorgungssicherheit ist im Zielszenario laut Bundesnetzagentur nur dann gewährleistet, wenn etwa der Netzausbau wie geplant verwirklicht wird. Wie der Bundesrechnungshof im vergangenen Jahr festgestellt hat, liegt dieser rund sieben Jahre im Rückstand.

Umsetzung der Reserve fragwürdig

Diese neue Kraftwerkskapazität müsste innerhalb der kommenden zehn Jahre betriebsbereit sein. Gemessen an der reinen Bauzeit wäre dies ein mehr als realistischer Rahmen. Der Bau des Gaskraftwerks Leipheim mit 300 MW hat knapp 24 Monate beansprucht. Allerdings müssen im Vorfeld Kraftwerksstandorte festgelegt und genehmigt werden, was zusätzlich Zeit benötigt.

Um bis 2035 besagte 118 Gaskraftwerke zur Verfügung zu haben, müsste jeden Monat ein solches Kraftwerk fertiggestellt werden. Um eine mehrtägige Dunkelflaute zu überbrücken, sind 387 Gaskraftwerke nötig und es müssten – parallel zum Ausbau der Erneuerbaren – mindestens drei Gaskraftwerke pro Monat entstehen.

Dass eine politische Ankündigung nicht zu einer schnellen Umsetzung führt, zeigte bereits die Forderung des früheren Wirtschaftsministers Robert Habeck (Grüne). Bereits vor zwei Jahren sprach er davon, umgehend 8,8 GW an neuen Kraftwerken, möglichst wasserstofffähige Gaskraftwerke, auszuschreiben. Dem folgte bis heute kein Realisierungsansatz. Die aktuelle Bundeswirtschaftsministerin Katherina Reiche (CDU) spricht von Ausschreibungen von „mindestens 20 Gigawatt Gaskraftwerken“.

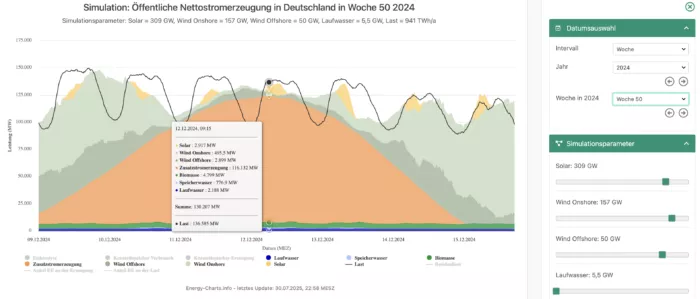

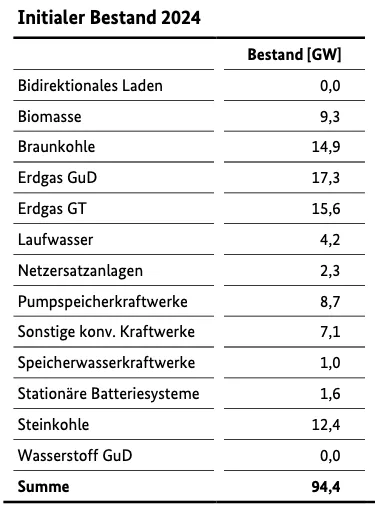

Ausgangsbestand der steuerbaren Kraftwerke und Speicher in Deutschland am 01.02.2024.

Foto:, Bundesnetzagentur

Systemstabilitätsbericht zeigt massive Sicherheitslücken

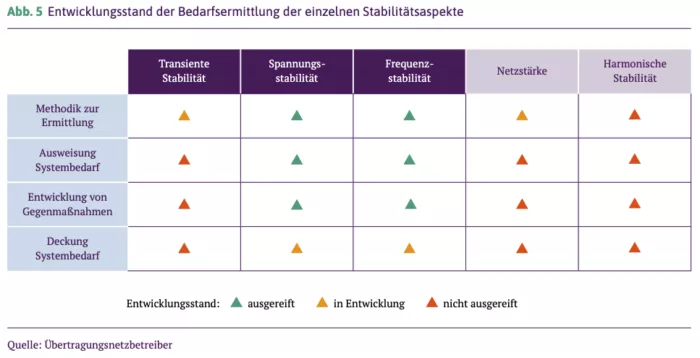

Mit dem Systemstabilitätsbericht 2025 wollten die deutschen Übertragungsnetzbetreiber den aktuellen Stand der einzelnen Stabilitätsaspekte unserer Stromnetze darstellen. Das soll die eingangs gestellte Frage ebenso beantworten.

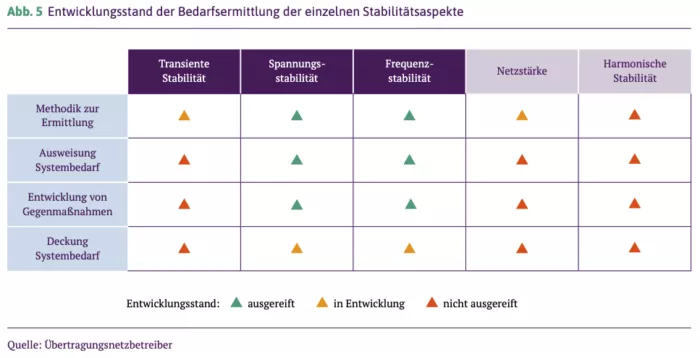

Entwicklungsstand der Bedarfsermittlung der einzelnen Stabilitätsaspekte.

Foto: Bundesnetzagentur, Systemstabilitätsbericht 2025

Die beiden Aspekte Frequenz- und Spannungsstabilität schneiden bei der Untersuchung noch am besten ab. Die Netzfrequenz liegt im europäischen Verbundnetz bei 50 Hertz. Diesen Wert müssen die Netzbetreiber möglichst konstant halten. Dazu muss die Stromerzeugung jederzeit genauso groß sein wie der Stromverbrauch. Die Spannungsstabilität beschreibt das Aufrechterhalten der Netzspannung.

Sowohl Frequenz- als auch Spannungsstabilität können die Übertragungsnetzbetreiber ermitteln und den Systembedarf definieren. Ebenso können sie bei Abweichungen Gegenmaßnahmen entwickeln, um diese stabil zu halten. Allerdings ist bei beiden Aspekten der Systembedarf noch nicht gedeckt. Sprich, TenneT und Co. können im Netz nicht die benötigten Strommengen halten, um das Netz stabil zu halten.

Das liegt unter anderem an der zunehmend fehlenden Momentanreserve, also mechanisch rotierende Schwungmassen von Turbinen in Großkraftwerken. Sie stabilisieren das Netz, da sie Spannungs- und Frequenzstörungen kompensieren können. Photovoltaik- und Windkraftanlagen können dies nicht. Sie speisen elektronisch über Wechselrichter ihren Strom in die Netze ein und sind vielmehr auf ein stabiles Netz angewiesen. Je mehr Wechselrichter und je weniger Momentanreserve, desto instabiler die Netze. Das führte im April letztlich zum Stromausfall auf der iberischen Halbinsel.

Noch „nicht ausgereift“

Deutlich kritischer sieht es bei der sogenannten „Transienten Stabilität“ aus, also wie sich das Netz bei Schwankungen verhält. Hier ist noch kein Bereich ausgereift. Die Methodik zur Ermittlung befindet sich noch „in Entwicklung“, die übrigen Bereiche sind noch „nicht ausgereift“. Auch hier spricht der Bericht von den rotierenden Massen:

„Die Analyse zeigt eine Verbesserung der Systemstabilität bei Erhöhung der Momentanereserve, wohingegen eine Reduktion der Momentanereserve zu einer Verschlechterung führt.“

Die Bilanz der allgemeinen „Netzstärke“ gleicht der „Transienten Stabilität“. So steht im Systemstabilitätsbericht: „Netzfolgende Stromrichter [Wechselrichter von Wind und Solar] tragen unter konservativen Annahmen hingegen nicht zur Netzstärke bei.“ Das bedeutet: Je mehr einspeisende Wechselrichter am Netz sind, umso instabiler wird das System.

Der letzte Aspekt, die „Harmonische Stabilität“, schneidet von allen Aspekten am schlechtesten ab. Hier ist jeder Bereich bisher „nicht ausgereift“. Die „Harmonische Stabilität“ beschreibt, wie gut es Wechselrichtern gelingt, „keine unzulässigen Schwingungen auszubilden“. Wechselrichter erzeugen solche Schwingungen. Das bedeutet, wenn ein Wechselrichter eine Oberschwingung aussendet, darf ein andere diese nicht auffangen und verstärken. Ein Netz mit viel Momentanreserve kann Oberschwingungen gut abfangen.

In Spanien haben diese Schwingungen zu einer erhöhten Netzspannungen geführt, was wiederum den Blackout auslöste.

Der Bundesverband Solarwirtschaft (BSW-Solar) begrüßt, dass der neue Bericht zur Versorgungssicherheit den Ausbau der „Erneuerbaren“ betont. Gleichzeitig kritisiert der Verband die mangelnde Erwähnung der Potenziale von Batteriespeichern für die Versorgungssicherheit.

Zwar schrieb die Bundesnetzagentur unter anderem: „Speicher werden eine immer wichtigere Funktion einnehmen. Schon heute können sich besonders Batteriespeicher im Strommarkt refinanzieren, wie die aktuelle Ausbaudynamik beweist. In bestimmten Marktsituationen können Speicher den Bedarf an zusätzlichen Kraftwerkskapazitäten reduzieren.

Dennoch forderte BSW-Solar die Überarbeitung des Berichts. Laut dem Verband habe die Bundesnetzagentur die Potenziale von Batteriegroßspeichern unzureichend abgebildet. Damit sei eine zentrale Realität der Energiewende ausgeblendet.

Dazu erklärte Carsten Körnig, Hauptgeschäftsführer des Bundesverbandes Solarwirtschaft: „Während Netzbetreiber bereits heute Zusagen für viele Gigawatt[stunden] an Speicherkapazitäten erteilt haben und bundesweit Anschlussanfragen in dreistelliger Gigawatt-Höhe vorliegen, bleibt der Bericht bei den Zahlen von gestern stehen und geht sogar realitätsfern von einem Rückbau stationärer Batteriespeicher aus.“ Körnig warf der Energiebehörde eine systematische Unterschlagung der Großspeicher vor.

Hierbei ist jedoch zu beachten, dass Batteriespeicher selbst keinen Strom erzeugen können. Sie speichern diesen nur zwischen. Daher können sie Kraftwerke nicht ersetzen.

Aktuell liegt die installierte Kapazität aller deutschen Batteriespeicher bei 20,7 Gigawattstunden (GWh), die der netzdienlichen Großspeicher bei nur knapp 3 GWh. Es besteht ein akuter Anschlussstau, sodass viele, die einen Batteriepark errichten wollen, teilweise zehn Jahre und länger warten müssen. Das liegt wiederum an der mangelnden Netzinfrastruktur.

Kommt ein Kapazitätsmechanismus?

Im Bericht der Bundesnetzagentur sagte Müller: „Unser Monitoring unterstreicht die Bedeutung der von der Bundesregierung geplanten Kraftwerksstrategie. Die weiteren notwendigen Kapazitäten sollten über einen Kapazitätsmechanismus bereitgestellt werden. Außerdem ist es wichtig, dass immer mehr Stromverbraucher flexibel auf Strompreise reagieren.“

Das bedeutet: Um den zusätzlichen Bedarf an neuen Kraftwerkskapazitäten zu finanzieren, ist ein sogenannter Kapazitätsmechanismus nötig. Dies soll laut dem Bericht eine technologieneutrale Finanzierungsmethode sein.

Dazu kursierte Anfang August das Gerücht einer neuen Stromsteuer. Das Wirtschaftsministerium hat dies allerdings nicht bestätigt. Stattdessen gebe es bei den „Möglichkeiten der Finanzierung“ noch „keine Festlegungen“. Auch der aktuelle Bericht zur Versorgungssicherheit bestätigt, dass der Kapazitätsmechanismus „zurzeit von der Bundesregierung erarbeitet“ wird.

Bis ausreichend Reservekraftwerke errichtet sind, bleibt die Versorgungssicherheit im deutschen Stromnetz ein Fragezeichen. Verzögerungen beim Ausbau der „Erneuerbaren“ würden laut der Energiebehörde die Versorgungssicherheit beeinflussen. Je mehr Strom aus Erneuerbaren erzeugt wird, desto wichtiger aber auch und rentabler werden Speicher und Nachfrageflexibilitäten.

Das Monitoring bestätigt, dass die zu transportierenden Energiemengen in den kommenden Jahren weiter ansteigen. Um diesen Veränderungen gerecht zu werden, bedarf es eines weiteren raschen Netzausbaus. Die Ergebnisse zeigen auch, dass Redispatchmaßnahmen in den kommenden Jahren notwendig bleiben. Diese haben in den vergangenen Jahren immer wieder neue Rekordwerte erreicht. Auch für 2025 wird ein neuer erwartet.

Der Beitrag erschien zuerst bei EPOCH Times hier

Laut Bundesnetzagentur sollen Gaskraftwerke in Deutschland künftig die Versorgungssicherheit garantieren.

Foto: Ruediger Fessel/iStock, Canva, Collage: Epoch Times

13. September 2025

Lesedauer: 14 Min.

In Kürze:

- Die Bundesnetzagentur veröffentlichte Anfang September den Bericht zur Versorgungssicherheit.

- Die binnen zehn Jahren erforderlichen bis zu 35,5 Gigawatt Reservekapazität entsprechen einem neuen Gaskraftwerk pro Monat.

- Ein Solarverband kritisiert, dass Potenziale von Batterieparks nicht ausreichend erwähnt wurden, und fordert die Überarbeitung des Berichts.

- Der aktuelle Systemstabilitätsbericht der Übertragungsnetzbetreiber zeigt seinerseits, wie viele Aspekte im Stromnetz „nicht ausgereift“ sind.

- Erneut wird ein Kapazitätsmechanismus genannt, der bereits mit einer neuen Stromsteuer in Verbindung gebracht wurde.

Wie stabil ist das deutsche Stromnetz im Rahmen der Energiewende?

Dieser Frage hat sich die Bundesnetzagentur mit dem Bericht zu Stand und Entwicklung der Versorgungssicherheit im Bereich der Versorgung mit Elektrizität gewidmet. Im Juni 2025 erschien dazu auch der Systemstabilitätsbericht der deutschen Übertragungsnetzbetreiber TenneT, 50 Hertz, Ampiron und TransnetBW.

MEHR DAZU

Stromversorgung „sehr zuverlässig“? – Mr. Blackout: „Instabilstes Netz seit 50 Jahren“

Riesige neue Kraftwerkskapazitäten benötigt

Das am 3. September 2025 erschienene Monitoring der Bundesnetzagenturanalysiert die Entwicklung im Stromsystem bis zum Jahr 2035. Klaus Müller, Präsident der Bundesnetzagentur, teilte zusammenfassend dazu mit:

„Die Stromversorgung ist auch in Zukunft sicher, wenn zusätzliche steuerbare Kapazitäten errichtet werden.“

Damit teilte der Bundesnetzagentur-Chef klar mit, dass das deutsche Stromsystem dringend mehr grundlastfähige Kraftwerke benötigt. Diese müssen auch dann Strom liefern können, wenn die Windkraft und Photovoltaik aufgrund schlechter Wetterbedingungen zu wenig Strom bereitstellen. Da die aktuelle Regierung am Atomausstieg festhält und die Kohlekraftwerke ebenfalls bis spätestens 2038 vom Netz gehen sollen, bleibt nur die Verstromung von Erdgas.

Konkret müssen laut der Energiebehörde bis 2035 zusätzliche Reservekraftwerke mit bis zu 22,4 Gigawatt (GW) elektrischer Leistung entstanden sein, sofern das Zielszenario eintritt. In diesem werde Deutschland künftig alle energiewirtschaftlichen und energiepolitischen Ziele erreichen.

Ausbauziele der installierten Leistung von hauptsächlich Wind- und Photovoltaikanlagen in Deutschland (interpoliert).

Foto: FfE, Bundesnetzagentur

Neben dem starken Ausbau von Wind und Solar beinhalten diese „hohe Flexibilitätspotentiale bei neuen Verbrauchern“ ebenso wie Wärmepumpen, Stromspeicher, Elektroautos oder Elektrolyseure. Die Bundesnetzagentur nennt zudem die Installation geeigneter Messsysteme. Für E-Autos ist in diesem Rahmen angedacht, dass sie ihren Strom dem Netz in Mangelzeiten teilweise zur Verfügung stellen. Auch die Industrie solle ihren Stromverbrauch flexibel anpassen, ihn also bei Strommangel herunterfahren.

MEHR DAZU

Bundesnetzagentur: Industrie soll sich jetzt an schwankende Stromerzeugung anpassen

118 neue Gaskraftwerke – trotz 500 GW „Erneuerbare“

Falls die Zubauziele verfehlt werden und die Flexibilität zu gering ausfällt, hat die Bundesnetzagentur zusätzlich das Szenario „verzögerte Energiewende“ errechnet. Dabei wären steuerbare Kapazitäten von bis zu 35,5 GW nötig. Da ein einfaches Gasturbinenkraftwerk im Schnitt rund 300 Megawatt (MW) an Leistung bringen kann, wären dafür 118 Gaskraftwerke nötig. Selbst beim Zielszenario wären noch 75 solcher Kraftwerke nötig.

Beachtenswert ist zudem, dass die Ausbauziele in Deutschland im Jahr 2035 mehr als 500 GW an installierter Leistung durch „erneuerbare“ Energien vorsehen. Trotz der erheblichen Überkapazität der Erneuerbaren fordert die Energiebehörde damit, dass neue Grundlastkraftwerke ein Drittel bis über die Hälfte des jetzigen Strombedarfs decken können müssen.

Bereits berücksichtigt hat die Energiebehörde in ihrer Rechnung geplante Stilllegungen bestehender Kraftwerke. Würde keines der bestehenden Kraftwerke stillgelegt werden, wären im Zielszenario noch 42 und bei der „verzögerten Energiewende“ 85 der genannten Gaskraftwerke nötig.

Zugleich gibt die Behörde für das Jahr 2035 einen Jahresstromverbrauch von 941 Terawattstunden an, also fast das Doppelte wie aktuell.

MEHR DAZU

Rauf oder runter? Rätsel um Entwicklung des deutschen Strombedarfs

Ereignet sich dann eine Dunkelfraute, also das Fehlen von Wind und Sonnen, wie vom 11. bis 14. Dezember 2024 wäre laut der Simulation des Portals „Energy Charts“die Zusatzstromerzeugung bei Weitem nicht ausreichend. Auch bei Erreichen der Ausbauziele wären in diesem Fall bis über 116 GW steuerbare Kapazität nötig.

Simulierte Stromerzeugung für Deutschland mit den geplanten Windkraft- und Solarwerten und der von der Behörde geschätzte Jahresstromverbrauch von 941 Terawattstunden. Als Relevanz dienen die Wind- und Solarwerte von Kalenderwoche 50 aus dem Jahr 2024.

Foto: Bildschirmfoto/energy-charts.info/Fraunhofer ISE

Verzögerte Energiewende wahrscheinlicher?

Wahrscheinlicher dürfte jedoch das Eintreten des Szenarios „verzögerte Energiewende“ sein. Wie Bundeswirtschaftsministerin Katherina Reiche (CDU) bereits angekündigt hat, will sie Betreiber von Windkraft- und Solaranlagen künftig mehr zur Verantwortung ziehen, indem sie sich beispielsweise an den Netzausbaukosten beteiligen sollen. Das könnte die Attraktivität dieser „erneuerbaren“ Kraftwerke spürbar reduzieren und den bisweilen gut laufenden Ausbau abbremsen.

Zudem soll in Kürze das Ergebnis der Prüfung der deutschen Energiewende folgen. Wie Reiche bereits andeutete, müsse sich der Zubau der „Erneuerbaren“ am Netz orientieren und nicht umgekehrt. Das lässt vermuten, dass die Regierung den Fokus bald weniger auf den Zubau der Erneuerbaren und mehr auf den Netzausbau legt, um die Versorgungssicherheit zu erhöhen.

Die Versorgungssicherheit ist im Zielszenario laut Bundesnetzagentur nur dann gewährleistet, wenn etwa der Netzausbau wie geplant verwirklicht wird. Wie der Bundesrechnungshof im vergangenen Jahr festgestellt hat, liegt dieser rund sieben Jahre im Rückstand.

MEHR DAZU

Nicht mehr zeitgemäß? Ministerin Reiche denkt über Ende der Solarförderung nach

Keine Windräder auf der Schwend: Anwohner stimmen gegen neuen Windpark

Umsetzung der Reserve fragwürdig

Diese neue Kraftwerkskapazität müsste innerhalb der kommenden zehn Jahre betriebsbereit sein. Gemessen an der reinen Bauzeit wäre dies ein mehr als realistischer Rahmen. Der Bau des Gaskraftwerks Leipheim mit 300 MW hat knapp 24 Monate beansprucht. Allerdings müssen im Vorfeld Kraftwerksstandorte festgelegt und genehmigt werden, was zusätzlich Zeit benötigt.

Um bis 2035 besagte 118 Gaskraftwerke zur Verfügung zu haben, müsste jeden Monat ein solches Kraftwerk fertiggestellt werden. Um eine mehrtägige Dunkelflaute zu überbrücken, sind 387 Gaskraftwerke nötig und es müssten – parallel zum Ausbau der Erneuerbaren – mindestens drei Gaskraftwerke pro Monat entstehen.

Dass eine politische Ankündigung nicht zu einer schnellen Umsetzung führt, zeigte bereits die Forderung des früheren Wirtschaftsministers Robert Habeck (Grüne). Bereits vor zwei Jahren sprach er davon, umgehend 8,8 GW an neuen Kraftwerken, möglichst wasserstofffähige Gaskraftwerke, auszuschreiben. Dem folgte bis heute kein Realisierungsansatz. Die aktuelle Bundeswirtschaftsministerin Katherina Reiche (CDU) spricht von Ausschreibungen von „mindestens 20 Gigawatt Gaskraftwerken“.

Ausgangsbestand der steuerbaren Kraftwerke und Speicher in Deutschland am 01.02.2024.

Foto: FfE, Bundesnetzagentur

Systemstabilitätsbericht zeigt massive Sicherheitslücken

Mit dem Systemstabilitätsbericht 2025 wollten die deutschen Übertragungsnetzbetreiber den aktuellen Stand der einzelnen Stabilitätsaspekte unserer Stromnetze darstellen. Das soll die eingangs gestellte Frage ebenso beantworten.

Entwicklungsstand der Bedarfsermittlung der einzelnen Stabilitätsaspekte.

Foto: Bundesnetzagentur, Systemstabilitätsbericht 2025

Die beiden Aspekte Frequenz- und Spannungsstabilität schneiden bei der Untersuchung noch am besten ab. Die Netzfrequenz liegt im europäischen Verbundnetz bei 50 Hertz. Diesen Wert müssen die Netzbetreiber möglichst konstant halten. Dazu muss die Stromerzeugung jederzeit genauso groß sein wie der Stromverbrauch. Die Spannungsstabilität beschreibt das Aufrechterhalten der Netzspannung.

Sowohl Frequenz- als auch Spannungsstabilität können die Übertragungsnetzbetreiber ermitteln und den Systembedarf definieren. Ebenso können sie bei Abweichungen Gegenmaßnahmen entwickeln, um diese stabil zu halten. Allerdings ist bei beiden Aspekten der Systembedarf noch nicht gedeckt. Sprich, TenneT und Co. können im Netz nicht die benötigten Strommengen halten, um das Netz stabil zu halten.

Das liegt unter anderem an der zunehmend fehlenden Momentanreserve, also mechanisch rotierende Schwungmassen von Turbinen in Großkraftwerken. Sie stabilisieren das Netz, da sie Spannungs- und Frequenzstörungen kompensieren können. Photovoltaik- und Windkraftanlagen können dies nicht. Sie speisen elektronisch über Wechselrichter ihren Strom in die Netze ein und sind vielmehr auf ein stabiles Netz angewiesen. Je mehr Wechselrichter und je weniger Momentanreserve, desto instabiler die Netze. Das führte im April letztlich zum Stromausfall auf der iberischen Halbinsel.

MEHR DAZU

Überspannung führte zu Spainout – was führte zur Überspannung?

Energiewende am Limit? Stromeinspeisung durch „Erneuerbare“ im ersten Halbjahr gefallen

Noch „nicht ausgereift“

Deutlich kritischer sieht es bei der sogenannten „Transienten Stabilität“ aus, also wie sich das Netz bei Schwankungen verhält. Hier ist noch kein Bereich ausgereift. Die Methodik zur Ermittlung befindet sich noch „in Entwicklung“, die übrigen Bereiche sind noch „nicht ausgereift“. Auch hier spricht der Bericht von den rotierenden Massen:

„Die Analyse zeigt eine Verbesserung der Systemstabilität bei Erhöhung der Momentanereserve, wohingegen eine Reduktion der Momentanereserve zu einer Verschlechterung führt.“

Die Bilanz der allgemeinen „Netzstärke“ gleicht der „Transienten Stabilität“. So steht im Systemstabilitätsbericht: „Netzfolgende Stromrichter [Wechselrichter von Wind und Solar] tragen unter konservativen Annahmen hingegen nicht zur Netzstärke bei.“ Das bedeutet: Je mehr einspeisende Wechselrichter am Netz sind, umso instabiler wird das System.

Der letzte Aspekt, die „Harmonische Stabilität“, schneidet von allen Aspekten am schlechtesten ab. Hier ist jeder Bereich bisher „nicht ausgereift“. Die „Harmonische Stabilität“ beschreibt, wie gut es Wechselrichtern gelingt, „keine unzulässigen Schwingungen auszubilden“. Wechselrichter erzeugen solche Schwingungen. Das bedeutet, wenn ein Wechselrichter eine Oberschwingung aussendet, darf ein andere diese nicht auffangen und verstärken. Ein Netz mit viel Momentanreserve kann Oberschwingungen gut abfangen.

In Spanien haben diese Schwingungen zu einer erhöhten Netzspannungen geführt, was wiederum den Blackout auslöste.

MEHR DAZU

Deutschland ist wieder Strompreis-Europameister

Solarwirtschaft kritisiert Speicherlücke im Bericht

Der Bundesverband Solarwirtschaft (BSW-Solar) begrüßt, dass der neue Bericht zur Versorgungssicherheit den Ausbau der „Erneuerbaren“ betont. Gleichzeitig kritisiert der Verband die mangelnde Erwähnung der Potenziale von Batteriespeichern für die Versorgungssicherheit.

Zwar schrieb die Bundesnetzagentur unter anderem: „Speicher werden eine immer wichtigere Funktion einnehmen. Schon heute können sich besonders Batteriespeicher im Strommarkt refinanzieren, wie die aktuelle Ausbaudynamik beweist. In bestimmten Marktsituationen können Speicher den Bedarf an zusätzlichen Kraftwerkskapazitäten reduzieren.“

MEHR DAZU

Zu viel Wind- und Solarstrom? Drosselungen erreichen neuen Rekordwert

Diese drei Stromerzeuger können eine weltweite Energiekrise verhindern

Dennoch forderte BSW-Solar die Überarbeitung des Berichts. Laut dem Verband habe die Bundesnetzagentur die Potenziale von Batteriegroßspeichern unzureichend abgebildet. Damit sei eine zentrale Realität der Energiewende ausgeblendet.

Dazu erklärte Carsten Körnig, Hauptgeschäftsführer des Bundesverbandes Solarwirtschaft: „Während Netzbetreiber bereits heute Zusagen für viele Gigawatt[stunden] an Speicherkapazitäten erteilt haben und bundesweit Anschlussanfragen in dreistelliger Gigawatt-Höhe vorliegen, bleibt der Bericht bei den Zahlen von gestern stehen und geht sogar realitätsfern von einem Rückbau stationärer Batteriespeicher aus.“ Körnig warf der Energiebehörde eine systematische Unterschlagung der Großspeicher vor.

Hierbei ist jedoch zu beachten, dass Batteriespeicher selbst keinen Strom erzeugen können. Sie speichern diesen nur zwischen. Daher können sie Kraftwerke nicht ersetzen.

Aktuell liegt die installierte Kapazität aller deutschen Batteriespeicher bei 20,7 Gigawattstunden (GWh), die der netzdienlichen Großspeicher bei nur knapp 3 GWh. Es besteht ein akuter Anschlussstau, sodass viele, die einen Batteriepark errichten wollen, teilweise zehn Jahre und länger warten müssen. Das liegt wiederum an der mangelnden Netzinfrastruktur.

MEHR DAZU

Philippsburg: Kernkraftwerk weicht Megabatteriepark – Verein: „Ein Rückschritt“

Boom der Batterieparks – eingebremst durch Anschlussstau

Kommt ein Kapazitätsmechanismus?

Im Bericht der Bundesnetzagentur sagte Müller: „Unser Monitoring unterstreicht die Bedeutung der von der Bundesregierung geplanten Kraftwerksstrategie. Die weiteren notwendigen Kapazitäten sollten über einen Kapazitätsmechanismus bereitgestellt werden. Außerdem ist es wichtig, dass immer mehr Stromverbraucher flexibel auf Strompreise reagieren.“

Das bedeutet: Um den zusätzlichen Bedarf an neuen Kraftwerkskapazitäten zu finanzieren, ist ein sogenannter Kapazitätsmechanismus nötig. Dies soll laut dem Bericht eine technologieneutrale Finanzierungsmethode sein.

Dazu kursierte Anfang August das Gerücht einer neuen Stromsteuer. Das Wirtschaftsministerium hat dies allerdings nicht bestätigt. Stattdessen gebe es bei den „Möglichkeiten der Finanzierung“ noch „keine Festlegungen“. Auch der aktuelle Bericht zur Versorgungssicherheit bestätigt, dass der Kapazitätsmechanismus „zurzeit von der Bundesregierung erarbeitet“ wird.

MEHR DAZU

Wirbel um neue Steuer für alle Stromkunden: Wirtschaftsministerium verweist auf Prüfstatus

Blackout-Angst: Deutliche Mehrheit sieht Stromausfall als größtes Infrastrukturrisiko

Bis ausreichend Reservekraftwerke errichtet sind, bleibt die Versorgungssicherheit im deutschen Stromnetz ein Fragezeichen. Verzögerungen beim Ausbau der „Erneuerbaren“ würden laut der Energiebehörde die Versorgungssicherheit beeinflussen. Je mehr Strom aus Erneuerbaren erzeugt wird, desto wichtiger aber auch und rentabler werden Speicher und Nachfrageflexibilitäten.

Das Monitoring bestätigt, dass die zu transportierenden Energiemengen in den kommenden Jahren weiter ansteigen. Um diesen Veränderungen gerecht zu werden, bedarf es eines weiteren raschen Netzausbaus. Die Ergebnisse zeigen auch, dass Redispatchmaßnahmen in den kommenden Jahren notwendig bleiben. Diese haben in den vergangenen Jahren immer wieder neue Rekordwerte erreicht. Auch für 2025 wird ein neuer erwartet.

Dieser Artikel hat mich besonders interessiert!

Stellen Sie eine Frage zum Artikel

Maurice Forgeng

Der Beitrag erschien zuerst bei EPOCH Times hier