Sunnova-Insolvenz signalisiert harte Zeiten für die Solarbranche

Das globale Wachstum der Solarenergie war auf hohe staatliche Subventionen angewiesen. Mit dem Wegfall der Subventionen dürfte der Sektor schrumpfen.

The Daily Economy, American Institute for Economic Research

Paul Mueller, 18. Juni 2025

Einer der größten Solarinstallateure für Privathaushalte, Sunnova, ging am 8. Juni pleite. Das Unternehmen hatte vor weniger als einem Jahr Schulden in Höhe von über 10 Milliarden Dollar und eine Marktkapitalisierung von über einer Milliarde Dollar. Während aggressive Expansionsinvestitionen und schlechtes Management einige der Probleme von Sunnova erklären, sah sich das Unternehmen auch mit erheblichen politischen Problemen konfrontiert: hohe Zinsen, höhere Kosten durch Inflation, Unsicherheit und höhere Kosten durch Zölle sowie das Einfrieren der Subventionen aus dem Inflationsschutzgesetz.

Kenner der Branche erinnern sich vielleicht an Solyndra, ein gescheitertes Solarunternehmen, das einen 500-Millionen-Dollar-Kredit von der Bundesregierung erhalten hatte. Manche behaupten , eine 3-Milliarden-Dollar-Kreditgarantie für Sunnova unter der Biden-Regierung sei eine größere Version von Solyndra. Das ist falsch.

Eine Kreditbürgschaft unterscheidet sich von einem Kredit. Der Bürge verpflichtet sich, die Differenz zwischen der vereinbarten und der tatsächlichen Zahlung eines säumigen Kreditnehmers zu übernehmen. Die 3-Milliarden-Dollar-Kreditbürgschaft betraf zudem Verbraucherkredite für die Installation von Solarmodulen und nicht Kredite, die direkt an Sunnova vergeben wurden. Schließlich wurden im Rahmen dieses Kreditbürgschaftsprogramms weniger als 50 Millionen Dollar an Krediten vergeben, bevor die Trump-Regierung es letzten Monat kündigte. Das bedeutet, zumindest auf Bundesebene, dass die Solyndra-Pleite die Steuerzahler mindestens zehnmal so viel kostete.

Neben der staatlichen Kreditgarantie verdeutlicht die Sunnova-Pleite viele der Verzerrungen, die Regierungen im Solarenergiesektor verursacht haben. Aber es ist auch persönlich: Ich habe Sunnova Solarmodule auf meinem Haus in New Jersey installiert und kann berichten, wie staatliche Anreize meine Entscheidung beeinflusst haben.

Die Solaranlage, die Sunnova mir verkaufte, hatte einen Listenpreis von etwa 20.000 Dollar. Ich schätze, dass ich dadurch 80 bis 120 Dollar pro Monat an Stromkosten gespart habe. Sagen wir also 1200 Dollar Energieeinsparung pro Jahr. Das entspricht einer Kapitalrendite von 6 Prozent. Nicht schlecht, aber auch nicht überragend – vor allem angesichts der hohen Anschaffungskosten und der Tatsache, dass die Module mit der Zeit an Wert verlieren. Aber wenn man die staatlichen und bundesweiten Subventionen berücksichtigt, war die Installation von Solaranlagen ein Kinderspiel.

Damals gewährte die Bundesregierung eine 30-prozentige Steuergutschrift auf Solarmodule. Dadurch sank der Preis von 20.000 auf 14.000 Dollar. Die Rendite meiner jährlichen Ersparnis von 1.200 Dollar stieg auf 8,6 Prozent. Dann griff die staatliche Förderung.

Einige Bundesstaaten praktizieren eine sogenannte Net-Metering -Praxis , bei der Energieversorger den Eigentümern von Solarenergie für den von ihnen ins Netz eingespeisten Strom eine Vergütung zahlen müssen. Diese Methode bringt viele Komplikationen und Probleme mit sich, über die wir uns hier keine Gedanken machen müssen. In meinem Fall verlangte New Jersey von den Energieerzeugern, die Solarstromerzeugung zu „kaufen“. Für jede zusätzliche Tausend Kilowattleistung, die meine Solarmodule erzeugten, könnte ich – wohlgemerkt zu meinem eigenen Vorteil – ein sogenanntes SREC (Solar Renewable Energy Certificate) generieren und an einer Börse verkaufen.

Die Preise für SRECs lagen zwischen 200 und 240 US-Dollar, als ich das System besaß und es 2–3 SRECS pro Jahr generierte. Das entspricht etwa 500 US-Dollar pro Jahr an zusätzlichen Direktzahlungen an mich, den Eigentümer der Solarmodule, und meine Rendite steigt auf 12 Prozent – kein schlechtes Geschäft. Also kauften ich und Tausende andere Solarmodule.

Und das ist die Berechnung mit nur zwei Subventionen. Je nach Zeitpunkt, Ort und Art des Kaufs gibt es Dutzende weiterer Förderformen für Solarmodule. Womit wir wieder bei der Sunnova-Pleite und der Situation der Solarenergie in den USA wären.

Die Solarenergie hat sich im letzten Jahrzehnt zu einer enormen Industrie entwickelt. Dies ist unter anderem auf die rasante technologische Entwicklung und die enorme Vielseitigkeit zurückzuführen. Die verbesserte Technologie hat zu Solarmodulen mit höherer Effizienz und niedrigeren Produktionskosten geführt. Es werden auch Solarmodule entwickelt, die Sonnenlicht von beiden Seiten einfangen können. Verbesserungen bei Materialien wie organischer Photovoltaik und ultradünnem Silizium führen zu dünnen, biegsamen und leichten Solarmodulen, die in verschiedene Oberflächen – einschließlich Fenster und Fassaden – integriert werden können, da transparente Solarmodule Realität werden.

Die wirtschaftliche Frage dreht sich jedoch nicht nur darum, wie beeindruckend die Solartechnologie ist, sondern auch darum, ob die Kosten für Produktion, Installation und Wartung von Solarmodulen durch ihren direkten Nutzen für die Verbraucher gerechtfertigt sind. Umweltaktivisten, opportunistische Politiker und die Solarlobby verschleierten die Antwort auf diese Frage, indem sie massive indirekte Klimavorteile durch Solarenergie behaupteten und Solaranlagen bei jeder sich bietenden Gelegenheit subventionierten – was zu meiner Geschichte führt.

Solarenergie (und auch Windenergie) ist als großflächige Stromquelle für das Stromnetz mit mehreren gravierenden Problemen verbunden. Das größte Problem ist ihre schwankende Verfügbarkeit. Solarmodule erzeugen nachts keinen Strom. Auch bei Bewölkung ist die Stromerzeugung unzuverlässig – sie schwankt je nach Jahreszeit und kann nicht an den Strombedarf der Bevölkerung angepasst werden – beispielsweise bei Unwettern. Die wichtigste Lösung für dieses Problem sind massive Energiespeicher (im Grunde riesige Batterien), deren Bau in großem Maßstab unerschwinglich teuer ist.

Ein weiteres oft übersehenes Problem sind die Übertragungskosten. Die besten Standorte für Solaranlagen befinden sich nicht unbedingt in der Nähe von Orten mit hohem Strombedarf. Tatsächlich sind die Opportunitätskosten für Grundstücke in Städten mit hohem Strombedarf deutlich höher als in ländlichen Gebieten. Der Bau von Übertragungsleitungen ist jedoch teuer und wird in der Kosten-Nutzen-Analyse von Solaranlagen meist nicht berücksichtigt, da die Regulierungsbehörden von den Versorgungsunternehmen (eigentlich von deren Stromzahlern) verlangen, die Kosten für den Bau der Übertragungsleitungen zu tragen.

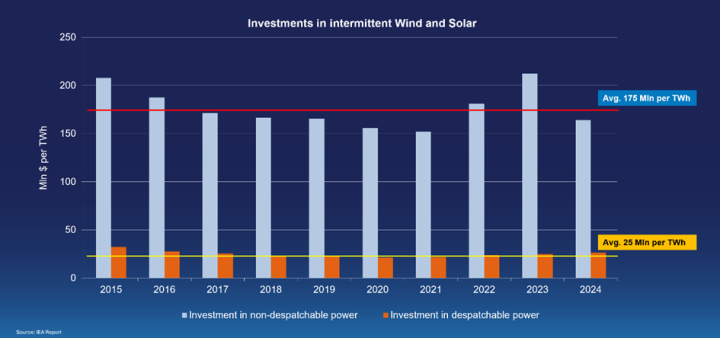

Der explosionsartige Anstieg der Solarenergie wurde durch hohe staatliche Subventionen weltweit vorangetrieben. Wenn diese Subventionen versiegen oder ganz eingestellt werden, beispielsweise durch das Einfrieren der Mittel des Inflationsreduktionsgesetzes durch die aktuelle Regierung oder den aggressiven Abbau der Subventionen für erneuerbare Energien im Rahmen des „Big Beautiful Bill“, ändert sich auch die Kosten-Nutzen-Rechnung für Solarenergie. Auch ohne Subventionen wird es einen Markt für Solarenergie geben. Er wird nur deutlich kleiner sein. Sollte das der Fall sein, steht uns ein stürmischer Himmel für Solarunternehmen aller Art bevor. Die Insolvenz von Sunnova ist wahrscheinlich eher der Anfang als das Ende der Probleme der Solarinvestoren.

Paul Mueller ist Senior Research Fellow am American Institute for Economic Research. Er promovierte in Wirtschaftswissenschaften an der George Mason University. Zuvor lehrte Dr. Mueller am King’s College in New York City.

Seine wissenschaftlichen Arbeiten wurden in zahlreichen Fachzeitschriften veröffentlicht

https://thedailyeconomy.org/article/sunnova-bankruptcy-signals-tough-times-for-solar/

###

PV in Deutschland – meine kurze Recherche mit Google: kfw-kredit photovoltaik rechner

Ist PV 2025 noch steuerfrei?

Die Photovoltaik Mehrwertsteuer. bleibt auch 2025 bei 0 Prozent! Diese wegweisende Entscheidung der Bundesregierung, die ursprünglich durch das Jahressteuergesetz 2022 eingeführt wurde, gilt weiterhin unverändert.

Welche Förderungen gibt es für PV-Anlagen 2025?

Die maximale Fördersumme beträgt 1.000 Euro. Für PV-Anlagen an der Außenfassade bekommen Sie ebenfalls 100 Euro pro Kilowatt-Peak. Hier können Sie bis zu 3.000 Euro Förderung erhalten. Bei fassadenintegrierten PV-Modulen erhöht sich die Förderung auf 300 Euro pro Kilowatt-Peak, maximal 9.000 Euro.22.05.2025

Kann ich die Installation einer Photovoltaikanlage von der Steuer absetzen?

Kann man eine Photovoltaikanlage privat steuerlich absetzen? Ja, seit 2024 können Sie die Arbeitskosten für Installation und Wartung als Handwerkerleistung mit 20% von der Steuer absetzen. Zudem fallen für Anlagen bis 30 kWp keine Mehrwertsteuer und Einkommensteuer mehr an.17.10.2024

Handwerkerkosten: Höchstgrenzen ausreizen und Geld sparen

Wer im Jahr 2024 einen Handwerker mit Arbeiten in seinem Privathaushalt beauftragt, kann dafür in der Steuererklärung 2024 eine Steuerermäßigung für Handwerkerleistungen beantragen.

Steuerlich absetzbar sind Nettokosten bis maximal 6.000 Euro, und zwar für die Arbeitsleistung ohne Materialkosten. Die Steueranrechnung beträgt 20 % der in Rechnung gestellten Leistung, also maximal 1.200 Euro pro Jahr.

********

Ergänzung:

Das Net-Metering-System-Dilemma

Versorgungsunternehmen in regulierten und deregulierten Staaten haben sehr hohe Fixkosten, die die Kosten für Bau, Betrieb und Wartung eines Verteilnetzes decken. Sie müssen die Verteilermasten, Leitungen, Zähler und alle weiteren notwendigen Geräte warten, um alle Kunden Tag und Nacht, bei gutem und schlechtem Wetter zuverlässig mit Strom zu versorgen – und das alles bei ständiger Investition in neue Technologien. Größere Kunden zahlen ihren Anteil an diesen Fixkosten in der Regel in ihrem Verbrauchstarif (in Dollar pro kWh) – abhängig von ihrem Spitzenverbrauch in einem Zeitraum von 15, 30 oder 60 Minuten, je nach Versorgungsunternehmen. Die meisten Privat- und Kleinkunden zahlen jedoch nur einen geringen monatlichen Fixpreis, in den alle weiteren Nebenkosten pro kWh eingerechnet sind. Das bedeutet, dass ein Kunde, der den gekauften Strom mit den erzeugten kWh verrechnet und so nahezu null kWh abrechnet, nicht zu den Fixkosten für die Wartung des von ihm genutzten Systems beiträgt. Je mehr Kunden die Möglichkeit der Nettomessung nutzen, desto weniger Fixkosten fallen an, was zu höheren Tarifen für Kunden ohne Nettomessung führt. …..

Net-Metering-Richtlinie: Eine vielversprechende Lösung

Durch die Erhöhung der monatlichen Fixkosten für Privatkunden und die Senkung des kWh-Preises könnten die Kosten unabhängig von der abgerechneten Strommenge gedeckt werden. Leider würde diese Strategie zu höheren monatlichen Rechnungen für Kunden mit geringerem Einkommen und geringerem Stromverbrauch führen. Niedrigere kWh-Kosten untergraben zudem einen wichtigen Anreiz zum Stromsparen. Gleichzeitig würden diejenigen, die Net Metering betreiben – ob Kunden oder Geräteanbieter – weniger profitieren, und der Ausbau der erneuerbaren Energien würde sich verlangsamen. ….

https://www.engieimpact.com/insights/net-metering-becoming-controversial