Grüne Fantastereien: Das Märchen vom Wasserstoff

Wenn man fossile Energierohstoffe ablehnt, selbst wenn CO2 aus dem Rauchgas abgeschieden wird, wenn man Kernkraft sowieso nicht will und bemerkt, dass gepushte „Erneuerbare“ die Erwartungen nicht erfüllen, braucht es Hoffnungszeichen und einen festen Glauben. Das Wunder des grünen Wasserstoffs soll über uns kommen. Die Illusionen von heute werden die Enttäuschungen von morgen sein.

Von Frank Hennig

Eine flüchtige Strategie für ein flüchtiges Gas

Jules Verne bezeichnete 1875 das Wasser als die neue Kohle, wenn es durch elektrischen Strom zerlegt wird. Damals nannte man seine Schriften utopische Literatur, heute wäre es Science-Fiction oder Fantasy. Aus guten Gründen ist sein Gedanke nicht Realität geworden. Er reicht aber aus, um bei uns darauf eine ganze Energiestrategie zu gründen – ohne Plan B.

Eine gängige Formulierung der Medien zu unserer erhofften wasserstoffgrünen Energiewendewunderwelt lautet: „Der grüne Wasserstoff gilt als Energieträger der Zukunft“. Damit übernehmen die meist regierungsbegleitenden Medien keine Verantwortung, legen sich nicht fest und müssen auch nicht kundtun, dass sie selbst nicht daran glauben. Jedenfalls nicht diejenigen Journalisten, die über ein gewisses Maß an naturwissenschaftlichen Grundkenntnissen verfügen.

Eine andere gängige Formulierung bezeichnet den Wasserstoff als den „Champagner der Energiewende“. Das ist treffend, wenn man ihm die Eigenschaften knapp, teuer und edel zuschreibt. Edel deshalb, weil er vielfältig verwendet werden kann, so als technisches Gas, als chemischer Grundstoff, als Energieträger und –speicher. Aber gerade die letztgenannten Verwendungsmöglichkeiten sind nicht wirtschaftlich darstellbar.

Eine Wasserstoffstrategie soll den Rahmen geben für eine staatlich organisierte Entwicklung. Schon 2021, noch unter Wirtschaftsminister Altmaier, sollten 62 Großprojekte aus EU-, Bundes- und Landesmitteln gefördert werden. Die Strategie wird nun fortgeschrieben, 10 Gigawatt (GW) Elektrolysekapazität bis 2030 sind das Ziel, wohl zwei Drittel des benötigten H2 werden importiert werden müssen.

Ein Start- und ein Kernnetz für die Verteilung des Wasserstoffs wird gewünscht und ein „Hochlauf“ des Marktes. Dabei handelt es sich um einen Subventionsmarkt, auf dem sowohl die Hersteller als auch die Verbraucher von grünem Wasserstoff subventioniert werden müssen. Angebot und Nachfrage folgen nicht den Marktmechanismen, sondern den Vorgaben und Subventionen des Staates. Global erfolgreich war ein solches Wirtschaftssystem noch nie.

Ergebnis ist wiederum das aus der E-Mobilität bekannte Henne-Ei-Problem. Potenzielle Verbraucher rufen nach dem Gas, Lieferanten verlangen Abnahmegarantien. Das Projekt einer Wasserstoffleitung von Dänemark nach Schleswig-Holstein wird nach Aussage des nördlichen Nachbarn nur gebaut, wenn potenzielle Abnehmer vor dem Bau eine feste Abnahmemenge für 15 Jahre buchen.

Weil das gewünschte Tempo der Umsetzung nicht erreicht wird, liegt nun der Entwurf eines Wasserstoffbeschleunigungsgesetzes (WasserstoffBG) vor. Insbesondere die Planungs- und Genehmigungsverfahren sollen schneller ablaufen. Ein festgeschriebenes „überragendes öffentliches Interesse“ soll auch hier eventuellen Widerstand von Anfang an platt machen.

Zeit ist relativ, wie wir von vielen staatlichen Projekten aus Erfahrung wissen. 14 Jahre Bauzeit für einen Flughafen, vermutlich 15 Jahre für einen Bahnhofsumbau, 14 Jahre für ein Schiffshebewerk. Aber schon 2030 soll grüner Wasserstoff in großen Mengen zur Verfügung stehen, einschließlich der nötigen Infrastruktur und der Importe. Unsere dauerprogressiven Ampelparteien denken nicht daran, Erfahrungen der Vergangenheit zu berücksichtigen.

Auf dem Kraftwerkstechnischen Kolloquium der TU Dresden im vergangenen Oktober äußerte sich der Präsident des Deutschen Wasserstoff- und Brennstoffzellenverbandes, Doktor Oliver Weinmann. Er ist ausgewiesener Fachmann und Lobbyist, der das Thema voranbringen will. Zur Zukunft einer Wasserstoffinfrastruktur merkte er in der Podiumsdiskussion an, dass wir bei dieser ganz am Anfang stünden und der Aufbau Jahrzehnte dauern werde. Solche Aussagen dringen offenbar nicht in die Berliner Blase ein. Sehr wahrscheinlich ist, dass es sich ziehen wird. Wir werden Forderungen hören nach mehr Zeichensetzung, ehrgeizigeren und ambitionierteren Zielen, angeschärften Kriterien, einer notwendigen Task-Force, einem Bundesbeauftragten für Wasserstoff, nach mehr IT-Kompetenz und smarten, verzahnten Ansätzen sowie Wasserstoff-Audits. Die Aufzählung ist beliebig erweiterbar. Allen Positionen ist gemeinsam, dass sie praktisch wirkungslos sein werden.

Der Wunderstoff

In der Handhabung erweist sich Wasserstoff als schwierig. Als Nummer eins im Periodensystem der Elemente und kleinstes Atom ist er diffusionsfreudig, schleicht sich durch die Metallgitter von Rohr- und Behälterwandungen, durch alle kristallinen Strukturen hindurch, indem es die Zwischengitterplätze nutzt. Dies führt im Wandungsmaterial auch zu Korrosion. Die notwendige Spezialbeschichtung treibt die Kosten.

Umgangssprachlich bezeichnet man Wasserstoff aus gutem Grund auch als Knallgas. Das beschreibt seine Reaktionsfreundlichkeit. Vier bis 76 Prozent Anteil in der Luft lassen ein Gemisch durchzünden, wenn ein Funken des Weges kommt. Das ist mit entsprechenden Maßnahmen beherrschbar, aber aufwändig. Funkenfreies Werkzeug dürfte noch die kleinste Kostenposition sein.

Zudem hat Wasserstoff einen geringen Energiegehalt, was große Volumina erfordert, die gehandhabt werden müssen. Die Druckerhöhung in den Verdichtern ist mit einem hohen spezifischen Aufwand verbunden, auch hier ist die Ursache die Winzigkeit der H2-Atome. Wasserstoff ist in elementarer Form schwer transportierbar, wenn Pipelines nicht genutzt werden können. Aufgrund des geringen Energieinhalts muss eine Hochverdichtung oder Tiefkühlung erfolgen. Der Schiffstransport erfordert eine Abkühlung auf mindestens minus 253 Grad, was hohen Energieaufwand, hohen Isolationsaufwand erfordert und Kälteverluste während des Transports mit sich bringt. Gegenwärtig existieren weltweit nur zwei Schiffe, die Wasserstoff transportieren können. Kostensenkend ist der Transport von Wasserstoff in Form seiner Derivate wie Methan, Methanol oder Ammoniak. Hier ist das Handling einfacher, jedoch sind die Prozesse zur Herstellung der Derivate und deren spätere Aufspaltung kostentreibend. Die entsprechende Infrastruktur in den Lieferländern wie auch bei uns wäre erst zu errichten und aufwändig zu betreiben.

Die Verbrennung von Wasserstoff ist ebenso nicht unproblematisch. Die Wasserstoffflamme ist kaum sichtbar, die Verbrennungstemperatur liegt bei 2.130 Grad (Erdgas: 1.970 Grad), was bei der Verbrennung mit Luft zu einer hohen Reaktionsfreudigkeit mit dem Luftstickstoff und hohen Stickoxidemissionen im Abgas führt. Diese Emissionen sind hinsichtlich der Grenzwerte des Bundesimmissionsschutzgesetzes (BImSchG) schwierig zu beherrschen, weshalb es noch keine wasserstofffähigen Gasturbinen am Markt gibt. Das ist technisch lösbar, wie eine Testmaschine von Kawasaki zeigt, aber bisher gab es mangels Wasserstoff schlicht keinen Bedarf für solche teureren Turbinen.

Die Verstromung in einer Brennstoffzelle erfolgt zu ähnlichem Wirkungsgrad wie bei der Elektrolyse (60 bis 70 Prozent). Auch hier ist nur ein konstanter Prozess optimal, hohe Materialpreise für die Membranen stehen der massenhaften Anwendung noch im Weg.

Solcher und solcher Strom

Ein scheinbar starkes Argument für die Produktion des teuren Energieträgers ist die Nutzung so genannten Überschuss-Stroms, der in den Sommermonaten immer häufiger anfallen wird. Natürlich kann man diesen nutzen, aber die Elektrolyseure arbeiten nur unter konstantem Stromfluss optimal. Für die Amortisation sind möglichst viele Betriebsstunden nötig. Einige hundert Stunden niedriger oder negativer Strompreise im Jahr dürften für einen Betrieb unter marktwirtschaftlichen Bedingungen nicht reichen. Aber aus marktwirtschaftlicher Sicht lässt sich eine Wasserstoffinfrastruktur dieser Größenordnung, die auf grünem Wasserstoff beruht, ohnehin nicht realisieren. Es wäre wie bei der Windkraft eine verstetigte Subventionswirtschaft aus „Klimagründen“, die uns im internationalen Wettbewerb benachteiligt.

Das „Westküstenprojekt“ in Schleswig-Holstein, getragen von drei durchaus potenten Firmen (Ørstedt, Raffinerie Heide, Hynamics Deutschland), starb im November 23 den Kostentod. Ein 30-Megawatt-Elektrolyseur sollte unter den lokal günstigen Bedingungen grünen Wasserstoff erzeugen, was sich aber nach internen Berechnungen als unwirtschaftlich herausstellte. Die Produktion von grünem Wasserstoff mache keinen Sinn, vor allem wegen der wirtschaftlichen Risiken, hieß es in der einer Pressemitteilung. Trotz der Fördermittel lohne sich ein dauerhafter Betrieb der Anlage wirtschaftlich nicht, so das Investoren-Konsortium. Wir erinnern uns an Ex-Wirtschaftsminister Altmaier, der im Rahmen seiner „Reallabore der Energiewende“ ebendieses Projekt mit 36 Millionen Euro förderte, weil er das Thema „fliegen sehen“ wollte. Das Geld ist nicht weg, es haben nur andere.

Auf zum nächsten Flop. Er heißt Hyscale 100 und soll auch in der Region Heide gebaut werden. 500 Megawatt Elektrolysekapazität werden mit 646 Millionen Euro gefördert. Bleiben wir im Norden: Auf dem Gelände des ehemaligen Kraftwerks Hamburg-Moorburg entsteht ein weiterer 100-Megawatt-Elektrolyseur. Die Kraftwerkskapazität im Großraum Hamburg nahm in den vergangenen 15 Jahren um zwei Drittel ab, man hofft auf Ersatz durch Windstrom. Ja, den gibt es. Zeitweise.

Der Stromspeichertraum

Über die gesamte Prozesskette Power-to-Gas-to-Power (P2G2P) ergibt sich ein desolater Wirkungsgrad von 20 Prozent, vielleicht auch etwas mehr. Für jede zurückgewonnene Kilowattstunde Strom muss also die fünffache Menge (Grün-) Strom vorher erzeugt werden. Hier können die Ökonomen den Stift beiseitelegen oder den Laptop zuklappen. Wer sich trotzdem der Mühe eigener Berechnung unterzieht wie Professor Vahrenholt, kommt auf irreal erscheinende Ergebnisse. Den Vertrag mit Ägypten zur Lieferung „grünen“ Ammoniaks zugrundelegend würde die Verstromung in Deutschland zu Gestehungskosten von 49 Cent pro Kilowattstunde führen. Dazu kommen dann Netzentgelte, Umlagen, Abgaben.

Auch auf der EU-Ebene hat der Realismus einen schweren Stand. Die „EU-Hydrogen Strategy“ wünscht sich bis 2030 zehn Millionen Tonnen grünen Wasserstoffs in der Gemeinschaft. Professor Markus Löffler und Tim Sumpf rechnen in der Epochtimes vor, dass die Elektrolyseure dafür 35 Stunden am Tag oder 530 Tage im Jahr laufen müssten.

Nun teilt der Europäische Rechnungshof mit: „Die EU (werde) ihre für 2030 gesetzten Ziele für Erzeugung und Import von erneuerbarem Wasserstoff voraussichtlich nicht erreichen.“ Gleichzeitig mahnten die Prüfer an, „die EU-Ziele einem Realitätscheck zu unterziehen“ und kritisieren weiter: Die Ziele seien nicht auf Grundlage solider Analysen erstellt worden, sondern nach politischem Willen festgelegt. Auch sei keine Abstimmung mit den Zielen anderer Länder erfolgt.

Der hohe Wasserbedarf für die Elektrolyse, mindestens neun Liter entsprechender Qualität pro Kilogramm H2, erfordert günstige Standorte oder entsprechende Wasseraufbereitung. Insbesondere im globalen Süden eine absolut kostentreibende Position. Selbst in Europa dürften potenzielle Elektrolysestandorte durch Wassermangel entfallen.

Nicht zuletzt: H2 ist ein Treibhausgas. Der Schlupf, die durch Undichtheiten an den Anlagen austretenden Mengen, würde die weitere globale Erwärmung beschleunigen, wenn man die regierungsamtliche Klimatheorie zugrundelegt.

Wie kommt es nun dazu, dass der Wasserstoff als einzige Zukunftsoption alternativlos verfolgt wird? Auch Politiker und –innen mit zweifelhaften Bildungsverläufen haben vermutlich ein Experiment aus dem Chemieunterricht im Gedächtnis, wo aus einem wassergefüllten Gefäß mit zwei darin platzierten Elektroden einige Bläschen lustig nach oben blubbern. Zurück bleibt der falsche Eindruck, dass es sich bei der Elektrolyse um einen einfachen Vorgang handelt. Aber

sowohl die Elektrolyse als auch die Umkehrung des Prozesses in der Brennstoffzelle oder die Verbrennung von Wasserstoff sind keineswegs simpel. Insbesondere die Materialfragen, mit denen Alterung und Verschleiß begegnet werden muss, erfordern hohen Forschungsaufwand und treiben bei großtechnischen Anlagen die Kosten. Deutschlandweit gibt es heute mehr als 50 Pilotanlagen Power-to-Gas (P2G), die nur mit Fördermitteln betrieben werden können und die vor allem mit den Fragen der Wirtschaftlichkeit der Prozesse zu kämpfen haben.

Die Wirtschaftlichkeit der Grünstromelektrolyse in Deutschland wird auch künftig nicht gegeben sein, da sie primär vom Strompreis abhängt und von einem kontinuierlichen, optimierten Betrieb der Anlagen.

Der grüne Kolonialismus

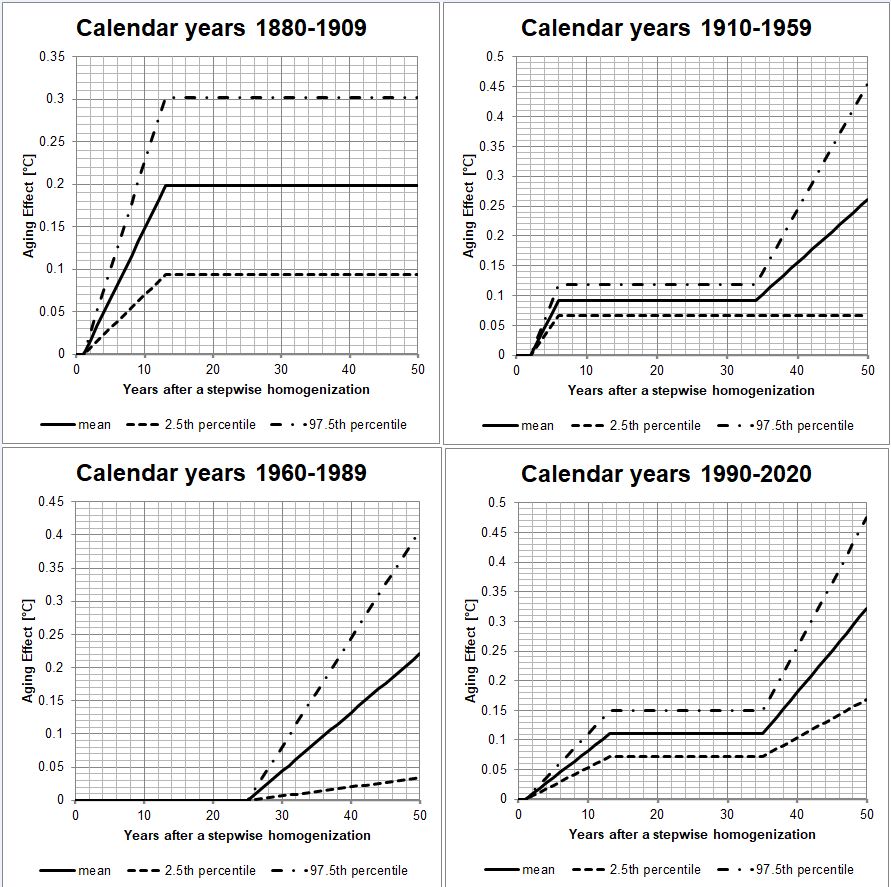

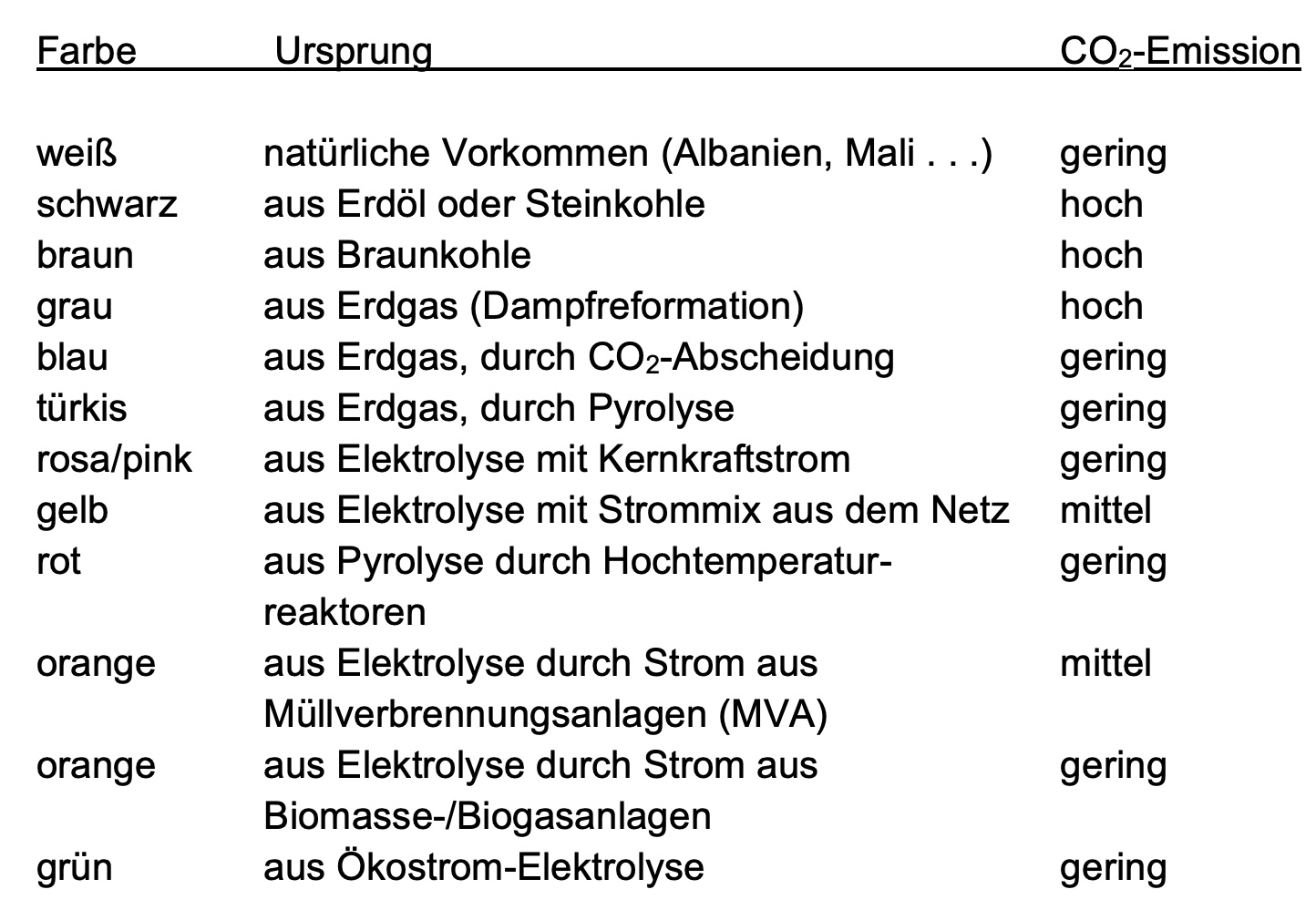

Eine typisch deutsche Eigenschaft ist die Absolutheit von Forderungen. So soll andersfarbiger Wasserstoff (s. unten), der nicht der Ökostrom-Elektrolyse entstammt, nicht akzeptiert werden. Aber hier gibt es inzwischen eine Aufweichung, wonach blauer Wasserstoff zunächst akzeptiert werden soll.

Der kalkulierte hohe Anteil an importiertem grünem Wasserstoff schafft Abhängigkeiten. Energiestrategisch begeben wir uns in Abhängigkeit von Ländern wie Ägypten, Marokko und Namibia und setzen uns einem Sanktionsrisiko aus. Der Ansatz, dem viele andere Länder folgen, nämlich hinsichtlich Ernährung und Energieversorgung möglichst unabhängig vom Ausland zu bleiben, wird in Deutschland verworfen.

In Fragen des Wasserstoffs betreiben wir sogar einen neuen Energiekolonialismus, was selbst die taz beklagt. Während wir uns für die Verbrechen der Kolonialzeit vor 120 Jahren heute noch, auch finanziell, entschuldigen, wollen wir nun namibische Nationalparks zerstören.

Die Abhängigkeit von Lieferungen aus arabischen Ländern wird auch eine wertegeleitete Außenpolitik beeinflussen. Kritik bezüglich der Menschenrechte sollte dann besser nicht geäußert werde, es könnte zu Lieferverzögerungen führen. Eine eskalierende internationale Lage könnte dann nicht nur zu einer Ölkrise wie 1973 führen, sondern auch zu einer Wasserstoffkrise für Deutschland. Unsere traditionelle Appeasement-Politik gegenüber islamischen Ländern würde verstärkt weitergeführt. Für Israel bleiben nur die Sonntagsreden.

Im unserem politischen Raum gehen Glauben vor Wissen, Ideologie und Lobbyismus vor Pragmatismus. Auch die Finanzen scheint niemand zu kalkulieren, denn große Investitionen in potenziellen Lieferländern müssten von Deutschland gestemmt werden. Natürlich hätten die Lieferländer auch ersten Zugriff auf die Ökoenergie, die dann erzeugt wird und die sinnvollerweise zunächst die Emissionen in den Lieferländern senken können.

Bei realistischer Betrachtung der Zeitschiene, der Kosten und der Fähigkeiten der uns schon länger Regierenden erweist sich die Wasserstoffstrategie nicht nur als flüchtig, sondern als ein großes Nichts. Oder eben Fantasy.

Anlage:

Wasserstoff Farbenlehre