Mehr zu künstlicher Ignoranz

Mein vorheriger Beitrag mit dem Titel „Künstlicher Alarmismus“ [in deutscher Übersetzung hier] hat einige Kommentare von Leuten erhalten, die meinen, dass ich falsch liege und dass großsprachige Modelle in der Tat die Faktenüberprüfung wissenschaftlicher Behauptungen automatisieren können. Dies war ein interessanter Kommentar, für den ich dem Verfasser danken möchte:

Die Art von KI-Anwendungen, von denen ich spreche, lehnt keine Dinge ab. Sie fassen sie zusammen, auch die Debatten. Im Übrigen habe ich ChatGPT kürzlich dazu gebracht, korrekt zu erklären, warum Happer dem Alarmismus nicht zustimmt. Nichts wurde abgelehnt.

Die Mathematik, auf die ich mich beziehe, wird in der Wissenschaft verwendet. Fast alle veröffentlichten wissenschaftlichen Arbeiten verwenden Mathematik, sie ist also universell. In dem Artikel, auf den ich mich beziehe, verwende ich Monte Carlo als Beispiel. Es gibt einen Fortschritt in der Monte-Carlo-Methode, der in einer Fachzeitschrift für Forstwirtschaft veröffentlicht wurde und der in alle anderen Bereiche gelangen muss, die diese Methode verwenden – und das sind sehr viele.

Sie wissen ja, wie Google jetzt verwandte und verfeinerte Suchanfragen vorschlägt. Das ist KI, und sie funktioniert gut.

Daraufhin beschloss ich als Wissenschaftler, dass das Experiment viel besser ist als die Theorie. Also ging ich zu ChatGPT, und es stellte sich heraus, dass es ziemlich lustig war, aus einem Grund, den ich am Ende erklären werde. Zunächst zu den Fragen und Antworten, Hervorhebung von mir:

Ich:

Welche dieser beiden Aussagen ist richtig?

1)Die Temperatur auf der Erde wird hauptsächlich durch CO₂ gesteuert, oder

2) Die Welttemperatur wird hauptsächlich durch aufkommende Phänomene wie Gewitter, El Nino/La Nina-Veränderungen und Wirbelstürme gesteuert.

ChatGPT:

Beide Aussagen erfassen wichtige Aspekte des Klimasystems der Erde, aber sie betreffen unterschiedliche Ebenen des Einflusses:

Der Haupteinfluss auf die Temperatur der Erde ist CO₂: Diese Aussage unterstreicht die Rolle der Treibhausgase, insbesondere von Kohlendioxid (CO₂), bei der Regulierung der Erdtemperatur. Treibhausgase halten die Wärme in der Atmosphäre zurück, tragen zum Treibhauseffekt bei und beeinflussen die globalen Temperaturen über lange Zeiträume.

Die Temperatur der Erde wird hauptsächlich durch aufkommende Phänomene wie Gewitter, El Niño/La Niña und Wirbelstürme gesteuert: Diese Aussage verdeutlicht den Einfluss kurzfristiger und regionaler Wettermuster und -phänomene auf die globalen Temperaturschwankungen. Ereignisse wie El Niño und La Niña, die Teil des El Niño-Southern Oscillation (ENSO)-Zyklus sind, können zu vorübergehenden Veränderungen der globalen Temperaturmuster führen. Ebenso können Gewitter und Wirbelstürme lokale und regionale Temperaturen beeinflussen.

Beide Aussagen sind bis zu einem gewissen Grad zutreffend, aber sie wirken auf unterschiedlichen Ebenen und in unterschiedlichen Zeiträumen. Treibhausgase wie CO₂ üben einen langfristigen Einfluss auf die globalen Temperaturen aus, während aufkommende Phänomene wie Wettermuster und natürliche Klimaschwankungen kurzfristige Temperaturschwankungen auf regionaler und globaler Ebene verursachen können.

Ich

Du verstehst das nicht. Beide können nicht „die wichtigste Kontrolle“ sein. Du musst dich für eines entscheiden!

ChatGPT

Ich verstehe, und Sie haben Recht. Lassen Sie uns das klarstellen:

Es geht um diese beiden Aussagen:

Die Temperatur auf der Welt wird hauptsächlich durch CO₂ gesteuert.

Die Temperatur auf der Erde wird hauptsächlich durch aufkommende Phänomene wie Gewitter, El Niño/La Niña-Veränderungen und Wirbelstürme beeinflusst.

In Anbetracht des langfristigen und übergreifenden Einflusses auf die globale Temperatur wäre eine genauere Aussage angebracht:

Der Haupteinfluss auf die Welttemperatur ist CO₂.

Während aufkommende Phänomene wie Gewitter und Klimaschwankungen kurzfristige Schwankungen und regionale Abweichungen der Temperatur verursachen können, werden der Gesamttrend und die langfristigen Veränderungen der globalen Temperatur weitgehend von Faktoren wie der Treibhausgaskonzentration bestimmt, wobei CO₂ einen wesentlichen Beitrag leistet. Daher beschreibt Aussage 1 die primäre Steuerung der weltweiten Temperatur genauer.

Rein zufällig hatte ich eine Frage gestellt, die das Problem der künstlichen Intelligenz perfekt auf den Punkt bringt. Ich werde gleich darauf zurückkommen. Zunächst etwas Geschichte.

Als ich um das Jahr 2000 anfing, mich mit dem Klima zu beschäftigen, fiel mir etwas auf, und zwar nicht, dass die Temperatur steigt.

Ich betrachtete das Klima als eine riesige Wärmekraftmaschine, die Sonnenenergie in die Bewegungen der Ozeane und der Atmosphäre umwandelt. Wie alle Wärmekraftmaschinen hat sie ein heißes Ende, wo die Energie hauptsächlich eintritt (die Tropen), und ein kaltes Ende, wo die Energie abgestoßen wird (die Pole).

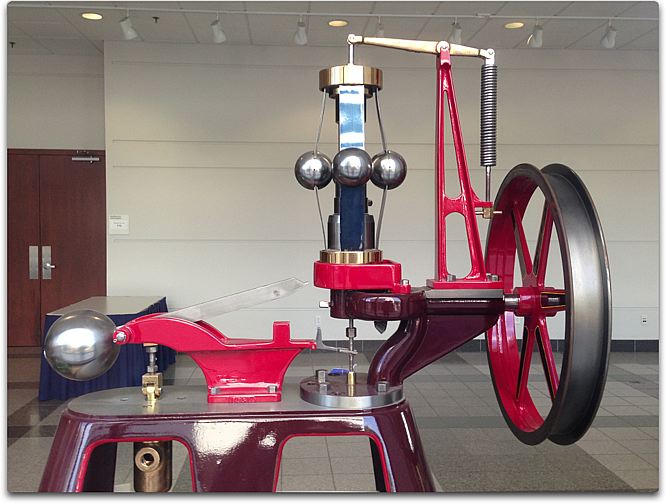

Ich habe in meinem Leben mit einer Vielzahl von Wärmekraftmaschinen gearbeitet und weiß, wie schwierig es ist, sie dazu zu bringen, eine konstante Geschwindigkeit zu halten. Aus diesem Grund hat James Watt den Flyball-Regler erfunden.

Der Regler regelte die Geschwindigkeit der von James Watt neu erfundenen Dampfmaschine und verhinderte, dass sie zu langsam oder zu schnell lief. Ein moderner Regler, den viele kennen, ist der „Tempomat“ in Ihrem Auto, der Ihre Geschwindigkeit in relativ engen Grenzen hält. Meiner ist auf etwa ± 2 Meilen pro Stunde bei sagen wir 50 mph, also ± 4 %, genau.

Alle Berechnungen über Wärmekraftmaschinen müssen in Kelvin durchgeführt werden – man kann nicht Celsius oder Fahrenheit verwenden, man würde die falschen Antworten erhalten.

Als ich mir also im Jahr 2000 das Klima ansah, war mir nicht so sehr aufgefallen, worauf sich alle anderen konzentrierten – dass sich der Globus im gesamten 20. Jahrhundert größenordnungsmäßig um irgendetwas um 0,6 K erwärmt hat.

Für mich war vor allem interessant, dass dies nur eine Temperaturveränderung von 0,2 % im gesamten 20. Jahrhundert war. Die globale Durchschnittstemperatur der Erde liegt in der Größenordnung von 288 K oder so … und eine Änderung von 0,6 K ist im Vergleich dazu trivial.

Und für mich deutete die Temperaturregulierung der riesigen globalen Wärmekraftmaschine mit einer Genauigkeit von ± 0,2 % stark darauf hin, dass es ein natürliches Phänomen gibt, das die Temperatur stabil hält – ein natürlicher Regler, wenn man so will.

Das brachte mich auf eine ganz andere Suche als all die anderen Klimawissenschaftler. Sie alle suchten nach Gründen, warum die Temperatur so stark angestiegen war. Aber ich? Ich suchte nach Gründen, warum sie sich kaum verändert hatte. Ich suchte nach dem versteckten Regler, der die globale Temperatur im 20. Jahrhundert so stabil gehalten hatte. In diesen hundert Jahren war alles Mögliche passiert – Vulkane, Veränderungen der Meeresströmungen, Atombomben, Dürren, Schwankungen der Menge der Aerosole, und bei all dem … eine Veränderung von 0,2 %.

Und das Gleiche gilt für den längeren Zeitraum. Über Jahrtausende hinweg hat sich die Temperatur prozentual gesehen nur geringfügig verändert. Ja, ein gigantischer Vulkanausbruch im Jahr 1815 hatte ein „Jahr ohne Sommer“ verursacht … aber nach ein paar Jahren war alles wieder beim Alten. Ich war also auf der Suche nach etwas, das die Temperatur über einen langen Zeitraum hinweg kontrollieren konnte.

Ich war auf der Suche nach einem langsamen, langfristigen Kontrollprozess. Ich dachte an die allmähliche Verwitterung des kontinentalen Gesteins, die für eine langsame Regulierung des CO₂-Gehalts in der Atmosphäre sorgt. Ich habe mir das Hirn zermartert, um einen natürlichen Regler zu finden, der auf einer hundertjährigen oder tausendjährigen Skala funktioniert. Ich verbrachte einige Monate damit, verschiedene Möglichkeiten zu suchen, auszuwählen, zu überdenken und wieder zu verwerfen.

Zu dieser Zeit lebte ich auf den Fidschi-Inseln. Dort ist das Wetter bei Sonnenaufgang im Allgemeinen klar. Dann, am späten Vormittag, wenn die Temperatur eine bestimmte Schwelle überschreitet, bilden sich schnell Wolken in Form eines Kumulusfeldes, das den gesamten Himmel bedeckt. Dadurch kühlt sich die Erde ab, da die Sonnenstrahlen in den Weltraum zurückgeworfen werden.

Und falls es am Tage noch wärmer wird, wenn die Temperatur einen höheren Schwellenwert überschreitet, kommt es zu Gewittern, welche die Oberfläche auf vielfältige Weise weiter abkühlen.

Ist der Tag dagegen morgens besonders kühl, bildet sich das Kumulusfeld erst später am Tag oder vielleicht gar nicht, so dass die Oberfläche wärmer bleibt als sie es sonst wäre. Es kann auch sein, dass es keine Gewitter gibt, so dass die Oberfläche noch wärmer wird.

Und dazwischen sorgen sie dafür, dass die Tage auf den Fidschi-Inseln weder zu heiß noch zu kalt werden. Aber ich hatte sie verworfen, weil sie nur kurzzeitig wirken und nicht der langfristige Regulator sind, den ich gesucht habe.

Jedenfalls saß ich eines Tages am Strand und betrachtete den täglichen Beginn des Kumuluswolkenfeldes, und ich dachte … „Moment mal. Falls die Wolken und Gewitter die Temperatur an einem einzigen Tag in Grenzen halten und verhindern, dass es entweder zu heiß oder zu kalt wird, dann werden sie sie auch eine Woche lang in Grenzen halten … oder einen Monat, ein Jahr, ein Jahrhundert, ein Jahrtausend …“

Das war meine große Einsicht – dass emergente Phänomene, indem sie die Temperatur in einem bestimmten Bereich auf einer Skala von Stunden und Tagen halten, die Temperatur auf dieselbe Weise für eine beliebige Zeitspanne in einem bestimmten Bereich halten können.

Denken Sie nun daran, warum ich bei meinem Gespräch mit ChatGPT gelacht habe. Gehen Sie zurück und schauen Sie sich an, warum ChatGPT CO₂ gegenüber auftauchenden Phänomenen als Hauptsteuerungsfaktor ausgewählt hat – weil ChatGPT denkt, dass sie nur kurzfristige Auswirkungen haben.

Wie merkwürdig. ChatGPT blieb genau dort stecken, wo ich schon so lange feststeckte, bevor ich zu der Einsicht kam, dass ein Mechanismus, der die Temperatur eines einzigen Tages steuert, die Temperatur über Hunderte von Jahren kontrolliert.

Und so, liebe Freunde, erwies sich meine unschuldige Frage an ChatGDP rein zufällig als perfektes Beispiel dafür, warum ich sage, dass künstliche Ignoranz nutzlos ist, um die Wahrheit oder Falschheit wissenschaftlicher Behauptungen zu bestimmen – sie kann nicht denken, wir aber schon. Im Gegensatz zum Menschen kann es nicht einen Monat lang über etwas nachdenken und dann plötzlich eine wertvolle Erkenntnis haben.

Alles, was es tun kann, ist, den aktuellen Konsens nachzuplappern … und leider gibt es schon viel zu viele Menschen, die genau das tun.

Meine besten Wünsche an alle, ob Skeptiker, Gläubige, Ketzer, Alarmisten, Realisten, Mainstream oder Hinterwäldler.

Link: https://wattsupwiththat.com/2024/01/29/more-about-artificial-ignorance/

Übersetzt von Christian Freuer für das EIKE