Andy May

Dies ist der Text eines Vortrags, den ich am 26. September 2024 auf einer Tagung des American Institute for Economic Research Bastiat Society of Houston gehalten habe.

Der Bericht AR6 des IPCC und der sogenannte „Klimakonsens“ verbergen und unterdrücken viele unbequeme Wahrheiten, die ihrer Hypothese widersprechen, wonach der vom Menschen verursachte Klimawandel gefährlich ist. Ich werde in diesem Beitrag einige Beispiele auflisten und erörtern, weitere sind in unserem kürzlich erschienenen Buch The Frozen Climate Views of the IPCC: Eine Analyse des AR6.

Doch zunächst einige persönliche Beispiele für die Unterdrückung von Konzepten, die nicht dem Konsens entsprechen.

Zwei Studien aus politischen Gründen abgelehnt

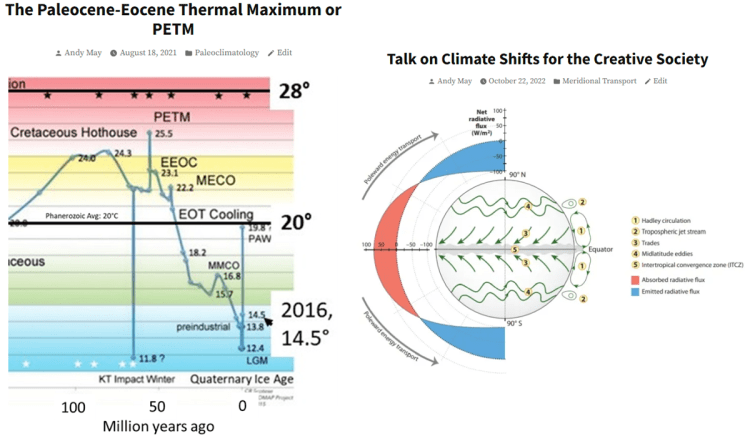

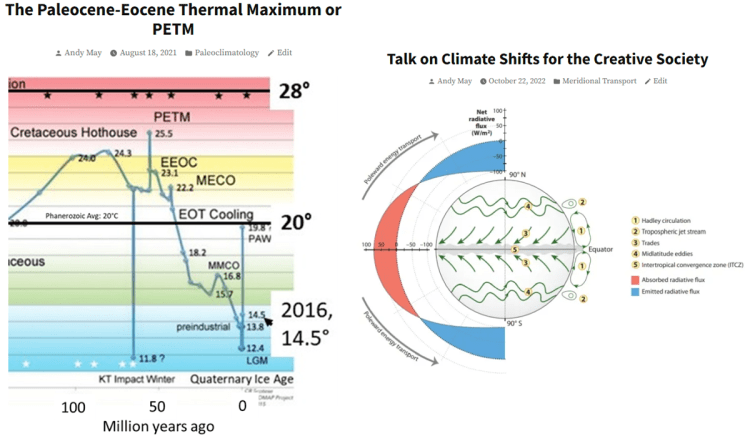

Abbildung 1. Zwei meiner eingeladenen Arbeiten, welche die Überprüfung bestanden haben und später von höheren Stellen abgelehnt worden sind.

Beide in Abbildung 1 gezeigten Studien wurden eingereicht, beide haben den Peer-Review und/oder die redaktionelle Prüfung bestanden, wurden aber schließlich von höheren Stellen in den jeweiligen Organisationen abgelehnt, und zwar kurz vor dem geplanten Veröffentlichungstermin und ohne Angabe von Gründen. Ich nahm dies als klares Zeichen dafür, dass beide Ablehnungen rein politisch motiviert waren. Schließlich hätten alle technischen Gründe für die Ablehnung während des Begutachtungsprozesses vorgebracht werden müssen.

Die PETM-Studie wurde von der Rocky Mountain Association of Geologists (RMAG) eingereicht. Sie beabsichtigte, den Artikel in ihrer Online-Publikation „The Outcrop“ zu veröffentlichen. Artikel für „The Outcrop“ werden von den Mitarbeitern und Redakteuren geprüft, jedoch nicht auf formale Art und Weise, wie dies bei Artikeln in wissenschaftlichen Zeitschriften der Fall ist.

Die Ablehnung der Studie erfolgte nicht aus fachlichen, sondern aus eklatanten politischen Gründen und nach monatelanger Arbeit des Herausgebers, eines anderen RMAG-Mitarbeiters und von mir. Die Ablehnung war eine Vorstandsentscheidung, die in letzter Minute und ohne Erklärung oder Rechtfertigung getroffen wurde, außer dem Hinweis, dass ich kein „ausgebildeter Klimatologe“ und ein „Blogger“ bin. Es war also ziemlich klar, dass die Studie nicht wegen irgendwelcher Probleme abgelehnt wurde, sondern wegen meiner Person.

Als ich mich beschwerte, schickte der Vorstand die Studie an einen weiteren Gutachter, nachdem die Studie bereits geprüft und angenommen worden war. Dem zusätzlichen Gutachter wurde ein früher Entwurf und nicht die endgültige Fassung zugesandt. In einer Telefonkonferenz wies er auf mehrere Fehler hin, von denen ich wusste, dass sie in der endgültigen Fassung nicht enthalten waren, was zu großer Verwirrung führte, bis ich erkannte, dass er die falsche Version der Studie in Händen hielt.

Der Ausschuss hat also entweder die endgültige Fassung nicht gesehen, als er die Entscheidung des Herausgebers und der Gutachter aufhob, oder er hat seinem zusätzlichen Gutachter absichtlich oder versehentlich die falsche Fassung geschickt. Ich habe dies alles erklärt, aber der Antrag wurde trotzdem abgelehnt, ohne dass ich ihn noch einmal überdacht oder auch nur einen Blick auf den endgültigen Entwurf geworfen hätte. Es handelte sich also eindeutig um eine politische Entscheidung, die auf den Schlussfolgerungen der Studie beruhte, der Tatsache, dass ich kein ausgebildeter Klimatologe bin, und der Tatsache, dass ich ein Blogger bin,. Die Studie erscheint nun in meinem Blog und ist einer meiner beliebtesten Beiträge.

Die zweite eingeladene, aber letztendlich abgelehnte Studie wurde für die Creative Society auf deren Wunsch hin geschrieben. Sie wollten, dass ich eine Studie über Klimaverschiebungen schreibe, wie sie etwa 1925, 1947, 1976 und 1997 stattgefunden haben. Sie baten mich, es in einem Online-Interview am 10. Oktober 2022 vorzustellen. Das Interview wurde aufgezeichnet, und als ich nachfragte, wann es online gestellt werden würde, hieß es, man werde sich bei mir melden. Das geschah nie, also habe ich die Studie in meinem Blog veröffentlicht. Mir wurde nie ein Grund genannt, warum es von der Creative Society nicht online gestellt wurde.

Die Diskussion über die Klimaverschiebungen war interessant, da sie mit den periodischen Veränderungen im Erdmantel zusammenhängen könnten.

Eine Studie, die einen Redakteur zum Rücktritt veranlasste

Abbildung 2. Eine sehr fundierte Studie von Roy Spencer und William Braswell, die den Herausgeber, der sie veröffentlichte, zum Rücktritt veranlasste.

Wolfgang Wagner, der damalige Chefredakteur der Zeitschrift Remote Sensing, trat 2011 wegen einer völlig plausiblen, aber gegen den „Konsens“ gerichteten Studie von Roy Spencer und William Braswell zurück. Spencer und Braswell präsentierten solide Beobachtungen und Fakten, während ihre Kritiker nur Modellergebnisse vorlegten.

Die Debatte zwischen den beiden Seiten ist komplex und dreht sich hauptsächlich um das Vorzeichen und das Ausmaß der Rückkopplungen auf die Erwärmung durch Treibhausgase (hauptsächlich CO₂). So sollte Wissenschaft eigentlich funktionieren. Wenn ein Redakteur von oben herab verkündet, dass eine gut belegte Meinung falsch und die andere richtig ist, ohne dass eine angemessene Diskussion und Debatte stattfindet, ist das Politik und keine Wissenschaft.

Zwei Studien, die zur Entlassung der Redakteure führten

Abbildung 3. Zwei von Prof. Richard Lindzens Studien, die dazu führten, dass die Redakteure gefeuert wurden, welche sie akzeptiert hatten. Die Studie auf der rechten Seite ist Lindzens bahnbrechende erste Studie über den Iris-Effekt.

Willie Soon und Dick Lindzen berichten, dass zwei Redakteure entlassen wurden, weil sie zwei von Lindzens Studien veröffentlicht hatten. In der ersten, 1990 veröffentlichten Studie werden Lindzens Einwände gegen die Vorstellung dargelegt, dass ein vom Menschen verursachter verstärkter Treibhauseffekt die Hauptursache für die derzeitige Erwärmung sein könnte; die Studie ist durchaus begründet und sicherlich kein Grund, jemanden zu entlassen. In der Studie wird davor gewarnt, dass noch mehr endgültige Beweise für die potenziellen Gefahren der vom Menschen verursachten globalen Erwärmung gefunden werden müssen, bevor drastische Maßnahmen wie der Verzicht auf fossile Brennstoffe ergriffen werden. Er erinnert uns daran, dass die Ergebnisse von Klimamodellen keine Beweise sind, sondern nur Vermutungen. Lindzens Studie ist auch heute noch gültig, da auch 34 Jahre später noch keine endgültigen Beweise und Beispiele für die Gefahren des vom Menschen verursachten Klimawandels gefunden worden sind. Dies wird in Tabelle 12.12 des AR6 WGI auf Seite 1856 gut veranschaulicht, die ein wenig später in diesem Beitrag gezeigt wird.

Die zweite ist Lindzens bahnbrechende erste Studie über den Iris-Effekt auf der rechten Seite von Abbildung 3. Heute, mehr als 23 Jahre später, ist der Iris-Effekt weithin anerkannt, und wenn er in Klimamodelle einbezogen wird, bringt er die Modellergebnisse näher an die Beobachtungen heran. Sicherlich ist die Annahme einer solch grundlegenden Studie kein Grund, jemanden zu entlassen.

Man muss bedenken, dass Albert Einsteins erste Doktorarbeit abgelehnt wurde. Jahre später reichte er eine Reihe von Studien bei Max Planck in der Zeitschrift Annalen der Physik ein, von denen eine als Dissertation angenommen wurde und er schließlich seinen Doktortitel erhielt. Planck veröffentlichte Einsteins neue Dissertation und mehrere andere Studien ohne formale Begutachtung durch Fachkollegen, und Einsteins Ruf wurde begründet. Max Planck sagte, es sei wichtig, riskante Studien zu veröffentlichen, aber es sei viel schlimmer, eine möglicherweise bahnbrechende Arbeit abzulehnen. Das Peer-Review-Verfahren kann wirklich innovative Arbeiten unterdrücken, und das geschieht auch häufig. Manchmal werden Studien einfach deshalb abgelehnt, weil sie neu sind und der „Konsens“-Meinung widersprechen.

Heute wird der Iris-Effekt in den IPCC-Berichten ausführlich erörtert, wenn auch oft ohne Erwähnung von Lindzens Namen, und eine Suche über Google Scholar zeigt sieben veröffentlichte Studien seit der Veröffentlichung der ursprünglichen Studie im Jahr 2001. Fünf davon wurden nach 2015 veröffentlicht, die jüngste im Jahr 2022. Über diese wichtige Entdeckung wurde in einer Zeitschrift berichtet, deren Herausgeber wegen der Veröffentlichung gefeuert wurde, und jetzt ist die Entdeckung anerkannte Wissenschaft. Ich konnte keine Beweise dafür finden, dass die Professoren entlassen wurden, welche Einsteins These ablehnten.

Die Zurückziehung der Studie von Alimonti

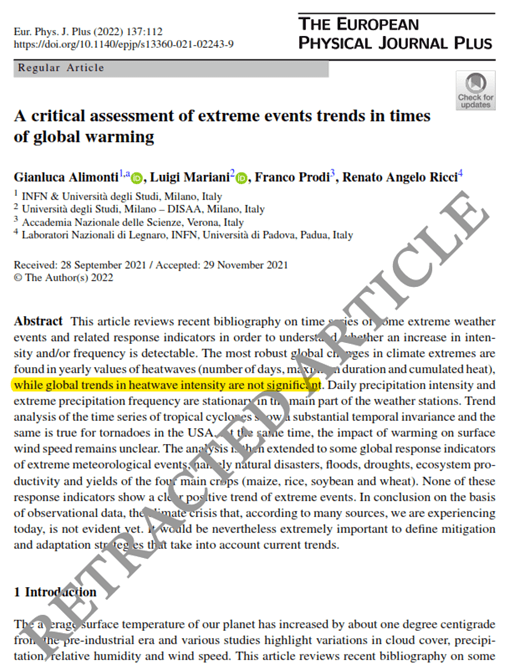

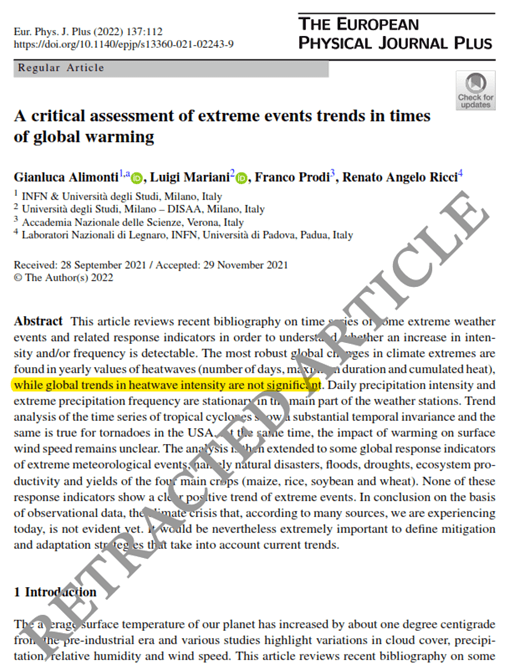

Abbildung 4. Eine ausgezeichnete Studie, die von Kapitel 12 des AR6 unterstützt wird, wurde von SpringerNature ohne Angabe von Gründen zurückgezogen, außer dass „Bedenken geäußert wurden…“.

Was Roger Pielke Jr. als das ungeheuerlichste Versagen moderner wissenschaftlicher Veröffentlichungen bezeichnet, ist die Tatsache, dass diese hervorragende Studie von Gianluca Alimonti und seinen Kollegen auf Druck des „Konsens’“ und der Mainstream-Medien zurückgezogen wurde. Pielke Jr. glaubt, dass der Rückzug allein auf dem folgenden Satz der Studie beruhte:

„Auf der Grundlage von Beobachtungsdaten lässt sich schlussfolgern, dass die Klimakrise, die wir nach Meinung vieler Quellen heute erleben, noch nicht offensichtlich ist.“

Das ist einfach dasselbe, was die AR6 WGI in ihrer Tabelle 12.12 in Abbildung 5 sagt. Die Rückzugsmeldung von SpringerNature enthielt keine inhaltlichen Einwände gegen die Studie, sondern besagt lediglich, dass „Bedenken geäußert wurden…“. Für weitere Details siehe hier.

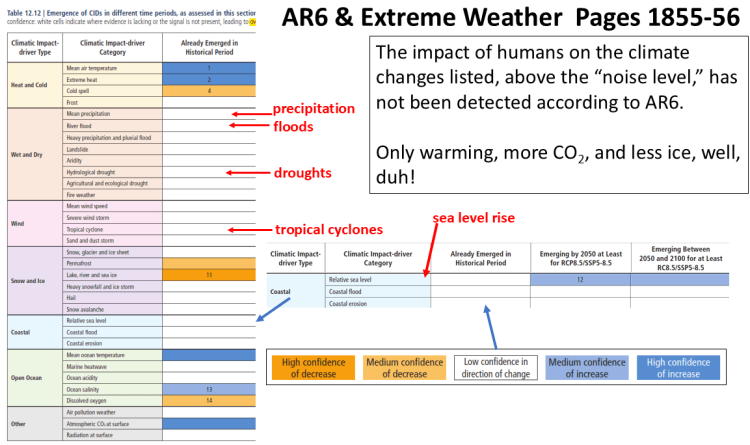

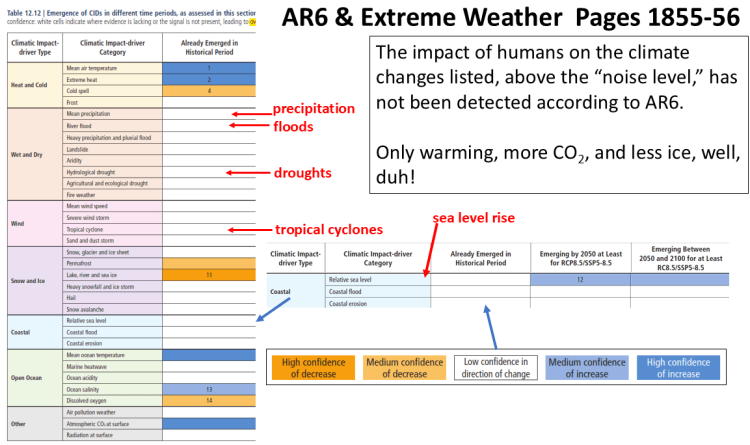

AR6 und Extremwetter

Abbildung 5. Tabelle 12.12 im AR6 WGI. Die farbigen Kästchen zeigen die Klimaänderungen, die sich bisher aus dem Klimarauschen ergeben haben. Es wurden nur einige sehr harmlose Klimaänderungen beobachtet. Die meisten, einschließlich Überschwemmungen, Meeresspiegelanstieg, Dürre und Wirbelstürme, wurden nicht beobachtet.

Hier sehen wir einen Teil der bereits erwähnten Tabelle 12.12, aus AR6, Kapitel 12, Seite 1856. Die rechte Spalte der Tabelle zeigt die nachgewiesenen „Einflussfaktoren des Klimawandels“, die heute oder in der jüngeren Geschichte der Erde, d. h. seit ~1750 oder später, zu beobachten sind. Der IPCC definiert die Einflussfaktoren des Klimawandels als physikalische Bedingungen des Klimasystems, die sich auf ein Element der Gesellschaft oder der Ökosysteme auswirken. Vom Menschen verursachte CIDs können in verschiedenen Regionen der Erde schädlich, vorteilhaft, neutral oder eine Mischung aus beidem sein.

Das heißt, eine bestimmte Klimaveränderung kann in einem Teil der Welt vorteilhaft und in einem anderen nachteilig sein. Dies liegt auf der Hand, wird aber vom Klima-Establishment oft ignoriert, das dazu neigt, nur die negativen Auswirkungen des Klimawandels zu berücksichtigen. Ein Einflussfaktor des Klimawandels ist definiert als eine Veränderung, die ein Signal-Rausch-Verhältnis von eins überschritten hat. Sie tritt oberhalb eines bestimmten Niveaus zufälliger Veränderungen auf, dem so genannten „ Rauschpegel “. Die Definition des Klimawandels ist also statistisch. Es braucht Zeit, um festzustellen, ob eine bestimmte Veränderung auf der Zeitskala des Klimas real ist. Roger Pielke Jr. und seine Kollegen fanden heraus, dass wir, selbst wenn eine bestimmte Veränderung eintritt, erst nach über 100 Jahren sicher sein können, dass es sich um eine echte Klimaänderung handelt. So lange würde es dauern, bis man die notwendigen Daten gesammelt hat, um nachzuweisen, dass sich die Veränderung aus dem Rauschen herausgelöst hat.

Wie die Legende zeigt, bedeutet Orange eine Abnahme und Blau eine Zunahme, ein weißes Kästchen bedeutet, dass keine Veränderung oberhalb des Lärmpegels festgestellt wurde. Das Kästchen für tropische Wirbelstürme ist weiß, ebenso sind die Kästchen für Windgeschwindigkeit, Dürre, Überschwemmungen, Niederschlag, Waldbrände, Erdrutsche, Versauerung der Ozeane und Anstieg des Meeresspiegels weiß, was bedeutet, dass bei all diesen Elementen keine signifikante Veränderung festgestellt wurde.

Es wird eine Zunahme extremer Hitze festgestellt, aber die Fußnote beschränkt dies auf einige tropische Regionen und Regionen der mittleren Breiten, so dass nicht einmal eine Zunahme extremer Hitzeereignisse auf globaler Ebene zu erkennen ist. In den meisten Regionen ist ein Rückgang der Kälteperioden und ein Anstieg der mittleren Lufttemperatur zu verzeichnen. Ebenso ist ein Rückgang des Permafrosts, des See- und Flusseises und ein Anstieg der mittleren Meerestemperatur zu verzeichnen. Wenn die Wissenschaftler also nur diese offensichtlichen Veränderungen festgestellt haben, die weitgehend harmlos sind, warum tun die Politiker dann so, als ginge die Welt unter? Genau das müssen wir uns fragen. Ich schätze, sie haben nicht erwartet, dass jemand bis zur Seite 1856 liest.

[Hervorhebung vom Übersetzer]

Im Folgenden beleuchtet Andy May einzelne Elemente des Wettergeschehens. Das wird immer wieder an anderer Stelle auf diesem Blog des EIKE angesprochen, so dass hier – auch wegen der Länge des Beitrags – auf die Übersetzung verzichtet wird. Im Einzelnen spricht May an:

Zyklonen und Extremwetter, Stürme, den Anstieg des Meeresspiegels, das Modell im AR6 bzgl. der Erwärmung seit der Kleinen Eiszeit, die derzeitige Sonnenaktivität und das Moderne Solare Maximum.

Am Ende seiner Ausführungen bringt May noch eine „Discussion“, die wieder übersetzt wird:

Diskussion

Zensur ist eine hässliche Sache. Sie ist Präsidentschaftskandidaten und Wissenschaftlern widerfahren. Sie ist auch mir passiert. Zensur aus einem anderen Grund als dem Schutz von Kindern vor altersunangemessenen Bildern und Texten ist sowohl unwissenschaftlich als auch falsch. Die Hauptaufgabe eines jeden Wissenschaftlers ist es, akzeptierte Ideen mit Daten und Analysen zu hinterfragen, Wissenschaft ist mit Zensur unvereinbar.

[Hervorhebung vom Übersetzer]

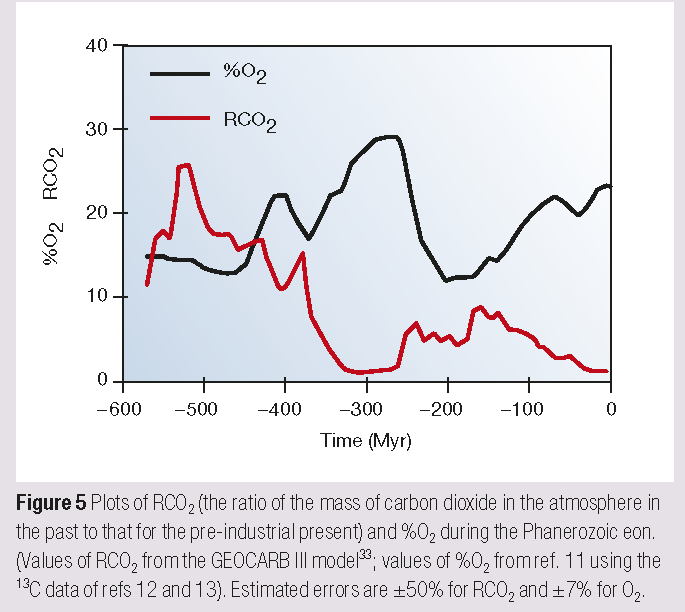

In den Medien hören wir ständig, dass der vom Menschen verursachte Klimawandel bereits jetzt gefährlich ist oder dass es Anzeichen dafür gibt, dass schwere Klimakatastrophen unmittelbar bevorstehen. Die einzigen beobachteten so genannten Gefahren sind jedoch, dass die Welt ein wenig wärmer ist und der CO₂-Gehalt in der Atmosphäre zugenommen hat. Diese offensichtlichen Veränderungen haben die Welt einfach grüner und besser gemacht. Alle angeblichen „Gefahren“ werden von Klimamodellen in die Zukunft projiziert, und die Klimamodelle haben sich als ungenau erwiesen.

Die Erwärmung findet hauptsächlich in den höheren Breitengraden statt, die Temperaturen in den Tropen ändern sich kaum und werden durch Verdunstung und die daraus resultierende hoch reichende Konvektion warmer, feuchter Luft mit der Folge von Gewittern auf etwa 30 °C begrenzt. Der Wärmetransport von den Tropen zu den Polen wirkt wie ein Wärmemotor, der unser Wetter erzeugt: Je mehr Wärme transportiert wird, desto stürmischer ist es. Je mehr Wärme transportiert wird, desto stürmischer ist das Wetter. Wenn sich also die höheren Breitengrade erwärmen, auch bekannt als „globale Erwärmung“, wird weniger Wärme zu den Polen transportiert, und in den mittleren Breiten bilden sich weniger und weniger heftige Stürme. Alle im 20. Jahrhundert gesammelten Daten deuten darauf hin, dass die Stürme mit der Erwärmung der Welt abnehmen und nicht zunehmen.

Der Anstieg des Meeresspiegels seit 1900 verläuft zu etwa 96 % linear, wenn man alle gängigen Aufzeichnungen über den Meeresspiegelanstieg verwendet. Die offensichtliche Beschleunigung seit 1990 fällt mit einem Aufschwung der AMO und anderer Meeresschwingungen zusammen und ist wahrscheinlich natürlichen Ursprungs. Es ist verfrüht, dies auf menschliche Aktivitäten zu schieben. Wir werden es erst in 30 Jahren wissen, wenn diese Oszillation in die Negativ-Phase wechselt.

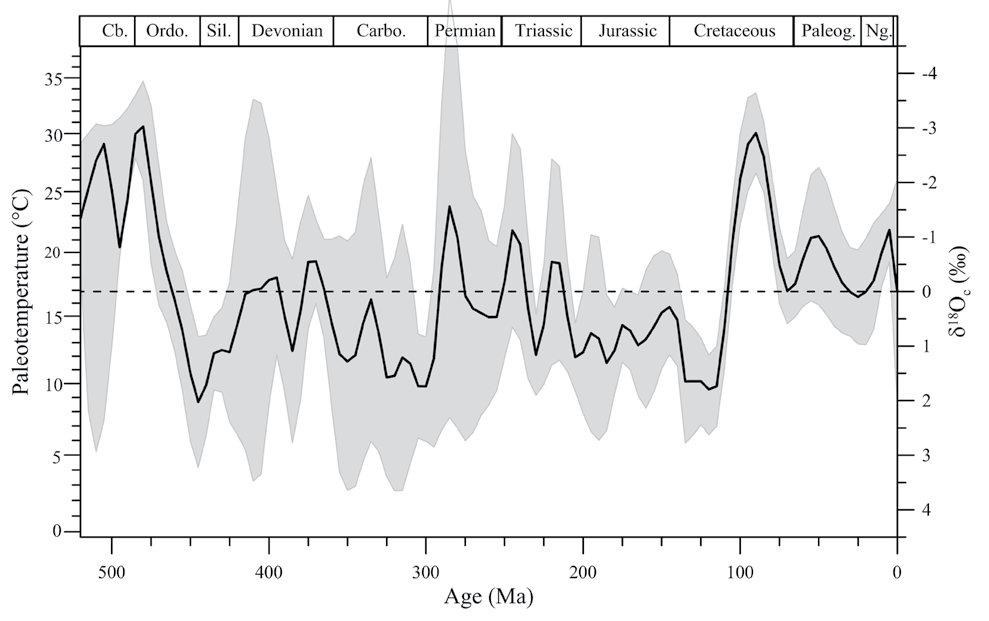

Der Einfluss der Sonne auf das Klima ist weitaus variabler, als vom IPCC und dem Klimakonsens angenommen. Außerdem korrelieren diese bekannten Schwankungen der Sonne sehr gut mit historischen Klimaveränderungen.

Die Voreingenommenheit in den UN-Berichten über den Klimawandel ist größtenteils eine Selektionsverzerrung. Sie wählen nur Studien aus, die ihre These stützen, dass der Mensch das Klima steuert, und ignorieren die umfangreiche Literatur, die zeigt, dass die Natur durch Wolkenbedeckung, Ozeanschwankungen und die Sonne einen großen Einfluss hat, wahrscheinlich den dominierenden Einfluss auf unser langfristiges Klima. Diese Zensur durch Auslassung führt zu einer radikalen Fehlinformation der Öffentlichkeit.

Die Wissenschaft ist das bewährte Verfahren, mit dem eine Person oder eine kleine Gruppe der Welt zeigen kann, dass die von ihr gehegten Überzeugungen falsch sind. Das funktioniert nur in einer offenen Welt mit freier Meinungsäußerung und einer freien Presse. Zensur, Unterdrückung der Redefreiheit und Konsensdenken sind die Feinde von Wissenschaft und Wahrheit.

Zensur und die Unterdrückung der freien Meinungsäußerung zerstören Innovation und menschlichen Fortschritt. Würde es in einer Welt, in der der Konsens regiert und neue Ideen unterdrückt werden, einen Personal Computer in jeder Tasche und jedem Portemonnaie oder ein SpaceX Starlink geben? Nein, dies waren die Visionen einiger weniger Personen unter der Führung von Steven Jobs bzw. Elon Musk. Andere würden die Ideen für verrückt halten, wie Einsteins These oder Richard Lindzens Hypothese des Iris-Effekts. Der so genannte „Konsens“ ist der Feind von Innovation und Wahrheit.

For more details on AR6 and its problems see: The Frozen Climate Views of the IPCC: An Analysis of AR6.

Link: https://andymaypetrophysicist.com/2024/09/27/suppression-of-science-and-inconvenient-truths/

Übersetzt von Christian Freuer für das EIKE