Unlogische Fakten – „Faktenchecks“ durch Innuendo

Kip Hansen

[Alle Hervorhebungen in diesem Beitrag im Original]

Die neueste Mode bei allen Arten von Aktivismus ist es, die eigenen ideologischen Gegner durch „Faktenüberprüfung“ anzugreifen. Wir sehen das in der Politik und bei allen modernen Kontroversen, natürlich auch bei der Klimawissenschaft.

Fast keine der „Fact-Checking-Sites“ und „Fact-Checking-Organisationen“ überprüfen tatsächlich die Fakten. Und wenn sie zufällig etwas prüfen, das wir alle als Tatsache und nicht nur als Meinung oder Standpunkt ansehen, wird es immer gegen eine gegenteilige Meinung, einen anderen Standpunkt oder eine alternative Tatsache geprüft.

Der daraus resultierende Faktencheck-Bericht hängt von den Zielen des Faktenchecks ab. Einige werden durchgeführt, um zu bestätigen, dass „unser Mann“ oder „unser Team“ richtig liegt, oder dass die Gegenseite nachweislich falsch liegt, lügt oder falsch informiert ist. Wenn sich herausstellt, dass eine Tatsache in irgendeiner Weise von der gewünschten Tatsache abweicht, und sei es auch nur im Geringsten, wird das überprüfte Original als Unwahrheit oder, schlimmer noch, als absichtliche Lüge bezeichnet. (oder umgekehrt, andere Leute lügen über unsere Fakten!). Niemand mag einen Lügner, so dass diese Art der gefälschten Faktenüberprüfung zwei Ziele erreicht – sie lässt Zweifel an der angeblich überprüften Tatsache aufkommen und verleumdet einen ideologischen Gegner als Lügner. Zwei Fliegen mit einer Klappe.

Obwohl nicht ganz neu in der Szene der Faktenüberprüfung, ist eine KI-gestützte Bemühung an die Oberfläche der aufgewühlten Meere der Kontroverse aufgetaucht: Logically Facts. „Logically Facts ist Teil des Third Party Fact-Checking Program (3PFC) von Meta und arbeitet mit TikTok in Europa zusammen. Wir sind seit 2020 ein verifizierter Unterzeichner des International Fact-Checking Network (IFCN) und sind Mitglied der Misinformation Combat Alliance (MCA) in Indien und des European Digital Media Observatory (EDMO) in Europa.“ [Quelle] Meta? „Meta Platforms … ist der unangefochtene Marktführer im Bereich der sozialen Medien. Das Technologieunternehmen besitzt drei der vier größten Plattformen nach monatlich aktiven Nutzern (Facebook, WhatsApp und Instagram).“ „Die sozialen Netzwerke von Meta sind als Family of Apps (FoA) bekannt. Bis zum vierten Quartal 2023 zogen sie fast vier Milliarden Nutzer pro Monat an.“ Und TikTok? Es hat über eine Milliarde Nutzer.

Ich bezweifle, dass man die 4 Milliarden und die 1 Milliarde zusammenzählen kann, um auf 5 Milliarden Nutzer von META und TikTok zu kommen, aber auf jeden Fall ist das ein riesiger Prozentsatz der Menschheit, egal wie man es betrachtet.

Und wer prüft die Fakten dieser Milliarden von Menschen? Logically Facts [LF].

Und welche Art von Faktenüberprüfung führt LF durch? Schauen wir uns ein Beispiel an, das sich mit etwas beschäftigt, das der Leserschaft hier sehr vertraut ist: Die Leugnung der Klimawissenschaft.

Die von Wiki vorgeschlagene Definition lautet:

„Klimawandelleugnung (auch Leugnung der globalen Erwärmung) ist eine Form der Wissenschaftsleugnung, die dadurch gekennzeichnet ist, dass sie den wissenschaftlichen Konsens über den Klimawandel ablehnt, sich weigert, ihn anzuerkennen, ihn anzweifelt oder bekämpft.“

Andere gängige Definitionen der Leugnung des Klimawandels lauten: Angriffe auf Lösungen, Infragestellung der offiziellen Klimawandelwissenschaft und/oder der Klimabewegung selbst.

Wenn ich alle Zeit der Welt hätte, könnte ich mich eingehend mit der Fact-Checking-Industrie befassen. Aber da meine Zeit begrenzt ist, wollen wir uns gemeinsam einen einzigen „Analyse“-Artikel von Logically Facts ansehen:

Pseudowissenschaft, keine Krise“: Wie angebliche Experten die Leugnung des Klimawandels anheizen

Dieser Artikel ist eine faszinierende Studie über „Fake-fact-checking by inuendo“. Während wir den Artikel durchgehen und seine Behauptungen stichprobenartig überprüfen, werde ich Sie auf jede Überprüfung einer tatsächlichen Tatsache hinweisen – halten Sie nicht den Atem an. Wenn Sie proaktiv sein wollen, lesen Sie zuerst den LF-Artikel, dann werden Sie besser verstehen, was sie tun.

Die Einführung zu ihrem Artikel lautet:

„Würden Sie einen Augenarzt um zahnärztlichen Rat bitten? Die Antwort ist offensichtlich. Doch in den sozialen Medien beeinflussen selbsternannte ‚Experten‘ mit wenig bis gar keinem relevanten Wissen über Klimawissenschaft die öffentliche Meinung.“

Als Herausgeber dieser „Analyse“ werden Shreyashi Roy [MA in Massenkommunikation und ein BA in englischer Literatur] und Nitish Rampal [ … mit Sitz in Neu-Delhi und …. mit großem Interesse an Sport, Politik und Technik] genannt. Der Autor ist angeblich [mehr zu „angeblich“ in einer Minute…] Anurag Baruah [MA in englischer Sprache und ein Zertifikat in Umweltjournalismus: Storytelling, erworben online bei der Thompson Founation.]

Warum sagen Sie „angeblich“, Herr Hansen? Wenn Sie den LF-Artikel gelesen hätten, wie ich vorgeschlagen habe, würden Sie sehen, dass er sich so liest, als ob er von einem KI-Large Language Model „geschrieben“ wurde, gefolgt von einer sinnvollen Überarbeitung durch einen Menschen, wahrscheinlich Herrn Baruah, gefolgt von einer weiteren Überarbeitung durch Roy und Rampal.

Der Vorspann ist selbst unlogisch. Zunächst ist von ärztlicher/zahnärztlicher Beratung die Rede, wobei zu Recht darauf hingewiesen wird, dass es sich um unterschiedliche Fachgebiete handelt. Dann wird beklagt, dass ungenannte so genannte selbsternannte Experten, von denen LF behauptet, sie hätten „wenig bis keine relevanten Kenntnisse der Klimawissenschaft“, die öffentliche Meinung beeinflussen. Da diese Personen bisher nicht namentlich genannt werden, können der KI, der Autor und die nachfolgenden Redakteure von LF unmöglich wissen, wie hoch ihr Wissensstand über die Klimawissenschaft sein könnte.

Wen genau wollen sie hier anschmieren?

Der erste ist:

Einer dieser „Experten“, Steve Milloy, eine prominente Stimme auf der Social-Media-Plattform X (früher Twitter), bezeichnete am 26. Juni 2024 einen Beitrag der NASA Climate (Archiv) über die Auswirkungen des Klimawandels auf unsere Meere als „Lüge“.

Es ist absolut wahr, dass Milloy, der dafür bekannt ist, dass er alles kritisiert, was er als schlecht gemacht, überbewertet oder anderweitig in seine Kategorie „Junk Science“ fällt, auf X den behaupteten Artikel veröffentlicht hat. LF, dessen KI, Autor und Redakteure machen keine Anstalten, die von Milloy als Lüge bezeichneten Fakten zu überprüfen oder die Fakten der NASA in irgendeiner Weise zu überprüfen.

Wenn Milloy irgendeine Behauptung der NASA als „Lüge“ bezeichnet, ist das a priori ein Fall von Klimaleugnung: Er widerlegt oder weigert sich, irgendeinen Punkt der offiziellen Klimawissenschaft zu akzeptieren.

Wer ist Steve Milloy?

Steve Milloy ist Vorstandsmitglied und Senior Policy Fellow des Energy and Environment Legal Institute, Autor von sieben Büchern und über 600 Artikeln/Kolumnen, die in großen Zeitungen, Zeitschriften und im Internet veröffentlicht wurden. Er hat auf Anfrage mehrfach vor dem US-Kongress ausgesagt, unter anderem zu den Themen Risikobewertung und Katastrophenschutz. Er ist außerordentliches Mitglied des National Center for Public Policy Research.

„Er hat einen B.A. in Naturwissenschaften von der Johns Hopkins University, einen Master in Gesundheitswissenschaften (Biostatistik) von der Johns Hopkins University School of Hygiene and Public Health, einen Juris Doctorate von der University of Baltimore und einen Master of Laws (Wertpapierregulierung) vom Georgetown University Law Center.

Es scheint, dass viele Herrn Milloy für einen Experten in vielen Dingen halten.

Und die Beweise für LFs Ablehnung von Milloy als „selbsternannter Experte“ mit „wenig bis gar keinem relevanten Wissen über Klimawissenschaft“? Der Guardian, Mitbegründer der Klimakrisen-Propagandaorganisation Covering Climate Now, sagte: „JunkScience.com wurde als ‚Hauptumschlagplatz für fast jede Art von Leugnung des Klimawandels bezeichnet“, und nach einem Link, der Milloys Abschlüsse auflistet, wurde er wegen „fehlender formaler Ausbildung in Klimawissenschaft“ abgewatscht. Nun, ein BA in Naturwissenschaften könnte schon etwas zählen. Und ein Jurastudium ist nicht nichts. Der letzte Link, der eindeutig beweist, dass Milloy ein anerkannter Experte ist, und es ist offensichtlich, dass der LF KI, der Autor und die Redakteure den Inhalt des Links entweder nicht gelesen oder einfach beschlossen haben, ihn zu ignorieren.

Unglaublicherweise ist das nächste Ziel von LF „… John Clauser, ein Nobelpreisträger für Physik aus dem Jahr 2022, behauptete, dass es keine Klimakrise gibt und dass die Klimawissenschaft ‚Pseudowissenschaft‘ ist. Clausers Nobelpreis verlieh seinen Aussagen Gewicht, aber er hat nie eine von Fachleuten begutachtete Arbeit über den Klimawandel veröffentlicht.“

LFs Beweis gegen Clauser ist die Washington Post, die in einem Artikel nicht nur Clauser angreift, sondern eine lange Liste bedeutender Physiker, die den IPCC-Konsens zum Klimawandel nicht unterstützen: Willie Soon (einschließlich der Lüge, dass Soon’s Arbeit von fossilen Brennstoffunternehmen finanziert wurde), Steve Koonin, Dick Lindzen und Will Happer. Der Post-Artikel geht auf keinen der Gründe ein, warum diese geschätzten Weltklasse-Physiker keine Mitglieder des Konsensclubs sind. Ihre Nichtübereinstimmung ist ihr Verbrechen. Es werden keine Fakten geprüft.

LF untermauert den Angriff auf weltbekannte Physiker mit einem Zitat von Professor Bill McGuire: „Solche Pseudo-Experten sind gefährlich und meiner Meinung nach unglaublich unverantwortlich – Nobelpreis hin oder her. Ein Physiker, der den anthropogenen Klimawandel leugnet, leugnet in Wirklichkeit die wohlbekannten physikalischen Eigenschaften von Kohlendioxid, was einfach absurd ist.“

McGuire ist kein Physiker und kein Klimawissenschaftler, aber er hat einen Doktortitel in Geologie und ist Vulkanologe und ein Mitautor des IPCC. Man könnte ihn auch als „ohne formale Ausbildung in Klimawissenschaft“ bezeichnen.

Aber McGuire hat einen Punkt, den LF, seine KI und seine menschlichen Redakteure zu übersehen scheinen: Die Grundlage der CO2-Hypothese der globalen Erwärmung basiert auf der Physik und nicht auf dem, was man heute „Klimawissenschaft“ nennt. Daher sind die Physiker die wahren Experten (und nicht die Vulkanologen….).

LF zieht dann den unbegründeten Vergleich mit „falschen Experten“ im Anti-Tabak-Kampf, spielt auf die Verbindungen zur Ölindustrie an und kommt dann direkt auf John Cook zu sprechen.

John Cook, ein weltweit führender Kämpfer gegen die Leugnung des Klimawandels, ist kein Klimawissenschaftler. Er ist kein Geologe, kein Atmosphärenforscher, kein Ozeanforscher, kein Physiker und nicht einmal ein Vulkanologe. Er „promovierte 2016 in Kognitionswissenschaften an der University of Western Australia“.

Der Rest der Fake-Analyse von Logically Facts ist im Grunde eine Umschreibung einiger von Cooks Anti-Klimaleugner-Beiträgen. Möglicherweise/wahrscheinlich resultiert sie aus einem KI-Sprachmodell, das auf Pro-Konsens-Klimamaterialien trainiert wurde. Logically Facts ist ausdrücklich und offen ein KI-basiertes Projekt.

LF greift nacheinander eine Reihe von Personen an, nicht deren Ansichten: Tony Heller, Dr. Judith Curry, Patrick Moore und Bjørn Lomborg.

Das Fachwissen dieser Personen auf ihren jeweiligen Gebieten wird entweder ignoriert oder übergangen.

Curry ist eine weltweit anerkannte Klimawissenschaftlerin und ehemalige Vorsitzende der School of Earth and Atmospheric Sciences am Georgia Institute of Technology. Curry ist Autorin des Buches „Thermodynamics of Atmospheres and Oceans“, eines weiteren Buches „Thermodynamics, Kinetics, and Microphysics of Clouds“ und des wunderbaren, bahnbrechenden Buches „Climate Uncertainty and Risk: Rethinking Our Response“. Eine Suche nach „Dr. Judith Curry climate“ bei Google scholar ergibt über 10.000 Treffer.

Lomborg ist ein Sozioökonom mit einer beeindruckenden Erfolgsbilanz, ein Bestsellerautor und ein führender Experte in Fragen der Energieabhängigkeit, des Nutzens von Geld, das für die internationale Armutsbekämpfung und die öffentliche Gesundheit ausgegeben wird, usw. Richard Tol wird negativ erwähnt, weil er es gewagt hat, den „97%-Konsens“ anzuzweifeln, wobei seine Qualifikationen als Professor für Wirtschaftswissenschaften und Professor für die Ökonomie des Klimawandels nicht erwähnt werden.

Unter dem Strich:

Logically Facts ist eine KI vom Typ Large Language Model [LLM], ergänzt durch Autoren und Redakteure, die das von dieser KI vom Typ Chat-Bot zurückgelieferte Chaos bereinigen sollen. Daher ist sie völlig unfähig, Werturteile zwischen wiederholten Verleumdungen, erzwungenen Konsensmeinungen, den vorherrschenden Voreingenommenheiten in wissenschaftlichen Bereichen und tatsächlichen Fakten zu treffen. Außerdem ist jede LLM-basierte KI unfähig, kritisch zu denken und logische Schlussfolgerungen zu ziehen.

Kurz gesagt, Logically Facts ist unlogisch.

Kommentar des Autors Kip Hansen dazu:

Ich bin kein Fan von Künstlicher Intelligenz (ein Oxymoron). Logically Facts und der Rest des Logically-Imperiums, Logically.ai, leiden unter all den großen Mängeln der aktuellen Versionen verschiedener Arten von KI, einschließlich Halluzinationen, Zusammenbrüchen und der KI-Version von „Du bist, was du isst“.

Soweit ich weiß, wird bei Logically Facts ein LLM eingesetzt, das darauf trainiert ist, offiziellen Quellen (Regierungen), renommierten Zeitungen (wie der New York Times, dem Guardian, der Washington Post usw.) und in diesen Quellen zitierten Wissenschaftlern zu vertrauen und jede Quelle zu ignorieren, die nicht mit den Meinungen dieser Quellen übereinstimmt.

Das Problem liegt auf der Hand: Bei jeder Art von Kontroverse gewinnt die „offiziellste“ und am weitesten verbreitete Ansicht und wird für „wahr“ erklärt, während gegenteilige Ansichten als „Fehlinformation“ oder „Desinformation“ bezeichnet werden. Personen, die die Minderheitsmeinung vertreten, werden als „Leugner“ (von was auch immer) abgestempelt und alle Verleumdungen und Beleidigungen gegen sie werden standardmäßig als „wahr“ eingestuft.

Das ist das natürliche Ergebnis von LLMs – dieser Effekt wird noch verstärkt, indem ihre Trainings-Algorithmen so angepasst werden, dass bestimmte Quellen und Arten von Quellen als endgültig und andere Quellen und Arten von Quellen als nicht vertrauenswürdig akzeptiert werden.

Ein KI-Chat-Bot kann einfache, nicht kontroverse Sachfragen korrekt beantworten – und ist eine schnelle, unkomplizierte Methode, um Dinge herauszufinden wie: „Was ist die Hauptstadt der Türkei?“ (solange man sich nicht über die Geschichte streiten will….). „Wie hoch ist die Einwohnerzahl von New York City?“ (aber Vorsicht, stellen Sie sicher, dass es das ist, was Sie wissen wollen, und nicht die Bevölkerung dessen, was wir als „NY City“ bezeichnen, einschließlich aller Bezirke und der umliegenden Gebiete – die Megalopolis NY-NJ-Connecticut).

Logically Facts prüft keine Fakten.

Link: https://climaterealism.com/2024/08/illogically-facts-fact-checking-by-innuendo/

Übersetzt von Christian Freuer für das EIKE

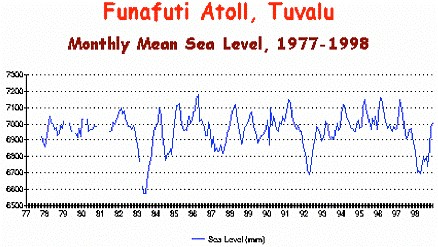

Abbildung 54: Verlauf des RSL in Tuvalu für die Zeit

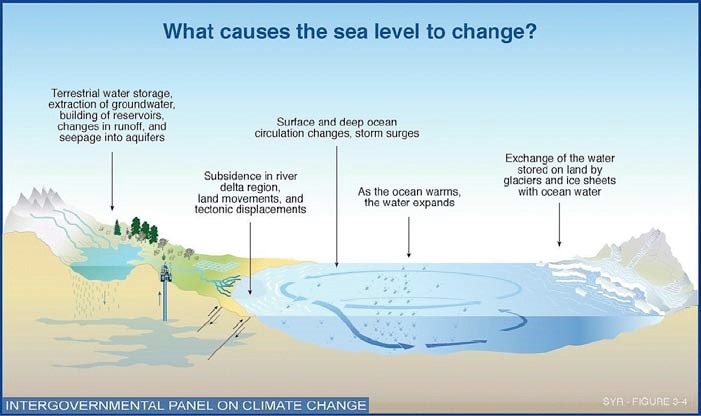

Abbildung 54: Verlauf des RSL in Tuvalu für die Zeit Abbildung 55: zeigt welche Ursachen nach Meinung des IPCC die Veränderungen beim GMSL bewirken. Von links nach rechts: Wasserspeicherung in Binnengewässern, Entnahme von Grundwasser und Einspeisung in

Abbildung 55: zeigt welche Ursachen nach Meinung des IPCC die Veränderungen beim GMSL bewirken. Von links nach rechts: Wasserspeicherung in Binnengewässern, Entnahme von Grundwasser und Einspeisung in