Teil 4: Die Bestimmung des globalen Meeresspiegels GMSL (Global Mean Sea Level)

Die Meeresspiegelangaben des IPCC, PIK etc. sind sowohl zeitlich als auch messtechnisch zu ungenau, um aus den beobachteten nur vage ermittelten Veränderungen (ca. 1 bis 2 mm/Jahr ), deren Abhängigkeit von der Globaltemperatur hinreichend klar zu bestimmen.

von Michael Limburg

4.4.6. Die Wahl des Vergleichszeitraumes und zeitliche Länge der Messreihe

Douglas [Douglas, 1994] unterstützt von Pugh [Pugh, 2004], berichtet von Beobachtungen, dass sowohl die Wahl des untersuchten Zeitraumes, als auch die Dauer der Aufzeichnung die Größe und das Vorzeichen des RSL Trends bestimmen. Diese Effekte treten selbst dann auf, wenn Zeiträume von bis zu 30 Jahren kontinuierlicher Messung zugrunde gelegt werden. Am Beispiel von San Francisco, mit einer kontinuierlichen Aufzeichnung des RSL über 140 Jahre und damit der längsten in den USA, führt Douglas [Douglas, 1991] aus, dass selbst 30 jährige Trends, die irgendwo in der Zeitreihe errechnet werden, von -2 mm/Jahr bis + 5 mm/Jahr schwanken können. Er schließt daraus, dass Zeitreihen, die kürzer als 30 Jahre sind, nicht zur Bestimmung des RSL Trends (und damit des GMSL Trends) herangezogen werden dürfen. Svetlana Jevrejeva und ihre Kollegen [Jevrejeva, 2006] haben auch kürzlich wieder bestätigt, dass die Wahl des Vergleichszeitraumes eine wichtige Rolle der Trendänderung des GMSL spielt.

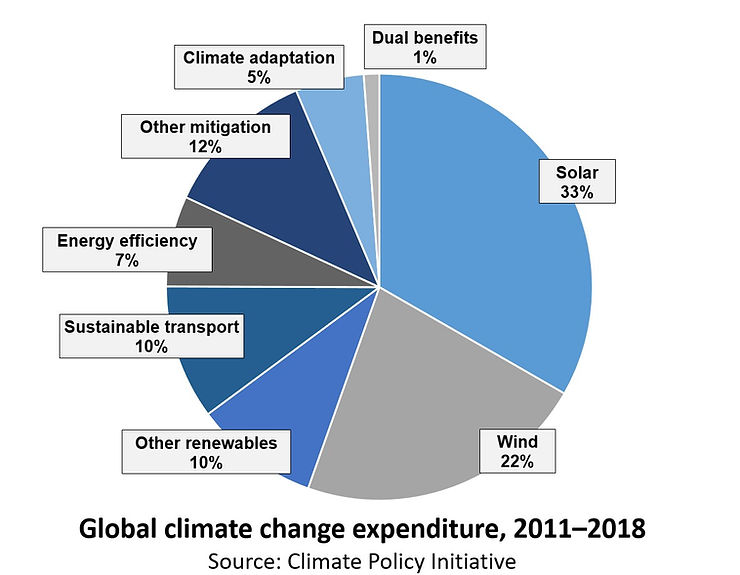

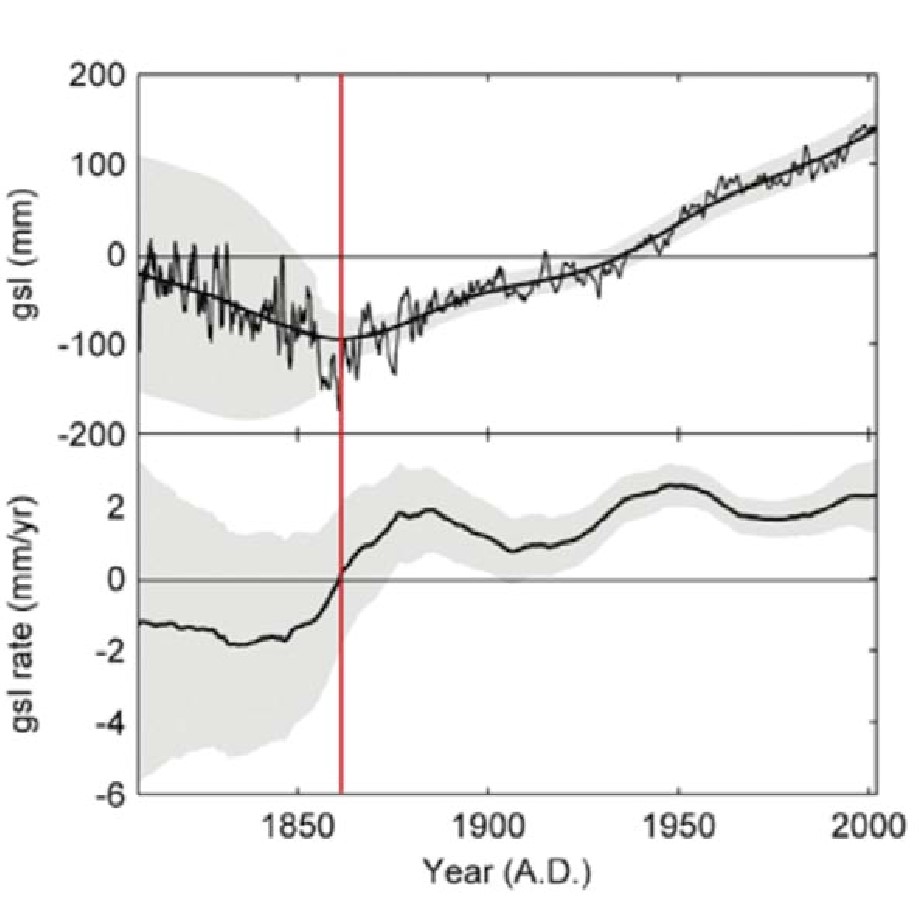

Abbildung 58: Der berechnete Verlauf des GSML nach Svetlana Jevrejeva und ihren Kollegen ([Jevrejeva, 2006]. Er zeigt das Absinken desselben bis 1860 und danach, nicht kontinuierliche, Ansteigen seit dieser Zeit um ca. 240 mm, d.h. 1,65 mm/Jahr. Der graue Schleier gibt einen Hinweis auf die Größe der jeweiligen Unsicherheit. Ist aber seinerseits nur eine unsichere Schätzung.

Wie in Abbildung 58 dargestellt ist der GMSL nach Jevrejeva et.al. ([Jevrejeva, 2006] bis 1860 gesunken, von da an mit leichter Wellenbewegung gestiegen. Die Rate liegt seitdem bei +1,65 mm/Jahr. Trivial, aber nicht unwichtig: Legte man den Startpunkt der Mittelwertbildung in obiger Abbildung auf das Startjahr um 1820, dann beträgt der mittlere Anstieg Jevrejeva Kurve nur ca. +0,8 mm/Jahr gegenüber ca. +1,65 mm beim Startjahr 1860

4.4.7. Der barometrische Druck

In vielen vom Autor durchgesehenen Papers zur Bestimmung des GMSL, z.B. [Miller, 2004] oder [Jevrejeva, 2006] wird darauf hingewiesen, dass eine Korrektur des barometrischen Druckes, der deutliche Auswirkungen auf den RSL hat, bei ihren Untersuchungen nicht erfolgte. Es ist nicht klar, ob diese Unterlassung mangels Daten erfolgte und für nicht wichtig erachtet wurde, wie es z.B. das IPCC im AR4 WGI Ch. 5[1] sieht [Bindoff, 2007, #25728] oder ob die ausgewerteten Daten später pauschal einer Korrektur dieser Störgröße unterzogen wurden. Auf Grund der spärlichen historischen Datenbestände, insbesondere von Zeitreihen > 50 Jahre und ihrer Dokumentation (Metadaten) ist wohl mit ziemlicher Sicherheit davon auszugehen, dass diese Daten selten vorlagen und deshalb nicht beurteilt werden konnten. Es ist jedoch erwiesen und physikalisch herleitbar, dass atmosphärischer Hochdruck pro 1 mBar den RSL um ca. 1 cm senkt, Tiefdruck pro 1 mBar um ca. 1 cm anhebt. Aus diesem Grund sind sämtliche modernen Stationen mit Sensoren zur Luftdruckmessung ausgerüstet. Überwiegend werden diese Einflüsse hochfrequenter Natur sein und zu einem unbekannten Teil bei Monats- und Jahresmittelwerten unter den Tisch fallen. Sicher ist das aber nicht. Druckschwankungen von einigen 10 mB innerhalb von Stunden und Tagen bis zu Monaten sind in vielen Klimazonen nichts Ungewöhnliches. D.h. die Pegelangaben aus diesen Breiten enthalten Fehler in der Größenordung von Dezimetern.

4.4.8. Andere Einflussgrößen und grobe Fehler

Von großem, evtl. beherrschendem Einfluss, und dies zeigen die Satellitenmessungen ganz deutlich, sind die Umverteilungen von Wassermassen in allen Ozeanen dieser Welt. Fast übereinstimmend sind die Forscher der Meinung, dass diese Umverteilungen in langjährigen, bis Jahrzehnte dauernden, Schwingungen erfolgen, die man erst seit kurzem genauer bestimmen lernt. Dazu gehören die Variationen der ozeanischen Zirkulationen. So schreiben z.B. Cazenave et. al [Cazenave, 2004] bezüglich ihrer Ergebnisse aus der Satellitenaltimetrie: “….the altimetric rate could still be influenced by decadal variations of sea level unrelated to long-term climate change, such as the Pacific Decadal Oscillation, and thus a longer time series is needed to rule this out.” Und sie erkannten auch, dass eine “non-uniform geographical distribution of sea-level change, with some regions exhibiting trends about 10 times the global mean.”

Bryden et. al [Bryden, 2003] untersuchten diesen Einfluss ebenfalls. In ihrer Studie führten sie aus: „there has been an oscillation in the water mass properties of the upper thermocline waters with freshening from 1965 to 1987 and then an increase in salinity from 1987 to 2002, with the properties observed in 2002 close to those observed in 1936 and 1965.“ Und zusätzlich notierten sie: „there can be substantial oscillations over decadal time scales,“ und dass „without regular observations, oceanographers have little understanding of the scales of variability in water mass properties.“ Klar stellten sie demnach fest, dass die beobachteten jüngsten Änderungen „almost entirely reverses the observed freshening of mode waters from the 1960s to 1987 that has been interpreted to be the result of anthropogenic climate change on the basis of coupled climate models.“

Diese und andere Strömungen verursachen zwar überwiegend, z.T. jedoch weiträumige, lokale RMSL Änderungen, da diese aber zum GMSL zusammen geführt werden müssen, beeinflussen sie das Ergebnis außerordentlich.

Wie überall bei Messungen, besonders über lange Zeiträume, lassen sich auch grobe Fehler nicht ausschließen. Diese werden z.B. durch mangelnde Wartung, verstopfte Zu- oder Abflüsse, fehlende Eintragung etc. hervorgerufen. Auch über die Verstopfung des Zuflusses der Messröhre durch Unrat, wie tote Fische, wurde berichtet. Insgesamt lassen sich diese Fehler aber nicht zuordnen, eine Abschätzung ihrer Größe ist daher nicht möglich.

Beide Einflussgrößen werden in dieser Arbeit daher nicht quantifiziert

4.5. Messergebnisse außerhalb von PGR/GIA beeinflussten Zonen

Verlässt man das Gebiet in dem die PGR/GIA auf der Nordhalbkugel dominiert und untersucht zur Quantifizierung der Veränderung eines globalen Meeresspiegels und seines Trends die Pegeländerungen auf der Südhalbkugel, dann sind die Pegel an den Küsten des, tektonisch relativ stabilen, australischen Kontinents sicherlich eine gute Wahl. Australien wird vom indischen, dem südlichen und dem pazifischen Ozeanen umspült. Es ist lange genug besiedelt, um über lange, hinreichend zuverlässige Messreihen zu verfügen. Die australische National Tidal Facility NTF in Flinders Adelaide hat dazu 1998 die Ergebnisse eines Projektes veröffentlicht, dem „Mean Sea Level Survey“, die nur Daten von Stationen enthält mit mehr als 23 Jahre stündlicher Messung.

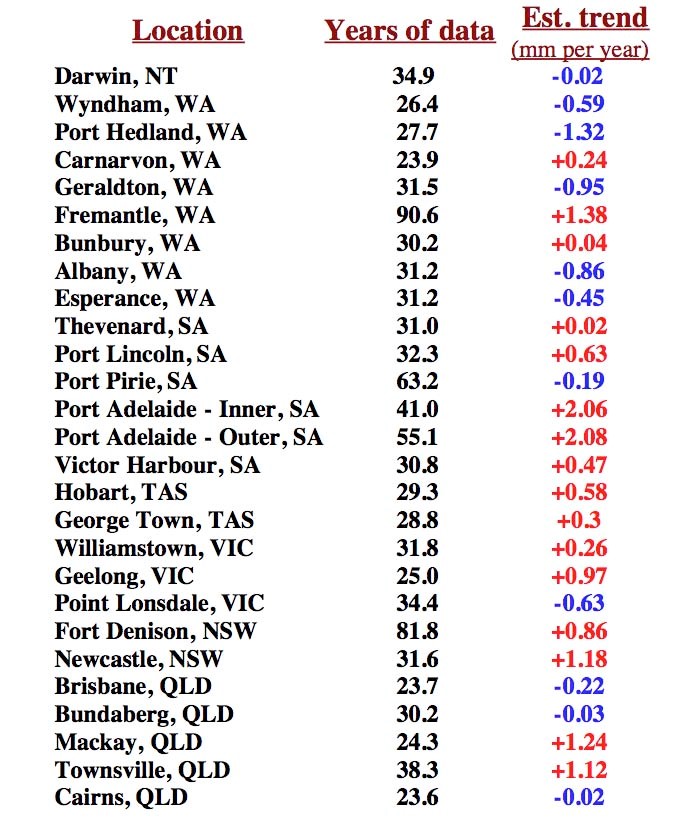

Die folgende Tabelle 12 zeigt die Ergebnisse der für geeignet erachteten Standorte.

Tabelle 12: Ergebnisse der australischen Untersuchung von 1998 über RSL Trends australischer Pegelmessstationen. Rot: positive Trends, blau: negative Trends

Tabelle 12: Ergebnisse der australischen Untersuchung von 1998 über RSL Trends australischer Pegelmessstationen. Rot: positive Trends, blau: negative Trends

Elf der 27 Stationen zeigen negative Trends mit im Mittel -0,48 mm/Jahr. 16 zeigen positive Trends incl. der Stadt Adelaide (mit + 2,06 und + 2,08 mm/Jahr). Gerade an Adelaide lässt sich der deutliche Trend zum Absinken der Stadt festmachen, denn die Messorte in der unmittelbaren Nachbarschaft wie Port Lincoln. Port Pirie und Victor Harbour zeigen entweder wesentlich kleinere Anstiege von nur einem guten Viertel der von Adelaide (Port Lincoln mit +0,63 mm/Jahr) oder einen, wenn auch geringen, negativen Trend. (Port Pirie mit -0,19 mm/Jahr). Trotz dieser Ausreißer von Adelaide beträgt der Mittelwert über alle 27 Stationen nur +0,3 mm/Jahr. Nimmt man Adelaide aus genannten Gründen heraus, dann bleibt für die restlichen 25 Stationen ein Anstieg von nur noch +0,16 mm/Jahr übrig. [Daly, 2000]

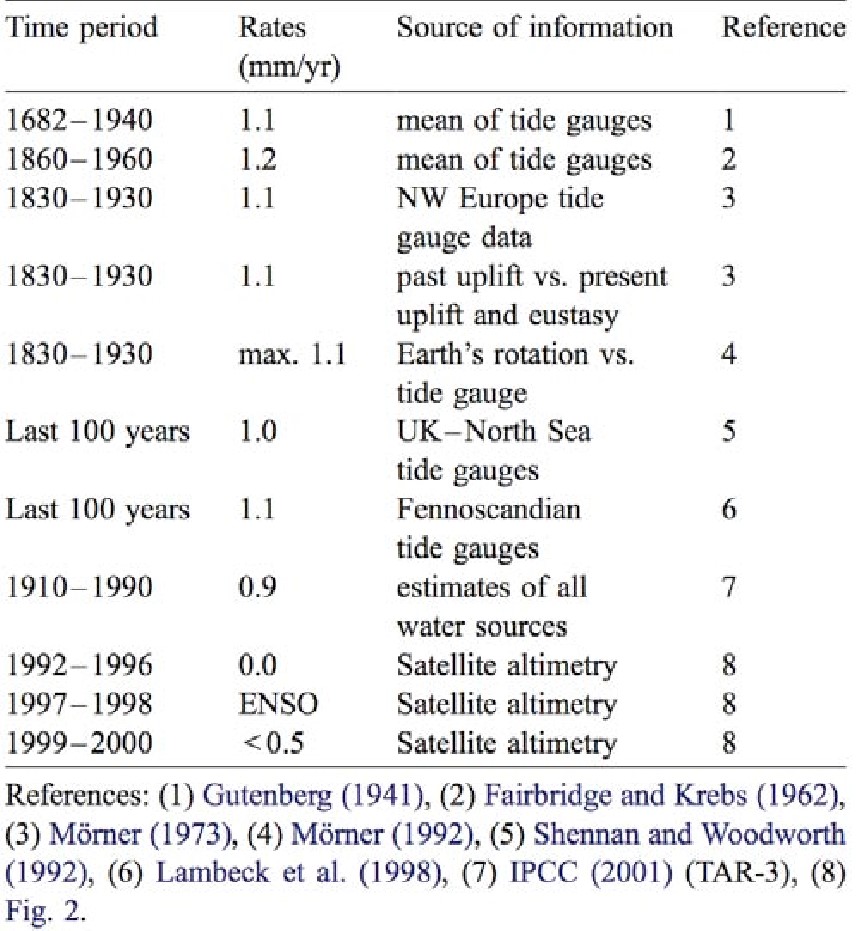

Umfassend und systematisch hat sich auch der ehemalige Präsident der INQA Commission on Sea Level Changes and Coastal Evolution Nils Axel Mörner mit der Frage der Bewertung der verschiedenen Anstiege auseinander gesetzt. In seinem Aufsatz „Estimating future sea level changes from past records“[Mörner, 2004] fasst er die verschiedenen Durchschnittswerte verschiedener Autoren tabellarisch zusammen. Tabelle 13 ist diesem Aufsatz entnommen.

Tabelle 13: Durchschnittlicher Anstieg des GSML nach verschiedenen Beobachtungen und Messmethoden von 1682 bis 2000. Alle Werte der Vergangenheit bis 1990 liegen danach bei ca. 1 mm/Jahr. Dies ist ein bemerkenswert anderes Ergebnis (nur gut 50%) des IPCC Wertes von 1,8 mm/Jahr. Quelle Mörner Seite 51 [Mörner, 2004]

Hervorzuheben ist dabei, dass Mörner diese Werte auf Beobachtungen zurückführt und nicht auf Modelle. Unterstützt wird Mörner durch die Übersicht von Gornitz [Gornitz, 1994], die darin über die bis dahin gefundenen Ergebnisse feststellte, dass alle, bis auf eine Untersuchung, vor 1989 einen Anstieg von weniger als 1,5 mm/Jahr zeigten. Nimmt man die extremen Werte heraus, dann bleiben 12 Papiere übrig, die einen mittleren Anstieg von nur 1,2 mm/Jahr erbrachten.

5 spätere Papiere, lt. Gornitz, ermittelten einen deutlich größeren Anstieg. Nimmt man auch dort wieder den einen Ausreißer heraus, dann ergibt sich ein Mittel von 1,9 mm/Jahr. Das ist ungefähr auch der IPCC Wert. Der Grund dafür ist, dass alle Autoren neuerer Papiere ihre Daten explizit nach dem ICE-3G Modell von Tushingham & Peltier zur Korrektur des PGR korrigiert hatten und real alle Berechnungen von Tushingham & Peltier ausführen ließen[2]. Ein Modell, das nicht nur zu dieser Zeit bereits sehr umstritten war, sondern heute als überholt [Milne, 2002] angesehen wird, weil es u.a. lt. Milne et. al. auf einer falschen „Sea Level Theory“ basiert und wichtige Einflussgrößen entweder gar nicht oder falsch berücksichtigte. Auf dieses ICE-3G Korrekturmodell und seine Nachfolger wird später noch einmal ausführlicher eingegangen. Interessant ist in diesem Zusammenhang auch, wie Douglas berichtet [Douglas, 1994], dass alle o.a. Autoren ihre Daten vom PMSL bezogen hätten, die ermittelten Unterschiede also nur von den Autoren und ihren Annahmen abhingen, jedoch nicht von den ihnen zugrunde liegenden Daten.

4.6. Die Zusammenfügung relativer Sea Level Änderungen zu globalen Änderungen

Ein Grundproblem aller Mittelwertbildungen ist, dass man normalerweise konsistente Datenreihen haben sollte, die in der Aufzeichnungsperiode und – dauer, der Art der Messmittel, deren Messfolge und –Genauigkeit weitestgehend übereinstimmen sollten. Es sei daran erinnert, dass z.B. die Wahl der Zeitperiode nicht nur darüber entscheiden kann, wie hoch der Anstieg (oder Abfall) war, sondern auch, welche Richtung dieser hatte; positiv oder negativ. Diese Grundvoraussetzung ist jedoch bei den Pegelmessdaten noch weniger gegeben als bei den Temperaturmessdaten. Man behilft sich deshalb mit einigen z.T. plausiblen, z.T aus der Not geborenen Hilfskonstruktionen die Jevereva et. al [Jevrejeva, 2006] so beschreiben (Hervorhebungen vom Autor):

There is no common reference level for the tide gauge records and this provides a problem when stacking records that do not cover the same time periods. One way overcome this problem is to calculate the rate of change in sea level for each station and stack the rates [Barnett, 1984]. However, many stations have historically only been measured for some months of the year and an annual cycle in sea level could therefore lead to severe bias. To maximize data usage, we calculate the mean annual rate for a given month over a whole year (e.g., the rate in January is calculated as the July to July difference). Using this method removes all systematic sub-annual signals from the data. Data gaps shorter than one year in the final rate series are filled by interpolation.

Der aus diesen Verlegenheitslösungen resultierende systematische Fehler wird mit 2-3 mm/Jahr von 1800 bis 1900 und 1 mm/Jahr für das 20. Jahrhundert angegeben[3]. Also Fehler von ganzer bis halber Größe des geschätzten Anstieges.

Es ist muss jedoch klar sein, dass alle Berechnungen, die auf solchen Hilfskonstruktionen beruhen, mit größter Vorsicht zu verwenden sind. Deswegen wohl auch die nüchterne Schlussfolgerungen: We have shown that the development of global sea level rise is highly dependent on the time period chosen and the global sea level rise occurred during the period from 1920 to 1945 is comparable with present-day rate of sea level rise.

Und

….However, our results show that global sea level rise is irregular and varies greatly over time, it is apparent that rates in the 1920 – 1945 period are likely to be as large as today’s. Nevertheless, considerable uncertainties remain. [Jevrejeva, 2006]

Ergänzung: Diese Hinweise von Jevereva et al plus die neueren Erkenntnisse von W. Eisenkopf zur „Genauigkeit“ (in Teil 1 hier) von Satellitenmessungen, lassen nur den Schluss zu, dass ausschließlich die Daten, die durch Pegelmessungen vor Ort, über lange Zeiträume von > 50 Jahren durchgeführt, und auch nur die in jüngerer Zeit, wo bspw. die barometrische Kompensation durchgeführt wurde, sich überhaupt eigenen relative Meeresspiegel (RSL) Messung zu gewinnen, diese zu vergleichen und daraus dann irgendwelche Schlüsse zu ziehen. Sie lassen aber vor allem den Schluss zu, dass der globale Meeresspiegel (GMSL), so wie er sich in den Köpfen von manchen Wissenschaftlern manifestiert hat, nicht existiert. Es gibt ihn nicht, so sehr viele daran festhalten. Was es gibt, sind die sehr wenigen lokale RSL Messungen, die – über genügende lange Zeiträume erstellt- zulassen, dass daraus bestimmte Schlüsse gezogen werden können. Eine von der mittleren Welttemperatur abhängige Zunahme ist nicht darunter, vielleicht auch deshalb, weil sie in ihrer Wirkung dermassen gering ist, dass sie im Bereich des Rauschens verschwindet, doch vielleicht auch nicht mal das.

4.7. Die Ermittlung von Beschleunigungen im Trend

Wie oben bereits erwähnt, meint das IPCC und einige seiner Autoren sogar eine kräftige Beschleunigung des Anstiegs des GMSL seit Mitte der 90 er Jahre ausgemacht zu haben (Nerem, Church, Cazenave). In einem kurzen Artikel fassten Rahmstorf et. al. [Rahmstorf, 2007c] die jüngsten Ergebnisse der genannten Autoren, und dazu ihre eigenen, zusammen und verglichen sie mit den Vorhersagen des IPCC. Dabei stellen sie fest, dass der jüngste Anstieg des GMSL mit 3,3 mm/Jahr ± 0,4 mm höher sei als vom IPCC vorhergesagt. Sie beziehen sich dabei auf die Satellitenmessungen, deren Zuverlässigkeit und Ergebnisse weiter vorn bereits kritisch beleuchtet wurden. Weiter stellten Rahmstorf et. al. fest, dass der so ermittelte Anstieg über die letzten 20 Jahre um 25 % höher sei, als in jeder anderen 20 jährigen Periode der letzten 115 Jahre. Diesen Anstieg wertet man als Folge der starken globalen Erwärmung der letzten Jahrzehnte.

Levitus et al. [Levitus, 2000] erwähnen sogar einen Anstieg der ca. 6 mal größer wäre als der Mittelwert der davor liegenden 4 Dekaden. Das bedeute, so schreiben sie “an acceleration took place in the recent past, likely related to warming of the world ocean.” Jedoch, so führen sie weiter aus “the recent rise may just correspond to the rising branch of a decadal oscillation.” Und zusätzlich stellen sie fest “satellite altimetry and in situ temperature data have their own uncertainties and it is still difficult to affirm with certainty that sea-level rise is indeed accelerating.” Sie zitierten dazu auch die Arbeit von Nerem and Mitchum [Nerem, 2001], die fordert, dass “about 20 years of satellite altimetry data would be necessary to detect, with these data alone, any acceleration in sea-level rise.” Diese Anforderung erfüllt jedoch keine der Arbeiten, die eine Beschleunigung feststellten.

Der Beobachtung einer besonders hohen Beschleunigung steht gegenüber, dass z.B. Jevrejeva et al [Jevrejeva, 2006] ermittelten, dass bereits von 1920-1950 ein Anstieg von 3-5 mm/Jahr beobachtet wurde. Eine Phase, die sowohl einen kräftigen globalen Temperaturanstieg, aber auch etwas später einen etwas weniger kräftigen Temperaturabfall kannte. Für den Zeitraum von 1993 bis 2000 errechnen sie einen Anstieg von (nur) 2,4 mm/Jahr. Siehe auch Abbildung 59.

Abbildung 59: Anstieg und Beschleunigung des GMSL nach Jevreva et. al. [Jevrejeva, 2006], diesmal die vollständige darstellung incl. des vermuteten Trends. Dieser ist dananch seit ca. 1870 ziemlich konstant um die 2 mm/Jahr. Eine Bescchleunigung in der letzen Dekade ist nicht zu erkennen.

Abbildung 59: Anstieg und Beschleunigung des GMSL nach Jevreva et. al. [Jevrejeva, 2006], diesmal die vollständige darstellung incl. des vermuteten Trends. Dieser ist dananch seit ca. 1870 ziemlich konstant um die 2 mm/Jahr. Eine Bescchleunigung in der letzen Dekade ist nicht zu erkennen.

Mörner [Mörner, 2004] kommt durch die Untersuchung sowohl von Satellitendaten als auch von Pegelmessungen zu dem Schluss, dass in den 90 Jahren überhaupt kein Anstieg, mithin auch keine Beschleunigung, sichtbar geworden seien.

Wer nun richtig liegt, mag sich der Leser aussuchen. Es bleibt die Frage, wie Rahmstorf und Kollegen auf ihre spektakuläre Aussage kommen? Dies ist nicht recht ersichtlich. Es wäre allerdings nicht das erste Mal, dass das Potsdam Institut für Klimafolgenforschung PIK, die akademische Heimat von Rahmstorf, durch spektakuläre Ergebnisse auf sich aufmerksam macht.

4.8. Korrekturversuche von bekannten Einflussgrößen

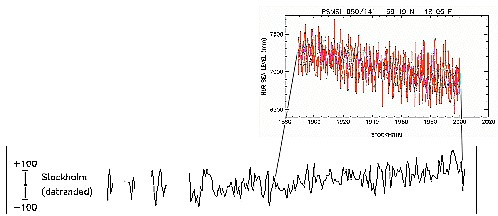

Wie zuvor beschrieben, wurden die früheren Daten von Pegelmessstationen durchgängig der Korrektur durch das ICE – 3 G Modell von Peltier & Tushingham unterworfen. Das brachte fast eine Verdopplung des als real angesehenen GMSL. Damit sollten die GIA/PGR Einflüsse kompensiert werden. Die Schätzungen erhöhten sich dadurch von ca. 1,1 bis 1,2 mm/Jahr auf 1,9 bis 2 mm/Jahr. Ein besonders markantes Beispiel dieser Korrektur zeigt der Trend von Stockholm, der nun statt wie zuvor beobachtet negativ, plötzlich deutlich positiv wurde wie die folgende Abbildung 60 zeigt.

Abbildung 60: Darstellung der RSL Daten von Stockholm aus der PMSL Datenbank und der „detrended“ Korrektur nach dem ICE-3G Modell von Tushingham & Peltier. Diese Grafik wurde aus Fig. 6 des TAR Technical Summary heraus kopiert, deswegen ist keine Zeitskala zu sehen. Links beginnt die Aufzeichnung bei 1770 und endet 1995 rechts. Die y-Achse zeigt ± 100 mm. Die PMSL Daten entsprechen also etwa der Hälfte der Aufzeichnung. Quelle: http://www.grida.no/publications/other/ipcc%5Ftar/?src=/climate/IPCC_tar/vol4/english/083.htm Das zur Korrektur verwendete ICE – 3G Modell war danach heftiger Kritik unterworfen und wurde inzwischen als überholt bezeichnet. Die wichtigsten Kritikpunkte hat Daly [Daly, 2000] zusammengefasst. Im Folgenden wird daraus zitiert.

- Das Modell versucht die Plastizität des oberen Erdmantels auf dem die Lithosphäre schwimmt auf lokaler Basis nachzubilden, um daraus die GIA/PGR- freie Verformung zu generieren. Es berechnet dazu wie sich die Eismassen durch Schmelzen auflösten und wie sich die darunter liegende Lithosphäre den Masse- und Gewichtsverlust isostatisch anpasste.

- Das Modell unterstellt, dass die Oberfläche der Ozeane sich durch den Zufluss an Wasser aus dem Eis nicht verändert hätte. Eine Annahme die offensichtlich falsch und weltfremd ist. Die Autoren gaben dies auch zu, aber glaubten dass dieser Effekt zu klein sei, um eine Wirkung zu haben.

- Das Modell unterstellt, dass Asthenosphäre und Lithosphäre sich vor dem Abschmelzen des Eises im isostatischen Gleichgewicht befanden. Auch diese Annahme ist mit Sicherheit falsch, weil bekannt ist, dass die Eiszeit selbst eine sehr dynamische, geologische Periode war.

- Das Modell wurde mit den Daten von 192 RSL Stationen kalibriert. 169 davon lagen im atlantischen Becken incl. der Arktis. Nur 18 lagen im pazifischen Ozean, die meisten davon waren von der tektonisch aktiven Westküste der USA. Nur 5 Stationen lagen im südlichen Atlantik, im indischen und südlichen Ozean. Diese stellen immer nahezu 2/3 der gesamten Wasserfläche der Welt dar.

- Das Modell benötigt einen manuellen Eingriff. Immer dann wenn die Werte zwischen beobachteten RSL Daten und Modellresultaten zu unterschiedlich waren, wurde per Hand dafür gesorgt, dass die Eisfläche dicker wurde, oder das Abschmelzen wurde verzögert.

- Das Modell sagte einen Anstieg des GMSL von 115 m während der Entgletscherung voraus, aber die Beobachtungsdaten zeigen einen solchen von 120-130 m. Der Unterschied wurde von Peltier & Tushingham „fehlendem Eis“ zugeschrieben, in Regionen, von denen man annahm, dass sie eisfrei geblieben seien, obwohl dort sehr wohl Eis gewesen sein könnte.

Mithin wird deutlich, dass dieses Modell kein Abbild der ganzen Welt war, sondern nur ein sehr grobes Abbild des Nordatlantischen Beckens. Es war allerdings auch nicht geeignet, genaue Berechnungen selbst in diesem Becken zu machen, und noch weniger für alle anderen Ozeane. Insbesondere deswegen, wenn man den Mangel an Kalibrierungsdaten für die großen Ozeane berücksichtigt. Unterstützt wird diese Kritik von Daly durch Studien von Davis et. al [Davis, 1996] und von Milne et. al [Milne, 2002]. Davis fand für die südöstlichen Seegebiete der USA (von Keywest zu Cape Hatteras), dass das Modell den GMSL Anstieg dort, auf Grund fehlerhafter angenommener Viskosität, um fast den Faktor 2 überschätzte. Man reduzierte deshalb dort den Wert von 2,28 mm/Jahr auf 1,45 mm/Jahr. Für die anderen 4 Ozeane dürfte dieses Modell wohl überhaupt nicht zu gebrauchen sein, u.a auch deswegen, weil es keinerlei Vorkehrungen darüber enthält, wie der sog. „Ring of Fire“[4] zu bewerten ist, ebenso wenig wie das Absinkverhalten von großen Städten etc.

Peltier hat seither das Modell ICE 3 G weiterentwickelt. Im Kapitel 4 „Global Glacial Isostatic Adjustment and Modern Instrumental Records of Relative Sea Level History“ des Buches [Peltier, 2001] „Sea Level Rise“ mit Douglas et. als Herausgeber, beschreibt er detailliert die Verbesserungen des Modells ICE 4G VM2(Viscosity 2) gegenüber der bisherigen Version. Auf die oben zitierte Kritik geht Peltier dabei nicht ein. Es ist deswegen unbekannt, ob sie im neuen Modell berücksichtigt wurde oder nicht. Diese Arbeit wird auch des Öfteren im Chapter 5 des AR4 WGI über den Meeresspiegel zitiert. Bemerkenswert ist, dass auch nach der neuen Korrektur des GIA/PGR Effektes der Anstieg des GMSL wieder mit ca. 1,9 mm/Jahr beziffert wird. Demselben Wert den auch die früheren Korrekturen ergaben. Das kann nur bedeuten, dass die bisherigen Modellannahmen nach Meinung der Autoren hinreichend korrekt waren, oder dass den neuen Annahmen andere Vermutungen zugrunde liegen, die aber zum gleichen Ergebnis führen. Mörner [Mörner, 2005] hat dies überprüft und dazu 2005 den Aufsatz „ Sea level changes and crustal movements with special reference to the Eastern Mediterranean.„ [Mörner, 2005] veröffentlicht. Darin zeigt er, dass die Grundannahme dieses Modells, nämlich eine lineare Viskosität über der gesamten Manteltiefe, falsch ist. Im Fernbereich, also dem Gebiet des pazifischen und indischen Ozeans, stieg der Meeresspiegel nach den Beobachtungen aber nicht an, was er nach den Modellannahmen z.B. durch Zuflüsse aus der Antarktis hätte tun müssen. Im Nahbereich, er erwähnt die Fennoskandinavische Eiskappe, ist man sich überdies seit langem sehr sicher, dass es dort auch Zonen mit niedriger Viskosität gibt. Dies führt dazu, dass die Modellannahmen zu unrealistischen Korrekturen führen. Sie werden durch Beobachtungen z.B. im Mittelmeerraum nicht bestätigt. Diese Ansicht wird durch die Arbeiten verschiedener Autoren unterstützt, die Milne et al [Milne, 2002] im Detail anführt. Deshalb ergibt das Modell von Peltier auch im Nahbereich lt. Mörner häufig unkorrekte Werte.

Neben dem ICE 4G Modell gibt es noch eine Anzahl weiterer Korrektur-Modelle, die auch von Milne angeführt werden. Sein Interesse gilt dem Verhalten dieser Modelle im Fernbereich, dessen Messwerte keinen wesentlichen Anstieg des RSL erkennen lassen. Peltier selber verteidigt sein Modell, mit dem Hinweis, dass es gut die Verhältnisse an den meisten Küsten der USA wiedergibt. Er glaubt deshalb, dass auch die thermische Expansion weltweit, statt wie vom IPCC angegeben bei 0,4 mm/Jahr, bei 0,6 ± 0,2 mm/Jahr angesetzt werden müsse.

Wird fortgesetzt.

Dieses ist ein Teil der Dissertation vom Autor, welche die Universität – nach Gerichtsentscheidung vom September 2011 als nicht eingereicht betrachtet hatte. Teil 3 finden Sie hier

- Zitat IPCC p. 408….some oceanographic factors (e.g., changes in ocean circulation or atmospheric pressure) also affect sea level at the regional scale, while contributing negligibly to changes in the global mean. ↑

- Details dazu hier: http://www.agu.org/revgeophys/dougla01/node3.html ↑

- : Our results show that error can be reduced with substantial increase of number of tide gauge records; for example, for the period 1800 – 1900 the errors are 2 – 3 mm/yr, compare to 1 mm/yr during 20th century. ↑

- Mit „Ring of Fire“ wird eine ca. 40.000 km lange Zone im pazifischen Becken bezeichnet, die , wie ein Hufeisen geformt, ungefähr 450 Vulkane enthält. Es ist dazu ein Gebiet von 90 % der beobachteten Erdbeben ↑