Waren die Fluten vom 16. September erste Folgen der CO₂-Vermeidung?

Helmut Kuntz

Auf eine solche Fragestellung kann man kommen, wenn man sich die in Windeseile dazu erstellte Eilanalyse ansieht [1] [2]. Wie nicht anders zu erwarten, kommt diese zu dem unvermeidbaren Schluss: „Einer Schnellanalyse zufolge hatte der Klimawandel wahrscheinlich großen Anteil an der aktuellen Starkregenepisode in Mitteleuropa. Die natürliche Klimavariabilität allein könne die Intensität des beobachteten Ereignisses nicht erklären“.

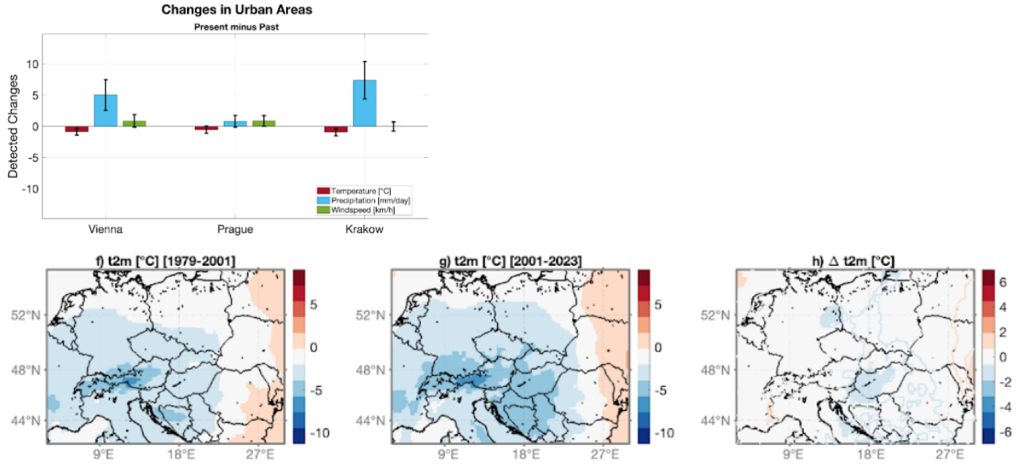

Allerdings sieht man in der Studie, dass sich die Temperatur im Vergleichszeitraum gegenüber früher verringert hat. Was zu der Frage berechtigt, warum dann gerade dieses Ereignis klimawandelbedingt verstärkt sein soll. Natürlich steht das als Aussage so nicht drin, denn das verklausuliert man mit der Darstellung: „Kein gesichertes Ergebnis. Die Unsicherheit sei bei dieser Schlussfolgerung allerdings recht groß, da es sich um ein ungewöhnliches Ereignis handele.“

Wie hat der brave, ordentliche, Ampel-bejahende Bürger die jüngsten Flutereignisse einzuordnen?

Die Redaktion der Nordbayerischen Nachrichten hat inzwischen die Nachfolge der „Alpenprawda“ angetreten und legt anscheinend gesteigerten Wert darauf, wie diese es bereits geschafft hat, auch viele ihrer Leser mit penetranter, GRÜN-Linker Dauerpropaganda zu vergraulen.

Und so sagte sie es ihren Lesern wieder in einem Leitkommentar „Wieder eine Jahrhundertflut? Naturkatastrophen: Viele Politiker schauen weg“ (Zitierungen aus einer lokalen Printausgabe vom 16.Sept.):

Gleich zu Beginn kommt die Kernaussage: „… Starkregen ist das neue Normal“.

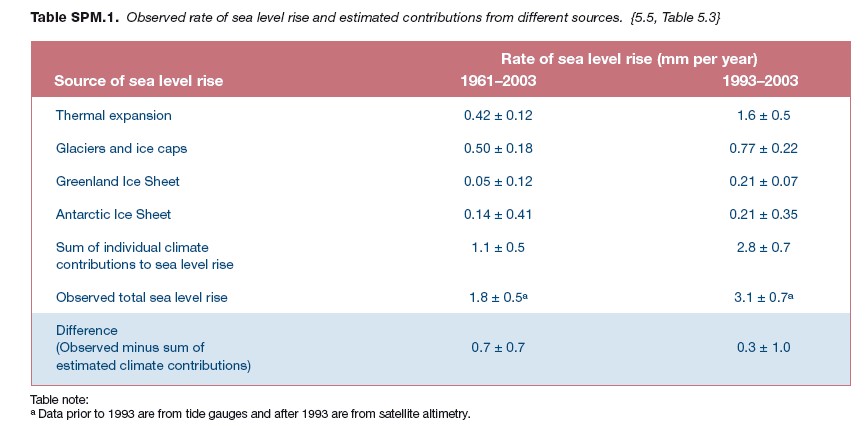

Und wenn man schon dabei ist, darf „das Übliche“ nicht fehlen: „ … steigende Meerespegel und irgendwelche Atolle im Pazifik, die im Ozean verschwinden können … “

Und nun die Warnung dazu: „ … Machen wir beim Klimaschutz weiter, wird es bald zu spät sein, eine globale Katastrophe zu verhindern … “

Selbst der Weltraumschrott muss nun als Menetekel herhalten: „ … Wie der Weltraumschrott, der sich im All ansammelt und uns alle besorgen müsste … offenbar ist es allzu menschlich, die Augen vor Gefahr zu verschließen … “

Nun kommt die Erklärung: „ … Machen wir beim Klimaschutz so weiter, wird es bald zu spät sein, eine globale Katastrophe zu verhindern … Die Klimawandel-Leugner, eine Ansammlung von Menschen, denen nicht zu helfen ist. Hier lohnt kein Energieeinsatz.

Inzwischen gibt es eine Abstufung der Klimawandel-Leugner die man neu lernen muss, da nun auch Pragmatiker – früher eine positive Notation – nun negativ konnotiert ist: Spannender ist die zweite, immer größer werdende Bewegung, nennen wir sie die politischen Pragmatiker … Es sind Politiker, die wahlweise unter Verdrängung wissenschaftlicher Erkenntnisse, aus Verzweiflung, weil sie radikale Maßnahmen nicht umsetzen wollen, oder aus Angst, ihr Mandat und somit ihre Macht zu verlieren – der Bevölkerung vorgaukeln, dass eine gemäßigte Klimapolitik ausreichen könnte, um das Schlimmste zu verhindern … “

Wie immer unvermeidbar kommt dann ein großes Lob auf die Ampelpolitik und vor allem der GRÜNen: „ … Im politischen Alltag findet die Wirkungsmacht dieser über Parteigrenzen vereinten Akteure im Grünen-Bashing Ausdruck … “

Was in der Darstellung über die Leistung der GRÜNen gipfelt: „ …wer den Wählern gegenüber ehrlich bleiben möchte, sollte radikalere, umweltpolitische Ansätze nicht länger durch den Kakao ziehen, sondern als alternativlos anerkennen. Ansonsten droht die Gefahr, dass unsere Kinder und Enkel in einer der nächsten Jahrhundertfluten ertrinken.“

Zu diesem Redaktionskommentar bekam die Redaktion vom Autor eine kritische Gegendarstellung, welche Anlass und Basis dieses Artikels ist. Ob die NN-Redaktion so etwas liest, nachdem der Autor zu dem Typus „bekennender „Klimawandel-Leugner“, dem laut Redaktion ja „nicht zu helfen ist“ gehört, sei dahingestellt. Aber man muss den Nachkommen zeigen, dass es damals auch Bürger gab, denen das Gehirn trotz aller Bemühungen und Drohungen nicht vollkommen GRÜN-Links ausgepustet werden konnte.

Kritik

Es lässt sich anhand der weltweiten Pegelmessungen recht leicht zeigen, dass der Meerespegel überhaupt nicht übernatürlich steigt, wie auch noch kein Atoll wegen dem Klima untergegangen ist, oder auch nur daran denkt, unterzugehen. Selbst eine entsprechende Aussage eines Klimawandel-bedingten Inseluntergangs in einem „Klimafachbuch“ von Herrn Schellnhuber lässt sich als (bisher nicht korrigierte) Falschaussage recherchieren (was der Autor gemacht hat).

Wenn Herr Habeck – laut Redaktion eine der intellektuellsten Personen der Ampel, weil er so gut Märchen erzählen kann – nun sagt (Berliner Morgenpost, 17.09.2024):

… Drittens sollten wir uns klar sein, was die Ursache ist: Immer häufigere Hochwasser, Katastrophen wie im Ahrtal, dieses Jahr in Bayern – sie sind eine Folge der Klimakrise. Daher sind unsere Anstrengungen so wichtig, die Klimakrise einzudämmen – der schnellere Ausbau der Erneuerbaren, die Wärmewende, eine klimafreundliche Produktion in der Industrie …

Dann sagt er ganz einfach nicht die Wahrheit, neben dem, dass er dazu nichts als den üblichen Unsinn wiederkäut.

Die von Habeck als Klimamenetekel angesprochene Ahrtalflut war, wie es die historische Fluthistorie und die Daten der dazu vom DWD verfassten Attributionsstudie eindeutig belegen, eben nicht ein Ereignis des Klimawandels, sondern eine Offenbarung allerschlimmsten und langen Behördenversagens.

Doch obwohl nun drei vergleichbare Fluten in den letzten 200 Jahren auftraten, wird in einer Atttributionsstudie dank ganz genau rechnender Computer eine mittlere Wiederholwahrscheinlichkeit von 15.000 Jahren errechnet:

[7] The best estimate of the return period of this event is so large, i.e. in the order of 1 in 15000 y – much larger than the length of the time series – that we cannot give a precise value ….

Andere Studien kommen auf 500 Jahre. Soweit zur statistischen (Un-)Genauigkeit für solche Ereignisse.

Die Rekonstruktion der Abflussmenge ist eine moderne „Kriminalgeschichte“. Die Messstation wurde 2021 (im Behördenchaos unbemerkt) von der Flut weggerissen, so dass die Abflussmenge rekonstruiert werden muss. Zudem ist nicht eindeutig, welche Angaben Peak- und welche Tagesmittelwerte sind. So ergeben sich eklatant unterschiedliche Flutmengenangaben:

Und so kommt beispielsweise ein Dr. Thomas Roggenkamp Geographisches Institut Universität Bonn zu dem Schluss:

[9] … Rekonstruktion Historischer Hochwasser zeigt, dass 2021 kein einmaliges Ereignis war.

„Merkel“ hat damals bei einer Besichtigung vor Ort jedoch entschieden, dass es anders sein muss. Seitdem gilt deren Bewertung als unbezweifelbare Aussage.

Zu den jüngsten Fluten von Tschechien bis Niederösterreich

Diese sind (für die Betroffenen) schlimm. Aber sie sind kein Beleg des ominösen Klimawandels. Denn, als es kälter war, gab es sie ebenfalls und oft schlimmer.

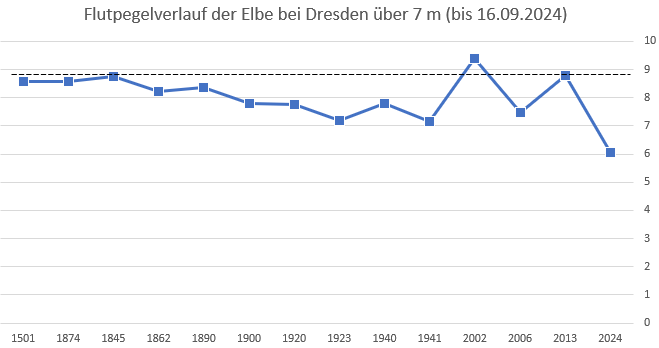

Anbei die höchsten Flutpegel der Elbe bei Dresden von 1501 bis einschließlich dem vom 18.09.2024, der den Niederschlag des aktuell schlimm betroffenen Tschechien mit repräsentiert. Wer daran einen schlimmen Einfluss des sich stetig wandelnden Klimas sehen kann, glaubt auch, dass ein Habeck etwas anderes als Märchen erzählen kann (um nicht immer den Zitronenfalter negativ zu zitieren).

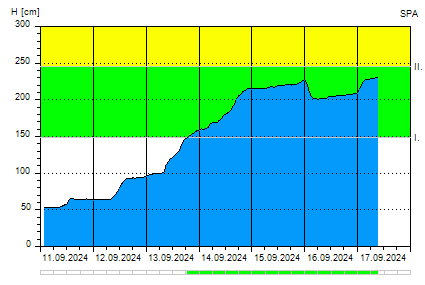

Im ebenfalls schlimm betroffenen Prag (RHEINISCHE POST):

erreicht der Moldaupegel gerade einmal die Meldestufe 2 (Grün, unter 245 cm), während frühere Pegel und die höchste Meldestufe bei 601 cm beginnen.

Das als „Jahrhundertflut“ zu bezeichnen, wie es die RHEINISCHE POST macht, gelingt nur durch bewusstes Weglassen aller historischen Daten:

… Die Prager Altstadt wurde seit ihrer Gründung im 14. Jahrhundert des öfteren einer Überflutungsgefahr ausgesetzt. 1342 riss der Fluss die Judith-Brücke hinweg, die an der Stelle der heutigen Karlsbrücke stand. 1496 und 1784 beschädigte das Hochwasser wiederholt u.a. auch die Karlsbrücke. 1845 vernichtete die Moldau Mittelböhmen und Prag – der wilde Fluss erreichte damals unter der Karlsbrücke die Breite von einem Kilometer. Große Flutwellen haben Prag auch 1862 und 1872 heimgesucht.

Die bisher letzte Jahrhundertflut brach im Jahre 1890 nach Prag ein und forderte einige Dutzend Menschenleben. Es stürzten damals sieben Pfeiler der Karlsbrücke ein und das Wasser reichte bis auf den Altstädter Ring.

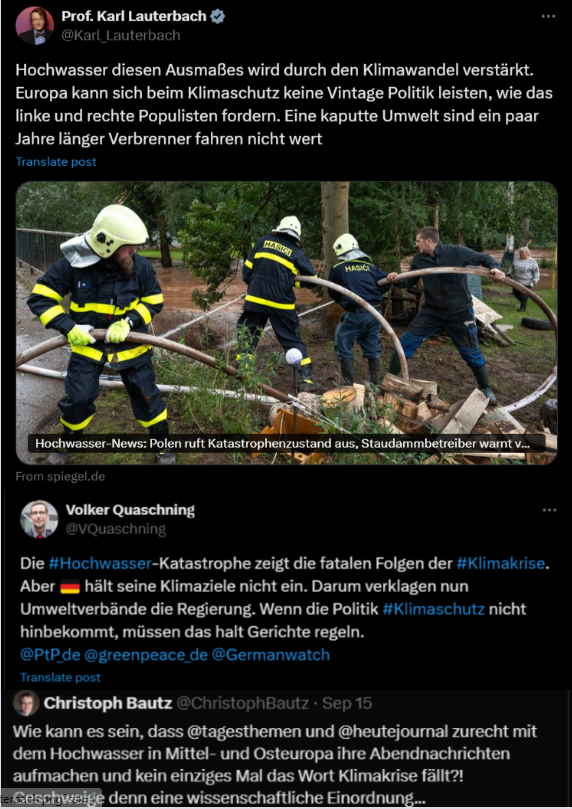

Die üblichen Fachpersonen, unter anderem unser Minister für Gesundheit, der nicht einmal Temperaturangaben richtig interpretieren kann, sind sich allerdings einig:

Die Schnellanalyse von Climameter

Natürlich gibt es auch Wissenschaftler (die sich durch Liefern „gewünschter“ Studienergebnisse finanzieren).

Und da solche inzwischen immer schneller arbeiten – also simulieren können -, erschien schon am 16.09. von solchen eine „Schnellanalyse“ (am 19.9. modifiziert) zu den aktuellen Flutereignissen mit der unvermeidbaren Aussage:

(dpa, 16.09.2024): … Einer Schnellanalyse zufolge hatte der Klimawandel wahrscheinlich großen Anteil an der aktuellen Starkregenepisode in Mitteleuropa. Die natürliche Klimavariabilität allein könne die Intensität des beobachteten Ereignisses nicht erklären, teilte das Forschungskonsortium Climameter mit.

Weil es so schnell gehen musste, ist die Aussage verständlicherweise recht ungenau:

(Schnellanalyse): „ … Die Unsicherheit sei bei dieser Schlussfolgerung allerdings recht groß, da es sich um ein ungewöhnliches Ereignis handele … “

Und wohl mangels Zeit konnten auch nur zwei 20jahres-Zeiträume verglichen werden:

(Schnellanalyse): „… nutzt Daten zu ähnlichen Tiefdrucksystemen von Gegenwart (2001-2023) und Vergangenheit (1979-2001) in der Region ...“

Obwohl bei Extremniederschlag selbst 100jahreszeiträume nicht für Trendaussagen ausreichen.

Sieht man in die Studie [3], kommt man ins Grübeln.

Einmal werden wieder nur kurze Zeiträume – hier 1979 – 2001/2001 -2023 – verglichen, was bei Distributionsstudien aber üblich ist.

Die einzige dem Autor dazu einfallende Erklärung bleibt und ist die, dass beim Erweitern der Zeiträume das gewünschte Ergebnis nicht erzielt werden kann.

Aber das Besondere in der Studie ist, dass es im beobachteten Großraum der Studie in den Vergleichszeiträumen gar nicht wärmer wurde, wie es Grafiken in der Studie zeigen:

Alleine das konterkariert die „Aussage“ der Studie, das zunehmende Wärme – also fortschreitender Klimawandel – alleinige Hauptursache sein kann.

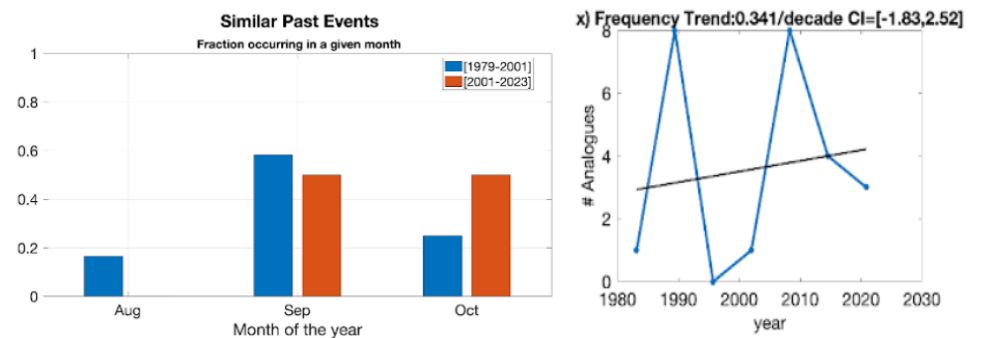

Etwas komisch ist die folgende Darstellung daraus. Derzeit haben wir noch September, sodass der Oktober noch gar nicht wirklich bewertet werden kann.

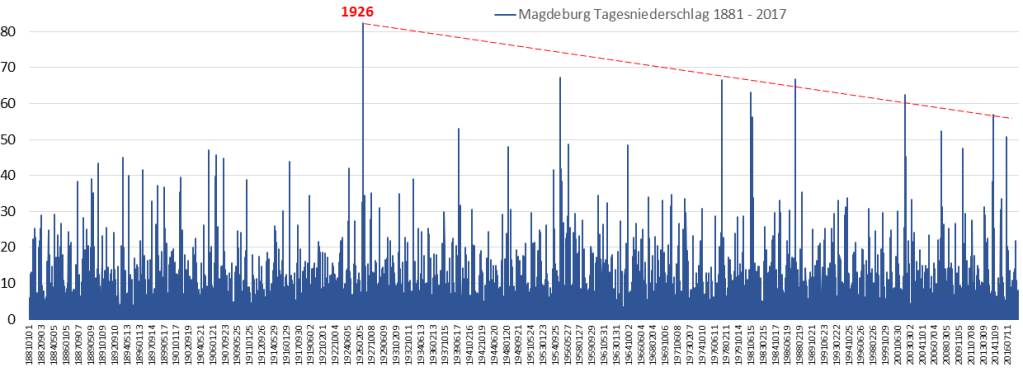

Und für den September zeigt die Grafik, dass das aktuelle Septemberereignis nicht zu den Schlimmsten gehört. Die Zyklik zeigt eindeutig, dass es sich um nichts wirklich Besonderes handelt, sondern sich gut in die (kurze) Historie einordnet. Mit unerschütterlicher Sturheit wird im Bild „x)“ eine Regressionsgerade zugefügt, obwohl sofort erkennbar ist, dass eine solche bei der offensichtlichen Periodizität unmöglich repräsentativ sein kann:

Zur genaueren Analyse benötigt man allerdings die Scatterdiagramme, welche den Zusammenhang zwischen Extremniederschlag und Temperatur zeigen. Normalerweise sind diese in Attributionsstudien enthalten.

Um für diese Publikation sorgfältiger analysieren zu können, hat der Autor bei ClimaMeter zu diesen fehlenden Diagrammen nachgefragt.

Antwort: solche gibt es nicht, das was in der Studie steht, sei alles an Daten!

Soviel zur Qualität und verhinderter Nachvollziehbarkeit heutiger „Schnellstudien“.

Für Klimahysterie-Gläubige ist das wohl ausreichend. Für den Autor als „Klimaleugner“, ein (weiterer) Beleg, dass eine sorgfältig durchgeführte Analyse wohl ein anderes Ergebnis gebracht hätte, wie es eine andere Studie parallel auch ermittelte [6].

In die Klimavergangenheit darf nicht mehr geschaut werden, weil dann eventuell das gängige Klimahysterie-Narrativ zusammenbricht

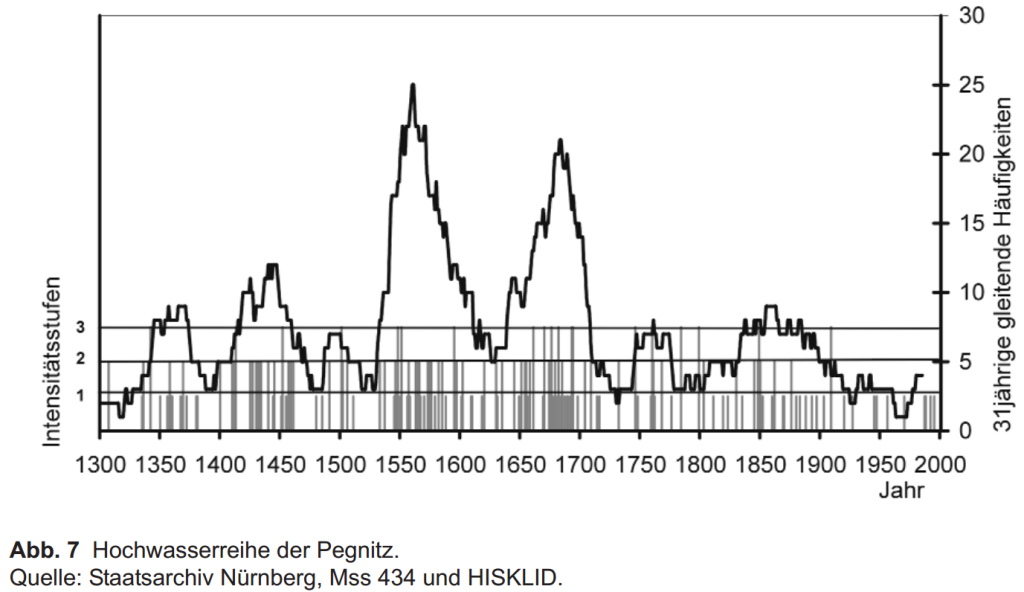

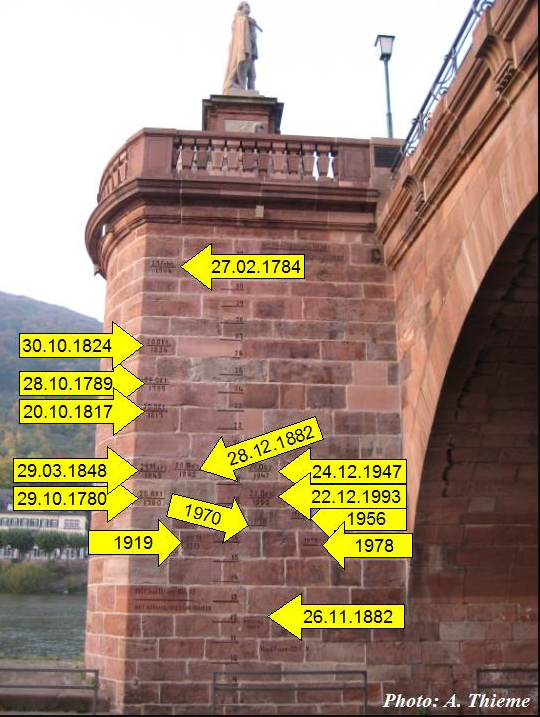

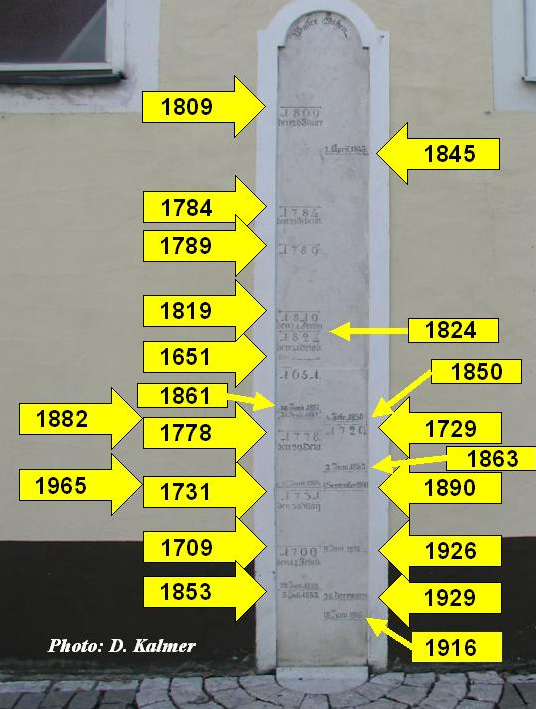

Der Autor ist nach wie vor der Überzeugung, dass die (angeblich), ausschließlich nur schlimmen Auswirkungen des ominösen Klimawandels nur im historischen Kontext (Bilder 2; 6; 7 und die Bilder zu Fluthistorien) richtig bewertet werden können.

Das führt gegenüber der „erlaubten“, alleine auf (ungenauen, extrem voneinander abweichenden) Klimasimulationen basierenden Klimazukunft natürlich zu erheblich abweichenden Aussagen.

Wie zu erwarten war, fiel dies auch der (Pseudo-)Klimaforschung auf und so errichtete sie dagegen eine „Begründungsmauer“:

[4] Correctiv, 09. Februar 2024: Faktencheck Hochwasser: Warum diese historischen Pegelstände nicht den Klimawandel widerlegen

Darin wird behauptet, dass historische Pegel nicht als Belege dienen können, sondern nur die modernen Klimasimulationen.

Unsere Öffentlichen übernahmen freudig diese Begründung und verkündeten sie so den Bürgern:

[5] Tagesschau, 03.06.2024, von Julia Kuttner, ARD-Faktenfinder: Kontext Hochwasser und Klimawandel Mehr Wärme, mehr Wolken, mehr Regen

… Schon immer gab es extreme Hochwasserereignisse. Klimaskeptiker argumentieren deshalb, dass der Klimawandel nicht die Ursache sein kann. Doch das ist ein logischer Fehlschluss, sagen Experten.

… „Jedes Hochwasser wird für die Klimalüge instrumentalisiert“, „jämmerliche Lüge – es gab schon immer Hochwasser“, „früher waren die Pegelstände an Saar, Rhein, Mosel, Neckar höher“. So und ähnlich kommentieren derzeit Klimaskeptiker in den sozialen Netzwerken

… Doch das ist ein logischer Fehlschluss, wissen Experten. „Es dürfen nicht einzelne Ereignisse betrachtet werden, sondern deren zunehmende oder abnehmende Häufigkeit. Ähnlich wie eine sehr alte, ungesund lebende Person und eine früh verstorbene, gesund lebende Person kein Beweis dafür sind, dass ein ungesunder Lebensstil die Lebensdauer nicht verringert, muss auch hier die Statistik betrachtet werden“, erläutert Professor Ralf Merz vom Helmholtz-Zentrum für Umweltforschung aus Halle (Saale) gegenüber dem ARD-Faktenfinder.

Natürlich habe es auch in früheren Zeiten immer wieder extreme Hochwasserereignisse wie das Magdalenenhochwasser von 1342 gegeben. „Was die Klimamodelle jedoch vorhersagen und was wir auch im Trend der letzten Jahrzehnte sehen, ist, dass die Auftretenswahrscheinlichkeit von Hochwasserereignissen zunehmen wird beziehungsweise bereits zugenommen hat“, so Merz.

… Die Überschwemmungen hätten ein Ausmaß erreicht, auf das „wir uns gar nicht vorbereiten können“. Das einzige, was man machen könne, um dem wirklich sinnvoll vorzubeugen, sei, extrem schnell Treibhausgasemissionen zu reduzieren und darauf zu drängen, dass die globale Temperatur nicht noch weiter steige. Ereignisse wie das Hochwasser seien keine Wetterkapriolen: „Es ist menschengemachter Klimawandel und den können wir nur mit der Reduktion von Treibhausgasen eindämmen.“

Kritik an dieser Kritik

Die Aussage: „ … was wir auch im Trend der letzten Jahrzehnte sehen, ist, dass die Auftretenswahrscheinlichkeit von Hochwasserereignissen zunehmen wird beziehungsweise bereits zugenommen hat“ … “

muss man als bewusste Datenignoranz, Negierung jeglichen Verständnisses für akkurate Methodik und damit als „nicht die wirkliche Wahrheit“ betrachten. Denn selbst rudimentäre Sichtungen von Fluthistorien belegen gerade auch über die jüngere Historie sofort das Gegenteil und lassen erkennen, wie Gefährlich solche Rückschauen für das aktuelle Narrativ sind.

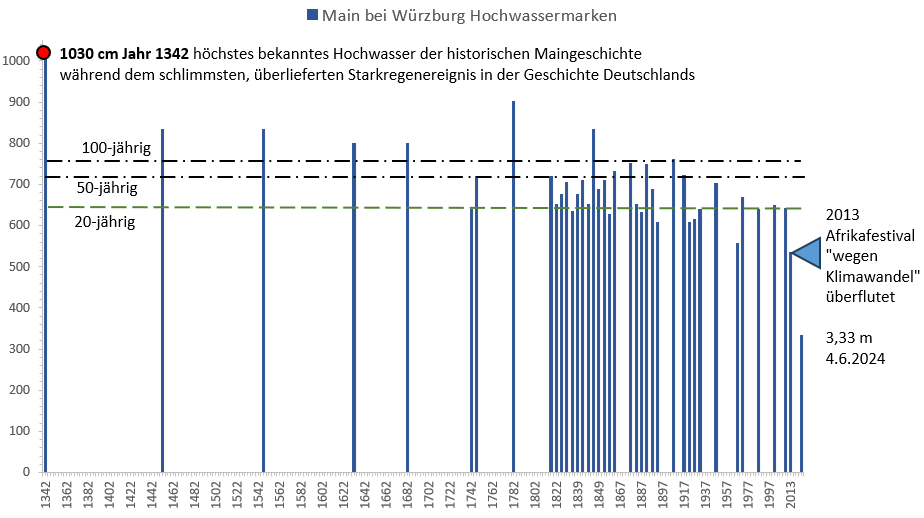

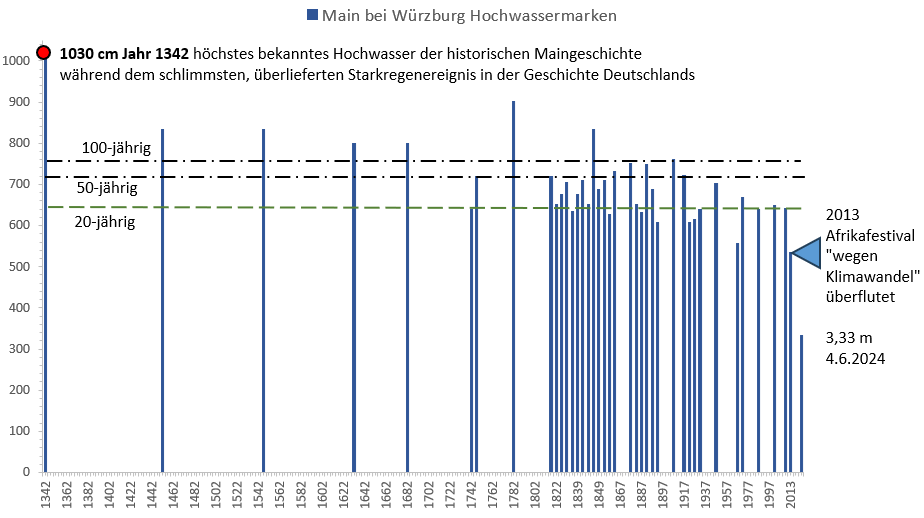

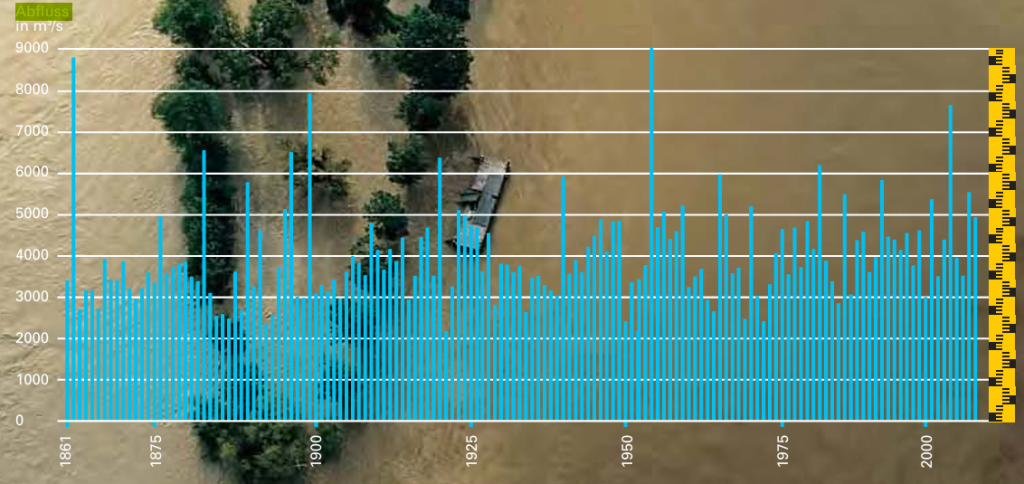

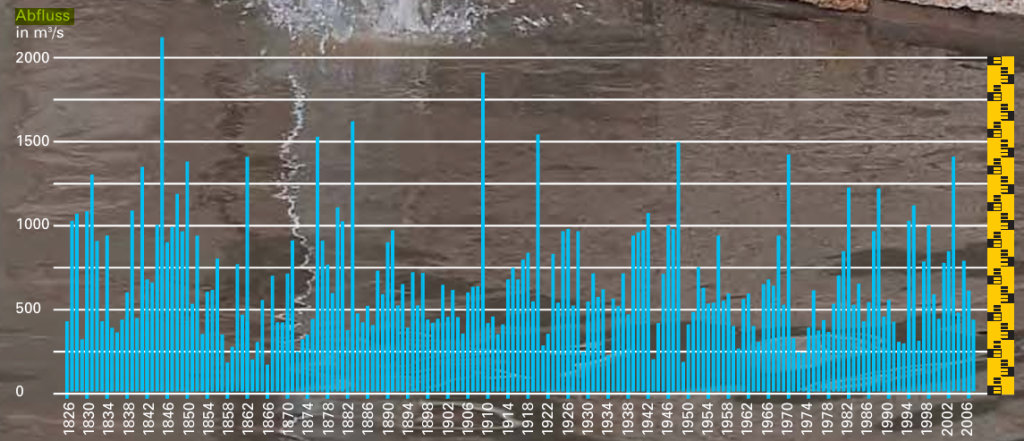

Alleine das Bild des historischen Verlaufs der Mainfluten bei Würzburg zeigt das offensichtliche Gegenteil einer Klimawandel-bedingten Zunahme von Extremfluten:

Bild 11 Hochwasser der Pegnitz in Nürnberg 1300 – 2000. Anm.: 1950 war in Nürnberg der Flutüberleiter fertig. Seitdem gibt es rein technisch bedingt keine hohen Flutpegel mehr

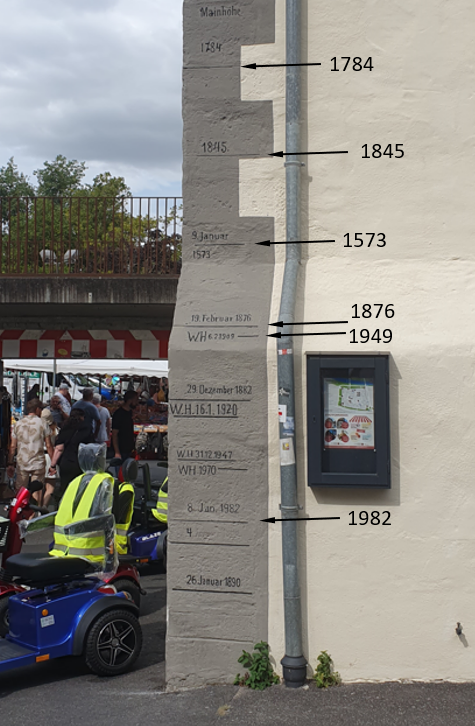

Flutpegelbilder selbst sind teils noch anschaulicher und deshalb für die Bürger, welche solche „falsch“ interpretieren könnten „gefährlich“. Man stelle sich eine solche vorindustrielle Flut wie im folgenden Bild heutzutage vor. Die Klimakleber würden wie die Zeugen Jehovas es ab und zu machen, wohl auf einen Hügel steigen und dort das „hereinbrechende Klima-Armageddon“ abwarten:

Bild 12 Hochwassermarken in Marktbreit am Main, Ecke Marktstraße/Schustergasse. Vom Autor fotografiert und ergänzt

Wer zusammenfassend nachlesen möchte, wie hoch und wie oft Flusshochwasser früher – als es kälter war – gewütet haben, dem sei die (kostenlos) ladbare Schrift vom Bayerisches Landesamt für Umwelt „Leben mit dem Fluss Hochwasser im Spiegel der Zeit“ empfohlen.

Gerade vor dem Beginn des ominösen Klimawandels war es geradezu entsetzlich: „Zwischen 1831 und 1850 gibt es kaum ein Jahr ohne Hochwassermeldung.“

Anbei historische Verläufe von maximalen Jahresabflusspegeln:

Völlig klar, dass man solche Vergleiche dem heutigen Bürger nicht mehr „erlauben“ darf, weil es zu massivem Zweifel Anlass gäbe.

Fazit

Weiterhin ist der Autor der festen Überzeugung, dass das was die Tagesschau fordert:

[5] Tagesschau, 03.06.2024: „… Die Überschwemmungen hätten ein Ausmaß erreicht, auf das „wir uns gar nicht vorbereiten können“. Das einzige, was man machen könne, um dem wirklich sinnvoll vorzubeugen, sei, extrem schnell Treibhausgasemissionen zu reduzieren und darauf zu drängen, dass die globale Temperatur nicht noch weiter steige. Ereignisse wie das Hochwasser seien keine Wetterkapriolen: „Es ist menschengemachter Klimawandel und den können wir nur mit der Reduktion von Treibhausgasen eindämmen.“

Der größte Wissenschaftsbetrug Schwachsinn der jüngeren Geschichte ist und bleibt und bezüglich Unsinn und Kosten noch weit vor der ja vom Ausland offiziell so deklarierten Energiewende rangiert.

Was wirklich helfen würde, sind Maßnahmen vor Ort, um die Auswirkungen der unvermeidbaren Extremniederschläge einzudämmen, wie es sich im Ahrtal so langsam als Erkenntnis durchsetzt.

Wenn man schon wieder lesen muss, wie viele Staumauern überlaufen und brechen und Deiche einstürzen, weiß man um die wesentlichen Schadensverursacher, nämlich die mangels Geldmittel (und politischen Willen) zunehmend maroder werdender Infrastruktur.

So lange Maßnahmen – wenn sie von „hinter einer Brandmauer“ oder etwas Ähnlichem – in Dresden waren es die Freien Wähler – bewusst niedergebügelt werden (ein Antrag zum Prüfen der bekannt maroden und dann auch eingestürzten Brücke auf Standfestigkeit) wird sich daran aber nichts ändern. Zudem verdienen mit dem CO₂-Handel inzwischen zu viele eine risikolose, „goldene Nase“(begonnen mit Al Gore). Auch die EU will ihre Bürokratie damit finanzieren, um kritikunabhängiger zu werden, ein weiterer Grund, warum das CO₂-Narrativ und dessen zunehmend steigende Bepreisung nie mehr rückgängig gemacht werden wird.

Nur manchmal gibt es kleine Lichtblicke, wie von einem Behördenleiter zu Sturmfluten:

Amt: Sturmfluten wegen Klimawandel regional nicht häufiger (msn.com)

Im gerade beginnenden Extremwetterkongress in Hamburg wird nämlich wie üblich von den üblichen dazu als Redner eingeladenen Klimahysterie-Protagonisten wieder das Gegenteil vorhergesagt.

Solche Aussagen sind aber selten. Denn ein Beamter riskiert dadurch seinen Job, vielleicht sogar seine Pension.

Anstelle solcher wirklichen Sachkenner finden sich an verantwortlichen, politischen Positionen zunehmend wirklich Nichtfachpersonen:

RP Online, 18.09.2024: „Jedes Jahr eine Jahrhundertflut“

Darin darf der sozialdemokratische Europaabgeordnete Tiemo Wölken beklagen, „dass am rechten Rand lieber auf göttlichen Beistand gehört als dafür gesorgt werde, die Klimakrise zu beenden. Was die EU auf diesem Gebiet tue, sei noch längst nicht genug: „Sonst werden diese Fluten nicht alle hundert Jahre, nicht alle zehn Jahre, sondern jedes Jahr auftreten“, sagt der SPD-Klimaexperte voraus.“ Und die „amtliche“ Migrantenschlepperin und nun Europaabgeordnete Rackete von den Linken kommt auch zu Wort um: „die „Verbrechen der fossilen Industrie an der Gesellschaft“ zu beklagen und deren Schließung „so schnell wie möglich“ zu verlangen.

Unsere Ursula von den Laien macht es ganz vorbildlich und schaut sich auf Einladung (dann kostet es nichts) fotogene Fluten vor Ort an. Bestimmt hält sie dann noch herrlich frisch „föhnfrisiert“ eine emotional erschütternde Rede, bevor sie sich weiter um ihre Karriere kümmert.

Nur wirkliche und unglaublich effektive Lösungen werden alleine dadurch nicht angestoßen:

Sächsische Zeitung, 18.09.2024: Hochwasser in Tschechien: Die Schäden hätten geringer ausfallen können

… Für Mährisch-Schlesien kam es beim tschechischen Hochwasser am Wochenende ganz dick. Die Opava (Oppa), wichtiger Nebenfluss der Oder, schwoll durch anhaltenden Starkregen dramatisch an und sorgte unter anderem in den Städten Krnov (Jägerndorf) und Opava (Troppau) für extreme Hochwasserstände. 80 Prozent von Krnov standen unter Wasse ….

Landwirtschaftsmister Marek Výborný ereiferte sich nach einer Sitzung der Zentralen Hochwasserkommission: Würde es den lange geplanten Staudamm in Nové Heřminovy an der Opava geben, sähe alles anders aus. „Beide Städte wären jetzt mit einem Fünfjahres-Hochwasser davongekommen und erlebten kein Jahrhundert-Hochwasser.“

Unwirksame und extrem teure CO₂-Vermeidung ist da viel einfacher. Mann muss sich mit Niemandem vor Ort anlegen und den (Misserfolg) bewertet wird frühestens – wenn überhaupt – um 2100.

Quellen

[1] ZDF heute, 17.09.2024: Klimawandel in Deutschland: Hochwasser: Hunderttausende künftig gefährdet

[2] Comdirect, 16.09.2024: Schnellanalyse: Starkregen größtenteils durch Klimawandel

[3] ClimaMeter, Updated 2024/09/17: Heavy Precipitations in Storm Boris exacerbated by both human-driven climate change and natural variability

[4] Correctiv, 09. Februar 2024: Faktencheck Hochwasser: Warum diese historischen Pegelstände nicht den Klimawandel widerlegen

[5] Tagesschau, 03.06.2024: Kontext Hochwasser und Klimawandel Mehr Wärme, mehr Wolken, mehr Regen

[6] SciFi, 17. Sept. 2017: Wieder kein menschengemachter Klimawandel: Historische Kältewelle und viel Feuchtigkeit hat Hochwasser im Schlepptau

[7] world weather attribution: Rapid attribution of heavy rainfall events leading to the severe flooding in Western Europe during July 2021

[8] KIT CEDIM Forensic Disaster Analysis (FDA) Group: Hochwasser Mitteleuropa, Juli 2021 (Deutschland) 21. Juli 2021 – Bericht Nr. 1 „Nordrhein-Westfalen & Rheinland-Pfalz”

[9] Dr. Thomas Roggenkamp Geographisches Institut Universität Bonn: Hochwasser im Ahrtal- Historische Betrachtung und die Flut 2021

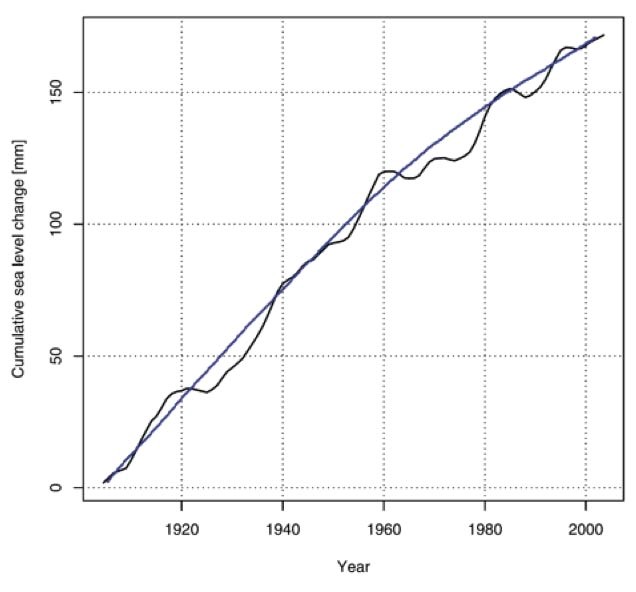

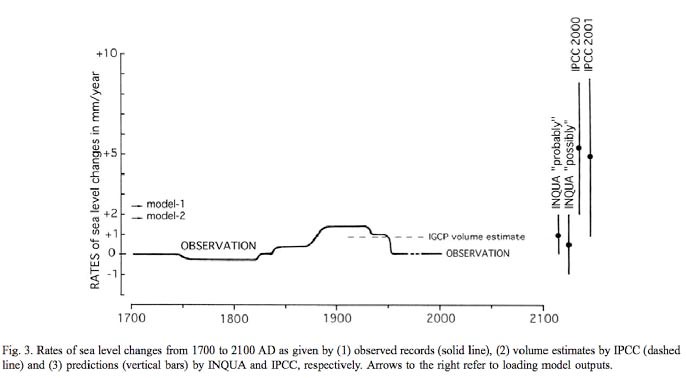

Abbildung 62: Vergleich der Veränderungen des GMSL nach Mörner [Mörner, 2004]. Sie zeigt die verschiedenen Schätzungen der vergangenen und erwarteten zukünftigen Entwicklungen nach Mörner, IPCC TAR und INQA. Deutlich erkennbar der große Unterschied, besonders der zukünftigen Entwicklung, zwischen IPCC einerseits und Mörner/INQA andrerseits.

Abbildung 62: Vergleich der Veränderungen des GMSL nach Mörner [Mörner, 2004]. Sie zeigt die verschiedenen Schätzungen der vergangenen und erwarteten zukünftigen Entwicklungen nach Mörner, IPCC TAR und INQA. Deutlich erkennbar der große Unterschied, besonders der zukünftigen Entwicklung, zwischen IPCC einerseits und Mörner/INQA andrerseits.