Beschleunigt sich der Anstieg des Meeresspiegels?

Uns wird ständig eingeredet, dass sich der Anstieg des mittleren globalen Meeresspiegels (GMSL) beschleunigt. Stimmt das? Wie eindeutig sind die Beweise? Wenn er sich beschleunigt, warum? Ist die Beschleunigung gefährlich?

Die übliche Annahme ist, dass der Anstieg vor allem auf die vom Menschen verursachte globale Erwärmung und das Abschmelzen der Gletscher und der Polkappen zurückzuführen ist. Stimmt das? Wir werden die Beweise untersuchen und sehen, was wir herausfinden können.

Dangendorf, et al. schreiben:

„Wir stellen eine anhaltende Beschleunigung des GMSL seit den 1960er Jahren fest und zeigen, dass diese weitgehend (~76 %) mit Änderungen des Meeresspiegels im Indopazifik und Südatlantik verbunden ist. Wir zeigen, dass der Beginn der Beschleunigung in den 1960er Jahren eng mit einer Intensivierung und einer äquatorialen Verschiebung der Westwinde der südlichen Hemisphäre auf Beckenebene verbunden ist, was zu einer erhöhten Wärmeaufnahme des Ozeans und damit zu größeren Raten des GMSL-Anstiegs durch Veränderungen in der Zirkulation des Südlichen Ozeans führt.“

Die absolute Höhe des Meeresspiegels ist nicht in jedem Ozeanbecken gleich, was auf die Form der Ozeanbecken, die Temperatur der einzelnen Ozeanbecken und die Stärke und Richtung der über dem Becken vorherrschenden Winde zurückzuführen ist*. Die Beschleunigung des Meeresspiegelanstiegs in jedem Becken ist also unterschiedlich, der globale mittlere Meeresspiegel ist eine Kombination aller Veränderungen in jedem Becken, und die bloße Angabe (oder Diskussion) des GMSL verschleiert eine Menge Komplexität.

[*Es fehlt die Angabe, dass der Meeresspiegel aufgrund etwas unterschiedlicher Gravitation auf der Erdoberfläche Unterschiede aufweist. Der Geophysiker spricht hier von einem „Geoid“. Die Oberfläche eines vollständig mit Wasser bedeckten Planeten würde also mehr einer Kartoffel ähneln als einer Kugel. A. d. Übers. der Vollständigkeit halber]

Dangendorf et al. beobachten eine anhaltende Beschleunigung des globalen mittleren Anstiegs des Meeresspiegels seit den 1960er Jahren und kommen zu dem Schluss, dass diese Beschleunigung auf eine Verschiebung der vorherrschenden Winde auf der südlichen Hemisphäre und nicht auf schmelzendes Eis zurückzuführen ist. Tatsächlich stellen sie fest, dass das schmelzende Eis in den 1930er Jahren, als die Treibhausgasemissionen viel geringer waren als heute, erheblich zu der hohen Anstiegsrate des Meeresspiegels beigetragen hat, aber „zwischen den 1940er und den frühen 1990er Jahren keine bis negative Beiträge zu den Beschleunigungskoeffizienten leistete.“

Sie berichten auch, dass die gegenwärtige (1968-2015) Beschleunigung des „globalen“ Meeresspiegel-Anstiegs überhaupt nicht global ist, sondern größtenteils ein Anstieg der Beschleunigung dieses Anstiegs in bestimmten Regionen ist. Im östlichen Pazifik und im Arktischen Ozean wurde keine Beschleunigung festgestellt, und im Südlichen Ozean wurde eine Verlangsamung festgestellt. In den Regionen, die am stärksten von der Eisschmelze betroffen sein sollten, nämlich in der Arktis und im Südlichen Ozean, ist also keine Beschleunigung festzustellen.

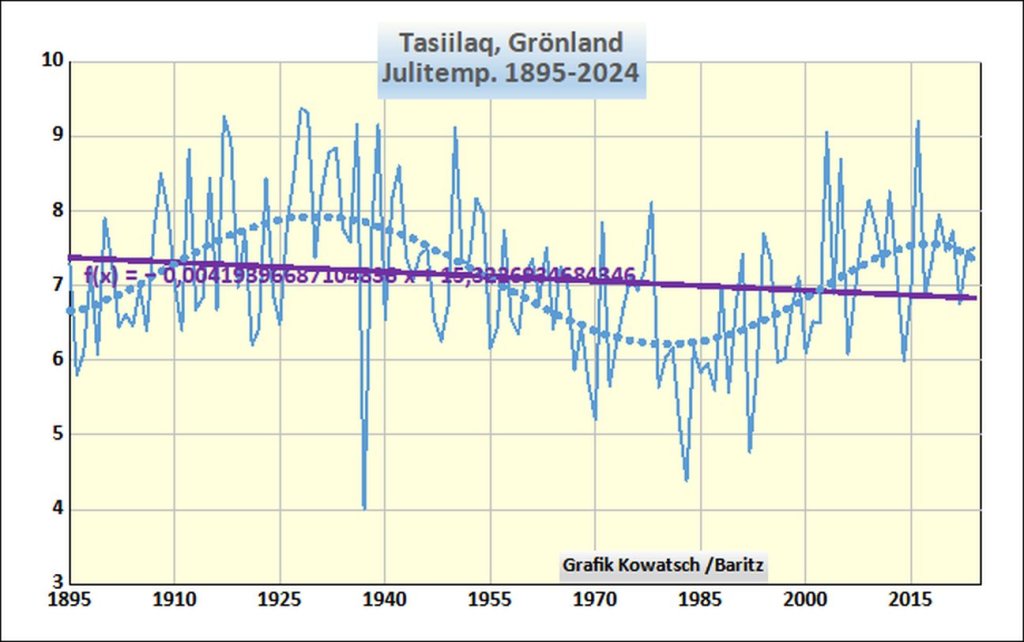

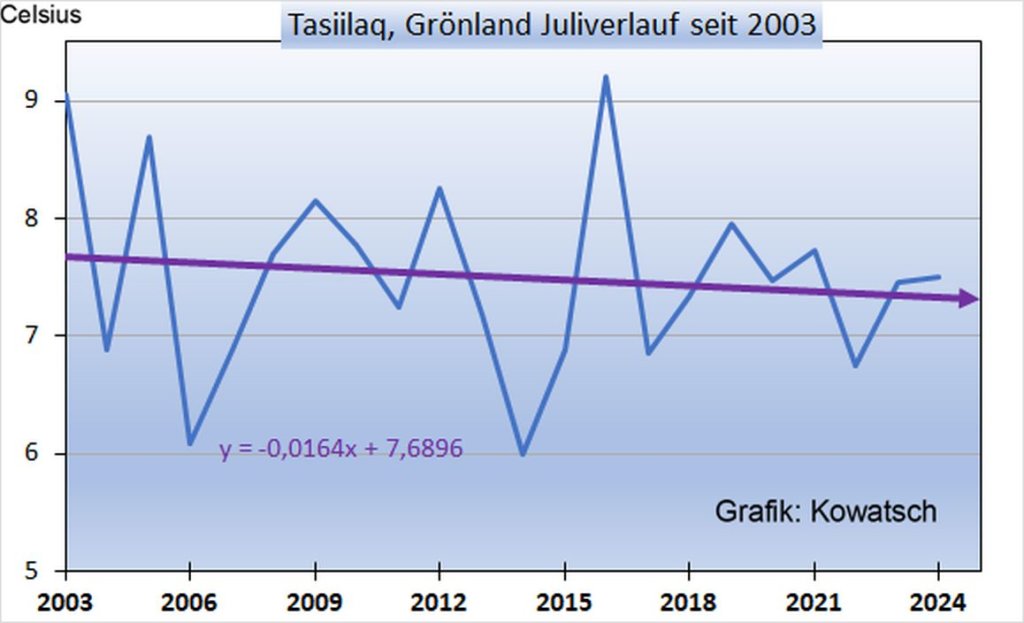

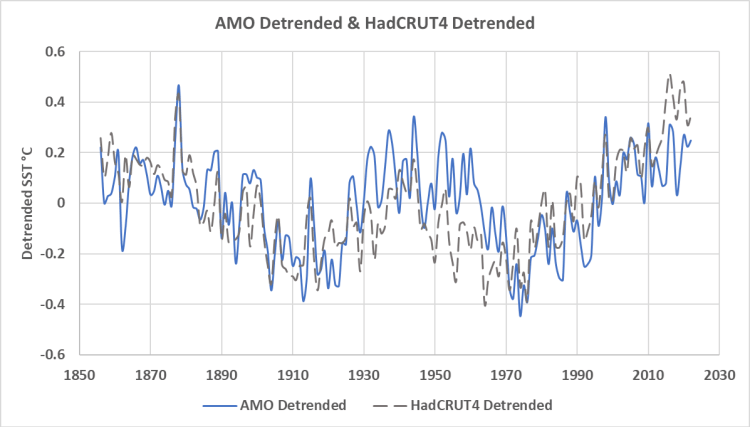

Dies deutet darauf hin, dass die derzeit beobachtete Beschleunigung auf Veränderungen der atmosphärischen Zirkulation und nicht auf die globale Erwärmung oder Treibhausgase zurückzuführen ist. Größere Änderungen der globalen Windzirkulation treten in einem Zeitraum von etwa 65 Jahren auf, und diese verursachen Änderungen der globalen Temperaturen wie in Abbildung 1 dargestellt:

Abbildung 1. Der Index der Atlantischen Multidekadischen Oszillation (AMO) und die HadCRUT4-Aufzeichnung der globalen Temperatur. Quelle: May & Crok, 2024.

Der AMO-Index ist zwar nicht genau dasselbe wie die 60- bis 70-jährige globale Klimaschwankung, die gewöhnlich als Klimastadium-Welle bezeichnet wird, aber er ist ähnlich, und die AMO ist eine wichtige Komponente der Stadium-Welle (Wyatt M. G., 2012c) und (Wyatt & Curry, 2014). Man beachte, dass die AMO zwischen 1910 und 1925 sowie zwischen 1970 und 1980 ein Minimum aufweist und dass diese Minima annähernd mit den Tiefstwerten der HadCRUT4-Durchschnittstemperatur nach deren Trendbereinigung übereinstimmen.

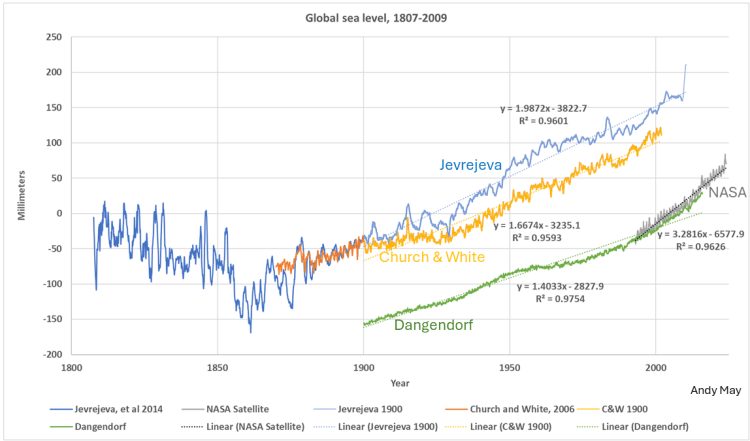

In Abbildung 2 sind verschiedene Schätzungen des Meeresspiegelanstiegs dargestellt, darunter die Schätzung von Dangendorf et al.:

Abbildung 2. Ein Vergleich verschiedener Schätzungen der Geschwindigkeit des globalen Meeresspiegelanstiegs. Die Schätzungen von Jevrejeva sowie Church & White stammen von Gezeitenmessern, die NASA-Schätzung (Beckley, Callahan, Hancock, Mitchum, & Ray, 2017) von Satellitenmessungen und der Dangendorf-Datensatz ist eine komplexe Mischform.

Das erste, was uns in Abbildung 2 auffällt, ist, dass von 1900 bis 2000 alle langfristigen Raten des Meeresspiegelanstiegs einigermaßen linear sind, mit Raten zwischen 1,4 und 2,0 mm/Jahr. Zweitens ist ein ähnliches zyklisches Muster von zunehmender und abnehmender Beschleunigung des Meeresspiegelanstiegs in allen Rekonstruktionen zu erkennen. Alle zeigen eine Beschleunigung von etwa 1920 bis etwa 1950-1960, gefolgt von einer Verlangsamung bis zu den frühen 1990er Jahren und einer erneuten Beschleunigung nach den 1990er Jahren. Zufälligerweise beginnen die Satellitenaufzeichnungen mit dem Beginn der zyklischen Beschleunigung in den frühen 1990er Jahren.

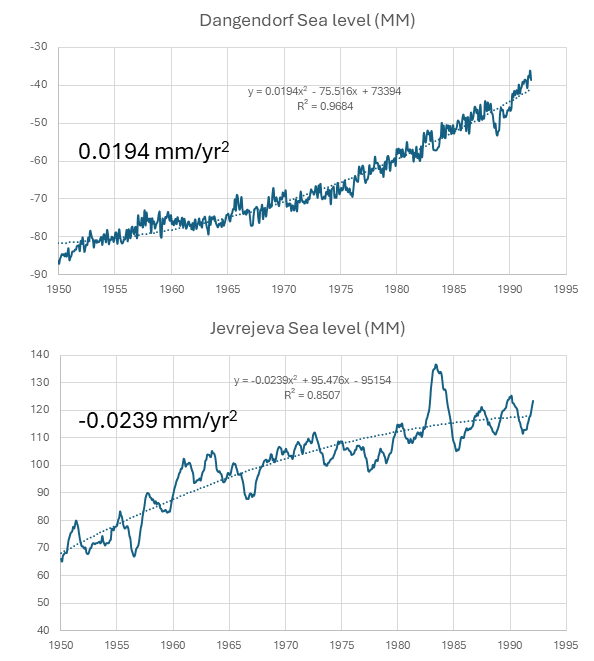

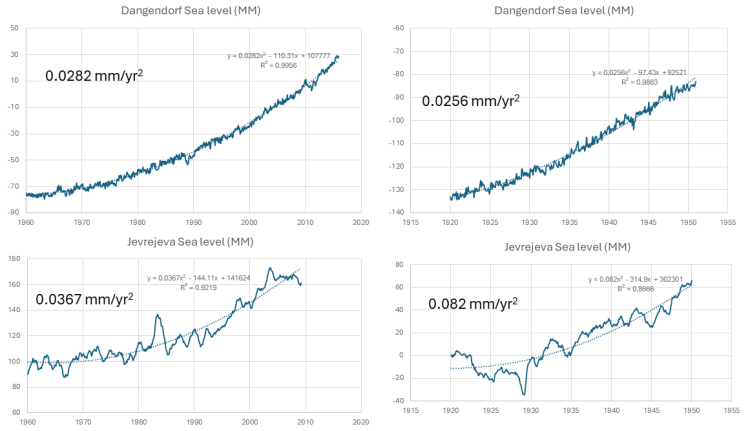

Laut Dangendorf et al. ist die Beschleunigung des Meeresspiegelanstiegs, die seit den 1960er Jahren (nahe dem Höhepunkt des Zyklus) beobachtet wurde, nicht wesentlich größer als die in den 1920er und 1930er Jahren festgestellte Beschleunigung. Es scheint wahrscheinlich, dass das in Abbildung 1 dargestellte natürliche Klimamuster die Beschleunigung des Meeresspiegelanstiegs in beiden Beschleunigungsperioden stark beeinflusst. Ein Vergleich der Beschleunigung von 1960-2016 mit der von 1920 bis 1950 beobachteten ist in Abbildung 3 für das Dangendorf-Hybridmodell und die Jevrejeva-Pegelrekonstruktion dargestellt:

Abbildung 3. Vergleich der Beschleunigung des Meeresspiegelanstiegs von 1960 bis 2016 (links) mit der von 1920 bis 1950 beobachteten Beschleunigung (rechts) für die beiden Aufzeichnungen zum Meeresspiegelanstieg von Dangendorf und Jevrejeva. Die aus einem Polynom 2. Ordnung berechnete Beschleunigung ist für jedes Diagramm angegeben.

In Abbildung 3 wird deutlich, dass die Jevrejeva-Aufzeichnung des Meeresspiegelanstiegs viel detaillierter und weniger bearbeitet ist als die komplexe hybride Dangendorf-Rekonstruktion, aber beide zeigen ähnliche Beschleunigungsraten für die jeweiligen Zeiträume. Die größte Beschleunigung weist die Jevrejeva-Rate für den Zeitraum 1920 bis 1950 auf, die kleinste die Dangendorf-Rate für denselben Zeitraum. Die moderne Dangendorf-Beschleunigungsrate ist bescheiden und kleiner als die moderne Jevrejeva-Rate.

Wie in Dangendorf et al. festgestellt, ist die Beschleunigungsrate im Zeitraum 1920 bis 1950 ähnlich hoch wie die Rate im modernen Zeitraum, und die Jevrejeva-Daten von 1920 bis 1950 deuten darauf hin, dass die Beschleunigung in diesem Zeitraum höher war als im aktuellen Zeitraum. Da die Beschleunigungsrate zu Beginn des 20. Jahrhunderts wahrscheinlich nicht durch Treibhausgasemissionen beeinflusst wurde, gibt es keinen Grund zu der Annahme, dass die Beschleunigung in der heutigen Zeit anders ist.

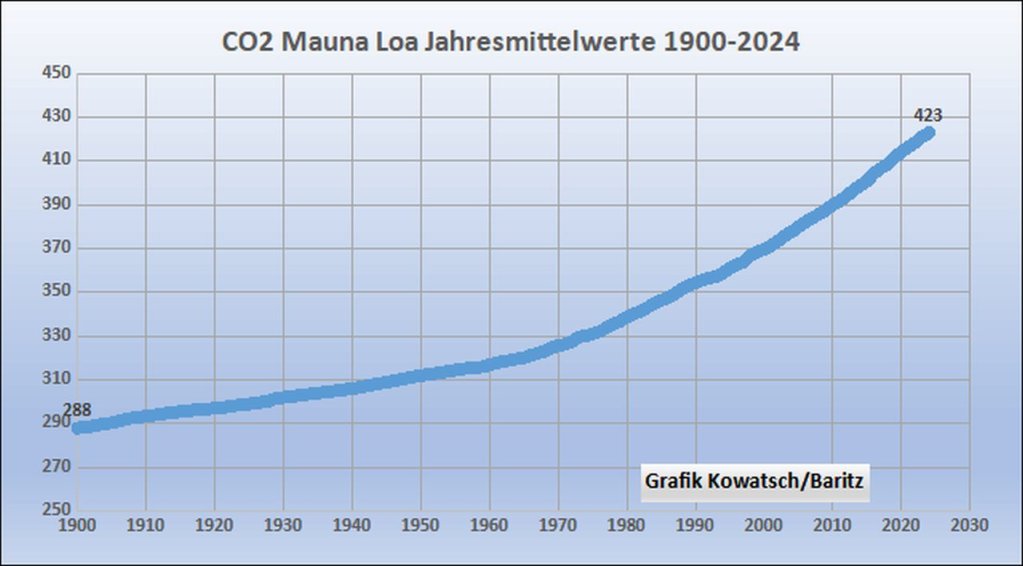

Die Treibhausgas-Emissionen von 1950 bis 1990 waren höher als von 1920 bis 1950, doch die Beschleunigung des Meeresspiegelanstiegs war damals geringer und möglicherweise negativ, wie in Abbildung 4 dargestellt:

Die sehr stark bearbeitete Aufzeichnung des Meeresspiegels von Dangendorf et al. zeigt eine geringe Beschleunigung von 1950 bis 1991, aber die Aufzeichnung des Pegels von Jevrejeva zeigt tatsächlich eine Verlangsamung in diesem Zeitraum.

Diskussion und Schlussfolgerungen

Es gibt bestimmte Bruchpunkte in den Klimatrends um 1912 und 1972, wie im AMO-Index in Abbildung 1 zu sehen ist. Diese Bruchpunkte sind auch in der trendbereinigten HadCRUT4-Aufzeichnung der globalen mittleren Temperatur zu erkennen. Weitere Informationen über Klimabruchpunkte, auch bekannt als Klimaverschiebungen, findet man hier, hier und hier. [Und natürlich bei Kowatsch et al. A. d. Übers.]

Auch bei der Anstiegsrate des Meeresspiegels treten Unterbrechungen auf, wie in Abbildung 2 dargestellt, die jedoch leicht verschoben sind, etwa zu ±1928 und ±1991. Alle Aufzeichnungen des Meeresspiegelanstiegs in Abbildung 2 zeigen diese Bruchstellen, wenn auch in unterschiedlicher Ausprägung.

Es ist unklar, warum sich das Klima zu diesen Zeiten ändert oder ob die Änderungen mit den Änderungen der Anstiegsrate des Meeresspiegels zusammenhängen. Dies ist ein Bereich, der noch weiter erforscht werden muss. Die Darstellungen lassen jedoch darauf schließen, dass sich die Beschleunigung des Meeresspiegelanstiegs in einem Zyklus von 60-70 Jahren ändert. Die Veränderungen folgen einem ähnlichen Muster wie die Veränderungen der globalen Temperatur und der Atlantischen Multidekadischen Oszillation.

Dangendorf et al. sind der Ansicht, dass die Veränderungen im 20. Jahrhundert bei der Beschleunigung des Meeresspiegelanstiegs eng mit Veränderungen der atmosphärischen Zirkulation verbunden sind, insbesondere der Zirkulation im Pazifik und im Südlichen Ozean. Wir sehen keinen Grund, dieser Meinung zu widersprechen. Die Veränderungen bei der Beschleunigung des Meeresspiegelanstiegs scheinen nicht mit Treibhausgas-Emissionen oder menschlichen Aktivitäten zusammenzuhängen.

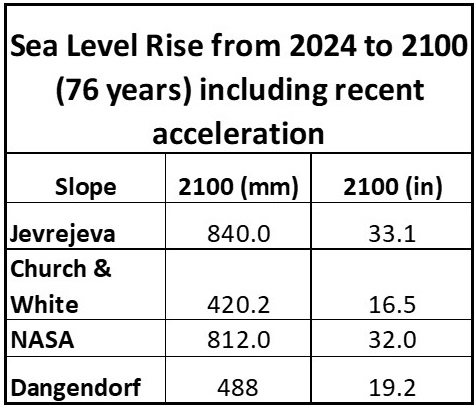

Was wäre, wenn es in diesem Jahrhundert keine Perioden der Verlangsamung des Anstiegs oder eine tatsächliche Verlangsamung des Meeresspiegelanstiegs gibt? Mit anderen Worten, was wäre, wenn die derzeitige natürliche Beschleunigung seit 1960 bis zum Jahr 2100 anhält? Wie hoch würde der mittlere globale Meeresspiegel ansteigen? In Tabelle 1 wird diese Berechnung anhand der Daten für jede in diesem Beitrag besprochene globale Meeresspiegel-Rekonstruktion durchgeführt. Die in den Berechnungen von Jevrejeva und Dangendorf verwendeten Funktionen sind in Abbildung 3 auf der linken Seite dargestellt. Die anderen verwendeten Funktionen finden Sie in der zusätzlichen Tabelle, die am Ende dieses Beitrags verlinkt ist.

Tabelle 1. Der erwartete Meeresspiegelanstieg im Jahr 2100 unter Verwendung der Beschleunigung seit 1960 (oder der ersten Schätzung) bis zur endgültigen Schätzung.

Wie Tabelle 1 zeigt, beträgt der Anstieg des Meeresspiegels im Jahr 2100 nur 41 bis 84 cm, wenn die beobachtete Beschleunigung seit dem letzten Aufschwung um 1960 in jeder Rekonstruktion extrapoliert wird. Dies ist weniger als der durchschnittliche tägliche Tidenhub und stellt für niemanden ein Problem dar. Es ist sehr unwahrscheinlich, dass sich die natürliche Beschleunigung seit 1960 bis zum Jahr 2100 fortsetzt; sie sollte bald wieder zu einer langsameren Beschleunigung zurückkehren, so wie es irgendwann zwischen 1955 und 1965 der Fall war.

Eine Tabellenkalkulation mit den Daten, die zur Erstellung der Zahlen und der Tabelle verwendet wurden, kann hier heruntergeladen werden.

Download the bibliography here.

Link: https://andymaypetrophysicist.com/2024/08/04/is-sea-level-rise-accelerating/

Übersetzt von Christian Freuer für das EIKE