Februar: keine CO₂-Treibhauswirkung erkennbar

Von Matthias Baritz, Josef Kowatsch und Stefan Kämpfe

- Wärmster Februar seit 1881

- 107 Jahre Abkühlung, Temperatursprung, ab 1988 bis heute Weitererwärmung.

- Keine Korrelation mit dem CO₂-Anstieg, keine Treibhauswirkung erkennbar

- Der vom Menschen verursachte WI-effekt hat die Erwärmung seit 1881 mitgetragen.

„Fast den ganzen Februar über wurde milde Atlantikluft nach Deutschland geführt. Daraus resultierte sowohl eine deutlich positive Temperaturabweichung, als auch überdurchschnittlich viel Niederschlag. Die Sonne hatte es den ganzen Monat über schwer, sich gegen die oft kompakte Bewölkung durchzusetzen. Schnee und Frost suchte man auch in den Wintersportgebieten der Mittelgebirge vergeblich. Nur in den Hochlagen der Alpen schneite es in der dritten Dekade etwas ergiebiger.“ Das meldet der Deutsche Wetterdienst (DWD) nach ersten Auswertungen der Ergebnisse seiner über 2000 Messstationen.

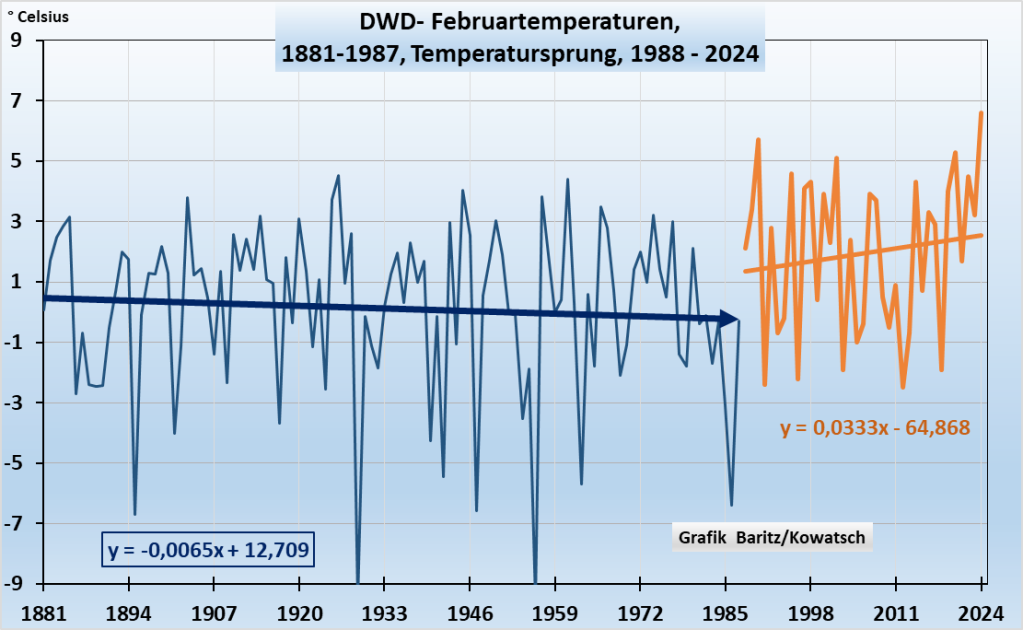

Und ein neuer Temperaturrekord seit 1881: Das Temperaturmittel lag im Februar 2024 bei 6,6 Grad Celsius (°C)

Wir fragen uns: Wo ordnet sich dieser Februar 2024 mit seinen schon frühlingshaften 6,6 °C in die bis 1881 zurückreichende Klimareihe Deutschlands ein, und wie entwickelten sich die Februar-Temperaturen langfristig?

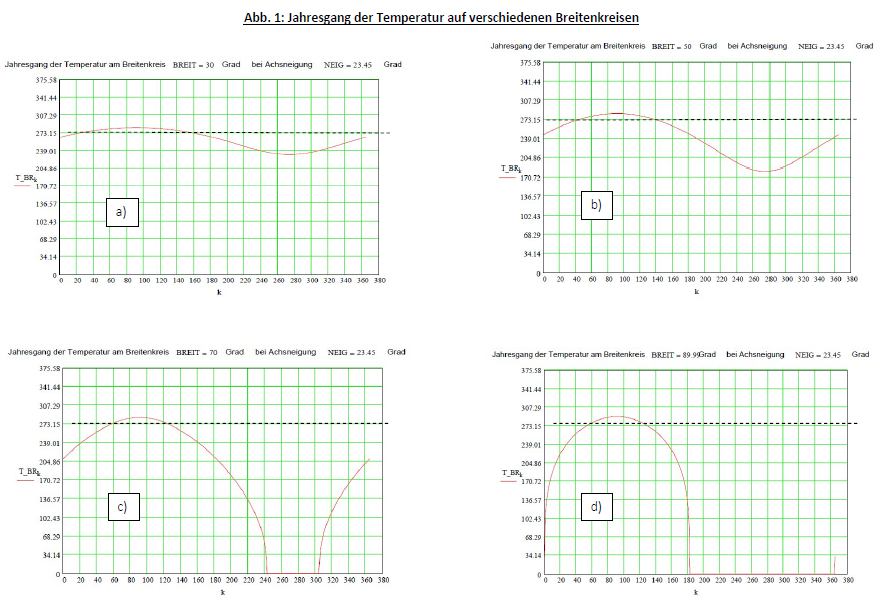

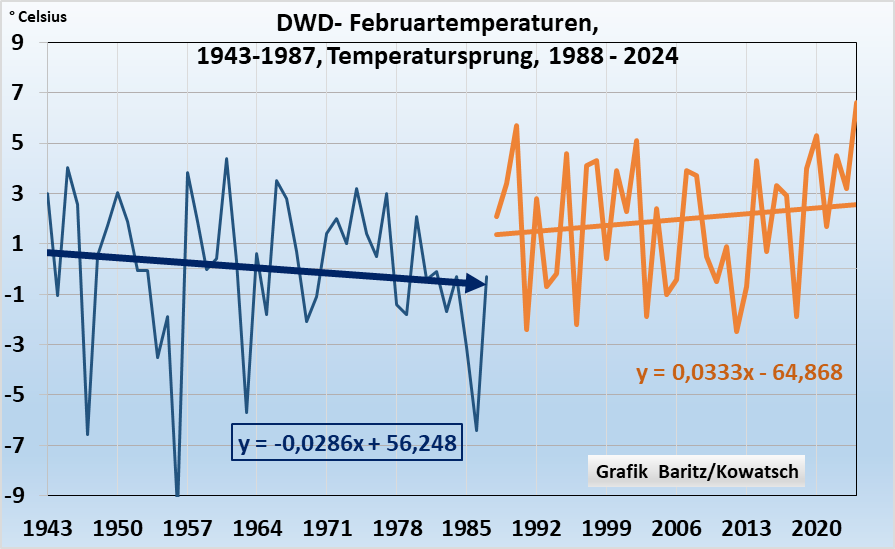

Doch zuerst zur Deutschland –Temperaturgrafik des Februars:

Abb. 1: Die Februar-Mitteltemperaturen des Deutschen Wetterdienstes seit 1881 bis 2024, also 144 Jahre:

Wir erkennen mindestens 3 Teilabschnitte:

- Leichte Abkühlung 107 Jahre lang bis 1987

- Temperatursprung von 1987 auf 1988 von 1,5 Grad

- Weitererwärmung seit 1988 bis heute laut DWD um 0,3 Grad/Jahrzehnt.

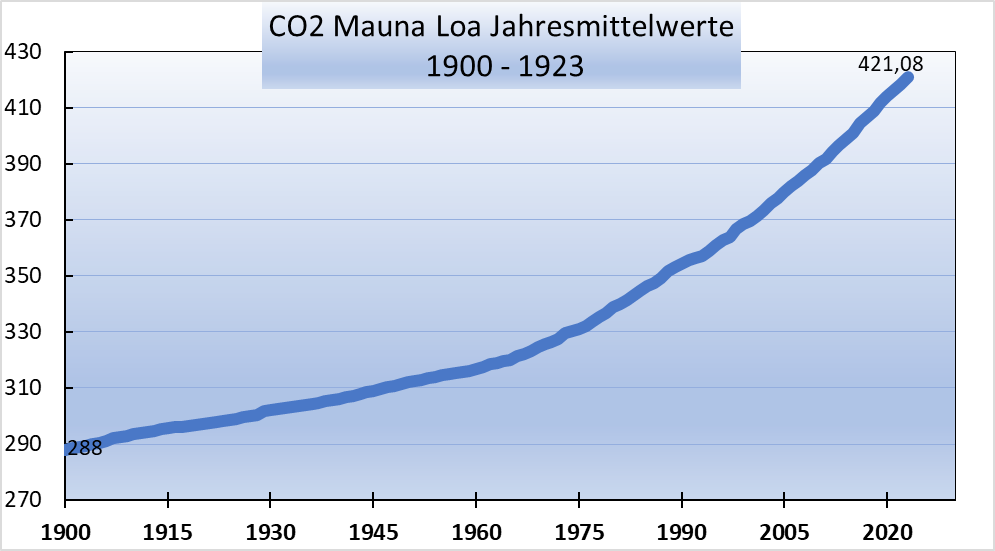

Die CO₂-Konzentrationszunahme in der Atmosphäre: Starker Anstieg

Wir gehen von einer erheblichen Zunahme der CO₂-Konzentration von 135 ppm seit 1881 aus, ob diese jedoch ausschließlich anthropogenen Ursprunges ist, wollen wir nicht diskutieren, sondern lediglich die vom PIK-Potsdam behauptete hohe CO₂-Klimasensitiviät anhand des Artikels in Frage stellen. Umso mehr, wenn man die ersten 107 Jahre näher betrachtet.

Der Temperaturverlauf in den ersten 107 Jahren ist jedoch keinesfalls immer fallend wie die Trendlinie der Grafik 1 suggeriert. Erst ab 1943 bis 1987 kühlte der Februar deutlich ab.

Betrachten wir nun den kürzeren Zeitraum ab 1943.

Abb. 3: Die Februarabkühlung begann eigentlich erst so richtig ab 1943, und zwar sehr deutlich. Der Temperatursprung im Jahre 1987/88 bleibt.

Wissenschaftliche Erkenntnis: CO₂ kann nicht über 100 Jahre abkühlend wirken, dann einen plötzlichen Temperatursprung verursachen und erst ab 1988 erwärmend weiter wirken. Solche Gaseigenschaften gibt es nicht.

Wir stellen bisher fest:

Die CO₂-Kurve der Konzentrationszunahme zeigt im Vergleich zur Entwicklung der deutschen Februartemperaturen keinerlei Ähnlichkeit. Ab 1988 bis heute handelt es sich um eine Zufallskorrelation.

Auch für den Temperatursprung im Jahre 1987 auf 1988 kann CO₂ nicht verantwortlich sein. Der Temperatursprung auf ein wärmeres Plateau hat somit ausschließlich natürliche Ursachen (Zirkulationsverhältnisse – mehr Westwetterlagen bei positiven NAO-Werten).

Aus den Grafiken muss man schließen, CO₂ hat entweder gar keinen Einfluss auf die Temperaturen oder einen nur sehr unbedeutenden. Eine politisch gewollte und nun von die Grünen favorisierte teure CO₂-Reduzierung durch das im Boden Verpressen oder Versenken von Kohlendioxid im Meer ist völlig nutzlos, dazu umweltzerstörend und gefährlich für die Bodenorganismen.

Damit ist die gängige Definition von Klimawandel falsch, die ausschließlich Kohlendioxid und andere Treibhausgase für die Klimaerwärmung verantwortlich macht.

Merke: Die treibhausbasierte Klimahysterie ist eine Wissenschaft des finstersten Mittelalters. Da geht es nur ums Geld und einen CO₂-Ablaßhandel

Doch zurück zu den Februartemperaturreihen des Deutschen Wetterdienstes: Einzuwenden wäre, dass um 1900 ein ganz anderes Deutschland mit anderen Grenzen bestand und die Wetterstationen samt ihren ganz anderen Temperaturermittlungen in der Wetterhütte mit den heutigen wärmeren Standorten nur bedingt vergleichbar sind. Deutschland hatte damals 104 Einwohner pro Quadratkilometer; heuer sind es mit 220 gut doppelt so viele, was bedingt durch den erhöhten Wohlstand und Energieverbrauch erwärmend wirkte. Die DWD- Wetterstationen stehen heute in den von Menschen geschaffenen großflächigen Wärmeinseln, auch gab es einst typische ländliche Stationen bei Klöstern oder Forsthäusern am Waldrand oder bei freistehenden Gutshöfen von Feudalherren.

Die Realität wäre: Die fallende Trendlinie von 1881 bis 1987 wäre noch mehr fallender. Der Temperatursprung wäre gleich. Die Erwärmungssteigung der Trendlinie ab 1988 bis heute wäre nicht so stark. Zum WI-effekt und zur Größeneinschätzung siehe weiter unten.

Wenn Kohlendioxid nicht erwärmt, was dann? Auf der Suche nach des Gründen des Februarverhaltens:

NAO = Nordatlantische Oszillation. Unter der NAO versteht man in der Meteorologie die Schwankung des Druckverhältnisses zwischen dem Islandtief im Norden und dem Azorenhoch im Süden

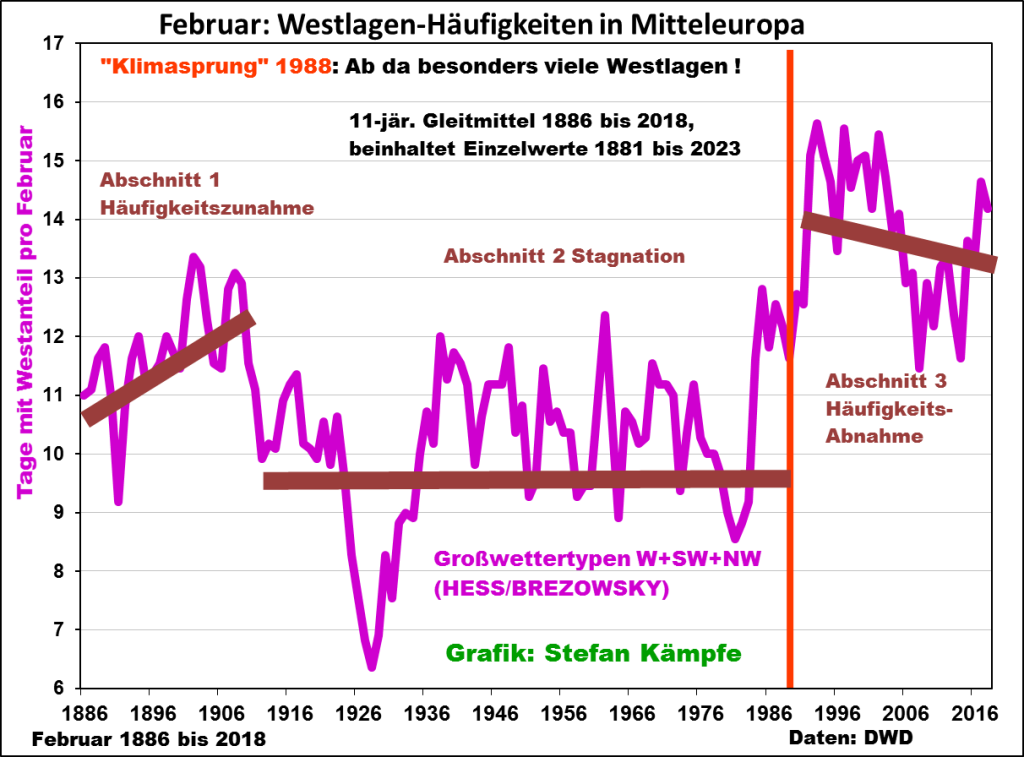

Dieses auffällige Temperaturverhalten in drei Phasen ähnelt grob dem des Januars und lässt sich sehr gut mit dem Verhalten der NAO und der an die NAO gekoppelten Häufigkeit der Großwetterlagen mit Westanteil erklären:

Abb. 4: Zentrierte, 11-jährige Gleitmittel der NAO und der Häufigkeit der im Februar meist milden Westwetterlagen. Man achte auf die relative Übereinstimmung, welche auch die in Abb.1 und 3 dargestellten Phasen erklärt. Die NAO als „Luftdruck-Schaukel“ zwischen Portugal/Azoren und Island beeinflusst die Häufigkeit und Intensität der wintermilden Westwetterlagen. Werte für 2024 noch nicht vorliegend, aber auch da zu viele W- und SW-Lagen. Der 2024er Februar war sehr wolkenreich (milde Nächte!)

Auch der DWD gibt als Hauptursache für den neuen Februartemperaturrekord nicht etwa den CO₂-Treibhauseffekt als Ursache an, sondern die milden Westwetterlagen, Abschnitt: „

Sehr milde Nächte und Tage bescheren neuen Temperaturrekord“ hier.

Der Mensch wirkt mit bei der Temperaturentwicklung durch zunehmende Wärmeinseleffekte (WI).

Klima verändert sich seit 4 Milliarden Jahren ohne Zutun des Menschen, es handelt sich um natürliche Klimaänderungen. In der Neuzeit wirkt der Mensch mit durch die ständige Ausbreitung der Wärmeflächen überall auf der Welt. Von Interesse wäre der Temperaturverlauf ohne die wärmenden menschlichen Veränderungen bei den Stationen. Vor allem in den letzten vier Jahrzehnten hat sich die Bebauung in die einst freie grüne Vegetations-Fläche hinein erweitert, derzeit um 60 Hektar täglich und innerhalb der Städte und Gemeinden werden Baulücken weiter geschlossen, damit die Flächenerweiterung ins Umland – eigentlich eine Naturzerstörung – rein statistisch geringer ausfällt, was für die Politik ein Beleg für Naturschutz ist. Derzeit ist ein Siebentel der Gesamtfläche unseres Landes versiegelt. Jede Sekunde wird in der Bundesrepublik Deutschland 6,7 m2 Boden neu als Siedlungs- und Verkehrsfläche beansprucht. Das bringt die Wärme ins Umland der DWD-Wetterstationen. Siehe: hier.

Im Winter wärmt zusätzlich die Abwärme der Industrie, der Haushalte und des Verkehrs die Siedlungen und deren näheres Umfeld besonders bei windstillen, kalten Hochdruckwetterlagen auf. Im Umland heizen „Biogas“-, Solar- und Windkraftanlagen ebenfalls. Insgesamt sind die WI- Effekte nach unseren bisherigen Untersuchungen im Winter aber etwas geringer als in den Frühjahrs- und vor allem den Sommermonaten. Jede Straße wirkt vor allem im Sommer wie ein heißes Wärmeband in der Landschaft. Die Freisolaranlagen werden zeitweise bis zu 80°C heiß. Bäuerliche Trockenlegung der Agrarlandschaft in den letzten 50 Jahren und neuerdings auch im Wald sorgt auch im Sommer für erhöhte Bodentemperaturen außerhalb der Versiegelungsflächen, also auch in der freien Landschaft.

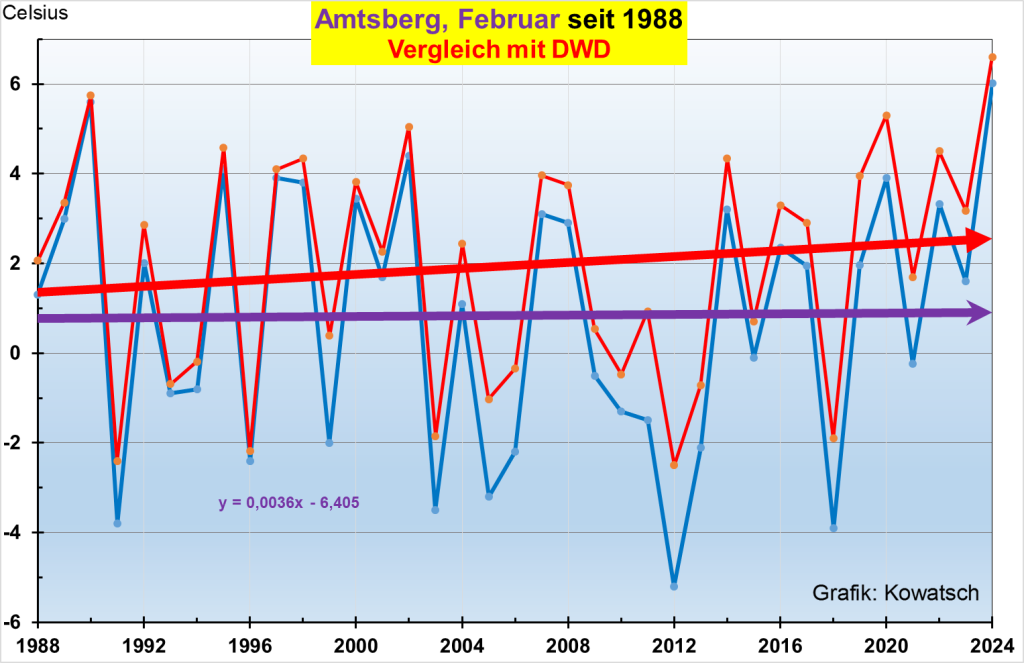

Kurzum, bei den Messstationen des DWD hat der Wärmeeintrag, bedingt durch anthropogene Nutzungsänderungen stark zugenommen und die Thermometer der Stationen messen diese vom Menschen erzeugte Zusatzwärme aus den sich ständig vergrößernden Wärmeinseln mit. Natürlich gibt es auch Stationen mit geringen wärmenden Veränderungen. Eine solche ist in Amtsberg-Dittersdorf südlich von Chemnitz, deren Temperaturverlauf im Vergleich zum DWD wir in der Grafik 5 wiedergeben.

Abbildung 5: Die WI-arme Station Amtsberg – siehe blauer Graph mit violetter Trendline – im kleinen Teilort Dittersdorf steht noch so wie 1988, der Ort hat sich kaum verändert und der Stationsleiter erfasst die Temperaturen noch im Wetterhäuschen am unveränderten Standort, allerdings inzwischen digital.

Wir sehen: Auch bei der Privatstation Amtsberg war der Februar 2023 der wärmste, aber die Erwärmung seit 1988 ist nur minimal im Vergleich zu den DWD-Stationen an den neuen genormten Standorten mit der neuen Messerfassungsmethode

Weitere Februar-Besonderheiten, die dem CO₂-Treibhauseffekt widersprechen:

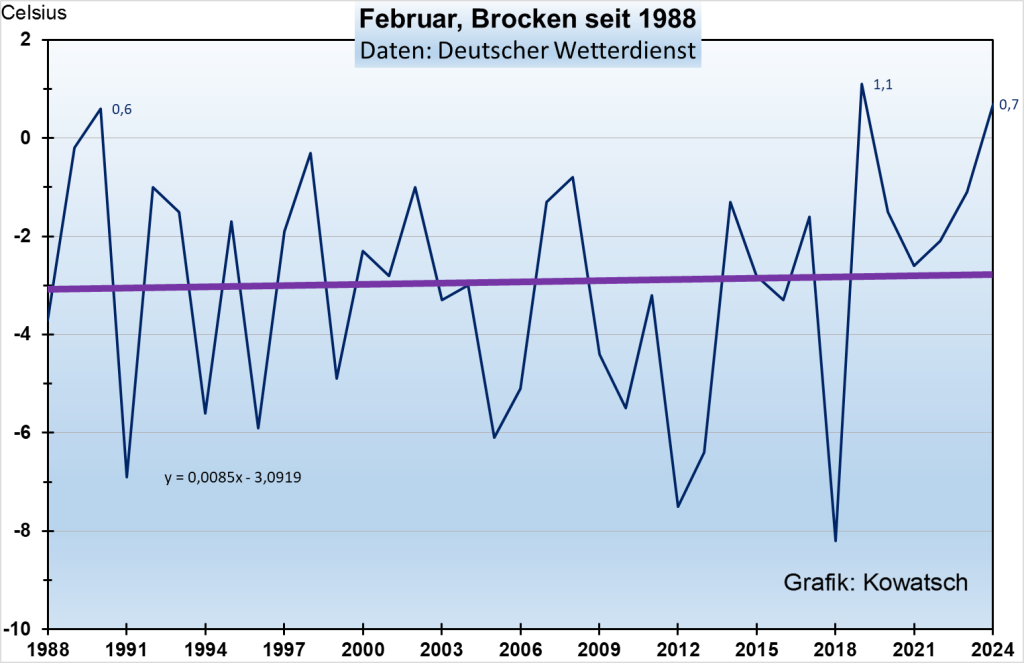

Höher gelegene Wetterstationen: Kaum Februarerwärmung seit 1988 – warum?

Auf das Phänomen der derzeitigen Höhen-Abkühlung, bedingt durch die verstärkte Advektion von Höhen-Kaltluft, hatten wir schon in unseren Januar-Beiträgen hingewiesen, hier und hier.

Es ist aber auch nicht unerheblich, dass die in den Wärmeinseln von Menschen erzeugte Warmluft nicht nach oben abfließen kann und wie in einer Warmluftglocke unterhalb 950 bis 1000 m Höhe eingesperrt bleibt.

Als Beispiel einer Wetterstation über 1000m NN sei der Brocken aufgeführt.

Abb.6: Die Wetterstation auf dem 1142 m hohen Brocken zeigt fast keine Februarerwärmung seit 1988. So ähnlich verhalten alle höheren Bergstationen. Und 2023 war mit 0,7°C nicht der wärmste Februar, sondern 2019 mit 1,1°C, siehe auch Grafik 7b.

Einordnung des Februars 2021 in einer längeren Zeitreihe, also vor 1881

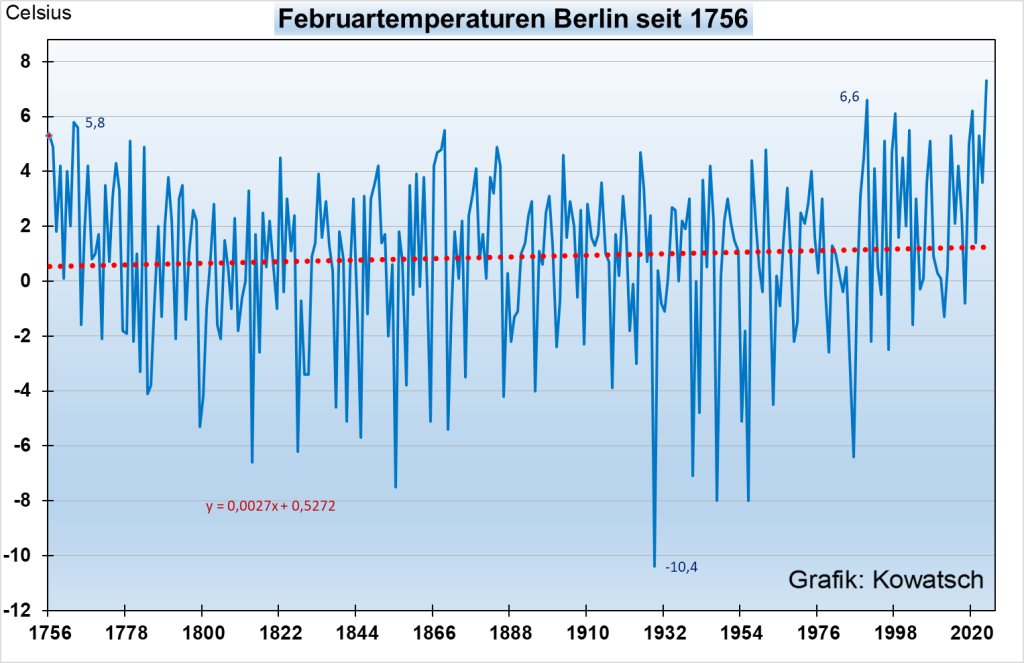

- Die Wetterstation Berlin-Tempelhof

Die Aufzeichnungen beim einstigen Feudalherrengutshof begann bereits um 1700, jedoch noch sehr lückenhaft, seit 1756 sind sie regelmäßig, allerdings nur bedingt vergleichbar mit heute. Grund: Tempelhof war vor 250 Jahren ein großer Gutshof, angeordnet wie ein Tempel, daher der Name. Um den Gutshof herum waren bebaute Felder zur Nahrungsversorgung des damaligen viel kleineren Berlins. Das noch unbebaute Tempelhoffeld zwischen Berlin und dem Gutshof diente als Exerzier- und Ausbildungsplatz für die Truppen Friedrichs des Großen oder auch der sonntäglichen Erholung und Belustigung der damaligen Stadtbevölkerung.

Heute ist Tempelhof ein Stadtteil der Großstadt Berlin mit über 60 000 Bewohnern. Eigentlich handelt es sich beim Temperaturvergleich um zwei völlig verschiedene Orte am selben Fleck und noch mit demselben Namen. Trotzdem ist das Ergebnis auch ohne Wärmeinselbereinigung der Temperaturwerte erstaunlich.

Abb. 7a: Die Wetterstation beim einstigen tempelartig angeordneten Gutshof auf freiem Feld außerhalb Berlins im Vergleich zur heutigen Großstadtwetterstation Tempelhof zeigt fast keine Februarerwärmung in über 260 Jahren. (In den Sommermonaten ist der Unterschied früher zu heute gravierend wegen der viel stärkeren WI-Effekte im Sommerhalbjahr.

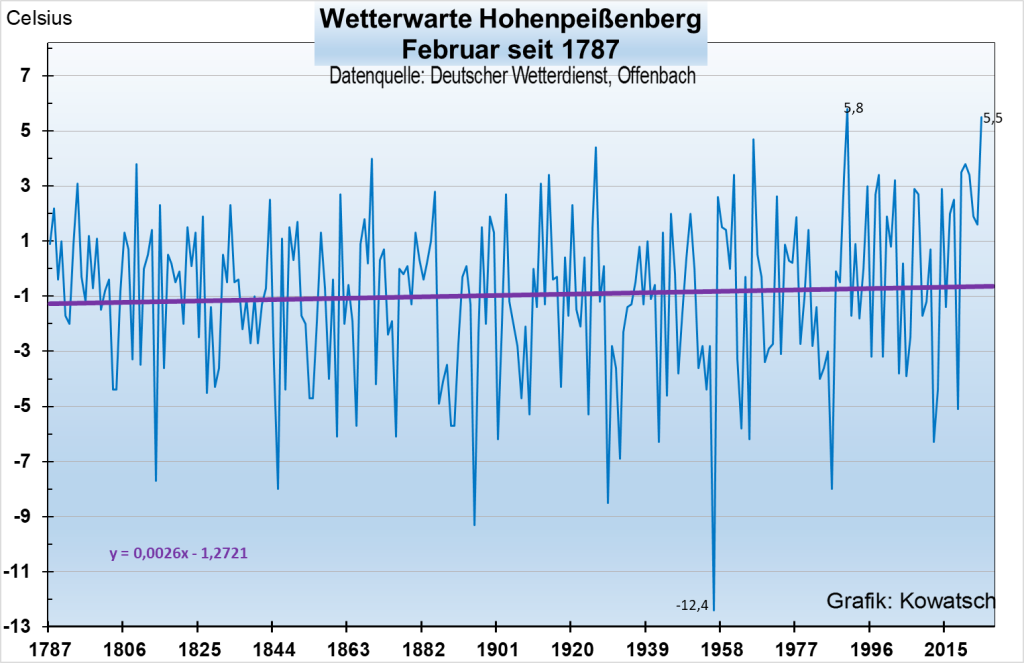

- Die Wetterstation auf dem Hohenpeißenberg, (HPB)

Wir erwähnten schon, dass 1881, der Beginn der DWD-Messreihen, in einer Kaltphase lag. Die Wetterstation auf dem Hohenpeißenberg geht 100 Jahre weiter zurück. Erwähnt werden muss lediglich, dass die Messstation bis 1936 an der Nordwand der unbeheizten Klosterkirche war, heute steht die Station frei im neu erbauten DWD-Zentrum. Allerdings sind die Wärmeinseleffekte im Winter recht gering, so dass die wärmende Standortverlegung weniger Einfluss auf die Temperaturerfassung hatte als etwa im Sommerhalbjahr.

Der Februar-Verlauf auf dem HPB ist erstaunlich. Kaum Erwärmung seit über 230 Jahren, trotz starker CO₂-Konzentrationszunahme und trotz Stationswechsels an einen wärmeren Standort. Erstaunlich auch, 2024 gab es keinen neuen Temperaturrekord, die Station liegt allerdings 977m hoch, da greift bereits die Höhenkaltluft.

Abb. 7b: Die Februartemperaturen der DWD-Wetterwarte Hohepeißenberg zeigen trotz CO₂-Zunahme und trotz der Standortverlegung 1936 und trotz des Temperatursprunges 1988 nur eine minimale Erwärmung seit fast 240 Jahren.

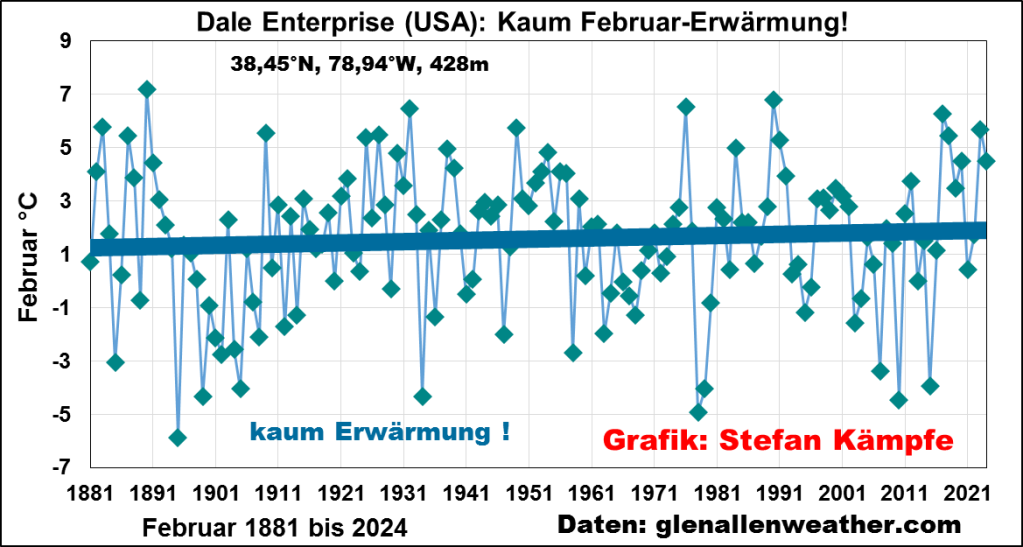

- Die Dale Enterprise Wetterstation mitten auf dem Land in Virginia/USA

Abb.7c: Die Station liegt bei einer Farm auf dem Land. Trotz starker CO₂-Zunahme seit 1880 hat sich der Monat Februar seit 145 Jahren kaum erwärmt. Der Verlauf über die Jahrzehnte ist jedoch anders als in Deutschland. Vor allem gibt es 1987 auf 1988 keinen Temperatursprung.

Wohin geht der zukünftige Februartrend in Deutschland?

Die langen Reihen zeigen: Kaum Erwärmung in einem langen Zeitraum trotz der gewaltigen wärmenden Landschaftsveränderungen mit den WI-effekten

Und nach dem Temperatursprung 1988 bis heute? Geringe Erwärmung bei WI-armen und Bergwetterstationen. Und zukünftig in Deutschland? Antwort: Sobald sich die Großwetterlagen wieder ändern. Wann wird das sein? Das weiß niemand.

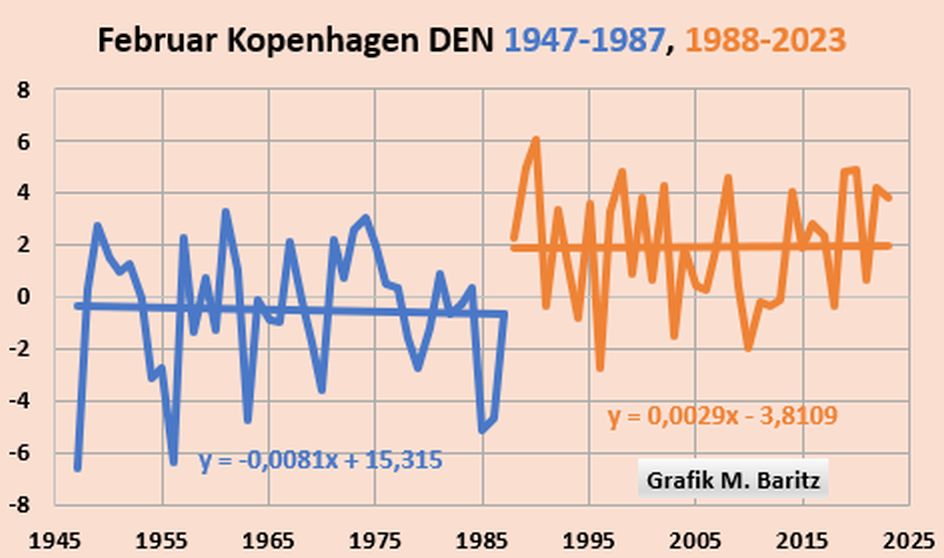

Wir fragen uns: Ist vielleicht Deutschland in den letzten 37 Jahren eine Ausnahme oder gar ein Sonderfall? Wird nur bei uns der Februar in den letzten 37 Jahren wärmer? Wir werfen einen Blick nach Zentralengland:

Abb. 8: Wie in Deutschland (vergleiche Abb.3) deutliche Februarabkühlung ab 1943, Temperatursprung 87/88 ca. 1,5 K,

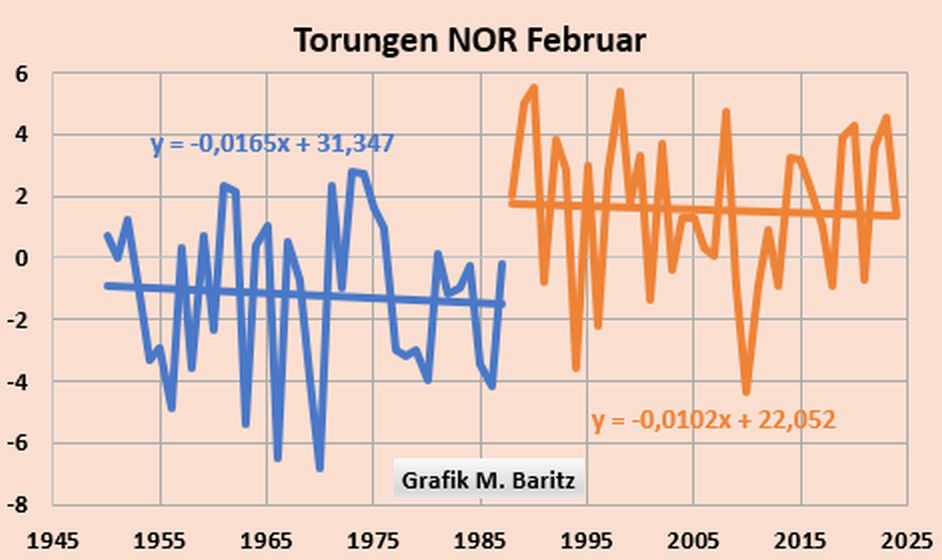

Werfen wir noch einen Blick auf Skandinavien. Weiter nördlich in Europa kühlt sich der Februar ab 1988 teilweise sogar ab.

Abb. 10a/b: Je weiter nördlich, desto größer der Temperatur-Sprung. Danach keine Weitererwärmung wie bei unseren Bergstationen.

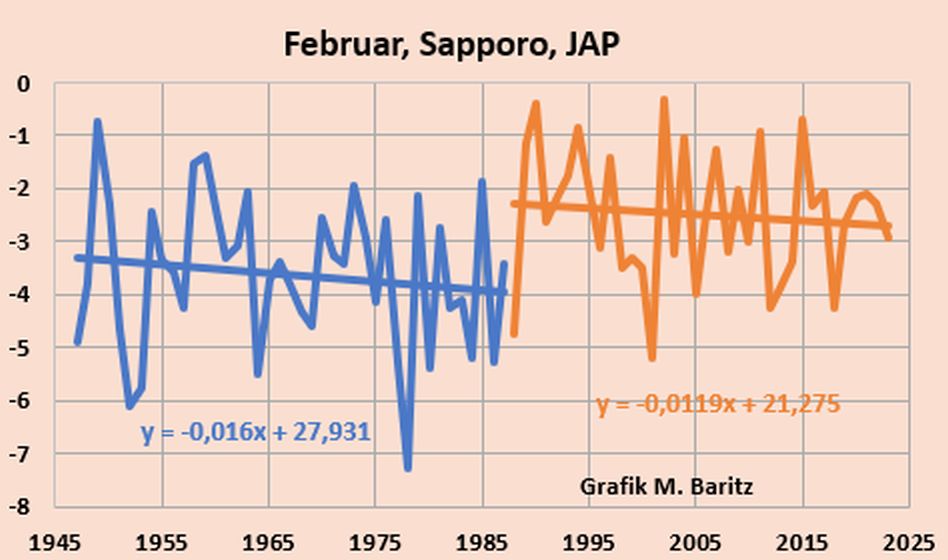

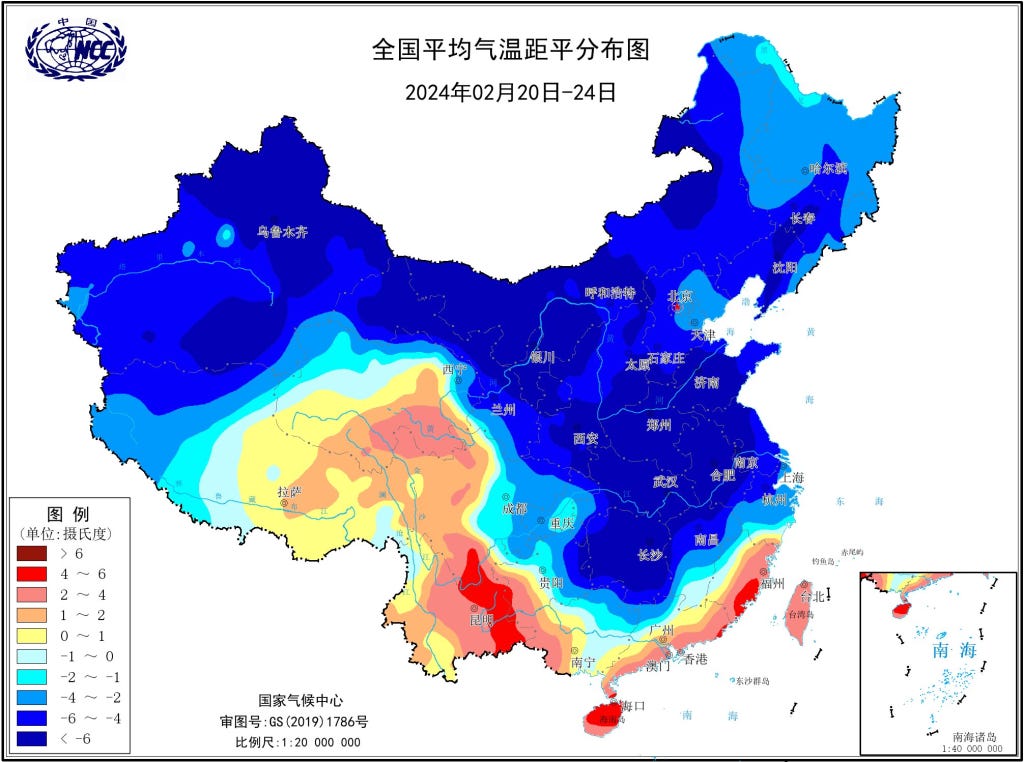

Auch in Teilen Ostasiens (beispielhaft hier Sapporo) und in Teilen der USA blieb seit 1988 eine Februar-Erwärmung aus. Siehe dazu die vielen Kälteberichte auf EIKE aus aller Welt, insbesondere aus Zentralasien. z.B. hier.

Fazit:

Die ständige Zunahme der Wärmeinseleffekte, die Schaffung großflächiger Wärmeregionen sind der mit Abstand größte menschengemachte Temperaturtreiber. Eine Einwirkung mittels CO₂ gibt es nicht oder die Wirkung ist minimal, das zeigen auch alle wissenschaftlich sauber durchgeführten Versuche.

Will der Mensch den menschengemachten Anteil an der Erwärmung bekämpfen, dann muss man die Wetterstationen entweder wieder raus in die Fläche stellen oder aber in den Städten und Gemeinden die Bebauung, Versiegelung der einst freien Landschaft und die Trockenlegung der Agrar-Landschaft rückgängig machen oder zumindest einstellen.

Eine Diskussion über die Reduzierung der menschenerzeugten WI-Effekte, also eine Diskussion zum Erhalt der Natur und Landschaft wäre zu begrüßen.

Politisch verordnete, teure CO₂-Einsparungen bewirken nichts. Es handelt sich um ein Ablasshandelsmodell ähnlich dem Ablasshandel im Mittelalter. Der Staat will uns ausplündern. Die Demokratie ist dadurch in höchster Gefahr.

CO₂ ist ein lebensnotwendiges Gas, genauso wie Sauerstoff und Wasser. Ohne CO₂ wäre die Erde kahl wie der Mond. Mehr CO₂ in der Atmosphäre wäre wünschenswert, denn es beschleunigt die Fotosynthese und lässt die Nahrungspflanzen schneller wachsen.

Wirklicher Natur- und Umweltschutz muss endlich in den Mittelpunkt des politischen Handelns gerückt werden und nicht das Geschäftsmodell Klimaschutz, das unser Land ruiniert und in das Privatleben der Bürger eingreift. Eine Gefahr für die Demokratie.

Die Februartemperaturreihen des Deutschen Wetterdienstes beweisen: Es gibt keinen Klimanotstand. Deshalb muss auch keiner bekämpft werden.

Josef Kowatsch, Naturbeobachter und unabhängiger, weil unbezahlter Klimaforscher

Stefan Kämpfe, Diplom- Agraringenieur, unabhängiger Natur- und Klimaforscher

Matthias Baritz, Naturwissenschaftler und Naturschützer