Andy May

[*Der angelsächsische Terminus „storm“ umfasst nicht nur Sturm, sondern Unwetter allgemein. In den USA ist ein „rainstorm“ ein Starkregen-Ereignis, auch wenn es dabei windstill ist. A. d. Übers.]

In Teil 4 wurden die Auswirkungen der Konvektion und der atmosphärischen Zirkulation auf das Klima erörtert. Wenn sich die Zirkulationsmuster ändern, verändern sie die Geschwindigkeit und Effizienz des Transports überschüssiger Wärme von den Tropen zu den Polen. Wenn dieser Wärmetransport schneller ist, wird die Welt kühler, da die Pole einen schwachen Treibhauseffekt haben und die Wärme effizienter in den Weltraum abstrahlen. Die Tropen sind feucht und haben einen sehr starken Treibhauseffekt, da Wasserdampf das stärkste Treibhausgas ist [1]. Daher wird die Wärmeenergie (Wärme), die zu den Polen mit niedriger Luftfeuchtigkeit transportiert wird, leichter in den Weltraum geleitet als in den Tropen.

Der Temperaturgradient, der sich zwischen den Tropen und den Polen bildet, trägt zu dieser Wärmeübertragung bei, wird jedoch durch atmosphärische und ozeanische Zirkulations- und Konvektionsmuster moduliert. Ein sehr starkes Gefälle, wie wir es heute haben, erhöht die Sturmaktivität.

Der Temperaturgradient steuert den meridionalen Transport und das Wetter

Es ist unumstritten, dass Temperaturgradienten zumindest teilweise für unser Wetter verantwortlich sind. Auf der Suche nach einer Gleichgewichtstemperatur will die Wärme von wärmeren in kältere Gebiete fließen. In größerem Maßstab ist der meridionale Transport zum Teil auch eine Funktion des Temperaturunterschieds zwischen den Tropen und den Polen. Leon Barry und Kollegen schreiben:

„Der atmosphärische Wärmetransport auf der Erde vom Äquator zu den Polen wird größtenteils durch Wettersysteme in den mittleren Breiten bewirkt.“ [2] – Leon Barry et al., Nature, 2002

Starke Stürme in den mittleren Breiten, Wirbelstürme und andere Stürme transportieren den größten Teil der überschüssigen tropischen Wärme polwärts, und je mehr sie transportieren, desto kälter wird die Erde. Der Temperaturgradient ist nicht der einzige Faktor, der den meridionalen Transport steuert, es gibt viele andere Einflussfaktoren [3], aber er ist ein wichtiger Faktor, vielleicht der wichtigste.

Die Atmosphäre ist eine riesige Wärmemaschine [4], die von der Oberfläche aus angetrieben wird (mit Ausnahme einiger begrenzter Gebiete in den Polarregionen) und die ungenutzte Wärme in den Weltraum abgibt [5]. Wie bei einer Zugmaschine kann die Wärme Arbeit erzeugen, wenn sie sich durch die Atmosphäre bewegt, und diese Arbeit ist unser Wetter, hauptsächlich Stürme. Wie in Teil 4 erörtert, schwanken die tropischen Temperaturen nicht sehr stark, so dass der entscheidende Faktor die Temperatur an den Polen ist. Die notwendige Konsequenz dieses Konzepts ist, dass das Wetter extremer ist, wenn der Planet kälter, der meridionale Transport stark und der Temperaturgradient steil ist. Es ist weniger extrem, wenn der Planet wärmer, der meridionale Transport schwach und der Temperaturgradient geringer ist. Dies ist das Gegenteil der Schlussfolgerungen des IPCC, der auf der Grundlage der CMIP-Modelle glaubt, dass wärmeres Wetter mehr Stürme bringt (AR6 WGI, Seite 1526-1527). Aber das ist nicht das, was beobachtet wird. Auf jeder Hemisphäre gibt es in den Wintermonaten mehr Unwetter als in den Sommermonaten [6].

Zhongwei Yan und Kollegen, zu denen auch Philip Jones und Anders Moberg gehören, haben herausgefunden, dass extreme Wetterereignisse vor allem in den Wintermonaten seit dem 19. Jahrhundert abgenommen haben, da sich die Welt erwärmt hat [7]. Sie stellen fest, dass der Zusammenhang zwischen Wärme und schwächerem Wetter in Europa und China in den kritischen Wintermonaten am ausgeprägtesten ist. Im Gegensatz zu Yan et al. heißt es im AR6:

„… sowohl thermodynamische als auch dynamische Prozesse sind an den Veränderungen von Extremen als Reaktion auf die Erwärmung beteiligt. Anthropogener Antrieb (z. B. Anstieg der Treibhausgaskonzentrationen) wirkt sich direkt auf thermodynamische Variablen aus, einschließlich des allgemeinen Anstiegs hoher Temperaturen und des atmosphärischen Verdunstungsbedarfs sowie regionaler Veränderungen der atmosphärischen Feuchtigkeit, die Hitzewellen, Dürren und Starkniederschlagsereignisse intensivieren, wenn sie auftreten (hohes Vertrauen). Dynamische Prozesse sind oft indirekte Reaktionen auf thermodynamische Veränderungen, werden stark von der internen Klimavariabilität beeinflusst und sind auch weniger gut verstanden. Daher gibt es ein geringes Vertrauen in die Auswirkungen dynamischer Veränderungen auf den Ort und das Ausmaß von Extremereignissen in einem sich erwärmenden Klima.“ – AR6 WGI, Seite 1527

Trotz der von Yan et al. und vielen anderen vorgelegten Beweise (siehe Kapitel 11 in The Frozen Climate Views of the IPCC) kommt der AR6 also zu dem Schluss, dass die anthropogene globale Erwärmung eine Zunahme von Wetterextremen verursacht und verursacht hat. Dies ist ein weiteres Beispiel für eine Verzerrung.

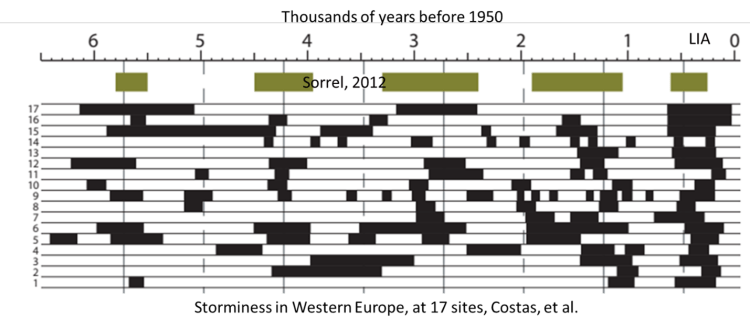

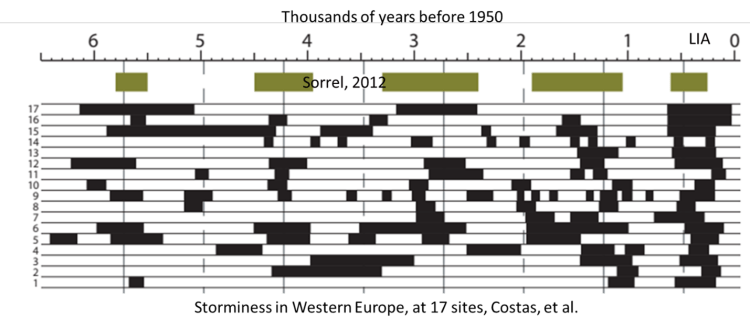

Auf längeren Zeitskalen nimmt die Unwetterhäufigkeit auch während historischer Kälteperioden zu. Sie erreichte in Europa während der sehr kalten Kleinen Eiszeit (in Abbildung 1 mit „LIA“ bezeichnet) einen Höhepunkt:

Abbildung 1. Stürmische Perioden in den letzten 6.500 Jahren in Europa. Nach Vinós, 2022.

Abbildung 1 zeigt Perioden von Stürmen, die anhand von sedimentologischen Merkmalen in Europa in 18 Studien ermittelt worden waren. Die stärkste Häufigkeit extremer Stürme trat während der kalten Kleinen Eiszeit auf [8], die der IPCC als „vorindustrielle“ Periode bezeichnet [9]. Es ist logisch, dass extreme Wetterlagen und Stürme in kalten Zeiten zunehmen, und das ist auch zu beobachten. Die Temperaturen in den Tropen ändern sich kaum, die globalen Temperaturveränderungen finden hauptsächlich in den höheren Breitengraden statt. Wenn die Temperaturen in höheren Breitengraden sinken, wird der Temperaturgradient steiler, was zu stärkeren Winden führt, und starke Winde sind das Markenzeichen extremer Wetterlagen.

IPCC AR6 WG1 Modell-Verzerrung, Zusammenfassung

Die schwächste Annahme des IPCC ist, dass die Sonne in ihrer Wirkung auf das Klima seit 1750 konstant geblieben ist. Wie wir in Teil 3 gezeigt haben, gibt es viele Beweise dafür, dass die Sonne in diesem Zeitraum Schwankungen unterworfen war und zur globalen Erwärmung beigetragen hat [10]. Die implizite Annahme des IPCC, wie in Abbildung 2 in Teil 3 gezeigt, dass eine Änderung des solaren Antriebs der gleichen Änderung (in W/m²) des Treibhauseffekts entspricht, ist einfach nicht wahr, wie uns die grundlegende Physik sagt. Der solare Antrieb hat eine längere Verweildauer, zumindest in den Ozeanen, und verursacht aufgrund der höheren Frequenzen des Sonnenlichts eine stärkere Erwärmung Watt für Watt. Die höheren Frequenzen durchdringen die Meeresoberfläche, während die Treibhausgasemissionen mit niedrigeren Frequenzen dies nicht tun.

Die CMIP6-Modelle versuchen zwar, den Wärmeinhalt des Ozeans, die Wärmepufferung des Ozeans und die Trägheit zu berücksichtigen, aber soweit ich sehen kann, berücksichtigen sie nicht die unterschiedlichen klimatischen Auswirkungen von Sonnenlicht und Treibhausgasemissionen. Falls doch, ist dies tief im AR6 WG1 vergraben [11]. Zwar wird in der Modelldokumentation eingeräumt, dass es einen Unterschied bei der Aufnahme durch den Ozean gibt [12], doch scheint man diese Tatsache einfach zu ignorieren. Sie behandeln sie gleich oder fast gleich, obwohl sie es nicht sind.

Dies ist wichtig, weil laut AR6 der Anstieg des Wärmeinhalts der Ozeane 91 % der gesamten Veränderung des globalen Energieinventars zwischen 1971-2006 und 2006-2018 ausmacht, also in zwei Perioden mit schneller Erwärmung [13]. Zufällig oder nicht, ist dies auch die letzte Hälfte des modernen Sonnenmaximums [14], in der man erwarten würde, dass die Ozeane die überschüssige Wärme abstrahlen, die sie in der ersten Hälfte des Maximums angesammelt haben. Die Ozeane strahlen die Wärme vor allem durch El Ninos, tropische Wirbelstürme (Hurrikane), Monsune und Stürme in den mittleren Breiten aus. Wie lange es dauert, bis die Atmosphäre nach einem Sonnenmaximum abkühlt, ist nicht bekannt, aber vielleicht erfahren wir es bald.

Während wir heute über viele Messungen des Wärmeinhalts bis zu einer Tiefe von 2000 Metern verfügen, sind diese Messungen vor 2004 recht selten, weshalb das spezifische, zur Berechnung des Wärmeinhalts im Ozean vor 2000 verwendet Modell sehr wichtig ist. Es ist bedauerlich, dass sich unsere Messungen des Wärmeinhalts der Tiefsee gerade dann so dramatisch verbessert haben, als das moderne Sonnenmaximum zu Ende ging, denn wir brauchen diese Daten, da der Wärmeinhalt ebenfalls zunahm. Satellitenmessungen der von der Erdoberfläche ausgehenden Strahlung reagieren sehr empfindlich auf die Temperatur, aber nicht unbedingt auf die Temperatur unterhalb der Meeresoberfläche.

Es gibt drei Prozesse, die zusammenwirken, um das Klima der Erde stabil zu halten: der Treibhauseffekt, die Wolken und der meridionale Wärmetransport. Diese Faktoren tragen auch dazu bei, die Verweilzeit der von der Sonne empfangenen Energie zu bestimmen. Der IPCC hat sich ausschließlich auf den ersten Faktor konzentriert, indem er seine CO₂-Klimahypothese entwickelt hat [15].

Die Auswirkung von Wolken und deren Variabilität auf den Klimawandel ist noch weitgehend unbekannt und bleibt die größte Unsicherheitsquelle bei der Berechnung der Auswirkungen von Treibhausgasen auf unser Klima [16]. Das IPCC kann nicht sagen, ob der Nettoeffekt einer zunehmenden Bewölkung die Erde erwärmt oder abkühlt. Da die Bildung und Auflösung von Wolken nicht modelliert werden kann [17], wird ihre Wirkung vom IPCC ignoriert oder einfach „parametrisiert“ [18].

Beim meridionalen Wärmetransport wird Energie zwischen dem Klimasystem und dem Weltraum nur über die Obergrenze der Atmosphäre ausgetauscht, was dazu führt, dass der globale meridionale Wärmetransport zwangsläufig einen Netto-Nullwert hat, wenn er sofort über das gesamte globale Klimasystem integriert wird. Die Verlagerung von Energie von einer Region in eine andere verändert nicht die Gesamtenergiemenge im System, obwohl sie die Verweilzeit der Energie verändern kann und dies auch tut. Indem der IPCC die Auswirkungen veränderter Konvektionsmuster auf die Verweildauer der Energie ignoriert hat, ist er zu dem Schluss gekommen, dass der meridionale Wärmetransport keine wesentliche Ursache für den Klimawandel sein kann, was sein fundamentalster Fehler ist [19].

Sowohl aus thermodynamischer als auch aus dynamischer Sicht ist das entscheidende Merkmal des Klimasystems der Erde der Energietransport. Der Energietransport ist die Ursache für jedes Wetter, insbesondere für alle Wetterextreme. Der größte Teil der nicht vom Planeten reflektierten Sonnenenergie wird in den Ozeanen gespeichert, wo 99,9 % [20] der „Wärm“ oder thermischen Energie des Klimasystems gespeichert sind. Allerdings transportieren die Ozeane die Energie nicht besonders gut. Unterschiede in der Wassertemperatur führen eher zu vertikalen Bewegungen durch veränderten Auftrieb als zu lateralen Bewegungen, so dass die Ozeane temperaturgeschichtet sind. Der größte Teil der Energie im Klimasystem wird von der Atmosphäre transportiert, und die Energie, die von den Oberflächenströmungen des Ozeans lateral transportiert wird, wird von den Winden angetrieben [21]. Der Fluss der nicht-solaren Energie an der Grenze zwischen Atmosphäre und Ozean (einschließlich über das Meereis) erfolgt fast immer und fast überall vom Ozean zur Atmosphäre [22].

In diesen ersten fünf Teilen werden die schwerwiegendsten systematischen Verzerrungen im IPCC-Bericht AR1 aufgezeigt, Climate Change 2021: The Physical Science Basis. Die Voreingenommenheit wird durch das Ignorieren der in dieser Reihe von Beiträgen und zahlreichen anderen ähnlichen Artikeln zitierten gültigen, von Experten begutachteten Artikel hervorgerufen, so dass es sich größtenteils um „Berichterstattung“ oder „Bestätigung“ handelt. Die Beweise dafür, dass die Sonnenvariabilität das Klima der Erde beeinflusst, sind enorm und in der Literatur gut belegt, wie Douglas Hoyt und Kenneth Schatten in ihrem ausgezeichneten Buch The Role of the Sun in Climate Change [23] und Joanna Haigh in ihrem Bericht Solar Influences on Climate [24] dargelegt haben.

Doch diese grundlegenden Werke sowie die vielen Arbeiten in der Bibliographie werden vom IPCC ignoriert oder als unwichtig abgetan. Darüber hinaus werden viele der Hunderte von Arbeiten, die in Connolly et al. [25] und im Kapitel von Nicola Scafetta und Fritz Vahrenholt [26] in The Frozen Climate Views of the IPCC zitiert werden, im AR6 ebenfalls ignoriert.

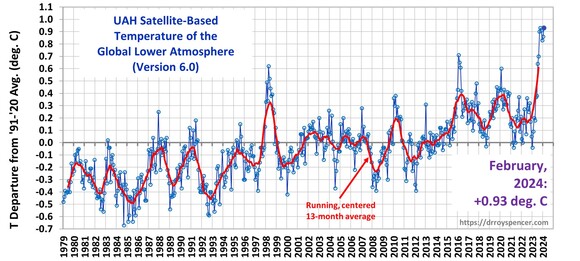

Es ist gut dokumentiert, dass die IPCC/CMIP6-Klimamodelle im Vergleich zu den Beobachtungen viel zu warm laufen [27]. Sie überschätzen die tropische Temperatur in der mittleren Troposphäre,[28] die Meerestemperatur [29] und die globale Erwärmung im Allgemeinen [30]. Diese Verzerrung wird im AR6 selbst eingeräumt, wo sie schreiben:

„Daher schätzen wir mit mittlerem Vertrauen ein, dass die CMIP5- und CMIP6-Modelle die beobachtete Erwärmung in der oberen tropischen Troposphäre über den Zeitraum 1979-2014 um mindestens 0,1°C pro Jahrzehnt überschätzen, was zum Teil auf eine Überschätzung des tropischen SST-Trendmusters über diesen Zeitraum zurückzuführen ist.“ [31] – AR6 WGI, Seite 444

Die IPCC/CMIP6-Klimamodelle simulieren nicht nur eine stärkere Erwärmung als beobachtet, sie „driften“ auch in ihren Berechnungen mit der Zeit ab. Bei den meisten Modellen läuft dies in Richtung einer stärkeren Erwärmung, was die natürliche Tendenz der Modelle noch verstärkt, heiß zu laufen. Außerdem schließen sich die Energie- und Massenbudgets in einzelnen Modellläufen nicht richtig, was gegen die physikalischen Gesetze der Massen- und Energieerhaltung verstößt [32]. In mancher Hinsicht schneiden die CMIP6-Modelle besser ab als die CMIP5-Modelle, in anderen jedoch schlechter, was darauf hindeutet, dass die Modelle mit der Zeit nicht besser werden und möglicherweise das Ende ihrer Nutzungsdauer erreicht haben.

Unerzwungene Modelldrift kontaminiert die erzwungenen (d. h. sich ändernden CO₂- oder Vulkanismus-)Trends. In einigen Modellen macht die Drift einen erheblichen Teil der berechneten Erwärmung aus. Sie resultiert aus der Parametrisierung von Größen, die nicht modelliert werden können, wie z. B. die Wolkenbedeckung, und aus einem Ungleichgewicht zwischen dem vorgeschriebenen Anfangszustand des Modells aufgrund von Beobachtungen und der im Modell programmierten Physik.

Ein weiterer Schuldiger kann der „Kopplungsschock“ sein, wenn die verschiedenen Modellkomponenten zusammengeführt werden wie die Ozean- und die atmosphärischen Komponenten, manchmal auch „Grenzschock“ genannt. Es genügt zu sagen, dass die Tatsache, dass Masse und Energie in diesen Modellen nicht konserviert sind und sie driften, ein echtes und bedeutendes Problem darstellt. Die Modelldrift ist einfach der Versuch des Modells, einen stabilen Zustand zu erreichen, nachdem die Start- (oder Spin-up-)Schocks aufgetreten sind. Das Gleichgewicht wird nach dem Spin-up erst nach über tausend Jahren erreicht, so dass es nicht praktikabel ist, das Modell so lange laufen zu lassen, nur um die Drift loszuwerden. Wenn die Modelle um die Drift korrigiert werden, verringern sich in der Regel die Probleme mit der Massen-/Energieerhaltung [33], doch die Diskrepanz zwischen der Modellphysik und dem ursprünglichen Modellzustand, der sich aus Beobachtungen ergibt, ist an sich schon beunruhigend.

Aus der Sicht dieses Modellierers hat sich das konzeptionelle Modell oder die Hypothese als falsch erwiesen, welche mit dem CMIP6 und seinen Vorgängern untersucht werden sollte. Diese Beobachtung kann nur durch die Einführung von immer mehr Verzerrungen kaschiert werden. Aber je mehr Verzerrungen in die Modelle und in die Interpretation der Ergebnisse einfließen, desto offensichtlicher werden diese auch. Es ist an der Zeit, aufzuhören und eine neue Hypothese und ein neues konzeptionelles Modell zur Untersuchung zu entwickeln, die Idee des „CO₂-Kontrollknopfes“ ist tot [34].

In Teil 6 befasse ich mich mit der Modellverzerrung in der WGII.

Download the bibliography here.

Link: https://andymaypetrophysicist.com/2024/03/08/climate-model-bias-5-storminess/

Übersetzt von Christian Freuer für das EIKE