Ein Fehler der Physik: Vernachlässigung der Sonne

Lord Christopher Monckton of Brenchley

Hintergrund

Die WESTLICHEN NATIONEN haben sich selbst einen erheblichen Nachteil bei den Handelsbedingungen zugefügt, indem sie bei der Verringerung der Treibhausgas-Emissionen fast im Alleingang handelten. Der weitgehend totalitäre Osten baut seine Kohle-, Öl- und Gasinfrastruktur weiter stark aus, während der weitgehend demokratische Westen teure und unzuverlässige Wind- und Solarenergie installiert. So sind die Strompreise im Westen bereits sechs- bis achtmal so hoch wie im Osten, so dass unsere überteuerten Energiepreise unsere Unternehmen vertreiben. Es stellt sich die Frage, ob das Opfer des Westens wirklich notwendig ist.

Die Besorgnis über die globale Erwärmung ist in der Tat fehl am Platze. Einige Jahre lang haben verblendete Klimawissenschaftler eine gelehrte Arbeit eines internationalen Teams herausragender Forscher unterdrückt. Die Studie entlarvt einen schwerwiegenden Fehler bei der Berechnung der von uns verursachten Erwärmung. Das vorliegende wissenschaftliche Informationsblatt erläutert den Fehler und seine schwerwiegenden wirtschaftlichen Folgen für den Westen. Eine Kopie der Studie folgt im Anschluss an die Erklärung der STAG in verständlicher Sprache.

Die Forscher, die den Fehler entdeckt haben, haben unter den das offizielle Narrativ unterstützenden Wissenschaftlern sehr gelitten, da diese ihren peinlichen Fehler nur ungern zugeben. Die STAG ist der Ansicht, dass sie nicht deshalb schlecht behandelt wurden, weil sie im Unrecht sind, sondern weil sie Recht haben.

Ein Professor für Klimatologie und ehemaliger Direktor des US-Forschungsprogramms zum globalen Wandel wurde von seinem Dekan so lange schikaniert, bis er vorzeitig von seinem Lehrstuhl zurücktrat.

Ein deutscher Professor für Kontrolltheorie, einem von den Klimawissenschaftlern entlehnten und missverstandenen Bereich der Ingenieurphysik, wurde vom Präsidenten seiner Universität angewiesen, seinen Namen aus der Studie zu entfernen, obwohl der Präsident zugab, dass er keinen Fehler darin finden konnte. Der Professor wandte sich an seine Regionalregierung, deren Aufgabe es ist, die akademischen Freiheiten zu schützen. Ihm wurde gesagt, dass es in Deutschland keine Meinungsfreiheit mehr gibt.

Ein preisgekrönter Sonnenastrophysiker wurde aus seiner Institution gejagt, weil er in einer früheren Studie auf die Existenz des hier beschriebenen Fehlers hinwies. Außerdem wurde er in großen US-amerikanischen und europäischen Zeitungen und wissenschaftlichen Zeitschriften verleumdet.

Ein Mitglied einer britischen Universität wurde aufgrund einer erfundenen Anschuldigung von der Universität verwiesen, als ein Gutachter der Studie dem Vizekanzler seiner Universität mitteilte, dass er sie nicht widerlegen könne. Der Vizekanzler wies die umweltwissenschaftliche Fakultät an, alles fallen zu lassen und die Studie zu widerlegen. Als sie die Arbeit nicht widerlegen konnten, wurde der Autor der Universität verwiesen.

Das Peer-Review-Verfahren versagt. Mehrere Klimajournale haben sich geweigert, die Studie zu veröffentlichen, obwohl die Gutachter keinen wirklichen Fehler darin finden konnten. Eine Zeitschrift behielt den Artikel zweieinhalb Jahre lang und weigerte sich, Folgebriefe des Hauptautors zu beantworten, bevor sie ihn ablehnte und den Einspruch der Autoren ignorierte. Eine andere Zeitschrift, die jede Studie ablehnt, die das offizielle Narrativ in Frage stellt, weigerte sich, die Studie zur Begutachtung einzureichen. Eine dritte Zeitschrift lieferte zwei wissenschaftsfeindliche Rezensionen. Eine vierte Zeitschrift stellte mehrere formelhafte Fragen, die von den Autoren leicht zu beantworten waren.

Nach Einschätzung der STAG hat die Studie durchaus ihre Berechtigung. Wenn sie stichhaltig ist, sind Maßnahmen zur Eindämmung des Klimawandels unnötig.

Ein Fehler der Physik: Vernachlässigung der Sonne

Die beigefügte wissenschaftliche Studie zeigt, dass Klimawissenschaftler in den 1980er Jahren einen Fehler begingen, als sie Rückkopplungs-Rechnungen aus der Regelungstheorie der technischen Physik entlehnten, ohne sie zu verstehen. Obwohl die Sonne, der dominierende Einfluss auf das Klima, 90 % der globalen Temperatur direkt beeinflusst, haben sie es an einem entscheidenden Punkt ihrer Berechnungen zur globalen Erwärmung versäumt, die Tatsache zu berücksichtigen, dass die Sonne scheint. Dieser Fehler führte dazu, dass sie die globale Erwärmung um das 2- bis 3-fache zu hoch vorhersagten.

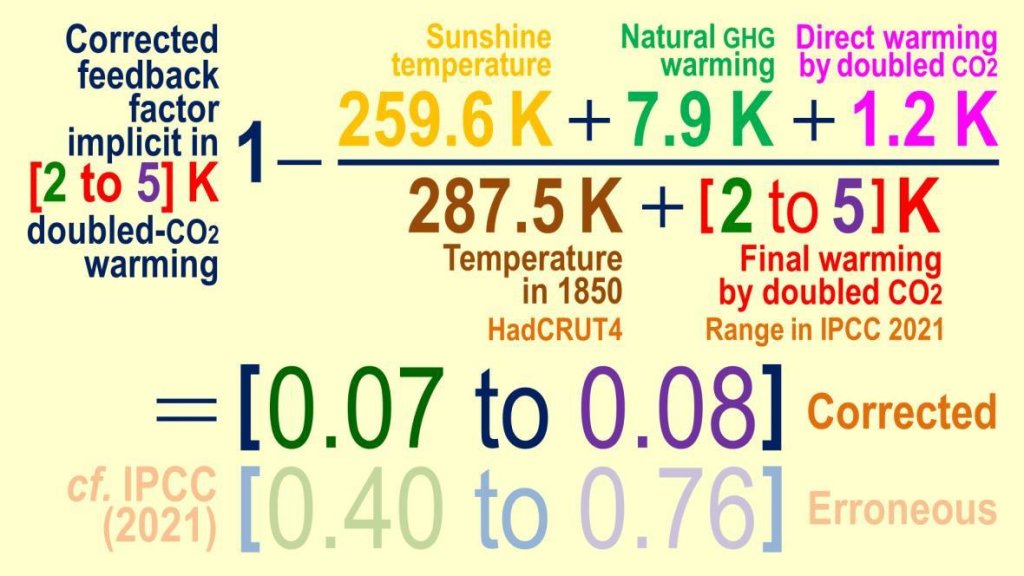

Im Jahr 1850 betrug die durchschnittliche Temperatur 287,5 Kelvin (15 °C), die Summe aus der Sonnenscheintemperatur von 259,6 Kelvin, die ohne Treibhausgase und vor dem Einsetzen von Rückkopplungen herrschen würde, 7,9 Grad natürlicher direkter Erwärmung durch vorindustrielle Gase und 20 Grad Rückkopplung. Die Sonnenscheintemperatur entsprach also 90 % der Temperatur im Jahr 1850:

2007 wurde Sir John Houghton, der erste wissenschaftliche Vorsitzende des IPCC gefragt, warum aus wenig mehr als einem Grad direkter Erwärmung durch die Verdopplung des CO₂-Gehalts in der Luft eine endgültige Erwärmung von vier Grad werden könnte. Er sagte, dass die zusätzlichen 3 Grad auf Rückkopplungen zurückzuführen sind, d. h. auf eine zusätzliche Erwärmung, die durch eine direkte Temperatur verursacht wird und proportional zu dieser ist. Der einzige Rückkopplungsprozess von Bedeutung ist die Wasserdampf-Rückkopplung. Wenn wir die Luft direkt erwärmen, kann sie mehr Wasserdampf transportieren, der selbst ein Treibhausgas ist, was eine zusätzliche Erwärmung bewirkt – eine Rückkopplung. Alle anderen Rückkopplungen heben sich im Großen und Ganzen gegenseitig auf.

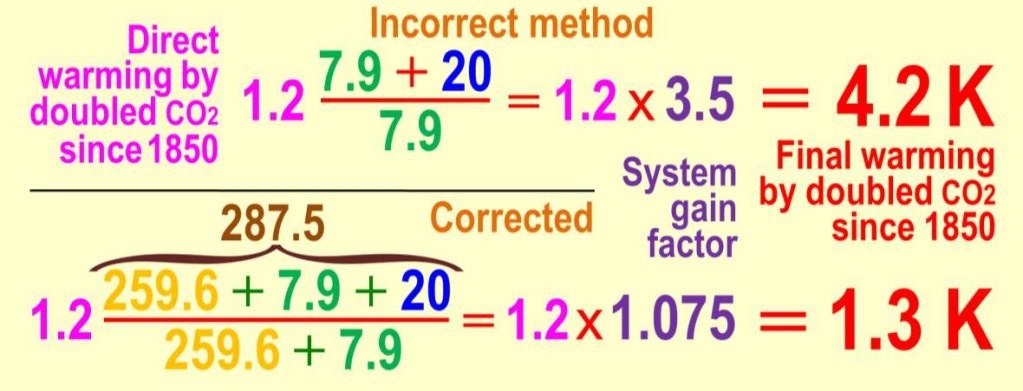

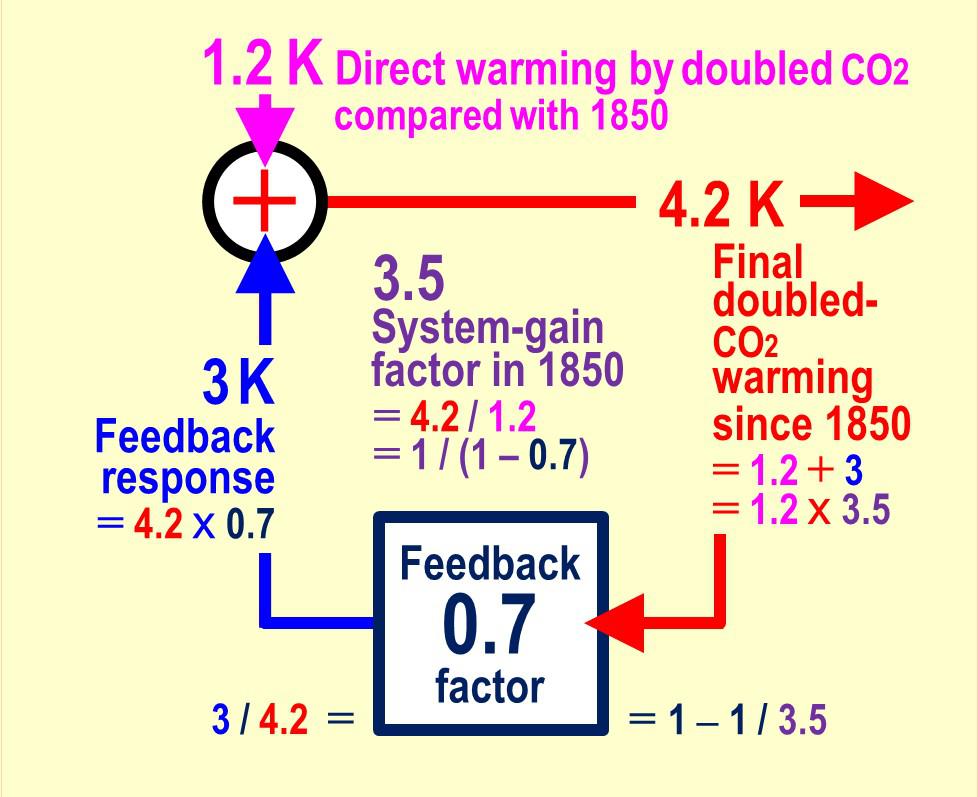

Sir John multiplizierte die direkte Verdoppelung der Erwärmung um 1,2 Grad mit einem Systemverstärkungsfaktor, um die Rückkopplung zu berücksichtigen und die endgültige Erwärmung zu erhalten, nachdem sich das Klima auf eine neue Endtemperatur eingestellt hat. Im Jahr 1850 betrug der natürliche Treibhauseffekt 27,9 Grad: 7,9 Grad direkte Erwärmung durch natürliche Treibhausgase plus 20 Grad Rückkopplungseffekt. Sein Systemverstärkungsfaktor betrug also 27,9 / 7,9 oder 3,5, so dass seine endgültige Erwärmung 1,2 x 3,5 oder 4,2 Grad betrug:

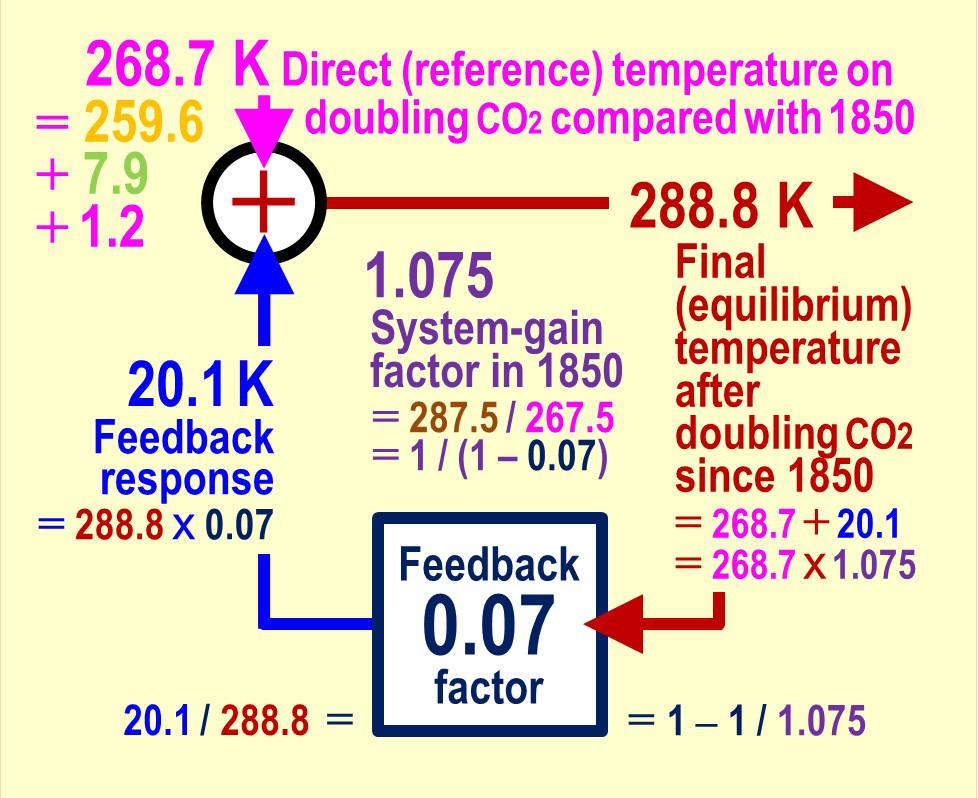

Sir John hatte nicht erkannt, dass Rückkopplungen nicht nur auf die direkte Erwärmung durch Treibhausgase reagieren, sondern auch auf die Sonnenscheintemperatur von 259,6 Kelvin. Der Systemverstärkungsfaktor für 1850 war nicht 27,9 / 7,9 oder 3,5. Er betrug (259,6 + 27,9) / (259,6 + 7,9), also nur 1,075. Die endgültige Erwärmung durch verdoppeltes CO₂ würde dann nicht 1,2 x 3,5 oder 4 Grad betragen, sondern 1,2 x 1,075 oder nur 1,3 Grad.

Elemente der Kontrolltheorie, die Königsdisziplin der Rückkopplungen

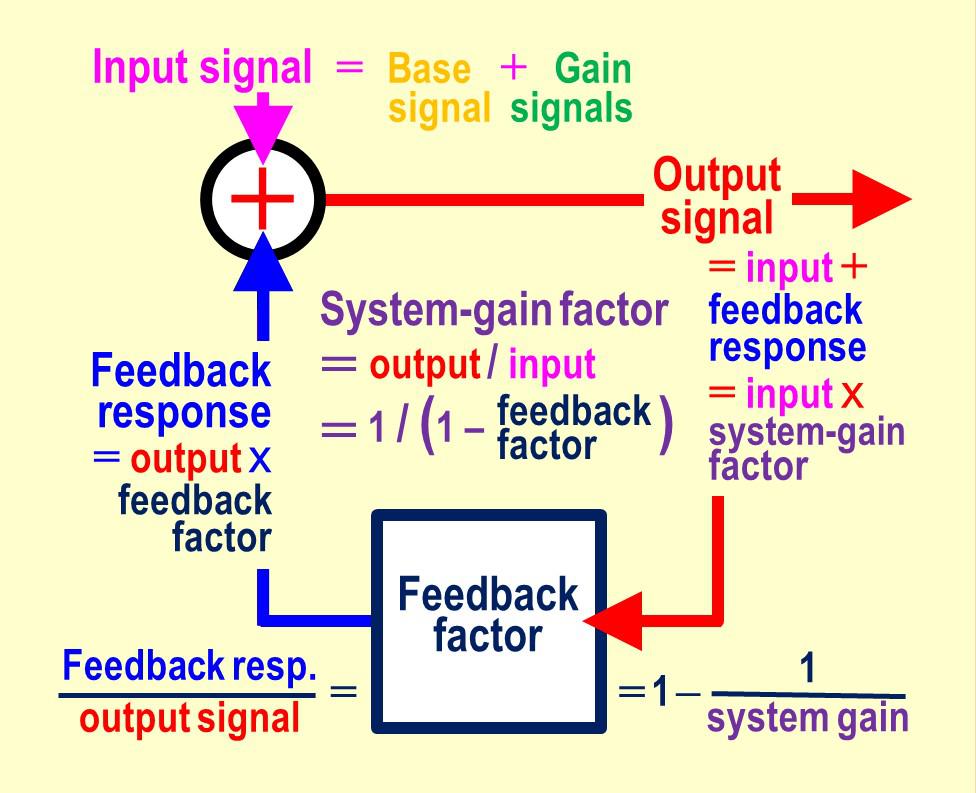

Die Rückkopplungsanalyse ist das Herzstück aller offiziellen Verfahren zur Vorhersage der globalen Erwärmung. Die Rückkopplungsrechnung ist für alle dynamischen Systeme (Systeme, die ihren Zustand im Laufe der Zeit ändern) gleich, von Uhren, Raketen und elektronischen Verstärkern bis hin zum Klima.

Temperatur-Rückkopplungen funktionieren wie in einem elektronischen Schaltkreis, aber die Rückkopplungssignale im Klima sind Temperaturen und nicht Spannungen.

Die Signale von Basis und Verstärkung bilden den Eingang (oben rechts). Das Signal folgt den Pfeilen unendlich oft durch die Schleife. Dann ist die Rückkopplungsantwort plus Eingang der Ausgang; der Ausgang mal Rückkopplungsfaktor ist die Rückkopplungsantwort; der Ausgang geteilt durch den Eingang ist der Systemverstärkungsfaktor; und 1 minus den Kehrwert des Systemverstärkungsfaktors ist der Rückkopplungsfaktor. Offensichtlich muss der Rückkopplungsfaktor auf das gesamte Eingangssignal reagieren. Rückkopplungen sind leblos. Sie können nicht wählen, auf welchen Teil der Eingangstemperatur sie reagieren sollen.

Geben wir einige Zahlen in die Methode unserer Klimawissenschaftler ein (Mitte), wobei wir die 259,6 Kelvin Sonnenscheintemperatur weglassen, und dann (unten) nach der korrekten Methode, wobei wir sie einbeziehen.

Der Fehler wird korrigiert, indem man die Sonnenscheintemperatur von 259,6 Kelvin und die direkte Erwärmung von 7,9 Grad durch natürliche Treibhausgase zu den 1,2 Grad direkter Erwärmung durch verdoppeltes CO₂ addiert, um ein wahres Eingangssignal von 268,7 Grad zu erhalten. Der wahre Rückkopplungsfaktor, der in der Methode der Klimawissenschaftler mit 0,7 angegeben wird, beträgt in Wirklichkeit nur 0,07, also ein Zehntel davon. Ihr Fehler ist groß.

Die wahre Rückkopplung beträgt 20,1 Grad, nur 0,1 Grad über den 20 Grad von 1850. Wenn, was wahrscheinlich ist, das Rückkopplungsregime so bleibt wie 1850, wird die Rückkopplungsreaktion nur sehr wenig zur globalen Erwärmung beitragen. Die Endtemperatur nach der CO₂-Verdoppelung beträgt 288,8 Kelvin, 1,3 Grad über den 267,5 Grad von 1850. Diese 1,3 Grad sind weniger als ein Drittel der 4,2 Grad, die Klimamodelle vorhersagen, und weniger als die Hälfte der besten Schätzung des IPCC von 3 Grad. Die Netto-Null-Emissionspolitik wird derzeit auf der Grundlage der besten Vorhersagen der Klimamodelle gemacht. Nach Korrektur des Fehlers werden diese extremen Vorhersagen jedoch so unwahrscheinlich, dass eine Abschwächung der globalen Erwärmung unnötig wird, wie einige weithin unbekannte Fakten bereits zeigen:

● Obwohl sich die Weltbevölkerung im letzten Jahrhundert vervierfacht hat, sind die jährlichen Todesfälle durch extreme Wetterbedingungen um 96 % zurückgegangen, so das U.S. Office for Foreign Disaster Assistance und das Centre for Research into the Epidemiology of Disasters.

● Mehrere Studien in The Lancet zeigen, dass der Kältetod in jeder Region zehnmal wahrscheinlicher ist als der Hitzetod, in Afrika sogar 40-mal wahrscheinlicher. Kälte ist der wahre Killer.

● Die Ernteerträge sind auf einem Rekordhoch. Hungersnöte sind jetzt selten. Durch CO₂-Düngung ist die Gesamtbiomasse der Bäume und Pflanzen in den letzten Jahrzehnten um 15 % gestiegen, denn CO₂ ist Pflanzennahrung.

Warum die Rückkopplungsanalyse nicht für Vorhersagen der globalen Erwärmung verwendet werden kann

Bei der korrigierten Berechnung wurde (nicht zu Unrecht) davon ausgegangen, dass sich das Rückkopplungssystem seit 1850 nicht verändert hat. Es könnte sich aber geändert haben. Diese Möglichkeit macht die Rückkopplungsanalyse für die Vorhersage der globalen Erwärmung wertlos. Um zu sehen warum, muss man sich von der vorhergesagten Spanne von 2 bis 5 Grad der endgültigen Erwärmung zurück arbeiten, um die implizite Spanne der korrigierten Rückkopplungsfaktoren zu finden:

Ein echter Rückkopplungsfaktor von 0,07 bis 0,08, mit einer Schwankungsbreite von nur 0,01, würde also eine endgültige Erwärmung von 2 bis 5 Grad ergeben. Da jedoch Klimamessungen unsicher sind, können Rückkopplungsfaktoren weder direkt gemessen noch durch theoretische Verfahren mit einer Genauigkeit von nur 0,01 abgeleitet werden. Zum Vergleich: Die impliziten Rückkopplungsfaktoren des IPCC (2021) sind mit 0,40 bis 0,76 bis zu achtmal zu groß mit einem 36-mal zu großen Bereich.

Nach der Korrektur ist der Rückkopplungsfaktor so klein und sein Bereich so eng, dass alle offiziellen Vorhersagen, einschließlich derjenigen in den sechs Sachstandsberichten des IPCC, nicht besser als Vermutungen sind.

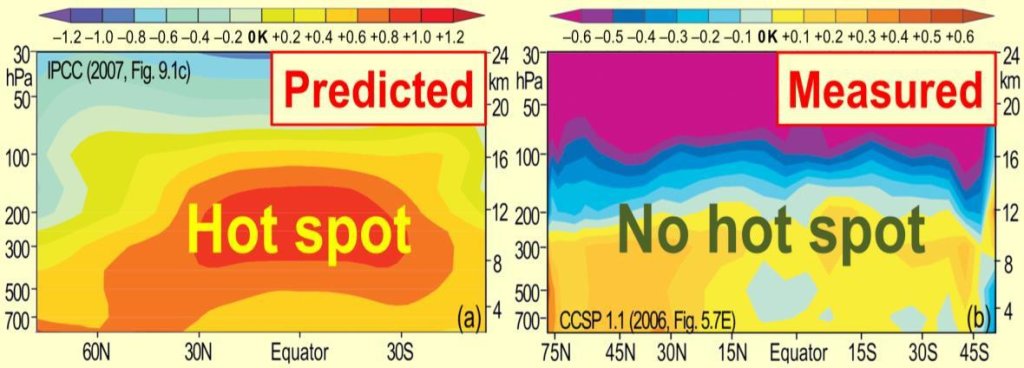

Der fehlende „Hot Spot“: ein Beweis für den Irrtum in der Realität

Klimawissenschaftler glauben, dass die Wasserdampf-Rückkopplung groß ist, weil ihre Modelle vorhersagen, dass bei einer direkten Erwärmung der Luft der Wasserdampfgehalt in einer Höhe von 10 km in den Tropen ansteigt und die obere Luft doppelt so schnell erwärmt wie die tropische Oberfläche. In Wirklichkeit ist der Wasserdampfgehalt in der oberen Luft seit einem Jahrhundert rückläufig. Daher zeigen Temperaturmessungen, dass der tropische „Hot Spot“ in der oberen Luft nicht vorhanden ist, was bestätigt, dass die Rückkopplung in der Tat gering sein muss:

Wie man die globale Erwärmung ohne Rückkopplungsanalyse vorhersagen kann

Mehrere Verfahren zur Vorhersage der globalen Erwärmung unabhängig von der Analyse von Rückkopplungen werden weniger beachtet, als sie sollten, da sie zusammen genommen eine viel geringere Erwärmung zeigen als die fehlerhafte Methode der Klimawissenschaftler, die von einer fehlerhaften Analyse von Rückkopplungen abhängig ist:

Verfahren 1: Die offiziell vorhergesagte endgültige Erwärmung durch verdoppeltes CO₂ im Vergleich zu 1850 – das Standardmaß – beträgt 2 bis 5 Grad, aber nach Einbeziehung der Sonnenscheintemperatur beträgt der korrigierte Wert nur 1,3 Grad, von denen 0,4 Grad bereits eingetreten sind, so dass weniger als 1 Grad weitere Erwärmung bis 2100 übrig bleibt. Das ist einfach zu wenig und wird nur Gutes bewirken.

Verfahren 2: 1990 sagte der IPCC eine globale Erwärmung von 0,2 bis 0,5 Grad/Dekade von 1990-2090 voraus (ein Zehntel der von ihm vorhergesagten endgültigen Erwärmung von 2 bis 5 Grad bei verdoppeltem CO₂). Seit 1990 wurden jedoch nur 0,14 Grad pro Dekade beobachtet. Die endgültige Erwärmung durch verdoppeltes CO₂ im Vergleich zu 1850 (die in etwa der vorhergesagten endgültigen Erwärmung im 21. Jahrhundert entspricht) könnte also nur 1,3 Grad betragen, was die korrigierte Schätzung von 1,3 Grad auf der Grundlage des Rückkopplungsregimes von 1850 bestätigt.

Verfahren 3: Mit dem statistischen Monte-Carlo-Verfahren können Zufallswerte innerhalb der Grenzen der fünf Parameter der Energiebudget-Gleichung eingegeben werden. Eine Milliarde Versuche zeigen, dass die Erwärmung im 21. Jahrhundert mit 95-prozentiger Sicherheit 1,3 Grad betragen wird, mit einer Bandbreite von 0,9 bis 2 Grad.

Ein Fehler der Physik: Schlussfolgerung

Der Westen wurde durch einen schwerwiegenden physikalischen Irrtum in die Irre geführt, den die Klimawissenschaftler, die vergessen haben, dass die Sonne scheint, nur widerwillig korrigieren wollen. Diejenigen, die den Irrtum aufgedeckt haben, waren Schikanen ausgesetzt, weil sie in Frage gestellt haben, was zu einer unanfechtbaren Orthodoxie geworden ist. Sie werden hier nicht namentlich genannt: Ihr Ergebnis spricht für sich selbst. In der Zwischenzeit profitieren die Länder des größtenteils totalitären Ostens von ihrem kontinuierlichen – und bzgl. des Klimas unbedenklichen – Ausbau der Kohleverstromung, so dass ihre Strompreise weniger als ein Sechstel der unseren betragen, die durch die absurd hohen Kosten für das Erreichen von Net Zero aufgebläht sind, auf die wir nun eingehen werden. Auch die Rolle der Einflussnehmer bestimmter Nationen bei der Förderung des offiziellen Klimanarrativs im Westen und bei der Schädigung des Rufs derjenigen Forscher, die es gewagt haben, dieses Narrativ in Frage zu stellen, sollte nicht unterschätzt werden.

Ein wirtschaftlicher Irrtum: Die Kosten-Nicht-Wirksamkeit von Netto-Null

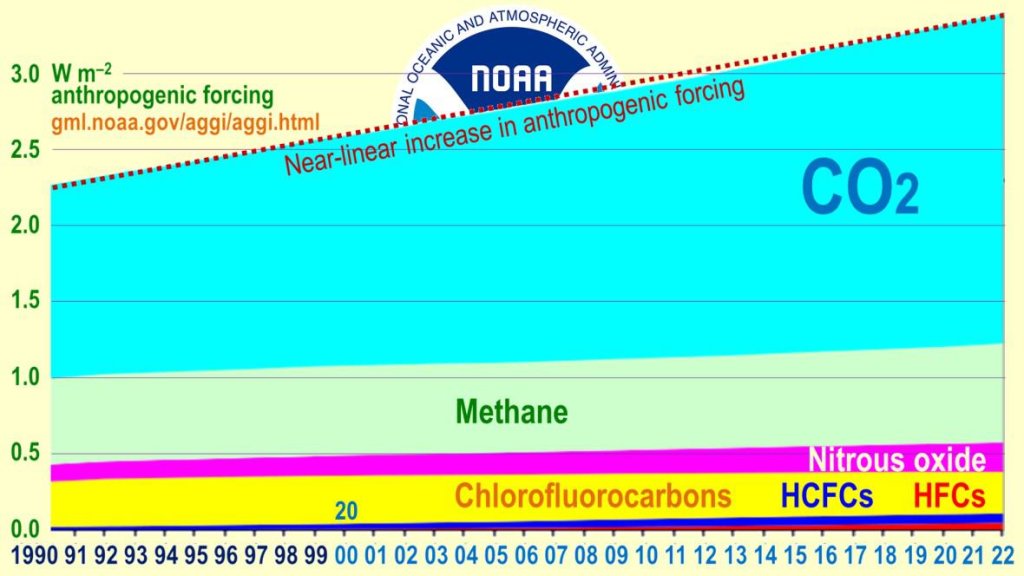

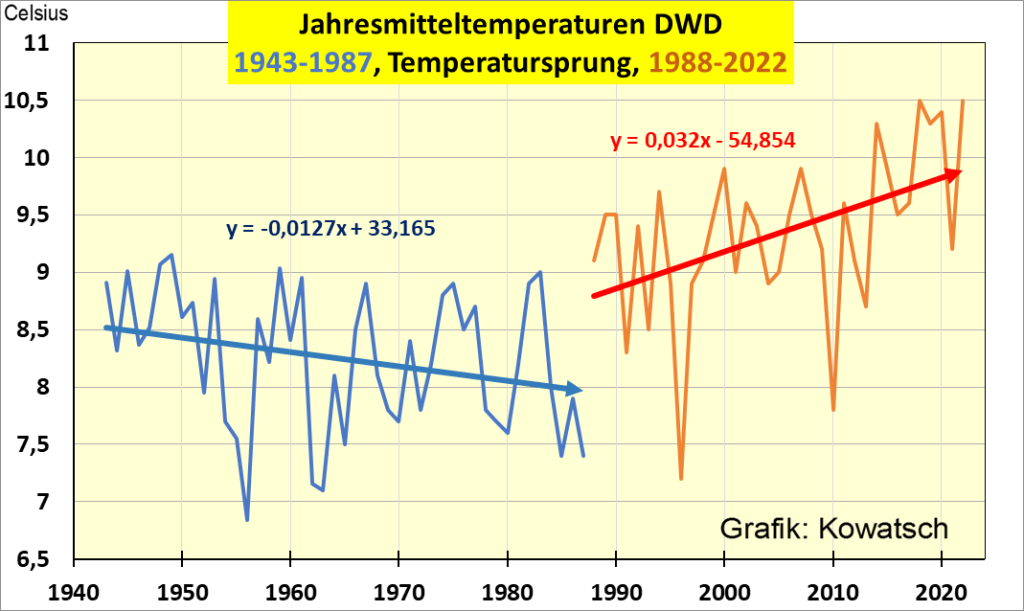

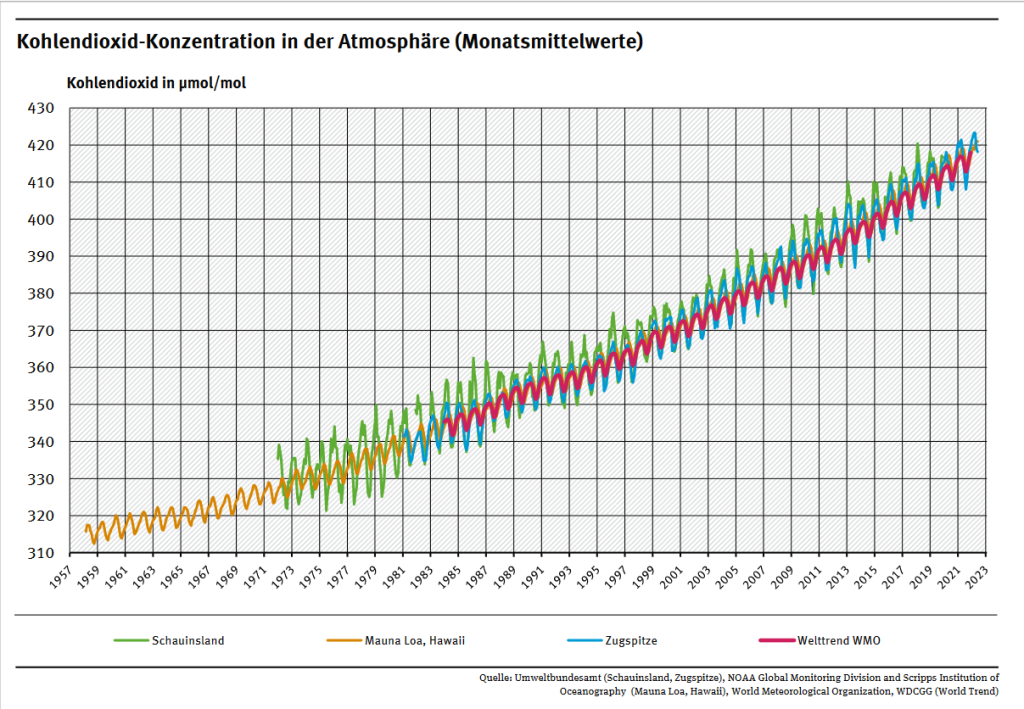

Der gravierende physikalische Irrtum der Klimawissenschaftler ist kostspielig. Die Billionen, die unnötigerweise für den Versuch zur Eindämmung der globalen Erwärmung ausgegeben worden waren, haben an der Steigerungsrate unseres Einflusses auf das Klima überhaupt nichts geändert. Sie steigt seit einem Dritteljahrhundert mit unverminderter Geschwindigkeit geradlinig an:

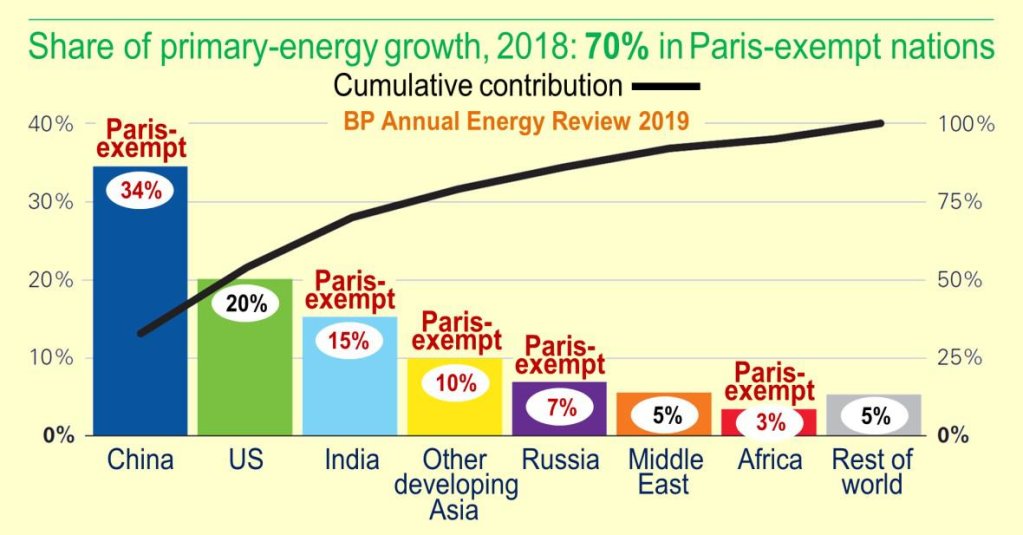

Das Pariser Klimaabkommen zielt selektiv auf den Westen ab. Die großen Nationen des Ostens – Russland und China, Indien und Pakistan – bauen weiterhin billige, effiziente und heutzutage auch saubere Kohlekraftwerke. Doch aufgrund eines physikalischen Fehlers verlagern die westlichen Demokratien ihre Produktionsbetriebe in den weitgehend totalitären Osten, wo die Strompreise weniger als ein Sechstel der unseren betragen. So entfallen etwa 70 % des Primär-Energiezuwachses auf Länder, die vom Pariser Abkommen ausgenommen sind:

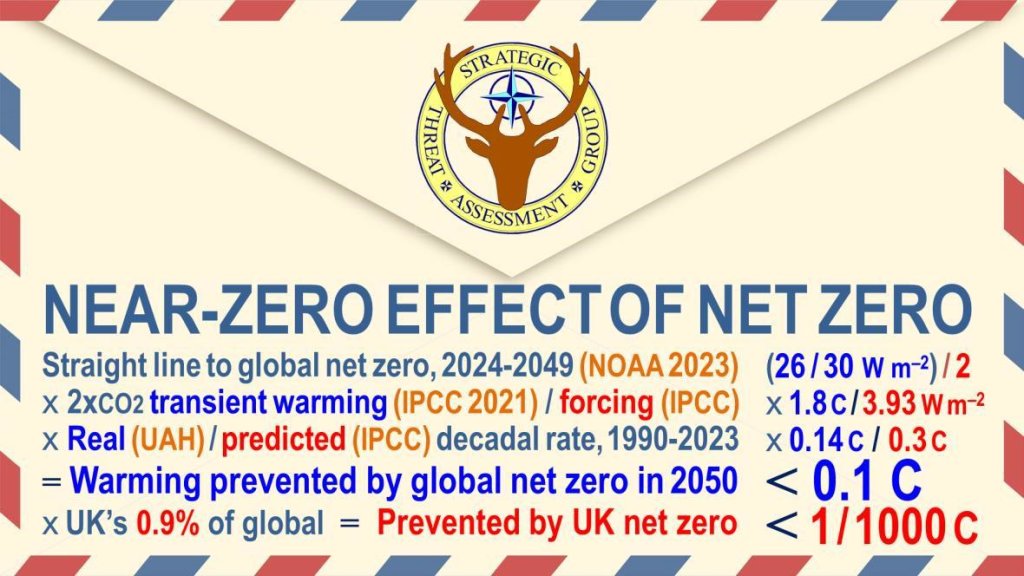

Falls die gesamte Welt ihre Volkswirtschaften zerstören und dadurch bis zum Zieljahr 2050 eine Netto-Null-Emission von Treibhausgasen erreichen würde, wie viel globale Erwärmung würde bis dahin verhindert werden? Unser Einfluss auf das Klima nimmt jedes Jahr um 1/30 einer Einheit zu. In den 26 Jahren bis 2049 würde der globale Netto-Nullpunkt also etwa die Hälfte der nächsten 26/30tel einer Einheit verringern.

Rechnet man die Einheiten in Temperaturänderungen um, indem man das Verhältnis der offiziell vorhergesagten Erwärmung im 21. Jahrhundert durch verdoppeltes CO₂ zum CO₂-Antrieb berücksichtigt. Nur ein Fünftel eines Grades Erwärmung würde verhindert – oder weniger als ein Zehntel eines Grades nach Korrektur der anhaltenden Überprognosen in den Klimamodellen. Net Zero im Vereinigten Königreich allein würde die globale Erwärmung um nur ein Tausendstel Grad reduzieren:

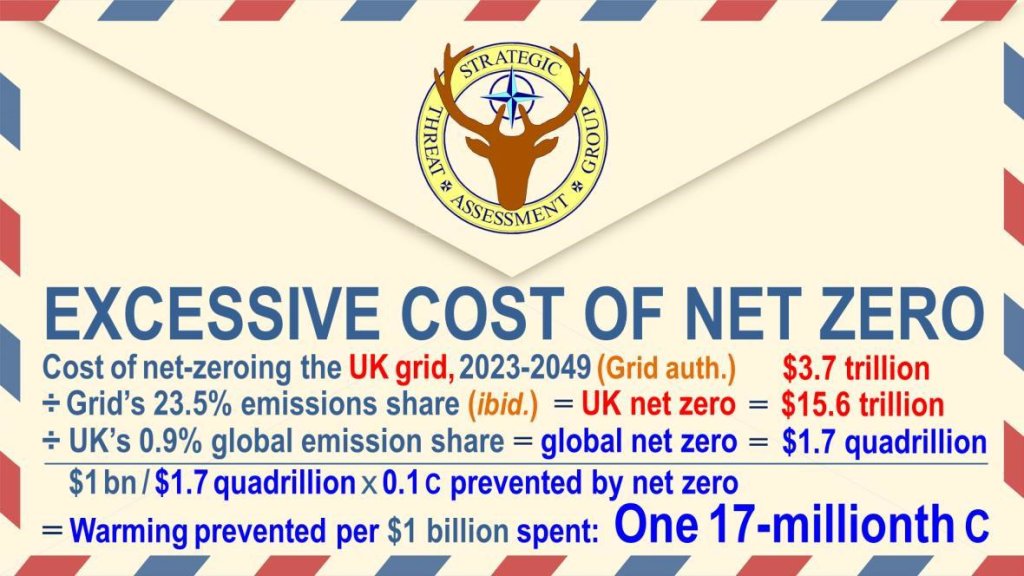

Was ist mit den Kosten? Lassen Sie uns die Rückseite eines zweiten Umschlags verwenden. Die britische Stromnetzbehörde schätzt die Kosten für die Vorbereitung des Netzes auf Net Zero auf 3,7 Billionen Dollar. Auf das Netz entfallen aber nur 23,5 % der britischen Gesamtemissionen. Pro rata würden sich die Kosten für die Vermeidung dieses einen Tausendstel Grades in Großbritannien also auf 15,6 Billionen Dollar belaufen. Großbritannien emittiert jedoch nur 0,9 % der weltweiten Emissionen, so dass eine globale Nullrunde mehr als 1,5 Billionen Dollar kosten würde:

So würde jede Milliarde Dollar, die weltweit für den Versuch ausgegeben wird, den Netto-Nullpunkt zu erreichen, weniger als ein Zehnmillionstel Grad globaler Erwärmung bis 2050 verhindern – das schlechteste Kosten-Nutzen-Verhältnis in der Geschichte, um ein Problem anzugehen, das laut der folgenden Studie ohnehin keines ist.

Übersetzt von Christian Freuer für das EIKE

Anmerkung: Diese Studie folgt im Original. Sie enthält viel Theorie und ist nur für Fachleute interessant. Daher wird hier auf die Übersetzung derselben verzichtet. Der oben übersetzte Text nebst der vollständigen Studie können in diesem PDF eingesehen werden:

[url=“https://eike-klima-energie.eu/wp-content/uploads/2023/11/stag-clima.pdf„]