Tony Brown

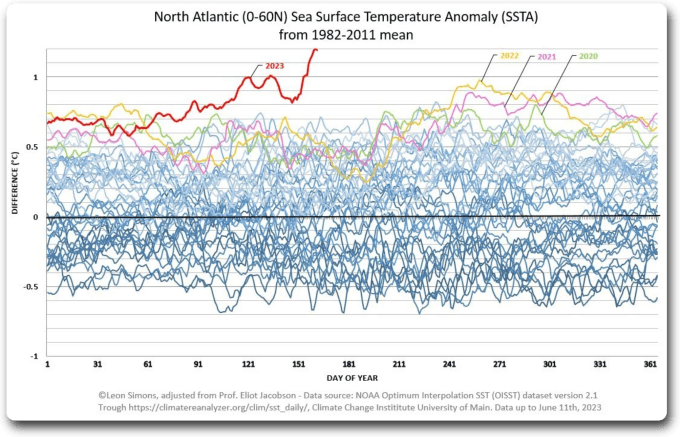

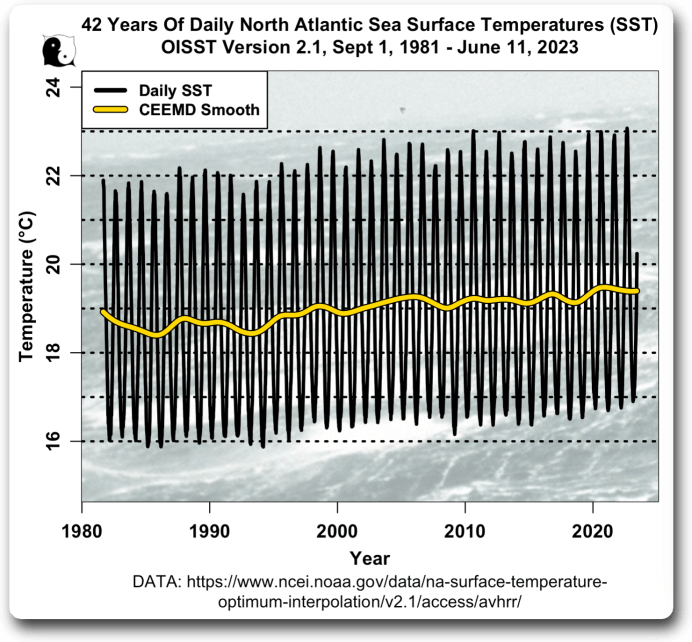

Vorbemerkung des Übersetzers: Dieser Beitrag ist schon älter, genauer gesagt stammt er aus dem Jahr 2011. Auch die hinterlegten Links sind natürlich die aus jener Zeit. Aber angesichts jüngster Meldungen über „extrem hohe Temperaturen im Nordatlantik“ und vor dem Hintergrund eines wahrscheinlichen neuen El Nino ist er heute noch hoch aktuell, weshalb er hier übersetzt wird. – Ende Vorbemerkung

Im Laufe der Jahre hat mich die Art und Weise fasziniert, in der historische Aufzeichnungen der Temperatur – die nie dazu gedacht waren, mehr als ein grobes Abbild des Mikroklimas um sie herum zu sein – verwendet wurden, als ob es sich um hochgenaue wissenschaftliche Daten handelte, und in der Folge zur Information der Politik genutzt wurden. Ich habe zwei Artikel über ihre historische Genauigkeit geschrieben, die beide über diesen Link abgerufen werden können.

Das ozeanische Äquivalent – die Meerestemperaturen (SST) – haben sogar noch zweifelhaftere Ursprünge als die Landtemperaturen, werden aber auch als wissenschaftliche Aufzeichnung wahrgenommen, die unser globales Verständnis der SST bis in die mittleren Jahrzehnte des 19. Jahrhunderts ebenfalls geprägt haben. In gewisser Weise sind sie sogar noch wichtiger als die Landtemperaturen, da der Ozean 70 % unseres Globus‘ ausmacht.

In diesem Artikel befassen wir uns mit den Verfahren zur Berechnung der SST – am bekanntesten ist das Hadley/Met Office, das die hier gezeigte Grafik der SST-Anomalien ab 1850 erstellt hat. Die Methodik wird vom Met Office Hadley Centre hier beschrieben:

„Die SST-Daten stammen aus dem International Comprehensive Ocean-Atmosphere Data Set, ICOADS, von 1850 bis 1997 und aus dem NCEP-GTS von 1998 bis heute. HadSST2 wird durch In-situ-Messungen der SST von Schiffen und Bojen erstellt, wobei Messungen, welche die Qualitätskontrollen nicht bestehen, zurückgewiesen werden, die Messungen in Anomalien umgewandelt werden, indem klimatologische Werte von den Messungen abgezogen werden, und ein robuster Mittelwert der resultierenden Anomalien auf einem monatlichen Gitter von 5° mal 5° Grad berechnet wird. Nach der Rasterung der Anomalien werden Verzerrungskorrekturen vorgenommen, um falsche Trends zu beseitigen, die durch Änderungen der SST-Messverfahren vor 1942 verursacht wurden. Für die gerasterten Monatsdaten wurden die Unsicherheiten aufgrund einer zu geringen Stichprobengröße berechnet, ebenso wie die Unsicherheiten bei den Verzerrungskorrekturen gemäß den in der Arbeit beschriebenen Verfahren.“

Wikipedia definiert die Meerestemperatur wie folgt:

„Die Meerestemperatur (SST) ist die Wassertemperatur in der Nähe der Oberfläche des Ozeans. Die genaue Bedeutung der Oberfläche variiert je nach verwendetem Messverfahren, liegt aber zwischen 1 Millimeter und 20 Metern unter der Meeresoberfläche.“

Die Komplexität der Definition der Meerestemperatur wird hier jedoch näher erläutert:

Die SST ist ein schwer genau zu definierender Parameter, da der obere Ozean (~10 m) eine komplexe und variable vertikale Temperaturstruktur aufweist, die mit den Turbulenzen im Ozean und den Wärme-, Feuchtigkeits- und Impulsflüssen zwischen Luft und Meer zusammenhängt. Definitionen der SST bieten einen notwendigen theoretischen Rahmen, der zum Verständnis des Informationsgehalts und der Beziehungen zwischen SST-Messungen durch verschiedene Satelliten- und In-situ-Instrumente verwendet werden kann.

Um herauszufinden, wie die grundlegenden SST-Daten physikalisch erfasst, verfeinert und anschließend als Grundlage für Informationen verwendet werden, die von Regierungen auf der ganzen Welt und in Verbindung mit der CRU als endgültige Aufzeichnung der globalen Land-/Meerestemperaturen genutzt werden, lohnt es sich, unsere Entdeckungsreise zu beginnen, indem wir den oben genannten Wikipedia-Artikel vollständig lesen;

„Es gibt eine Vielzahl von Verfahren zur Messung dieses Parameters, die zu unterschiedlichen Ergebnissen führen können, weil unterschiedliche Dinge gemessen werden. Außerhalb der unmittelbaren Meeresoberfläche werden allgemeine Temperaturmessungen mit einem Hinweis auf die spezifische Messtiefe versehen. Der Grund dafür sind die erheblichen Unterschiede zwischen Messungen in verschiedenen Tiefen, insbesondere tagsüber, wenn geringe Windgeschwindigkeiten und starke Sonneneinstrahlung zur Bildung einer warmen Schicht an der Meeresoberfläche und zu starken vertikalen Temperaturgradienten führen können (tageszeitliche Thermokline). Die Messungen der Meerestemperatur beschränken sich auf den oberen Teil des Ozeans, die so genannte oberflächennahe Schicht.“

[Es ist unklar, ob das heute noch genauso bei Wikipedia steht. Vielleicht hat einer der Kommentatoren etwas dazu. Mir fehlt die Zeit zur Recherche. A. d. Übers.]

Die Methoden zur Erfassung der Meerestemperaturen umfassen Messungen von Schiffen (Eimer und Motoreinlässe), auf der Meeresoberfläche schwimmende Bojen, Wetterschiffe und in den letzten Jahren den Einsatz einer Reihe von Tauchbojen („Argo“). Satellitenmessungen, die in den 1970er Jahren begannen, werden in diesem Artikel nicht behandelt. Alle Verfahren messen in unterschiedlichen Tiefen, von der obersten „Haut“ des Ozeans bei 0,01 mm bis zu Hunderten von Metern unter der Oberfläche, und daher kann ein Verfahren nicht ohne weiteres mit einem anderen verglichen werden, da die Temperatur je nach Tiefe wahrscheinlich erheblich variiert.

„Die Temperatur des Weltozeans ist an der Oberfläche sehr unterschiedlich und reicht von weniger als 0 °C in der Nähe der Pole bis zu mehr als 29 °C in den Tropen. Er wird durch das Sonnenlicht von der Oberfläche nach unten erwärmt, aber in der Tiefe ist der größte Teil des Ozeans sehr kalt. Fünfundsiebzig Prozent des Ozeanwassers fallen in den Temperaturbereich von -1 bis +6°C und in den Salzgehalt von 34 bis 35.“ (Referenz)

Die frühesten Messungen der Weltmeere und nicht der Küstengewässer wurden von Schiffen aus vorgenommen. Ein frühes Beispiel dafür war Benjamin Franklin, der auf seiner Reise zwischen den USA und Europa ein Quecksilberthermometer an ein Schiff hängte, als er im späten 18. Jahrhundert seine Beobachtungen bzgl. des Golfstromes durchführte. Die Temperaturen können jedoch relativ konstant sein, wenn es eine Strömung – wie den Golfstrom – gibt, die sich durch die verschiedenen Ebenen zieht, wie die folgenden Beispiele zeigen. Dies sind die ersten zuverlässigen Hinweise auf systematische und detaillierte Messungen der Meerestemperatur zu wissenschaftlichen Zwecken, die dem Autor bekannt sind. Sie stammen aus den 1820er Jahren, als die Royal Society Expeditionen unternahm, um das „beispiellose“ Abschmelzen der Arktis zu untersuchen.

„Eine Beobachtung, die an dieser Stelle interessant ist und die einen Beweis für den sehr geringen Unterschied zwischen der Oberflächentemperatur und der Temperatur in einer gewissen Tiefe liefert, wird in der Reise von Kapitän Graah, S. 21, erwähnt. Er sagt: „Am 5. Mai 1828 wurde in 57° 35′ nördlicher Breite und 36° 36′ westlicher Länge die Oberflächentemperatur auf 6°-3 und in einer Tiefe von 660 Fuß auf 5°5 + K. gemessen.“ Dies beweist, dass es an dem erwähnten Ort südöstlich von Cape Farewell keine kalte Unterwasserströmung gibt. Ein noch schlüssigeres Experiment wurde von Sir Edward Parry in seinem Bericht über seine erste Reise am 13. Juni 1819 aufgezeichnet: in 57° 51′ nördlicher Breite, 41° 5′ Länge. 41° 5′, mit einer sehr leichten südlichen Strömung, war die Oberflächentemperatur 4,4°C. und in 235 Faden 3,9°C, ein Unterschied von nur 0,5 K.“ (Referenz).

Jegliche Messung der Meeresoberfläche oder des tieferen Untergrunds vor der Mitte des 19. Jahrhunderts wird im Allgemeinen als von relativ begrenztem wissenschaftlichem Wert angesehen, da die Datenerfassung wenig einheitlich war.

1853 half Leutnant MF Maury bei der Organisation der internationalen Schifffahrtskonferenz in Brüssel, auf der sich alle teilnehmenden Länder darauf einigten, gemeinsame Verfahren zur Überwachung meteorologischer und mariner Informationen einzuführen, von denen die SST nur einen kleinen Teil ausmachte. Sein 1855 erschienenes Buch „The Physical Geography of the Sea“ wurde zur Pflichtlektüre.

Doch erst nach dem Zweiten Weltkrieg gewann die Wissenschaft der SST-Messung an Schwung, als neue und zuverlässigere Verfahren zu ihrer Messung entwickelt wurden, die während des Internationalen Geophysikalischen Jahres 1957/8 einen weiteren Auftrieb erhielten. Doch auch in den letzten Jahren hat der Ozean immer wieder für Überraschungen gesorgt. So wurde beispielsweise Mitte der 1990er Jahre entdeckt, dass die Strömungen in der Tiefsee sowohl viel stärker als auch viel variabler sind als bisher angenommen. In diesem Zusammenhang kann man sagen, dass die Entwicklung immer genauerer SST-Werte (wenn sie aus wissenschaftlichen Quellen stammen), auch wenn sie räumlich noch unvollständig sind, erst im letzten halben Jahrhundert stattgefunden hat. Davor gesammelte Daten sind mit einem großen Fragezeichen versehen, wie wir noch feststellen werden.

Kapitel 5 des Buches „Descriptive Physical Oceanography“ von M. P. M. Reddy beschreibt einige der verwendeten Methoden, ist aber vielleicht noch interessanter wegen der allgemeinen Vorgeschichte.

Angemessene wissenschaftliche Expeditionen, wie die der Royal Society in den 1820er Jahren, waren wahrscheinlich in der Lage, während eines kurzen Zeitfensters, bevor das Schiff weiterfuhr, die Meerestemperaturen für einen winzigen Abschnitt des Ozeans weitgehend genau (auf wenige Grad genau) zu bestimmen (vorbehaltlich aller relevanten Vorbehalte, die in dem Artikel über Landtemperaturen erwähnt wurden). Dann würde der Beobachter ein Stück Ozean abtasten, das möglicherweise völlig andere Temperatureigenschaften aufweist, denn wie jeder Schwimmer bestätigen wird, vermischt sich das Wasser nicht immer sehr gut, und wie bereits festgestellt, spielt die Tiefe eine entscheidende Rolle für die Temperatur.

Die meisten früheren Aufzeichnungen erfolgten jedoch nicht unter strengen wissenschaftlichen Bedingungen, sondern auf einer viel zwangloseren Ad-hoc-Basis durch Mitglieder der internationalen Seestreitkräfte und Fischer. Das Verfahren der Probenentnahme war recht einfach: Ein Holz- oder Segeltucheimer wurde an einem in Fadenlänge markierten Seil befestigt, das Ensemble über Bord geworfen, der Eimer anschließend angehoben und ein Thermometer hineingesteckt, um die Temperatur dieses kleinen Teils des Ozeans zu messen. (siehe Abbildung). Ein Verfahren, das, mit kleinen Abweichungen, 140 Jahre lang beibehalten wurde.

Zu den Unstimmigkeiten in den Daten wird in dieser Studie angemerkt:

„…Ein neuer Artikel von David Thompson und anderen NOAA-Atmosphärenforschern in Nature liefert eine andere Erklärung (für die Genauigkeit). Die meisten Kriegsmessungen der Meerestemperaturen, die in den globalen Durchschnitt einflossen, stammten von US-Kriegsschiffen, die im Gegensatz zur britischen Marine dazu neigten, die Messwerte des Wassereinlass-Thermometers im Maschinenraum als repräsentativ für die Temperatur des Meeres zu erfassen. Die hartgesottenen Matrosen, die gegen Ende des Krieges in den meteorologischen Dienst zurückkehrten, verließen sich stattdessen wie immer auf das altehrwürdige Verfahren, einen Eimer über die Bordwand zu werfen, ihn einzuholen und an Deck zu stellen, damit ein mit einem Thermometer bewaffneter Chief oder Offizier ihn messen konnte. Der spätviktorianische Wechsel von Eichenholzkübeln zu verzinktem Stahl wurde vor dem Zweiten Weltkrieg noch verschärft, als nicht nur britische, sondern auch holländische und japanische Hydrographen mit porösen und daher kühlungsanfälligen Segeltuchschaufeln ausgestattet wurden – eine schlechte Idee, da der Wind auf einem fahrenden Schiff in der Regel lebhaft ist. Das entnommene Seewasser kühlte zwangsläufig ab, und zwar in der Zeit, die es brauchte, um es zur Messung an Deck zu bringen.“

Man kann sich vorstellen, wie schwierig es ist, ein so empfindliches Instrument wie ein Thermometer in einem Stück zu halten, geschweige denn zu kalibrieren. Auf ernsthaften wissenschaftlichen Expeditionen wurde es vielleicht in der Kabine des Kapitäns verschlossen aufbewahrt, aber unter vielen anderen Umständen konnte es bei jedem Wetter draußen an einem Haken hängen bleiben.

Dieser Link zeigt ein Schiffsbarometer und -thermometer aus der Zeit um 1855. Das im Eimer verwendete Thermometer war oft eine robuste, eigenständige Version des Instruments links im Hauptbild.

[Bild aus dem angegebenen Link entnommen]

Um die Probleme zu verdeutlichen, die mit der Aufzeichnung von „Eimer“-Temperaturen auf diese Weise verbunden sind, kann ich nichts Besseres tun als ein Gespräch wiederzugeben, das ich vor einigen Jahren mit jemandem geführt habe, der in den 40er und 50er Jahren in der britischen Marine gedient hat, als die Eimer-Messungen noch üblich waren (sie wurden schließlich in den frühen 60er Jahren eingestellt).

Er wies sachlich darauf hin, dass das Wasser aus allen möglichen Tiefen entnommen wurde (was stark von der Kraft und der Veranlagung des Betreffenden abhing) und das Wasser in dem Behälter (nicht immer ein zugelassener Eimer) für unbestimmte Zeiträume stehen gelassen wurde, was Zeiten mit heißem Sonnenschein und die Kühle der Nacht einschloss. Auch die Qualität der Thermometer war nicht immer die beste, die Kalibrierung erfolgte nur selten, und die Thermometer wurden in der Umgebungstemperatur an Deck belassen, bevor die Wasserprobe oft nur flüchtig abgelesen wurde, was die Unsicherheit noch erhöhte.

Sein ungläubiges Lachen, als ich ihm von der großen Bedeutung erzählte, die Wissenschaftler Messwerten wie dem seinen beimaßen, ist mir noch in Erinnerung. Damit soll natürlich nicht gesagt werden, dass alle SST-Werte auf diese Weise erhoben wurden, aber es waren viel zu viele, als dass die allgemeine Aufzeichnung als wissenschaftlich solide und aussagekräftig gelten könnte.

Das Folgende stammt aus einer Veröffentlichung aus dem Jahr 1947 mit dem Titel „A new bucket for measurement of sea surface temperatures“:

„Es ist seit vielen Jahren bekannt, dass das Standardverfahren zur Messung der Meerestemperaturen durch Entnahme einer Probe mit einem Leineneimer mit erheblichen Fehlern behaftet ist.“

Ganz genau.

In diesem Buch aus dem Jahr 1963 bemerkt H. F. Herdman, dass „die Probe zu oft in einem Leineneimer entnommen und die Temperatur nach einer beträchtlichen Zeit abgelesen wird“.

Dieses interne Memorandum des hoch angesehenen D. E. Parker aus dem Jahr 1985 mit dem Titel „A comparison of bucket and non-bucket measurements of sea surface temperatures“ (Vergleich von Messungen der Meerestemperatur mit und ohne Eimer) betrifft die Temperaturunterschiede zwischen Wasser, das in isolierten und nicht isolierten Eimern gesammelt wurde. Der Autor scheint der festen Überzeugung zu sein, dass trotz aller gegenteiligen Beweise das aus Eimern entnommene Wasser auf Zehntelgrade genau analysiert werden kann. Er zeigt auch das Gittersystem, das zur Messung von Daten über die 70 % der Erdoberfläche, die aus Ozeanen bestehen, verwendet wird, und veranschaulicht die Präzision, von der Hadley glaubt, dass sie sie haben. Unverzichtbare Lektüre für alle, die sich ernsthaft mit der SST beschäftigen, da sie einen Einblick in die frühe Entwicklung der SST-Datenbank gibt.

Es gab eine Abwandlung des Eimer-Verfahrens, bei dem das Thermometer in den Eimer gesteckt wurde, bevor man es über die Bordwand absenkte, wobei in späteren Jahren ein Gummipolster als Schutz diente. Ein Umkehrthermometer – im Allgemeinen für größere Tiefen als die Oberfläche verwendet – wurde 1874 entwickelt und von 1900 bis 1970 verwendet.

Im Allgemeinen waren die gesammelten SST-Daten von unterschiedlicher Qualität, was auf die Methodik und die Qualität der Instrumente zurückzuführen ist. Hinzu kommt das Fehlen von „räumlichen“ Daten – die Messungen wurden nur sporadisch über einen winzigen Teil der Weltmeere durchgeführt, wie hier beschrieben ist:

„Aus den ICOADS-Daten wurden auch Karten der mittleren Temperatur erstellt. Die Daten sind zeitlich und räumlich schlecht verteilt, außer in einigen Gebieten der nördlichen Hemisphäre. Darüber hinaus stellten Reynolds und Smith (1994) fest, dass die Temperaturdaten von Schiffen doppelt so große Fehler aufweisen wie die Temperaturfehler in den Daten von Bojen und AVHRR. Somit sind die von Reynolds verarbeiteten Weltraumdaten genauer und besser verteilt als ICOADS.“

Ein wenig mehr Einblick in die Erstellung von Aufzeichnungen der Meerestemperatur wurde von Richard Verney (in den Kommentaren) gewährt, der hier über das Verfahren schreibt, das schließlich die Eimer ablöste – die Messungen an den Motoreinlässen:

„Es scheint mir, dass das Met Office und die CRU nicht verstehen, wie die Daten von Schiffen erhoben werden. Die von Schiffen gemeldete Seewassertemperatur wird aus dem Seewasser entnommen, das zur Kühlung des Motors verwendet wird. Woher dieses Wasser entnommen wird, hängt von der Konstruktion und Konfiguration des Schiffes ab und davon, ob das Schiff mit Ballast fährt oder beladen ist. Schiffe versuchen, lange Ballastfahrten zu vermeiden, da diese nicht zu den Einnahmen bringenden Strecken gehören. Bei einem beladenen Schiff wird das zur Kühlung entnommene Seewasser etwa 10 m unter der Wasseroberfläche entnommen (das kann überall zwischen 7 und 13 m liegen, typisch sind jedoch etwa 10 m).

Was bedeutet das? Es bedeutet, dass Schiffe die Meerestemperatur in einer Tiefe von etwa 10 m messen, während Bojen die Meerestemperatur in einer Tiefe von etwa 1 m (bis 3 m) messen. (Anmerkung der Autoren: Bojen messen die Temperatur in verschiedenen Tiefen, je nach Position des Werfers, Satelliten in 0,01 mm Tiefe). Allgemein gilt: je tiefer, desto kühler.

Daraus (d.h. aus dem Tiefenunterschied) folgt, dass man erwarten würde, dass die Daten des Schiffsmotoreneinlasses eine niedrigere (und nicht eine höhere) Temperatur aufzeichnen, wenn man sie mit den ähnlichen Messungen der Bojen (die näher an der Oberfläche messen) vergleicht. Das bedeutet, dass man entweder die Bojentemperatur nach unten oder die Schiffstemperatur nach oben korrigieren muss, um einen vergleichbaren Vergleich anstellen zu können. Es gibt keinen Grund, die Bojentemperatur nach oben zu korrigieren, da dies den Unterschied zwischen den Tiefen, in denen die Daten gemessen wurden, noch vergrößert.

Darüber hinaus neigt eine nicht unerhebliche Anzahl von Schiffen dazu, die Meerestemperatur absichtlich zu niedrig aufzuzeichnen. Viele Schiffe befördern flüssige Ladungen, die erhitzt werden müssen (verschiedene Chemikalien, Palmöl, Pflanzenöl usw.). Vereinfacht gesagt, wird der Schiffseigner für die Erwärmung dieser Ladungen bezahlt…. In sehr warmen tropischen Meeren kühlt die Ladung natürlich langsamer ab, und die natürlich vorherrschende Meerwassertemperatur kann ausreichen, um die Ladung frei fließen zu lassen, so dass eine Erwärmung nicht unbedingt erforderlich ist. Es liegt daher im Interesse des Schiffseigners, Seewassertemperaturen aufzuzeichnen, die etwas niedriger sind als die tatsächlich vorherrschenden Temperaturen, so dass er Heizkosten geltend machen und in Rechnung stellen kann, obwohl in Wirklichkeit keine Heizkosten anfallen. Ich behaupte nicht, dass diese Praxis in der gesamten Schifffahrtsbranche einheitlich ist, aber sie kommt sicherlich vor. So wird auf einer Reihe von Schiffen eine niedrigere Temperatur aufgezeichnet/angegeben, als sie tatsächlich herrscht.

Aus diesen beiden Gründen besteht Grund zu der Annahme, dass die von den Schiffen gelieferten Temperaturaufzeichnungen die Meerestemperatur unterbewerten/unterzeichnen. In diesem Fall könnten die Meerestemperaturen sogar noch stärker gesunken sein, als das ‚Team‘ (oder die ihm nahestehenden Personen und/oder seine Befürworter) zu akzeptieren bereit sind.“

Diese Interpretation wird von der Seafriends-Website von Dr. J. Floor Anthoni bestätigt, von der dieser Auszug über die Meerestemperaturen stammt:

„Die Temperatur der Meeresoberfläche wird schon seit mehreren Jahrhunderten von Schiffen gemessen. Zunächst wurde das Oberflächenwasser während der Fahrt in einem Eimer aufgefangen, später wurde der Kühlwassereinlass des Motors verwendet. Leider machte dies einen Unterschied, da der Wassereinlass in einer gewissen Tiefe unter Wasser liegt. Heute kann dies von Vorteil sein, da Satelliten nur die obersten paar Zentimeter des Meeres messen können, wird doch die Infrarotstrahlung vom Wasser schnell absorbiert. Da das Wasser ständig aus dem Meer verdunstet, ist der Oberflächenfilm etwas kälter als ein paar Meter tiefer.“

Ungeachtet des Verfahrens der Datenerfassung muss auch berücksichtigt werden, dass die wenigen Messwerte von Schifffahrtswegen stammen, die nur einen winzigen Bruchteil der Meeresoberfläche ausmachen, und hier kommt ein weiterer, bereits angesprochener Faktor zum Tragen, denn neben der Qualität der Informationen ist auch die Quantität der Daten von Bedeutung, da nur relativ wenige Messwerte erfasst wurden und die geografische Abdeckung viel geringer ist als selbst bei den unzureichenden Aufzeichnungen der Landtemperatur.

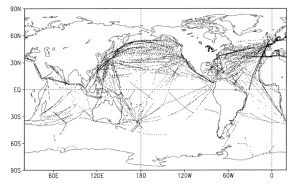

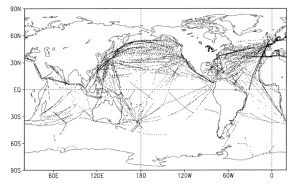

Diese Grafik [die sich leider nicht vergrößern lässt, ohne unscharf zu werden, A. d. Übers.] – Reynolds 2000 – zeigt den Verkehr der Schiffe, die in der Woche vom 1. bis 8. Januar 2000, einer Zeit höchster wirtschaftlicher Aktivität, zur Erhebung von SST-Daten eingesetzt wurden. (Die Breite der Fahrspuren wurde zu Darstellungszwecken stark übertrieben). Schon damals war die Abdeckung sehr dürftig, aber eine Momentaufnahme aus dem Jahr 1850 würde eine weitaus geringere Aktivität erkennen lassen. Beobachtungen und Berechnungen von SST-Anomalien sind in dieser WG2-Analyse des IPCC dargestellt.

Die heutige Hightech-Version dieser älteren Messverfahren sind ARGO-Bojen:

„ARGO ist ein globales System von 3.000 frei treibenden Messbojen, die die Temperatur und den Salzgehalt in den oberen 2000 Metern des Ozeans messen. Dies ermöglicht zum ersten Mal eine kontinuierliche Überwachung der Temperatur, des Salzgehalts und der Strömungsgeschwindigkeit des oberen Ozeans, wobei alle Daten innerhalb von Stunden nach der Erfassung weitergeleitet und öffentlich zugänglich gemacht werden.“

Dieses derzeit kurzlebige Experiment hatte einen umstrittenen Anfang, da die Bojen anfangs einen sinkenden Wärmeinhalt des Ozeans aufzeichneten (wenn auch nicht streng nach denselben Kriterien wie die SST). Dies war eine offensichtliche Anomalie, da die Ozeantemperaturen laut Computermodellen eigentlich steigen sollten. Diese Abweichung wurde in diesem Artikel erläutert, der auch nützliche Informationen darüber liefert, welcher Anteil des Ganzen – wie Wärmeausdehnung und Gletscherschmelze – den einzelnen Aspekten des Meeresspiegelanstiegs zuzuschreiben ist.

„Im Jahr 2004 veröffentlichte Willis eine Zeitreihe zum Wärmeinhalt des Ozeans, aus der hervorging, dass die Temperatur in den oberen Schichten des Ozeans zwischen 1993 und 2003 gestiegen war. Im Jahr 2006 leitete er eine Folgestudie unter der Leitung von John Lyman am Pacific Marine Environmental Laboratory in Seattle, in welcher die Zeitreihe für 2003-2005 aktualisiert wurde. Überraschenderweise schien sich der Ozean abgekühlt zu haben.

Es überrascht nicht, sagt Willis mit einem Augenzwinkern, dass diese Studie viel Aufmerksamkeit erregte, aber nicht immer in dem Maße, wie es ein Wissenschaftler begrüßen würde. In Gesprächen mit Reportern und der Öffentlichkeit bezeichnete Willis die Ergebnisse als „Bremsklotz“ auf dem Weg zur globalen Erwärmung, als Beweis dafür, dass es selbst bei einer Erwärmung des Klimas aufgrund von Treibhausgasen immer noch Schwankungen geben würde. Die Botschaft kam jedoch nicht bei allen an. In Blogs und Radiotalkshows zitierten Leugner der globalen Erwärmung als Beweis dafür, dass die globale Erwärmung nicht real sei und dass die Klimawissenschaftler nicht wüssten, was sie täten.“

Die obige Interpretation wurde jedoch durch diese Studie vom November 2010 mit dem Titel „Recent energy balance of earth“ von Knox und Douglass überholt, die nach einer Untersuchung der Daten der ARGO-Bojen zeigen, dass der Wärmehaushalt der Ozeane im jüngsten Zeitraum 2003-2008 tatsächlich immer noch abkühlt und sich nicht erwärmt.

Abstract: Eine kürzlich veröffentlichte Schätzung des globalen Erwärmungstrends der Erde liegt bei 0,63 ± 0,28 W/m², berechnet aus den Daten der Anomalie des Wärmeinhalts der Ozeane im Zeitraum 1993-2008. Dieser Wert ist nicht repräsentativ für die jüngste Erwärmungs-/Abkühlungsrate (2003-2008), da um 2001-2002 eine „Abflachung“ eingetreten ist. Wenn wir nur die Daten der ARGO-Bojen von 2003-2008 verwenden, stellen wir mit vier verschiedenen Algorithmen fest, dass der jüngste Trend zwischen -0,010 und -0,160 W/m² liegt, mit einer typischen Fehlerbreite von ±0,2 W/m². Diese Ergebnisse stützen nicht die Existenz eines häufig zitierten großen positiven berechneten Strahlungsungleichgewichts.

Die erneute Bestätigung, dass sich die Ozeane generell abzukühlen scheinen, löste eine lebhafte Debatte in diesem Blogbeitrag aus.

Bislang ist dieses Verfahren zur Erfassung der Meerestemperaturen aufgrund der in dem Papier genannten Anpassungen, der Kürze des Projekts und der Schwierigkeit, kontinuierlich Daten zu erhalten, noch nicht bewiesen.

Schlussfolgerungen zu den Temperaturen an der Meeresoberfläche

Bei den Landtemperaturen haben wir festgestellt, dass wir oft Äpfel mit Birnen verglichen haben. Ähnlich verhält es sich mit den SST-Werten, bei denen wir eine Vielzahl inkompatibler Verfahren zur Datenerfassung miteinander vermischen und feststellen müssen, dass die Anzahl der Probenahmen im Ozean gemessen an der physikalischen Zahl sehr gering ist und die Methodik selbst möglicherweise schwerwiegende Mängel aufweist. Hinzu kommt, dass das begrenzte Wissen, das wir über die Meerestemperaturen haben, exponentiell abnimmt, je weiter die Zeit zurückliegt und je abgelegener das Gebiet ist, da die Messpunkte so begrenzt sind. Erschwerend kommt hinzu, dass dort, wo die Daten spärlich sind, sie statistisch aus Gebieten aufgefüllt werden, in denen sie noch spärlicher sein könnten.

Nichts von alledem wird Hadley (und andere) davon abhalten, die globalen SST-Werte bis auf einen Bruchteil zu analysieren und die Robustheit der Antwort zu erläutern, was dann vom IPCC und den nationalen Regierungen als positiver Beweis für den Erlass weiterer Maßnahmen zum Schutz gegen die Erwärmung angesehen wird.

Die von Klimawissenschaftlern, Statistikern und Analysten in gutem Glauben verwendeten historischen Temperaturdaten, ob zu Lande oder an der Oberfläche, scheinen grundlegenden Qualitäts-Kontrollmaßnahmen nicht zu genügen und sind nicht für den Zweck geeignet, Temperaturen auf Zehntelgrade genau zu bestimmen. Insbesondere historische Meerestemperaturen sind höchst unsicher und sollten nicht als verlässliches Maß angesehen werden.

References

220,000 log books of the Royal Navy from 1669 to 1976 are being studied for meteorological information that can give an insight into climate change.

A project to recover worldwide weather observations made by Royal Navy ships around the time of World War I.

Metrology of thermometers is the science of measuring as described here

Fascinating article about various types of historic measurements taken at sea

Bob Tisdale has an excellent web site dealing with all aspects of ocean temperatures

Link: https://judithcurry.com/2011/06/27/unknown-and-uncertain-sea-surface-temperatures/

Übersetzt von Christian Freuer für das EIKE