Der gemeine Küchenherd als Beispiel für die Anwendung des Stefan-Boltzmann-Gesetzes – Teil 2

von Uli Weber

In Teil 1 (hier) hatte ich zunächst in Kapitel (A) meine Motivation für diesen Artikel erläutert. In Kapitel (B) wurden dann die verständnisfördernden physikalischen Einheiten und deren Zusammenhang beschrieben. Darauf folgte in Kapitel (C) das sagenumwobene Stefan-Boltzmann-Gesetz und in Kapitel (D) die zeitlichen und geometrischen Bedingungen, unter denen dieses physikalische Gesetz anzuwenden ist. Und schließlich wurde in Kapitel (E) der sogenannte „natürliche atmosphärische Treibhauseffekt“ vorgestellt.

Hier in Teil 2 beginnen wir nun mit der Fortsetzung von Kapitel (E) aus Teil 1:

Schau‘n wir mit dem, was wir bisher gelernt haben, also einmal auf diese eigenartige Stefan-Boltzmann-Berechnung der Klimawissenschaft, an deren Ende ein „natürlicher atmosphärischer Treibhauseffekt“ stehen soll:

- Die Sonne scheint nur auf der Tagseite der Erde und die andere Hälfte der Erde ist dunkel, aber man mittelt die Sonneneinstrahlung einfach über Tag und Nacht.

- Aus dem Beispiel mit der Glühbirne haben wir gelernt, dass wir über Dunkelzeiten keinen Durchschnitt bilden dürfen, weil das zu physikalisch falschen Ergebnissen führt.

- Und aus dem Beispiel mit dem Herd haben wir gelernt, dass eine Pizza nicht aufgebacken wird, wenn der Herd nicht angeschaltet ist. Folglich kann also auch die Sonne keine Temperatur auf der Erde erzeugen, wenn sie nachts gar nicht scheint.

- Die Klimawissenschaft rechnet also einfach über 24 Stunden, weil man weiß, dass der Tag nun mal so lang ist, und nicht über 12 Stunden, obwohl nur da die Sonne scheint. Vielmehr weist man dann der dunklen Nachtseite der Erde dieselbe Temperatur zu wie der sonnenbeschienenen Tagseite. Und nun wundert man sich, dass diese „theoretische Temperatur“ nicht mit der „gemessenen“ globalen Durchschnittstemperatur übereinstimmt, sondern sich eine Differenz von 33°C zugunsten der „gemessenen“ Temperatur ergibt.

- Als Erklärung für diese Temperaturdifferenz von 33°C konstruiert die Klimawissenschaft dann ihren „natürlichen atmosphärischen Treibhauseffekt“, der durch eine sogenannte „atmosphärische Gegenstrahlung“ der IR-aktiven „Klimagase“ erzeugt werden soll.

(F) Gegenprobe mit der physikalischen Wärmelehre und Richtungsvektoren: Wir müssen jetzt noch etwas in die physikalische Wärmelehre einsteigen. Die Hauptsätze der Thermodynamik beschäftigen sich mit der Umwandlung und Änderung von Energie innerhalb eines oder mehrerer Systeme. Das klingt zunächst einmal sehr abstrakt, ist aber ganz einfach zu verstehen:

- Energieerhaltungssatz: Energie kann weder erschaffen noch vernichtet, sondern nur umgewandelt werden.

Beispiel: Wenn Sie mit Holzkohle grillen, dann entziehen Sie damit der Holzkohle die dort gespeicherte Energie, und diese Energie heizt wiederum den Grill, die Wurst und die umgebende Luft – und wenn Sie zu nah ‘rangehen, verbrennen Sie Sich die Finger…

- Richtung von Prozessen: Es gibt keine Zustandsänderung, deren einziges Ergebnis die Übertragung von Wärme von einem Körper niederer auf einen Körper höherer Temperatur ist.

Beispiel: Es kann kein Perpetuum Mobile geben. Ein Perpetuum Mobile wäre ein Prozess, der ohne Zufuhr von Energie selbständig Energie erzeugen kann. Stellen Sie sich dazu einfach mal ein Auto vor, mit dem Sie ohne zu tanken beliebig herumfahren könnten, weil es die erforderliche Energie selber erzeugt – schön wär’s…

Und mit diesem Wissen schauen wir uns jetzt noch einmal den sogenannten „natürlichen atmosphärischen Treibhauseffekt“ an. Mit dem „Energieerhaltungssatz“ müssen wir fordern, dass die Erde im Mittel genauso viel Energie abstrahlt, wie sie im Mittel von der Sonne erhält. Denn würde sie mehr abstrahlen, dann würde die Erde kontinuierlich kälter; würde sie dagegen weniger abstrahlen, würde sie kontinuierlich wärmer. Mit der „Richtung von Prozessen“ müssen wir in erster Näherung schließen, dass der „natürliche atmosphärische Treibhauseffekt“ eine zusätzliche eigene Energiequelle besitzt, nämlich die sogenannte „atmosphärische Gegenstrahlung“ der IR-aktiven „Klimagase“. Der vorgebliche Weg ist folgender:

Solare Einstrahlung (primär): Die hochfrequente (HF) solare Einstrahlung heizt die Erdoberfläche auf.

Terrestrische Abstrahlung (sekundär): Die erhitzte Erdoberfläche strahlt infrarote (IR) Strahlung ab.

(?) Atmosphärische „Gegenstrahlung“ (tertiär): Die sogenannten „Klimagase“ nehmen angeblich die IR-Strahlung der Erde auf und strahlen sie vorgeblich je zur Hälfte ins Weltall und zur Erde zurück, und zwar als sogenannte „Gegenstrahlung“. Durch diesen „Treibhauseffekt“ soll die Erde sich um 33°C erwärmen.

Wir stellen also fest:

(1.) Mit einem Gleichstand zwischen der primären Einstrahlung und der sekundären Abstrahlung wäre der Energieerhaltungssatz erfüllt.

(2.) Die „Wiederverwendung“ der sekundären Abstrahlung als zusätzliche Heizquelle für die Erdoberfläche wäre dagegen ein Perpetuum Mobile, denn die Erdoberfläche würde sich dann durch ihre eigene Abstrahlung zusätzlich weiter erwärmen. Dieser „Münchhauseneffekt“ ist aber physikalisch unmöglich.

Beweis durch Widerspruch: Gäbe es eine wie immer geartete IR-Heizung, durch deren IR-Bestrahlung von „Klimagasen“ eine „Gegenstrahlung“ erzeugt werden könnte, die einen Temperaturanstieg von 33°C gegenüber der ursprünglichen Quelle erzeugen würde, dann hätten wir alle jetzt und in alle Zukunft keinerlei Heizungsprobleme mehr.

Ergebnis: Gibt es eine solche Gegenstrahlungsheizung?

Nein: Es ist also schon sehr eigenartig, was die sogenannte „Klimawissenschaft“ auf Basis „glaubensgerechter Physik“ so daherzurechnen beliebt!

Richtungsvektoren: Es gibt noch einen weiteren physikalischen Nachweis für die Unsinnigkeit einer platten Faktor4-Mittelung der solaren Sonneneinstrahlung zur Ermittlung einer „natürlichen“ Temperatur unserer Erde. Dazu müssen wir wissen, was ein „Vektor“ und was ein „Skalar“ ist, Zitat von ingenieurkurse.de:

„Ein Vektor ist eine physikalische Größe, die durch Angabe eines Zahlenwertes, ihrer Einheit und zusätzlich durch eine Richtung charakterisiert ist. Beispiele für Vektoren sind: Die Geschwindigkeit ist ein Vektor. Bei der Geschwindigkeit wird zusätzlich zur Angabe eines Zahlenwertes plus Einheit eine Richtung angegeben.

Ein Skalar ist eine physikalische Größe, die durch die Angabe eines Zahlenwertes und ihrer Einheit charakterisiert ist. “

Also: Ein Vektor ist eine gerichtete physikalische Größe, die eine Maßzahl, eine eindeutige Richtung und eine physikalische Einheit besitzt. Stellen Sie Sich einfach einen Pfeil vor, dessen Spitze die Richtung anzeigt und die Länge des Schaftes den Betrag angibt. Ein Skalar ist dagegen eine ungerichtete Größe, die nur eine Maßzahl (Betrag) und eine physikalische Einheit besitzt, ein Richtungsbezug fehlt hier völlig. Und jetzt schauen wir uns noch einmal die Situation bei der Sonnenbestrahlung der Erde genauer an:

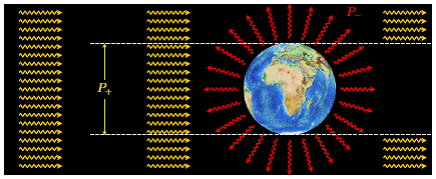

Abbildung: Die solare Bestrahlung der Erde und die terrestrische Abstrahlung

Quelle: Prof. Dr. Dr. h. c. Gerhard G. Paulus: Erderwärmung zum Nachrechnen

Die gelbe solare HF-Einstrahlung in dieser Abbildung ist mit parallelen (alle Strahlen sind gerader Richtung nebeneinander auf die Erde gerichtet) Strahlenvektoren auf die Erde gerichtet, während die rote IR-Abstrahlung radial (senkrecht zur Erdoberfläche) von der Erdoberfläche wegführt. Die Stärke der terrestrischen IR-Abstrahlung ergibt sich bei der klimaalarmistischen THE-Berechnung jetzt aus der Viertelung der solaren HF-Einstrahlung minus Albedo. Dabei kommt es aber zu einer Kollision der gerichteten Vektoren von HF-Ein- und IR-Abstrahlung, denn ein Vektor ändert nicht ohne Grund seine Richtung. Man hat bei dieser konventionellen Berechnung der Klimawissenschaft also ganz offensichtlich die unterschiedlichen vektoriellen Richtungen ignoriert und die Strahlungswerte lediglich als ungerichtete Skalare behandelt.

Frage: Auf welche Weise kann nun der Vektor der parallel einfallenden HF-Sonneneinstrahlung auf die radiale Richtung der IR-Abstrahlung der Erde „umgebogen“ werden?

Antwort: Gar nicht – eine Änderung des Richtungsvektors kann nur erfolgen, wenn zwischen HF-Einstrahlung und IR-Abstrahlung ein eigenständiger physikalischer Prozess stattfindet. Dieser Prozess ist die Erwärmung der Erdoberfläche durch die solare HF-Einstrahlung. Dann, und nur dann, strahlt die Erdoberfläche ihre IR-Wärmestrahlung radial ab. Und nur dann strahlt die Erdoberfläche auf der Nachtseite ebenfalls radial ab, weil durch die Drehung der Erde die erwärmte Oberfläche einfach auf die Nachtseite „mitgenommen“ wird.

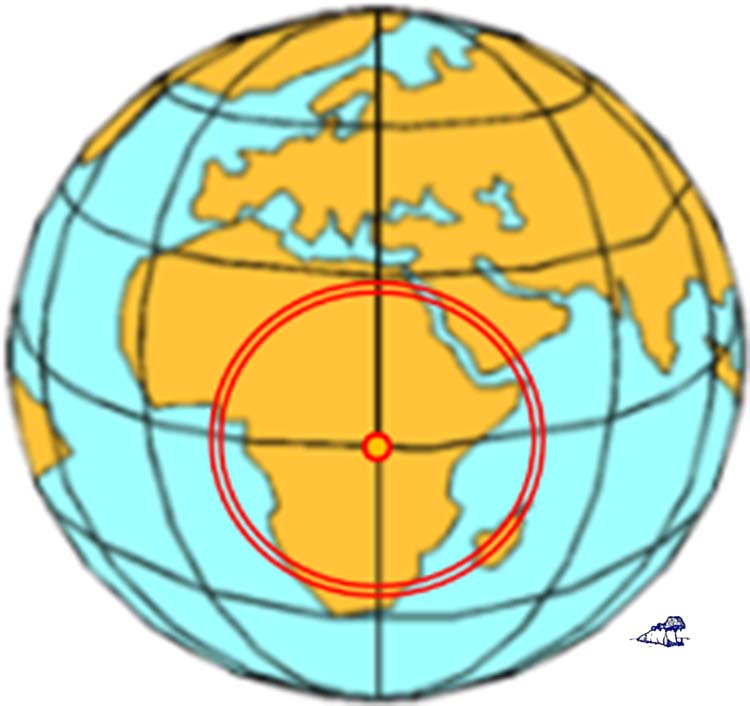

(G) Und nun kommt endlich mein hemisphärisches Stefan-Boltzmann-Modell: Versuchen wir einfach mal eine Temperaturberechnung allein für die Tagseite der Erde. Dazu nehmen wir an, die Sonne stünde genau über dem Äquator, also auf dem Frühlings- oder Herbstpunkt (Tag-und-Nacht-Gleiche). Dann teilen wir die gekrümmte Tagseite der Erde (Halbkugelfläche) in konzentrische Ringe um diesen Fußpunkt der Sonne auf, wobei auf jeder Ringfläche die spezifische Strahlungsleistung der Sonne konstant ist:

Abbildung: Die Tagseite der Erde, aufgeteilt in konzentrische Ringe von jeweils 1 Grad um den Fußpunkt der Sonne auf dem Äquator, also 0°-1°, 1°-2°, 2°-3°,….., 89°-90°.

Abbildung: Die Tagseite der Erde, aufgeteilt in konzentrische Ringe von jeweils 1 Grad um den Fußpunkt der Sonne auf dem Äquator, also 0°-1°, 1°-2°, 2°-3°,….., 89°-90°.

Wegen der Erdkrümmung erhält nämlich jeder dieser konzentrischen Ringe einen ganz individuellen Anteil der Sonneneinstrahlung. Im Zentrum, am Fußpunkt der Sonne auf dem Äquator (=0°), treffen die Sonnenstrahlen senkrecht auf die Erdoberfläche. Der Boden dort erhält also die gesamten 940 /m² (=1.367 W/m² – 30%) von der Sonne. Zur Mitte und zum Rand hin vermindert sich dieser Wert aufgrund der immer schräger werdenden Auftreffwinkel der Sonnenstrahlen kontinuierlich, bis schließlich die Sonneneinstrahlung ganz am Rand (=90°) auf 0 W/m² zurückgeht. Der Richtungsabhängigkeit der solaren HF-Einstrahlung ist somit also Genüge getan. Wenn wir nun für jeden Ring aus der jeweiligen Sonneneinstrahlung eine Temperatur mit dem Stefan-Boltzmann-Gesetz ableiten und dann über alle Ringe eine Mittelung durchführen, dann erhalten wir +14,03°C. Und wenn wir die Ringe noch schmaler machen, dann werden es sogar +15,15°C, also ziemlich genau die sogenannte „global gemessene Durchschnittstemperatur“. Und die IR-Strahlung der erwärmten Erdoberfläche strahlt nun überall auf der Erde radial von der Erdoberfläche ab, wie es das Stefan-Boltzmann-Gesetz befiehlt.

Wir sehen also, wenn wir mit dem Stefan-Boltzmann-Gesetz physikalisch richtig rechnen, bleibt gar kein Platz mehr für einen „natürlichen atmosphärischen Treibhauseffekt“ und damit auch keine Notwendigkeit, unsere technische Zivilisation aus Angst vor einer globalen Klimakatastrophe zu zerstören. Denn gegenüber der vorstehend berechneten Durchschnittstemperatur von ca. 15°C für die Tagseite der Erde müsste die „theoretische“ Nachttemperatur nun um 66°C absinken, um im gemeinsamen Mittel eine globale „theoretische“ Durchschnittstemperatur von -18°C zu ergeben. Aber haben Sie einen solchen nächtlichen Temperatursturz von mehr als 60°C schon jemals erlebt? – Nein? – Und auch der sogenannte „natürliche atmosphärische Treibhauseffekt“ von 33°C hilft hier wenig, denn dann würden immer noch 33°C fehlen.

ERGEBNIS: Es gibt auf unserer Erde gar keinen „natürlichen atmosphärischen Treibhauseffekt“!

Und auf der immer als „leuchtendes“ THE-Beispiel herangezogenen Venus übrigens auch nicht!

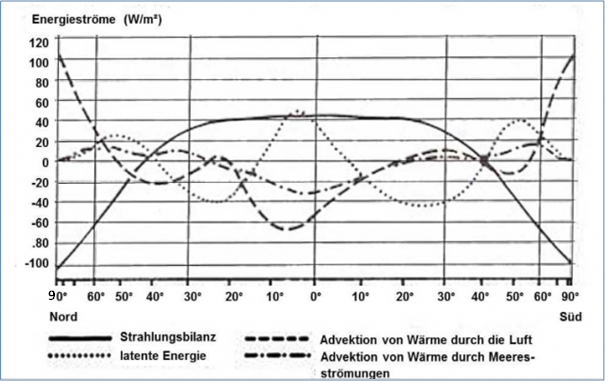

(H) Noch ein paar abschließende Bemerkungen zum globalen Wärmetransport und zur Wärmespeicherung auf der Erde: Es ist offensichtlich, dass auf der Erdoberfläche die rein rechnerische Temperatur nach dem Stefan-Boltzmann-Gesetz aus der solaren Einstrahlung nirgendwo erreicht wird. Andererseits wissen wir aber aus dem Energieerhaltungssatz der Wärmelehre, dass Energie nicht einfach so verschwinden kann. Vielmehr vermindert der ständige Abfluss von Wärme durch Konvektion und Verdunstung den durch die Sonneneinstrahlung bedingten örtlichen Temperaturanstieg. Dabei spielt der Energietransport durch Atmosphäre und Ozeane aus Tropen und Subtropen in die Polarzonen hinein eine ganz wesentliche Rolle für unser Klima. Die nachfolgende Abbildung hatte ich schon in vielen Artikeln als Beweisführung für meinen hemisphärischen S-B-Ansatz herangezogen, und zwar zuletzt in dem Artikel, „Die dunkle Seite unserer Erde und der meridionale Energietransport“ (2022):

Abbildung: „Jahresmittel des Energiehaushaltes der Atmosphäre und seiner Komponenten in Abhängigkeit von der geographischen Breite“ nach HÄCKEL, H. (1990): Meteorologie. – 8. Aufl. 2016; Stuttgart (Verlag Eugen Ulmer), ISBN 978-3-8252-4603-7)

Hinweis: Die X-Achse (90° Nord bis 90° Süd) ist als „Draufsicht“ auf die Erde eingeteilt, d.h. die Abstände zwischen 0° und 90° werden jenseits von 30° sichtbar kürzer.

In dieser Abbildung bedeutet die „0 [W/m²]“-Linie die „durchschnittliche“ Ortstemperatur, die sich im Gleichgewicht von solarer Einstrahlung und örtlichem Energie-zu-/ab-fluss einstellt. Die (unterschiedlich schraffierten) Linien oberhalb der „0“-Linie stellen einen Energieüberschuss dar, die Linien unterhalb der „0“-Linie einen Energieverlust. Nehmen wir zum Beispiel einmal das Maximum links von 0° (=Äquator). Aus der Strahlungsbilanz und der latenten Energie (die Energie, die durch Verdunstung im Wasserdampf gebunden ist) sind jeweils ca. 45 [W/m²] vorhanden und ergeben zusammen 90 [W/m²] Überschuss. Gleichzeitig tritt durch Advektion (Verfrachtung) ein Wärmeverlust von ca. 60 [W/m²] durch Luftströmungen und ca. 30 [W/m²] durch Wasserströmungen ein, also insgesamt ebenfalls 90 [W/m²]. Für jeden Punkt auf der X-Achse von 90° Nord bis 90° Süd halten sich bei einer individuellen örtlichen Durchschnittstemperatur Energieüberschuss und Energieverlust also genau die Waage.

Dieser polwärts gerichtete Energietransport auf unserer Erde bewirkt, dass die Ortstemperatur in den Tropen und Subtropen bis in die sommerlichen mittleren Breiten hinein niedriger ausfällt als mit dem Stefan-Boltzmann-Gesetz berechnet. In höheren geografischen Breiten sowie winterlichen mittleren Breiten dagegen wird die Ortstemperatur durch den Zufluss von Energie gestützt:

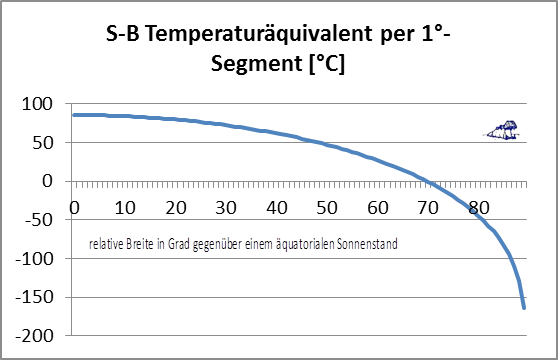

Abbildung: Maximale theoretische Stefan-Boltzmann-Ortstemperatur im Äquinoktium (= Tag- und Nacht-Gleiche) vom Äquator (=0°) bis zu den Polen (90° Nord/Süd)

Die maximale Stefan-Boltzmann-Ortstemperatur sinkt vom Äquator (940 [W/m²] entsprechend ca. 86 [°C] oder 359 [Kelvin]) zu den Polen auf (0 [W/m²] entsprechend ca. -273 [°C] oder 0 [Kelvin]) ab. Bei etwa 70° nördlicher und südlicher Breite unterschreitet diese maximale Stefan-Boltzmann-Ortstemperatur die 0°C-Linie, und zwar ausdrücklich zur Tag- und Nacht-Gleiche. Dort befinden sich in etwa das Nordkapp (71° 1′ N, 25° 7′ O) und die Polarkreise (Nord und Süd) auf 66° 34′ N / S. Der Sonnenstand schwankt im Jahresverlauf zwischen den beiden Wendekreisen auf 23° 26‘ Nord (Nordsommer=Südwinter) und 23° 26‘ Süd (Südsommer=Nordwinter) um den Äquator. Insbesondere auf der jeweiligen Winterhalbkugel ist die Ortstemperatur in mittleren und höheren Breiten daher von der Energie-Verfrachtung aus niederen geografischen Breiten abhängig, denn sonst würde am Pol der Winterhemisphäre die Temperatur in die Nähe des absoluten Nullpunktes absinken. Dieser globale Wärmetransport in Atmosphäre und Ozeanen kostet natürlich Zeit. Bei den großen ozeanischen Strömungen spricht man von 100 Jahren und mehr.

Wenn also Energie in diesen Strömungen gespeichert wird und für ein Jahrhundert „unter Wasser verschwindet“, warum wird es dann auf der Erde nicht kälter? – Nun, die Antwort ist eigentlich ganz einfach: Unsere Erde ist ein „eingeschwungenes“ System.

Die 100 Jahre, die ein Umlauf in den großen ozeanischen Strömungen dauert, sind bereits bei deren Entstehung abgelaufen. Das bedeutet, gleichzeitig mit dem „Verschwinden“ von Energie in diesen ozeanischen Strömungen taucht im Mittel eine gleich große, vor 100 Jahren gespeicherte Energiemenge aus diesen Strömungen an anderer Stelle wieder auf. Und gleichzeitig mit der Verdunstung von Wasser kondensiert der vorher bereits entstandene Wasserdampf unter Abgabe von Energie an ganz anderer Stelle und regnet wieder ab.

Wir leben also in einer globalen energetischen „Durchschnittsbetrachtung“, wo all das vorstehend Beschriebene gleichzeitig passiert, wenn auch an ganz unterschiedlichen Orten.

Weiterführende Links zu meinem hemisphärischen Stefan-Boltzmann-Modell:

Eine noch einfachere Beschreibung: https://eike-klima-energie.eu/2017/01/23/ueber-einen-vergeblichen-versuch-unsere-welt-vor-der-dekarbonisierung-zu-retten/

Ein Modellvergleich mit der Temperatur auf dem Mond: https://eike-klima-energie.eu/2017/07/02/beweist-die-temperatur-des-mondes-den-hemisphaerischen-stefan-boltzmann-ansatz/

Zur Energiespeicherung in Atmosphäre und Ozeanen: https://eike-klima-energie.eu/2019/07/29/safety-first-zum-besseren-verstaendnis-meiner-hemisphaerischen-energiebilanz/

Die genaue S-B-Berechnung für die Tagseite der Erde: https://www.eike-klima-energie.eu/2019/09/11/anmerkungen-zur-hemisphaerischen-mittelwertbildung-mit-dem-stefan-boltzmann-gesetz/

Vergleich der Treibhaustheorien, Teil 1 Gegenüberstellung: https://www.eike-klima-energie.eu/2019/12/02/eine-analyse-der-thesen-antithesen-fuer-einen-natuerlichen-atmosphaerischen-treibhauseffekt-teil-1-gegenueberstellung-der-thesen-antithesen/

Vergleich der Treibhaustheorien, Teil 2 Diskussion: https://www.eike-klima-energie.eu/2019/12/03/eine-analyse-der-thesen-antithesen-fuer-einen-natuerlichen-atmosphaerischen-treibhauseffekt-teil-2-diskussion-der-thesen-antithesen/

Vergleich der Treibhaustheorien, Teil 3 Erkenntnisse: https://www.eike-klima-energie.eu/2019/12/04/eine-analyse-der-thesen-antithesen-fuer-einen-natuerlichen-atmosphaerischen-treibhauseffekt-teil-3-erkenntnisse-zu-den-thesen-antithesen-und-das-ergebn/

Bücher

Allgemeine Kritik am Klimawahn: Klimahysterie gefährdet die Freiheit – ISBN-13: 9783744835602

Zusammenstellung von Artikeln gegen den Klimawahn: Klima-Mord – Der atmosphärische Treibhauseffekt hat ein Alibi – ISBN-13: 9783744837279

Mein hemisphärisches S-B-Modell: Die hemisphärische Stefan-Boltzmann Temperatur unserer Erde – ISBN-13: 9783752870343

Wissenschaftliche Veröffentlichungen: Mehr geht nicht – Ein klimawissenschaftliches Vermächtnis – ISBN-13: 9783744818513

Hier der Link für den gesamten Beitrag als pdf.