Schätzungen der Erwärmung von 1970 bis 2021 aus der Klima-Sensitivität

Dr. Roy Spencer, Ph. D.

Als Reaktion auf die Kommentare der Gutachter zu einer von John Christy und mir eingereichten Studie über die Auswirkungen von El Nino und La Nina auf die Schätzungen der Klimasensitivität habe ich beschlossen, den Schwerpunkt so zu ändern, dass eine völlige Neufassung der Studie erforderlich wurde.

Sie befasst sich nun mit der Frage: Was bedeutet es für die Klimasensitivität, wenn wir alle verschiedenen Temperatur-Datensätze und ihre unterschiedlichen Schätzungen der Erwärmung in den letzten 50 Jahren nehmen?

Das Problem bei der Schätzung der Klimasensitivität anhand von Beobachtungsdaten besteht darin, dass man, selbst wenn die Temperaturbeobachtungen weltweit vollständig und fehlerfrei wären, immer noch ziemlich genau wissen muss, welcher „Antrieb“ die Temperaturänderung verursacht hat.

Zur Erinnerung: Jede Temperaturänderung in einem Objekt oder System ist auf ein Ungleichgewicht zwischen Energiegewinn und Energieverlust zurückzuführen, und die Hypothese der globalen Erwärmung geht von der Annahme aus, dass sich das Klimasystem von Natur aus in einem Zustand der Energiebilanz befindet. Ja, ich weiß (und stimme zu), dass diese Annahme nicht als absolut wahr bewiesen werden kann, wie Ereignisse wie die mittelalterliche Warmzeit und die kleine Eiszeit belegen.

Aber nehmen wir zur Veranschaulichung an, dass sie für das heutige Klimasystem zutrifft und dass der einzige Grund für die jüngste Erwärmung die vom Menschen verursachten Treibhausgasemissionen (hauptsächlich CO₂) sind. Deutet die derzeitige Erwärmungsrate darauf hin (wie uns gesagt wird), dass uns eine globale Erwärmungskatastrophe bevorsteht? Meiner Meinung nach ist dies eine wichtige Frage, die unabhängig von der Frage zu klären ist, ob ein Teil der jüngsten Erwärmung natürlichen Ursprungs ist (was AGW noch weniger zu einem Problem machen würde).

Lewis und Curry (zuletzt 2018) gingen die ECS-Frage auf ähnliche Weise an, indem sie die Temperaturen und die Schätzungen des Strahlungsantriebs von Ende der 1800er bis Anfang der 2000er Jahren verglichen und Antworten im Bereich von 1,5 bis 1,8 deg. C möglicher Erwärmung bei einer Verdoppelung der vorindustriellen CO₂-Konzentration (2 X CO₂). Diese Schätzungen liegen deutlich unter den Angaben des IPCC, die sich auf die Projektionen von Klimamodellen stützen.

Unser Ansatz ist etwas anders als der von Lewis & Curry. Erstens verwenden wir nur Daten aus den letzten 50 Jahren (1970-2021), d. h. aus dem Zeitraum des schnellsten Anstiegs des CO₂-bedingten Treibhauseffekts, dem Zeitraum des schnellsten Temperaturanstiegs und dem Zeitraum, der am weitesten zurückreicht, um mit Sicherheit Aussagen über den Wärmeinhalt der Ozeane machen zu können (eine sehr wichtige Variable bei Schätzungen der Klimasensitivität).

Zweitens ist unser Modell zeitabhängig, mit monatlicher Zeitauflösung, so dass wir (zum Beispiel) die jüngste Beschleunigung des Temperaturanstiegs in der Tiefsee (Wärmeinhalt des Ozeans) untersuchen können.

Im Gegensatz zu Lewis & Curry und der Differenzierung der Durchschnittswerte zweier Zeiträume, die mehr als 100 Jahre auseinander liegen, verwenden wir ein zeitabhängiges Modell der vertikalen Energieflüsse, über das ich schon einmal geschrieben habe. Es wird mit monatlicher Zeitauflösung betrieben und ermöglicht so die Untersuchung von Themen wie der jüngsten Beschleunigung des Anstiegs des ozeanischen Wärmeinhalts (OHC).

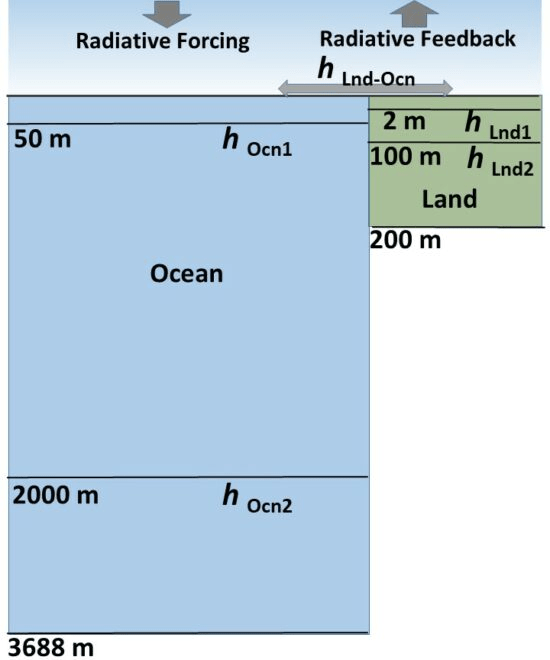

Als Reaktion auf die Kommentare der Rezensenten habe ich den Bereich der nicht von Eis bedeckten Ozeane (60N-60S) auf die globale Abdeckung (einschließlich Land) ausgedehnt und auf Bohrlöchern basierende Schätzungen der Erwärmungstrends in der Tiefe des Landes vorgenommen (ich glaube, das ist eine Premiere für diese Art von Arbeit). Das Modell bleibt ein 1D-Modell der Temperaturabweichungen vom angenommenen Energiegleichgewicht innerhalb von drei Schichten, die in Abb. 1 schematisch dargestellt sind:

Eine Sache, die ich dabei gelernt habe ist, dass, obwohl die Bohrlochtemperaturen auf eine Erwärmung hinweisen, die sich bis in eine Tiefe von fast 200 m erstreckt (deren Ursache mehrere Jahrhunderte zurückzuliegen scheint), moderne Erdsystem-Modelle (ESMs) eingebettete Landmodelle haben, die sich nur bis zu einer Tiefe von etwa 10 m erstrecken.

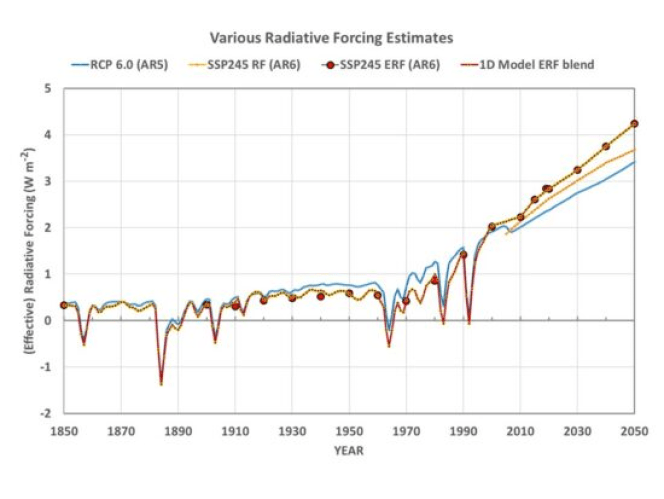

Eine andere Sache, die ich gelernt habe (im Laufe der Beantwortung der Kommentare der Rezensenten) ist, dass der angenommene Strahlungsantrieb einen ziemlich großen Einfluss auf die diagnostizierte Klimasensitivität hat. Ich habe das RCP6-Szenario für den Strahlungsantrieb aus dem vorherigen IPCC-Bericht (AR5) verwendet, aber als Reaktion auf die Vorschläge der Rezensenten betone ich jetzt das SSP245-Szenario aus dem jüngsten Bericht (AR6):

Ich habe alle Modellsimulationen entweder mit dem einen oder dem anderen Datensatz für den Strahlungsantrieb durchgeführt, initialisiert im Jahr 1765 (ein üblicher Ausgangspunkt für ESMs). Alle nachstehenden Ergebnisse basieren auf dem neuesten (SSP245) Szenario für den effektiven Strahlungsantrieb, das vom IPCC bevorzugt wird (und das, wie sich herausstellt, tatsächlich zu niedrigeren ECS-Schätzungen führt).

Die Modellexperimente

Zusätzlich zu der Annahme, dass die Szenarien für den Strahlungsantrieb eine relativ genaue Darstellung dessen sind, was den Klimawandel seit 1765 verursacht hat, besteht auch die Annahme, dass unsere Temperaturdatensätze genau genug sind, um ECS-Werte zu berechnen.

Wenn wir uns also auf diese Annahmen verlassen, können wir weitermachen…

Ich habe das Modell mit Tausenden von Kombinationen von Wärmeübertragungs-Koeffizienten zwischen den Modellschichten und dem Parameter für die Netto-Rückkopplung (der den ECS-Wert bestimmt) laufen lassen, um Temperaturtrends zwischen 1970 und 2021 innerhalb bestimmter Bereiche zu erhalten.

Für die Trends der Landtemperatur habe ich 5 „verschiedene“ Landdatensätze verwendet: CRUTem5 (+0,277 C/Dekade), GISS 250 km (+0,306 C/Dekade), NCDC v3.2.1 (+0,298 C/Dekade), GHCN/CAMS (+0,348 C/Dekade) und Berkeley 1 deg. (+0,280 C/Dekade).

Für die globale durchschnittliche Meeresoberflächentemperatur habe ich HadCRUT5 (+0,153 C/Dekade), Cowtan & Way (HadCRUT4, +0,148 C/Dekade) und Berkeley 1 deg. (+0,162 C/Dekade) verwendet.

Für den tiefen Ozean habe ich Cheng et al. 0-2000m globale durchschnittliche Ozeantemperatur (+0,0269 C/Dekade) und Chengs Schätzung der Erwärmung in der Tiefe von 2000-3688m verwendet, die eine (sehr unsichere) Gesamterwärmung von +0,01 über die letzten 40 Jahre ergibt. Das Modell muss die Oberflächentrends innerhalb des von diesen Datensätzen repräsentierten Bereichs und die Trends in 0-2000 m Tiefe innerhalb von +/-20 % der Trends der Cheng-Tiefseedaten erzeugen.

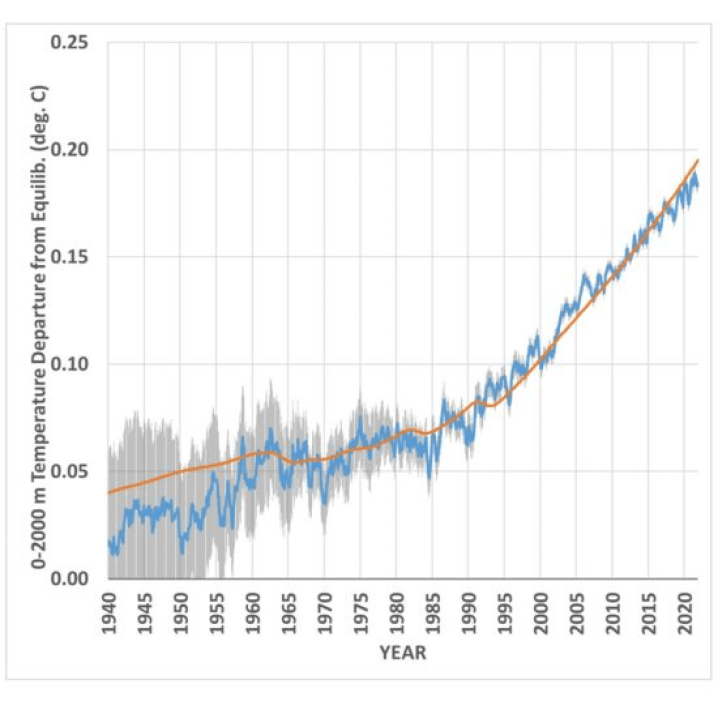

Da die Wärmespeicherung in der Tiefsee ein so wichtiger Faktor für die ECS ist, zeige ich in Abb. 3 den 1D-Modelllauf, der den 0-2000m-Temperaturtrend von +0,0269 C/Dekade über den Zeitraum 1970-2021 am besten wiedergibt:

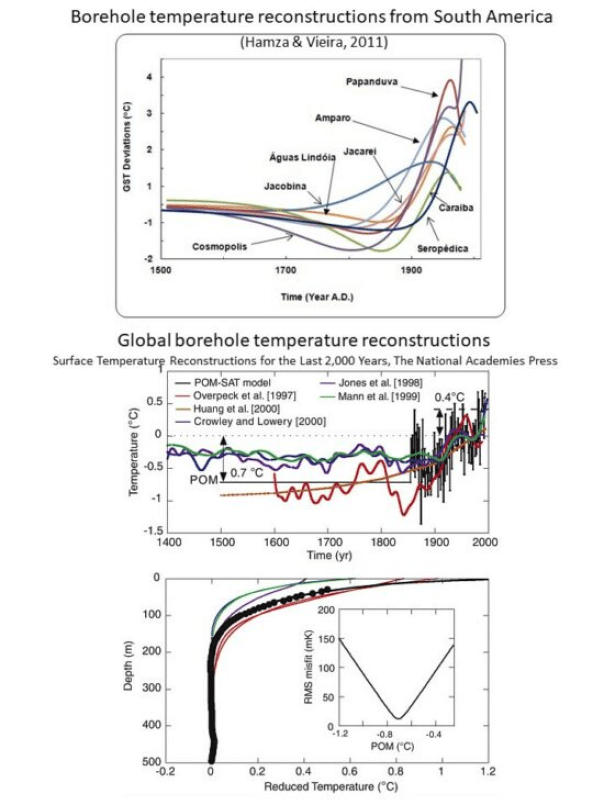

Schließlich wird die Wärmespeicherung seitens der Landoberfläche bei solchen Bemühungen in der Regel ignoriert. Wie bereits erwähnt, sind in die Klimamodelle Modelle der Landoberfläche eingebettet, die nur bis in 10 m Tiefe reichen. Es wurden jedoch Bohrloch-Temperaturprofile analysiert, die auf eine Erwärmung bis zu 200 m Tiefe hindeuten (Abb. 4):

Diese große Tiefe wiederum deutet darauf hin, dass es einen Erwärmungstrend über mehrere Jahrhunderte gegeben hat, sogar im frühen 20. Jahrhundert, welchen der IPCC ignoriert und der auf eine natürliche Quelle für den langfristigen Klimawandel hindeutet. Jede natürliche Quelle der Erwärmung führt, wenn sie ignoriert wird, zu überhöhten Schätzungen des ECS und der Bedeutung des zunehmenden CO₂ in den Projektionen zum Klimawandel.

Anhand der schwarzen Kurve (unteres Feld von Abb. 4) habe ich geschätzt, dass sich die oberflächennahe Schicht 2,5 Mal schneller erwärmt als die 0-100 m Schicht und 25 Mal schneller als die 100-200 m Schicht. In meinen 1D-Modellsimulationen benötigte ich diese Menge an Wärmespeicherung in der Tiefe (analog zu den Berechnungen der Wärmespeicherung in der Tiefe des Ozeans, aber mit schwächeren Wärmeübergangs-Koeffizienten für Land und anderen volumetrischen Wärmekapazitäten).

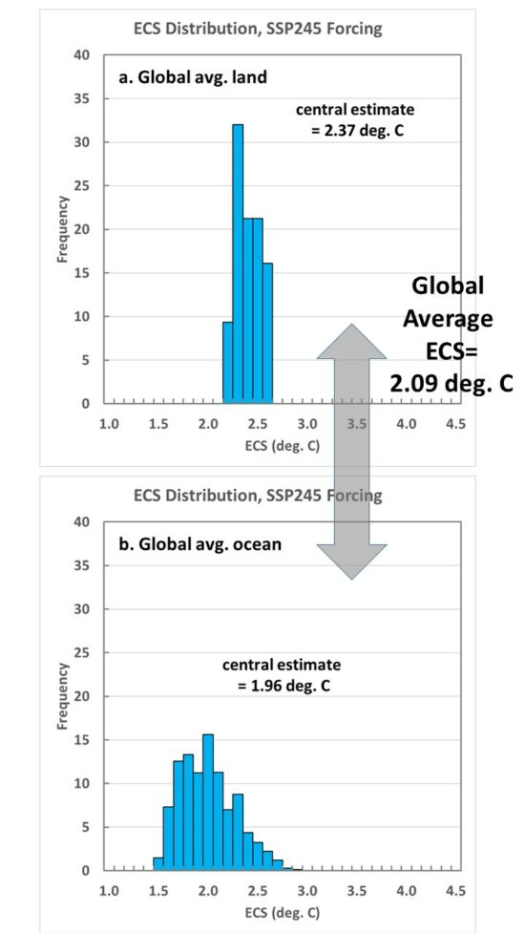

Die Verteilungen der diagnostizierten ECS-Werte, die ich für Land und Ozean erhalte, sind in Abb. 5 dargestellt:

Der endgültige globale durchschnittliche ECS aus den zentralen Schätzungen in Abb. 5 beträgt 2,09 Grad. C. Dies ist wiederum etwas höher als die 1,5 bis 1,8 deg. C, die Lewis & Curry ermittelt haben, aber das liegt zum Teil an den größeren Schätzungen für die Wärmespeicherung in den Ozeanen und an Land, die hier verwendet wurden, und ich vermute, dass unsere Verwendung von Daten aus den letzten 50 Jahren ebenfalls einen gewissen Einfluss hat.

Schlussfolgerungen

Ich habe ein zeitabhängiges 1D-Modell der Temperaturabweichungen vom angenommenen Energiegleichgewicht verwendet, um diese Frage zu beantworten: Was bedeuten die verschiedenen Schätzungen der Erwärmung an der Oberfläche und unter der Oberfläche in den letzten 50 Jahren für die Empfindlichkeit des Klimasystems gegenüber einer Verdoppelung des atmosphärischen CO₂?

Unter Verwendung der jüngsten Schätzungen des effektiven Strahlungsantriebs aus Anhang III des jüngsten IPCC-Berichts (AR6) deuten die Beobachtungsdaten auf eine geringere Klimasensitivität (ECS) hin als vom IPCC propagiert, mit einer zentralen Schätzung von +2,09 Grad Celsius für den globalen Durchschnitt. Dies liegt am unteren Ende der wahrscheinlichen Spanne des jüngsten IPCC-Berichts (AR6) von 2,0 bis 4,5 Grad. C.

Ich glaube, dass dies immer noch eine Obergrenze für ECS ist, und zwar aus den folgenden Gründen:

1. Die Bohrlochtemperaturen deuten auf einen langfristigen Erwärmungstrend hin, zumindest bis ins frühe 20. Jahrhundert. Wird dies (unabhängig von der Ursache) ignoriert, führt dies zu überhöhten Schätzungen des ECS.

2. Ich bin nach wie vor der Meinung, dass ein Teil der Landtemperaturdatensätze durch den langfristigen Anstieg der städtischen Wärmeinseleffekte verunreinigt wurde, die in Homogenisierungsschemata nicht von der Klimaerwärmung zu unterscheiden sind.

Link: https://wattsupwiththat.com/2022/12/20/climate-sensitivity-from-1970-2021-warming-estimates/

Übersetzt von Christian Freuer für das EIKE