Wärmeinsel-Effekte im sommerlichen Kanada: Einige Ergebnisse aus Alberta

Summary

Der Vergleich zwischen ländlichen und städtischen Temperaturmessungen in ganz Kanada während der Sommer 1978-2022 zeigt die erwartete durchschnittliche nächtliche Erwärmung in städtischen Gebieten mit einem schwächeren Effekt während des Tages. Bei der Anwendung der auf Landsat-Bildern basierenden Diagnose der zunehmenden Verstädterung im Laufe der Zeit wird festgestellt, dass 20 % der Temperaturtrends in einer kleinen Region, die Calgary und Edmonton umfasst, auf die zunehmende Verstädterung zurückzuführen sind. Calgary führt die Liste der kanadischen Städte mit zunehmender Verstädterung an, wobei schätzungsweise 50 % der nächtlichen Erwärmungstrends in 10 kanadischen Ballungsräumen auf die zunehmende Verstädterung zurückzuführen sind, und 20 % der Erwärmungstrends am Tag.

Introduction

Dies ist Teil meiner fortlaufenden Untersuchung des Ausmaßes, in dem landgestützte Temperaturdatensätze Erwärmungstrends erzeugen, die durch die zunehmende Verstädterung übertrieben werden (der städtische Wärmeinseleffekt, UHI). Die derzeitigen „Homogenisierungs“ -Verfahren zur Anpassung von Thermometerdaten versuchen nicht ausdrücklich, städtische Trends zu korrigieren, um sie an ländliche Trends anzupassen, obwohl ich davon ausgehe, dass sie diese Funktion erfüllen, wenn die meisten Stationen ländlich sind. Stattdessen laufen sie auf statistische „Konsensbildungs“-Übungen hinaus, bei denen die Mehrheit gewinnt. Wenn also die meisten Stationen in unterschiedlichem Ausmaß von zunehmenden UHI-Effekten betroffen sind, werden diese nicht zwangsläufig an die ländlichen Stationen angepasst. Das Gegenteil ist der Fall. In den USA hat beispielsweise die Analyse der Stationsdaten durch Watts et al. gezeigt, dass der homogenisierte US-Datensatz (USHCN) Temperaturtrends erzeugt, die genauso groß sind wie die der Stationen mit den schlechtesten Standorten in Bezug auf falsche Wärmequellen. Sie stellten ferner fest, dass die Verwendung von Thermometern nur an gut gelegenen Standorten zu einer erheblichen Verringerung der Temperaturtrends im Vergleich zu dem weithin verwendeten homogenisierten Datensatz führt.

Ich halte die Homogenisierung für einen Black-Box-Ansatz, der die falsche Erwärmung in den Thermometer-Aufzeichnungen, welche aus der weit verbreiteten Verstädterung im Laufe der Zeit resultiert, nicht berücksichtigt. Mein Ansatz war ein anderer: Ich dokumentiere die absoluten Temperaturunterschiede zwischen Stationspaaren und setze sie in Beziehung zu einem unabhängigen Maß für den Urbanisierungsunterschied. Der auf Landsat basierende globale Datensatz von „bebauten“ Gebieten (die ich im Folgenden grob als Maß für die Verstädterung bezeichnen werde) bietet die Möglichkeit, die Verstädterung in Thermometerdaten zu korrigieren, die bis in die 1970er Jahre zurückreichen (als die Landsat-Satellitenserie begann).

Ich habe mich zunächst auf den Südosten der USA konzentriert, auch weil mein Mitforscher John Christy Klimatologe des Bundesstaates Alabama ist und ich zum Teil von diesem Amt finanziert werde. Aber ich untersuche auch andere Regionen. Bislang habe ich einige vorläufige Analysen für das Vereinigte Königreich, Frankreich, Australien, China und Kanada durchgeführt. Hier werde ich einige erste Ergebnisse für Kanada vorstellen.

Der erste Schritt besteht darin, anhand von eng beieinander liegenden Stationen den Unterschied der monatlichen Durchschnittstemperaturen zwischen eher städtischen und eher ländlichen Gebieten zu quantifizieren. Der Temperaturdatensatz, den ich verwende, ist die Global Hourly Integrated Surface Database (ISD), die kontinuierlich bei NOAA/NCEI archiviert wird. Die Daten werden von stündlichen (oder dreistündlichen) Beobachtungen dominiert, die zur Unterstützung der Luftfahrt auf Flughäfen in der ganzen Welt gemacht werden. Sie sind größtenteils (aber nicht vollständig) unabhängig von den Maximal- und Minimalmessungen (Tmax und Tmin), aus denen andere weit verbreitete und homogenisierte globale Temperaturdatensätze bestehen. Der Vorteil des ISD-Datensatzes ist die stündliche Zeitauflösung, die eine gründlichere Untersuchung von Tag- und Nachteffekten sowie eine bessere Instrumentierung und Wartung zur Unterstützung der Flugsicherheit ermöglicht. Ein Nachteil ist, dass der Datensatz im Vergleich zu den Tmax/Tmin-Datensätzen nicht so viele Stationen enthält.

Wie ich in meinem letzten Beitrag zu diesem Thema dargelegt habe, ist eine entscheidende Komponente meines Verfahrens der relativ neue, hochauflösende (1 km) globale Datensatz zur Urbanisierung, der seit 1975 im Rahmen des EU-Projekts Global Human Settlement (GHS) von den Landsat-Satelliten abgeleitet wurde. Dadurch kann ich benachbarte Stationen vergleichen, um zu quantifizieren, wie viel städtische Wärme mit Unterschieden in der Verstädterung zusammenhängt, die anhand von Landsat-Bildern von „bebauten“ Strukturen diagnostiziert werden.

Städtische vs. ländliche Sommertemperaturen in Kanada

Kanada ist ein überwiegend ländliches Land, in dem die Temperatur-Messstationen weit verstreut sind. Der größte Teil der Bevölkerung (wo sich die meisten Thermometer befinden) konzentriert sich entlang der Küsten und vor allem an der Grenze zu den USA. Im Vergleich zur Größe des Landes gibt es relativ wenige Flughäfen, was die Anzahl der Vergleiche zwischen ländlichen und städtischen Gebieten einschränkt, die ich vornehmen kann.

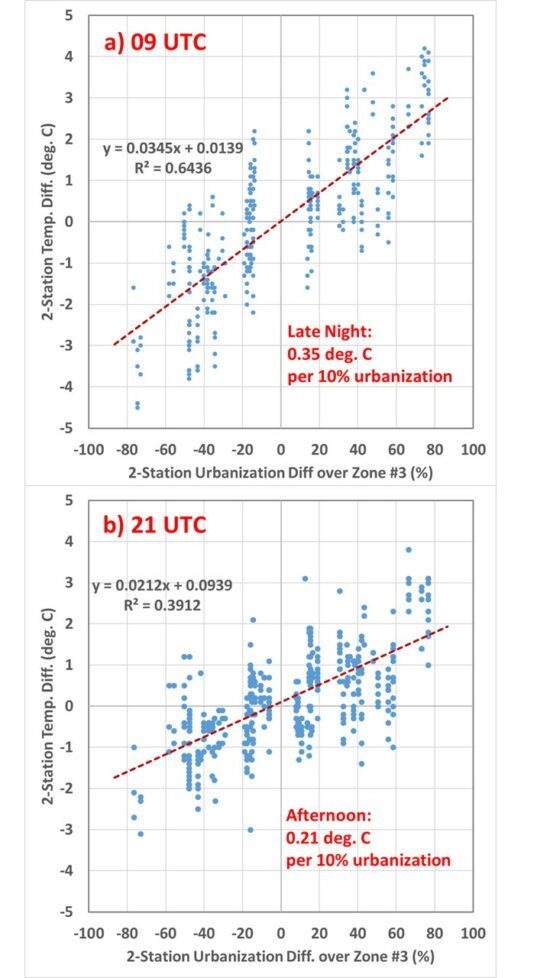

Für einen maximalen Abstand von 150 km zwischen den Stationspaaren sowie einige andere Tests für die Einbeziehung (z. B. weniger als 300 m Höhenunterschied zwischen den Stationen) zeigt Abb. 1 die Unterschiede bei der Durchschnittstemperatur und den flächenbezogenen Durchschnittswerten der Landsat-basierten Urbanisierung für (a) 09 UTC (späte Nacht) und (b) 21 UTC (Nachmittag). Diese Zeiten wurden so gewählt, dass sie ungefähr den Zeiten der Mindest- und Höchsttemperaturen (Tmin und Tmax) entsprechen, die in anderen globalen Temperaturdatensätzen enthalten sind, so dass ich einen Vergleich mit ihnen anstellen kann.

Abb. 1 Vergleich der Temperaturunterschiede zwischen nahe beieinander liegenden kanadischen Stationen und Landsat-basierten Urbanisierungsschätzungen für (a) die Nacht und (b) den Tag. Bei den Daten handelt es sich um monatliche Durchschnittstemperaturen für Juni, Juli und August in den Jahren 1988-1992, 1998-2002 und 2012-2016, die den Landsat-Datensätzen der Jahre 1990, 2000 und 2014 entsprechen. Im ISD-Archiv waren nicht genügend Thermometerdaten vorhanden, um sie mit den Landsat-Urbanisierungsschätzungen von 1975 zu verwenden. Die flächengemittelte Zone 3 ist ~21×21 km groß, zentriert auf jede Station.

Wie andere Studien gezeigt haben, ist der UHI-Effekt auf die Temperatur nachts größer, wenn die vom Boden absorbierte Sonnenenergie (die im Vergleich zum Boden oder zur Vegetation eine hohe Wärmeleitfähigkeit hat) in die Luft abgegeben wird und durch die Stabilität der nächtlichen Grenzschicht und die im Vergleich zum Tag schwächeren Winde über der Stadt gefangen wird. Für diesen begrenzten Satz kanadischer Stationspaare beträgt die UHI-Wärmeverzerrung 0,21 deg. C pro 10 % Verstädterung während des Tages und 0,35 deg. C pro 10 % in der Nacht.

Wenn wir diese Beziehungen auf die monatlichen Temperatur- und Verstädterungsdaten von ca. 70 über ganz Kanada verteilten Stationen anwenden, erhalten wir eine Vorstellung davon, wie stark die zunehmende Verstädterung die Temperaturtrends beeinflusst hat. (HINWEIS: Die Beziehungen in Abb. 1 gelten nur für den Durchschnitt, daher ist nicht bekannt, wie gut sie auf die einzelnen Stationen in den folgenden Tabellen zutreffen).

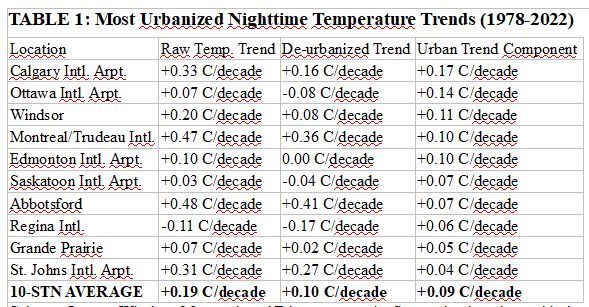

Von den etwa 70 kanadischen Stationen sind im Folgenden die 10 Stationen mit den größten diagnostizierten falschen Erwärmungstrends (1978-2022) aufgeführt. Man beachte, dass die rohen Trends beträchtliche Schwankungen aufweisen, von denen einige wahrscheinlich nicht wetter- oder klimabedingt sind (Änderungen in der Instrumentierung, Standortwahl usw.). Tabelle 1 enthält die Ergebnisse für die Nachtzeit, Tabelle 2 für die Tageszeit.

Calgary, Ottawa, Windsor, Montreal und Edmonton sind die fünf Stationen mit der größten Verstädterungsrate seit den 1970er Jahren, wie sie von Landsat gemessen wurde, und daher auch mit der größten Rate an unechter Erwärmung seit 1978 (dem frühesten Zeitpunkt, für den mir vollständige stündliche Temperaturdaten vorliegen). Im Durchschnitt der 10 Orte mit dem höchsten Wachstum sind schätzungsweise 48 % des durchschnittlichen Erwärmungstrends allein auf die Verstädterung zurückzuführen.

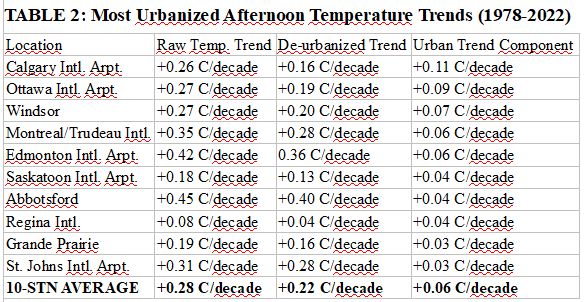

Tabelle 2 zeigt die entsprechenden Ergebnisse für die sommerlichen Nachmittagstemperaturen, von denen wir aus Abb. 1 wissen, dass sie schwächere UHI-Effekte haben als die nächtlichen Temperaturen:

Für die 10 am stärksten verstädterten Stationen in Tabelle 2 beträgt die durchschnittliche Verringerung der beobachteten Erwärmungstrends am Nachmittag 20 %, verglichen mit 48 % für die Trends in der Nacht.

Vergleich mit den CRUTem5-Daten in Süd-Alberta

Wie wirken sich die Ergebnisse in Tabelle 1 auf die weithin berichteten Erwärmungstrends im Durchschnitt von ganz Kanada aus? In Anbetracht der Tatsache, dass Kanada überwiegend ländlich geprägt ist und nur spärliche Messungen vorliegen, lässt sich dies anhand der verfügbaren Daten nur schwer feststellen. Es steht jedoch außer Frage, dass das Bewusstsein der Öffentlichkeit in Bezug auf Fragen des Klimawandels stark von den Bedingungen an ihrem Wohnort beeinflusst wird, und die meisten Menschen leben in städtischen Gebieten.

Um zu prüfen, ob diese meist flughafenbasierten Temperaturmessungen für die Klimaüberwachung geeignet sind, habe ich die Region im Südosten Albertas untersucht, die durch die Breiten-/Längengrade 50-55N und 110-115W begrenzt wird und Calgary und Edmonton umfasst. Das Vergleichsgebiet wird durch den vom IPCC genehmigten CRUTem5-Temperaturdatensatz bestimmt, der Durchschnittsdaten auf einem 5-Grad-Raster für Breiten- und Längengrade enthält.

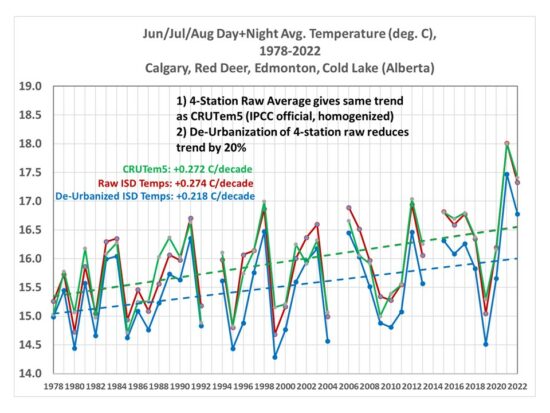

Mein Datensatz enthält vier Stationen in dieser Region, und die Mittelung der Rohtemperaturdaten der vier Stationen ergibt einen Trend (Abb. 2), der im Wesentlichen mit dem des CRUTem5-Datensatzes identisch ist, der über umfangreiche Homogenisierungsmethoden und (vermutlich) über viel mehr Stationen verfügt (deren Aufzeichnungszeiträume oft begrenzt sind und die daher zusammengefügt werden müssen). Dieses hohe Maß an Übereinstimmung ist zumindest teilweise zufällig.

Abb. 2. Monatliche Durchschnittstemperaturen im Sommer (Juni-Juli-August), 1978-2022, für Südost-Alberta, aus dem CRUTem5-Datensatz des IPCC (grün), Rohtemperaturen von 4 Stationen (rot) und de-urbanisierte Durchschnittstemperaturen von 4 Stationen (blau). Auf die CRUTem5-Anomalien wird ein Temperatur-Offset angewandt, so dass sich die Trendlinien im Jahr 1978 schneiden.

Die Anwendung der Urbanisierungskorrekturen aus Abb. 1 (groß für Calgary und Edmonton, winzig für Cold Lake und Red Deer) führt zu einer durchschnittlichen Verringerung des Trends der Gebietsdurchschnittstemperatur um 20 %. Dies untermauert meine Behauptung, dass die auf die globalen Tmax/Tmin-Datensätze angewandten Homogenisierungsverfahren die städtischen Trends nicht an die ländlichen Trends angepasst haben, sondern stattdessen eine „wählerische“ Anpassung darstellen, bei der ein Datensatz, der von Stationen mit zunehmender Verstädterung dominiert wird, die Trendcharakteristiken der UHI-kontaminierten Standorte weitgehend beibehält.

Conclusions

Kanadische Städte weisen im Sommer einen beträchtlichen städtischen Wärmeinseleffekt auf, insbesondere nachts, und auf Landsat basierende Schätzungen der zunehmenden Verstädterung deuten darauf hin, dass dies eine falsche Erwärmungskomponente der gemeldeten Temperaturtrends verursacht hat, zumindest für Orte mit zunehmender Verstädterung. Ein begrenzter Vergleich in Alberta deutet darauf hin, dass der CRUTem5-Datensatz nach wie vor eine Verzerrung der Erwärmung in Städten aufweist, was mit meinen früheren Beiträgen zu diesem Thema und der Arbeit anderer übereinstimmt.

Das Thema ist wichtig, weil eine rationale Energiepolitik auf der Realität und nicht auf der Wahrnehmung basieren sollte. In dem Maße, in dem die Schätzungen der globalen Erwärmung übertrieben sind, werden auch die energiepolitischen Entscheidungen übertrieben sein. Schon jetzt gibt es Anzeichen dafür (z. B. hier), dass die Klimamodelle, die als Richtschnur für die Politik dienen, eine stärkere Erwärmung ergeben als beobachtet, vor allem im Sommer, wenn die übermäßige Hitze ein Problem darstellt. Wenn die beobachtete Erwärmung noch geringer ist als angegeben, dann werden die Klimamodelle für energiepolitische Entscheidungen zunehmend irrelevant.

This piece originally appeared at Drroyspencer.com and has been republished here with permission.

Übersetzt von Christian Freuer für das EIKE