Fracking – und der deutsche Kampf dagegen

ERDGASFÖRDERUNG IN DEUTSCHLAND

Beim 2017 eingeführten Fracking-Verbot spielten Umwelt-NGOs eine entscheidende Rolle: Sie zeichneten ein Schreckensbild der Technologie, das mit der Realität nichts zu tun hat. Das Verbot sollte bis mindestens 2021 gelten, danach sollte der Bundestag entscheiden. Doch der rührt sich nicht.

von Holger Douglas

Der Erdgaspreis stieg dramatisch an. Die Erdgasmengen, die die Gasfelder in Nordamerika und in der Nordsee lieferten, gingen zurück. Das war 2008, also noch gar nicht so lange her. ‚Das war’s jetzt mit dem Erdgas‘ – war die Stimmung zu jener Zeit.

Doch bereits vor 25 Jahren hatte der amerikanische Erdöl-Ingenieur Nick Steinsberger probiert, wie man Schiefergestein tief unter der Erde aufspaltet, damit Erdgas entströmen kann. Eine alte Idee: Bereits in den 1940er Jahren war die sogenannte hydraulische Frakturierung erfunden worden. Dabei pumpen die Ingenieure Erdölgele in gashaltige Schichten, um das Gas zum Fließen zu bringen. Doch das funktionierte nicht im Schiefergestein, das jedoch erhebliche Mengen an Gas und Öl enthält. Die Schieferschichten schließen die Gasvorkommen ein; es galt also, das Gestein durchlässig zu machen.

Steinsberger probierte es, indem er Wasser und dann Sand in die Risse leitete. So wurde das Gas aus den Bläschen im Gestein herausgedrückt. Mit dieser »Slick-Water-Fracking«-Methode kam er mit weit weniger Chemikalien aus als bei früheren Technologien – der Weg zur Ausbeutung mächtiger weltweiter Schiefergasvorkommen war frei.

Ein Ergebnis dieser neuen Methode: Die Erdgasproduktion in den USA stieg rasch an, bald darauf ebenso die Öl-Produktion. Die USA überholten Russland als größten Gasproduzenten der Welt und Saudi-Arabien als größten Ölproduzenten. Heute ist Steinberger Chef eines Gasconsulting-Unternehmens und war bereits an mehr als 1000 Schieferbohrungen beteiligt.

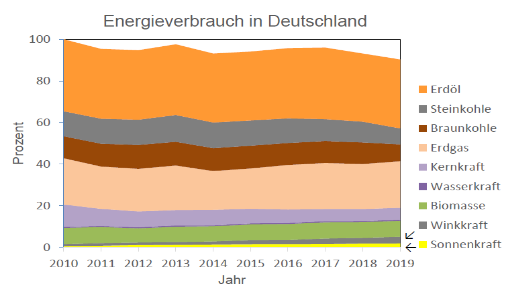

Der billige Gaspreis zog zahlreiche Chemieunternehmen an, die Fabriken in den USA aufbauten – darunter auch die deutsche BASF. Dies ist die große Energiegeschichte des letzten Jahrzehnts, so sagen Öl- und Gasexperten – im Gegensatz zur Wind- und Solarenergie, die kaum mehr als zwei Prozent der weltweiten Primärenergie liefern. Damals dachte man sich nichts dabei, ölhaltige Stoffe ins Gestein zu pumpen. Denn diese Gesteine sind schließlich bereits mit Öl und Gas getränkt. Die Panik vor dem Fracking kam erst später auf, als NGOs Kampagnen gegen Fracking als lukratives neues Geschäftsfeld entdeckten.

Es war im Wesentlichen ein Videofilm aus dem Jahr 2010, der mit zweifelhaften Methoden massive Angst vor dem Fracking erzeugte: »Gasland«. Vor allem eine Szene schürte die Angst, in der aus einem Wasserhahn strömendes Methan angezündet wurde. Doch ist dies an einer Reihe von Orten ein natürliches Phänomen, wenn Grundwasser mit Gas in Verbindung kommt und »verunreinigt« wird. In diesem Fall, von dem der Film erzählt, wurde das Wasser vom Wasserwerk durch Kohleflöze geleitet; dabei reicherte es sich auch etwas mit Methan an. Mit Frackingmethoden hatte dies nichts zu tun.

Auch hierzulande wird eine Verschmutzung des Grundwassers bei der Gewinnung von Schiefergas als Argument gegen das Fracking vorgeschoben. Doch Grundwasser kommt meist aus Tiefen zwischen 20 und 50 Meter, mitunter auch maximal bis 400 Meter. Erdgas dagegen wird aus 3000 bis 5000 Meter Tiefe gefördert. Die notwendigen Chemikalien sollen wie Seife die Gleitfähigkeit erhöhen, Bakterien bekämpfen und Ablagerungen verhindern. Je nach Bohrloch-Lagerstätten werden unterschiedliche Mittel in sehr verdünntem Maßstab eingesetzt.

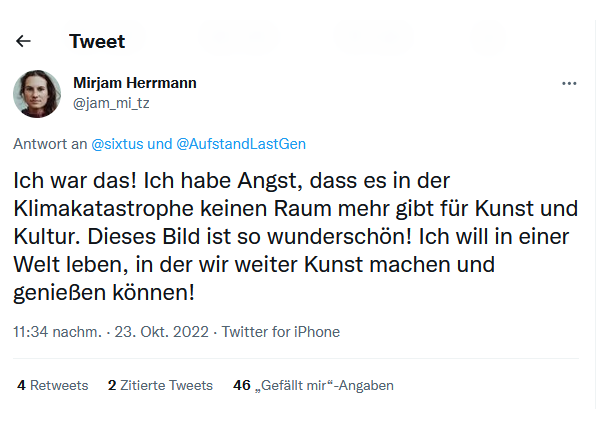

Der ehemalige Generalsekretär der Nato, Anders Rasmussen, hat seinerzeit sogar Russland vorgeworfen, die Umweltbewegung im Westen zu unterstützen – mit dem Ziel: die Abhängigkeit Europas von importiertem russischen Gas aufrechtzuerhalten.

In Deutschland werden nur noch etwa fünf Prozent des Bedarfs an Erdgas selbst gefördert. Doch die Mengen ließen sich relativ rasch wesentlich erhöhen. Nach der Bundesanstalt für Geowissenschaften und Rohstoffe würden die Vorkommen ausreichen, den Bedarf von Deutschland für etwa 25 Jahre zu decken. Die Förderung könnte innerhalb eines halben Jahres beginnen und schnell gesteigert werden.

Doch seit 2017 besteht ein Frackingverbot in Deutschland. Die damalige CDU-Kanzlerin hat mit der damaligen SPD-Umweltministerin Barbara Hendricks in einer Nacht- und Nebelaktion das sogenannte Fracking-Verbot durchgedrückt. Das Verbot des sogenannten unkonventionellen Frackings sollte bis mindestens 2021 gelten. Danach sollte der Bundestag eigentlich entscheiden, ob es bei den Regelungen bleibt. Tut der Bundestag nichts, würde das Verbot weiter gelten. Doch der Bundestag rührte sich nicht.

Im Augenblick stellt auch der stellvertretende Vorsitzende der Expertenkommission Fracking, Holger Weiß, das in Deutschland geltende Verbot der Erdgasförderung in Frage. »Man kann das eigentlich nur mit ideologischen Vorbehalten erklären. Einer sachlichen Grundlage entbehrt das«, so Weiß gegenüber der Frankfurter Allgemeinen Sonntagszeitung. Die beim Fracking mittlerweile verwendete Flüssigkeit sei kein Gift. »Das ist Spüli!« Weiß: »Heutzutage kann man Fracking mit einem vertretbaren Restrisiko machen.« Auch der Geologe Christoph Hilgers vom Karlsruher Institut für Technologie meinte: »Wenn man Fracking richtig macht, ist das Risiko gering. Das ist eine etablierte Technologie.«

Der ehemalige Präsident der Bundesanstalt für Geowissenschaften und Rohstoffe, Hans-Joachim Kümpel, wies in einem Gespräch mit der Welt auf die hohen Sicherheitsstandards und umfangreiche Genehmigungsverfahren hin, die es hier gebe. Einige Frackingvorhaben in den USA wären hier nicht genehmigt worden. Außerdem verfügten die Geologischen Dienste über hochaufgelöste Daten aus dem Untergrund und wüssten daher ziemlich genau über die Verhältnisse im Untergrund Bescheid. Nicht nur im Untergrund von Niedersachsen, sondern auch in Nordrhein-Westfalen sei mit den alten Flözgasen ein großes Potenzial vorhanden.

Doch hierzulande geht die derzeit bescheidene inländische Erdgasförderung weiter zurück – anstatt ausgeweitet zu werden. Die Frage ist jetzt: Wie viele Unternehmen, die viel Gas benötigen, müssen noch dicht machen, bevor Bewegung in die Förderung eigener Energievorkommen kommt? In Großbritannien wurde das Frackingverbot Ende September aufgehoben. Ein entsprechendes Fracking-Moratorium wurde Ende September aufgehoben, damit solle die Energiesicherheit des Landes gestärkt werden.

Außerdem will Großbritannien bis 2040 zum Netto-Energieexporteur werden. Die Kurzzeit-Premierministerin Lizz Truss hatte noch am Rande der UN-Generalversammlung in New York die Aufhebung verteidigt: »Fracking ist ein Teil des Energiemixes, wir sollten alle Optionen prüfen«. Alles müsse auf den Tisch, um die Energiesicherheit zu verbessern. »Denn das ist das Hauptproblem, mit dem wir konfrontiert sind.« Großbritannien verfügt ebenfalls über sehr reichhaltige Schiefervorkommen vor allem in Lancashire und Yorkshire, die für viele Jahrzehnte ausreichen.

Der Beitrag erschien zuerst bei TE hier