Meridionale Strömung, die fundamentalste aller Klima-Variablen

„Der atmosphärische Wärmetransport auf der Erde vom Äquator zu den Polen wird größtenteils von den Stürmen der mittleren Breiten durchgeführt. Es gibt jedoch keine zufriedenstellende Theorie zur Beschreibung dieses grundlegenden Merkmals des Erdklimas.“ – (Barry, Craig, & Thuburn, 2002)

Dies ist die Abschrift des Vortrags, den ich in Tom Nelsons Podcast-Interview hier gehalten habe.

Nachdem Leon Barry und seine Kollegen die obige Aussage in ihrem Nature-Artikel gemacht hatten, schreiben sie, dass die mittleren Breiten eine Zone mit starken Temperaturgradienten sind und diese Gradienten Stürme erzeugen, die schwerwiegend sein können. Je geringer der Temperaturgradient zwischen den Tropen und den Polen ist, desto weniger schwere Stürme sind erforderlich, um die Aufgabe zu erfüllen, überschüssige tropische Energie (oder Wärme) zu den Polen zu transportieren. Behalten Sie dieses Konzept im Hinterkopf, wenn ich den meridionalen (Nord-Süd-) Energietransport beschreibe.

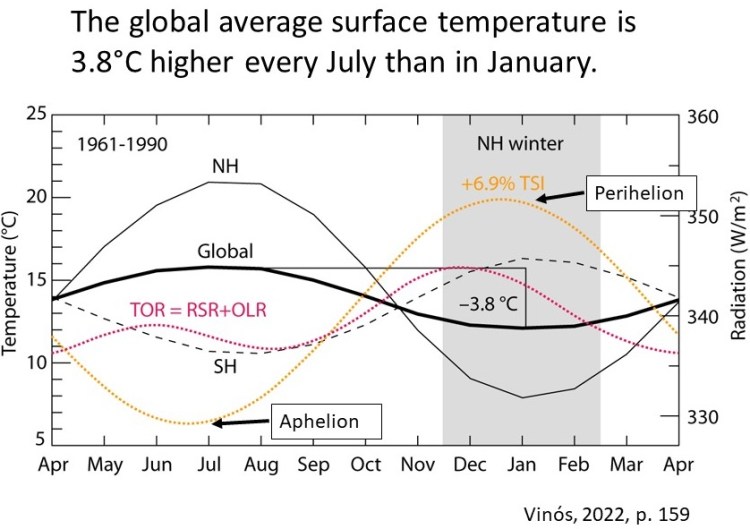

Ein Großteil dieses Vortrags basiert auf Javier Vinós‘ neuem Buch Climate of the Past, Present, and Future, A Scientific Debate, 2nd Edition, Kapitel 10. Abbildung 1 aus dem Buch zeigt die globale Durchschnittstemperatur über ein durchschnittliches Jahr:

Abbildung 1. Globale und hemisphärische Temperatur- und Strahlungsveränderungen über ein mittleres Jahr.

Die gesamte Sonneneinstrahlung (in Abbildung 1 als TSI bezeichnet) macht über 99,9 % des Energieeintrags in das Klimasystem aus. Die von der Sonne empfangene Energie ändert sich im Laufe des Jahres um 6,9 %, was auf den sich ständig ändernden Abstand zwischen Erde und Sonne zurückzuführen ist. Die Erde ist der Sonne am 4. Januar am nächsten (Perihel) und am 4. Juli am weitesten entfernt (Aphel). Obwohl die Hälfte der Erde zu jeder Zeit von der Sonne bestrahlt wird, verursachen die Veränderungen in der Ausrichtung der Erdachse, die unregelmäßige Verteilung der Landmassen, Veränderungen in der Albedo (oder Reflektivität) und regionale Veränderungen in der Oberflächen- und Lufttemperatur erhebliche jahreszeitliche Veränderungen in der Menge der reflektierten Sonnenstrahlung (in Abbildung 1 als „RSR“ bezeichnet) und der ausgehenden langwelligen Strahlung (oder „OLR“). Infolgedessen ändert sich die Temperatur der Erde ständig, und der Planet befindet sich nie im thermischen Gleichgewicht.

Entgegen unserer Erwartung ist die Erde kurz nach der Juni-Sonnenwende am wärmsten, wenn sie am weitesten von der Sonne entfernt ist, und kurz nach der Dezember-Sonnenwende am kältesten, wenn sie 6,9 % mehr Energie von der Sonne erhält. Die durchschnittliche Temperatur der Erde beträgt etwa 14,5 °C, was nach geologischen Maßstäben kalt ist, aber im Laufe des Jahres erwärmt und kühlt sie sich um 3,8 °C, wie in Abbildung 1 dargestellt. Erwartungsgemäß gibt die Erde mehr Energie ab (TOR genannt, die rote gestrichelte Linie in Abbildung 1), wenn sie sich abkühlt, und weniger, wenn sie sich erwärmt, unabhängig davon, was sie zu diesem Zeitpunkt empfängt. Die Vorstellung eines Energiegleichgewichts an der Obergrenze der Atmosphäre ist eindeutig falsch. Die Erde weist von Jahr zu Jahr nur sehr geringe Temperaturschwankungen auf, aber es gibt keinen Grund zu der Annahme, dass wir die an der Temperaturstabilität der Erde beteiligten Prozesse richtig verstehen. Und natürlich ist die Vorstellung absurd, dass eine globale Erwärmung von zwei Grad gefährlich ist.

In Abbildung 1 ändert sich die globale Oberflächentemperatur des Planeten (die dicke schwarze Linie in Abbildung 1) vor allem deshalb so stark, weil die nördliche Hemisphäre (die dünne durchgezogene schwarze Linie) in einem mittleren Jahr um 12 °C schwankt. Der Planet hat zwei Spitzen des Energieverlusts an den Weltraum (oder TOR in Abbildung 1), nämlich dann, wenn jeder Pol dunkel ist und abkühlt. Der höchste Wert wird erreicht, wenn der Nordpol dunkel ist. Zwischen November und Januar gibt der Planet mehr Energie ab als zu jeder anderen Zeit. Die südliche Hemisphäre ist die gestrichelte schwarze Linie. Die Temperaturdaten für 1961-1990 stammen von Phil Jones vom Hadley Climatic Research Center. Die Strahlungsdaten stammen von Barbara Carlson und Kollegen.

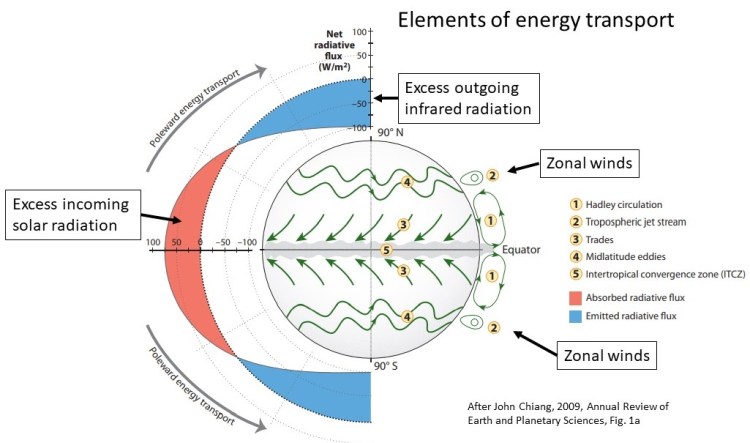

Abbildung 1 zeigt, dass das Klimasystem zwar vollständig durch die Sonneneinstrahlung angetrieben wird, die Temperatur der Erde aber dadurch bestimmt wird, was das Klimasystem mit dieser Energie macht. Doch das Klimasystem ist äußerst komplex. Wie Leon Barry und seine Kollegen in dem Zitat am Anfang dieses Vortrags sagen, fehlt der modernen Klimatologie eine richtige Theorie darüber, wie sich die Energie im Klimasystem unseres Planeten bewegt. Es ist möglich, etwas zu modellieren, was nicht richtig verstanden wird, aber an ein solches Modell zu glauben, ist töricht. Abbildung 2 zeigt die grundlegenden Energie-Umverteilungsprozesse der Erde:

Abbildung 2. Eingehende und ausgehende Nettostrahlung der Erde sowie die grundlegenden Elemente der Umverteilung der Strahlung.

Die durchschnittliche absolute (oder Kelvin-) Temperatur der Erdoberfläche variiert nicht so stark mit dem Breitengrad, sie liegt zwischen 278 und 300 Kelvin zwischen 60°N-60°S. Die Strahlungsmenge, die die Erdoberfläche abgibt, ist eine Funktion dieser absoluten Temperatur, die Menge, die den Weltraum erreicht, ist hauptsächlich eine Funktion der Treibhausgas-Konzentration und der Wolkenbedeckung, die beide in den Tropen höher sind, wo die absoluten Temperaturen höher sind. Daher variiert die ausgehende langwellige Strahlung nicht so stark mit dem Breitengrad. Daraus ergibt sich, dass der Nettostrahlungsfluss an der Obergrenze der Atmosphäre (TOA) im Jahresdurchschnitt zwischen etwa 30°N-30°S positiv (mehr ein- als ausgehende Strahlung) und zwischen etwa 30° Nord oder Süd und den Polen negativ ist, wie in Abbildung 2 dargestellt. Der genaue Punkt, an dem die eingehende Nettostrahlung gleich der ausgehenden ist, hängt natürlich von der Hemisphäre, dem Monat des Jahres, anderen orbitalen Parametern und der Bewölkung ab, aber im Durchschnitt liegt er in der Nähe von 30° Nord oder Süd. Die Abkühlung, wenn man sich von den Tropen polwärts bewegt, ist hauptsächlich auf die geringere Sonneneinstrahlung zurückzuführen – die Menge an Sonnenenergie, die die Oberfläche erreicht. Die Verringerung der Sonneneinstrahlung in Richtung der Pole führt zu einem Nettoenergiedefizit und einem Temperaturgefälle in den Breitengraden. Durch den meridionalen Transport wird Energie von Breitengraden, in denen ein Netto-Energiegewinn besteht (der rote Bereich), zu Breitengraden transportiert, in denen ein Netto-Energieverlust in den Weltraum besteht (der blaue Bereich).

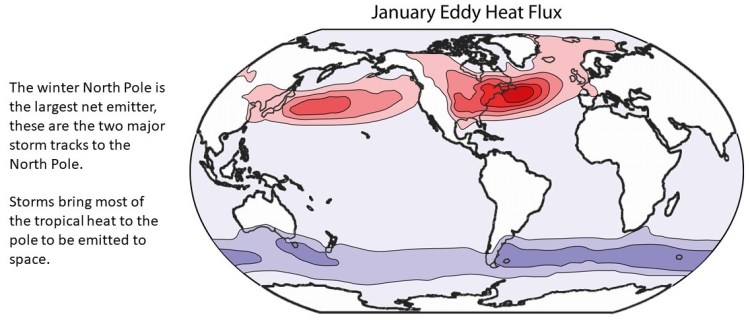

Durch den meridionalen Transport wird viel mehr Energie in Richtung des Winterpols transportiert. Der Winterpol strahlt viel mehr Energie in den Weltraum ab als er empfängt, da die Sonne unter dem Horizont steht. Praktisch die gesamte Energie, die der Winterpol abgibt, wird durch Winterstürme dorthin transportiert oder ist latente Wärme, die beim Gefrieren von Sommer-Schmelzwasser freigesetzt wird.

Ohne den meridionalen Transport würde die Temperatur der blauen Regionen – wo der Nettoenergiefluss in Richtung Weltraum negativ ist – kontinuierlich abnehmen, bis die ausgehende langwellige Strahlung so gering ist, dass sie der Sonneneinstrahlung entspricht. In der dunklen Polarnacht würde sich diese Temperatur dem absoluten Nullpunkt oder -273°C nähern. Durch den meridionalen Transport von Luft, Wasserdampf und Wasser in der Atmosphäre und in den Ozeanen bleibt die Temperatur am dunklen Pol jedoch viel höher.

Das Temperaturgefälle zwischen den Breitengraden der Erdoberfläche ist eine direkte Folge des Sonneneinstrahlungsgefälles in den Breitengraden. Thermische Energie fließt von wärmeren Regionen zu kälteren Regionen. Dies ist die physikalische Grundlage des meridionalen Transports, aber das Klimasystem ist komplex, so dass es sich keineswegs um einen passiven Prozess handelt, der nur von der Temperaturdifferenz zwischen den Tropen und den Polen abhängt. Vielmehr handelt es sich um einen komplexen Prozess, der sowohl von geografischen als auch von klimatischen Prozessen abhängt. Es ist möglich, mit einem geringeren Temperaturunterschied mehr Energie zu transportieren als mit einem größeren Temperaturunterschied. So hat beispielsweise der meridionale Transport in den ersten beiden Jahrzehnten des 21. Jahrhunderts zugenommen, trotz der Erwärmung der Arktis, die den Temperaturgradienten in Breitenrichtung verringert hat. Es ist nicht so einfach, wie Leon Barry und Kollegen in ihrem Artikel schreiben, aber vieles von dem, was er geschrieben hat, ist richtig.

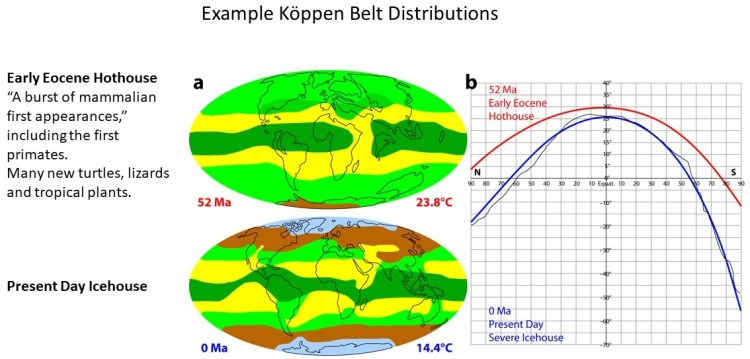

Wir wissen, dass der Temperaturgradient in den Breitengraden der Erde im Laufe der geologischen Vergangenheit stark variiert hat. Wladimir Köppen, ein russisch-deutscher Wissenschaftler, untersuchte im 19. Jahrhundert den Einfluss der Sonne auf das Klima und erstellte ein Klimaklassifizierungssystem, das noch heute verwendet wird. Seine Klimazonen werden anhand von Temperatur, Niederschlag und ihrer jahreszeitlichen Verteilung definiert. Viele Pflanzen- und Tiergruppen sind auf einen engen Temperaturbereich beschränkt, ebenso wie bestimmte geologische Prozesse. Anhand dieser Informationen sowie gut datierter Fossilien und Gesteinsformationen aus der ganzen Welt hat Christopher Scotese im Rahmen seines Paleomap-Projekts die Klimageschichte der Vergangenheit kartiert. Anhand dieser Informationen konnte er die globalen Köppen-Klimazonen alle fünf Millionen Jahre kartieren, seit Beginn des Phanerozoikums vor 540 Millionen Jahren. Karten der Köppen-Gürtel, wie sie heute und vor 52 Millionen Jahren existieren, sind in Abbildung 3 dargestellt:

Abbildung 3. Verteilung der Köppen-Gürtel heute im Vergleich zu vor 52 Millionen Jahren und die sich daraus ergebenden durchschnittlichen Temperaturgradienten nach Breitengraden. Quelle: Vinós, 2022, Seite 158.

Jede Köppen-Gürtelkombination definiert einen Temperaturgradienten in der Breite. Auf diese Weise können Scotese und seine Kollegen die in der rechten Abbildung gezeigten Temperaturdiagramme erstellen. Anhand dieser Diagramme lässt sich eine ungefähre globale durchschnittliche Oberflächentemperatur für diesen Zeitraum abschätzen. Scotese und seine Kollegen haben also gezeigt, dass der Temperaturgradient in Breitengraden eine grundlegende Klimavariable ist, eine Annahme, die mit dem Zitat von Barry et al. zu Beginn dieses Vortrags übereinstimmt. Nach den Definitionen von Scotese wird der gegenwärtige (21. Jahrhundert) latitudinale Temperaturgradient als ein „strenges Eishaus“ betrachtet, wie in Abbildung 3 dargestellt. In der rechten Grafik vergleichen wir den derzeitigen starken Eishaus-Temperaturgradienten in Blau mit dem Treibhausgradienten des frühen Eozäns vor 52 Millionen Jahren. Zu beachten ist, dass Grönland und die Antarktis heute mit Eis bedeckt sind (blau auf der unteren Karte), während die Pole auf der oberen Karte eisfrei sind. Ein Eishausklima ist durch ganzjährige Eisschilde an den Polen gekennzeichnet.

Das Klima im Treibhaus des frühen Eozäns war für heutige Verhältnisse recht warm. Die durchschnittliche globale Temperatur war bis zu 10 °C höher als heute. Das „Auftreten der ersten Säugetiere“ fiel in diese Zeit. Eines der Säugetiere, die im frühen Eozän erstmals auftraten, war der erste Primat, unser entfernter Vorfahre. Primaten verbreiteten sich schnell über die ganze Welt. Neben neuen Säugetieren entstanden und gediehen in dieser Zeit auch viele neue Gattungen von Schildkröten, Eidechsen und Pflanzen. Einige Tiefsee-Foraminiferen starben aus, aber den meisten Organismen ging es gut und sie verbreiteten sich weit.

Die Existenz sehr unterschiedlicher vergangener Klimazonen auf der Erde stellt ein unüberwindbares Problem für die moderne „Konsens“-Klimatologie dar. Während des letzten glazialen Maximums vor 20.000 Jahren war die von der Sonne empfangene Energie die gleiche wie heute. Und nicht nur das, auch die Milankovitch-Parameter der Erdumlaufbahn waren nahezu identisch. Die Verteilung der Sonnenenergie über der Erde war fast identisch mit der heutigen, doch das Klima war ganz anders. Der Energieeintrag in das Klimasystem muss geringer gewesen sein, weil die größeren Eisschilde mehr Sonnenenergie reflektierten und der Treibhauseffekt geringer war. Der geringere Treibhauseffekt war auf weniger CO2 in der Atmosphäre und weniger verfügbares Wasser zurückzuführen. Durch die niedrigeren Temperaturen war das CO2 in den Ozeanen besser löslich und wurde so der Luft entzogen. Die sehr großen kontinentalen Eisschilde während des letzten glazialen Maximums entzogen dem Klimasystem viel Wasser und Wasserdampf und speicherten es in Eis.

Ein geringerer Energieeintrag und ein größerer Nord-Süd-Temperaturgradient hätten den Tropen durch einen stärkeren meridionalen Transport Wärme entziehen müssen, was aber nicht der Fall war. Die tropischen Temperaturen während des letzten glazialen Maximums sind nach wie vor umstritten, aber es scheint, dass sie nur 1-2 °C niedriger lagen als heute. Dies steht im Einklang mit den von Chris Scotese und Kollegen vorgelegten Beweisen, dass sich die tropischen Temperaturen im Laufe der letzten 540 Millionen Jahre trotz enormer Veränderungen der Durchschnittstemperatur des Planeten (9-30 °C) nicht wesentlich verändert haben. Aus Abbildung 3 geht hervor, dass das sehr warme Treibhausklima des frühen Eozäns am Äquator eine ähnliche Temperatur aufweist wie heute, aber der Unterschied am Südpol beträgt 44 °C und am Nordpol 23 °C. Es ist offensichtlich, dass der größte Teil der Erwärmung in den höheren Breitengraden stattfindet.

Falls das letzte glaziale Maximum ein Problem für die Funktionsweise des meridionalen Transports während einer Eiszeit darstellt, führt das gleichmäßige Klima des frühen Eozäns zu einem Paradoxon, das die moderne Konsens-Klimatologie nicht lösen kann. Gegenwärtig befindet sich die Erde in einem strengen Eishausklima mit einem sehr steilen Temperaturgradienten in den Breitengraden, wie das rechte Diagramm in Abbildung 3 sehr deutlich zeigt. Gegenwärtig fällt die Temperatur vom Äquator bis zum Winterpol um 0,6-1°C/° Breitengrad. Eine derart kalte Umgebung war in den letzten 540 Millionen Jahren relativ selten und kam weniger als 10 % der Zeit vor. Im frühen Eozän herrschte auf der Erde eine geschätzte Durchschnittstemperatur von 24 bis 25 °C, die Scotese als Treibhausbedingungen bezeichnet. Das Temperaturgefälle in den Breitengraden des frühen Eozäns war mit 0,25 bis 0,45 °C/Breite sehr gering, wobei die Temperaturen am Nordpol das ganze Jahr über über dem Gefrierpunkt lagen, was durch das Vorhandensein von frosttoleranten Lebensformen belegt wird. Diese Gewächshausbedingungen sind noch seltener anzutreffen. Über 60 % des phanerozoischen Äons hatte die Erde eine Durchschnittstemperatur von 19 bis 20 °C. Die durchschnittliche globale Oberflächentemperatur des gesamten Phanerozoikums – der letzten 540 Millionen Jahre – liegt bei sehr angenehmen 18 °C, etwa 3,5 °C höher als heute.

Das Klima des frühen Eozäns wird als gleichmäßig definiert. Es ist durch eine warme Welt mit einem geringen Temperaturgefälle in den Breitengraden, einer geringen Saisonalität und weniger Stürmen in den mittleren und hohen Breitengraden als heute gekennzeichnet. Das Versagen der modernen Konsens-Klimatheorie bei der Erklärung dieser Perioden wird als „Problem des gleichmäßigen Klimas“ bezeichnet. Um die hohen kontinentalen Innentemperaturen des frühen Eozäns und die über dem Gefrierpunkt liegenden Winter in den Polarregionen zu reproduzieren, müssen die Modelle den CO2-Gehalt auf 4700 ppm erhöhen, eine unplausible Klimasensitivität für CO2 verwenden und zulassen, dass die tropischen Temperaturen 35°C überschreiten. Die besten CO2-Schätzungen für das Klimaoptimum im frühen Eozän gehen jedoch von einem wahrscheinlichen CO2-Gehalt von 500-1.000 ppm aus, und die höchsten Schätzungen liegen unter 2.000 ppm. Außerdem ist es unwahrscheinlich, dass in den Tropen Temperaturen über 30 °C möglich sind, da bei dieser Temperatur die Wärmeabfuhr durch Verdunstung und Tiefenkonvektion (Konvektion feuchter Luft in die obere Troposphäre) nicht mehr effizient ist. Außerdem können Säugetiere nicht über einer Feuchttemperatur von 35°C überleben, da sie dann keine Wärme mehr abgeben können. Fossilien zeigen uns jedoch, dass Säugetiere im frühen Eozän gut gediehen. Die höchste Feuchttemperatur auf der Erde liegt heute bei 30 °C, und es gibt keinen Grund zu der Annahme, dass sie zu irgendeinem Zeitpunkt in der Vergangenheit an Orten, an denen Fossilien von Säugetieren gefunden wurden, höher war.

Das Problem des gleichmäßigen Klimas ist eng mit dem „Low-Gradient-Problem“ verbunden. Wir gehen davon aus, dass für warme Pole mehr Wärme dorthin transportiert werden muss, insbesondere im Winter, um das Defizit der Sonneneinstrahlung auszugleichen. Der meridionale Wärmetransport ist ein sehr wichtiger Teil des planetarischen Energiehaushalts, und ohne ihn wären die Pole viel kälter. Der meridionale Transport hängt jedoch vom Temperaturgradienten in der Breite ab, da ein Großteil des polwärts gerichteten Transports im gegenwärtigen Klima durch Stürme in den mittleren und hohen Breiten erfolgt, die aus der atmosphärischen Instabilität aufgrund steiler Temperaturgradienten resultieren. Das Paradoxon entsteht dadurch, dass die warmen Pole des frühen Eozäns zwar mehr Energietransport zu erfordern scheinen, der geringere Temperaturgradient in Breitenrichtung aber einen geringeren meridionalen Transport zur Folge hat. Es ist kein Wunder, dass die Klimamodelle mit diesem Rätsel zu kämpfen haben.

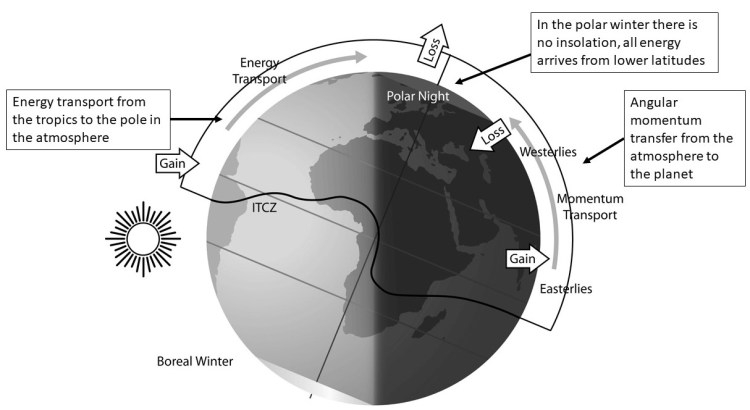

Abbildung 4. Schematische Darstellung der Strahlung, die an der Erdoberfläche ankommt und am winterlichen Nordpol austritt. Aus (Vinós, 2022, S. 171).

Die untere Atmosphäre ist ein dünner Gasfilm, der nur 1/600 des Erddurchmessers (oder etwa 10 km) beträgt. Diese dünne Atmosphäre hat die entscheidende Aufgabe, stets eine für komplexes Leben verträgliche Temperatur an der Landoberfläche aufrechtzuerhalten, was sie zumindest in den letzten 540 Millionen Jahren getan hat. Dazu muss sie die Temperaturunterschiede an der Oberfläche ausgleichen, die durch die unterschiedliche Sonneneinstrahlung entstehen. Zunächst muss sie den Unterschied zwischen Tag und Nacht ausgleichen. Dies geschieht vor allem durch den Treibhauseffekt und die Wolken, die die nächtliche Abkühlung verringern, indem sie die Strahlungsemissionen in den Weltraum verzögern, während die Wolken tagsüber die einfallende Sonnenstrahlung reflektieren. Darüber hinaus muss sie den Rückgang der Sonneneinstrahlung in den Breitengraden und die jahreszeitlichen Veränderungen aufgrund der Achsenneigung des Planeten ausgleichen. Dies geschieht durch den meridionalen Wärmetransport.

Die drei Faktoren, die für die thermische Stabilität der Erde verantwortlich sind, sind also der Treibhauseffekt, die Wolken und der meridionale Transport. Die moderne Klimatologie ignoriert die letzten beiden und konzentriert sich ausschließlich auf den ersten Faktor, indem sie die CO2-Klimahypothese entwickelt. Der Einfluss der Wolken und ihrer Variabilität auf den Klimawandel ist noch weitgehend unbekannt. Laut dem IPCC-Bericht AR6 (Seite 979) könnte die Rückkopplung der Wolken auf die Oberflächenerwärmung positiv oder negativ sein und stellt die größte Unsicherheitsquelle bei der Wirkung von Treibhausgasen auf das Klima dar.

Wie in Abbildung 4 zu sehen ist, findet der Energieaustausch zwischen dem Klimasystem und dem Weltraum nur über die Obergrenze der Atmosphäre statt. Dies bedeutet, dass der meridionale Transport einen Nettowert von Null hat, wenn er über den gesamten Planeten integriert wird, da die Verschiebung von Energie die Gesamtenergie innerhalb des Systems nicht verändert. Diese Tatsache hat viele Klimawissenschaftler zu der Annahme veranlasst, dass Veränderungen meridionaler Strömungen keinen Klimawandel verursachen können – wahrscheinlich der grundlegendste Fehler der modernen Konsens-Klimatologie.

Die Atmosphäre kann eine große Menge an Energie schnell und effizient über die gesamte Erdoberfläche transportieren. Der Großteil des meridionalen Transports wird hauptsächlich von der Atmosphäre bewirkt. Nur in den inneren Tropen (10°S-10°N) reicht die Atmosphäre für den notwendigen Energietransport nicht aus. Dies ist die Region, in der die meiste Sonnenenergie in das Klimasystem gelangt. In dieser Region muss der Ozean den größten Teil des Wärmetransports in den inneren Tropen übernehmen. Da der tropische Pazifik so groß ist – er umspannt fast die halbe Erde – gelingt es der El Niño/Southern Oscillation (ENSO), den tropischen Wärmeinhalt unter Kontrolle zu halten. El Niño ist die Art und Weise, wie die Erde in regelmäßigen Abständen überschüssige gespeicherte Wärme ausstößt, die durch normale meridionale Transportprozesse nicht abtransportiert werden konnte. ENSO ist ein wichtiger Teil des globalen meridionalen Transportsystems.

Polwärts von 10-20° Breite gibt der Ozean den größten Teil seiner Energie an die Atmosphäre ab, insbesondere in den Grenzströmungen der westlichen Ozeanbecken, wie dem Kuroshio-Strom im Pazifik und dem Golfstrom im Atlantik. Sobald die Meereiskante erreicht ist, wird der Transport im Wesentlichen ausschließlich von der Atmosphäre übernommen, da der Energiefluss durch das Meereis viel geringer ist als der von der flüssigen Ozeanoberfläche. Der primäre Mechanismus der Wärmeübertragung ist die Verdunstung, so dass die Meerestemperatur für den Energiefluss zwischen Ozean und Atmosphäre nicht so wichtig ist wie die Windgeschwindigkeit und die Luftfeuchtigkeit, da diese die Hauptfaktoren für die Verdunstung sind. Allerdings begrenzt die Verdunstung die maximale Meerestemperatur auf etwa 30 °C.

Wenn in den mittleren bis hohen Breiten West-Ost-Winde vorherrschen, nehmen die meridionalen oder Süd-Nord-Winde und der meridionale Energietransport ab, was zu einer globalen Erwärmung führt. Wenn die West-Ost-Winde (oder zonalen Winde) abnehmen, nimmt der meridionale Transport zu, mehr Energie erreicht den Pol, und der Planet kühlt sich ab.

Der Drehimpuls wird zwischen dem festen Erdozean und der Atmosphäre aufgrund von Änderungen der Windrichtung und -geschwindigkeit in den höheren Breitengraden ausgetauscht. Die Änderungen des Drehimpulses verändern die Rotationsgeschwindigkeit der Erde, die wir als Tageslänge messen. Die Tageslänge nimmt zu, was zu einem kürzeren Tag führt, wenn die durchschnittlichen zonalen (West-Ost-) Windgeschwindigkeiten zunehmen. Wenn die zonale Windgeschwindigkeit zunimmt, wird der Polarwirbel stärker, kalte Luft wird in der Arktis eingeschlossen, und der Planet erwärmt sich.

Die zonale Windzirkulation ist im Winter stärker, wenn aufgrund eines größeren Temperaturgefälles in der Breite mehr Drehimpuls in der Atmosphäre verbleibt, so dass sich die Erde im Januar und Juli schneller dreht und im April und Oktober langsamer, wenn die zonale Zirkulation schwächer ist. Es ist bekannt, dass der grundlegende 11-jährige Sonnenzyklus (der Schwabe-Zyklus) und der ENSO-Zyklus die zonalen und meridionalen Winde und damit die Geschwindigkeit der Erdrotation beeinflussen.

Doch während die Rolle von ENSO weithin bekannt ist und darüber berichtet wird, bleibt die Rolle der Sonne weitgehend unbeachtet. Wir haben festgestellt, dass die Sonne das Klima durch ihre Wirkung auf die atmosphärische Zirkulation beeinflusst, nicht durch Unterschiede in der gesamten Sonneneinstrahlung.

Abbildung 5. Die Hauptsturmbahnen der nördlichen Hemisphäre sind in rot dargestellt. Die Zugbahnen der Stürme auf der Südhalbkugel sind blau dargestellt, werden hier aber nicht behandelt. Aus (Vinós, 2022, S. 163).

Der Energietransport in der Atmosphäre ist mit dem Transport von Masse, Schwung, Feuchtigkeit und Wolken verbunden. Er findet hauptsächlich in der Troposphäre statt. Nördlich und südlich vom etwa 30° Breitengrad wird die Energie hauptsächlich durch Stürme auf bevorzugten Routen über Ozeanbecken transportiert. Die beiden wichtigsten Sturmzugbahnen der nördlichen Hemisphäre sind in Abbildung 5 in rot dargestellt.

Abbildung 6 zeigt die Korrelation zwischen der Sonnenaktivität (in rot) und dem durchschnittlichen atmosphärischen Drehimpuls. Die beiden korrelieren gut und positiv von 1920 bis heute, aber sie sind antikorreliert (negativer Korrelationskoeffizient) vor 1920. Viele Korrelationen zwischen Sonne und Klima kehrten sich um 1920 um, was zu großer Verwirrung unter den Sonnen- und Klimaforschern führte. Vor 1920 ging man davon aus, dass eine niedrige Sonnenfleckenzahl wärmeres Wetter verursacht, eine negative Korrelation. Nach 1920 kehrte sich diese Beziehung um, und die Sonnenflecken korrelierten positiv mit der Erwärmung.

Nach der Umkehrung im Jahr 1920 war die Vorstellung, dass es einen Zusammenhang zwischen der Sonne und dem Klima gibt, in Verruf geraten. Der Grund für diese Umkehrung ist unbekannt und wird es wahrscheinlich auch bleiben, bis sie wieder eintritt. Douglas Hoyt und Kenneth Schatten erklären, dass die Umkehrung offenbar alle 80-120 Jahre stattfindet, so dass 1600 bis 1720 eine negative Korrelation, 1720 bis 1800 eine positive Korrelation, 1800 bis 1920 eine negative Korrelation und 1920 bis heute eine positive Korrelation aufwiesen. In den nächsten Jahrzehnten könnte es zu einer weiteren Umkehrung kommen, was die Entdeckung eines Prozesses ermöglichen könnte.

Wenn wir wissen, wie die Wärme in die Arktis transportiert wird, können wir das Phänomen der arktischen Verstärkung untersuchen, d. h. die Vorstellung, dass bei einem globalen Temperaturanstieg die Temperaturen in der Arktis und Antarktis schneller steigen. Allgemeine Zirkulationsmodelle sagen dies voraus, seit die ersten Modelle von Syukuro Manabe und Kirk Bryan in den 1960er Jahren geschrieben wurden. In der modernen globalen Erwärmungsperiode wurde jedoch keine antarktische Verstärkung beobachtet. Bis 1995 wurde trotz der intensiven globalen Erwärmung in den vorangegangenen 20 Jahren so wenig Verstärkung in der Arktis beobachtet, dass Judith Curry sagte:

„Das relative Fehlen einer beobachteten Erwärmung und der relativ geringe Eisrückgang könnten darauf hindeuten, dass die GCMs die Empfindlichkeit des Klimas gegenüber Prozessen in den hohen Breitengraden überbetonen.“ – Curry, et al., 1996

Das sollte sich in jenem Jahr ändern, als sich die arktische Verstärkung plötzlich beschleunigte, wie in Abbildung 7 dargestellt. Aber die Frage ist immer noch aktuell. Warum war die arktische Verstärkung vor 1996, als eine intensive globale Erwärmung stattfand, gering und nach 1996, als die globale Erwärmungsrate abnahm – die so genannte „Pause“ – groß? Die moderne Klimatologie hat darauf keine Antwort.

In Abbildung 7 ist die schwarze Kurve die mittlere Temperaturanomalie im Sommer (Juni-August) aus der Reanalyse-Datenbank des European Weather Center für die Region nördlich von 80°N. Die rote Kurve ist die entsprechende mittlere Wintertemperaturanomalie (Dezember-Februar) für dieselbe Region.

Die Arktis ist im Winter die größte Wärmesenke – der größte Energieverlust an den Weltraum – auf unserem Planeten. Die Niederschlagsmenge in der Arktis beträgt im Sommer etwa 15 mm, im Winter sinkt sie jedoch auf fast Null. Infolgedessen wird die Bewölkung im Winter geringer, was den Energieverlust erhöht. Bei geringerer Bewölkung, fast keinem Wasserdampf und keinem Albedo-Effekt gibt es in der Arktis im Winter im Wesentlichen keine Rückkopplungen auf den Treibhauseffekt durch CO2. Van Wijngaarden & Happer, stellen fest, dass

„Die relativ warmen Treibhausgasmoleküle in der Atmosphäre über der kalten Oberfläche bewirken, dass die Erde mehr Wärme von den Polen in den Weltraum abstrahlt, als dies ohne Treibhausgase der Fall wäre.“ – Van Wijngaarden & Happer, 2020

Die Verstärkung der Arktis ist die Folge des verstärkten meridionalen Transports, nicht des Treibhauseffekts. Die Arktis hat ein negatives jährliches Energiebudget (d. h. einen Netto-Energiestrom in den Weltraum), und eine Verstärkung des Treibhauseffekts macht es nicht weniger negativ – das ist die Erwärmung. Die Erwärmung der Arktis, insbesondere im Winter, kann nur durch eine Zunahme des Wärmetransports aus niedrigeren Breiten entstehen. Der Anstieg des arktischen Wärmetransports, der nicht zurück in niedrigere Breiten exportiert wird, verteilt sich auf eine erhöhte Strahlung in den Weltraum und eine erhöhte langwellige Abwärtsstrahlung, die die Oberfläche erwärmt. Die verstärkte Abwärtsstrahlung erhöht zwar die Temperatur, aber aufgrund der geringen Wärmeleitfähigkeit des Eises und da der Wärmestrom im Winter immer vom wärmeren Ozean in die Atmosphäre fließt, kommt es häufig zu Temperaturinversionen, die oft von Feuchtigkeitsinversionen begleitet werden. So setzt sich die Abkühlung durch Strahlung von der Oberseite der Inversionsschicht oder der Oberseite der Wolken fort, bis der Wasserdampf gefriert und ausfällt, wodurch der ursprüngliche sehr kalte Zustand wiederhergestellt wird.

Der Wärmetransport im arktischen Winter wird zu Zeiten verstärkt, wenn über dem Pol hohe Druckverhältnisse herrschen, die zu einem schwachen oder gespaltenen Wirbel führen. Warme Luft dringt dann in die zentrale Arktis ein und verdrängt kalte Luft, die über die Kontinente der mittleren Breiten zieht und anomal niedrige Temperaturen und Schnee erzeugt. Seit Beginn der arktischen Verstärkung hat die Häufigkeit kalter Winter in den mittleren Breiten zugenommen, was die Modelle nicht erklären können. Etwas Ähnliches fand zwischen 1920-40 statt.

Zusammenfassung der Daten

Die globale durchschnittliche Temperatur der Erde schwankt jedes Jahr um 3,8 °C. Die Höchsttemperatur ist im Juli, die Tiefsttemperatur im Januar. Daher ist es schwierig, die Warnungen des IPCC vor einer Erwärmung um zwei Grad in den nächsten 100 Jahren ernst zu nehmen.

Die Tropen der Erde erhalten viel mehr Sonnenenergie, als sie in den Weltraum abstrahlen können. Dadurch werden viele ausgeklügelte natürliche Prozesse in Gang gesetzt, um die Energie in Richtung der Pole zu lenken, wo der Netto-Energiefluss in den Weltraum erfolgt. Veränderungen in diesem Energiefluss können zu Klimaveränderungen führen.

Geologen haben ein Verfahren entwickelt, die sich der Klimagürtel von Wladimir Köppen bedient, um die vergangenen globalen Durchschnittstemperaturen zu rekonstruieren. Die Rekonstruktionen haben eine sehr geringe zeitliche Auflösung und bestimmen nur eine globale durchschnittliche Temperatur alle fünf Millionen Jahre, aber das Verfahren ist vernünftig. Unser heutiges Klima ist in der Erdgeschichte ungewöhnlich kalt, kälter als 90 % der letzten 540 Millionen Jahre. Die Temperaturen in den Tropen schwanken nicht sehr stark, die globale Erwärmung oder Abkühlung findet hauptsächlich in den mittleren und hohen Breitengraden statt.

Die Stürme nehmen in Perioden mit einem größeren Temperaturgefälle in der Breite zu, da der größte Teil der überschüssigen tropischen Energie aus den Tropen in Stürmen transportiert wird. Da die globale Erwärmung den Gradienten verringert, sind weniger Stürme zu erwarten.

Die Sonnenaktivität beeinflusst das Klima der Erde, aber die Korrelation ändert sich mit der Zeit. Manchmal ist sie positiv, d. h. die Erde erwärmt sich mit zunehmender Sonnenaktivität, und manchmal kühlt sich die Erde mit zunehmender Sonnenaktivität ab. Die Wechsel scheinen alle 80-120 Jahre zu erfolgen. Die Änderungen der Klima/Solar-Korrelation deuten darauf hin, dass der solare Einfluss auf das Klima nicht direkt auf Änderungen der Sonneneinstrahlung zurückzuführen ist, wie der IPCC vorschlägt, sondern auf solarinduzierte Änderungen großer atmosphärischer Prozesse, die vernachlässigt werden.

Die Sommertemperaturen in der Arktis ändern sich kaum, wahrscheinlich weil jede Zunahme des meridionalen Transports einfach mehr Polareis zum Schmelzen bringt. Die Wintertemperaturen ändern sich, da zusätzliche Energie, die in die Arktis transportiert wird, die Oberfläche erwärmt. Wenn im Sommer aufgrund des verstärkten meridionalen Transports zusätzliches Eis schmilzt, führt das erneute Gefrieren des Eises im Winter dazu, dass die freigesetzte latente Wärme in den Weltraum gestrahlt wird.

Zusammenfassung der Probleme der Klimamodelle

Das erste ernstzunehmende Klimamodell, mit dem versucht wurde, Treibhausgase, insbesondere CO2, nachzuweisen, die die gesamte oder fast die gesamte moderne globale Erwärmung erklären könnten, wurde 1979 entwickelt und von der National Academy of Sciences veröffentlicht. Er wird gewöhnlich als „Charney-Report“ bezeichnet. In den 43 Jahren, die seit der Veröffentlichung dieses Berichts vergangen sind, hat der IPCC 47 weitere Berichte veröffentlicht, die zu fast den gleichen Schlussfolgerungen über CO2 und Klima kommen. Doch auch nach dem Verfassen von Zehntausenden von Seiten und der Ausgabe von Milliarden von Dollar haben sie die Mehrheit der Menschen auf der Erde oder in den Vereinigten Staaten nicht davon überzeugt, dass der vom Menschen verursachte Klimawandel unser wichtigstes und ernstestes gesellschaftliches Problem ist. Andere gesellschaftliche Probleme werden immer als wichtiger und dringender angesehen. In einer Gallup-Umfrage von 2018 rangierte der Klimawandel auf Platz 18 von 19 wichtigen Themen, in einer ähnlichen Umfrage von 2014 rangierte der Klimawandel auf Platz 14 einer Prioritätenliste. Eine Umfrage des Pew Research Center aus dem Jahr 2022 ergab, dass der Klimawandel ebenfalls auf Platz 14 rangiert. Die Denkweise wird nicht verändert.

Diese Modelle können nicht erklären, warum die Häufigkeit der kalten Winter in den mittleren Breiten der nördlichen Hemisphäre zugenommen hat. Sie können die warmen Bedingungen des frühen Eozäns nicht simulieren, ohne unrealistische CO2-Werte und eine hohe CO2-Empfindlichkeit des Klimas zu verwenden.

Sie können nicht erklären, warum die Artenvielfalt, insbesondere die der Säugetiere, im frühen Eozän zunahm, als die globalen Temperaturen zehn Grad höher lagen. Sie können nicht erklären, warum es keine Erwärmung der Arktis gab, als die globale Erwärmung zwischen 1980 und 1997 ihren Höhepunkt erreichte, während sie nach 1997, als sich die Erwärmung verlangsamte, zunahm.

Außerdem wurde diese stark veraltete Hypothese vor der Entdeckung aller multidekadischen Ozeanschwankungen und ihrer Verbindungen zur Sonnenaktivität aufgestellt. Seit 1979 wurden beträchtliche Beweise dafür gefunden, dass der Klimawandel nicht einfach eine Funktion der sich ändernden Treibhausgas-Konzentrationen, sondern viel komplexer ist und einen großen Anteil an natürlichen Einflüssen hat.

Besonders besorgniserregend ist, dass die Erwärmung im frühen Eozän und die derzeitige Erwärmung der Arktis nicht mit der IPCC-Hypothese des Klimawandels durch Treibhausgase erklärt werden können. Allein diese Probleme reichen aus, um die Hypothese zu entkräften. Ich denke dabei an das Reiten eines toten Pferdes.

Download the meridional transport bibliography here.

The full Tom Nelson interview can be viewed here.

Übersetzt von Christian Freuer für das EIKE