Sind fossile CO↓2-Emissionen nun gut oder schlecht?

Dies ist die Abschrift meiner Grundsatzrede vor der AAPG-Abteilung für berufliche Angelegenheiten auf dem zweiten Internationalen Treffen für angewandte Geowissenschaften und Energiekongress im George R. Brown Convention Center in Houston am 30. August 2022, die ich geringfügig bearbeitet habe, um sie in das Format eines Blogbeitrags zu bringen.

In der großen Klimawandel-Debatte zwischen dem emeritierten Princeton-Professor William Happer und dem Professor der Universität Melbourne, David Karoly, wurde ihnen vom Moderator James Barham die folgende Frage gestellt:

„Die offizielle Position des IPCC lässt sich in vier Behauptungen zusammenfassen: Die globale Erwärmung ist eine wohlbekannte Tatsache; sie ist vom Menschen verursacht; sie ist ein großes Problem für die Menschheit; und es sind konzertierte globale Regierungsmaßnahmen erforderlich, um sie zu bekämpfen.“

James Barham und TheBestSchools.org

In diesem Vortrag werden wir nur einen Teil des zweiten und dritten Teils der Frage behandeln, die wir folgendermaßen formulieren: „Ist die Verbrennung fossiler Brennstoffe und die Abgabe von CO2 und anderen Treibhausgasen an die Atmosphäre eine gute Sache oder eine schlechte Sache für die Menschheit?“ Die anderen Facetten der Frage sind in meinem neuesten Buch gut behandelt. Ein großer Teil dieses Vortrags stammt aus Kapitel 10.

Als Antwort auf die Frage schrieb Professor Happer:

„Es gibt keine wissenschaftlichen Beweise dafür, dass die weltweiten Treibhausgasemissionen eine schädliche Wirkung auf das Klima haben werden. Ganz im Gegenteil, es gibt sehr gute Beweise dafür, dass der bescheidene Anstieg des atmosphärischen CO2 seit Beginn des Industriezeitalters bereits gut für die Erde war und dass mehr davon noch besser sein wird.“. – Professor William Happer

Die Antwort von David Karoly:

„Die Wissenschaft hat festgestellt, dass es praktisch sicher ist, dass der Anstieg des atmosphärischen CO2 durch die Verbrennung fossiler Brennstoffe einen Klimawandel verursachen wird, der erhebliche negative Auswirkungen auf die Menschheit und die natürlichen Systeme haben wird. Daher sind sofortige, strenge Maßnahmen zur Eindämmung der Verbrennung fossiler Brennstoffe sowohl gerechtfertigt als auch notwendig.“ – Professor David Karoly

Mit „Wissenschaft“ meint Karoly die Ansichten und Meinungen des IPCC und anderer Organisationen, die glauben, dass der vom Menschen verursachte Klimawandel gefährlich ist. Wissenschaft ist eine organisierte Debatte, bei der beide Seiten ihre Daten und Analysen vorlegen, und schließlich wird eine Seite durch den Vergleich ihrer Projektionen mit zukünftigen Beobachtungen als richtig befunden, spülen und wiederholen. Wissenschaft ist keine Sache, keine Person, kein Peer-Review und kein Konsens; sie ist ein Prozess. Wissenschaftliche Theorien werden durch Beobachtungen bestätigt, nicht durch die Meinung von Wissenschaftlern oder Regierungsvertretern.

Die beiden oben dargelegten Ansichten, beide von sehr qualifizierten und angesehenen Klimawissenschaftlern, schließen sich gegenseitig aus – welche ist richtig? Wir werden die Daten untersuchen, wie sie heute vorliegen, und Sie können dann entscheiden. Die Beobachtungen unterstützen Happers Ansicht. Die Modellprojektionen des zukünftigen Klimas unterstützen in extremen Szenarien die Ansicht von Karoly. Wie hoch sind die Kosten für die Abschaffung oder Einschränkung fossiler Brennstoffe? Ist es billiger und sinnvoller, sich an den Klimawandel anzupassen? Alles gute Fragen.

Karoly verlässt sich sehr auf den IPCC. Wie viel Erwärmung ist gefährlich? Der IPCC behauptet, dass 1,5 °C über der vorindustriellen Temperatur (vor 1750) gefährlich sein könnten, und 2 °C sind definitiv gefährlich. Der Ursprung der Zwei-Grad-Grenze ist fadenscheinig und wird von Rosamund Pearce in einem gut referenzierten Blogbeitrag bei Carbon Brief diskutiert. Die ursprüngliche Referenz ist eine Studie von William Nordhaus aus dem Jahr 1977, der fälschlich behauptet, dass zwei Grad außerhalb der Beobachtungsspanne der letzten 100.000 Jahre liegen. Eine andere Begründung für den Grenzwert liefert er nicht. Im Grunde gibt es weder für die 2-Grad- noch für die 1,5-Grad-Grenze eine wissenschaftliche Rechtfertigung, wie David Victor und Charles Kennel 2014 in Nature feststellten.

Ein späterer Bericht des Stockholmer Umweltinstituts aus dem Jahr 1990 räumte ein, dass die Festlegung eines Ziels für die globale Erwärmung schwierig und mit Unsicherheit behaftet ist. Der einzige Grund, den sie für die Festlegung eines Ziels anführen, ist die Möglichkeit, den Fortschritt in Richtung des Ziels zu messen. Sie geben zu, dass das Ziel einfach darin besteht, die Emissionen aus fossilen Brennstoffen zu reduzieren, aber der Grund, warum dies notwendig ist, ist mit Unsicherheiten behaftet, weshalb ein sichtbares und festes „Ziel“ erforderlich ist. Aus dem Bericht:

„Wenn es schon kein allgemeines Einvernehmen über die Nützlichkeit von klimapolitischen Zielen gibt, dann erst recht nicht darüber, wie solche Ziele aussehen sollten.“ – Stockholmer Umweltinstitut

In dem Bericht wird lediglich spekuliert, dass 2 °C globale Erwärmung ungewöhnlich und möglicherweise gefährlich sind. Soweit ich weiß, ist das immer noch der Fall, es gibt keine erkennbare Gefahr durch 2°C globale Erwärmung.

Es gibt zwei Fragen zu erörtern. Erstens: Hat Happer recht, und mehr CO2 ist besser? Oder hat Karoly Recht, und mehr CO2 wird einen gefährlichen Klimawandel verursachen? Zweitens: Ist die Erwärmung gut oder schlecht? Wie viel Erwärmung ist schlecht?

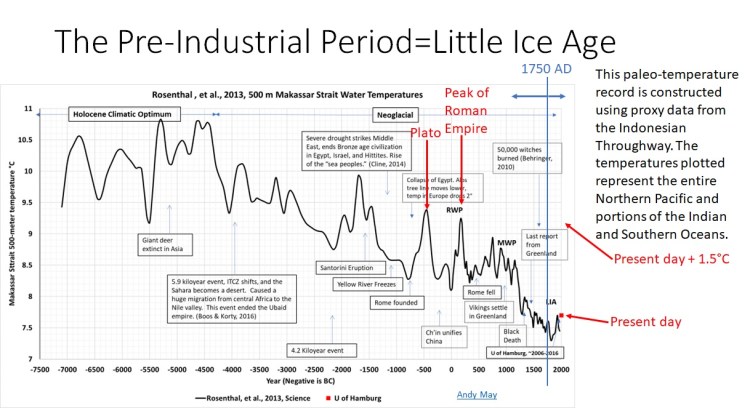

Was ist die vorindustrielle Zeit? War sie eine gute Zeit? Der IPCC definiert die vorindustrielle Zeit als vor 1750, aber die globalen Zahlen, die er für diesen Zeitraum verwendet, stammen notwendigerweise aus den Jahren 1850-1900. Dies sind die frühesten verfügbaren globalen Temperatur- und CO2-Konzentrationen. Offensichtlich waren große Teile Europas, Asiens und Nordamerikas bereits vor 1850 industrialisiert.

Abbildung 1. Yair Rosenthals Temperaturrekonstruktion des 500-Meter-Wassers im indonesischen Durchfluss. Klicken Sie hier, um die Graphik in voller Auflösung zu sehen.

Abbildung 1 zeigt eine rekonstruierte Temperaturaufzeichnung von benthischen Foraminiferen, die etwa 500 Meter unter der Meeresoberfläche im indonesischen Durchfluss [Makassar-Straße] leben. Die Rekonstruktion wurde von Yair Rosenthal und Kollegen erstellt und in der Zeitschrift Science veröffentlicht. Dabei handelt es sich um eine Meerespassage durch die indonesischen Inseln, die den Pazifik vom Indischen und Südlichen Ozean trennt. Die Wassertemperaturen dort reflektierenn größtenteils die Temperatur im nördlichen und tropischen Pazifik, werden aber in geringerem Maße vom Indischen und Südlichen Ozean beeinflusst. Ich ziehe diese Temperaturrekonstruktion den verschiedenen Rekonstruktionen der grönländischen Eiskerne vor, weil sie einen viel größeren Teil des Klimasystems der nördlichen Hemisphäre repräsentiert. Abgesehen davon ähnelt diese Rekonstruktion den Rekonstruktionen der grönländischen Eiskerne sowohl in Form als auch in der Amplitude.

Auf der Nordhalbkugel leben die meisten Menschen, und dort gibt es die meisten Langzeit-Temperaturproxys. Temperaturproxys in der südlichen Hemisphäre sind selten. Außerdem sind die jüngsten Erwärmungstrends auf der Südhalbkugel viel geringer als auf der Nordhalbkugel.

Diese Rekonstruktion zeigt einen Temperaturrückgang von etwa 3 °C von 4500 v. Chr. bis zum Beginn der Kleinen Eiszeit um 1750 n. Chr. Bo Vinthers Rekonstruktion der Temperatur im grönländischen Eiskern zeigt ebenfalls einen Rückgang um drei Grad, wie in Abbildung 2 dargestellt [in deutscher Übersetzung hier]. Versuche von hemisphärischen Rekonstruktionen, wie Michael Manns Hockeyschläger, unterschätzen immer die Temperaturvariabilität aufgrund der Mittelwertbildung unterschiedlicher Temperaturproxies und ihrer zwangsläufig ungenauen radiometrischen Daten.

Abbildung 2. Eine Darstellung der Rekonstruktionen der grönländischen Eiskerne von Richard Alley, Bo Vinther und Takuro Kobashi.

Zu dieser Graphik: Die Rekonstruktion von Kobashi reicht nur bis 2000 v. Chr. zurück. Alleys Rekonstruktion ist zwar häufiger zu sehen, aber sie ist nicht höhenkorrigiert und während des sehr warmen holozänen Klimaoptimums von 8000 bis 4500 v. Chr. unregelmäßig. Die Rekonstruktion von Vinther ist für Höhenänderungen korrigiert und zeigt ein ausgeprägtes holozänes Klimaoptimum, in welchem es über drei Grad wärmer war als in der vorindustrielle Periode. Die Referenzen und weitere Informationen sind hier und hier zu finden.

Es scheint also wahrscheinlich, dass die Temperaturen der nördlichen Hemisphäre im holozänen Klimaoptimum (etwa 9000 v. Chr. bis 4200 v. Chr.) um mehr als drei Grad höher waren als in der vorindustriellen Periode, die auch als Kleine Eiszeit bezeichnet wird. Der vorindustrielle Grenzwert des IPCC von 1750 n. Chr. ist in Abbildung 1 mit einer vertikalen blauen Linie dargestellt. Die heutige Temperatur in 500 Metern Höhe, gemittelt von 2006 bis 2016, ist als roter Kasten dargestellt. Die heutigen Daten stammen von Viktor Gouretski von der Universität Hamburg. Die dargestellte Rosenthal-Rekonstruktion hat alle zwanzig Jahre einen Wert, der Temperaturfehler beträgt etwa ein Drittel Grad, und die allgemein akzeptierte zeitliche Auflösung liegt bei plus/minus 50 Jahren.

Wenn wir 1,5 Grad zur heutigen Temperatur hinzuzählen, kommen wir auf 9,2 °C, was ungefähr der Temperatur im indonesischen Durchfluss entspricht, die während der römischen Warmzeit (RWP) herrschte, oder der Temperatur, als Platon lebte und lehrte. Es ist deutlich mehr als ein Grad kühler als während des holozänen Klimaoptimums, als sich die menschliche Zivilisation und die Landwirtschaft entwickelte. Wir sehen in dieser Rekonstruktion keinen Hinweis darauf, dass 1,5 oder gar 2 °C Erwärmung in der Vergangenheit ein Problem waren.

Es gibt auch keine Anhaltspunkte dafür, dass die vorindustrielle Periode ein guter Standard für die globale Temperatur ist. Es war die kälteste Periode im gesamten Holozän. Die Kleine Eiszeit fand nicht überall auf der Welt zur gleichen Zeit statt, aber sie kam einer Rückkehr zu eiszeitlichen Bedingungen in den letzten 12 000 Jahren am nächsten. In Europa, Grönland und Nordamerika war die kälteste Zeit von etwa 1650 bis 1750 n. Chr. und fiel mit dem Maunder-Minimum zusammen, einer Periode geringer Sonnenaktivität von 1645 bis 1715. In der Rosenthal-Aufzeichnung war die kälteste Zeit von etwa 1800 bis 1815.

Kälteperioden traten in der vorindustriellen Zeit häufig auf und bereiteten der Menschheit viele Probleme. Das ausgezeichnete Buch von Paul Homewood und Wolfgang Behringer A Cultural History of Climate sowie ein Artikel von Geoffrey Parker bieten uns eine Vielzahl historischer Beispiele. Überall auf der Welt erreichten die meisten Gletscher ihre maximale Ausdehnung im Holozän während der Kleinen Eiszeit. In Chamonix, Frankreich, verschluckten sie ganze Dörfer, während sie vorrückten.

Im Jahr 1675 gab es keinen Sommer, und es war der zweitkälteste Sommer der letzten 600 Jahre in Nordamerika, wie die Proxy-Daten belegen. Der Winter von 1657-1658 war besonders brutal. Sowohl die Massachusetts Bay als auch der Delaware River froren zu, so dass Menschen und Hirsche auf dem Eis übersetzen konnten. Die Ostsee fror so stark zu, dass Pferde und beladene Wagen von Gdansk (Polen) bis zur Halbinsel Hel über 10 Meilen nördlich der Stadt übersetzen konnten. Der folgende Sommer war jedoch in Italien und Griechenland übermäßig heiß. In Indien fiel in diesem Jahr der Monsun aus, was zu einer verheerenden Hungersnot führte.

Zwischen 1660 und 1680 suchten mehr Taifune Südchina in der Provinz Guangdong heim als je zuvor in der Geschichte. Im Jahr 1666 wurde England von einem Hagelsturm heimgesucht, dessen Hagelkörner teilweise die Größe eines Tennisballs erreichten.

Ein enorm zerstörerischer Hurrikan traf 1666 die Karibikinseln Guadeloupe und Martinique. Er forderte 2.000 Todesopfer und zerstörte eine Küstenbatterie mit drei Meter dicken Mauern sowie zahlreiche Schiffe.

In Ägypten gab es in den 1670er Jahren viele sehr strenge Winter, und die Menschen begannen, Pelzmäntel zu tragen, etwas, das es in Ägypten zuvor noch nie gegeben hatte. In den 1680er Jahren wurde die afrikanische Sahelzone von einer schweren Dürre heimgesucht, und der Tschadsee erreichte den niedrigsten jemals gemessenen Wasserstand.

Der Winter 1691-1692 war sehr streng, hungrige Wölfe drangen in Wien ein und griffen Männer und Frauen auf der Straße an. Alle Kanäle in Venedig froren zu, und die Mündung des Nils war eine Woche lang mit Eis bedeckt. Die Kälte der 1690er Jahre verursachte eine große Hungersnot in Nordeuropa, bei der die Hälfte der Bevölkerung Finnlands und 15 % der Bevölkerung Schottlands starben. Die schottische Hungersnot war ein wichtiger Faktor für die erzwungene Union mit England. Zwischen die kalten Jahre mischten sich gelegentlich Sommer mit großer Hitze und Trockenheit, wie die Sommer 1693 und 1694, als die Hitze sowohl in England als auch in Italien unerträglich war. Los Niños traten während der kleinen Eiszeit häufiger auf als heute. Dieser Prozess kann während des El Niño-Ereignisses selbst hohe atmosphärische Temperaturen verursachen, aber der El Niño kühlt die Erde schließlich ab, sobald die atmosphärische Wärme abgestrahlt wird. Wenn die Abkühlung aufhört, werden die Los Niños immer seltener.

Im Jahr 1715 suchte ein verheerender Hurrikan die Bahamas und Florida heim und tötete zwischen 1.000 und 2.000 Menschen. In jenem Winter herrschten in Paris -20°C. In London fand in jenem Jahr auf der zugefrorenen Themse ein Frostfest statt, mit Lagerfeuern, an denen Ochsen geröstet wurden, Kutschen, die auf dem Eis fuhren, und Schlittschuhlaufen.

Wir haben den Schwerpunkt auf den schlimmsten Teil der Kleinen Eiszeit (1650-1715) gelegt, aber insgesamt dauerte sie von etwa 1300 bis 1850. Die erste außergewöhnliche Kälteperiode der LIA begann an verschiedenen Orten zu unterschiedlichen Zeiten, aber in Europa begann sie um 1310 mit einer Reihe sehr kalter und nasser Winter, die bis 1330 andauerten. Zunächst waren die Ernten zwar schlecht, aber ausreichend, doch um 1315 begann die große Hungersnot, auf die von 1346 bis 1352 der Schwarze Tod folgte, der mehr als ein Drittel der europäischen Bevölkerung tötete.

In der europäischen Gesellschaft gab es kein Konzept des Zufalls, immer war jemand an der Katastrophe schuld. Entweder war es eine Person oder eine Gruppe, die die Katastrophe verursachte, oder es war eine Sünde, die Gott dazu veranlasste, die Katastrophe zu verursachen. Sie glaubten nicht, dass die Natur allein handelte. So dauerte es nicht lange, bis die Juden für die Hungersnöte, die Kälte und die Überschwemmungen verantwortlich gemacht wurden. Tausende von ihnen wurden getötet. Später, um 1400, waren es dann Hexen, wie der in Abbildung 3 gezeigte Holzschnitt von 1486 zeigt. Auf dem Holzschnitt ist eine Hexe zu sehen, die mit dem Kieferknochen eines Esels einen Hagelsturm heraufbeschwört. Zwischen 1500 und 1700 wurden mehr als 50.000 angebliche Hexen getötet.

Der aktuelle „Klimakonsens“ ist nicht das erste Mal in der Geschichte, das Wetter auf menschliche Aktivitäten zurückführt. Dies ist ein wiederkehrendes Thema in der Geschichte der Menschheit. Abbildung 3 stammt aus Behringers Buch, etwas mehr über sein Buch finden Sie hier.

Dies ist eine kurze Einführung in die vorindustrielle Zeit, also in das „Standardklima“ des IPCC, an dem unsere derzeitigen globalen Durchschnittstemperaturen gemessen werden. Der Tiefpunkt der Kleinen Eiszeit fällt mit dem Großen Solaren Minimum von Maunder und dem kältesten Teil des jüngsten Hallstatt-Bray-Zyklus zusammen. Nach großen solaren Minima und Hallstatt-Bray-Kälteperioden erholt sich das Klima immer wieder. Die eigentliche Frage ist, warum die Kleine Eiszeit nicht zu einer vollen Eiszeit wurde – und nicht, warum es danach warm wurde. Ich denke, dass unser derzeitiges Wetter besser ist als das vorindustrielle. Wahrscheinlich ist die nächste volle Eiszeit bereits eingeläutet und wird in 1.500 bis 2.500 Jahren beginnen. Unsere größte Herausforderung im Zusammenhang mit dem Klimawandel ist die Frage, wie wir uns darauf einstellen können. Die globale Erwärmung ist nichts im Vergleich dazu.

Nun haben wir die Begriffe, die in der Frage an Happer und Karoly verwendet wurden, und ihre ersten Antworten definiert und erklärt. Schauen wir uns ihre Ansichten in Abbildung 4 an. Karoly ist der Meinung, dass zusätzliche CO2-Emissionen gefährlich sind, weil sie zu schwerwiegenden Veränderungen des Klimas, insbesondere zur globalen Erwärmung, führen werden. Wir haben gerade gesehen, dass das Klima in der vorindustriellen Zeit möglicherweise ungünstiger war als heute. Karoly räumt zwar ein, dass zusätzliches CO2 für Pflanzen und Nutzpflanzen von Vorteil ist, aber er hält die Probleme des Klimawandels für größer als die Vorteile.

Abbildung 4. Die positiven Aspekte des zunehmenden CO2-Gehaltes und der globalen Erwärmung (hier).

Happer geht im Detail auf die Vorteile von mehr CO2 für die Pflanzenwelt ein. Auf der linken Seite von Abbildung 4 sehen wir das Ergebnis eines kontrollierten Experiments von Dippery et al. (1995). Bei der CO2-Konzentration des letzten Gletschermaximums wächst die Pflanze in 14 Tagen nur sehr wenig, bei einer CO2-Konzentration von 350 ppm aus der Zeit um 1990 ist das Wachstum robust. Bei einer zukünftigen Konzentration von 700 ppm wird deutlich mehr Wachstum erzielt. Rechts sehen wir die Ergebnisse der Studie von Zaichun Zhu über die Ergrünung der Erde aus der Zeitschrift Nature Climate Change.

Die obere Abbildung ist eine Karte, die zeigt, wo die Begrünung stattfindet, wobei Satellitendaten zur Schätzung der Veränderung des Blattflächenindex (LAI) von 1982-2009 verwendet wurden. Zhu hat für diese Schätzungen drei Satellitendatensätze verwendet, die alle zeigen, dass die Erde deutlich grüner geworden ist. Die obere Karte verwendet den Globmap-Datensatz. Wo sie grün, blau oder rosa ist, gab es 2009 eine größere Pflanzendecke. Wo sie gelb oder rot ist, ist das Gebiet braun geworden und hat weniger Pflanzenbewuchs. Der größte Teil der Welt ist heute viel grüner als 1982.

Insgesamt berichtet Zhu, dass 21 bis 46 % der globalen Vegetationsfläche heute grüner und weniger als 4 % brauner sind. Seine Simulationen zeigen, dass 70 % der Begrünung auf zusätzliches CO2 zurückzuführen sind. Die untere Karte ist eine Simulation der Begrünung nur aufgrund von CO2. Der linke rote Balken im Histogramm ist die beobachtete Ergrünung, und die rechten Balken zeigen die modellierten Komponenten der verstärkten Ergrünung, grün ist die CO2-Komponente, der Klimawandel oder die Erwärmung ist gelb dargestellt, blau ist die zusätzliche Stickstoffdeposition, und lila ist die zusätzliche Anbaufläche. Diese Ergebnisse stammen aus einem Multi-Modell-Ensemble-Mittelwert, abgekürzt als „MMEM“.

Generell zeigen Beobachtungen und Modellierungen, dass die Zufuhr von CO2 in die Atmosphäre dem Pflanzenleben zugute kommt, was wiederum unser Leben verbessert.

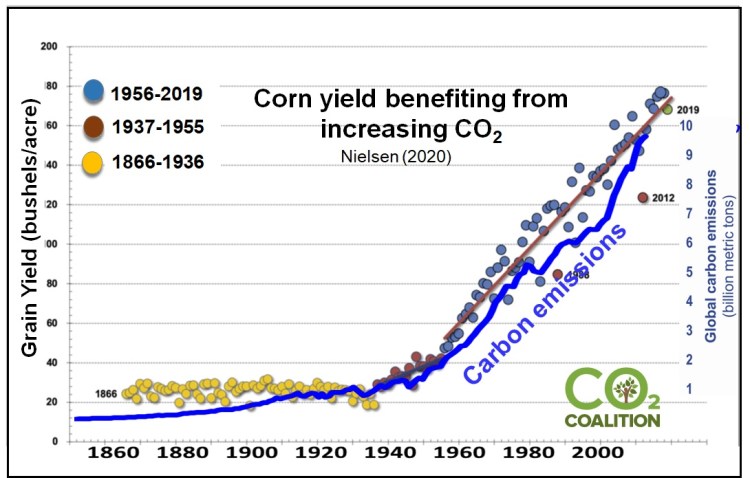

Abbildung 5 ist ein interessantes Diagramm der weltweiten Kohlenstoffemissionen und Maiserträge von 1860 bis 2020. Die Grafik stammt von der CO2-Coalition. Die Maiserträge stammen von Bob Nelson in Purdue und die CO2-Daten von der CO2-Datenbank der Appalachian State University, die von Gilfillan et al. gepflegt wird. Sie zeigt den Zusammenhang zwischen steigenden CO2-Werten und Ernteerträgen.

Abbildung 6. Zunehmendes CO2 und globale Erwärmung, das Schlechte (hier).

Das IPCC behauptet, dass die globale Erwärmung zu einem schnelleren Anstieg des Meeresspiegels, extremeren Wetterereignissen, sinkenden landwirtschaftlichen Erträgen und einer Senkung des pH-Werts der Ozeane, der so genannten Versauerung der Ozeane, führen wird. Es geht davon aus, dass diese Trends in der Zukunft Probleme verursachen werden. Doch was zeigen die Daten in Abbildung 6? Das NOAA-Diagramm des Meeresspiegels, oben in der Mitte, zeigt eine gewisse Beschleunigung des Meeresspiegel-Anstiegs, der Zeitraum von 1880 bis 1970 ist sehr linear, mit einem Anstieg des Meeresspiegels um fünf Inch [12,7 cm] pro Jahrhundert. Von 1971 bis 2022 beträgt die Rate 9 Inch [23 cm] pro Jahrhundert, ein Anstieg, aber immer noch nicht sehr beängstigend. Immerhin beträgt der tägliche Tidenhub im offenen Ozean zwei Fuß [60 cm] und in vielen Küstengebieten noch viel mehr. Rechts neben den NOAA-Daten zum Meeresspiegel befindet sich ein Diagramm, das den Anstieg des Meeresspiegels seit dem letzten glazialen Maximum zeigt. Sie zeigt, dass der Anstieg des Meeresspiegels in der Vergangenheit viel höher war, insbesondere vor 5000 v. Chr. während des holozänen Klimaoptimums, als die menschliche Zivilisation begann.

Wie das Histogramm von Roger Pielke Jr. unten links in Abbildung 6 zeigt, sind die Kosten für wetterbedingte Katastrophen im Verhältnis zum weltweiten BIP in den letzten 30 Jahren rapide gesunken. Er hat auch die Gesamtzahl der klima- oder wetterbedingten Katastrophen aus der EM-DAT-Datenbank seit dem Jahr 2000 aufgetragen, und die Gesamtzahl ist ebenfalls rückläufig. Das ist nicht überraschend, denn die Nächte erwärmen sich schneller als die Tage und die Winter mehr als die Sommer. Kurzum, das Wetter wird mit der Zeit milder, weniger extrem, nicht mehr.

Und schließlich hat Bjorn Lomborg in seiner Studie 2020 gezeigt, dass die Zahl der klima- und wetterbedingten Todesfälle seit 1920 drastisch zurückgegangen ist, während die nicht klimabedingten Todesfälle aufgrund von Naturkatastrophen weit weniger zurückgegangen sind, wie in Abbildung 6 unten rechts zu sehen ist. Kurz gesagt, es gibt keinen Beweis dafür, dass der Anstieg des Meeresspiegels oder extreme Wetterverhältnisse heute ein Problem darstellen.

Abbildung 7. Ernteerträge und Ozeanversauerung (hier).

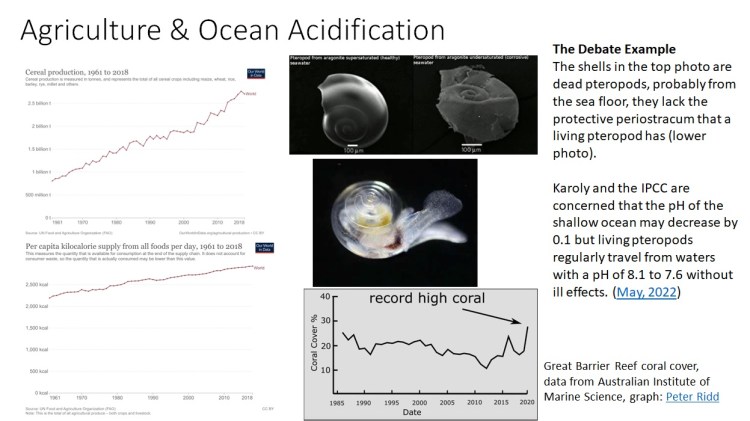

Abbildung 7 zeigt den Austausch zwischen Happer und Karoly über die Versauerung der Ozeane und die Entwicklung der landwirtschaftlichen Erträge. Die linken Diagramme zeigen die weltweiten Trends in der Getreideproduktion (oberes Diagramm) und die Anzahl der pro Person verfügbaren Nahrungskalorien (unteres Diagramm) seit 1961. Beide nehmen in einem nahezu linearen Trend zu. In den vorangegangenen Abbildungen haben wir gesehen, dass die Korrelation zwischen den steigenden CO2-Emissionen und den Maiserträgen seit 1860 auffällig ist; und Zhu schätzt, dass 70 % des zunehmenden Pflanzenwachstums auf steigendes CO2 und höhere Temperaturen zurückzuführen sind. Hier gibt es keine Anzeichen für Probleme.

Ozeanversauerung ist ein falscher Begriff. Der pH-Wert des Oberflächenwassers der Ozeane liegt bei etwa 8,1, was basisch und nicht sauer ist. Tatsächlich schwankt der pH-Wert zwischen 8 und 8,25, was vor allem vom Breitengrad abhängt; in den Tropen ist er etwas niedriger und an den Polen etwas basischer. Der pH-Wert nimmt in der Regel mit der Wassertiefe, der Nähe zum Land und der Jahreszeit ab und kann in seltenen natürlichen Umgebungen Werte von bis zu 6 (wirklich sauer) erreichen. Alle Muscheltiere und Fische verfügen über eingebaute Abwehrmechanismen, die sie vor Veränderungen des pH-Werts in diesem natürlichen Bereich schützen. Der Rückgang des pH-Werts seit 1770, der vermutlich auf den Anstieg des CO2-Gehalts zurückzuführen ist, beträgt etwa 0,11, wobei die größte Veränderung in der Arktis zu verzeichnen ist, wo der pH-Wert um 0,16 gesunken ist. Das sind sehr kleine Veränderungen, und Fische und Schalentiere erleben diese Art von Veränderungen jeden Tag.

Der pH-Wert schwankt an der Meeresoberfläche zwischen Tag und Nacht stärker, als sich der Durchschnittswert seit 1770 verändert hat. Wenn der Ozean tagsüber CO2 aufnimmt, wird es vom Phytoplankton für die Photosynthese rasch absorbiert. In der Nacht, wenn das Phytoplankton atmet, sinkt der pH-Wert um etwa 0,7 Einheiten. Für die Fische im Wasser ist das natürlich kein Problem.

Wie rechts in Abbildung 7 dargestellt, korrodieren einige tote Pteropoden, wenn sie auf den Meeresboden fallen. Der Meeresboden kann korrosiv sein. Diese obere Abbildung wurde in der Debatte als Beweis dafür angeführt, dass ein abnehmender pH-Wert für geschälte Tiere gefährlich ist. Dies ist aber nur dann der Fall, wenn das Tier mit Schale bereits tot ist. Unter den toten Pteropoden ist ein lebender Pteropode abgebildet, dem es gut geht, weil er ein Periostracum hat, das den pH-Wert in der Region reguliert, in der das lebende Tier seine Schale bildet. Das Periostracum kann externe pH-Werte von weit über 8,3 bis 6 mit Leichtigkeit verarbeiten. Es werden keine pH-Werte außerhalb dieser Bereiche projiziert.

Was das australische Great Barrier Reef betrifft, so zeigen die in Abbildung 7 dargestellten Daten des Australian Institute of Marine Science, dass es derzeit eine Rekordmenge an Korallen enthält. Dem Riff geht es gut und es ist nicht in Gefahr.

Die wirtschaftlichen Folgen der globalen Erwärmung und des steigenden CO2-Ausstoßes wurden in der Debatte nur gestreift, aber wir möchten die Arbeit von Yale-Professor William Nordhaus zur Ökonomie des Klimawandels erwähnen. Nordhaus erhielt 2018 den Nobelpreis für Wirtschaftswissenschaften für seine Arbeit über die Ökonomie des Klimawandels. Die Grafiken in Abbildung 8 stammen aus seiner Nobelpreis-Dankesrede, die er 2018 in Schweden hielt. Seine Analyse der vom IPCC geschätzten Kosten der globalen Erwärmung und der Kosten für die Verringerung oder Beseitigung der CO2-Emissionen aus fossilen Brennstoffen zeigt, dass der wirtschaftlich optimale Weg zur globalen Erwärmung die orangefarbene Linie ist, die in der linken Grafik mit Dreiecken gekennzeichnet ist. Die Y-Achse ist der Anstieg der globalen Temperatur in Grad C. Der optimale Pfad führt zu einer Erwärmung um 4 Grad bis 2130. Das rechte Diagramm vergleicht die Kosten für die Verringerung der Nutzung fossiler Brennstoffe (rot) mit den zukünftigen Kosten für die Vermeidung der Erwärmung (grün), wie sie vom IPCC geschätzt werden. Das optimale Szenario wird mit einem Basisszenario verglichen, bei dem nichts unternommen wird, und mit Fällen, in denen die CO2-Emissionen verringert werden, um die Erwärmung in den nächsten 100 bis 200 Jahren unter 2 und 1,5 Grad zu halten.

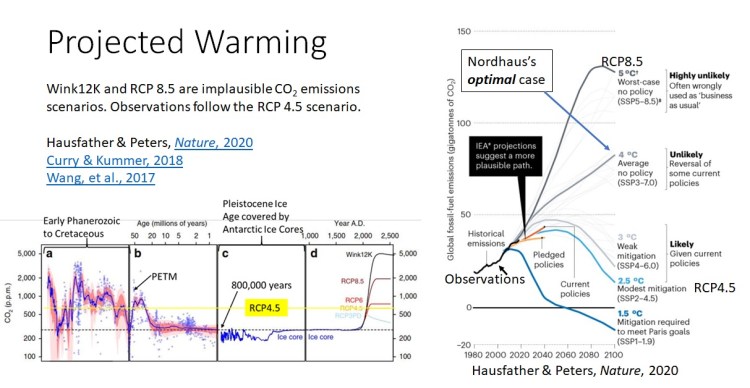

Nordhaus wählte ein extremes Szenario für die globale Erwärmung, das nicht mit den Beobachtungen übereinstimmt, wie wir in Abbildung 9 sehen. Es handelt sich also um eine Analyse der möglicherweise überhöhten Kosten aufgrund der überhöhten prognostizierten Erwärmung. Dennoch ist klar, dass wir es uns nicht leisten können, die Nutzung fossiler Brennstoffe zu reduzieren, um die Erwärmung auf 1,5 bis 2 Grad zu begrenzen, da die Kosten für die Eindämmung einfach zu hoch sind.

[Hervorhebung vom Übersetzer]

Abbildung 9. CO2-Emissionsszenarien im Kontext (hier).

Auf der rechten Seite dieser Folie sehen wir eine realistische Einschätzung der verschiedenen CO2-Emissionsszenarien des IPCC. Die Zusammenfassung stammt aus einem Artikel in Nature aus dem Jahr 2020 von Zeke Hausfather und Glen Peters, beide Wissenschaftler sind keine Skeptiker oder „Leugner“. Sie gehören zum Mainstream und sind verärgert darüber, dass die extremen und sehr unwahrscheinlichen Szenarien RCP8.5 und das neuere Szenario AR6 SSP3-7.0 in den Medien als „business as usual“ dargestellt werden. Dabei stellen beide eine „unwahrscheinliche, risikoreiche Zukunft“ dar, die in der Fachliteratur diskreditiert wurde.

Nordhaus‘ optimales Szenario ist wie das zweite von oben in Abbildung 9, beschriftet mit „Unlikely“ (unwahrscheinlich), in dem die Temperaturen bis 2100 um 4 °C steigen (Nordhaus, 2018, S. 452). Die jüngsten Beobachtungen liegen deutlich unter diesem Szenario und folgen dem RCP4.5-Szenario. Um einen geologischen Kontext zu schaffen, zeigen wir das RCP4.5-Niveau von CO2 im Jahr 2100 auf einem Diagramm der CO2-Konzentration der letzten 500 Millionen Jahre. Wie Sie sehen können, wurde dieses CO2-Niveau vor 50 bis 20 Millionen Jahren um das PETM (Paleozän-Eozän-Thermal-Maximum) herum überschritten, als die Temperaturen wahrscheinlich zehn Grad höher waren als heute. Dies war auch die Zeit, in der sich unsere Vorfahren, die Primaten, entwickelten und weit über die Welt verbreiteten. Primaten, andere Säugetiere, neue Schildkröten- und Eidechsenarten und viele Pflanzen entwickelten und verbreiteten sich während dieses sehr angenehmen, warmen Klimas.

Schlussfolgerungen

Ist CO2 gut oder schlecht? Zusammenfassend lässt sich sagen, dass wir derzeit keine negativen Auswirkungen des CO2-Anstiegs oder der globalen Erwärmung beobachten können. Wenn überhaupt, dann geht es der Welt heute besser als in der vorindustriellen Zeit. Wir haben weniger wetter- und klimabedingte Probleme, die landwirtschaftliche Produktivität ist höher, und es gibt glaubwürdige Modelle, die diese Verbesserungen auf den steigenden CO2-Gehalt und das wärmere Wetter zurückführen.

Die Weltwirtschaft wächst derzeit mit etwa 3 % pro Jahr, und niemand erwartet, dass sich diese Wachstumsrate wesentlich ändert. Bei dieser Rate wird die Wirtschaft im Jahr 2100 um 1.000 % größer sein als heute. Bei einer Wachstumsrate von 2 %, dem historischen Durchschnitt, wird das globale BIP bis 2100 um 478 % wachsen. Der IPCC schätzt, dass sich dieses Wachstum aufgrund des Klimawandels um 3 % verringern wird, was bedeutet, dass wir ein Wachstum von 464 % und nicht von 478 % erleben würden. Die Frage ist nur: Wird das jemand merken? In der Zwischenzeit werden wir unsere Wirtschaft heute radikal zerstören, indem wir auf fossile Brennstoffe verzichten, um im Jahr 2100 ein Wachstum von 14 % zu erreichen. Ist das klug? Das ist die Frage, die wir uns stellen müssen.

Nordhaus behauptet, dass das optimale wirtschaftliche Szenario zu einer globalen Erwärmung von vier Grad führt. Aktuelle realistische Prognosen gehen von einer Erwärmung von 2,5 bis 3 °C im Jahr 2100 aus. Was ist der Grund für die Aufregung? Vor mehr als 6000 Jahren, als die Zivilisation begann, waren die Temperaturen in der nördlichen Hemisphäre mindestens drei Grad höher als heute. Alles, was Karoly und der IPCC zu bieten haben, sind ominöse Prognosen über die künftige Erwärmung und darauf basierende Prognosen über die Schäden. Keine ihrer Projektionen wurde bestätigt, und sie wurden von Ross McKitrick und John Christy in zwei kürzlich veröffentlichten kritischen Studien (2018 und 2020) entkräftet.

Beruhigt euch, Leute, es gibt keinen Grund zur Sorge.

Bei der Veranstaltung handelte es sich um einen Lunch-Vortrag, der mit 70 Dollar pro Teller restlos ausverkauft war. Im Anschluss gab es mehrere Fragen, die alle höflich waren. Die Gastgeber veranstalteten danach eine Signierstunde für mich, und ich verkaufte alle Bücher, die ich mitgebracht hatte, und habe bereits mehrere Vorbestellungen für weitere Bücher. Ein guter Tag.

Link: https://andymaypetrophysicist.com/2022/08/30/are-fossil-fuel-co2-emissions-good-or-bad/

Übersetzt von Christian Freuer für das EIKE