Uni Stuttgart: Ingenieure und Wissenschaftler ziehen Bilanz aus 20 Jahren Energiewende

Kritiker auf verlorenem Posten?

Edgar L. Gärtner

Ingenieure sieht man so gut wie nie in deutschen TV-Talk Shows. Dabei gibt es unter den führenden Köpfen ingenieurwissenschaftlicher Fachbereiche durchaus Leute (inzwischen oft im Rentenalter), die mit Witz und Verve vortragen können. Das zeigte sich am vergangenen Wochenende im Internationalen Begegnungszentrum IBZ des Campus Stuttgart-Vaihingen. Dort hatte Prof. Dr. André Thess, Inhaber des Lehrstuhls für Energiespeicherung am Institut für Gebäudeenergetik, Thermotechnik und Energiespeicherung (IGTE) für den 8. bis zum 10. Juli zu einer Fachtagung zum Thema „20 Jahre Energiewende“. Als Schirmherrn und Moderator der Veranstaltung gewann Prof. Thess (der in Dresden zu Hause ist) den bekannten Dresdner Politikwissenschaftler Prof. Dr. Werner J. Patzelt. So war gewährleistet, dass die Diskussionen nicht in Fachsimpelei versandeten.

Der Wissenschaftsphilosoph und Ethiker Prof. Dr. Carl Friedrich Gethmann (Siegen) eröffnete den Reigen der Fachvorträge. Der von Mathematik und Logik herkommende Philosoph ließ allerdings die religiöse Dimension der Energiewende-Politik m. E. unterbelichtet. Immerhin warnte er klar vor der Übergriffigkeit einer sich auf „die“ Wissenschaft berufenden Politikberatung. Der über Skype aus Kopenhagen zugeschaltete bekannte dänische Politologe Björn Lomborg wiederholte seinen beeindruckenden statistischen Nachweis der generellen Weltverbesserung seit der vorletzten Jahrhundertwende. So hat sich die von Waldbränden betroffene Fläche zwischen 1900 und 2000 um etwa ein Drittel vermindert. Im 21. Jahrhundert hat sich dieser Trend, wie präzise Satellitenaufnahmen zeigen, fortgesetzt. (Ich habe schon vor vier Jahren an dieser Stelle darauf hingewiesen.) Die Zahl der von Wetter- und Klimaextremen verursachten Todesopfer ist im gleichen Zeitraum auf ein Zehntel gesunken.

Das Kosten-Nutzen-Verhältnis der Klimapolitik ist negativ

Der allgemeine Trend der Weltverbesserung, davon ist Lomborg überzeugt, wird auf absehbare Zeit auch vom Klimawandel nicht durchkreuzt. Das Kosten-Nutzen-Verhältnis der Verfolgung des 1,5- oder 2-Grad-Ziels in der Klimapolitik sei deshalb negativ. Optimal sei eine globale Erwärmung um 3,75 Grad. Lomborg konnte von daher die Schätzung der Unternehmensberatung McKinsey, wonach für die Bekämpfung des Klimawandels 5,4 Prozent des BIP oder über ein Drittel der globalen Steuereinnahmen aufgebracht werden müssen, nur mit Kopfschütteln quittieren. Die beste Antwort auf den Klimawandel sei intelligente Anpassung. Dabei akzeptiert Lomborg leider unhinterfragt das politische Dogma eines linearen Zusammenhangs zwischen den menschlichen CO2-Emissonen und dem Anstieg der Erd-Temperatur. Aber er geht davon aus, dass nur technische Innovationen und nicht Verbote und Rationierung den CO2-Anstieg kosteneffektiv bremsen können. Als grün dürften dabei aber nicht nur Solar- und Windenergie anerkannt werden. Eine globale CO2-Steuer sei der beste Weg, um technologie-neutral Öko-Innovation zu fördern.

Prof. Dr. Michael Beckmann (Dresden) untersuchte, ob die angebotenen Technologien, um dem Ziel 100 Prozent Erneuerbare näher zu kommen, wirklich anwendungsreif sind. Er verwendete dabei die u.a. im Flugzeugbau bewährte 9-stufige Klassifikation des Technology Readiness Levels (TRL). Dabei kam er trotz optimistischer Annahmen zum Schluss, dass Industrieregionen allenfalls das Niveau 4 erreichen, also noch im Anfangsstadium der Technologieentwicklung stecken. Nur einige kleine Inseln ohne Großindustrie wie etwa die Kanaren-Insel El Hierro mit 11.000 Einwohnern erreichen das Niveau 7, wobei auch El Hierro auf den Einsatz von Diesel-Aggregaten nicht verzichten kann. Nicht nur Deutschland, sondern die ganze Welt ist noch weit vom TRL-Niveau 9 entfernt.

Prof. Dr. Harald Schwarz (Cottbus) beschäftigte sich mit den besonderen Problemen der Stromnetze. Die Elektrizität deckt zurzeit etwa 20 Prozent des deutschen Jahres-Energiebedarfs von 2.317 TWh ab. Dieser Anteil soll nach dem Willen der Grünen aber schon in naher Zukunft auf 75 Prozent ansteigen. Das ist utopisch. Allein um die für E-Autos notwendigen Ladestationen mit der nötigen Leistungsstärke zu versorgen, müssten die Niederspannungs-Netze auf über einer Million Kilometern verstärkt werden. Wer soll das bezahlen und wo findet man genügend qualifizierte Handwerker? Die gesicherte Leistung von Onshore-Windkraftanlagen liegt bei nur einem Prozent. Die in Deutschland vorhandenen Pumpspeicher reichen nur für 30 bis 60 Minuten. Wie will man da den für die Netzstabilität wichtigen Grenzwert von 49,8 Hertz einhalten? Wie will man ein von Erneuerbaren dominiertes Netz nach einem Blackout schwarz starten? Lauter ungelöste Fragen!

Sehr interessant war m.E. auch der Vortrag von Prof. Dr. Thomas Koch vom bundeseigenen Karlsruhe Institut für Technologie (KIT), das viel mit wissenschaftlicher Politikberatung beschäftigt ist. Koch wies darauf hin, dass alle von Kraftfahrzeugen hervorgerufenen Umweltprobleme wie NOx-, SO2 oder Kohlenwasserstoff- und Partikel-Emissionen längst befriedigend technisch gelöst sind. Bei den Bemühungen der Politik in Brüssel und Berlin, den CO2-Ausstoß von Kfz mit immer größerem technischen Aufwand weiter zu senken, gehe es nicht um die Schonung des der Menschheit vom Klimarat IPCC zugestandenen Rest-Budgets von 420 Gigatonnen CO2, sondern um die Abschaffung der Kfz mit Verbrennungsmotor. Bei der Verschiebung der Einführung der Euronorm 7 für Kfz-Abgase durch den Vizepräsidenten der EU-Kommission Frans Timmermans gehe es einzig darum, die Automobilindustrie von weiteren technischen Innovationen abzuhalten. Theoretisch könne man die Verbrenner mit dem Einsatz „klimaneutraler“ E-Fuels retten. Bei einem Strompreis von 1ct/KWh seien diese wettbewerbsfähig. In manchen Ländern sei ein solch günstiger Strompreis durchaus erreichbar.

Vorteile der Kernenergie

Prof. Dr. Horst Michael Prasser, früher am Helmholtz-Zentrum Dresden-Rossendorf und heute an der ETH Zürich forschend und lehrend, gab ein eindrucksvolles Plädoyer für die Kernenergie. Selbst beim EPR, dessen Baukosten wegen Fehlplanungen aus dem Ruder gelaufen sind, betragen diese mit 0,015 €/KWh weniger als die Hälfte der Baukosten von Photovoltaik-Anlagen. Ganz zu schweigen von den Betriebs- und Entsorgungskosten über den gesamten Lebenszyklus. Hier seien moderne Kernkraftwerke um den Faktor 1.000 und mehr besser als PV-Anlagen. Radioaktive Abfälle stellten wegen ihres geringen Volumens kein großes Problem dar. Deutschland könne sich übrigens mithilfe der Hinterlassenschaft der untergegangenen Wismut AG in Thüringen und Sachsen mit Uran selbst versorgen. Die Zukunft des Dual-Fuel-Reaktors, der auch aus radioaktiven Abfällen Energie gewinnen kann, hänge an der Entwicklung widerstandsfähiger Werkstoffe aus Silizium-Karbid-Keramik. Vielleicht kann die carbothermische Nitridierung silikatreicher Braunkohle, die ich vor einigen Jahren an dieser Stelle vorgestellt habe, dazu beitragen.

Immerhin schaffte es Prof. Thess in Gestalt von Anna-Veronika Wendland (Leipzig und Marburg) in der von Männern dominierten Technik-Welt auch eine Frau als Referentin aufzutreiben. Die auf Osteuropa spezialisierte Historikerin betreibt in der Nuklearwirtschaft Sicherheitsforschung besonderer Art, das heißt „Maschinen-Ethnologie“ oder „Industrial Anthropology“ im Sinne des bekannten französischen Öko-Theoretikers Bruno Latour. Sie geht der Frage nach, ob und inwieweit die Kernenergie etwas zur gesellschaftlichen Sicherheit beitragen kann. Damit hat sich die ehemalige Nuklear-Gegnerin viele Sympathien der politischen Linken, der sie sich noch immer zugehörig fühlt, verscherzt. Sie sieht ihre Aufgabe in der gesellschaftlichen „Konsens-Herstellung“. Deshalb müsse man Initiativen wie Fridays for Future (FfF) durchaus ernstnehmen, müsse aber deren Apokalyptik zurückweisen. Sie verweist auf den enormen Rohstoffbedarf der so genannten Erneuerbaren im Vergleich zur Kernkraft mit geringster Materialintensität. Diese werde von den Grünen aber gerade wegen ihrer Vorteile abgelehnt, weil das die Chancen der Erneuerbaren schmälert. Denuklearisierung sei der Grünen Bewegung also wichtiger als Dekarbonisierung. Die Laufzeitverlängerung bestehender Kernkraftwerke sei die günstigste Option der Klimapolitik zur Ansteuerung des Net-Zero-Ziels für 2050. Auch der Neubau von KKW werde sich lohnen. Daher sei es nur logisch, dass das Joint Research Institute (IRC) der EU die Kernenergie als nachhaltig eingestuft hat und die Mehrheit des EU-Parlaments dieser Einschätzung folgte.

Wie man sich denken kann, stieß der von Frau Wendland gewählte Begriff „Konsens-Herstellung“ bei den Diskutanten auf Widerspruch. Einvernehmen statt Konsens reiche völlig aus, betonte der Physiker Philip Lengsfeld. Die Mehrheit der Deutschen freunde sich angesichts des Gasmangels inzwischen ohnehin mit der Kernenergie-Nutzung an. Ohnehin müsse man die Kerntechnik als Low Risk Technologie betrachten, schloss Frau Wendland. Um hier Investitionen anzuziehen, müsse der Staat allerdings Planungssicherheit garantieren.

Die Linke hat total versagt

Beim abendlichen Kamingespräch fragte Prof. Patzelt als Moderator: „Muss unser Klima wirklich gerettet werden?“ Der Journalist Alexander Wendt (München) stellte die Gegenfrage: „Wann ist das Klima gerettet?“, um zu zeigen, dass die grüne Bewegung mit verschwommenen Zielvorstellungen operiert und dadurch eine Verengung des Diskurses erreicht. Der ehemalige RWE-Manager Fritz Vahrenholt (Hamburg) wies darauf hin, dass es nach der Verabschiedung des „Osterpakets“ der Berliner Ampel-Regierung kaum noch Klagemöglichkeiten gegen Windkraft-Projekte gibt. Die Fixierung auf die Abwendung einer angeblich drohenden Klimakatastrophe stelle eine Gefahr für die Demokratie dar. Schon jetzt gebe es Beispiele staatlicher Zuteilung von Ressourcen nach Gutsherrenart. So habe der konkursreife Windradbauer Enercon im Zuge der Corona-Hysterie 500 Millionen Euro erhalten. Wofür? Alexander Wendt verwies auf die Forderung des von der Regierung bestellten Sachverständigenrates für Umweltfragen, die Zuständigkeit der Parlamente durch einen nicht gewählten Zukunftsrat einzuschränken. FfF-Ikone Louisa Neubauer beruft sich darauf, wenn sie offen verfassungsfeindliche Forderungen stellt. Wendt wies auch darauf hin, dass die Energiewende schon allein deshalb scheitern muss, weil sie zu viele Ziele gleichzeitig verfolgt: Die Energieversorgung sollte gleichzeitig sauberer, billiger, dezentraler und weniger vom Ausland abhängig werden. In der Praxis wurde in allen Punkten das Gegenteil erreicht. Statt ihr Scheitern einzugestehen, verbarrikadierten sich die Befürworter der Energiewende in einer Wagenburg.

Die Ex-Grüne Antje Hermenau (Dresden) wies darauf hin, dass mittelständische Unternehmen wegen der unsicheren Materialversorgung infolge der Störung von Lieferketten untereinander schon Tauschhandel praktizieren. Statt vom Prinzip der Subsidiarität auszugehen, baue die EU aber an einer Arbeitsteilung nach dem Modell des untergegangenen sozialistischen RGW. Anna Veronika Wendland klagte, es gebe in Deutschland keinen oppositionellen Umweltverband mehr. Die Investoren in Wind- und Solarkraftwerke kontrollierten sich also selbst und sorgten für immer mehr Umverteilung von unten nach oben. Es gebe einen inhaltlichen Gleichklang zwischen den Transformations-Modellen der globalen WEF-Elite (Sozialismus der Milliardäre) und dem grün-linken Milieu. „Wer das kritisiert, wird als Verfassungsfeind abgestempelt. Die Linke hat total versagt“, stellte sie fest. Immerhin gebe es in Deutschland etwa 1.000 Bürgerinitiativen gegen Windkraft-Projekte, erinnerte Fritz Vahrenholt. Gebe es Anfang Januar 2023 kein Gas mehr, komme der große Aufstand. Das wage ich aufgrund der Kenntnis der Psyche meiner Landsleute zu bezweifeln.

Wenn die Kosten den Umsatz übersteigen…

Der bekannte Wirtschaftswissenschaftler Ulrich van Suntum (Münster) beschäftigte sich am folgenden Tag der Veranstaltung mit den Kosten der Energiewende. Das Münchner Ifo-Institut schätzt die Kosten der Vermeidung von einer Tonne CO2 auf 60 bis über 400 Euro. Die CO2-Zertifikate kosten in Deutschland zurzeit zwischen 80 und 85 €/t, sind in anderen Ländern aber für weniger als ein Zehntel dieses Preises zu haben. Das führe dazu, dass in Deutschland oft am falschen Ende gespart wird. Ohnehin liege Deutschlands Anteil am globalen CO2-Ausstoß inzwischen unter 2 Prozent. Selbst wenn es Deutschland gar nicht mehr gäbe, mache das also kaum einen Unterschied. Die CO2-Vermeidung komme mithilfe der Photovoltaik (415 €/t) am teuersten. Die in der deutschen Energiepolitik übliche kleinteilige Planwirtschaft diene nur der Profilierung von Berufspolitikern, die sich immer den wissenschaftlichen Rat suchen, der ihnen gerade in den Kram passt. „Was Deutschland macht, ist alles Tinnef“, schloss van Suntum sarkastisch und plädierte für einen internationalen Klima-Fonds, um die Klimapolitik den Machenschaften kurzsichtiger Politiker zu entziehen.

Ein Highlight der Veranstaltung war der Vortrag von Dr. Ing. Hans-Bernd Pillkahn (Werdohl). Pillkahn hat sein ganzes Berufsleben in der Metallindustrie zugebracht und kennt die geostrategische Situation Deutschlands aus eigener Erfahrung. Es sei wirtschaftlich unmöglich, die politische Vorgabe einer 36prozentigen Absenkung des deutschen CO2-Ausstoßes bis 2030 allein durch die Nutzung von Wind- und Solarenergie zu erreichen. Die Windleistung von einem Kilowatt kostet Investitionen von 1,5 Millionen Euro. Die im bereits erwähnten „Osterpaket“ als „Freiheits-Strom“ titulierte Solarenergie koste 1,4 Billionen Euro je Gigawatt Leistung. Dabei erreicht die Nutz-Zeit der Sonnenenergie in Deutschland nur 10,5 Prozent, die der Windkraftanlagen 20,9 Prozent. Da konnte Pillkahn genüsslich zitieren, was Wilhelm Busch im Jahre 1870 über die Nöte der Windmüller schrieb. Pillkahn beschäftigte sich dann mit dem Rohstoffbedarf der Erneuerbaren. Nach einer aktuellen Studie der belgischen Universität Leuwen wächst allein der Lithiumbedarf bei der Verfolgung der so genannten SDS-Strategie um über 1.000 Prozent!

Aber nicht nur bei Lithium, auch bei allen anderen Metallen ist die Abhängigkeit Deutschlands von Importen sehr groß. 67 Prozent aller Kapazitäten der Erz-Raffinierung befinden sich in Asien, nur 1,5 Prozent in Deutschland, 6,6 Prozent in der EU und 3,6 Prozent in den USA. Es gibt in Deutschland zum Beispiel nur eine einzige Zinkhütte. Nicht von ungefähr erreicht der in der Schweiz ansässige Rohstoff-Handelskonzern Glencore einen Jahresumsatz von 270 Milliarden Euro. Der Versuch der Umsetzung der politischen CO2-Vorgaben in der Metallindustrie kostet überall Millionen-, wenn nicht Milliardenbeträge. So wird der Ersatz der bislang bei der Herstellung von Gusseisen eingesetzten Kupolöfen, die mit Koks befeuert werden, durch elektrische Induktionsöfen schätzungsweise 45 Millionen Euro kosten. Unbezahlbar teuer würde die von der Politik gewünschte Herstellung von “grünem“ Stahl mithilfe von Wasserstoff (H2). Deren Strombedarf wird auf 110 TWh, die Leistung von drei großen Kernkraftwerken vom Typ Isar 2, geschätzt. Deren Ersatz durch Grünstrom würde mehr kosten als der gegenwärtige Umsatz der Stahlindustrie! Weltweit habe bislang noch niemand auch nur eine Tonne Stahl mithilfe von Wasserstoff hergestellt, betonte Pillkahn in der anschließenden Diskussion.

Das jähe Ende der „Gaswende“

Prof. Dr. Fritz Vahrenholt, jetzt Aufsichtsratsvorsitzender der Hamburger Aurubis AG, des größten deutschen Kupferherstellers, konnte da direkt anschließen. Was als umfassende Energiewende verkündet wurde, sei in Wirklichkeit nur eine Wende zum Erdgas gewesen. Die Pipeline Nord Stream 2, die die Russen im Verbund mit westeuropäischen Konzernen auf ausdrücklichen Wunsch Berlins gebaut haben, sollte ausschließlich dieser „Gaswende“ dienen. Es war bekannt, dass die geplanten Windräder wegen ihrer unsteten Leistung dringend eines Backup durch flexibel einsetzbare Gaskraftwerke bedurften. (Ich habe darauf schon im Jahre 2008 im „Wall Street Journal“ hingewiesen.) Die letzte Berliner Koalitionsvereinbarung sah den Bau von 30 bis 50 zusätzlichen Gaskraftwerken vor. 38 Prozent des von Deutschland importierten Erdgases werden von der Industrie benötigt. Drehte Präsident Putin im Zuge des zum totalen Krieg auswachsenden Konfliktes zwischen der NATO und Russland den Gashahn endgültig ab, seien in Deutschland 5,6 Millionen Arbeitsplätze in höchster Gefahr. Das russische Gas durch den Schiffstransport von Flüssiggas (LNG) zu ersetzen sei in absehbarer Zeit nicht möglich. Noch unrealistischer sei der Ersatz thermischer Kraftwerke durch die Produktion von „Freiheits-Strom“ aus Wind und Sonne. Deren Anteil an der Primärenergieerzeugung machte im vergangenen Jahr gerade einmal 5,1 Prozent aus. Kurz- und mittelfristig helfe nur die Zulassung der heimischen Erdgasförderung aus Schiefergestein durch Fracking aus der gefährlichen Gasknappheit. Deutschlands Schiefergasvorräte reichen immerhin für Jahrzehnte.

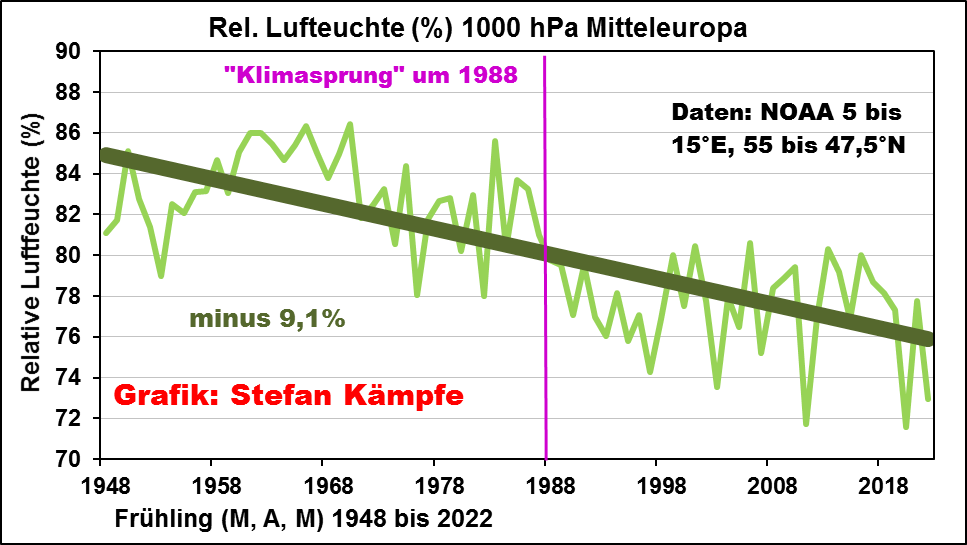

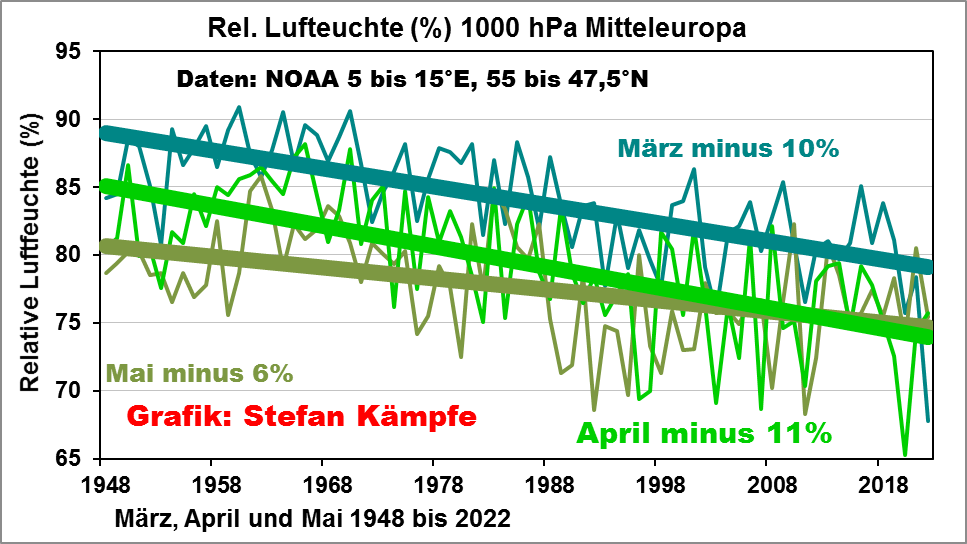

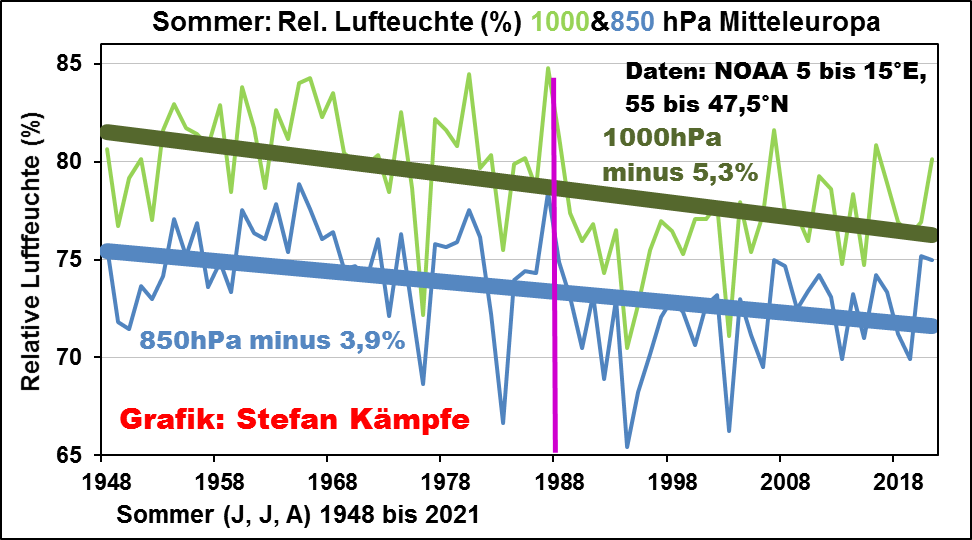

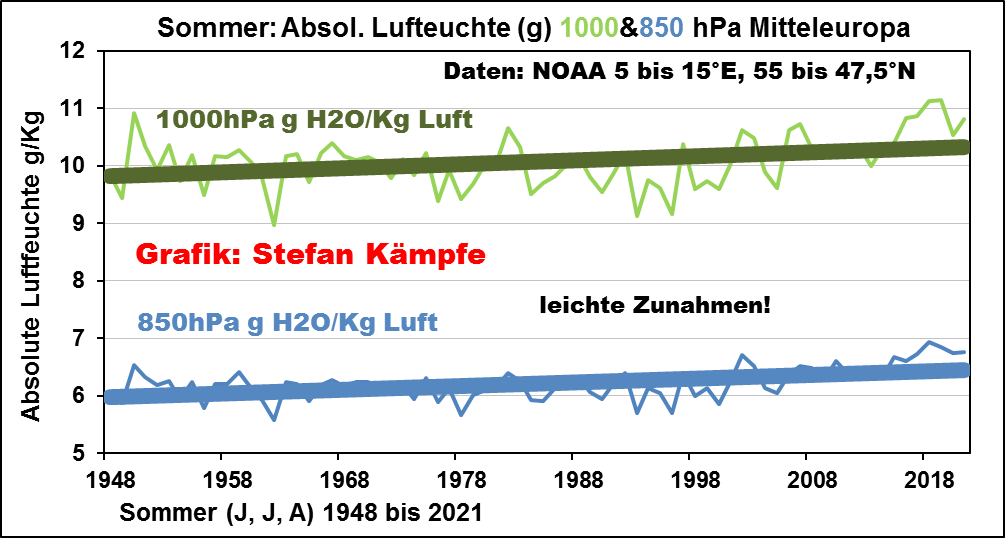

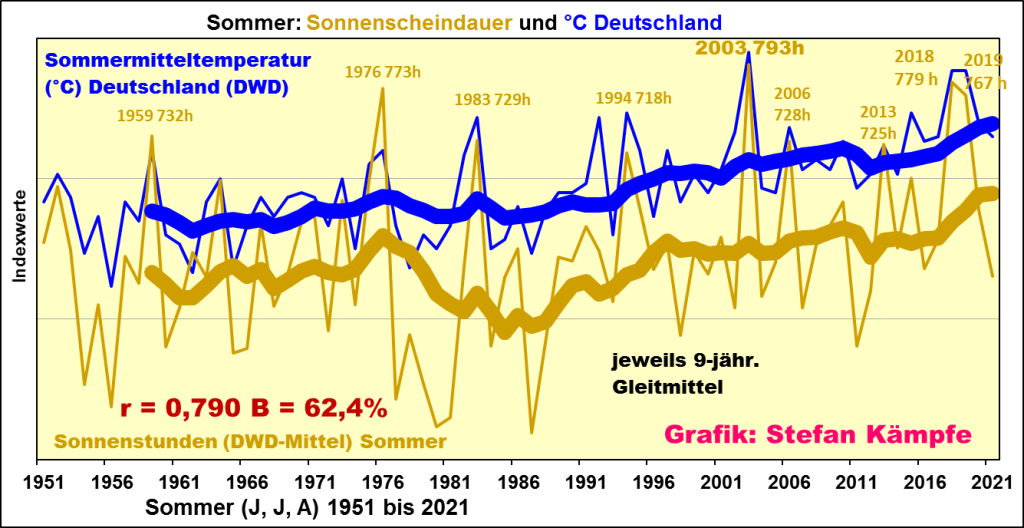

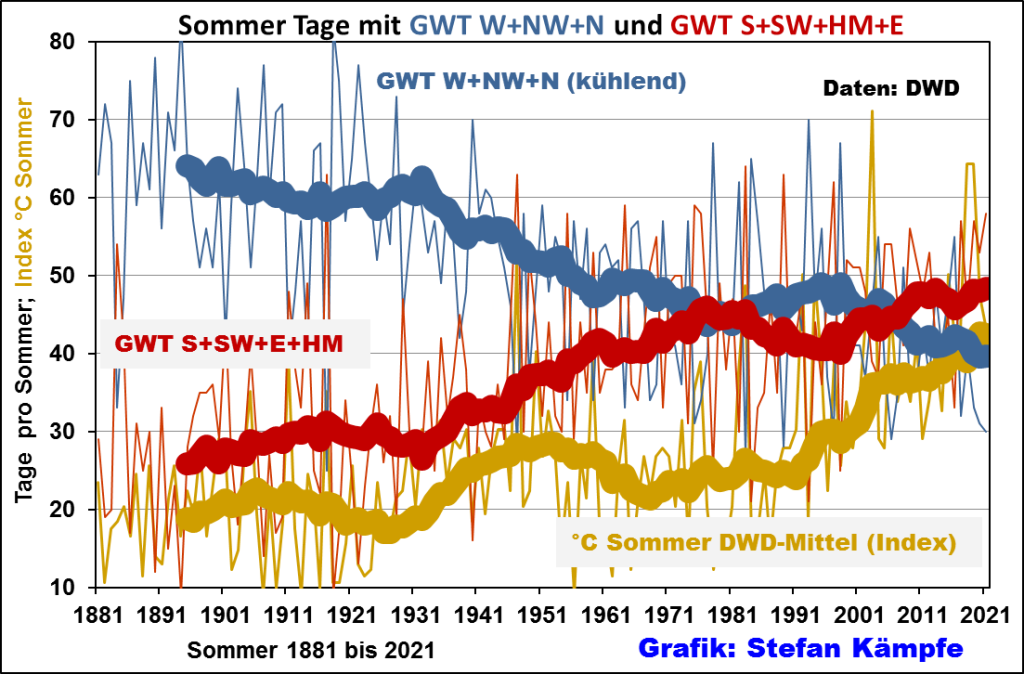

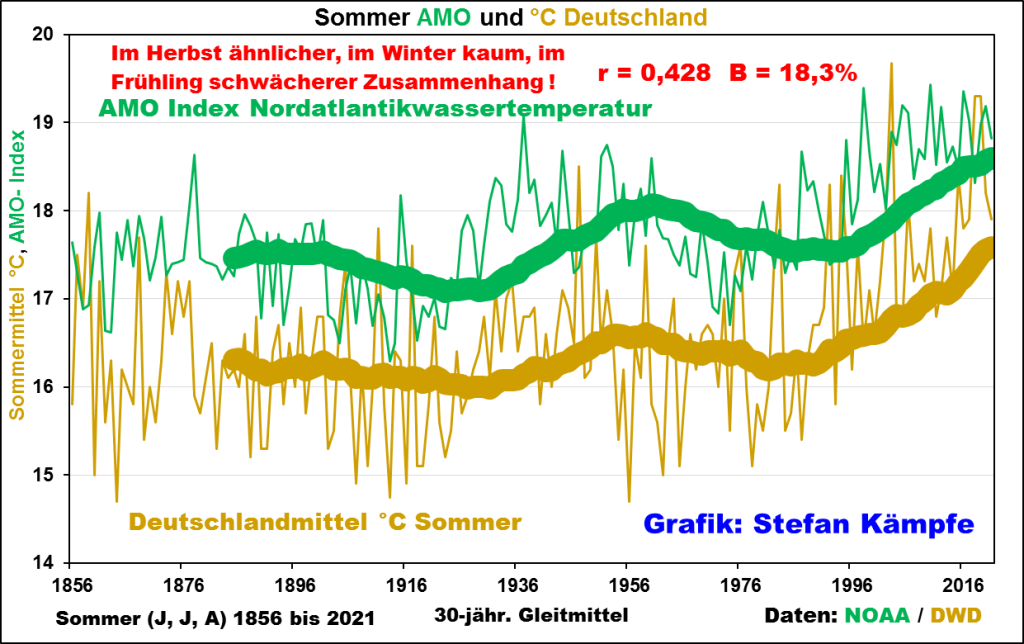

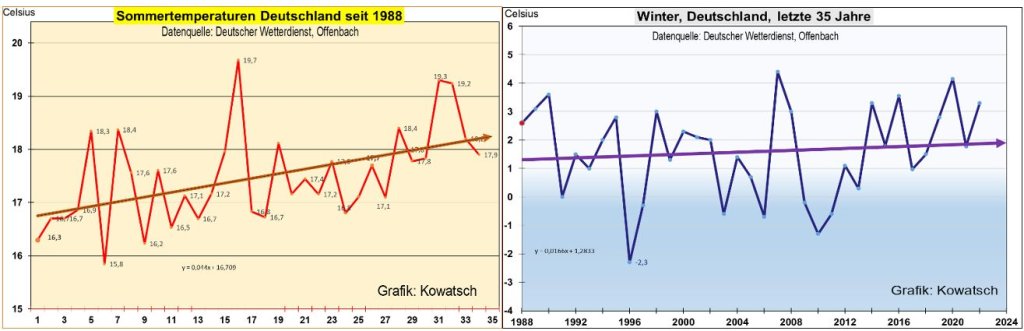

Prof. Vahrenholt erinnerte daran, dass der Gaspreis schon vor Beginn des Ukraine-Krieges am 24. Februar 2022 nach oben gesprungen ist. Das sei kein Wunder, weil alle westlichen Energiekonzerne, abgeschreckt von unsicheren politischen Rahmenbedingungen, die Exploration und Erschließung neuer Gas-Lagerstätten eingestellt haben. Im Prinzip investieren nur noch russische, chinesische und saudische Staatskonzerne in die Erschließung neuer Lagerstätten. Die Volksrepublik China gilt bekanntlich im Pariser Klimaschutz-Abkommen von 2015 noch immer als „Entwicklungsland“, das vorerst seinen CO2-Ausstoß nicht verringern muss. Dabei hat das Land mit einem Pro-Kopf-Ausstoß von 8,2 Tonnen CO2 gerade Deutschland überholt, das „nur“ 7,7 Tonnen je Einwohner freisetzt. Vahrenholt fügte allerdings hinzu, niemand wisse, in welchem Maße das CO2 die globale Durchschnittstemperatur beeinflusst. Der jüngste IPCC-Bericht helfe da leider nicht weiter, weil er methodisch hinter seine Vorgänger zurückfalle. So gehe der IPCC in seinem Szenario 8.5 von der Emission von 6.100 Gigatonnen CO2 bis zum Jahre 2100 aus. Dadurch werde es zu einem globalen Temperaturanstieg von bis 4°C kommen. Dabei haben die Modellierer übersehen, dass die Brennstoff-Vorräte der Erde gar nicht ausreichen, um so viel CO2 zu erzeugen. Vahrenholt vermutet, dass die in den letzten Jahrzehnten gemessene Erwärmung der Erdatmosphäre zu einem guten Teil auf die Verlängerung der Sonnenscheindauer und jährlich 250 Stunden zurückgeht.

Wer haftet für Klima- und Energie-Simulationen?

Die Klimapolitik und somit auch die Entscheidung für die Energiewende beruht fast ausschließlich auf Modell-Simulationen, deren Validierung kaum möglich ist. Wer haftet für solche Simulationen? Mit dieser Frage setzte sich der Gastgeber André Thess selbst auseinander. In den Ingenieurwissenschaften unterscheidet man drei Kategorien von Simulationen. Kategorie A bezieht sich auf den Bau von Verkehrsflugzeugen. Deren Bau wird mithilfe der Navier-Stokes-Gleichungen der Strömungsmechanik berechnet. Die Validierung der mathematischen Modelle erfolgt mit einer Fehlerquote von unter einem Prozent im Windkanal. Die Hersteller haften für ihre Produkte. Das gilt als Goldstandard für Simulationen in den Ingenieurwissenschaften. In die Kategorie B gehören Wetter- und Klimaprognosen mit einer Fehlerquote von über 5 Prozent. Dafür haftet niemand. Energieszenarien mit dem Ziel, den kostengünstigsten Investitionspfad herauszufinden, gehören in die Kategorie C. Hier gibt es weder Validierung noch Haftung. Simulationsversuche sind allenfalls auf kleinen Inseln wie Pellworm oder El Hierro möglich. In der Diskussion kam die Frage auf, ob man nicht auch die Klimasimulationen dieser Kategorie zurechnen müsse. Ohne ein ständiges Monitoring sei die Arbeit mit solchen Modellen jedenfalls sinnlos.

Wie kann sich dann das Bundesverfassungsgericht in seinem umstrittenen Urteil zum Klimaschutz vom 24. März 2021 auf den Artikel 20a des Grundgesetzes berufen, in dem von „Klima“ gar nicht die Rede ist? Prof. Patzelt sieht hier die Gefahr einer Vertiefung der ohnehin schon vorhandenen Spaltung der Gesellschaft in „Anywheres“ und „Somewheres“. Für die Grünen sei die Energiewende das Generationenprojekt, an dem sich ihre Identität festmacht. Mit ihrer Ablehnung der Kernenergie haben sie erst die Massenmedien und dann die parlamentarische Mehrheit erobert. Patzelt hat daran nichts auszusetzen. Er beklagt aber die Ausartung der Öko-Bewegung zu einem Glaubenskampf, zu einer Hexenjagd gegen „Klimaleugner“ und KKW-Befürworter, die eine faire Debatte nicht mehr zulassen.

Patzelt ging leider nicht der Frage nach, wie es zu der auch von ihm beklagten „Zerstörung der kulturellen Homogenität“ unseres Landes kommen konnte. Deshalb darüber hier meine ganz persönliche Hypothese: Die Grünen repräsentieren die erste nachchristliche bzw. neuheidnische Generation Westeuropas. Es geht dabei nicht so sehr um Frömmigkeit, sondern um die Ablösung einer im weitesten Sinne christlich geprägte Kultur durch Formen des Gnostizismus in Verbindung mit heidnischer Mythologie. Zur christlichen Kultur gehört die ethische Argumentations-Figur der Übelabwägung. Der Gnostizismus hingegen verabscheut Kosten-Nutzen-Vergleiche und verabsolutiert das (angeblich Gute) um beinahe jeden Preis. Im Mittelalter hat man diese suizidale Irrlehre (z.T. erfolgreich) durch Kreuzzüge zu bewältigen versucht. Heute käme es darauf an, Heute käme es darauf an, das Selbstmordprogramm der FfF-Aktivist*innen bzw. der „Letzten Generation“ erst einmal als solches zu charakterisieren, anstatt davor auf die Knie zu fallen.

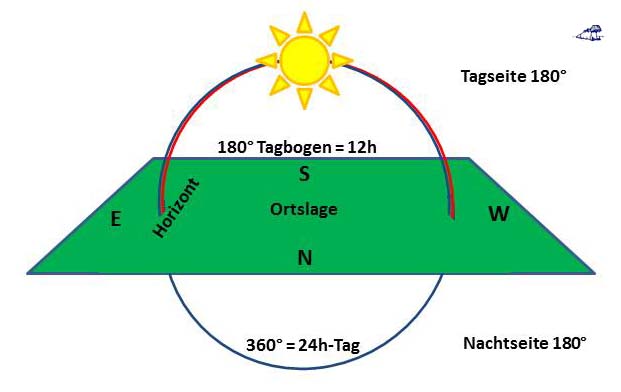

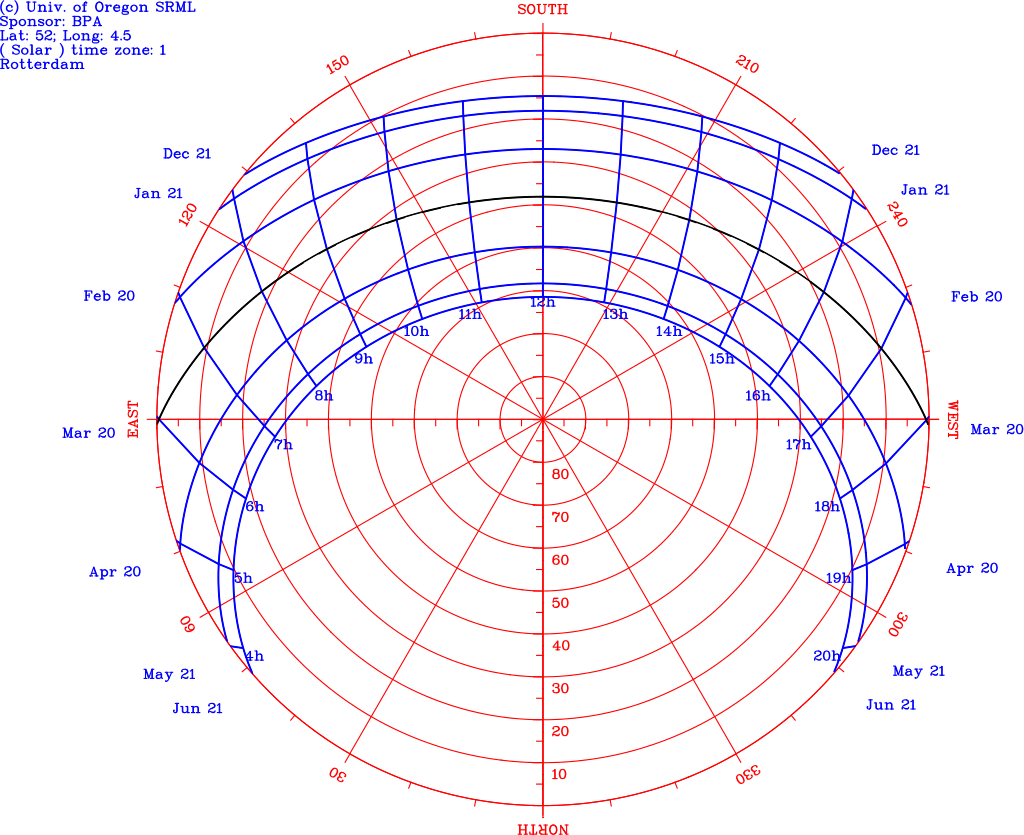

Abbildung 1: Die Variation des Tagbogens der Sonne in Mitteleuropa @ 52°N

Abbildung 1: Die Variation des Tagbogens der Sonne in Mitteleuropa @ 52°N