Was kann das „Jahr ohne Sommer“ für die sogenannte „atmosphärische Gegenstrahlung“ bedeuten?

von Uli Weber

Das Jahr 1816 wird als „Jahr ohne Sommer“ bezeichnet. Als Folge des Tambora-Ausbruchs im April 1815 kam es in Mitteleuropa zu Unwettern, Ernteausfällen, Hungersnöten und Seuchen. Die historischen Auswirkungen sind beispielsweise auf Wikipedia nachzulesen.

Die Eruption des Tambora (1815), und später auch des Krakatau (1883), entließ große Mengen feiner Aschepartikel und Aerosole in die hohe Atmosphäre, die sich dort in wenigen Tagen weltweit verteilten. Der Trübungsindex der Krakatau-Eruption von 1883 wurde auf 1000 gesetzt, der Tambora-Ausbruch erhielt danach einen Trübungsindex von 3000. Vor allem durch die das Sonnenlicht reflektierenden Aerosole sank auf der Nordhalbkugel die Durchschnittstemperatur; die gleiche Quelle nennt für das Jahr nach der Tambora-Eruption ein Absinken der gemessenen Temperaturen um 2,5 Grad, beim Krakatau sollen es 0,5 Grad gewesen sein.

Dieser Temperaturrückgang lässt Schlussfolgerungen über die sogenannte „atmosphärische Gegenstrahlung“ zu. Unsere Erde soll sich angeblich durch die Rückstrahlung ihrer eigenen IR-Abstrahlung noch weiter erwärmen. Dieses Phänomen wird als „atmosphärische Gegenstrahlung“ bezeichnet und widerspricht dem 2. HS der Thermodynamik:

1. Primär: Hochfrequente (HF) Sonneneinstrahlung (@PIR²) erwärmt die Materie auf der Tagseite der Erde (@2PIR²).

2. Sekundär: Diese erwärmte Materie strahlt Infrarot(IR)-Strahlung über die gesamte Erdoberfläche (@4PIR²) ab.

3. Tertiär: Die IR-Abstrahlung animiert angeblich sogenannte „Klimagase“ zu einer IR-„Gegenstrahlung“ (@4PIR²), die teilweise auf die Erdoberfläche zurückgestrahlt werden soll.

4. Quartär: Und diese IR-„Gegenstrahlung“ soll schließlich, im Widerspruch zum 2. HS der Thermodynamik, wiederum die Erdoberfläche (@4PIR²) noch weiter erwärmen, beziehungsweise (nach anderen Quellen) „deren Abkühlung verlangsamen“.

Anmerkung: Eine „verlangsamte Abkühlung“ stellt aber wiederum noch lange keine Temperaturerhöhung dar…

Es gibt daher nur eine Möglichkeit, wie sich die Reduzierung der solaren Einstrahlung durch eine solche Dunkelwolke auf die ominöse „atmosphärische Gegenstrahlung“ auswirken muss:

Alle gemessenen oberflächennahen Temperaturwerte auf der Erde müssen absinken, weil die primäre solare (HF) Einstrahlung reduziert wird und sich damit auch die sekundäre IR-Abstrahlung der Erde als Quelle der sogenannten „atmosphärischen Gegenstrahlung“ verringert.

Wenn wir uns nun einmal die Deutschland-Temperaturen für den Zeitraum um 1816 anschauen, dann können wir dieses Ereignis in einer detaillierterer Temperaturkurve mit einem 12-monatigen beweglichen Durchschnitt nur ansatzweise erkennen.

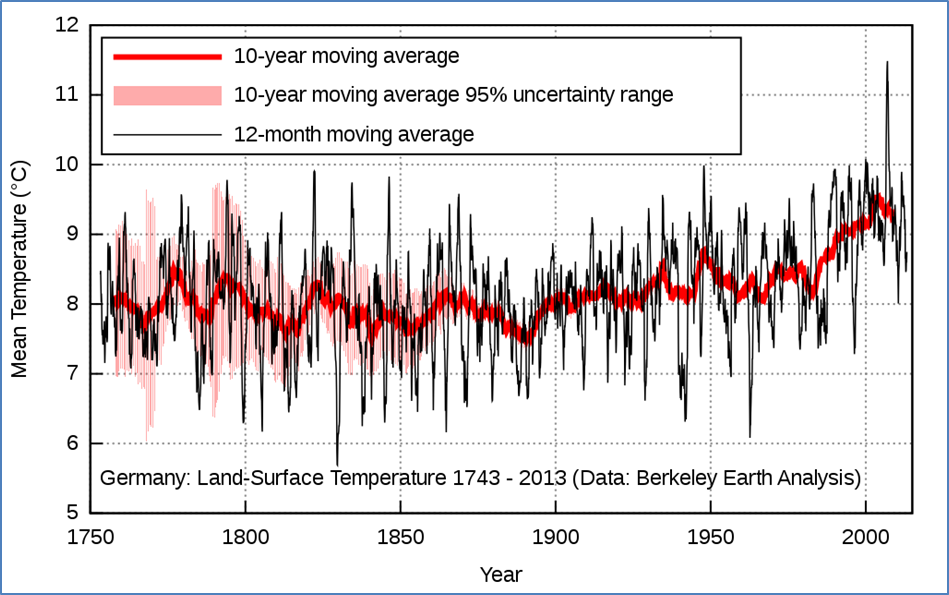

Abbildung 1: „Deutschland: mittlere Jahrestemperaturen 1743–2013 als gleitende 12-Monats- sowie 10-Jahres-Mittel“ Quelle Wikipedia, Autor Phrontis, Lizenz: CC BY-SA 3.0

Datenbasis: http://berkeleyearth.lbl.gov/auto/Regional/TAVG/Text/germany-TAVG-Trend.txt

Auffällig sind lediglich drei Jahre vor 1820, in denen die Spitzen des 12-monatigen Mittels im Maximum kaum über das 10-jährige gleitende Mittel hinausreichen. Ähnliche Verläufe zeigt der Temperatur-Graph um 1765, 1780, 1885, 1940 und 1980. Unter diese Auffälligkeiten fällt übrigens auch der Ausbruch des Krakatau, einem Vulkan in der Sundastraße zwischen den indonesischen Inseln Sumatra und Java, am 27. August 1883.

Symptomatisch beim „Jahr ohne Sommer“ und den beiden Folgejahren sind zunächst die fehlenden positiven Temperaturspitzen oberhalb des gleitenden 10-Jahres-Mittels, während die negativen Extreme nicht unter die Minima der benachbarten Jahre abfallen. Diese Minima setzen sich sowohl aus den örtlichen Nachttemperaturen als auch aus den Temperaturen im Winterhalbjahr zusammen.

Und was bedeuten nun verringerte Maximalwerte und gleichbleibende Minimalwerte für die sogenannte „atmosphärische Gegenstrahlung“?

Abbildung 1 weist für das „Jahr ohne Sommer“ und die zwei Folgejahre ein deutliches Absinken der Maximaltemperatur aus, während sich die Minimaltemperatur nicht proportional vermindert hatte. Da aber die sogenannte „atmosphärische Gegenstrahlung“ vorgeblich aus der IR-Abstrahlung der gesamten Erdoberfläche gespeist werden soll, die wiederum direkt an die Erwärmung von Materie auf der Tagseite durch die Sonneneinstrahlung gekoppelt ist, erhalten wir einen Widerspruch.

Widerspruch: Wenn es eine von der infraroten Rückstrahlung unserer Erde direkt abhängige „atmosphärische Gegenstrahlung“ geben würde, dann müssten sowohl die Temperatur-Maxima als auch die Temperatur-Minima nach solchen Ereignissen um vergleichbare Beträge absinken.

Erklärung: Der in Abbildung 1 dargestellte Temperaturverlauf ergibt einen Widerspruch für die Existenz einer sogenannten „atmosphärischen Gegenstrahlung“, die einen „natürlichen atmosphärischen Treibhauseffekt“ antreiben soll. Denn die Ursache-Wirkungs-Kette HF=Primär => IR=Sekundär => „Gegenstrahlung“ => 33°THE für die Erwärmung unserer Erde aus der eigenen IR-Abstrahlung wäre bei einer Reduzierung des solaren HF-Primärantriebs in allen ihren nachfolgenden Gliedern ebenfalls reduziert.

Daher müssten bei Existenz einer Gegenstrahlung und einer Verminderung der solaren Einstrahlung sowohl die Maximaltemperatur als auch die Minimaltemperatur von einem Temperaturrückgang betroffen sein.

Wie lassen sich dann aber fehlende Maxima erklären, die keinen Einfluss auf die Minima haben?

Unsere Erde besitzt mit den globalen Zirkulationen (Atmosphäre und Ozeane) eine kombinierte Luft-Wasser-Heizung, und diese Wärmespeicher werden wiederum fortwährend durch die solare Einstrahlung auf der Tagseite unserer Erde „aufgeladen“. Allein die Ozeane, die zwei Drittel unserer Erdoberfläche bedecken, enthalten ein Wärmeäquivalent von etwa 50.000 24h-Tagen Sonneneinstrahlung. Diese Wärmespeicher lassen die kontinentalen Nachttemperaturen in Abhängigkeit vom Abstand zu den Ozeanen nur in geringem Maße schwanken. Dasselbe sollte daher ebenfalls für einige aufeinanderfolgende Sommer mit geringerer solarer Einstrahlung gelten.

Also: Die Maximaltemperaturaus der solaren Einstrahlung sinkt, aber die Minimaltemperatur wird weiterhin durch die globalen Wärmespeicher getragen.

Für den Verlauf des natürlichen Klimawandels hatten Usoskin et al. (2004/2005) nachgewiesen, dass eine Veränderung der Kennzahl für den solaren Klimaantrieb (Anzahl der Sonnenflecken) etwa 10 Jahre benötigt, um auf der Nordhalbkugel vollständig als Temperaturveränderung sichtbar zu werden (dort Abbildung 3 mit einem zwischen 0 und 10 Jahren kontinuierlich ansteigenden Korrelationskoeffizienten). Diese Erkenntnis von Usoskin et al. (2004/2005) gilt also für einen stetigen Verlauf von Ursache (Sonnenflecken) und Wirkung (Temperatur), mit denen die ozeanisch gespeicherte Wärme in einer kontinuierlichen Interaktion Schritt zu halten vermag. Der Tambora-Ausbruch hatte dagegen als disruptives Ereignis sofort und messbar mit einem plötzlichen Absinken der Maximaltemperatur um bis zu 2,5 Grad auf dieses und die beiden nachfolgenden Jahre durchgeschlagen, während die Minimaltemperaturen weiterhin von den „trägen“ globalen Wärmespeichern gestützt worden waren. Und Willis Eschenbach hatte gerade nachgewiesen, dass die Korrelation zwischen den dekadischen globalen Durchschnittstemperaturen der außertropischen Nordhemisphäre und den dekadischen globalen Durchschnittstemperaturen des gesamten Globus‘ bei 0,98 liegt (Abbildung 4 in: deutsche Übersetzung auf EIKE, Original auf WUWT). Wir können damit also in erster Näherung annehmen, dass sich die Globaltemperatur in etwa wie die Temperatur der Nordhemisphäre verhält und auch damals ebenfalls verhalten hatte.

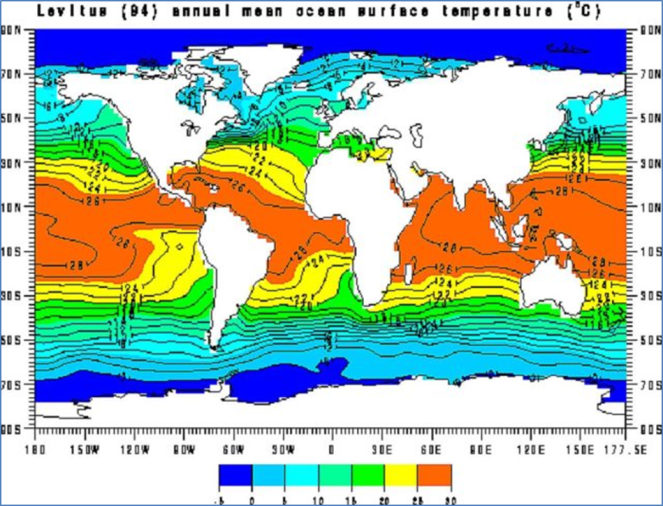

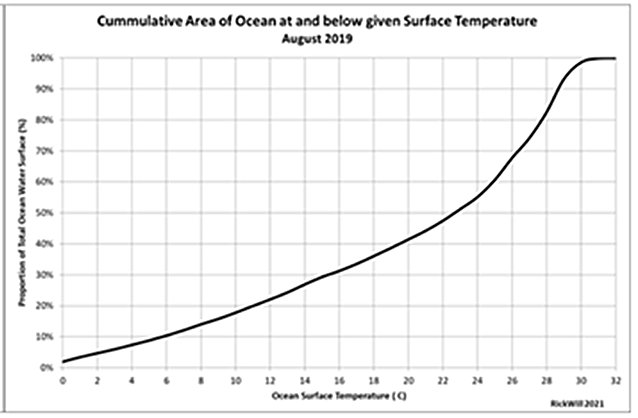

In der nachfolgenden Abbildung ist links die jahresdurchschnittliche Oberflächentemperatur der Ozeane dargestellt, also der Durchschnitt zwischen Tag und Nacht sowie Frühling, Sommer, Herbst und Winter – mit entgegengesetzten Jahreszeiten auf beiden Hemisphären, rechts die ozeanische Oberflächentemperatur im August 2019, also der Durchschnitt zwischen Tag und Nacht sowie der Nord- und der Südhalbkugel:

Abbildung 2: Die Ozeantemperaturen

Links: “Annual Mean Ocean Surface Temperature” based on observed data up until 1994 (NASA)

Rechts: „Area of ocean surface at a specific temperature as a proportion of the total ocean surface area and cumulative proportion by area at or below given surface temperature” im August 2019. Original von Richard Willoughby auf WUWT. Abbildungstext auf EIKE: Kumulative Fläche des Ozeans bei bestimmten Temperaturen, sie erreicht 100 % bei 30 Grad.

Zitat aus dem Text von Willoughby (dort Abbildung 4): “More than 50% of the ocean water surface exceeds 22C as shown in Figure 4 right panel while the peak proportion of area is in the range 28C to 29C but falls off sharply above 29C such that there is less than 1% of the ocean surface area warmer than 32C, left panel.”

(Google-Übersetzer: Mehr als 50 % der Ozeanwasseroberfläche überschreiten 22° C, wie […] rechts gezeigt, während der Spitzenanteil der Fläche im Bereich von 28° C bis 29° C liegt, aber über 29° C stark abfällt…).

Die hier in Abbildung 2 dargestellten Ozean-Temperaturen repräsentieren zwei Drittel der „gemessenen“ globalen Ortstemperaturen. Die mittlere jährliche Oberflächentemperatur der Ozeane liegt zwischen -5°C und 30°C; ein globaler Durchschnitt dürfte in etwa bei der NST von etwa 15°C kumulieren. Diese Wärmespeicher verlieren über den 24h-Tag „nur sehr wenig“ Energie und müssen deshalb auf der Tagseite lediglich „nachgefüllt“ werden (hier letzte Abbildung), mehr nicht. Im Mittel sprechen wir hier aktuell von 1,05*10^22 Joule, die die Erde über den durchschnittlichen 24h-Tag netto erhält und auch wieder abstrahlt. Denn sonst wäre die sogenannte „gemessene“ globale Durchschnittstemperatur (NST) nicht einigermaßen stabil. Dagegen enthalten die Ozeane nach vorsichtiger Schätzung eine Wärmemenge von mehr als 4,59*10^26 Joule, sodass dort der Verlust durch eine reduzierte Sonneneinstrahlung zunächst kaum ins Gewicht fällt. Die nachstehende Abbildung beschreibt den Verlauf von Energiehaushalt und Temperatur in Abhängigkeit von der geographischen Breite:

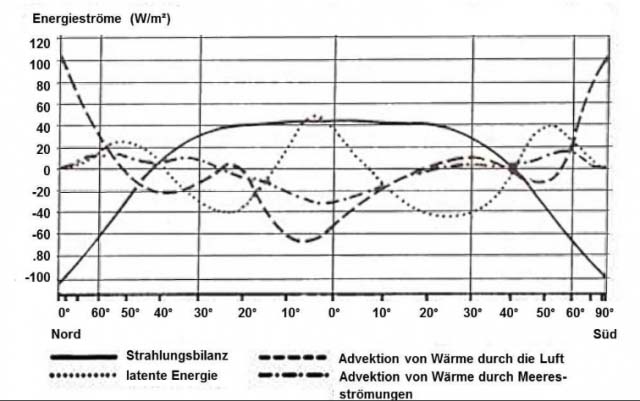

Abbildung 3: Energiehaushalt und Temperatur in Abhängigkeit von der geographischen Breite

Links: Jahresmittel des Energiehaushaltes der Atmosphäre und seiner Komponenten in Abhängigkeit von der geographischen Breite. Die hier dargestellten Energieströme summieren sich für eine feste geographische Breite im durchschnittlichen Jahresmittel gerade auf null.

Quelle: HÄCKEL, Meteorologie, Verlag Eugen Ulmer, Stuttgart 1990

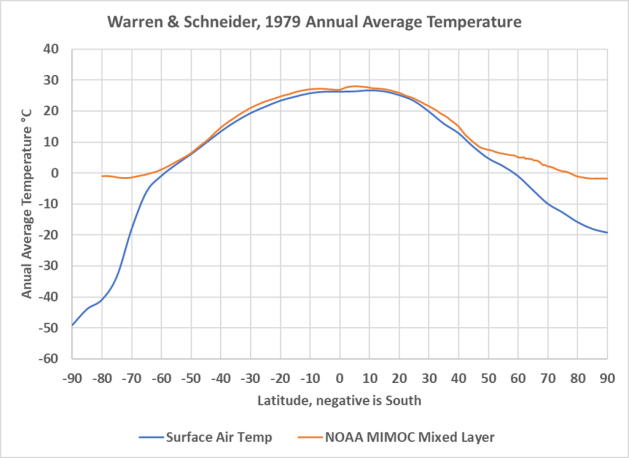

Rechts: Temperatur in Abhängigkeit von der geographischen Breite. Die blaue Linie ist die Oberflächenlufttemperatur von Warren und Schneider nach Breitengrad, die orangefarbene Linie ist der Durchschnitt der NOAA-MIMOC-Ozean-Mischschichttemperatur nach Breitengrad.

Quelle: Andy May (Abbildung 2 im Original, deutsche Übersetzung auf EIKE)

Maßstab für die Betrachtung der terrestrischen Temperaturgenese ist also der Wärmeinhalt der globalen Zirkulationen mit Temperaturen um die sogenannte „gemessene globale Durchschnittstemperatur“ (NST). Dagegen legt der konventionelle THE-Tag=Nacht-Ansatz für die Nachtseite unserer Erde eine Temperatur von 0 Kelvin zugrunde, was wiederum einen zusätzlichen „natürlichen atmosphärischen Treibhauseffekt“ von 33°C erfordert, um die „gemessene“ NST zu erklären. Nach Andy May folgt die Oberflächenlufttemperatur von Warren und Schneider in niederen bis mittleren Breiten zwischen etwa 55° S bis 45° N ziemlich gut der NOAA-Mischschichttemperatur, südlich und nördlich dieser Breiten zu den Polen hin sind die Meerestemperaturen aber viel höher als die Lufttemperaturen. Die Lufttemperaturen repräsentieren also eher den örtlichen Verlauf des (um Konvektion und Verdunstung reduzierten) S-B-Temperaturäquivalentes aus der solaren Einstrahlung, deren durchschnittlicher globaler Mittelwert nach Häckel jenseits von ca. 45° nördlicher und südlicher Breite negative Werte annimmt. Dagegen leiten sich die Meerestemperaturen aus der konvektiven geographischen Verteilung der in den Ozeanen gespeicherten Energiemenge her. Auf der Nordhalbkugel spalten sich Lufttemperatur und Mixed Layer Temperatur nach Warren&Schneider ziemlich genau im Bereich der 0-Linie der Strahlungsbilanz von Häckel auf, auf der Südhalbkugel ist diese Übereinstimmung nicht ganz so deutlich.

Wir können aus Abbildung 3 (links) jedenfalls herleiten, dass sich die Überschüsse und Defizite gegenüber dem hemisphärisch berechneten S-B-Temperaturäquivalent im Normalfall durch den lateralen Transport von Wärme global gerade ausgleichen. Positive und negative örtliche Differenzen zwischen den gemessenen Temperaturen und dem rechnerischen S-B-Temperaturäquivalent der spezifischen solaren Einstrahlung werden also durch laterale Ausgleichsbewegungen von Wärme über die geographischen Breitenkreise hinweg ausgeglichen. Im Falle des Tambora-Ausbruchs verringert sich nun schlagartig die solare Einstrahlung und reduziert damit in globalem Maßstab die örtliche Maximaltemperatur. Da der Energieinhalt der Ozeane aber bereits vorher gespeichert worden war, wird daraus jetzt weiterhin die örtliche Minimaltemperatur gestützt. Die für die terrestrische Temperaturgenese verfügbare Sonneneinstrahlung wird allein von der Solarkonstanten (So=1.367W/m²) und der Albedo unserer Erde bestimmt:

(S0 – S0*ALBEDO +/- S0*DELTA ALBEDO)@PIR² = (Merw + Evap + Konv)@2PIR²

mit Merw Erwärmung von Materie

Evap Verdunstung

Konv Konvektion

unter Vernachlässigung des Bodenwärmeflusses

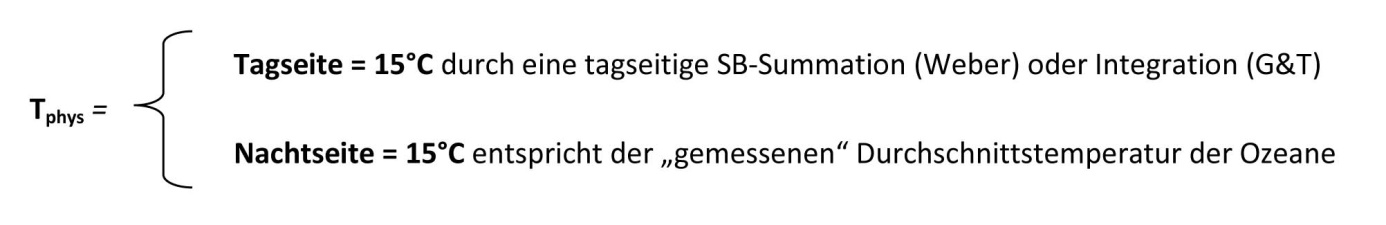

Die Temperatur unserer Erde beträgt bei einer Albedo von 30,6%:

Die Temperatur unserer Erde beträgt bei einer Albedo von 30,6%:

Dabei handelt es sich bei der Temperatur der Tagseite um die primäre Wirkung der solaren Strahlungsleistung auf der Tagseite der Erde. Die Temperatur der Nachtseite unserer Erde ist dagegen den terrestrischen Wärmespeichern geschuldet, insbesondere den Ozeanen. Die Abstrahlungsleistung eines Körpers mit einer Temperatur größer 0 Kelvin steigt proportional zur 4. Potenz seiner Temperatur. Im eingeschwungenen Zustand des Systems Erde müssen sich daher bei konstanter Temperatur Ein- und Abstrahlung gerade entsprechen. In diesem Fall sind nämlich die Wärmespeicher voll aufgeladen, und es müssen nur noch die Abstrahlungsverluste ersetzt werden. Bemessungsgrundlage für die Nachttemperatur unserer Erde ist also nicht etwa der Absolute Nullpunkt von -273°C, wie im konventionellen THE-Tag=Nacht-Ansatz, sondern die Temperatur der globalen Wärmespeicher.

Im Fall des Tambora-Ausbruchs hatte sich die terrestrische Albedo schlagartig um einen Betrag „+DELTA ALBEDO“ erhöht, wodurch sich die Maximaltemperatur um (– Δ T) verringert hatte. Die Albedo der Erde steigt also nach einem Vulkanausbruch mit einem VEI größer gleich 6 (VEI=Vulkanexplosivitätsindex, Tambora=7, Krakatau=6) für einen begrenzten Zeitraum an, sodass der 24h-tägliche Abstrahlungsverlust unserer Erde bei zunächst unveränderter Temperatur der Wärmespeicher nicht mehr ausreichend durch die solare Einstrahlung ersetzt werden kann, weil sich die Maximaltemperatur sofort an das neue Einstrahlungsniveau anpasst:

Tagseite: Tphys = 15°C – Δ T

Die maximale Tagestemperatur sinkt also sofort, aber die globalen Zirkulationen besitzen noch ihren gespeicherten Energieinhalt aus der solaren Einstrahlung vor dem Tambora-Ereignis und stützen damit weiterhin die Minimaltemperaturen. Wenn sich die temperaturwirksame Strahlungsleistung verringert, dann passt sich der Wärmeinhalt der globalen Zirkulationen also nicht sofort an das niedrigere Temperaturniveau an, sondern benötigt nach der Arbeit von Usoskin et al. (2004/2005) einen Zeitraum von etwa 10 Jahren für eine solche Anpassung. So lange hatte die globale Verdunklung nach dem Tambora-Ausbruch allerdings gar nicht gedauert, vielmehr steigt ab ca. 1820 das gleitende 10-Jahres-Mittel in Abbildung 1 bereits wieder deutlich an. Der Wärmeüberschuss in den globalen Zirkulationen gegenüber der plötzlich gesunkenen maximalen Tagestemperatur nach dem Tambora-Ausbruch stützt also die globale Minimaltemperatur. Wir können uns einen solchen Ablauf anhand der nachfolgenden Abbildung verdeutlichen:

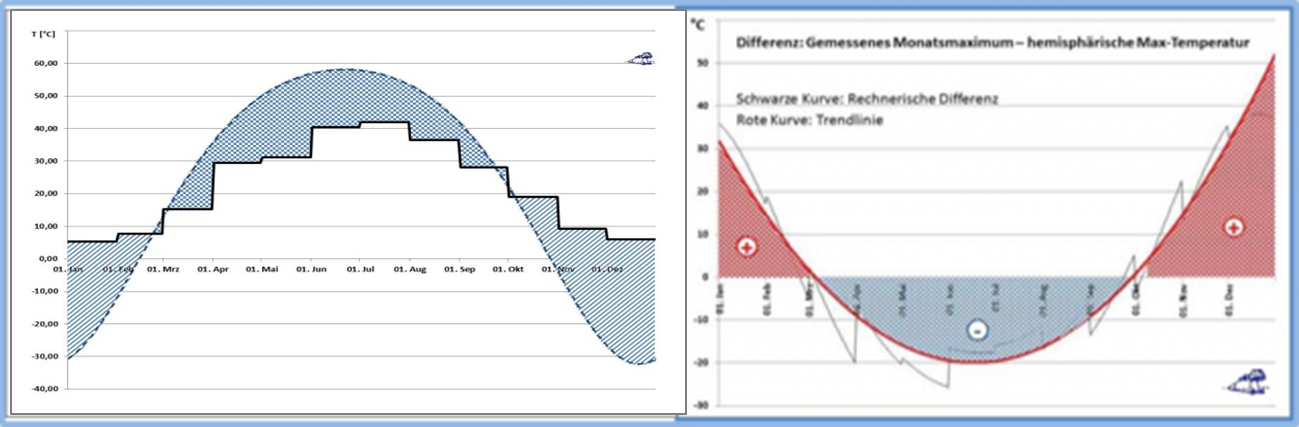

Abbildung 4: Jahresverlauf der Temperatur am Beispiel Potsdam

Abbildung 4: Jahresverlauf der Temperatur am Beispiel Potsdam

Links: Treppenkurve: Maximale monatliche Bodentemperatur in Potsdam Jahre 1890-2013

Blau gestrichelt: Maximales jahreszeitliches S-B-Temperaturäquivalent

Rechts: Differenz zwischen der maximalen monatliche Bodentemperatur in Potsdam und dem maximalen örtlichen S-B-Temperaturäquivalent

Rote Kurve: Trendlinie für die Differenz (schwarze Zackenkurve) zwischen maximaler monatlicher Bodentemperatur und dem maximalen örtlichen S-B-Temperaturäquivalent in Potsdam

Rot schraffiert: Zufluss von Wärme im Winterhalbjahr

Blau schraffiert: Abfluss von Wärme im Sommerhalbjahr

Daten von: https://www.pik-potsdam.de/services/klima-wetter-potsdam/wetterextreme

Anmerkung: Die S-B Gleichgewichtstemperatur im solaren Zenit wurde jahreszeitabhängig unter Berücksichtigung der durchschnittlichen Albedo mit netto 780 W/m² berechnet (Weber @DGG 2019)

Im linken Bild übersteigt das rechnerische S-B-Äquivalent der spezifischen solaren Strahlungsleistung im Frühjahr und Sommer (mittlerer Abschnitt) die tatsächlich gemessene Maximaltemperatur. Die „überschüssige“ Strahlungsleistung wird in Form von Konvektion und Verdunstung abgeführt. Im Herbst und Winter (rechts und links) dagegen, wo die spezifische solare Strahlungsleistung für die tatsächlich gemessene Maximaltemperatur nicht ausreicht, findet ein Zufluss von Energie aus den globalen Zirkulationen statt. Im Sommerhalbjahr fließt also Wärmeenergie in die globalen Wärmespeicher und im Winterhalbjahr wird die Ortstemperatur durch einen Wärmezufluss aus diesen Wärmespeichern gestützt. In sehr viel kleinerem Maßstab geschieht ein solcher Temperaturausgleich auch zwischen der Tages- und der Nachttemperatur, es sei hier beispielsweise an den Absatz „Das Land-Seewind-System als Funktionsbeispiel für die globalen Zirkulationen“ erinnert. Wir stellen also ganz einfach fest, dass sich im „Jahr ohne Sommer“ in erster Näherung sowohl die solare Einstrahlung als auch die Temperatur der individuellen Ortslagen reduziert hatte. Und damit hatte sich auch der blau schraffierte Abfluss von Wärme in die globalen Zirkulationen reduziert, während der rot schraffierte Zufluss von Wärme aus den globalen Zirkulationen zunächst weitgehend stabil geblieben sein muss.

Nach den Ausbrüchen von Tambora und Krakatau hatten sich durch die Aschewolke in der hohen Atmosphäre also die Spitzen der örtlichen Tagestemperaturen deutlich reduziert. Die nächtlichen Minimaltemperaturen konnte das Klimasystem unserer Erde dagegen aufgrund der gefüllten ozeanischen Wärmespeicher weiterhin aufrechterhalten. Und diese Erkenntnis ist wiederum ein schöner Beweis gegen einen „natürlichen atmosphärischen Treibhauseffekt“ und für mein hemisphärisches S-B-Modell.