Windflauten lösen Unruhe bei Energiekonzernen aus*

Dagmar Jestrzemski (Red. PAZ)*

Immer mehr Windräder, aber weniger Wind –

Könnte eine hohe Konzentration an Windparks zu den in vielen Ländern verzeichneten „Winddürren“ führen?

====================================================

Nach mehreren Dürrejahren in Folge regnete es 2021 in großen Teilen Deutschlands wieder reichlich. Zumindest die oberen Bodenschichten waren gut durchfeuchtet. Zugleich wurde für Deutschland die geringste Sonnenscheindauer seit langer Zeit registriert.

In anderen Teilen Europas hat jedoch die Dürre im vierten Jahr in Folge drastische Ausmaße angenommen, so in Großbritannien und Irland. Ursache war ein außergewöhnlich langes statisches Hochdruckgebiet zwischen Island und Schottland von April bis Anfang Oktober. Die damit einhergehende Dürre und Flaute wurde als die schwächste Windphase seit 60 Jahren bezeichnet. Die Windenergie-Firmen RWE und Ørsted gaben eine Warnung heraus. Auch die Stromerzeugung durch Wasserkraft fiel laut SSE (Scottish and Southern Energy) um 32 Prozent niedriger aus als erwartet.

In mehreren Online-Magazinen wurde über mögliche Ursachen der in den vergangenen Jahren weltweit gehäuft aufgetretenen sogenannten Omega-Hochdruckgebiete spekuliert. Erörtert wurde die Interaktion zwischen dem dynamischen System von Atmosphäre und Ozean und dessen Auswirkung auf das Wettergeschehen.

Im aktuellen Fall war jedoch kein Zusammenhang mit einer derartigen Konstellation erkennbar. Jedenfalls würden die monatelangen „Winddürren“ veranschaulichen, dass die Erneuerbaren Energien auf Vermutungen basieren, „wie die Welt funktioniert“, befand das Online-Politikmagazin slate.com. Die Welt würde gerade aus ihrer Balance geworfen.

Eine Nachwuchsforscherin im Bereich der Klimarisikoforschung, Hannah Bloomfield von der Universität Bristol, präsentierte im Magazin Energypost.eu („Die besten Denker über Energie“) weitergehende Schlussfolgerungen als in der der Windindustrie zugeneigten Wissenschaftsgemeinschaft üblich. Mit ihrem Team habe sie aufgezeigt, dass die stagnierenden Hochdruckgebiete über Zen-traleuropa und monatelangen Schwachwindphasen zu einem Problem für die zukünftigen Energiesysteme werden könnten. Die letzte lange Windflaute sei eine Mahnung, wie veränderlich diese Art der Energieerzeugung sei und dass Windenergie nicht die einzige Investition für eine verlässliche zukünftige Energieversorgung sein könne.

Bloomfield gibt zu bedenken: Die beobachtete abnehmende Geschwindigkeit des oberflächennahen Windes könnte auf das Phänomen „Global Stilling“ (global abnehmende Windgeschwindigkeiten) zurückzuführen sein, das am auffälligsten in den mittleren nördlichen Breiten Europas und Nordamerikas sowie in Teilen Asiens in Erscheinung tritt. Die Ursachen sind bisher nicht eindeutig feststellbar. Jedoch scheint es in der Forschung eine Übereinkunft darüber zu geben, dass ein Zusammenhang mit dem Klimawandel besteht.

Auffällige Flauten in Windparknähe

Seit den 1970er Jahren hat die Windgeschwindigkeit weltweit pro Dekade im Durchschnitt um 0,5 Kilometer in der Stunde abgenommen. Noch weitaus gravierender dürfte dies in Europa der Fall sein. Der letzte Bericht des Weltklimarats (IPCC) sagt für Europa eine weitere Abnahme der Windgeschwindigkeit um acht bis zehn Prozent voraus. Nach Erkenntnissen einer von der EU in Auftrag gegebenen Großstudie würde eine langfristige Fortsetzung des „Stilling“ die Gesellschaften substanziell gefährden.

Bereits 2018 und 2019 war die Ursache für das ungewöhnlich langanhaltende Sommerwetter über Europa und andere Regionen der Nordhalbkugel eine Abfolge von stabilen, sich ständig erneuernden Hochdruckgebieten. Ein solches Blockadewetter mit einer langen Schwachwindphase herrschte auch in Nordamerika großräumig ab Mitte 2018 und etwas abgeschwächt bis Ende 2019.

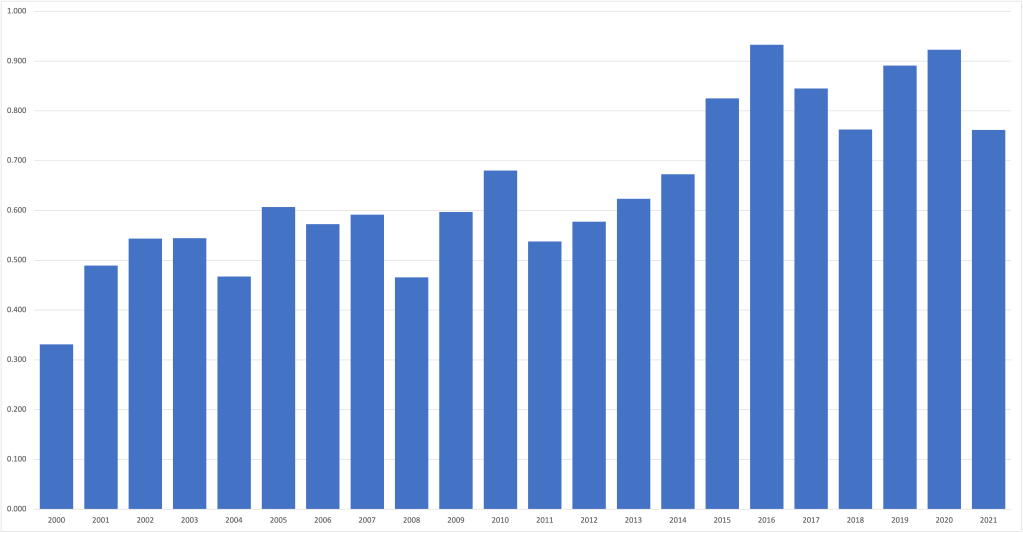

Trotz eines massiven Zubaus der Windstromkapazität um zehn Prozent innerhalb dieses Zeitraums generierten die US-Windparks 2019 nur 4,3 Prozent mehr Strom als im Vorjahr. In der westlichen Hälfte und in den zentralen US-Bundesstaaten herrschte zuvor bereits von Juni 2013 bis Mitte 2015 und nochmals 2016 die schwerste und längste „Winddürre“ seit den 60er Jahren. Die meisten Meteorologen glaubten, das Extremwetter sei zumindest teilweise auf die Pazifische Dekaden-Oszillation zurückzuführen, eine abrupte Änderung der Oberflächentemperatur im nördlichen Pazifik.

Auffällig war jedoch, dass sich die Windflaute in Verbindung mit einer verheerenden Dürre am meisten in Staaten wie Texas, Oklahoma und Kansas auswirkte, wo die größten Windparks mit jeweils Tausenden von Windrädern konzentriert sind. Für die internationale Klimaforschung ergibt sich daraus die Notwendigkeit, dementsprechend endlich auch diesen Faktor in den Blick zu nehmen, was bislang nicht in Betracht kommt.

=================================================================

)* Anmerkung der EIKE-Redaktion :

Dieser Aufsatz ist zuerst erschienen in der Preußischen Allgemeinen Zeitung; 28. Januar 2022, S.7; EIKE dankt der PAZ-Redaktion sowie der Autorin Dagmar Jestrzemski für die Gestattung der ungekürzten Übernahme, wie schon bei früheren Artikeln : https://www.preussische-allgemeine.de/ ; Hervorhebungen im Text: EIKE-Redaktion.

=================================================================