Stefan Kämpfe

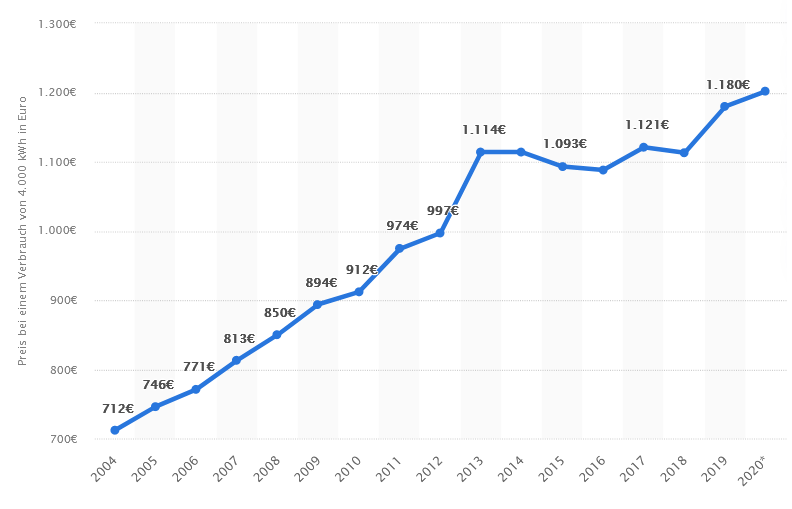

Als die sehr bekannte irische New-Wave-Band „The Boomtown Rats“ im Jahre 1978 ihren ersten Erfolgshit „Rat Trap“ (Rattenfalle) landete, war die Welt trotz der Öl- und Wirtschaftskrisen noch voller Optimismus, und mit den 1980er Jahren kehrten ja Wachstum und annähernde Vollbeschäftigung noch einmal zurück. Doch heute scheint die ganze Menschheit in einer Rattenfalle zu sitzen. Das hat wenig mit Corona zu tun, sondern zeichnete sich schon seit den 1990er Jahren ab – speziell in Europa und im Energiesektor. Der Autor dieses Beitrages erwartet zwar keinen baldigen Weltuntergang, hält es aber für notwendig, die immensen Probleme anzusprechen und zur Diskussion zu stellen. Denn ganz hoffnungslos ist die Lage nicht – aber dazu bedarf es einer realitätsnäheren Politik.

1. Trotz scheinbar großer Erfolge und viel Wissenszuwachs – stecken Forschung und Technik in der Sackgasse und gibt es eine Schallmauer für den Erkenntniszuwachs?

Nie gab es mehr Wissen und einen höheren Technisierungsgrad als momentan; das ist unstrittig. Auch der Wissenszuwachs war nie größer, als heute. Doch Flugzeuge, Autos, Raketen, Internet, Smartphones und immer schnellere Großrechner basieren allesamt auf Grundlagenwissen, welches mit überschaubarem Aufwand von meist wenigen, genialen Forschern vor mehreren Jahrzehnten bis Jahrhunderten erarbeitet wurde; diese Ära endete etwa so zwischen 1915 und den späten 1960er Jahren (Einstein, Heisenberg, Higgs).

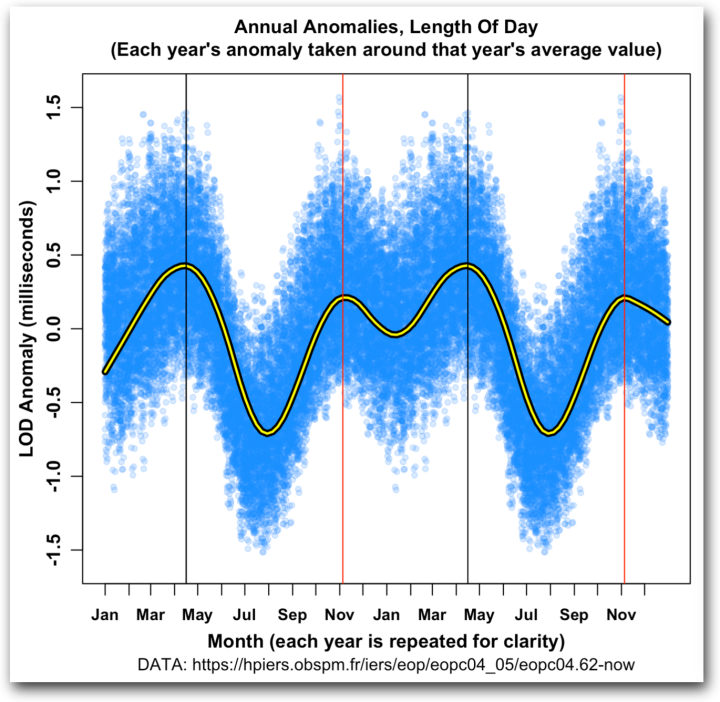

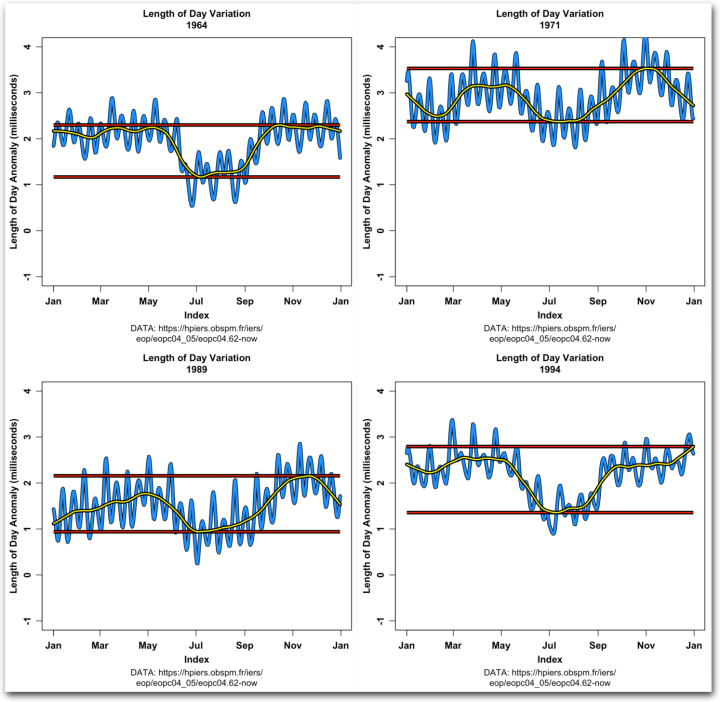

Ein Paradebeispiel ist die Wetter- und Klimavorhersage. Anfangs gab es dabei enorme Fortschritte, wobei die „Erfindung“ der Wetterkarte (Heinrich Wilhelm Brandes, Leipzig, um 1817), die Telegrafie, das Funk- und Flugwesen, immer leistungsfähigere Großrechner, und die satellitengestützte Beobachtungen (ab den 1960er Jahren) dabei große Entwicklungsschübe auslösten. Doch leider gibt es hierfür Grenzen. Es wird nie gelingen, mit auch noch so viel Aufwand eine auch nur halbwegs exakte Wetterprognose für einen bestimmten Ort für zehn oder gar zwanzig Tage im Voraus zu erstellen; schon für mehr als drei Tage ist das bei sehr vielen Wetterlagen schwierig. So auch an Weihnachten 2021, als es noch am Beginn der Weihnachtswoche unmöglich war, vorherzusagen, wo wann wieviel Schnee bei welchen Temperaturen an den Feiertagen fallen würde. Grund ist der Schmetterlingseffekt (englisch butterfly effect), ein Phänomen der Nichtlinearen Dynamik. Er tritt in nichtlinearen dynamischen, deterministischen Systemen auf und äußert sich dadurch, dass nicht vorhersehbar ist, wie sich beliebig kleine Änderungen der Anfangsbedingungen des Systems langfristig auf die Entwicklung des Systems auswirken.

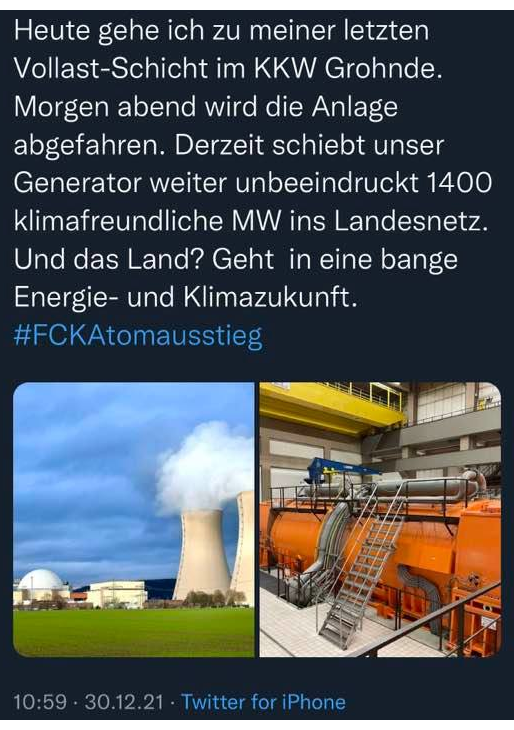

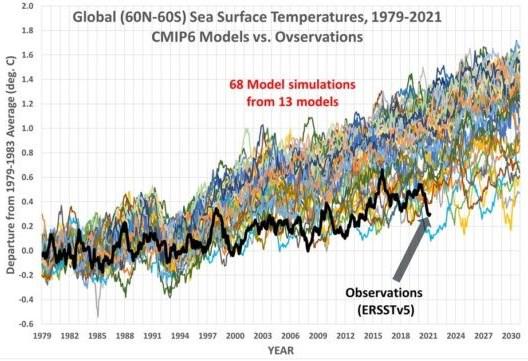

In der (langfristigen) Klimaprognose kommt die einseitige, politisch-ideologisch motivierte Fixierung auf CO2 hinzu; dabei wird der Einfluss der Wolkenbedeckung (Art und Menge der Wolken), der Sonnenaktivität und der Biosphäre bis heuer unzureichend oder fast gar nicht verstanden. Dementsprechend mangelhaft und fast stets übertrieben fallen die Klimaprognosen aus.

Abbildung 1: Während die meisten Modelle (farbig) für den Zeitraum 1979 bis 2021 eine starke Erwärmung von 0,6 bis 1,4°C berechneten, fiel die reale Erwärmung mit 0,2 bis 0,6°C kaum halb so stark aus, und im Jahr 2021 betrug sie kaum mehr als 0,2°C Bildquelle

Ein anderes Beispiel findet sich in der physikalischen Grundlagenforschung. So hat das CERN, die Europäische Organisation für Kernforschung, momentan etwa 3.400 Mitarbeiter, und über 14.000 Gastwissenschaftler aus 85 Nationen arbeiten an CERN-Experimenten. Das Jahresbudget des CERN belief sich 2014 auf ungefähr 1,11 Milliarden Schweizer Franken (ca. 1 Milliarde Euro). Ja, man fand dort neue Elementarteilchen, unter anderem das Higgs-Teilchen, welches beim tieferen physikalischen Verständnis der Masse aller Materie und Körper eine gewisse Rolle spielt. Aber verglichen mit den fundamentalen Erkenntnissen Einsteins, der erst nach der Veröffentlichung seiner speziellen Relativitätstheorie mit der berühmten Formel E=mc² Professor wurde und auch später nur relativ wenige Mitarbeiter hatte, muten diese Ergebnisse dürftig an; ihr künftiger Nutzen ist zwar nicht ausgeschlossen, aber sehr ungewiss.

Als Beispiel für die Krise der Technik sehen wir uns das Fliegen näher an. Es gibt drei grundlegende Prinzipien, um zu fliegen. Erstens leichter als Luft: Gebrüder Montgolfier (Heißluftballon, 1783) und Physikprofessor Jacques Alexandre César Charles (Wasserstoffballon, 1783). Der berühmte Graf Zeppelin entwickelte diese Technik um 1900 weiter; seine Zeppeline spielten militärisch (Erster Weltkrieg) und in der zivilen Luftfahrt der 1920er bis 1930er Jahre eine wesentliche Rolle. Zweitens schwerer als Luft nach dem Bernoulli-Effekt im weitesten Sinne (Propeller-, Düsen- und Segelflugzeuge, Hubschrauber). Als Erfinder (nicht ganz unstrittig) gelten die Gebrüder Wright (1903; sie waren ursprünglich als Drucker und Fahrradmechaniker tätig).

Und drittens schwerer als Luft, aber als Antrieb das Rückstoßprinzip, dass für den Flugkörper auf die umgebende Luft keine Rücksicht nehmen muss, oder, wie im Falle des Düsentriebwerks, nur den Sauerstoff der Luft aus Effizienzgründen verwendet, . Der revolutionäre Übergang vom Propeller- zum Düsenflugzeug (ab den späten 1930er Jahren) ist den Erfindern Hans Joachim Pabst von Ohain (Deutschland) sowie etwa zeitgleich Frank Whittle (Großbritannien) zu verdanken. Düsentriebwerke setzten sich zunächst beim Militär, ab etwa den 1960er Jahren auch in der zivilen Luftfahrt, durch. Und, daraus fortgeschrieben, das reine Rückstoßprinzip (Raketen).

Das Grundprinzip war ja seit der Erfindung des Schwarzpulvers und der ersten Feuerwerkskörper (China) bekannt. Doch sind Raketen derart schwer beherrschbar und komplex, dass der erste Flugapparat, Wernher von Brauns Aggregat 4, besser bekannt als V2, erst nach massiver Unterstützung durch die Nazis 1942 vermutlich das Weltall tangierte. Im Gegensatz zu den beiden ersten Flugprinzipien, war der Aufwand zur Entwicklung der weltraumfähigen Raketentechnik schon anfangs sehr hoch; doch er gipfelte vermutlich im Apollo-Programm, für welches zeitweise etwa 400.000 Mitarbeiter tätig waren.

Aber wo stehen wir heute?

Das Ballon-Prinzip ist seit der Hindenburg-Katastrophe (Lakehurst, 1937) nur noch eine Nischentechnik (Wetterballone, Rundflüge, mitunter Geofernerkundung und Spezialtechniken). Dem Flugzeug blieb, zumindest in der zivilen Luftfahrt, seit dem tragischen Unfall der Concorde (2000) nur der Unterschallbereich – man fliegt heuer etwa so schnell, wie schon in den 1970er Jahren. Und die nicht erst seit dem 11. September 2001 massiv zunehmende Terrorgefahr verteuerte und verkomplizierte die Fliegerei nicht unwesentlich. Dank der oft überbewerteten Raketentechnik und Weltraumfahrt gelangten bisher gerade mal 12 (!) Menschen auf den uns nächstgelegenen Himmelskörper, den Mond – der letzte 1972. Das Space-Shuttle-Programm wurde wegen ausufernder Kosten und zweier tragischer Unfälle (Challenger, Columbia) nach 2010 eingestellt; ohnehin taugte es nur für den erdnahen Raum. Immerhin bescherte uns die Raumfahrt außer enormen Kosten auch merkliche Fortschritte in der Kommunikationstechnik, Navigation und Erderkundung (Internet, Satellitenfernsehen, GPS, ISS, Erkennung und Erforschung von Umweltschäden, Wetterbeobachtung).

Doch neuerdings ziehen auch über den Satelliten und der ISS dunkle Wolken auf. Man hatte seit den Anfangsjahren der Raumfahrt kein Konzept zur Entfernung ausgedienter Raketen und Raketenstufen, Satelliten und von Restmüll aus dem Erdorbit, welche mit etwa 8 Km/s durch das All rasen und ein enormes Zerstörungspotential haben. Dieser Müll erfordert schon jetzt riskante, teure Ausweichmanöver für Satelliten und die ISS. Nur mit enormen finanziellen und logistischen Aufwendungen ließe sich der Müll entfernen; doch unterlässt man es, könnte der erdnahe Weltraum schon bald zu gefährlich für weitere Missionen werden, und viele Satelliten würden zerstört. Ähnlich, wie bei den Flugzeugen, ist der auf chemischer Energie basierende Raketenantrieb längst ausgereizt, für Reisen zu anderen Planeten zu ineffizient und zu langsam; die Russen fliegen immer noch mit der zwar zuverlässigen, aber total veralteten Sojus-Technik; auch die Amerikaner planen für ihre bevorstehenden Mond- und Marsmission mit dieser Technik.

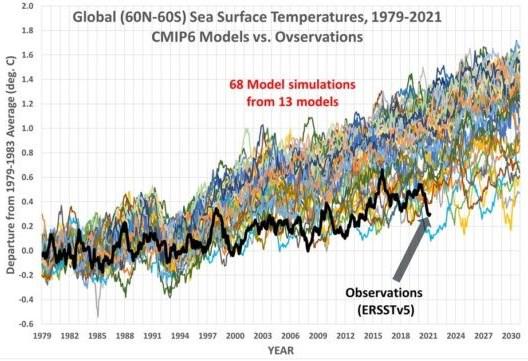

An neuen Antrieben wird geforscht, aber außer dem Ionenantrieb, der aber nur für Raumsonden oder Satelliten taugt, gibt es keine in technisch machbarer Reichweite befindlichen Verfahren. Ähnliches ließe sich auch über unsere Autos und Züge sagen – seit Jahrzehnten keine oder nur geringe Fortschritte. Es scheint, als folgten Wissenschaft und Technik folgender Gesetzmäßigkeit:

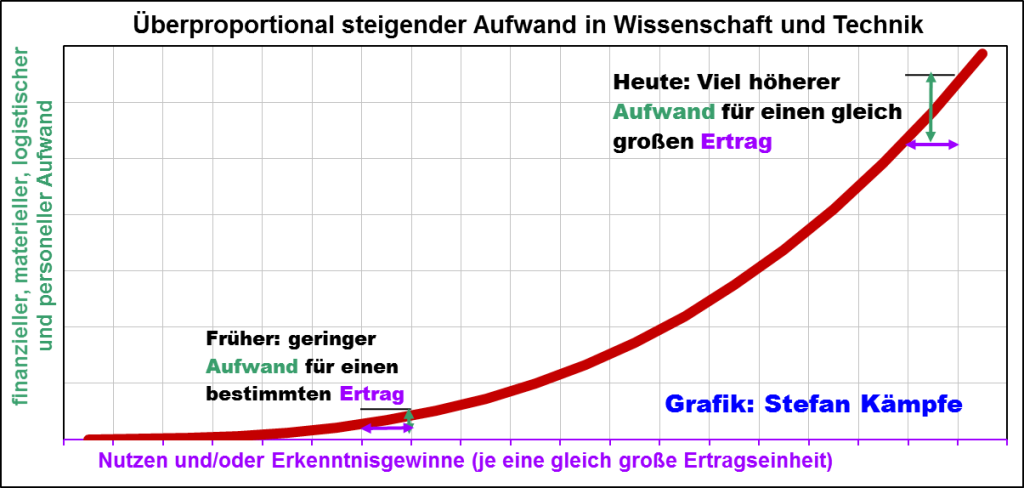

Um heute einen etwa gleich großen quantitativen oder qualitativen Fortschritt (Ertrag im weitesten Sinne) zu erzielen, müssen überproportional steigende Aufwendungen betrieben werden.

Abbildung 2: Überproportional steigende Aufwendungen für denselben Ertrag in Wissenschaft und Technik (schematisch). Für den gleichen Ertrag musste man in der Anfangszeit von Wissenschaft und Technik (links auf der waagerechten Ordinate) viel weniger Ressourcen einsetzen, als heute (rechts).

Es bestehen hier freilich erhebliche Unterschiede zwischen den einzelnen Wissenschafts- und Technikgebieten; trotzdem nähern wir uns immer mehr einer Art Schallmauer: Erkenntnisse sind immer schwerer zu gewinnen und in praxistaugliche Technik umzusetzen. Außerdem spielen gesellschaftliche Gegebenheiten eine wesentliche Rolle. In Deutschland mit seiner überbordenden Bürokratie, seinem komplizierten Steuer- und Rechtssystem und seiner zunehmend technik- und wissenschaftsfeindlichen Bevölkerung (Kern- und Gentechnik!) ist es sicher schwieriger und teurer, bahnbrechende Neuerungen zu entwickeln, als in aufstrebenden Nationen. Und gerade für eine zunehmend überalternde Gesellschaft, wie die deutsche, ist die überproportionale Aufwandsentwicklung ein zunehmendes Problem – jedem neuen Projekt droht zunehmender Personalmangel. Ob Robotik und künstliche Intelligenz hier Abhilfe schaffen können, ist ungewiss. Um Missverständnissen vorzubeugen – Forschung soll nicht in Frage gestellt werden. Aber sie ist zunehmend nur unter einer Voraussetzung möglich: Wohlstand und Produktivität müssen weiter wachsen, um die dafür benötigten Ressourcen zu erwirtschaften – womit wir beim Thema der Energieversorgung wären.

2. Die aktuelle Energiekrise ist hausgemacht und bedroht den allgemeinen Wohlstand

Sowohl bei der Entwicklung der Einwohnerzahlen, aber auch bei der des Pro-Kopf-Einkommens und des allgemeinen Wohlstands, zeigten sich bis ins frühe 19. Jahrhundert nur geringe Zuwächse. Ganz wenigen, reichen Herrschern standen stets nur einige mehr oder weniger wohlhabende Menschen (meist niederer Adel, Ritter, Kaufleute, hohe Beamte, seit der frühen Neuzeit auch einige Unternehmer und Wissenschaftler) gegenüber, aber mehr als 80% der Bevölkerung lebten am Existenzminimum. Als Ursache hierfür wird in der Geschichtsschreibung stets auf die gesellschaftlichen Verhältnisse verwiesen (Sklavenhalterei, Feudalismus und Kapitalismus). Dann hätte es ja in unserer aktuellen Gesellschaftsordnung, immer noch dem Kapitalismus, so weitergehen müssen.

Es hat auch wenig mit Demokratisierung zu tun, denn auch nach der Unabhängigkeit der USA oder der Französischen Revolution gab es zwar mehr Mitspracherechte für Teile der Bevölkerung, aber die Massenarmut blieb, während in manchen Diktaturen (Nazi-Deutschland der 1930er Jahre, DDR) ein, wenn auch sehr bescheidener, Wohlstand für breite Bevölkerungskreise herrschte.

Der wahre Grund ist – Energie. Erst, als die nur aufwendig zu gewinnenden, oft nur begrenzt verfügbaren und energetisch nicht sehr dichten Energieträger Arbeitspferde, Wind, Wasserkraft und Holz durch Energieträger hoher Dichte wie Kohle, Erdöl, Erdgas und Kernkraft ersetzt wurden, stieg die Produktivität; schwere körperliche Arbeit konnte mechanisiert werden; Nahrungsmittel und Waren des täglichen Bedarfs wurden preiswerter, verfügbarer – sie konnten nun mit bezahlbarem Aufwand weltweit geliefert werden, weil Dampf- und Motorschiffe, Eisenbahnen und Lastautos viel mehr Güter je Zeiteinheit bewegen konnten, als es Segelschiffe und Pferdefuhrwerke je vermocht hätten. Diese „Energierevolution“ bewirkte mittels preiswerter Energie sowie Kunstdünger und Mechanisierung der Landwirtschaft eine massive Verbilligung von Grundnahrungsmitteln, was vor allem ärmeren Bevölkerungsschichten zugutekam, weil der Kostenanteil für die Lebenshaltung sank.

Aber seit der Ökologismus ab den späten 1970er Jahren nach und nach an die politische Macht drängte, wurden die Forderungen zu einer Rückkehr der alten Energieträger lauter. Das schien auch logisch, denn die Nutzung der Windenergie wurde im Vergleich zur alten Getreide-Windmühle viel effizienter; zudem stand mit der Solarenergie eine moderne, neue Technik zur Verfügung; und was dann noch an Energie fehlte, sollte Biomasse (der Acker als Bohrloch) liefern. Außerdem könne man ja überschüssige Wind- und Solarenergie speichern – für Flauten und trübe Zeiten. Leider übersah man dabei vier wesentliche Gegebenheiten – die trotz enormer, technischer Verbesserungen viel zu geringe Energiedichte dieser so genannten „Erneuerbaren“ oder „grünen“ Energien, die enormen Energieverluste der Speichertechniken, die Begrenztheit der Windenergie (die Anlagen nehmen sich gegenseitig den Wind) und die Umweltschäden, welche leider auch diese Energiequellen massiv verursachen. Bezüglich der Effizienz sieht das so aus:

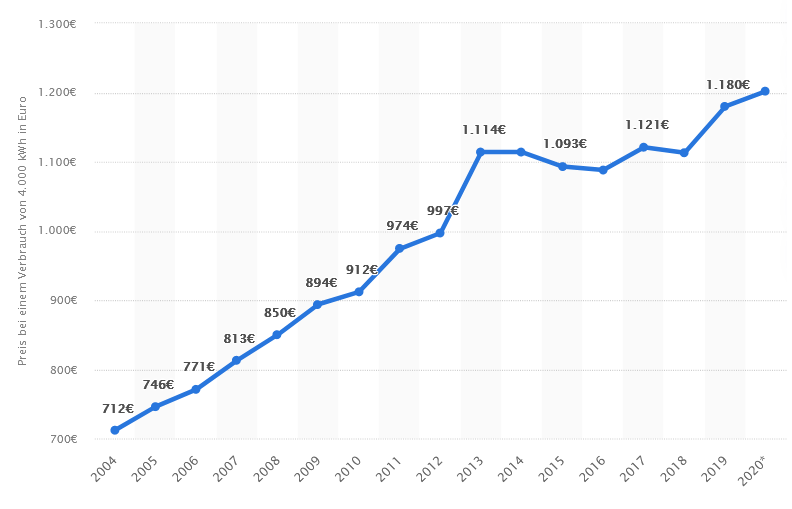

Abbildung 3: Der Nutzen der Energieträger im Vergleich zum Aufwand wird oft als „Erntefaktor“ oder EROI (Energy Return on Invest oder energy recovered over invested energy) angegeben. Bildquelle hier

Wie Abbildung 3 zeigt wird die Effizienz der Energieträger oft als „Erntefaktor“ oder EROI (Energy Return on Invest oder energy recovered over invested energy) angegeben. Sie ist das Verhältnis, wie viel Energie benötigt wird, um eine gegebene Energiemenge in eine gewünschte Energieform, etwa Strom, zu wandeln (produzierte zur für die Produktion eingesetzten Energie). Sie hängt nicht unwesentlich von dem potentiellen Energiegehalt des jeweiligen Energieträgers ab (eine gleich große Masse Mais enthält weniger Energie als die gleiche Menge Kohle oder gar Uran). Wind schneidet vergleichsweise schlecht ab, weil er als bewegte Luft (ein Medium mit geringer Dichte) trotz mitunter hoher Windgeschwindigkeiten viel weniger kinetische Energie liefert, als zum Beispiel Wasser, das eine viel höhere Dichte aufweist. Bei der Photovoltaik ist erstens die Bestrahlungsdichte zu gering, um mit vertretbarem Flächenaufwand sehr große Energiemengen zu erzeugen, und zweitens werden auch nur 10 bis 15% der Solarstrahlung in Strom umgewandelt – der „Rest“ von über 80% wird zu Wärme und heizt das Klima auf.

Auch das Umwandlungsverfahren ist wichtig: Weil Kohle, Gas und Kernkraft erst zu Wärme, die dann Dampfturbinen antreibt, umgewandelt wird, kann ihr sehr hoher Energiegehalt nicht besser genutzt werden (bei der sehr günstigen, aber in Europa fast ausgereizten Wasserkraft wird der Strom, ebenso wie bei der Windenergie, direkt aus der Bewegungsenergie gewonnen). Ebenso spielt die Art und Weise der Anlagen eine Rolle (Materialeinsatz, Nutzungsdauer, Logistik, Störanfälligkeit, Betrieb und Wartung). Weil aus Gründen der Netzstabilität Stromproduktion und –verbrauch stets annähernd übereinstimmen müssen, können nur stetig verfügbare Energieträger (Gas, Kohle, Biomasse, Kernkraft), die gleichmäßig Strom erzeugen, das Netz ohne Puffer stabil halten. Alle anderen benötigen hierfür Puffer (oft auch „Backups“ genannt), welche aber, egal ob als Batterie-, Wasserstoff- oder sonstige Speicher, oder als konventionelles Kraftwerk, das im Falle des Mangels einspringt, den Erntefaktor verringern, da sie zusätzlichen Aufwand erfordern (gelbe Säulen).

Eine andere, in der Abbildung nicht enthaltene „Erneuerbare“ Energiequelle ist die Geothermie. Hier schwanken jedoch die Erntefaktoren je nach Standort der Anlage extrem stark, und diese Technik ist mit großen Risiken verbunden; es kann zu enormen Folgeschäden kommen – siehe hier.

Wer die obige Abbildung 3 aufmerksam studiert, ahnt es schon: Fast alle „Erneuerbaren“ liefern nur dann genügend Strom, wenn dafür riesige Flächen verbraucht werden, der dann über ein noch zu bauendes, umweltschädliches, schwer beherrschbares Leitungs- und Transformationsnetz zum oft weit entfernten Verbraucher unter Verlusten (Widerstand) zu transportieren ist; zudem müssen noch sehr teure, nur umweltschädlich zu gewinnende Materialien (oft „Seltene“ Erden) für ihre Errichtung importiert werden; sie sind extrem ertragsschwankend (Witterung), ihr Verschleiß und der Wartungsaufwand sind, weil sie im Freien stehen müssen, viel höher, als bei konventionellen Kraftwerken. Bis heute gibt es, trotz aller Forschungsmilliarden, kein für Mitteleuropa akzeptables Speichermedium, welches Strom über längere Zeit zu ökonomisch, ökologisch und wirtschaftlich akzeptablen Bedingungen konservieren könnte.

Der von unserer rot-gelb-grünen Ampelregierung favorisierte Wasserstoff wird da auch keine Wunder bewirken. Er wird durch Elektrolyse erzeugt (Strom spaltet Wasser in Sauerstoff und Wasserstoff). Aber dabei gehen etwa 20 bis 40% der eingesetzten Elektroenergie „verloren“ – eine Strommenge von 100 KWh erzeugt eine Wasserstoffmenge, welche nur noch etwa 60 bis 80KWh der eingesetzten Energie enthält.

Diese geringe Effizienz lässt sich aus physikalischen Gründen (Hauptsätze der Energieerhaltung beziehungsweise der Thermodynamik) auch niemals auf nur annähernd 100% steigern; für alle anderen Speichermedien (Batterien, Pumpspeicherkraftwerke, Druckluftspeicher…) gilt das auch. Aber der Wasserstoff, ein sehr leichtes, gefährliches, hoch entzündliches Gas, muss für Lagerung und Transport stark verdichtet und gekühlt werden; dabei entstehen weitere Energieverluste. Und zum Schluss muss er ja wieder in Strom verwandelt werden – das „kostet“ in Brennstoffzellen erneut 20 bis 40% Energieverlust, bei der Verbrennung in einem Gaskraftwerk sogar 40 bis 50%! Der gesamte Wandlungszyklus Strom-Wasserstoff-Strom lässt also von der ursprünglich eingesetzten Energie meist deutlich weniger als die Hälfte übrig. In der Praxis sind diese Bilanzen meist noch viel schlechter, weil dort, anders als im Forschungslabor, unter anderem Wartung und Verschleiß der Anlagen ertragsmindernd wirken. Details dazu hier.

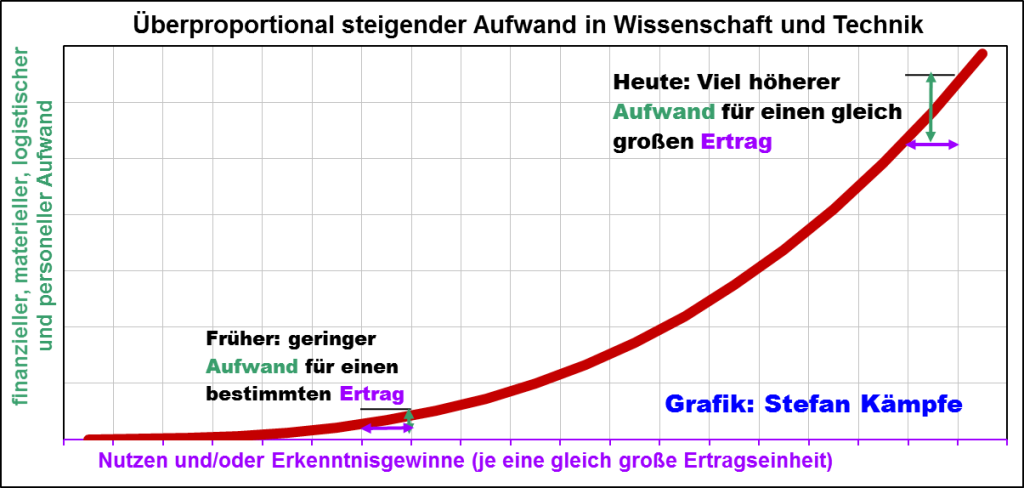

Der Begriff „Energiewende“ ist übrigens irreführend – er bezieht sich bislang fast ausschließlich auf Strom. Für Heizen, Industrie und Verkehr wird nach wie vor überwiegend konventionelle (fossile) Energie benötigt. Diese soll aber – geht es nach der Politik, ebenfalls aus „Klimaschutzgründen“ durch Strom und/oder Wasserstoff ersetzt werden. Aber was hat das nun alles für Auswirkungen auf uns Verbraucher? Wegen der Unwirtschaftlichkeit der „Erneuerbaren“ wird Energie deutlich teurer. Das zeigte sich bislang beim Strompreis:

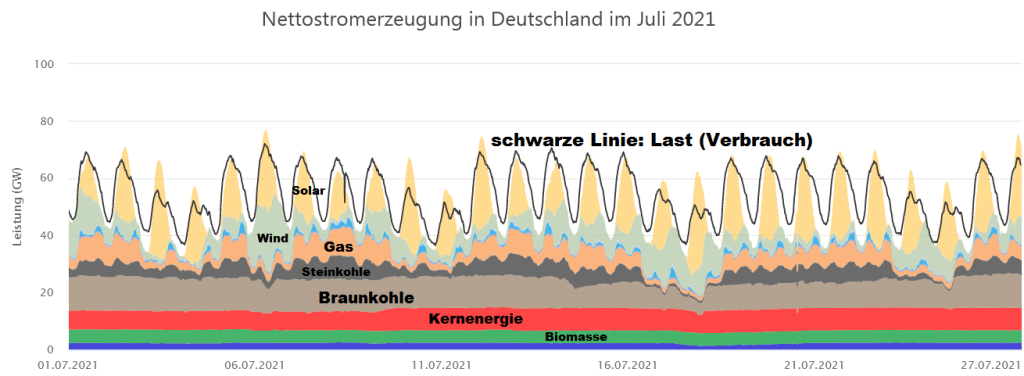

Abbildung 4: Seit den frühen 2000er Jahren verteuerte sich Strom in Deutschland viel stärker, als die meisten andern Verbraucherpreise. Hier sind 4.000 KWh Jahresverbrauch zugrunde gelegt.

Im Jahre 2021 verteuerten sich auch andere Energieträger (Öl, Kohle, besonders aber Erdgas) stark. Während die Politik dafür allein geopolitische Ursachen anführt, verschweigt sie, dass auch die Energiewende, welche ja nicht nur in Deutschland vollzogen wird, preistreibend wirkt. Wie wir anhand der Abbildung 3 sahen, ist der Betrieb der „Erneuerbaren“ nur mit Puffern oder Backups möglich, was die Nachfrage nach dafür geeigneten Rohstoffen und Energien stark anheizt (Verteuerung). In Deutschland sind das (noch) die Kernenergie (läuft Ende 2022 aus), Braun- und Steinkohle, zunehmend aber Erdgas. Doch Steinkohle und Erdgas unterliegen den Weltmarktpreisen. Einzig die heimische Braunkohle ist davon unabhängig – aber sie wird bis 2030 nun ebenfalls ausrangiert. Die folgende Grafik lässt erahnen, welche riesigen Stromlücken sich da auftuen werden, zumal dann wenn, wie 2021, der Wind schwächer weht:

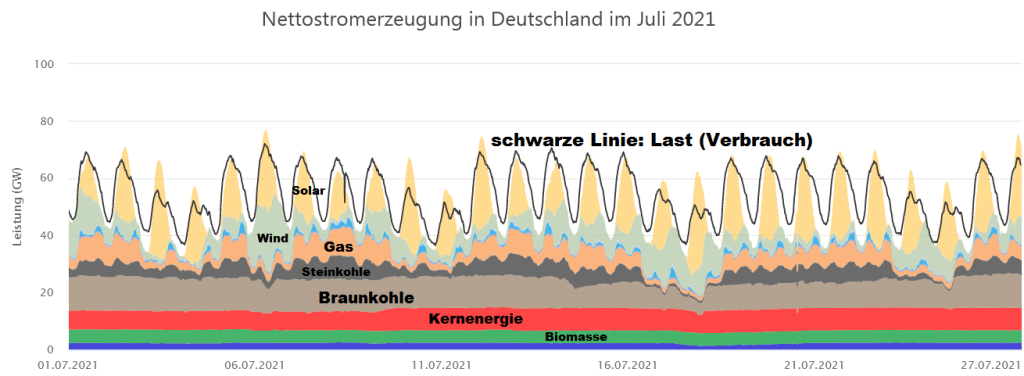

Abbildung 5: Verlauf der deutschen Stromproduktion über 4 Juli-Wochen 2021. Trotz enormer Anstrengungen in Sachen „Energiewende“ müssen selbst im sonnenscheinreichen Hochsommer noch 30 bis 70% des Stroms konventionell erzeugt werden; hinzu kommen Produktionslücken, welche schon jetzt durch Stromimporte zu decken sind (weiße Flächen unter der schwarzen Linie (Stromverbrauch), und die praktisch NIE aus erneuerbaren Quellen stammen. Nun stelle man sich einmal den Wegfall der Braunkohle und Kernenergie vor… . Bildquelle: energy-charts.info

Doch Energie verteuert sich nicht nur, sie wird auch schwerer verfügbar, es drohen immer häufiger Stromausfälle; vielfach mussten stromverbrauchsintensive Anlagen in der chemischen und metallverarbeitenden Industrie schon heruntergefahren werden – mit enormen Schäden für die Volkswirtschaft.

Aber wie sähe beispielsweise der Forschungsbetrieb am CERN aus, wenn Energie nicht mehr ständig verfügbar ist? Der Energieverbrauch des LHC und der Detektoren des CERN beträgt ungefähr 120 Megawatt. Dies entspricht in etwa dem Verbrauch aller Haushalte des Kantons Genf mit etwa 500.000 Einwohnern! Bei Flaute und trübem Wetter müssten alle Experimente ausfallen – denn ein Speicher für derart gigantische Energiemengen ist auf Jahrzehnte nicht in Sicht. Weil Energie unser ganzes Leben bestimmt, verteuern sich mit ihr auch alle Produkte und Dienstleistungen – die horrende Inflation des Jahres 2021 lässt grüßen. Künstliche Verknappung des Lebensmittel-Aufkommens durch Bio-Anbau und Bio-Treibstoffe verschärfen diese prekäre Lage weiter, denn sie konkurrieren mit der konventionellen Nahrungsmittelproduktion um die immer knapper werden Anbauflächen (täglich werden in Deutschland noch immer mehr als 50 Hektar Boden, das sind 500.000m², meist Ackerland, für Bebauungsmaßnahmen verloren.

3. Wird uns Energieeinsparung retten?

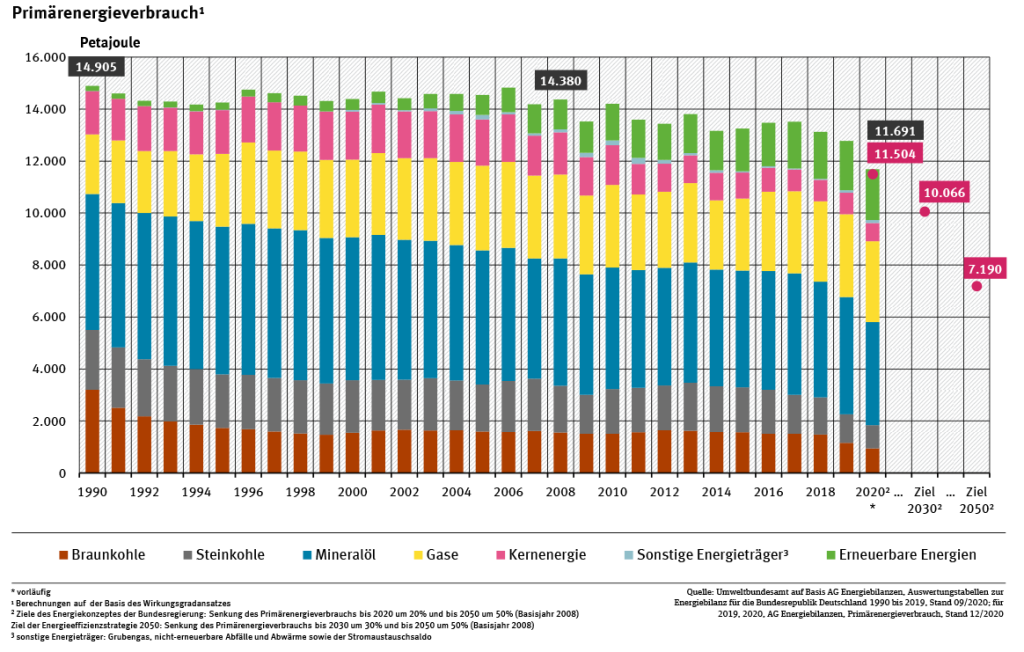

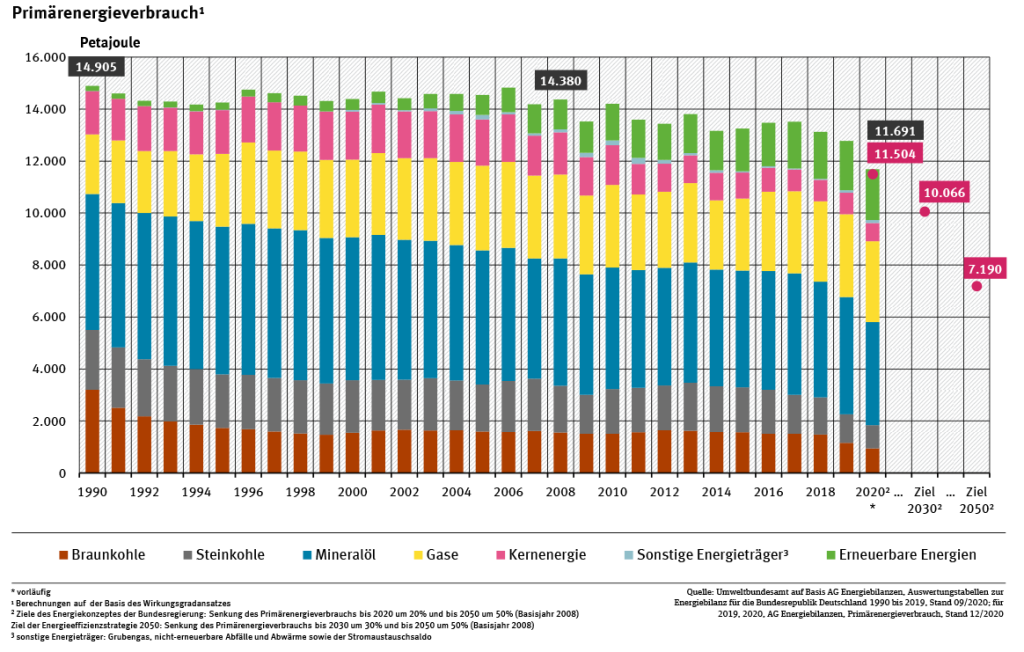

Von den Befürwortern der Erneuerbaren Energien wird Energieeinsparung als Möglichkeit gesehen, trotz der geringen Energieerträge die Versorgung zu gewährleisten. Doch schon ein Blick auf die Entwicklung des Primärenergieverbrauchs in Deutschland zeigt, wie schwierig das wird. Der Primärenergieverbrauch bezeichnet den Energiegehalt aller im Inland für die gesamte Volkswirtschaft (inklusive Privathaushalte, Staatswesen) eingesetzten Energieträger – kurzum alles, wofür Energie benötigt wird.

Abbildung 6: Entwicklung des jährlichen Primärenergieverbrauchs in Deutschland seit 1990 in Petajoule (1 Petajoule entspricht etwa 278 Millionen Kilowattstunden). Zwar sank dieser seit 2006 leicht, doch wurde dieser Effekt wesentlich durch gehäuft sehr milde Winter (wenig Heizung!) und zum Schluss (2020) auch durch die Corona-Krise (Wirtschaftseinbruch) begünstigt. Die oberen, grünen Säulenteile geben an, was an „Erneuerbaren“ verbraucht wurde – mit etwa 15% nach dreißig Jahren massivster Förderung dieser Quellen ein sehr bescheidenes Ergebnis. Und trotz der äußerst günstigen Rahmenbedingungen 2020 (extrem milder Winter, Lockdowns ab März) wurden die Einsparungsziele der Bundesregierung (rot hinterlegter Wert und Punkt an der Säule) nicht mal ganz erreicht. Bis 2050 soll sich der Primärenergieverbrauch gegenüber 1990 mehr als halbieren – ein illusorisches Ziel. Bildquelle: Umweltbundesamt

Energiesparen ist richtig und wichtig – doch es gibt dafür Grenzen. Diese ergeben sich schon aus den physikalischen Gesetzen. Eine gewisse Energiemenge wird immer benötigt, um einen bestimmten Prozess (Heizen, Kühlen, Fortbewegen, Beleuchten…) zu bewerkstelligen, zusätzlich wird es dabei stets Verluste durch Abwärme, Strahlung, Reibung oder elektrischen Widerstand geben.

Einfacher gesagt: Ein alltagstaugliches Gerät wird immer eine Mindestmenge an Energie verbrauchen müssen – und seien die Einsparbemühungen noch so ausgefeilt. Während in ihren Anfangsjahren Kühlschränke, Radios, Fernseher und Glühbirnen unsere Wohnungen aufheizten, arbeiten sie heuer derart effizient, dass weitere Einsparungen kaum noch möglich sind – die „Schallmauer“ des technischen Fortschritts lässt grüßen. Es kommt aber noch schlimmer: Weil immer neue Techniken und Geräte erfunden werden, erhöhte sich auch der Ausstattungsgrad der gesamten Volkswirtschaft mit Energieverbrauchern stark, was die Einsparungseffekte größtenteils zunichtemacht. Standen in einem durchschnittlichen Haushalt der 1970er Auto, Heizung, Kühlschrank, Herd, Waschmaschine, Staubsauger, Telefon, Radio, Fernseher und einige Küchengeräte sowie der Fön, so kamen bis heuer mindestens Computer, Smartphone, Mikrowelle, Elektrofahrrad und oft eine Klimaanlage hinzu; außerdem wurden oft Zweitwagen und Zweitgeräte angeschafft – man nennt das „Rebound-Effekt“. Rebound (englisch: zurückprallen) bezeichnet in der Energieökonomie das unerwünschte Phänomen, dass Energieeinsparungen durch Effizienzsteigerung nicht wie erwartet eintreten: Die geplante Einsparung wird nur zum Teil oder gar nicht wirksam. Es kann sogar zu einem Mehrverbrauch kommen, weil sich das Verbraucherverhalten ändert oder die Einsparmaßnahmen selbst unsinnig und energieintensiv sind. So wurden die Motoren zwar immer effizienter – aber die Autos auch immer größer und luxuriöser. Ein anderes Beispiel ist das Wärmedämmen. Heizen beansprucht im Privathaushalt etwa zwei Drittel des Gesamtenergieverbrauchs; deshalb wurde ab den 2000er Jahren Wärmedämmen massiv gefördert. Doch die Einspareffekte blieben mit 10 bis 20% bescheiden – dafür kam es oft zu massiven Problemen mit Schimmelbildung. Das Umweltbundesamt merkt dazu etwas gequält an: „Die privaten Haushalte benötigten im Jahr 2018 etwa gleich viel Energie wie im Jahr 1990 und damit gut ein Viertel des gesamten Endenergieverbrauchs in Deutschland.“

Kurzum – Energiesparen kann unsere aktuellen Energieprobleme bestenfalls etwas lindern.

4. Wege aus der Rattenfalle – wie könnten sie aussehen?

Zunächst einmal müssen Wissenschaft, Technik und Energiegewinnungsverfahren endlich wieder ideologiefrei und objektiv beurteilt werden. Bislang gibt es (leider) keine wirklich umweltfreundliche Energienutzung! Es gelang auch praktisch nie, eine bestimmte Technik oder ein Energiegewinnungsverfahren erfolgreich per Dekret von oben zu verordnen! Den Königsweg für alle Nationen und Standorte gibt es nicht. Während in Island die Geothermie und in Norwegen die Wasserkraft dominieren, hat sich in den meisten Staaten ein Energiemix aus verschiedensten Quellen bewährt. Wegen ihrer hohen Energiedichte darf auch die in Deutschland geächtete Kernenergienutzung kein Tabu sein, zumal neue, inhärent sichere Reaktortypen in technischer und finanziell machbarer Reichweite liegen. Auch Methanhydrate könnten eine Option sein, falls sie sich kostengünstig und umweltfreundlich fördern lassen. Wind- und Solarenergie sollten nur dort eine wesentliche Rolle spielen, wo sie reichlich vorhanden sind und nahe am Ort der Erzeugung direkt als Strom verbraucht werden können – wegen ihrer geringen Energiedichte sind lange Transportwege oder die Umwandlung in andere Energieträger wenig sinnvoll. Und es muss an den wirklich potentiellen Energiequellen der Zukunft geforscht werden. Allerdings liegen diese, etwa die Kernfusion, noch in weiter, ungewisser Ferne. Heute arbeiten weltweit mehrere Tausend Mitarbeiter an ITER. Insgesamt 35 Nationen aus Europa, Asien, Russland und den USA sind an diesem Projekt zur Erforschung der Kernfusion beteiligt; Kostenpunkt: mindestens 20 Milliarden Euro. Technisch umsetzbare Ergebnisse lieferte ITER bislang aber nicht.

Die Aufgabe unserer Regierungen besteht nicht darin, ihre Ideologien in der Energiepolitik auszuleben, sondern bezahlbare Energie für alle Menschen zu gewährleisten. Andernfalls werden schon in naher Zukunft zunehmende soziale Spannungen drohen, die sich schnell zu bürgerkriegsähnlichen Zuständen verschärfen können. Des Weiteren bedarf es einschneidender Reformen, um unser sehr ineffizientes Renten- Gesundheits- und Bildungssystem den schwierigen Erfordernissen der Neuzeit anzupassen.

Stefan Kämpfe, unabhängiger Natur- und Klimaforscher