Die Temperaturen im November und Neues aus der Klimaforschung

von Fritz Vahrenholt

Es gibt Ermutigendes aus der Klimaforschung. Eine kürzlich erschienene Veröffentlichung bestätigt Erkenntnisse, wonach der Mensch nicht allein die Erwärmung der letzten 150 Jahre verursacht hat.

Zunächst aber wie immer zur Temperaturkurve.

Die Abweichung der globalen Mitteltemperatur der satellitengestützten Messungen vom Durchschnitt der Jahre 1991-2020 fiel im November ziemlich deutlich von 0,37 Grad Celsius auf 0,08 Grad Celsius. Die Abkühlung umfasste die Nord- und Südhemisphäre. Besonders die Arktis kühlte sich deutlich ab. Der mittlere Temperaturanstieg der letzten 40 Jahre betrug 0,14 Grad Celsius pro Jahrzehnt.

Steven Koonin : Klimawissenschaft ist „Unsettled“

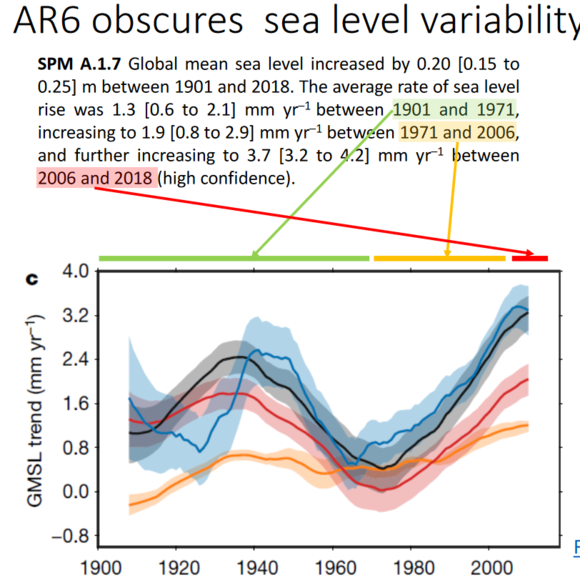

Als Kuratoriums-Mitglied der Global Warming Policy Foundation war ich im November zum Vortrag von Steven Koonin in London eingeladen. In einer beeindruckenden Rede beschrieb der ehemalige Unterstaatsekretär für Energie unter Präsident Obama die Übertreibungen, Verfälschungen und Auslassungen, die die Wissenschaft bei der politischen Zusammenfassung in der Summary for policymakers des IPCC erfährt. Ich will aus der Präsentation nur ein Beispiel herausgreifen. Der UN-Weltklimarat IPCC erweckt in seinem letzten Bericht auf Seite 5 den Eindruck, dass der Meeresspiegel beschleunigt ansteigt (Übersetzung des zweiten Satzes der Abb. unten):

„Die mittlere Rate des Meerespiegelanstiegs war 1,3 mm/Jahr zwischen 1901 und 1971, ansteigend auf 1,9 mm/Jahr zwischen 1971 und 2006 und weiter ansteigend auf 3,7 mm/Jahr zwischen 2006 und 2008“.

Da kann man ja Angst bekommen.

Koonin zeigt aber in der unten ebenfalls dargestellten Grafik aus einer Veröffentlichung aus dem Jahre 2020, wie die Entwicklung tatsächlich verlaufen ist : der Meeresspiegel ist dem natürlichen Muster der 60-jährigen atlantischen Oszillation folgend hin – und hergeschwankt. Pickt man sich entsprechende Zeiträume heraus, so kommt man zu der falschen Aussage des IPCC. Betrachtet man das Gesamtbild, so erkennt man die natürliche Variabilität und einen durchschnittlichen Anstieg von etwa 1,6 mm.

Es lohnt sich, den Vortrag anzusehen oder das Buch von Steven Koonin „Unsettled“ zu lesen.

Eine bemerkenswerte Veröffentlichung zum solaren Einfluss auf das Klima bleibt unbemerkt

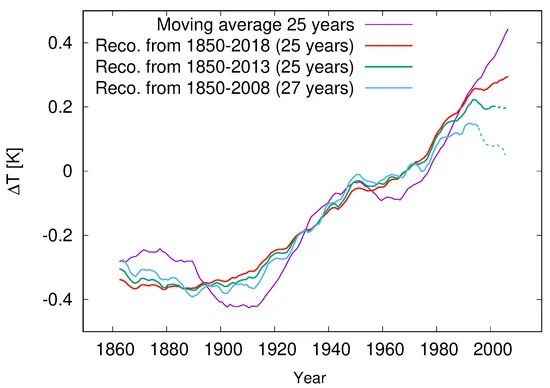

Am 3. November erschien in dem anerkannten Wissenschaftsjournal Climate eine Veröffentlichung zum solaren Einfluss auf das Klima. Die Arbeit des angesehenen Solarforschers Dr. Frank Stefani vom Helmholtz Zentrum Dresden-Rossendorf trägt den Titel : „Solare und Anthropogene Einflüsse auf das Klima : eine Regressionsanalyse und vorläufige Vorhersagen“ und kommt zu dem Ergebnis, dass der Einfluss des CO2 auf die Entwicklung der globalen Temperaturen von 1860 bis heute nur etwa halb so groß war wie es der letzte Bericht des Weltklimarats IPCC angenommen hat. Zur Erinnerung: der Weltklimarat kommt zum Ergebnis, dass 98 % der Erwärmung (1,07 Grad von 1,09 Grad) menschlich verursacht sind. Nach der Analyse Stefanis liegt der Anteil des Sonneneinflusses bei immerhin 30-70 %.

Stefani untersuchte den Verlauf des geomagnetischen aa – Index, der die Stärke des Erdmagnetfeldes wiedergibt. Dieser Index wird seit 1844 in Cambridge und Melbourne gemessen und spiegelt den Einfluss der solaren Aktivität wider. In früheren Veröffentlichungen hatte Stefani schon nachweisen können, dass der 11-jährige Solarzyklus von den Anziehungskräften von Venus, Erde und Jupiter ausgelöst wird, die alle 11,07 Jahre in einer Bahnresonanz stehen.(hier,hier und hier) Da die Sonne – durch alle Planeten beeinflusst (insbesondere durch Jupiter und Saturn) – sich zusätzlich um den Schwerpunkt des Sonnensystems bewegt, entstehen solare Zyklen, die in der Temperaturgeschichte als 193-jähriger Suess-de Vries-Zyklus und 90- jähriger Gleissberg-Zyklus bekannt geworden sind.

In einer gekoppelten Regressionsanaylse von aa – Index, CO2 und Temperatur konnte Stefani eine CO2-Klimasensitivität TCR (Transient Climate Response bei einer Verdoppelung der CO2-Konzentration) von 1,1 +- 0,5 Grad Celsius bestimmen. Wegen der zyklischen Natur der solaren Aktivität konnte Stefani eine Prognose des aa – Index für die nächsten 150 Jahre wagen. Danach würde bis zum Ende dieses Jahrhunderts selbst bei einer weiteren Zunahme der CO2-Konzentration um 2,5 ppm pro Jahr lediglich eine Temperaturerhöhung von 1 Grad Celsius entstehen. Stefani : „Das angestrebte 2-K-Ziel könnte wahrscheinlich ohne eine drastische Dekarbonisierung erreicht werden.“

Bei einer mäßigen Decarbonisierung (Anstieg bis 500 ppm) würde durch die zurückgehende Aktivität der Sonne der Erwärmungseffekt des CO2 weitgehend kompensiert, die Erwärmung kommt zum Erliegen.

Vielleicht sollte Ministerpräsident Michael Kretschmer, der gegen den Bruch der Vereinbarung zum Auslauf der Braunkohleförderung im Jahre 2038 kämpft (nunmehr im Koalitonsvertrag „idealerweise 2030“), Herrn Stefani von Dresden-Rossendorf einmal persönlich in die Staatskanzlei bitten. Sein Vorvorgänger Stanislaw Tillich hatte im Jahre 2012 Sebastian Lüning und mich in das sächsische Kabinett eingeladen, um vor sämtlichen Ministerinnen und Minstern die Thesen des Buches „Die kalte Sonne“ vorzutragen. Das waren noch Zeiten!

Die Rekonstruktion mit einer Klimasensitivität von CO2 von 1,1 Grad Celsius (ein Drittel weniger als die Annahme des Weltklimarates) ist im folgenden Bild der Arbeit von Stefani entnommen. Die Divergenz ab 2.000 ist dem starken Temperaturanstieg durch den El Niño 2016 geschuldet, die sich aber nach 2018 wieder leicht zurückentwickelt hat (siehe oben die Eingangsgrafik).

Die Koaltionsvereinbarung und das 2 % -Ziel für die Windenergie

Die Koalitionsvereinbarung will nach dem Kernenergieausstieg Ende 2023 den Kohleausstieg bis 2030 vorziehen: „Idealerweise gelingt das schon bis 2030“. Hierzu sollen die Erneuerbaren Energien 80 % der Stromerzeugung übernehmen, die von heute 600 TWh (Terawattstunden) auf 680-750 TWh ansteigen (S.56) soll.

Während für die Solarenergie (Vervierfachung der heutigen Kapazität auf 200 GW) und für die off-shore Windenergie (ebenfalls Vervierfachung auf 30 GW) konkrete Erzeugungsziele benannt werden, spricht die Vereinbarung bei der on-shore Windenergie lediglich von einem Ziel einer Flächeninanspruchnahme von 2% der Landesfläche. Würde man über einen Zubau von 30000 Anlagen sprechen – und davon ist bei einer Verdoppelung der Fläche von heute 0,9 % der Landesfläche auszugehen, käme das auf dem Lande eher nicht so gut an.

Aber ist die Fläche von 2% denn überhaupt zutreffend bestimmt? Das ist sie genausowenig wie die Flächenangabe von 0,9 Prozent für den heutigen Bestand. Denn die Flächenangaben beziehen sich jeweils auf die eng begrenzte, die Anlagen umfassende B-Plan-Fläche. Die notwendigen Abstände zu Wohnbebauungen sind in dieser Flächenangabe nicht enthalten.

Die 0,9% entsprechen heute rechnerisch 3100 km² (Quelle Umweltbundesamt sowie Kompetenzzentrum Naturschutz und Energiewende)

„1.325 Quadratkilometer und damit zirka 42 Prozent der betrachteten Flächen sind – bei Berücksichtigung der Bestandsanlagen zum Stichtag 31.12.2017 – für die Errichtung von Windenergieanlagen frei.“

Das bedeutet : Auf 1800 km² standen 2017 28500 Anlagen ( heute sind es 30 000 Anlagen). Das ist, wie gesagt, die Fläche der B-Pläne. Diese Fläche umfasst nicht den notwendigen Abstand zu Wohnhäusern, der aber planerisch mit abgedeckt sein muss. Teilt man die Anzahl der Anlagen (28.500 ) durch die Fläche (1.800 km²), so stehen 16 Anlagen auf 1 km², d.h. Im Durchschnitt 62.500 m² pro Anlage oder 250 m mal 250 m. Das zeigt, das der notwendige Abstand zu Wohngebäuden in dieser Fläche nicht enthalten sein kann. Rechnet man vereinfachend mit einer Durchschnittsgrösse von 5 Anlagen pro Windpark, so würde der Windpark ohne Abstandsflächen durchschnittlich (bei einem Abstand von 300 m der Anlagen zueinander) etwa 176.000 m² (420 m x 420 m Fläche mit vier Windkraftanlagen an den Kanten und 1 in der Mitte) umfassen. Mit Abstandsflächen von 600 m ( was immissionschutzrechtlich schon bedenklich ist) zur nächsten Wohnbauung benötigt der Park eine Fläche von 1.020 m x 1.020 m = 1,04 km². Das ist die sechsfache Fläche der B-Plan Fläche, die sich lediglich um die Anlagenkonfiguration schmiegt.

Selbst wenn man berücksichtigt, dass heute 5% der Anlagen im Wald stehen ( in dem es keine Abstandsrestriktionen gibt) und zukünftig vielleicht 20% im Wald gebaut werden, würde der Flächenbedarf sich lediglich auf das Fünffache der B-Plan Fläche reduzieren.

Das heißt: Wer 2% Landesfläche mit B-Plänen für Windkraftanlagen verlangt, benötigt in Wirklichkeit 10% der Landesfläche.

Nun wird man einräumen, dass die Anlagengröße und -höhe deutlich steigen wird, so dass wir mit weniger als 30.000 Anlagen zu rechnen haben. Das ist richtig. Aber der Flächenverbrauch bleibt in der gleichen Größenordnung, denn grössere Anlagen benötigen einen größeren Abstand untereinander ( fünf mal Rotordurchmesser, bei 120 m sind das 600m Abstand). Und sie benötigen mindestens einen Abstand von etwa 1.000m zur Wohnbebauung. Der Ertrag steigt, aber ebenso der Flächenverbrauch.

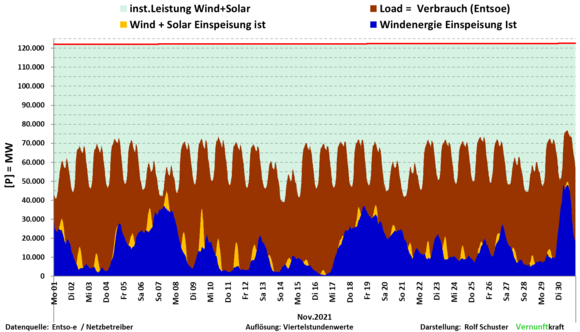

Dass eine Vervielfachung der Windenergie keine gesicherte Leistung ergibt, braucht hier nicht noch einmal erwähnt zu werden. Auch der windstarke November hat gezeigt, dass die Windenergieerzeugung häufig genug nahe Null bis 5000 MW, und somit unter 10 % der möglichen Leistung von 60.000 MW lag. Und drei mal Null ist Null. (Quelle der Grafik : Rolf Schuster)