Arctic Tales and Fails*

Abschmelzendes Arktis-Eis? Von wegen! Bild: Erwin Lorenzen / pixelio.de

[*Schwer übersetzbares Wortspiel. Etwa: Arktische Märchen und deren Scheitern]

Joseph D’Aleo, CCM

Berichte der letzten Jahrzehnte über den Rückgang des arktischen Eises haben die Diskussion über die Möglichkeit der Eröffnung einer Schiffspassage für Russland durch seine nördlichen Gewässer wieder in Gang gebracht, die es in den Mittelpunkt einer neuen globalen Handelsschifffahrtsroute stellen könnte. Nichts daran ist neu für diejenigen, die sich darum kümmern und genug über diese Angelegenheit wissen.

Die Nordwestpassage ist ein Seesweg, der den Atlantischen und den Pazifischen Ozean durch die Inseln des kanadischen Arktischen Archipels und entlang der nördlichsten Küste Nordamerikas verbindet. Die Europäer suchten 300 Jahre lang nach einer brauchbaren Seehandelsroute nach Asien. Kolumbus sowie andere europäische Seefahrer begannen, eine westliche Route zu suchen. Prominent in dieser Suche waren Namen wie Jacques Cartier, Gaspar und Miguel Corte-Real, Sir Martin Frobisher, John Davis, Henry Hudson und William Baffin. Sehen Sie hier das rege Interesse Großbritanniens zu Beginn des 19. Jahrhunderts.

Dr. Gary Sharp schlug folgende geschichtliche Darstellung vor: „Die Nordwestpassage ist ein Seeweg zwischen dem Atlantik und dem Pazifischen Ozean. Mehr als drei Jahrhunderte lang hatten Forscher versucht, die Route zu finden, bevor sie schließlich 1906 vom norwegischen Entdecker Roald Amundsen (1872-1928) entdeckt wurde. Als Amundsen die Nordwestpassage erfolgreich navigierte, stellte er fest, dass sie sich zwischen dem Festland des nördlichen Kanadas und den arktischen Inseln Kanadas schlängelte. Die Reise an Bord seines kleinen Schiffes Gjoa dauerte mehr als drei Jahre, weil er und seine Mannschaft gezwungen waren, drei Winter lang zu kampieren. Die erste erfolgreiche kommerzielle Reise wurde 1969 von dem Eis brechenden Tanker SS Manhattan unternommen. Diese Reise folgte der Entdeckung großer Ölvorkommen in Alaska, was die Eröffnung einer kürzeren Route zur Ostküste der Vereinigten Staaten beeinflusste.“

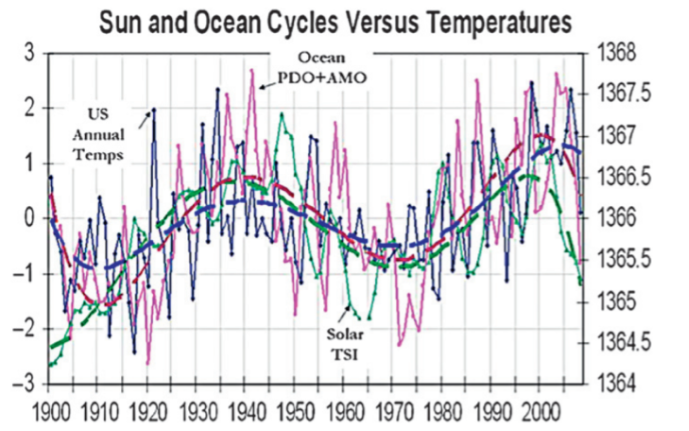

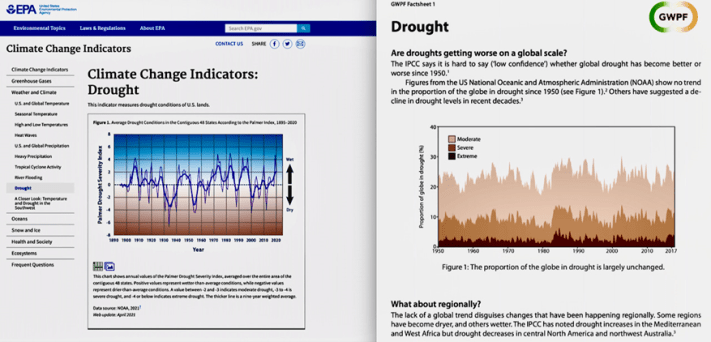

Wie lebensfähig ist eine sich jedes Jahr öffnende, zuverlässige Nordroute? Einige glauben, dass der durch CO2 induzierte Klimawandel eine solche mit sich bringen wird. Aber kann man das Abnehmen und Zunehmen des Eises mit den natürlichen atlantischen und pazifischen Zyklen von Wärme und Kälte erklären.

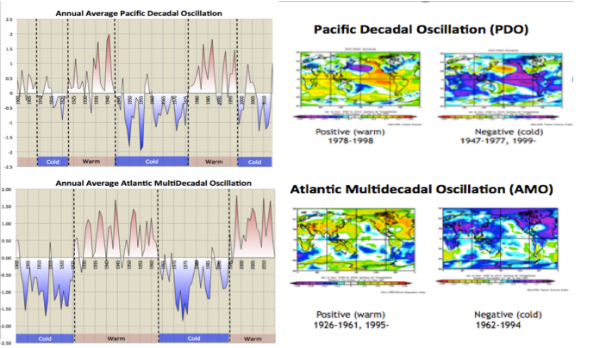

In den späten 1990er Jahren fand die US-Fischereiabteilung an der UWA heraus, dass die Erwärmungs- und Abkühlungszyklen des Pazifischen Ozeans sich darauf auswirken, wohin die Fischbestände wandern. In den 1990er Jahren fanden Forscher einen ähnlichen Zyklus im Atlantikbecken.

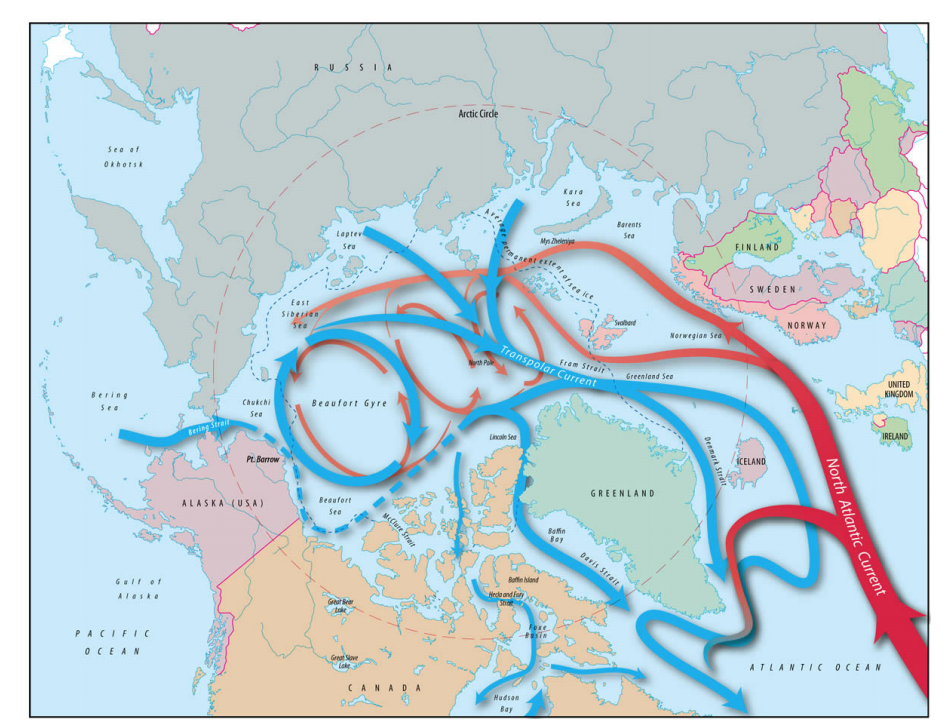

Beide Zyklen haben einen großen Einfluss auf die globalen Temperaturen, einschließlich der arktischen Temperaturen, da das Wasser (warm oder kalt) von den Strömungen unter dem arktischen Eis transportiert wird.

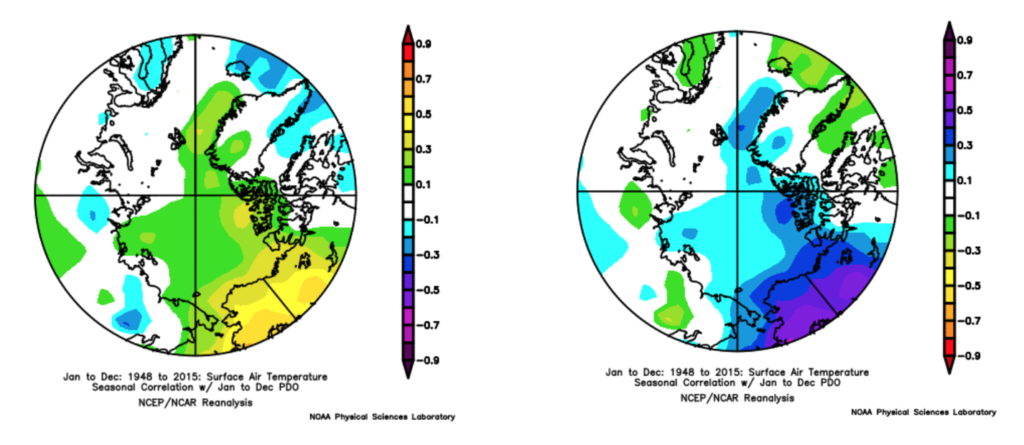

Wenn sich der Pazifik erwärmt, gelangt warmes Wasser aus der Beringsee westlich von Alaska in die Arktis und fördert die Eisschmelze früh in der Saison und verzögert das Einfrieren und verringert die Eisdicke. Hier erkennt man die höheren jährlichen Durchschnittstemperaturen in der warmen PDO, die mehr El Ninos begünstigt (links) und die niedrigen, wenn die PDO in die Kaltphase wechselt, was kühlere La Ninas begünstigt (rechts):

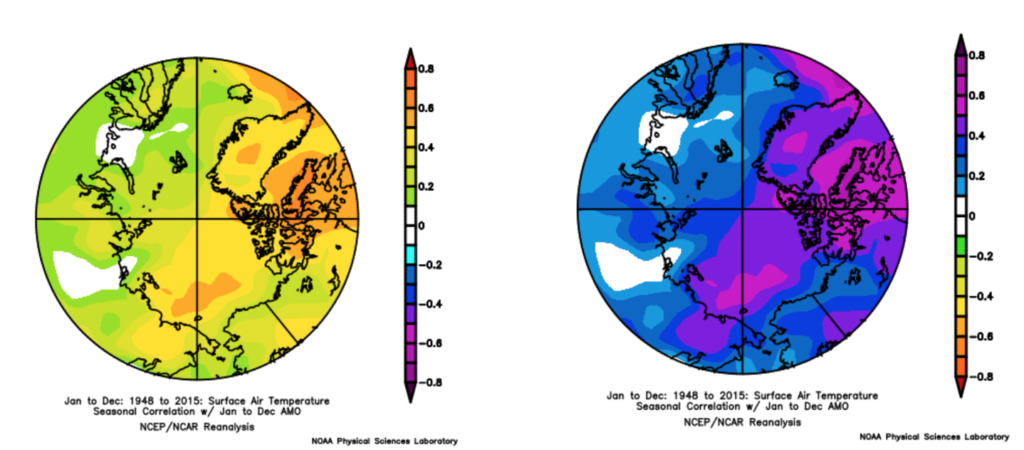

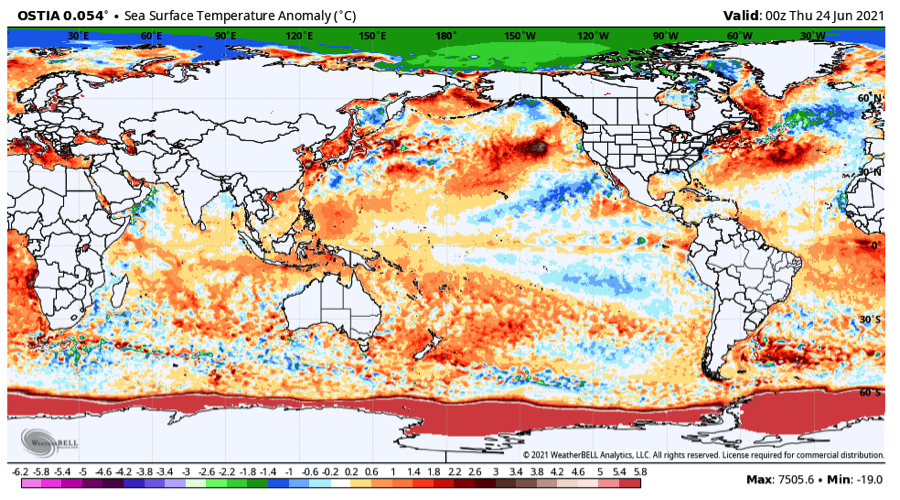

Wenn sich der Atlantik erwärmt, wird das warme Wasser von den Strömungen unter das Eis transportiert (das schwimmt) und die Arktis erwärmt sich (links). Dieses warme Wasser hat einen erheblichen Einfluss auf die Eisbedeckung während der Sommersaison. Wenn der Atlantik abkühlt, nimmt die Schmelze ab und das Eis wird dicker und hartnäckiger. Abkühlung ist die Folge (rechts):

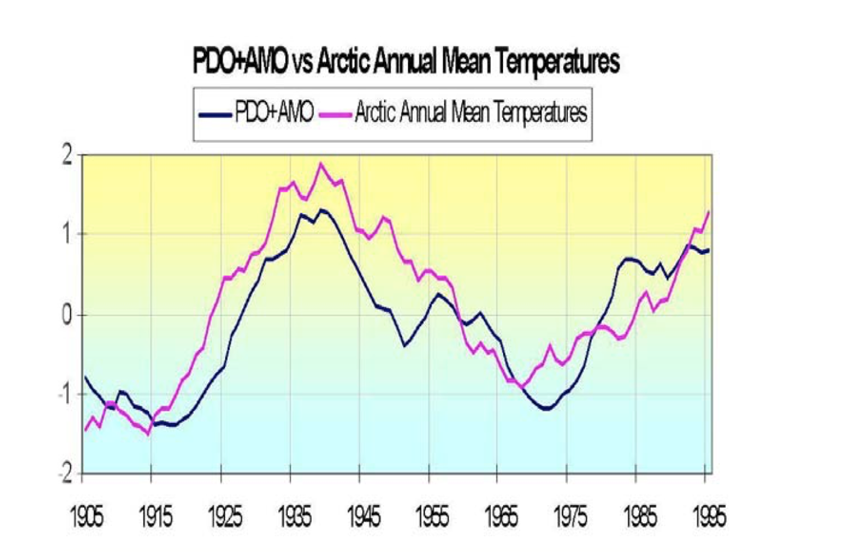

Mehr Eis bedeutet niedrigere Temperaturen. Die Summe der mittleren PDO und AMO zeigen eine sehr gute Übereinstimmung mit den arktischen Mitteltemperaturen (von Polyokov, UAF):

Dies wird durch die Forschung unterstützt. Francis et al. (GRL 2007) zeigten, wie die Erwärmung in der Arktis und das schmelzende Eis mit warmem Wasser (+3C) in der Barentssee zusammenhängt, das sich langsam in die sibirische Arktis bewegt und das Eis schmilzt. Sie bemerkte auch die positive Rückkopplung von veränderter Rückstrahlung durch offenes Wasser, das dann die Erwärmung weiter verstärkt.

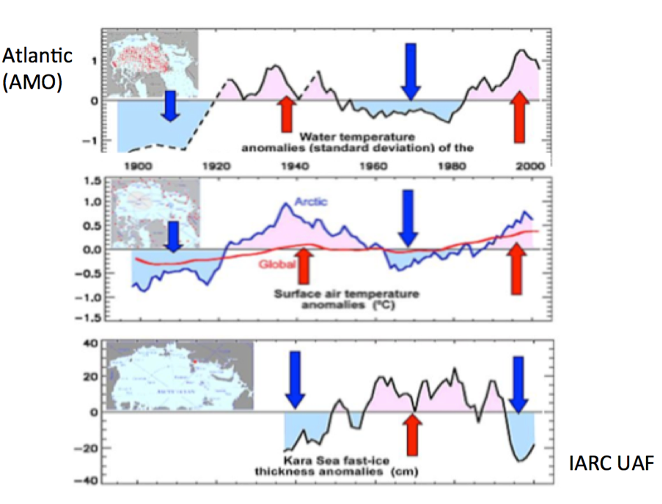

Das Internationale Arktis-Forschungszentrum an der Universität von Alaska, Fairbanks, zeigte, wie die arktischen Temperaturen mit dem Eindringen von atlantischem Wasser zyklisch schwanken – zwischen kalt und warm:

Bevor das NSIDC in seiner Objektivität zum Schweigen gebracht wurde [!], schrieben sie nach 2007: „Ein prominenter Forscher, Igor Polyakov von der Universität von Fairbanks in Alaska, weist darauf hin, dass Impulse von ungewöhnlich warmem Wasser vom Atlantik in den Arktischen Ozean eindringen, die mehrere Jahre später im Ozean nördlich von Sibirien zu sehen sind. Diese Wasserimpulse tragen zur Erwärmung des oberen Arktischen Ozeans bei, was zur sommerlichen Eisschmelze beiträgt und das Eiswachstum im Winter reduziert.“

Ein anderer Wissenschaftler, Koji Shimada von der Japan Agency for Marine-Earth Science and Technology, berichtet über Hinweise auf Veränderungen der Ozeanzirkulation auf der pazifischen Seite des Arktischen Ozeans. Durch eine komplexe Wechselwirkung mit dem abnehmenden Meereis wird warmes Wasser, das im Sommer durch die Beringstraße in den Arktischen Ozean gelangt, von der Küste Alaskas in den Arktischen Ozean geschoben, wo es den weiteren Eisverlust fördert.

Viele Fragen müssen noch beantwortet werden, aber diese Veränderungen in der Ozeanzirkulation könnten wichtige Schlüssel zum Verständnis des beobachteten Verlustes des arktischen Meereises sein.

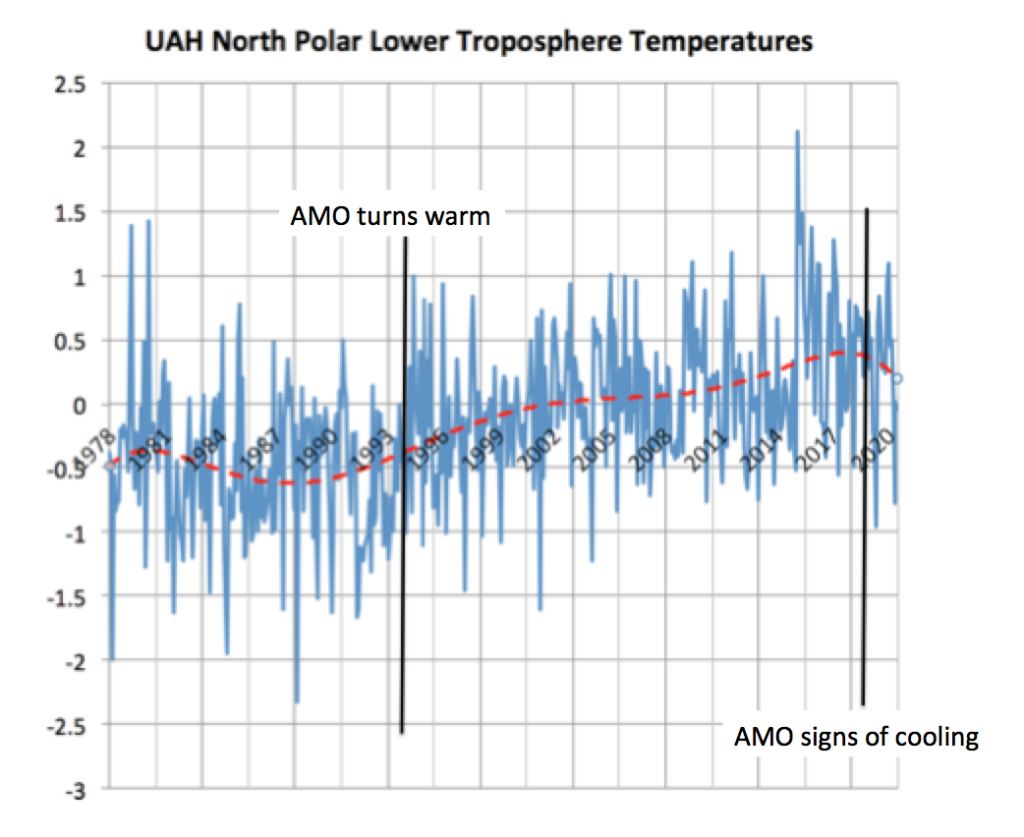

Beachten Sie, dass sich die nordpolare Atmosphäre seit des Wechsels der AMO in die Warmphase im Jahre 1995 erwärmt hat. Beachten Sie auch, dass es jetzt Anzeichen für eine Abkühlung zeigt, die der verstorbene große Hurrikan-Experte Dr. Bill Gray für das Jahr 2020 erwartet hatte (Atlantik-Temperaturen beeinflussen die Hurrikan-Saison). Beachten Sie den Rückgang nach 2016 mit einigen Monaten, die 3°C kälter sind als der Super-Nino-Höchststand 2016.

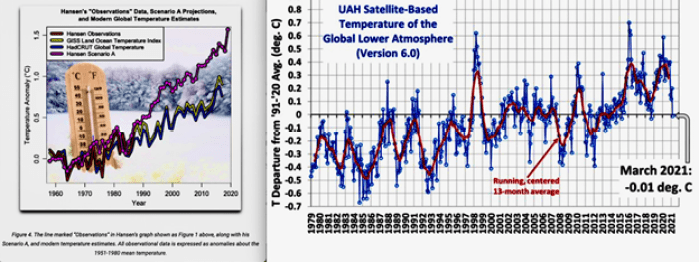

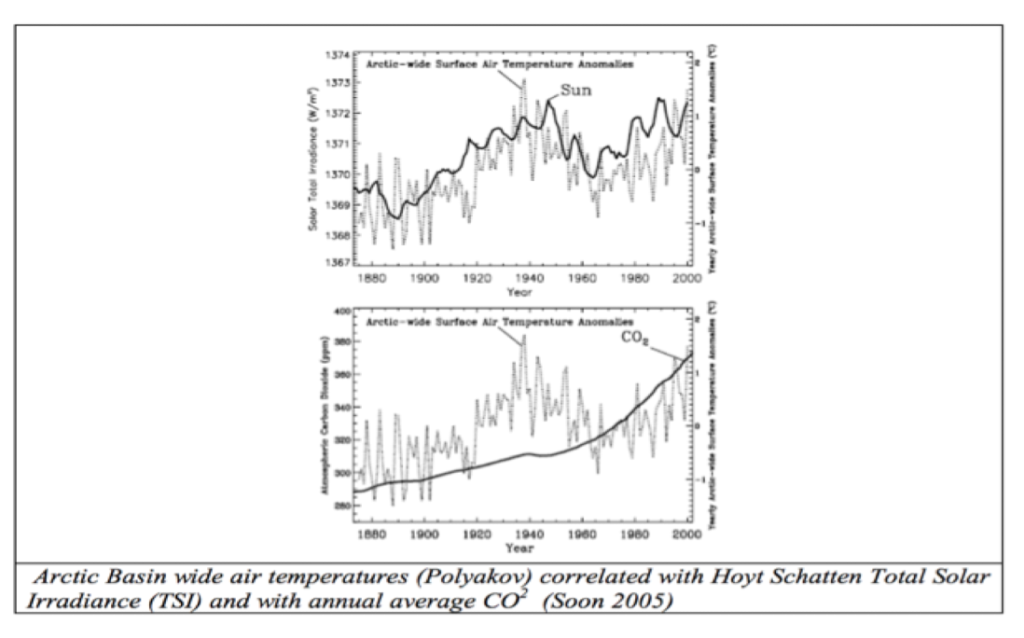

Dr. Willie Soon wies nach, dass die Temperaturen der Arktis viel besser mit solaren Zyklen korrelieren als mit CO2:

Die Sonne scheint der Treiber hinter der globalen Temperatur und ozeanischen Zyklen zu sein.

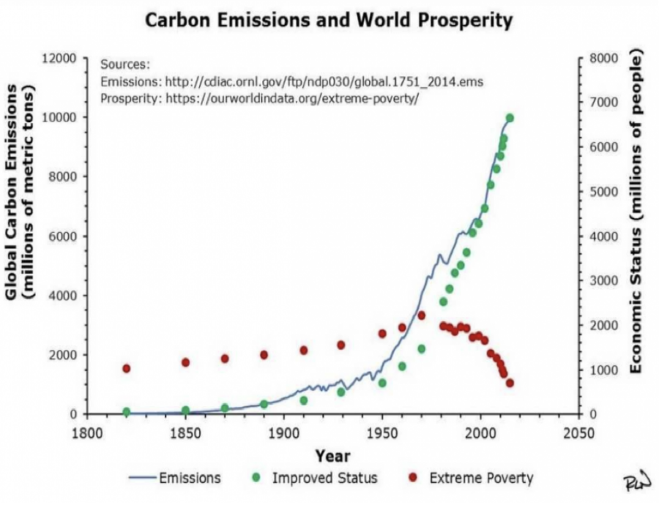

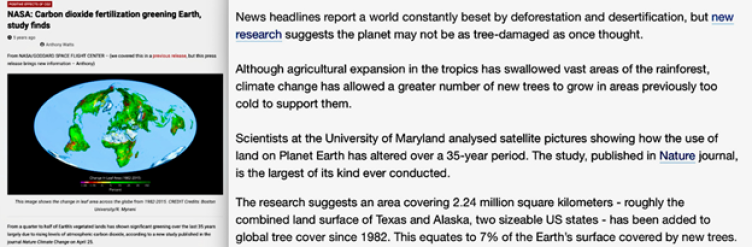

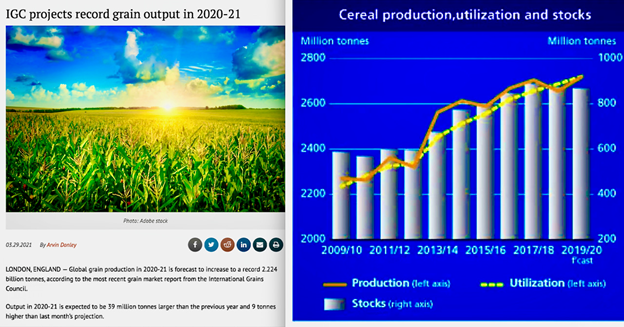

Die einzige Folge des zunehmenden CO2-Gehaltes ist die Zunahme des Wohlstands der Welt durch Pflanzendüngung – sogar die Flächenausdehnung der Sahara-Wüste ist um 8% zurückgegangen. Die Kälte wird zurückkehren und das Eis auch. Die Menschheit wird ärmer und stark gehandicapt zurückbleiben, um damit umzugehen.

Link: http://icecap.us/index.php/go/new-and-cool/arctic_tales_and_fails/

Übersetzt von Christian Freuer für das EIKE