Karlsruhe contra Freiheit der Wissenschaft

Wenn sie denn könnte würde Justitia in Tränen ausbrechen ob der Art und Weise, wie in D „Recht“ gesprochen wird! Bild: Thomas Max Müller / pixelio.de

Fred F. Mueller

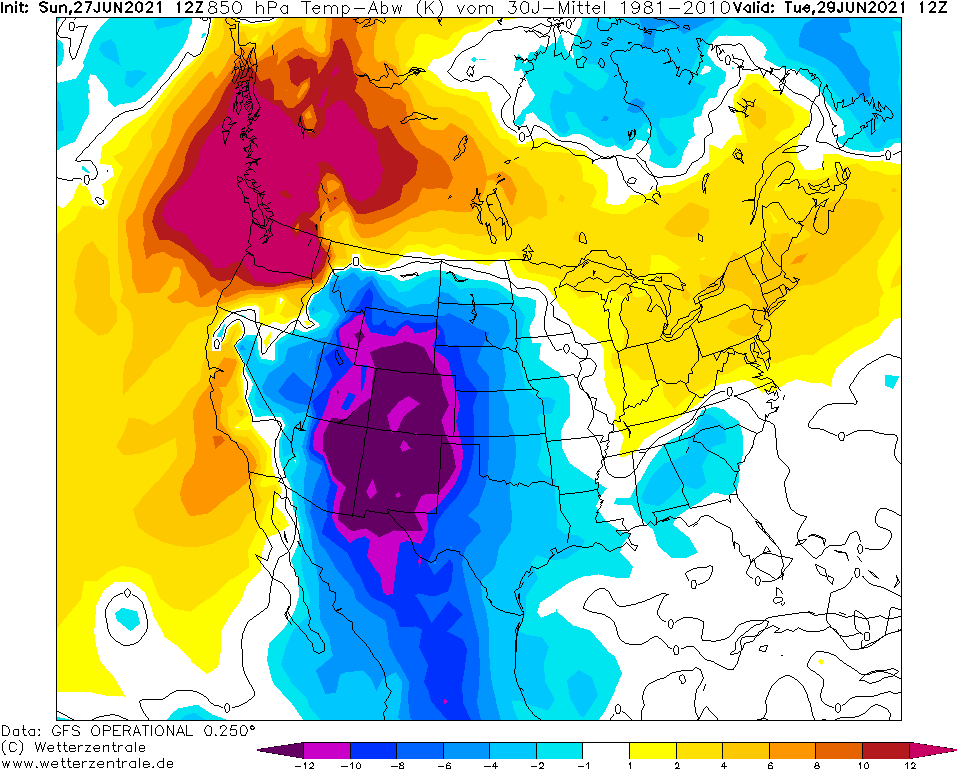

Wenn die „Klimaschützer“ erstmal an der Macht sind, ist es mit ihrem Motto „follow the science“ schnell vorbei. Der Beschluss des Bundesverfassungsgerichts zum sogenannten Klimaschutzgesetz vom 24.März 2021 wird sicherlich in die Geschichtsschreibung eingehen. Obwohl das Wort „Klima“ in der aktuellen Fassung des Grundgesetzes nirgendwo vorkommt, werden „Klimaschutz“ und darüber hinaus sogar die „Herstellung der Klimaneutralität“ quasi zu Verfassungszielen erhoben. Nach Ansicht des höchsten deutschen Gerichts rechtfertigt die Einhaltung des „2-Grad-Ziels“ und möglichst sogar des „1,5 -Grad-Ziels“ des Pariser Klimaabkommens sogar erhebliche staatliche Eingriffe in die im Grundgesetz verankerten Freiheitsrechte.

Als erstes Freiheitsrecht haben Gerichtspräsident Stephan Harbarth und seine sieben Richterkollegen in der ersten Kammer schon mit der Urteilsbegründung die Freiheit von Forschung und Lehre ins Visier genommen: Das Bundesverfassungsgericht sieht sich befugt, über naturwissenschaftliche Fragen durch Richterspruch statt wie sonst üblich durch naturwissenschaftlichen Nachweis zu entscheiden. Man könnte dies geradezu als eine Art Rückfall ins Mittelalter ansehen. Auch den religiösen und politischen Machthabern jener Epoche waren Menschen, die auf ihren eigenen Verstand vertrauten, ein Dorn im Auge. Diese unabhängigen Geister wagten es doch glatt, all das anzuzweifeln, was dem Volk von Fürsten und Priestern vorgesetzt wurde. In den jahrhundertelangen Auseinandersetzungen zwischen Naturwissenschaften einerseits und den religiösen sowie weltlichen Eliten andererseits markierte das Urteil der Inquisition gegen Galileo Galilei – einen der wesentlichen Begründer der modernen Naturwissenschaften – in gewisser Weise einen Wendepunkt. Bei diesem Prozess ging es im Grunde darum, ob es einem Untertanen erlaubt sei, die Vorgänge in der Natur durch Experiment und Logik zu klären oder ob die Machthaber – damals die Kirche mithilfe von Inquisitionsgerichten, die auch weltliche Macht bis hin zu Scheiterhaufen und Kerkerhaft ausübten – auch hier das letzte Wort hatten. Nach dem Skandalurteil gegen Galilei verlor die Kirche mehr und mehr an Ansehen. Die Naturwissenschaften konnten sich dagegen in langem, zähen Ringen nach und nach durchsetzen, auch wenn es bei der katholischen Kirche bis 1992 dauerte, bevor Galileo Galilei offiziell rehabilitiert wurde. Weltliche Gerichte hatten sich dagegen schon sehr viel länger davor gehütet, naturwissenschaftliche Fragen juristisch „klären“ zu wollen. In Fächern wie Physik, Chemie oder Mathematik gelten weder Mehrheitsmeinungen noch Gerichtsurteile, sondern ausschließlich Logik, Experiment und Beweisführung.

Bild 1. Das Henry-Gesetz in Aktion: Unter Druck in Sprudelwasser gelöstes CO2 gast beim Einschenken unter Blasenbildung aus (Foto: Autor)

Umso mehr überrascht es, wenn sich in der heutigen Zeit ein weltliches Gericht daranmacht, die Auffassungen von lediglich zwei akademischen Gremien zu quasi verbindlichen Verfassungsgeboten zu erheben. Hierbei handelt es sich zum einen um das IPCC (UN Intergovernmental Panel on Climate Change), das seit Jahren als Weltautorität in Klimafragen dargestellt wird. Zweiter Ideengeber des Karlsruher Urteils ist sodann der Sachverständigenrat für Umweltfragen (SRU). Dieses Gremium wurde von der Regierung mit handverlesenen Spezialisten besetzt, die allesamt Professortitel führen. Sie verfügen über Kompetenzen auf zahlreichen Gebieten wie Medizin, Biologie, Abfall und Recycling, Umweltrecht und Umweltforschung sowie Politikwissenschaft. Allerdings weist nur ein einziges Mitglied – ein Physiker und Geograf – die zur Beurteilung von Fragen der Klimawissenschaften erforderliche Ausbildung auf. Stellvertretende Vorsitzende des SRU ist Fr. Prof. Kemfert. Diese telegene und wortgewandte blonde Wirtschaftswissenschaftlerin wird in Presse und Medien gern interviewt beziehungsweise zu Talkshows eingeladen. Zwar wird sie dort als kompetent in Energiefragen dargestellt, doch ist sie de facto eine vehemente Lobbyistin der Solar- und Windenergiebranche. Auch fällt sie gelegentlich durch den Gebrauch von Begriffen aus dem Vokabular einer obskuren neomarxistischen Sekte auf.

Henrys Gesetz höchstrichterlich für unzutreffend erklärt

Naturwissenschaftliches Opfer des Karlsruher Urteils ist das Henry-Gesetz, das kaum jemand kennen dürfte, wenn er auf der Straße danach gefragt würde. Dabei sind seine Auswirkungen allgemein bekannt, denn es wirkt sicht- und hörbar jedesmal, wenn man eine Flasche Sprudelwasser oder eine Dose mit Erfrischungsgetränken öffnet: Unter intensivem Zischen bilden sich im Getränk über einen längeren Zeitraum Gasblasen. Bei diesem Gas handelt es sich um CO2, welches der Abfüller vorher dem Getränk unter hohem Druck zugefügt hatte, wobei es in der Flüssigkeit in Lösung ging. Beim Öffnen sinkt dieser Druck, und das CO2 drängt aus der Flüssigkeit wieder in Form von Gasblasen heraus.

Das gleiche Gesetz erklärt auch, warum Fische im Hochsommer ersticken, weil im warmen Wasser zuwenig Sauerstoff enthalten ist, oder warum Taucher schwere Gesundheitsschäden durch Stickstoffblasen im Blut erleiden, wenn sie zu schnell auftauchen.

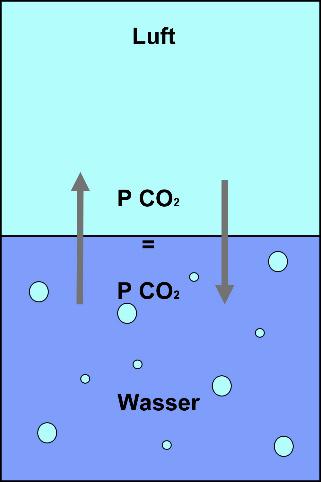

Bild 3. Henry erkannte, dass an der Grenzfläche zur Luft ein ständiger Gasaustausch stattfindet, so dass sich ein Gleichgewicht zwischen dem „inneren Druck“ des Gases in der Flüssigkeit und seinem Teildruck in der Atmosphäre einstellt (Grafik: Autor)

Das Henry-Gesetz ist nicht schwer zu verstehen: Die Grenzfläche zwischen Wasser und Luft ist für Gasmoleküle gut durchlässig, so dass ständig Moleküle aus der Atmosphäre ins Wasser wandern bzw. umgekehrt aus dem Wasser in die Atmosphäre. Dabei bildet sich nach einiger Zeit ein Gleichgewicht, sobald die Zahl der pro Zeiteinheit in die jeweilige Richtung wandernden Moleküle gleich ist. Man kann sich das Ganze so vorstellen, dass das Gas in der Flüssigkeit unter einem „inneren Druck“ steht, der den Ausgleich mit seinem Druckanteil (Partialdruck) in der Atmosphäre herbeiführt. Würde man den Stickstoffanteil der Atmosphäre plötzlich erhöhen, so würde sich solange zusätzlicher Stickstoff im Wasser lösen, bis das Gleichgewicht wieder hergestellt ist. Dieses Gesetz gilt auch für alle anderen Gase in der Atmosphäre. Berechnen kann man das Ganze recht einfach mithilfe der sogenannten Henry-Konstanten. Darüber hinaus hat auch die Temperatur einen großen Einfluss.

Erkannt und naturwissenschaftlich untersucht wurden diese Zusammenhänge bereits 1802/03 von dem englischen Arzt und Chemiker William Henry (1774 bis 1836). Das nach ihm benannte Henry-Gesetz beschreibt den Einfluss von Drücken und Temperaturen auf die Menge von in Wasser gelösten Gasen. Er hätte es sich wahrscheinlich nie träumen lassen, dass seine Erkenntnisse mehr als 200 Jahre später im fernen Deutschland höchstrichterlich angezweifelt werden könnten. Doch genau das ist in Karlsruhe geschehen.

Kernaussagen des Karlsruher Urteils

Entscheidende Aussagen im Karlsruher Urteil sind:

- Nur kleine Teile der anthropogenen Emissionen werden von den Meeren und der terrestrischen Biosphäre aufgenommen…

- Der große Rest anthropogener CO2-Emissionen verbleibt aber langfristig in der Atmosphäre, summiert sich, trägt dort zur Erhöhung der CO2-Konzentration bei und entfaltet so Wirkung auf die Temperatur der Erde.

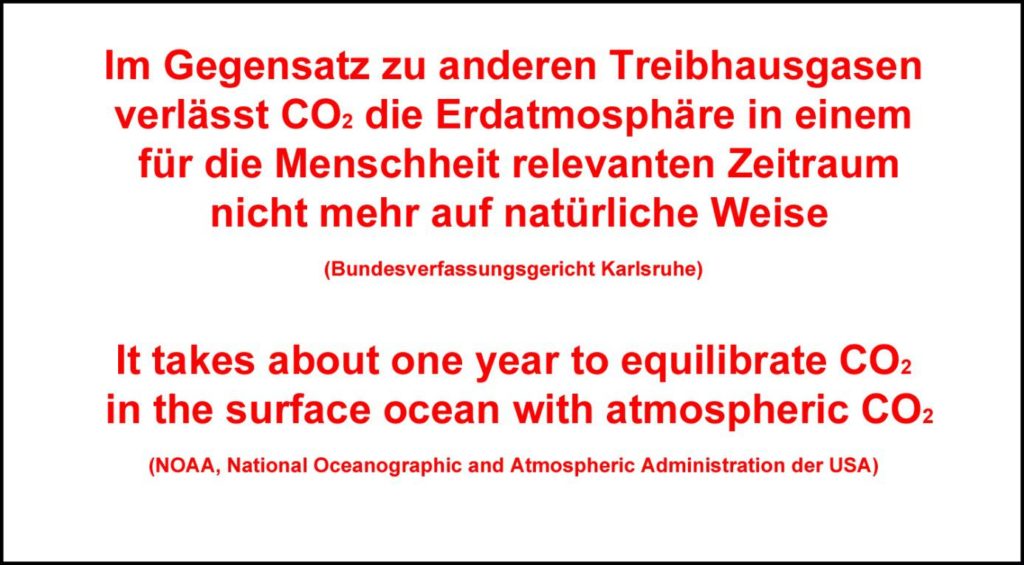

- Im Gegensatz zu anderen Treibhausgasen verlässt CO2 die Erdatmosphäre in einem für die Menschheit relevanten Zeitraum nicht mehr auf natürliche Weise. Jede weitere in die Erdatmosphäre gelangende und dieser nicht künstlich wieder entnommene (unten Rn. 33) CO2-Menge erhöht also bleibend die CO2-Konzentration und führt entsprechend zu einem weiteren Temperaturanstieg.

Je mehr Wasser, desto mehr Gas kann es aufnehmen

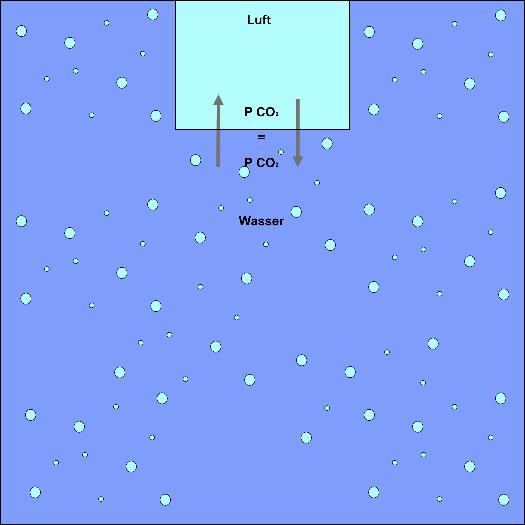

Das Verhältnis der Gesamtmengen des Gases in der Atmosphäre und im Ozean hängt dabei von den Gesamtmengen des Gases im Wasser und in der Atmosphäre ab. Das ist einfach zu verstehen: Erhöht man die Wassermenge, so erhöht sich auch die Menge an Gas, die es bei gleichen Druck- und Temperaturverhältnissen aufnehmen muss, um das Druckgleichgewicht wieder herzustellen. Da unsere Ozeane im Verhältnis zur Atmosphäre riesig sind, enthalten sie um ein Vielfaches mehr an Gasen als die Atmosphäre selbst.

Bild 5. Je mehr Wasser, desto größer die Gasmenge, die in die Ozeane strömen muss, bis das Gleichgewicht wiederhergestellt ist (Grafik: Autor)

Bild 6. Mit seiner Aussage befindet sich das Karlsruher Gericht im Widerspruch nicht nur zum Henry-Gesetz, sondern auch zu Erkenntnissen der NOAA (National Oceanographic and Atmospheric Organisation) der USA

Da bekannt ist, welche Mengen an CO2 in der Atmosphäre bzw. im Meer enthalten sind, kann man bei Annahme konstanter Temperatur- und Luftdruckverhältnisse recht einfach berechnen, welche Anteile einer vom Menschen zusätzlich in die Atmosphäre freigesetzten Menge CO2 in der Atmosphäre verbleiben und wieviel davon im Ozean in Lösung gehen werden. Im Jahr 2008 enthielt die Erdatmosphäre angenähert 3.000 Gigatonnen CO2 (1 Gigatonne = 1 Milliarde Tonnen). Die Menge des in den Meeren gelösten CO2 liegt mit rund 140.000 Gigatonnen um etwa den Faktor 50 darüber. Daraus ergibt sich ein Verhältnis von 98 zu 2. Nach Henry werden somit von jeder zusätzlich in die Atmosphäre eingebrachten Tonne CO2 rund 98 % bzw. 980 kg in den Ozeanen dauerhaft in Lösung gehen. Behauptungen über Klimakatastrophen aufgrund einer „Vermüllung der Atmosphäre durch CO2“ mit der Folge einer „Selbstverbrennung“ sowie darauf fußende Berechnungen von „CO2-Restbudgets“ widersprechen elementaren naturwissenschaftlichen Erkenntnissen. Dies gilt auch für die Urteilsbegründungen deutscher oder niederländischer Gerichte. Die dadurch ermutigten Klima-NGO’s haben schon angekündigt, die „böse“ Industrie in ganz Europa mit einer Klagewelle zu überziehen. Die Klimakids von „Fridays for Future“ werden in voraussichtlich wenigen Jahren in einem Alptraum aufwachen und sich fragen, wie sie da nur hineinrutschen konnten. Wie sagte man dazu früher in China: „Mögest du interessante Zeiten erleben“.

Bild 7. Der Austausch von CO2 zwischen Ozean und Atmosphäre wird von Wissenschaftlern wie z.B. Prof. Andrew Watson ganz anders bewertet als vom Bundesverfassungsgericht, das seiner Interpretation allerdings quasi Verfassungsrang verliehen hat

Quellen

www.gesetze-im-internet.de/gg/BJNR000010949.html

https://ec.europa.eu/clima/policies/international/negotiations/paris_de https://www.un.org/en/global-issues/climate-change

https://www.umweltrat.de/DE/SRU/Ratsmitglieder/ratsmitglieder_node.html

https://de.wikipedia.org/wiki/Galileo_Galilei

https://de.wikipedia.org/wiki/Henry-Gesetz

https://de.wikipedia.org/wiki/Kohlenstoffdioxid_in_der_Erdatmosph%C3%A4re

https://worldoceanreview.com/en/wor-1/ocean-chemistry/co2-reservoir/

https://phys.org/news/2020-09-ocean-carbon-uptake-widely-underestimated.html

https://uitspraken.rechtspraak.nl/inziendocument?id=ECLI:NL:RBDHA:2021:5339