Wieder einmal: Gescheiterte Klima-Prophezeiungen

Es gibt jetzt eine Menge neuerer aktiver Kommentatoren hier, ein gutes Zeichen für Anthony und Charles. Sie haben vielleicht nicht tief in den umfangreichen WUWT-Archiven gegraben. Eine Möglichkeit, ihren Dialog über das große Bild zu gestalten, ist, sich einige der grundlegendsten gescheiterten Vorhersagen der Klima-Alarmisten anzusehen und warum sie gescheitert sind. Hier sind neun von meinen eigenen GROSSEN, gruppiert nach drei Ursprüngen.

Modelle

● Es gibt einen modellierten tropischen Troposphären-Hotspot. ABER, wie John Christy vor dem Kongress im Jahr 2016 aufzeigte, ist dieser in der Realität nicht existent. Die Klimamodelle überbewerten die Erwärmung der tropischen Troposphäre um etwa das Dreifache. Der plausibelste Grund ist Eschenbachs Hypothese der aufkommenden Phänomene, insbesondere Gewitter. Diese waschen Feuchtigkeit aus, können aber nicht modelliert, sondern nur parametrisiert werden. (Details in einem lange zurückliegenden Beitrag, ‚The trouble with climate models‚ [in deutscher Übersetzung beim EIKE hier]). Aus Beobachtungen heraus modellierte CMIP5 etwa die Hälfte der tropischen Niederschläge, die ARGO beobachtet, durch Änderungen des Salzgehalts der Thermokline. Es stimmt also.

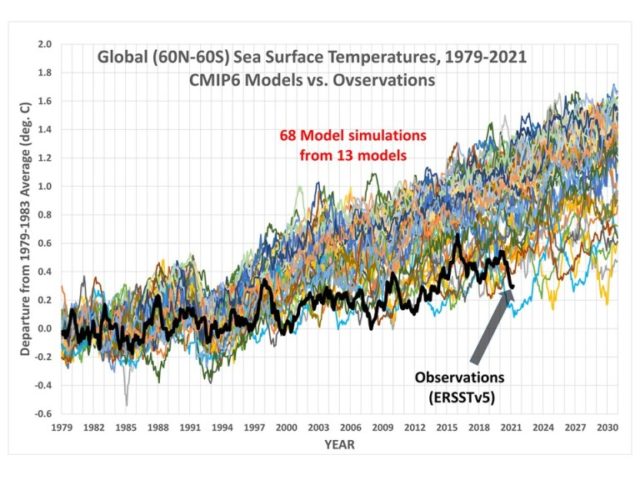

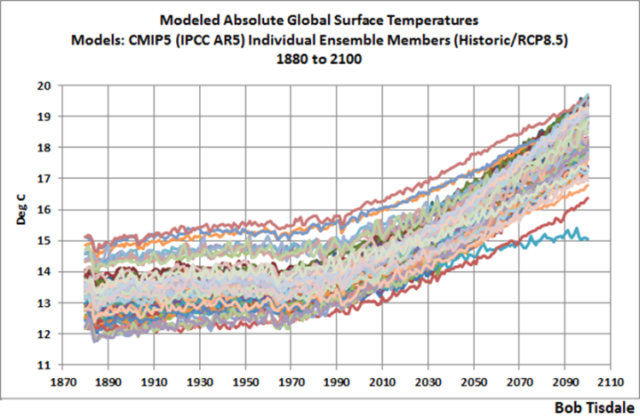

● Modelle passen Anomalien ausreichend an, um mit Beobachtungen übereinzustimmen. Eigentlich ist das nur halb wahr, denn die erforderlichen Modellparameter werden so lange abgestimmt, bis sie stimmen. Die Täuschung liegt in der Verwendung von Modellanomalien. In Wirklichkeit wichen die CMIP5-Modelle in Bezug auf die absolute Temperatur im Jahr 2000 (früh in ihrer Abstimmungsperiode) um ~4C vom beobachteten globalen Durchschnitt von ~15,5C ab.

Fast keine waren nahe an der beobachteten Realität – fast alle waren viel zu warm. Anomalien verbergen diesen grundlegenden Vorhersagefehler des Klimamodells.

● Modelle sagen zuverlässig eine ‚Gleichgewichts-Klimaempfindlichkeit‘ (ECS) von etwa 3C voraus. Wiederum halb wahr. Sie tun es alle, aber nicht „zuverlässig“. Beobachtete ECS unter Verwendung von Energiebudget- (und anderen) Methoden zeigen konsistent etwa 1,6-1,7C, etwa die Hälfte der modellierten. Das ist eine große Sache, da die ganze alarmistische Untergangsstimmung von einem hohen ECS (oder seinem nahen Verwandten TCR) abhängt. Bei 1,6 gibt es überhaupt kein Klimaproblem. Bei 3 gibt es vielleicht eines, vielleicht auch nicht. Die Diskrepanz zwischen Modell und Beobachtung ist so groß, dass der AR5 es abgelehnt hat, eine zentrale Schätzung des ECS zu erstellen, eine peinliche Unterlassung.

Fortsetzung

● Der Meeresspiegelanstieg wird sich beschleunigen. Aber das ist nicht der Fall, basierend auf langen Aufzeichnungen differentieller GPS-korrigierter Gezeitenpegel, von denen es jetzt etwa 70 gibt. Der Grund dafür ist, dass wir ähnliche Bedingungen wie im letzten Eem-Interglazial erleben (das Holozän ist jetzt laut Paläoproxy- und Eiskernaufzeichnungen etwa 1 °C kälter), währenddessen die geologischen Beweise auf einen maximalen Eem-Meeresspiegelanstieg (SLR) von etwa 2,2 mm/Jahr hindeuten – genau das, was wir jetzt beobachten, mit Abschluss, von den langen Aufzeichnungen der Gezeitenpegel im letzten Jahrhundert. Es gibt keine SLR-Beschleunigung.

● Die Ernteerträge werden ausfallen und die Menschen werden verhungern. Dies war das Thema meines ersten Beitrags hier vor langer Zeit. Die schreckliche NRDC-Vorhersage an den Kongress basierte auf zwei Unwahrheiten. Erstens stellten sie die „schlechteste“ Vorhersage als die Norm dar. Zweitens war das „schlimmste“ Papier, auf das sie sich für Mais stützten, selbst grundlegend fehlerhaft (ob absichtlich oder aus Inkompetenz, darüber kann man streiten). Es handelte sich um eine umfangreiche statistische Analyse der US-Maiserträge im Laufe der Zeit, und zwar auf der Ebene der einzelnen US-Bezirke für alle wichtigen Mais produzierenden Staaten. Sie behauptete zu zeigen, dass vorübergehende Temperaturen über x die Maiserträge dauerhaft um y reduzierten. AUSSER, ihre multivariate Regressionsanalyse ließ einen wichtigen kovarianten Term aus, Temperatur x Wasser. Die Logik der Auslassung war, dass Temperatur und Wasser meteorologisch nicht korreliert sind. Richtig. Der Fehler in ihrer Argumentation war, dass Mais WIRKLICH wichtig ist, und ihre y-Variable war der Maisertrag. Der ausgelassene Term verfälscht ihre Analyse, wie (nachdem die Autoren unter Alarmisten berühmt wurden und dann dummerweise ihre nun berühmten Maisdaten in grafischer Form veröffentlichten) durch einfache visuelle Inspektion und ein wenig Logik leicht ersichtlich wurde. Keine fortgeschrittene Statistik erforderlich. Schlussfolgerung: BOGUS.

● Eisbären werden aussterben, weil das arktische Sommereis irgendwann verschwinden wird (die Vorhersage, wann das sein wird, variiert, aber Wadkins war ein führender Alarmist, der bereits dreimal bewiesen hat, dass er falsch liegt). Wie Dr. Susan Crawford schon mehrfach betont hat, ist die gesamte wissenschaftliche Aussterbeprämisse falsch. Eisbären nehmen etwa 80% ihrer jährlichen Kalorienzufuhr während der Robbenfangsaison im Frühjahr auf. In der Tat ist zu dickes Eis im Frühjahr, nicht zu dünnes, ein Problem für Robben und dann für Bären. Sie sind zur Nahrungsaufnahme überhaupt nicht auf das Sommereis angewiesen. Sie kommen an Land und ernähren sich dann im Sommer wie ihre nahen Verwandten, die Braunbären (Grizzlybären), opportunistisch von Eiern aus Vogelnestern, Beeren, Aas wie angeschwemmten toten Walen und Walrossen, vielleicht sogar von einem gelegentlichen unglücklichen Karibu-Kitz.

Lösungen

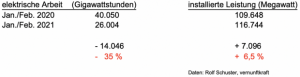

● „Erneuerbare“ Energien und der Green New Deal (GND). AOC und Konsorten haben offensichtlich keine Ahnung von Elektrotechnik. Das Netz soll zuverlässig sein. Erstens sind „erneuerbare“ Energien (Wind, Sonne) intermittierend. Daher brauchen sie bei jeder signifikanten Verbreitung ein Backup, ein großer Kostenfaktor, der von den stets subventionierten (weil unwirtschaftlichen) „erneuerbaren“ Energien nicht getragen wird. Zweitens erfordert das Netz Frequenzstabilität, auch bekannt als Netzträgheit. „Erneuerbare“ Energien sind asynchron, liefern also keine. Große rotierende konventionelle Generatoren, die mit Kohle, Erdgas oder Kernkraft betrieben werden, liefern automatisch Trägheit. Es gibt eine Lösung, die als Synchronkondensator bezeichnet wird (im Wesentlichen eine große, sich drehende, aber nicht angetriebene Generatormasse), aber auch für diese leisten die „erneuerbaren“ Energien keinen Beitrag, also werden keine hinzugefügt.

● EVs werden das „Kohlenstoff“-Problem der Benzin-/Diesel-Emissionen lösen. Sie benötigen große Mengen an Kobalt und Lithium (Hydroxid oder Karbonat). Von beidem haben wir nicht genug, und die Aussichten, die Situation in den nächsten Jahrzehnten durch neue Minen zu verbessern, sind bei der vom GND gewünschten Verbreitung von Elektrofahrzeugen gleich null. Lithium ist das 33. am häufigsten vorkommende Element der Erde, Kobalt das 31. Die Aussichten sind auf lange Sicht NICHT gut. Im Vergleich zur Häufigkeit in der Erdkruste (allein) liegt Aluminium auf Platz 3, Eisen auf Platz 4 und Kohlenstoff auf Platz 17. Übersetzung: Cola-Dosen und Flugzeuge, Stahl was auch immer, und „Kohlenstoff“-Treibstoffe haben wir. EV-Batterien, nicht so sehr. Ignoriert man die Dominanz Chinas bzgl. der Seltenen Erden kommt die Umweltvergiftung ist Spiel, nicht der Überfluss. Die USA haben ein sehr großes Vorkommen an der Grenze zwischen Kalifornien und Nevada in der Mountain-Pass-Mine, die jetzt im Besitz von China ist. Das Kostenproblem ist nicht das Erz, sondern die Folgen der Umweltaufbereitung. China kümmert das nicht. Uns schon. Vorteil China.

● EVs werden eine große Investition in das Stromnetz erfordern. T&D plus Erzeugung. Eine grobe Schätzung ist das Doppelte, um Benzin und Diesel zu verdrängen. Das ist weder im Zeitrahmen von Biden/.GND möglich, noch auch nur annähernd wirtschaftlich. Das Versprechen von Unmöglichem mag sich gut anhören, endet aber in der Realität immer schlecht

Link: https://wattsupwiththat.com/2021/04/26/failed-climate-predictions/

Übersetzt von Chris Frey EIKE