Klima-Reflexionen

Steven Koonins neues Buch „Uncertainty“* (das ich gerade zu Ende gelesen habe und das ursprünglich diesen Gastbeitrag inspiriert hat) trägt viel dazu bei, eine nuanciertere Perspektive voranzutreiben, indem es die faktische Klima-“Ungenauigkeit“ (auch bekannt als falsches Zeug) und die damit verbundene „Ungewissheit“ (Unwissenheit) in der Klimadebatte hervorhebt. Aber seinem ‚wissenschaftlichen‘ Ansatz fehlt teilweise der Gegenpol zu der hier angesprochenen zusätzlichen ‚religiösen Klimagläubigen, die gegen die Wissenschaft immun sind‘-Dimension, auch wenn Koonin sie in seinen Schlusskapiteln kurz anschneidet. Dieser Beitrag bleibt absichtlich nicht so an der Oberfläche.

[*Beim EIKE auf Deutsch hier vorgestellt]

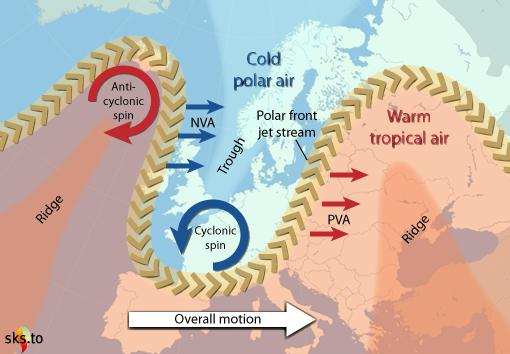

Als einleitendes Beispiel ignorieren die „Klimagläubigen“ die Unterbrechungen und die fehlende Netzträgheit, die ihre Lösungen für erneuerbare Energien (Green New Deal, GND) automatisch mit sich bringen. Dies mag nur aus physikalischer Unkenntnis der komplexen Mathematik der Wechselstromelektrizität (a+bi, mit der Quadratwurzel aus minus 1, was physikalisch eine Phasenverschiebung anzeigt) [?] sein. Aber nach vielen Blog-Interaktionen denke ich jetzt, dass es wahrscheinlicher auf absichtlicher, vorsätzlicher Ignoranz beruht, die im US-Recht als „kriminelle grobe Fahrlässigkeit“ definiert ist… „wusste, oder hätte wissen müssen“.

Es gibt viele andere Beispiele für „kriminelle grobe Fahrlässigkeit“ der Klimawissenschaft.

Zum Beispiel hat Dr. Susan Crockford die „Eisbärenexperten“ entlarvt, die behaupten, Eisbären seien durch (modelliert) vermindertes arktisches Meereis im Sommer gefährdet, wenn in Wahrheit etwa 80% ihrer jährlichen Nahrungsaufnahme von der Wurfsaison der Robben im Frühjahr abhängt – wenn das arktische Eis jahreszeitlich bedingt immer abnimmt.

Zum Beispiel hängt der behauptete GAST-Temperaturanstieg von einem „vernachlässigbaren“ (pro BEST) UHI plus unzureichenden landgestützten Messstationen ab, die für eine globale Abdeckung eingefügt wurden. Ein klassisches Beispiel für letzteres ist die BEST-Station 166900, also die Amundsen-Scott-Station am Südpol, die wohl teuerste und am besten gewartete Wetterstation auf dem Planeten. Der „automatische Anpassungs-Algorithmus“ von BEST verglich sie mit McMurdo, 1300 km entfernt an der Küste und 2700 Meter tiefer gelegen. Der BEST-Qualitätskontroll-Algorithmus kam zu dem Schluss, dass die Amundsen-Scott-Messungen für 26 extrem kalte Monate auf der Grundlage von McMurdo und NICHT auf derjenigen von BEST berücksichtigt werden müssen. BEST hat Amundsen Scott automatisch, aber fälschlich künstlich erwärmt.

Zum Beispiel behauptete Fabricius (NCC, 2011), dass die Korallen in der Milne Bay durch die Versauerung der Ozeane (OA) abnehmen würden. Ihre SI zeigte, dass ihre eine karge (7,8 pH) See wegen H2S giftig war, so giftig für Meeresorganismen, wie Zyanid für uns ist – und aus den gleichen Gründen.

Es gibt viele weitere ähnliche nachfolgende Gastbeiträge hier und bei Climate Etc.

Also, wie kann diese Klima-Perversion der wahren Wissenschaft über mehrere Jahrzehnte weitergehen? Was motiviert die offensichtliche absichtliche „kriminelle grobe Fahrlässigkeit“?

Es gibt mindestens drei Antworten auf diese Frage.

Die erste Antwort ist das Geld in Form von Festanstellungen und staatlichen Zuschüssen. Mitmachen, um mitzukommen. Manns gefälschter Paläo-Hockeystick von 1999 ist nur ein berühmtes Beispiel. Er wurde reich und erhielt eine Festanstellung für eine SEHR schlechte Arbeit, die inzwischen gründlich diskreditiert ist. Sein Bankkonto kümmert das nicht.

Das zweite ist die akademische Akzeptanz; Gruppenzwang, wenn man so will. Das ist es, was Dr. Judith Curry vom Lehrstuhl für Geowissenschaften an der Georgia Tech vertrieben hat, nach ihrer eigenen Erklärung. Junge Klimawissenschaftler, die aufsteigen wollen, können keine Abtrünnigen sein, und sie konnte ihnen nicht guten Gewissens einen anderen Rat geben.

Drittens ist ‚cool sein‘. Es gibt keine andere Erklärung für John Kerry als Bidens ‚Klima-Zar‘. Es ist dumm und letztlich selbstzerstörerisch, aber definitiv ein großes Plus auf jeder gegenwärtigen MA-Cocktailparty. AOC und ihr GND ist ein kleineres Beispiel für das gleiche ‚coole‘ soziale Phänomen aus Brooklyn im Kongress.

Also, was zu tun?

Es mag einige wirksame Gegenmaßnahmen jenseits der „Wissenschaft“ geben, gegen die wahre Klima-Gläubige offenbar immun sind. Die folgenden drei Vorschläge sind alle aus Alinskys „Regeln für Radikale“ entlehnt, die seit langem gegen als Leugner bezeichnete Skeptiker eingesetzt werden. Mein Vorschlag lautet, zum Gegenangriff überzugehen, und zwar nicht nach den Regeln des Marquis von Queensbury, die Skeptiker gewöhnlich anwenden, sondern nach den Regeln von Alinsky.

Zuerst muss man den Feind lahmlegen und ihn dann lächerlich machen. Mark Steyn tat dies sehr effektiv gegen Mann mit seinem Buch „A Disgrace to the Profession (volume 1)“. Unanfechtbar, da Mann bis heute nicht darauf reagiert hat und die implizite „Band 2“-Drohung schon seit Jahren im Raum steht.

Der zweite Punkt ist, den Feind dazu zu bringen, sich an seine eigenen Regeln über die Klimawissenschaft zu halten. Das war Koonins zentraler Punkt, den er in seinem neuen Buch wiederholt betont.

Drittens geht es darum, die Expertise des Gegners zu verlassen. Erneuerbare Intermittenz und fehlende Netzträgheit sind Beispiele für Fachwissen, die hier bereits diskutiert wurden und die die Grünen ignorieren oder gar nicht erst begreifen, weil sie außerhalb ihrer Expertise liegen.

Abschließende Überlegungen

Viele hier bei WUWT mögen wie ich zuvor auch gedacht haben, dass eine „wissenschaftliche“ Widerlegung gegen Warmisten ausreicht. Das tut es aber nicht. Sie haben ein sozio-religiöses Glaubenssystem (Greta Thunberg ist ein Beispiel) erschaffen, das stärkere Gegenmaßnahmen erfordert.

Link: https://wattsupwiththat.com/2021/05/12/climate-reflections/

Übersetzt von Chris Frey EIKE