Einen Abgleich meines hemisphärischen S-B-Modells mit allen wesentlichen THE-Thesen hatte ich hier auf EIKE bereits als Trilogie (Darstellung, Diskussion, Ergebnis) vorgelegt. Allerdings soll dieser THE nach „neuesten Erkenntnissen“ jetzt nur noch (32°) betragen, und damit gibt es dann wiederum mehr Spielraum für den Klimaeinfluss des Menschen oberhalb von (14°C). Andererseits ist es völlig unmöglich zu beweisen, dass es irgendein Phantasieprodukt gar nicht gibt, eben weil dieses Etwas gar nicht existiert. Dazu ein Beispiel aus einer Reportage von RSH (Radio Schleswig-Holstein), gesendet am 23. Dezember 2011: Auf einem Weihnachtsmarkt wurden Besucher gefragt, ob sie denn beweisen könnten, dass es den Weihnachtsmann gar nicht gibt. Natürlich konnte keiner der Befragten einen schlüssigen Beweis erbringen. Nähern wir uns mit diesem Wissen jetzt einmal dieser sogenannten „atmosphärischen Gegenstrahlung“, die sich angeblich folgendermaßen herleitet:

1. Hochfrequente (HF) Sonneneinstrahlung (@PIR²) => Erwärmung von Materie auf der Tagseite der Erde (2PIR²)

=> 2.Erwärmte Materie strahlt über die gesamte Erdoberfläche (4PIR²) Infrarot(IR)-Strahlung ab

=> 3. Diese IR-Strahlung animiert sogenannte „Klimagase“ zu einer IR-„Gegenstrahlung“ (@4PIR²)

=> 4. Diese IR-„Gegenstrahlung“ soll wiederum vorgeblich die Erdoberfläche (@4PIR²) erwärmen beziehungsweise deren „Abkühlung verlangsamen“ =>

Jetzt wird’s schwierig, denn nun geht es gleichzeitig mit 1. (@2PIR²) und 2. (@4PIR²) weiter.

WIDERSPRUCH 1: Die Erde soll sich durch die Rückstrahlung ihrer eigenen Abstrahlung (= Gegenstrahlung) noch weiter erwärmen; eine solche „Selbstaufheizung“ widerspricht aber dem 2. HS der Thermodynamik. Denn wenn ein solcher Vorgang funktionieren würde, könnten Sie Ihren Kaminofen zum Glühen bringen, indem Sie ein paar Kästen Mineralwasser davorstellen…

Und jetzt schauen wir uns nachfolgend einmal beim Deutschen Wetterdienst (DWD) die vorgeblich gemessene atmosphärische Gegenstrahlung an:

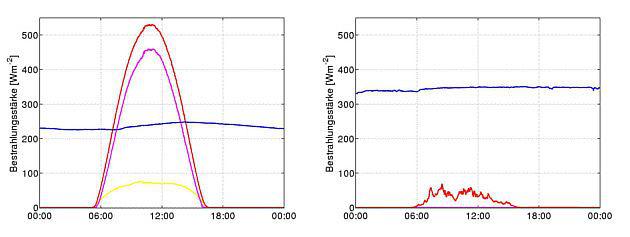

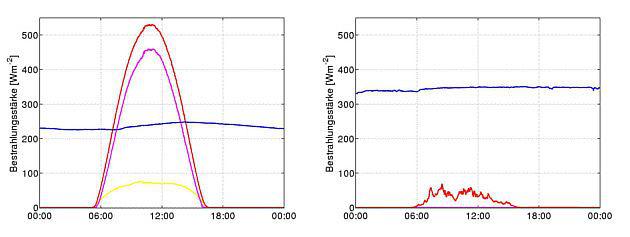

Abbildung 1: Originalbeschreibung, „Globale (rot), direkte (magenta) und diffuse (gelb) Sonnenstrahlung sowie langwellige Gegenstrahlung der Atmosphäre (blau) an einem wolkenlosen (links) und an einem bedeckten (rechts) Oktobertag in Lindenberg“ (Quelle: DWD Deutscher Wetterdienst)

Wir gehen jetzt einfach einmal davon aus, dass die beiden Beispiele einigermaßen vergleichbare Situationen darstellen. Daher halten wir an dieser Stelle fest:

- An einem wolkenlosen Oktobertag schwankt die vom DWD gemessene Gegenstrahlung zwischen 0:00 und 24:00 Uhr von ca. 220 bis 250 W/m².

- An einem bedeckten Oktobertag schwankt die vom DWD gemessene Gegenstrahlung zwischen 0:00 und 24:00 Uhr von ca. 330 bis 350 W/m².

- Es gibt nur bei wolkenlosem Himmel eine schwache optische Korrelation zwischen einem tentativen tageszeitlichen Temperaturverlauf und der sogenannten „Gegenstrahlung“, aber eine Differenz von etwa 100W/m² zugunsten einer Wolkenbedeckung.

- Die Unterschiede in der absoluten Bestrahlungsstärke der sogenannten „Gegenstrahlung“ liegen also weniger im Ablauf von Tag und Nacht, als vielmehr im Bedeckungsgrad.

WIDERSPRUCH 2: Hier treffen also eine über Nacht unverminderte „atmosphärische Gegenstrahlung“ und die Sonneneinstrahlung des neuen Tages unvermittelt aufeinander. Die sogenannte „atmosphärische Gegenstrahlung“ und die Sonneneinstrahlung des neuen Tages müssten daher zusammen eine Resonanzkatastrophe (=Selbstverbrennung der Erde) durch einen von Tag zu Tag ungebremst fortlaufenden Temperaturanstieg verursachen.

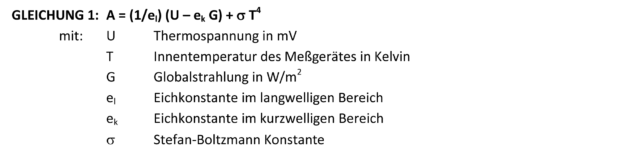

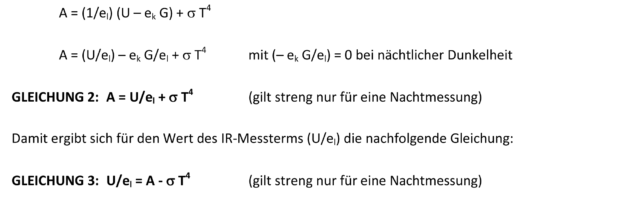

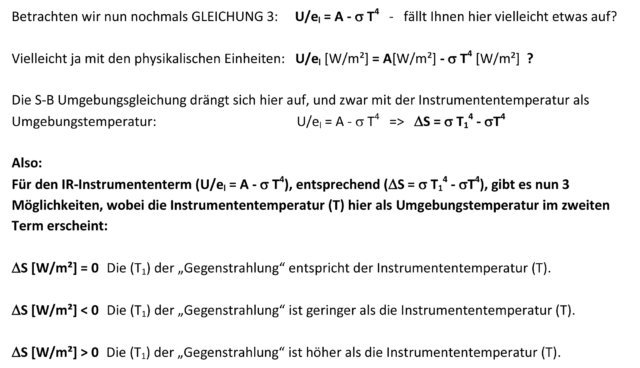

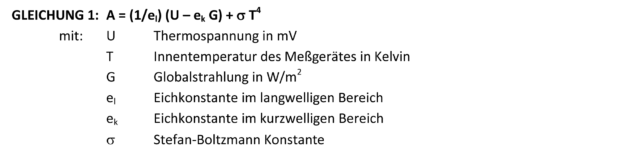

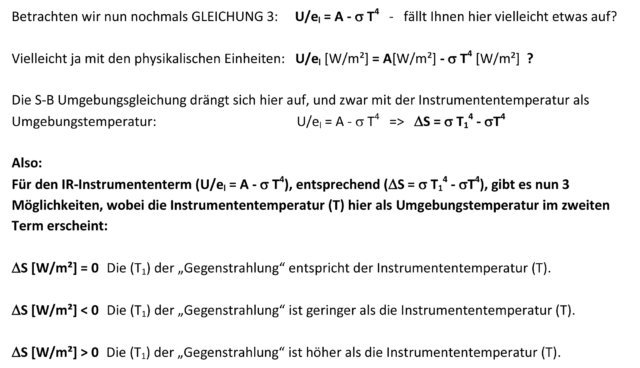

Schauen wir weiter, in Nr. 178 der „Berichte des Deutschen Wetterdienstes“ wird auf Seite 11, oben links, eine Formel zur Berechnung der Gegenstrahlung als Leistungsfluss „A“ in W/m^2 für die 1989 in der Station Hartheim am Rhein verwendete Messapparatur angegeben:

Die „gemessene“ Gegenstrahlung „A“ wird hier im Wesentlichen als Funktion der gemessenen langwelligen IR-Strahlung und der Instrumententemperatur dargestellt. Ohne die Kenntnis der ursprünglichen Messwerte „U“ und der beiden Eichkonstanten ist es schwer, eine direkt Aussage aus dieser Formel abzuleiten. Also müssen wir uns auf anderem Wege einem Verständnis nähern. Wie Abbildung 1 beweist, ist der gemessene langwellige (IR-) Anteil tagsüber wie auch nachts über 24h vorhanden, die direkte kurzwellige Sonneneinstrahlung ist dagegen nachts nicht wirksam. Wir überführen daher die Gleichung 1 in Gleichung 2 unter der Annahme, dass der Term für die Globalstrahlung bei der Messung der „Gegenstrahlung“ nachts keine Wirkung entfaltet, also:

Wenn wir nun auf die Abbildung 1 zurückgehen und den geringen Unterschied zwischen Tag und Nacht auf die Gegenstrahlung betrachten, dann ergibt sich für eine solche Messung das folgende Bild:

- Der Einfluss der direkten Sonneneinstrahlung auf die „Gegenstrahlung“ ist bei einem sehr geringen Temperaturgang am wolkenlosen Tag offenbar recht gut kompensiert worden und bei Nacht gar nicht vorhanden.

- Der Einfluss von langwelliger IR-Strahlung ist Tag und Nacht über die Thermospannung „U“ messbar.

- Der Term „SIGMA T4“, also der Einfluss der Instrumententemperatur, spiegelt sich dauerhaft Tag und Nacht im Messergebnis wider.

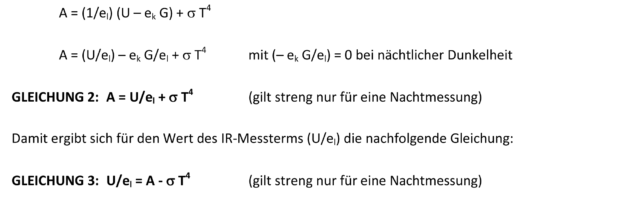

In der DWD-Abbildung 1 fehlt der Temperaturverlauf über die beiden dort dargestellten 24h-Tage. Da aber die Eigentemperatur „T“ des Messinstruments als ein wesentlicher Faktor in der Gleichung 1 erscheint, ergeben sich daraus erhebliche Unterschiede für die „gemessene“ Gegenstrahlung, je nachdem, ob es sich um ein beheiztes, gekühltes oder ein Instrument bei normal variabler Umgebungstemperatur handelt. In Tabelle 1 wurde der Messwert „U/el = A – T4“ für unterschiedliche Instrumententemperaturen „T“ aus der in Abbildung 1 dargestellten „gemessenen“ Gegenstrahlung „A“ hergeleitet:

Tabelle 1 gilt im Wesentlichen auch für Tagmessungen, soweit die jeweiligen DWD-Messergebnisse korrekt um den Einfluss der Globalstrahlung korrigiert wurden. Die Analyse aus dieser Tabelle ergibt nun eindeutig, dass es sich nicht um ein beheiztes Instrument handeln kann, weil dessen Messfähigkeit zu höheren Temperaturen stark eingeschränkt wäre; denn dieses Gerät kann nur eine Einstrahlung messen, deren S-B-Temperaturäquivalent höher als die eigene Temperatur ist. Selbst ein gekühltes Instrument würde nur eingeschränkt funktionieren und müsste zur Messung einer „Gegenstrahlung“ von 220W/m² unter -23,5°C gekühlt werden. Es wäre zu erwarten gewesen, dass insbesondere der wesentliche Term „U/el“, also die Geräte-Ausgangsspannung mit dem Ergebnis des langwelligen (IR-)Strahlungsanteils, einen primären und eindeutig definierten Beitrag zum Messergebnis liefern würde. Das ist offensichtlich nicht der Fall, denn das Ergebnis der Analyse aus Tabelle 1 legt nahe, dass das Messergebnis für die sogenannte „atmosphärische Gegenstrahlung“ in allen hier aufgezeigten Temperaturbereichen von der Instrumententemperatur (T=-18°C bis +15°C) majorisiert wird. So, und jetzt stellen Sie Sich als „Messinstrument“ einfach mal die Ordowski’sche Glasplatte vor, wo eine ca. 1 m über dem Boden angebrachte Glasplatte über den Tagesverlauf immer die gleiche Temperatur wie die umgebende Luft aufweist und sich nur dann noch weiter erhitzt, wenn sie nahe an den Erdboden abgesenkt wird…

WIDERSPRUCH 3: Wir stehen hier vor dem physikalischen Paradoxon, dass eine Messapparatur, die darauf ausgelegt ist, etwas WÄRMERES zu messen als ihre Eigentemperatur, tatsächlich auch etwas KÄLTERES gemessen haben will. Die Tabelle 1 beweist aber eindeutig, dass dieses Messinstrument nicht in der Lage ist, eine niedrigere Temperatur zu messen als die Instrumententemperatur „T“ selbst, denn solche Werte wären negativ.

Wie kommen wir nun aus dieser Nummer wieder heraus?

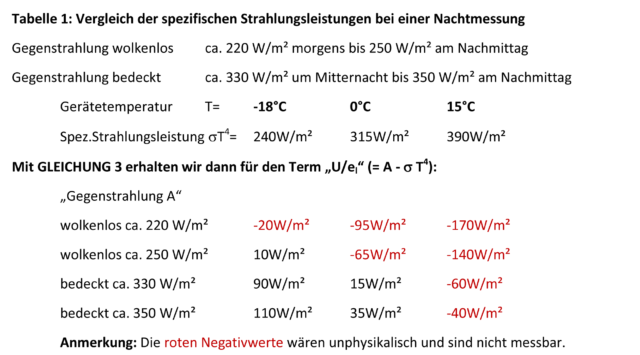

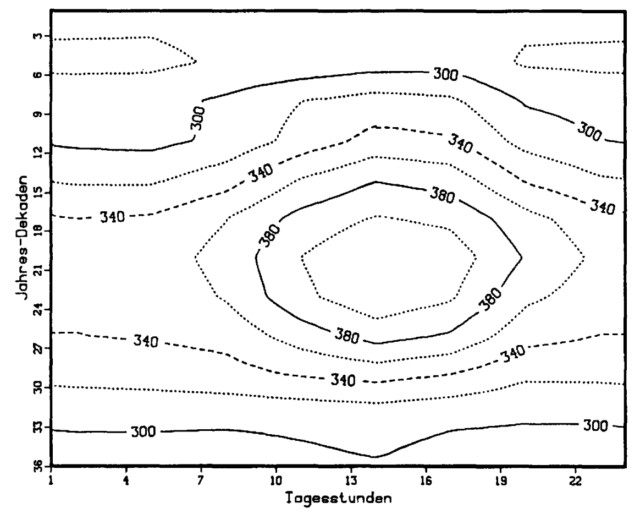

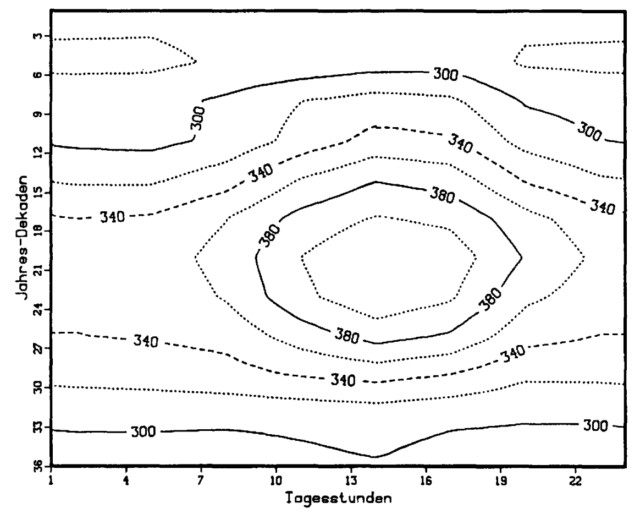

Schauen wir also einmal weiter. In Nr. 178 der „Berichte des Deutschen Wetterdienstes“ ist auf Seite 40 eine Isoplethendarstellung der über alle Wetterlagen gemittelten Bestrahlungsstärke der Gegenstrahlung abgebildet. Diese Darstellung bildet die Tageskurven der Gegenstrahlung im Verlauf des Jahres (hier in 10-Tages-Schritten) ab.

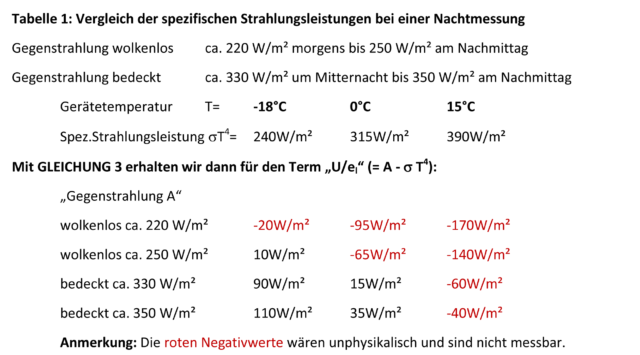

Abbildung 2: Isoplethendarstellung der über alle Wetterlagen gemittelten Gegenstrahlung (Quelle: DWD)

Dazu heißt es dort auf Seite 37 letzter Absatz rechts, Zitat: „Obgleich die Anwesenheit von Wolken verstärkend auf die Gegenstrahlung wirkt, kann daraus nicht geschlossen werden, dass bei bewölktem Wetter generell höhere Gegenstrahlungswerte auftreten. Ganz im Gegenteil liegen die absoluten (mittleren) Maxima mit 437 W /m2 Mitte Juli um 14 Uhr im Schönwettertyp und nahezu gleich beim Windtyp. Je stärker die Bewölkung eines Wettertyps wird, desto geringer wird tendenziell dieses Maximum. Lediglich bei Nebel wird diese Regel zugunsten etwas höherer Strahlung gebrochen. Zeitlich ist die Lage des jeweiligen Maximums bei allen Wetterlagen konstant am oben genannten Zeitpunkt, mit Ausnahme des Stratusschichttyps, wo der höchste Wert erst im August um 17 Uhr erreicht wird.“

Halten wir an dieser Stelle fest:

- Die über alle Wetterlagen gemittelte Bestrahlungsstärke der Gegenstrahlung an der Messstelle Hartheim liegt zwischen MIN= 280W/m² (nachts im Februar) und MAX=400W/m² (nachmittags in den Sommermonaten).

- Die absoluten (mittleren) Maxima der Gegenstrahlung liegen mit 437 W/m2 Mitte Juli um 14 Uhr im Schönwettertyp und entsprechen einem S-B-Temperatur-Äquivalent von 23,2°C.

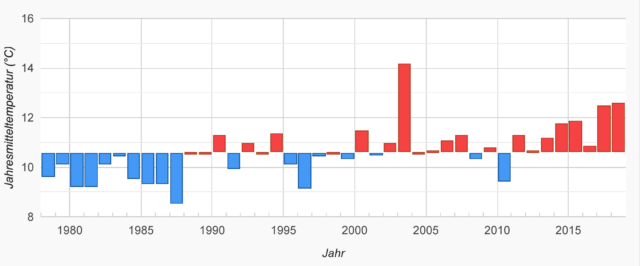

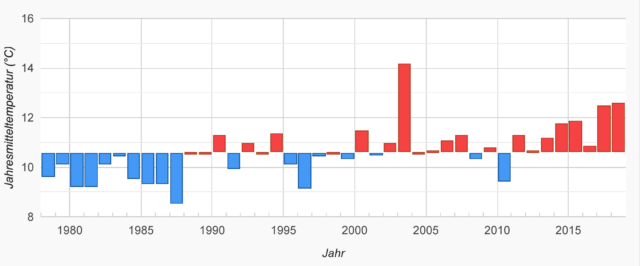

Die Messstelle Hartheim besteht heute als forstmeteorologische Meßstelle Hartheim der Albert-Ludwigs-Universität Freiburg fort. Auf der Internetseite meteo.uni-freiburg.de wird das Jahresmittel der Lufttemperatur (1978 -2018) für diese Messstelle mit 10,6°C angegeben:

Abbildung 3: Bildunterschrift „Die Entwicklung der Jahresmitteltemperatur an der forstmeteorologischen Messstelle Hartheim von 1978 bis 2018 relativ zum 41-jährigen Mittel 1978 – 2018. Rote Jahre waren überdurchschnittlich warm, blaue Jahre kühl.“ (Quelle: Forstmeteorologische Messstelle Hartheim – meteo.uni-freiburg.de)

An dieser Stelle halten wir also fest:

- Die Jahresmitteltemperatur an der Meßstelle Hartheim von 10,6°C entspricht einem S-B-Strahlungsäquivalent von 368W/m².

ANALYSE: Da hier nur gemittelte Werte zur Verfügung stehen, kann die nachfolgende Analyse nur eine grobe Annäherung an die tatsächlichen Gegebenheiten darstellen. Das S-B-Strahlungsäquivalent von 368W/m² für die Jahresmitteltemperatur von 10,6°C an der Meßstelle Hartheim entspricht der Bestrahlungsstärke der Gegenstrahlung im Sommerhalbjahr am Vormittag und am Abend, also im Anstieg und Abfall des Nachmittagsmaximums in Abbildung 2. Gleichzeitig liegt dieses S-B-Strahlungsäquivalent von 368W/m² ziemlich nahe an dem Mittelwert von 340W/m² zwischen MIN=280W/m² und MAX=400W/m² über den Jahresverlauf der Bestrahlungsstärke der Gegenstrahlung. Damit aber spielt die „gemessene“ Gegenstrahlung vom Betrag her in derselben Liga wie die Sonneneinstrahlung, allerdings anders als diese über den gesamten 24h-Tag. Die übertragene Wärmemenge wäre damit im groben Tagesdurchschnitt pro 24h:

Gegenstrahlung: 340W/m² * 24h = 29.376.000 Joule/m²

Sonneneinstrahlung: 368W/m² * 12h* = 15.897.600 Joule/m²

*) Tentativer Durchschnittswert über das Jahr

WIDERSPRUCH 4: Wir stellen also in grober Näherung fest, dass die Wärmezufuhr durch die sogenannte Gegenstrahlung an der Meßstelle Hartheim den Einfluss der Sonne um nahezu das Doppelte übertreffen soll. Dieses Ergebnis ist insofern eigenartig, als ja nach der vorherrschenden Klimatheorie die sogenannte Gegenstrahlung selbst erst durch die Wärmewirkung der Sonneneinstrahlung erzeugt werden soll.

- Wir halten an dieser Stelle weiterhin fest, dass die wichtigsten Treibhausgase in der Reihenfolge ihrer Wirksamkeit der Wasserdampf, Kohlendioxid, Ozon, Methan und Distickstoffoxid sind.

Daraus folgt mein finaler Lösungsansatz für das Phänomen „atmosphärische Gegenstrahlung“:

Die sogenannten „Treibhausgase“ sind Gase, und auch noch durchsichtig, ihre Moleküle bewegen sich in großem Abstand voneinander und füllen den verfügbaren Raum gleichmäßig aus. Deren Klimawirkung soll auf der Aufnahme der terrestrischen IR-Abstrahlung beruhen, mit der wiederum die atmosphärische Gegenstrahlung befeuert werden soll. Der wesentliche Unterschied in der Gegenstrahlung an beiden Tagen der DWD-Abbildung 1 liegt aber zwischen einem wolkenlosen und einem bedeckten Himmel, also zwischen dem gasförmigen und dem flüssigen Aggregatzustand von Wasser. Und im flüssigen Aggregatzustand hat Wasser gegenüber gesättigtem Wasserdampf eine doppelt so hohe Wärmekapazität, also eine erhöhte Speicherfähigkeit für Wärme; gegenüber trockener Luft erhöht sich dieses Verhältnis sogar auf einen Faktor von etwa vier. Abbildung 1 beweist also, dass die sogenannten Treibhausgase bei der Bestrahlungsstärke der atmosphärischen „Gegenstrahlung“ bestenfalls eine untergeordnete Rolle spielen. Denn die Zusammensetzung der gut durchmischten gasförmigen Bestandteile der umliegenden Atmosphäre an der Meßstelle Hartheim dürfte sich zwischen den beiden DWD-Tagesgängen „wolkenlos“ und „bedeckt“ bis auf Menge und Aggregatzustand des Wassers nicht wesentlich verändert haben.

WIDERSPRUCH 5: Wenn dort beim DWD also überhaupt etwas gemessen worden sein sollte, dann war es wohl nicht die „atmosphärische Gegenstrahlung“ von IR-aktiven „Klimagasen“, sondern eher der Wärmeinhalt einer Zusammenballung von Wassertröpfchen, die man gemeinhin als „Wolken“ zu bezeichnen pflegt und die der Meßstelle Hartheim durch Advektion und Kondensation offenbar zusätzliche Wärme zugeführt hatten.

Im Ergebnis hat es den Anschein, als dass die an der Meßstelle Hartheim gemessene „Bestrahlungsstärke der Gegenstrahlung“ den jahreszeitlichen Beitrag von Advektion und Kondensation auf die Ortstemperatur spiegeln würde. Im Umkehrschluss dürften also die dort dargestellten Werte sehr viel eher die Temperatur von Messgerät und unmittelbarer Umgebung wiedergeben als einen unabhängigen Wert für die sogenannte Gegenstrahlung.

Wolken treten in meinem hemisphärischen S-B-Modell unter den Stichworten „Advektion“ als „fliegende Wärmflaschen“ auf, aber auch die „Kondensation“ erzeugt Wärme vor Ort, was ein befreundeter Segelflieger folgendermaßen beschrieben hatte, Zitat:

„… nachts ist die Luft oft sehr ruhig. Dadurch ist lokale Wolkenbildung möglich, an den Grenzschichten unterschiedlicher Luftzusammensetzung, die sich nur ungern vermischen. Die Dicke bzw. Dichte dieser Wolken nimmt in der Regel gegen Morgen hin zu, sodass die Masse an ‚Materie‘ zunehmend ist. Dass dem so ist beweisen manchmal auftretende lokale morgendliche Regenfälle, wenn diese Ruhewolken das ‚Wasser nicht mehr halten‘ können. Sobald durch Sonneneinstrahlung etwas Bewegung in die Atmosphäre kommt verschwinden diese Wolken genauso lokal wie sie entstanden sind und man hat die Chance auf einen herrlichen Tag…“

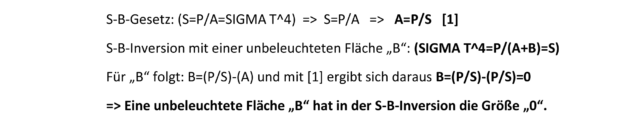

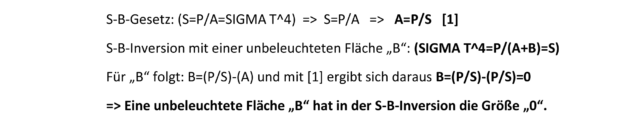

ERGO: Wir haben heute keine Angst mehr, von der „Erdscheibe“ herunterzufallen. Wir glauben heute nicht mehr, die Erde stünde im Mittelpunkt des Universums. Aber wir glauben, die spezifische Strahlungsleistung einer „atmosphärischen Gegenstrahlung“ zu messen und damit ein unzureichendes 2-dimensionales Klimamodell für unsere Erde zu bestätigen. Man könnte also sagen, dass die sogenannte „atmosphärische Gegenstrahlung“ die Rache der Mathematik für eine fehlerhafte physikalische Faktor4-Stefan-Boltzmann-Inversion ist, BEWEIS:

ERGEBNIS: Es gibt im streng „gleichzeitigen“ Stefan-Boltzmann-Gesetz keine Flächen (B), die nicht zur Strahlungsleistung (P) des Schwarzkörpers beitragen. Daher sind auch keine unbeleuchteten Flächen (B) in einer „gleichzeitigen“ S-B-Inversion erlaubt. Physikalisch „gleichzeitig“ bedeutet übrigens auch nicht, dass unterschiedliche „Gleichzeitigkeiten“ in einer einzigen S-B-Berechnung aufaddiert und gemittelt werden dürften. Damit ist eine globale Faktor4-Tag=Nacht-THE-Flacherde-Inversion der Solarkonstanten physikalisch nicht statthaft.

Versuchen Sie einfach mal den Gegenbeweis: Wenn Sie die Oberfläche eines Fußballs vollständig* mit einer Taschenlampe beleuchten können, dann wäre der Faktor4-Ansatz bewiesen.

*) Hinweis für die Sophisten unter den geschätzten Kommentatoren: Dieses Beispiel unterstellt Gleichzeitigkeit mit einer einzigen Taschenlampe ohne weitere Hilfsmittel, wie Sie das beispielsweise mit der Sonne als „Taschenlampe“ im Wechsel von Tag und Nacht auf der Erde beobachten können; aber vielleicht versuchen Sie’s einfach mal mit einer Rotationsgeschwindigkeit größer 300.000 km/s…