Alles war ein ungeheurer Fehler. Die Befürchtungen über eine gefährliche globale Erwärmung ergaben sich aus einem schwerwiegenden Fehler der Physik aus dem Jahr 1984. Niemand hatte es bisher bemerkt, weil die Klimawissenschaftler die Rückkopplungsmathematik aus der Kontrolltheorie, einem anderen Zweig der Physik, übernommen hatten, ohne sie zu verstehen. Die Kontrolltheoretiker, deren Wissenschaft die Klimatologen ausgeliehen hatten, hatten nicht erkannt, wie sie missbraucht worden war.

Ein internationales Team hervorragender Klimatologen und Kontrolltheoretiker, das von Christopher Monckton aus Brenchley zusammengestellt wurde, verbrachte Jahre mit der Jagd nach dem Fehler. Ihre 70-seitige wissenschaftliche Arbeit errechnet, dass die vom Menschen verursachte globale Erwärmung nach Korrektur des Fehlers nur ein Drittel dessen betragen wird, was die Klimawissenschaftler vorhergesagt hatten.

Es wird zu wenig globale Erwärmung geben, um uns zu schaden. Eine kleine, langsame Erwärmung wird insgesamt eine gute Sache sein. Es gibt keinen Klima-Notstand. Den hat es nie gegeben. Die Billionen, die für die Vernichtung von Arbeitsplätzen und Industrien verschwendet wurden, können jetzt für die vielen echten Umweltprobleme der Welt ausgegeben werden. Die globale Erwärmung gehört nicht dazu.

EINIGE DEFIITIONEN: Emissions-Temperatur angetrieben durch die Wärme der Sonne, an der Oberfläche ohne Treibhausgase in der Luft erhalten würde. Die Rückkopplungsreaktion ist eine zusätzliche Erwärmung, vor allem durch mehr Wasserdampf in der wärmeren Luft, ausgelöst durch direkte Erwärmung (z.B. durch CO2). Die solare Rückkopplungsreaktion wird durch die Emissionstemperatur ausgelöst. Zu den nicht kondensierenden Treibhausgasen gehören CO2, Methan, Ozon, Distickstoffoxid und FCKW, nicht aber Wasserdampf. Der natürliche Treibhauseffekt ist die Differenz zwischen der Emissionstemperatur und der Temperatur im Jahre 1850, als das Industriezeitalter begann. Die Gleichgewichts-Klimasensitivität (ECS) ist letztlich die endgültige Erwärmung durch verdoppeltes CO2.

Infolge des Fehlers waren die Klimawissenschaftler davon ausgegangen, dass, obwohl nur etwa 1 °C – also ein Viertel der globalen Erwärmung, die sie durch die Verdoppelung des CO2 in der Luft vorhersagten – direkt von dem hinzugefügten CO2 herrührte, zu dieser direkten Erwärmung weitere 3 °C zusätzliche Erwärmung kommen würden, die als Rückkopplungsreaktion bezeichnet wird, hauptsächlich durch mehr Wasserdampf – ein Treibhausgas – der in die durch CO2 erwärmte Luft verdunstete.

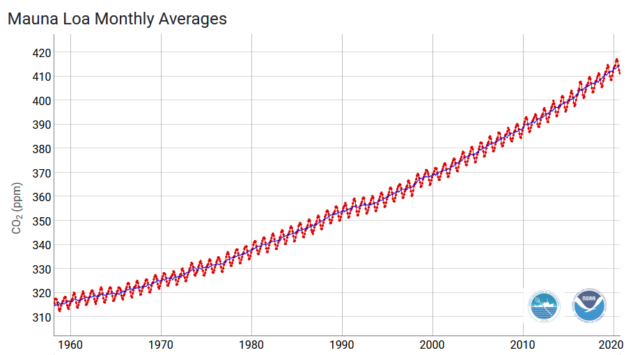

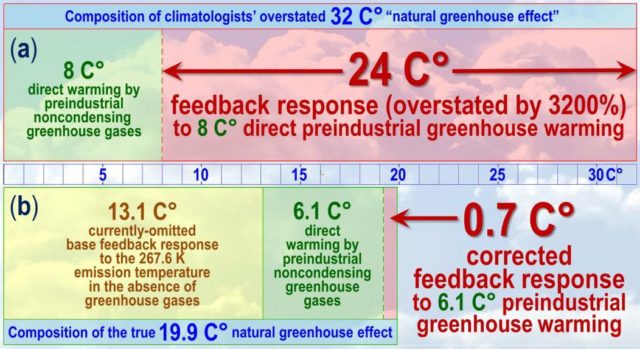

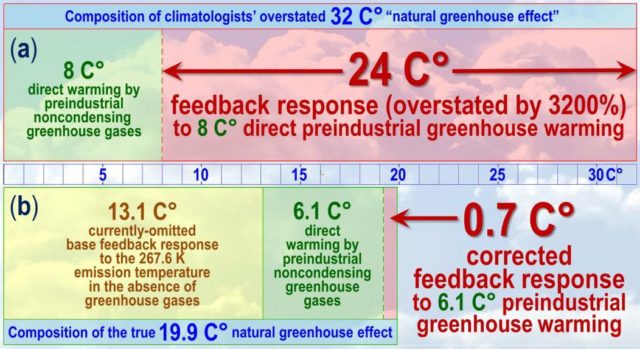

Sie hatten angenommen, dass der natürliche Treibhauseffekt – die Differenz zwischen der Emissionstemperatur an der Oberfläche ohne Treibhausgase und der Oberflächentemperatur im Jahr 1850, zu Beginn des Industriezeitalters – 32 °C betrug. Davon hatten sie 8 °C für eine direkte Erwärmung durch die vorindustriellen Treibhausgase gehalten mit den verbleibenden 24 °C als Rückkopplung (Abb. 1a).

Abbildung 1: (a) irrige und (b) korrigierte Darstellung des natürlichen Treibhauseffektes

Die direkte Erwärmung durch verdoppeltes CO2 beträgt nur etwa 1°C, was nach irrtümlicher Vorstellung der Klimawissenschaftler eine Rückkopplung von 3°C auslösen wird, so dass 1°C direkte Erwärmung zu einer Enderwärmung von 4°C wird.

Sie hatten zwei Fehler gemacht, einen kleinen und einen sehr großen. Ihr kleiner Fehler: Sie hatten vergessen, dass es ohne Treibhausgase in der Luft keine Wolken gäbe, welche die Sonnenstrahlung wie ein Spiegel harmlos in den Weltraum reflektieren würden. Die wahre Emissionstemperatur – die Temperatur, die an der Oberfläche herrschen würde, wenn sich anfangs keine Treibhausgase in der Luft befänden – wäre etwa 12 °C größer als von ihnen berechnet. Der wahre natürliche Treibhauseffekt war also nicht 32 °C, sondern 12 °C kleiner, bei nur 20 °C.

Ihr sehr großer Fehler: Sie haben vergessen, dass die Sonne scheint. Denn fast die gesamte vorindustrielle Rückkopplung bis 1850 – die zusätzliche Erwärmung, von der sie alle dachten, sie sei durch nicht kondensierende Treibhausgase (andere Gase als Wasserdampf) ausgelöst worden – wurde in Wirklichkeit nicht durch diese Gase, sondern durch die Wärme der Sonne ausgelöst. Tatsächlich fügten sie hinzu, dass die solare Rückkopplung als Teil der vorindustriellen Treibhausgas-Rückkopplung, die sie um 3200% überbewertet hatten, falsch berechnet wurde.

Die Argonauten berechnen, dass von den echten 19,9 °C des natürlichen Treibhauseffekts (Abb. 1b) 13,1 °C eine Rückkopplung auf die durch die Sonnenwärme getriebene Emissionstemperatur waren (solare Rückkopplung). Nur 0,7 °C war eine vorindustrielle Rückkopplung auf die 6,1 °C direkte Erwärmung durch Treibhausgase.

Die 24 °C Rückkopplung der Klimawissenschaftler war um das 33-fache zu groß. Deshalb haben sie die Rückkopplung nicht nur der direkten vorindustriellen Erwärmung der Treibhausgase überbewertet, sondern auch die direkte Erwärmung im industriellen Zeitalter, die weitgehend durch unsere eigenen Treibhausgasemissionen von 1850-2020 verursacht wurde.

Die Auswirkungen der Überbewertung durch die Klimawissenschaftler waren gravierend. Die Argonauten sind der Ansicht, dass aufgrund des Irrtums die gegenwärtig vorhergesagte vom Menschen verursachte globale Erwärmung etwa dreimal zu groß ist. Eine Korrektur beendet die Krise.

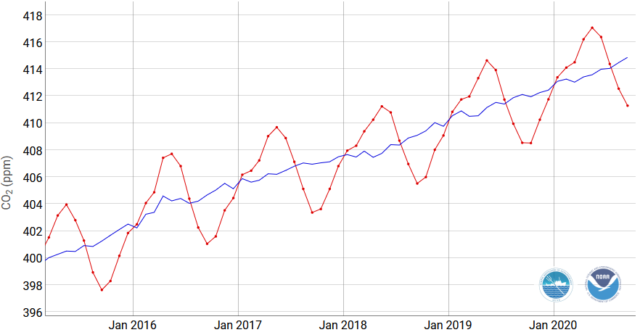

Klimawissenschaftler hatten weit mehr globale Erwärmung prophezeit als tatsächlich eingetreten ist

In der Wissenschaft ist jede Theorie – wie schön oder gewinnbringend sie auch sein mag – falsch und muss geändert oder sogar ersetzt werden, wenn Daten aus der realen Welt ihr widersprechen. Die große Diskrepanz zwischen vorhergesagter und realer Erwärmung in den letzten Jahrzehnten hat in der Tat gezeigt, dass mit der offiziellen Theorie etwas sehr falsch sein muss.

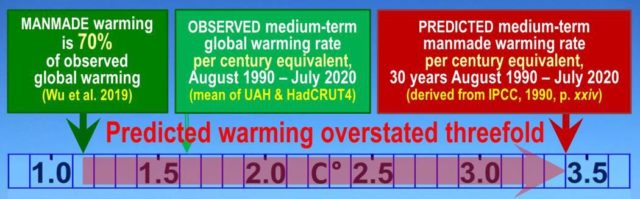

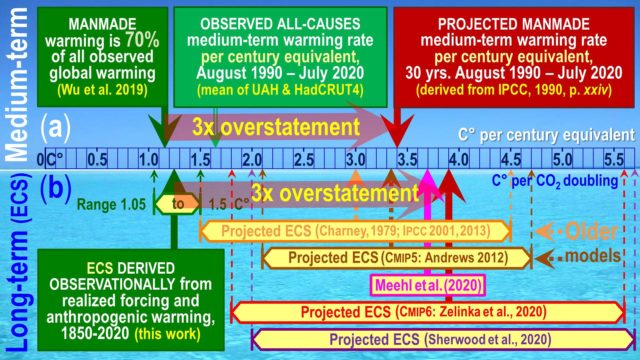

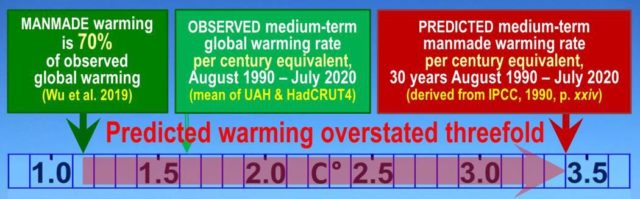

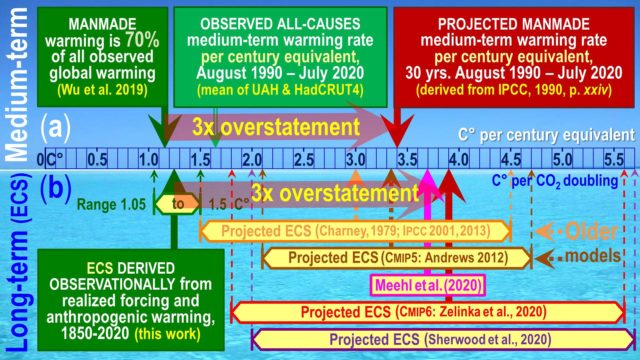

IPCC (1990, S. xxiv) hatte zuversichtlich eine mittelfristige, vom Menschen verursachte Erwärmung von 3,4 °C pro Jahrhundert vorhergesagt. Die gemessene vom Menschen verursachte globale Erwärmung von 1990-2020 entsprach jedoch nur 1,15 °C pro Jahrhundert (Abb. 2).

Abbildung 2: Mittelfristige projizierte im Vergleich zu vom Menschen verursachten Erwärmungsraten, 1990 bis 2020

Die vom IPCC vorhergesagte mittelfristige vom Menschen verursachte Erwärmung hat sich als um das Dreifache zu groß erwiesen. Diese enorme Glaubwürdigkeitslücke zwischen Vorhersage und realem Wandel stimmt mit den Berechnungen der Argonauten überein.

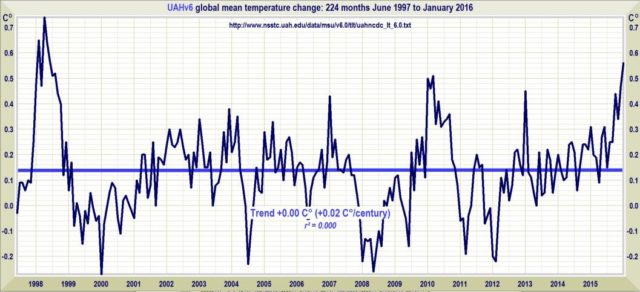

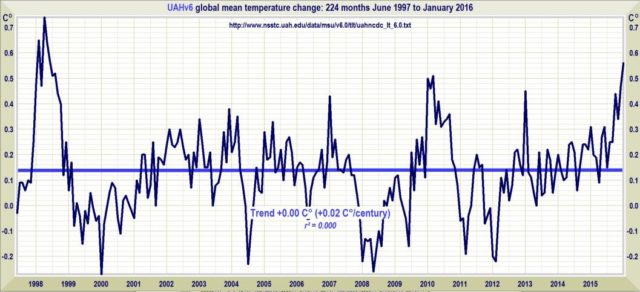

Die Klimamodelle hatten auch die fast 19-jährige Pause der Erwärmung von 1997-2015 nicht vorhergesagt (Abb. 3). Gegen Ende dieses Zeitraums, als ein Drittel unseres Klimaeinflusses eingetreten war, aber keine Erwärmung eingetreten war, ersetzte das IPCC die Modellprojektionen durch sein „Expertenurteil“ und kürzte seine mittelfristigen Vorhersagen stark ab.

Abbildung 3: Keine Erwärmung während der 18 Jahre von Juli 1997 bis Januar 2016 (UAH)

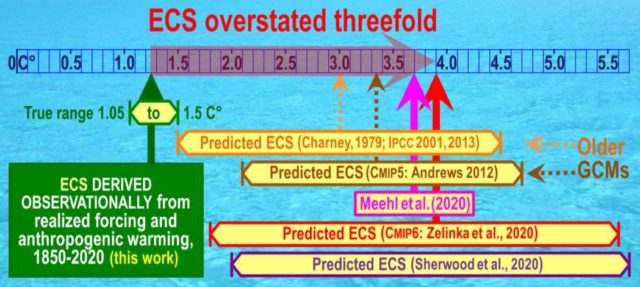

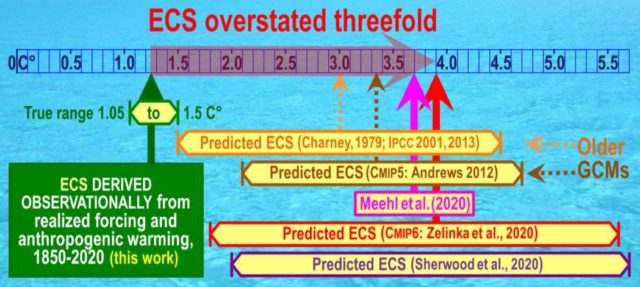

Widersprüchlicherweise hat der IPCC nicht auch seine langfristige globale Erwärmungsvorhersage reduziert, die trotz Milliardenausgaben für die Klimaforschung bei 1,5-4,5 °C pro CO2-Verdoppelung bleibt. Diese Vorhersage ist seit dem Charney-Bericht (1979) vor mehr als 40 Jahren unverändert geblieben. Sie war und ist übertrieben.

Wie der Nobelpreisträger und Physiker Richard Feynman zu sagen pflegte: „Wenn Experimente mit der Theorie nicht übereinstimmen, ist die Theorie falsch. In dieser einfachen Aussage liegt der Schlüssel zur Wissenschaft.“ Vorhersagen über die globale Erwärmung stimmen nicht mit beobachteten und gemessenen Temperaturänderungen in der realen Welt überein. Die Korrektur des Fehlers löst diese Diskrepanz auf.

Wie der Fehler zustande kam: Klimawissenschaftler hatten übersehen, dass die Sonne scheint

Die Entstehungsgeschichte des Fehlers ist interessant. Zu Beginn des 20. Jahrhunderts hatten Arrhenius (1906) und Callendar (1938) vorausgesagt, dass die endgültige Erwärmung durch verdoppeltes CO2 in der Luft etwa 1,5 °C betragen würde. Obwohl die Rückkopplungstheorie damals noch in den Kinderschuhen steckte, waren ihre Schätzungen mehr oder weniger korrekt.

Eine der frühesten Arbeiten, die die mathematischen Grundlagen der Rückkopplungstheorie legten, war Black (1934). Eines Morgens im Jahr 1927 befand sich Harold S. Black auf dem Weg zur Arbeit in den Bell Labs in Manhattan, wo er Verfahren zur Reduzierung des Lärms auf Ferngesprächsleitungen entwickelte. Die Gleichungen für Rückkopplungen in dynamischen Systemen kamen ihm in den Sinn, und er notierte sie in der Zeitung jenes Tages, die bis heute im Bell Labs Museum ausgestellt ist.

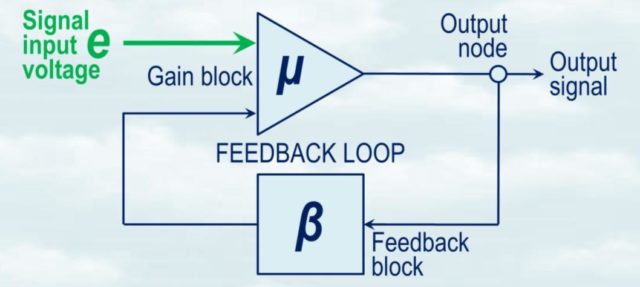

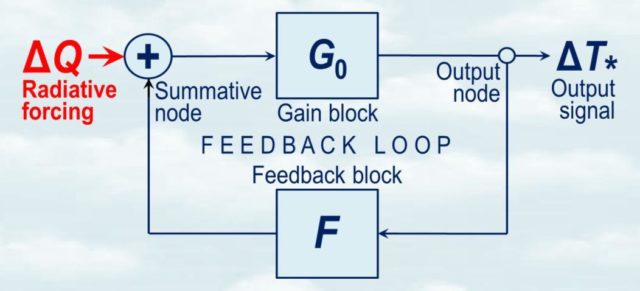

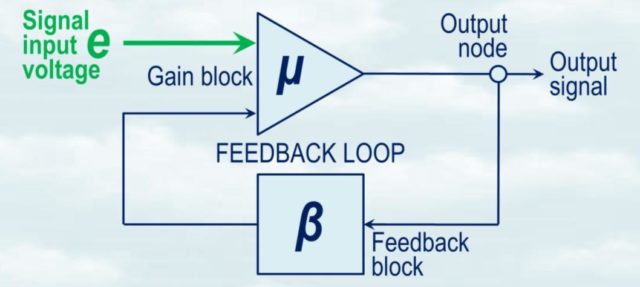

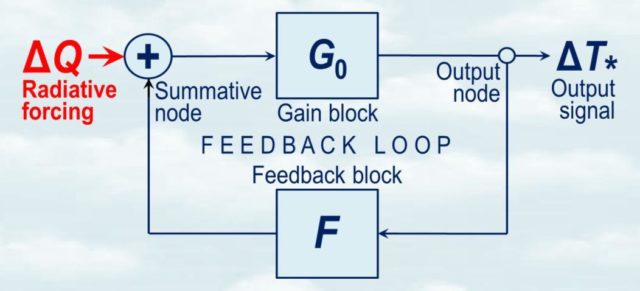

Die rückgekoppelte Verstärkerschaltung von Black (Abb. 4) zeigt nicht nur den μ Verstärker (im Klima, direkte Erwärmung durch Treibhausgase) und den β Rückkopplungsblock, sondern auch das Eingangssignal e (die durch die Sonnenwärme getriebene Emissionstemperatur bei Abwesenheit von Treibhausgasen). Das Papier von Black nennt e die „Signaleingangsspannung“.

Die Klimawissenschaftler hatten nicht erkannt, dass man keinen Verstärker ohne ein zu verstärkendes Eingangssignal haben kann.

Der Verstärkungsblock μ im Blockdiagramm von Black (Abb. 4) verstärkt das Eingangssignal e, so wie die direkte Treibhausgas-Erwärmung die Emissionstemperatur verstärkt. Der β-Rückkopplungsblock erzeugt eine Rückkopplung nicht nur auf den μ-Verstärkungsblock (direkte Treibhausgas-Erwärmung), sondern auch auf das Eingangssignal e.

Abbildung 4: R+ckkopplungs-Verstärkungs-Blockdiagramm, welches das Eingangssignal e zeigt, also die Nicht-Treibhausgas-Emissionstemperatur, welche die Klimawissenschaftler übersehen hatten.

Wenn man die große solare Rückkopplung übersieht, addiert man sie effektiv zu der eigentlich winzigen vorindustriellen Rückkopplung auf die direkte Erwärmung durch nicht kondensierende Treibhausgase (wie CO2, Methan, Distickstoffoxid und Ozon, denn Änderungen in der Konzentration des wichtigsten kondensierenden Treibhausgases, Wasserdampf, werden als Rückkopplung behandelt) und zählt sie falsch. Diese falsche Zuordnung bläht die Rückkopplung auf die Treibhauserwärmung auf und führt dazu, dass Klimawissenschaftler die globale Erwärmung überbewerten. Die Klimawissenschaftler hatten vergessen, dass die Sonne scheint und ihre eigene substanzielle Rückkopplung antreibt.

1945 schrieb Harold Blacks Kollege bei Bell Labs, Hendrik Wade Bode, das Standard-Lehrbuch über das Design von Rückkopplungsverstärkern. Es erwies sich als so populär, dass es 30 Jahre lang jährlich veröffentlicht wurde.

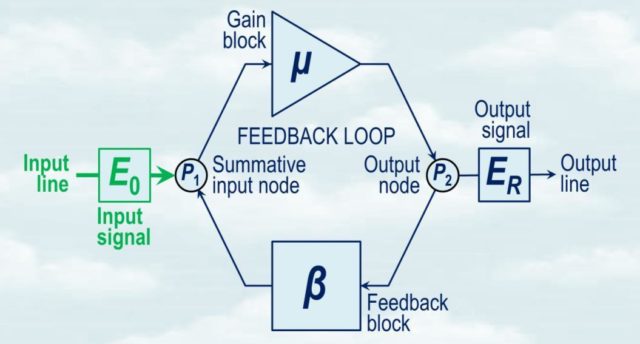

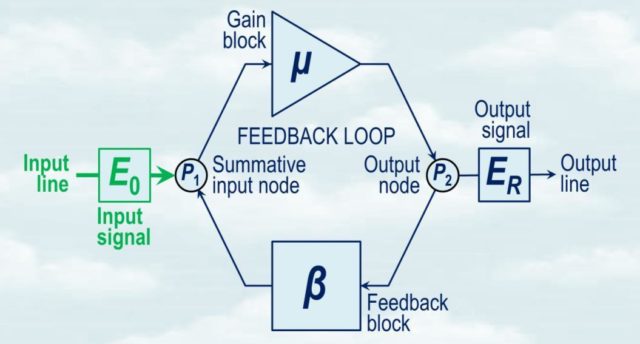

Das Blockschaltbild des Rückkopplungs-Verstärkers (Bild 5) ist praktisch identisch mit dem von Black. Hier ist E0 das Eingangssignal, dessen große Rückkopplung Klimawissenschaftler irrtümlicherweise zur Rückkopplung der direkten Erwärmung durch Treibhausgase addieren hatten.

Abbildung 5: Blockdiagramm des Rückkopplungsverstärkers (Bode, 1945), welches das Eingangssignal E0 (in Klima, Emissionstemperatur) zeigt, das die Klimawissenschaftler übersehen hatten, wodurch versehentlich die solare Rückkopplung zur Rückkopplung der direkten Erwärmung durch vorindustrielle, nicht kondensierende Treibhausgase addiert wurde.

1945 schrieb Harold Blacks Kollege bei Bell Labs Hendrik Wade Bode das Standardlehrbuch über die Konstruktion von Rückkopplungsverstärkern. Es erwies sich als so populär, dass es 30 Jahre lang jährlich veröffentlicht wurde.

Das Blockschaltbild des Rückkopplungs-Verstärkers (Abb. 5) ist funktionell identisch mit dem von Black. Hier ist E0 das Eingangssignal, dessen große Rückkopplung Klimawissenschaftler irrtümlicherweise zur Rückkopplung der direkten Erwärmung durch Treibhausgase addiert hatten.

Leider zitierten die Klimaforscher Bodes Buch, ohne es jedoch zu verstehen, gerade in dem Moment, als die Digitalisierung die Bedeutung der Rückkopplungstheorie geschmälert hatte. So schrieb zum Beispiel Hansen (1984):

„Wir verwenden Verfahren und Terminologie von Rückkopplungsstudien in der Elektronik (Bode, 1945), um die Beiträge verschiedener Rückkopplungsprozesse analysieren zu können. Wir definieren die Systemverstärkung als das Verhältnis des Netto-Rückkopplungsanteils der Temperaturänderung zur gesamten Temperaturänderung“.

Hier beschreibt Hansen fälschlicherweise den Rückkopplungsanteil (den Anteil der End- oder Gleichgewichtstemperatur oder Erwärmung, der durch die Rückkopplung dargestellt wird) als „Systemverstärkung“. Der Systemverstärkungsfaktor ist eigentlich die Größe, mit der die direkte Temperatur oder Erwärmung vor der Rückkopplung multipliziert wird, um die End- oder Gleichgewichtstemperatur oder -erwärmung zu erhalten, nachdem die Rückkopplung gewirkt und das Klima wieder ins Gleichgewicht gebracht hat.

Hansens schwerwiegenderer Fehler ist jedoch nicht der einer bloßen Nomenklatur. Er versäumt es, die solare Rückkopplung zu erwähnen, geschweige denn sie zu erklären. Deshalb stellt er sich vor, dass die direkte Erwärmung von wenig mehr als 1 °C durch das verdoppelte CO2 in der Luft zu einer schlussendlichen oder Gleichgewichtserwärmung von etwa 4 °C wird, so wie es Lacis et al., Hansens Kollegen am NASA Goddard Institute for Space Studies, in den Jahren 2010 und 2013 getan haben und so wie es heutige Modelle tun (z.B. Zelinka et al., 2020, Sherwood et al., 2020).

Schlesinger (1988) verschlimmerte Hansens Fehler und zementierte ihn. Sein Rückkopplungs-Blockdiagramm (Abb. 6) zeigt Verstärkungs- und Rückkopplungsblöcke, aber wie Hansen berücksichtigte er weder die Emissionstemperatur noch ihre große Rückkopplung, die er effektiv als Teil der Rückkopplung auf die direkte Erwärmung durch die vorindustriellen, nicht kondensierenden Treibhausgase falsch berechnet hat.

Abbildung 6: Fehlerhaftes Rückkopplungs-Blockdiagramm (Schlesinger 1988). Das Eingangssignal, die Emissionstemperatur, ist nicht vorhanden. Schlesinger impliziert somit, dass die große solare Rückkopplung darauf Teil der eigentlich winzigen Rückkopplung auf die vorindustrielle direkte Erwärmung durch nicht kondensierende Treibhausgase ist.

So stellte sich Schlesinger vor, dass der Rückkopplungsanteil – der Anteil der End- oder Gleichgewichtserwärmung, der durch die Rückkopplung repräsentiert wird – bis zu 71% betragen würde, ähnlich wie die 75% in Lacis et al.

1988 sagte Hansen vor dem US-Senat aus und prophezeite eine sehr schnelle globale Erwärmung. Seine Vorhersagen waren jedoch in seinem Irrtum verwurzelt. In jenem Jahr wurde das IPCC ins Leben gerufen. Sein Erster Sachstandsbericht sagte 1990, ebenfalls aufgrund des Irrtums, mittelfristig dreimal so viel globale Erwärmung voraus als während der folgenden 30 Jahre bis heute eingetreten ist (Abb. 2). Sein fünfter und jüngster Sachstandsbericht (IPCC 2013, S. 1450) definierte die Klima-Rückkopplung so:

„Klima-Rückkopplung: Eine Wechselwirkung, bei der eine Störung in einer Klimagröße eine Änderung in einer zweiten bewirkt und die Änderung der zweiten Größe letztlich zu einer zusätzlichen Änderung der ersten führt. Eine negative Rückkopplung ist eine Rückkopplung, bei der die anfängliche Störung durch die von ihr verursachten Änderungen abgeschwächt wird; eine positive Rückkopplung ist eine Rückkopplung, bei der die anfängliche Störung verstärkt wird … die Klimagröße, die gestört wird, ist die globale mittlere Oberflächentemperatur, die wiederum Änderungen des globalen Strahlungshaushalts verursacht. … Die anfängliche Störung … kann von außen erzwungen werden oder als Teil der internen Variabilität auftreten“.

Die IPCC-Definition spiegelt nicht die in der Kontrolltheorie inzwischen fundierte Tatsache wider, dass das Eingangssignal – in Klima, Emissionstemperatur – selbst eine große solare Rückkopplung erzeugt.

Das IPCC verfügt über ein Fehlerbericht-Erstattungsprotokoll, zu dessen Annahme er von seinen Mitgliedsstaaten verpflichtet worden war, nachdem es eine Reihe von peinlichen Fehlern veröffentlicht hatte. Nach diesem Protokoll wurde der vorliegende Fehler dem IPCC gemeldet. Das IPCC weigerte sich jedoch sogar, den Erhalt des Fehlerberichts zu bestätigen, obwohl er zweimal an mehrere IPCC-Beamte und an das Sekretariat geschickt wurde. Nun, da der Fehler ans Licht gekommen ist, wird das IPCC nicht mehr benötigt.

Konsequenzen des Fehlers

Die direkteste Folge des Fehlers ist, dass, wenn die Emissionstemperatur weggelassen wird (Abb. 6-7), die große solare Rückkopplung fälschlicherweise zur eigentlich winzigen vorindustriellen Rückkopplung auf die direkte Erwärmung durch Treibhausgase addiert und entsprechend falsch gezählt wird.

Abbildung 7: Klimawissenschaftler stellen sich vor, dass 8°C direkte Erwärmung durch vorindustrielle, nicht kondensierende Treibhausgase eine Rückkopplung von 24°C bewirkten. Ihr Systemverstärkungsfaktor beträgt also 32 / 8 oder 4: Mit anderen Worten, sie multiplizieren jede direkte vom Menschen verursachte Erwärmung mit etwa 4, um die endgültige Erwärmung zu erhalten. Da die direkte Erwärmung als Reaktion auf das verdoppelte CO2 in der Luft etwa 1°C beträgt, sagen heutige Modelle nach Berücksichtigung der Rückkopplung eine mögliche Erwärmung von etwa 4°C voraus.

Das Team korrigierte diesen Fehler und berechnete, dass man die 6,1 °C direkte Erwärmung durch die vorindustriellen, nicht kondensierenden Treibhausgase nicht mit einem Systemgewinnfaktor von 32 / 8 oder 4 multiplizieren sollte, wie es Klimawissenschaftler tun. Stattdessen sollte man sie mit einem Systemverstärkungsfaktor von 6,8 / 6,1 oder nur mit 1,11 multiplizieren. Da sich die Erwärmung mit zunehmender Oberflächentemperatur ein wenig beschleunigt, wird aus dem Faktor 1,11 heute etwa 1,19.

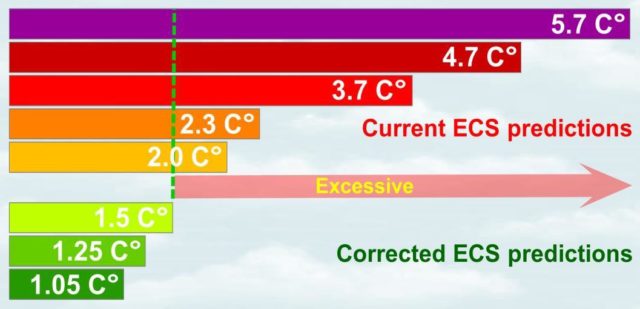

Daher wird die direkte globale Erwärmung von 1,06 °C als Reaktion auf die Verdoppelung des CO2-Gehalts in der Luft zu einer Enderwärmung von nur 1,19 x 1,06, also nur 1,25 °C.

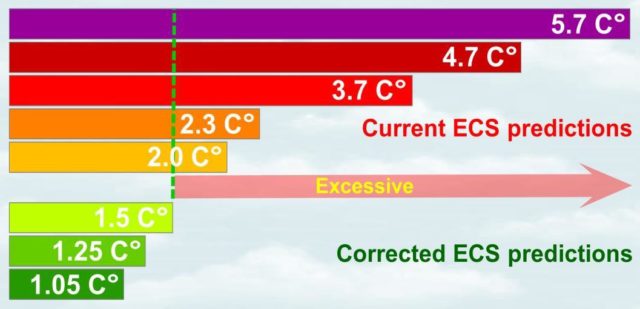

Die globale Erwärmung wird also weniger als ein Drittel der 4 °C betragen, die sich die Klimaforscher vorgestellt hatten.

Abb. 8 vergleicht die korrigierte Erwärmung mit aktuellen Vorhersagen.

Abbildung 8: Korrigierte Enderwärmung im Vergleich zu den Vorhersagen der Klimatologen.

Abb. 1 und 8 können kombiniert werden, um Abb. 9 zu erhalten, die die signifikante Kohärenz zwischen (a) der dreifach überhöhten Vorhersage der Klimawissenschaftler von 1990 über die mittelfristige, vom Menschen verursachte globale Erwärmung bis 2020 im Vergleich zur realen Erwärmung und (b) der dreifach überhöhten Vorhersage der Klimawissenschaftler von 1990 über die langfristige, endgültige Erwärmung durch verdoppeltes CO2 im Vergleich zu den korrigierten 1,25 °C zeigt.

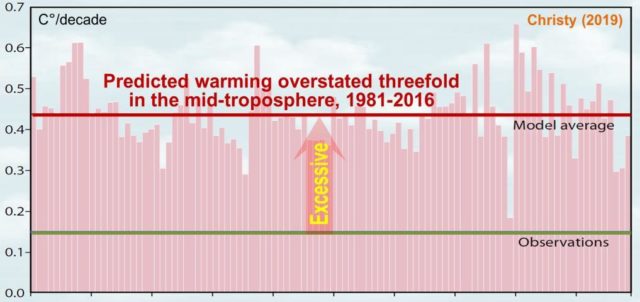

Später wird sich auch zeigen, dass diese dreifach überhöhten Vorhersagen der mittel- und langfristigen globalen Erwärmung mit der dreifach überhöhten Vorhersage der mittelfristigen Erwärmung der tropischen Mitteltroposphäre über die letzten Jahrzehnte zusammenhängen (Abb. 19).

Die von den Argonauten nach Korrektur des physikalischen Fehlers der Klimaforscher abgeleitete Enderwärmung von 1,25°C stimmt mit der Rate der beobachteten Erwärmung von 1850-2020 überein, aber die gesamte Bandbreite der Vorhersagen der Klimaforscher über die Enderwärmung stimmt nicht mit der Rate der beobachteten Erwärmung überein.

Abbildung 9: Klimatologen haben (a) die mittelfristige globale Erwärmung seit 1990 und (b) die langfristige, endgültige globale Erwärmung (d.h. die gleichgewichtige Klimasensitivität oder ECS) im Vergleich zu den auf Beobachtungen basierenden Werten überprognostiziert. Mittel- und langfristige Erwärmungsvorhersagen sind kohärent, wenn die Erwärmung um das Dreifache überbewertet wird.

Die Seiten 8-9, die ein wenig technisch sind, zeigen, wie die Argonauten fünf Tests zur Bewertung von Vorhersagen der globalen Erwärmung entwickelt haben. Zunächst nutzten sie die Tests, um ihre eigene Berechnung zu überprüfen, dass es nach Korrektur des Fehlers der Klimawissenschaftler zu einer Enderwärmung von 1,25°C durch verdoppeltes CO2 kommen würde (bekannt als Gleichgewichtsklimaempfindlichkeit oder ECS), mit einem Bereich von 1,05 bis 1,50°C. Als nächstes überprüften sie den gesamten Bereich der von den Klimawissenschaftlern vorhergesagten ECS von 2,0 bis 5,7°C, wobei sie Werte in diesem vorhergesagten Bereich als Input für einen Algorithmus verwendeten, um herauszufinden, ob und in welchem Ausmaß jede Vorhersage zu einem Widerspruch führte.

Die fünf Tests zum Nachweis, dass die Prophezeiungen der Klimawissenschaftler exzessiv sind

Lewis & Curry (2015) zeigten, dass man ohne ein gigantisches Klimamodell die endgültige Erwärmung durch verdoppeltes CO2 aus der beobachteten globalen Erwärmung des Industriezeitalters, den offiziell geschätzten Veränderungen, die durch unsere Treibhausgasemissionen verursacht werden, und dem gemessenen Strahlungsungleichgewicht der Erde berechnen kann. Sie kamen zu dem Schluss, dass die endgültige Erwärmung etwa 1,5°C betragen würde, so wie es Arrhenius und Callendar vor einem Jahrhundert getan hatten.

Ungeachtet einer ähnlich geringen Erwärmung, die in Lewis & Curry und vielen anderen Arbeiten (z.B, Lindzen & Choi 2011; Aldrin et al. 2012; Otto et al. 2013; Akasofu 2013; Spencer & Braswell 2014; Skeie et al. 2014; Soon et al. 2015; Bates 2016), haben die Klimaforscher ihre Vorhersagen von etwa 4 °C Enderwärmung als Reaktion auf die Verdoppelung des CO2-Gehalts in der Luft nicht reduziert, um die Reduktion zu erreichen, zu der sie die langsame Erwärmung der realen Welt in ihren mittelfristigen Vorhersagen der vom Menschen verursachten globalen Erwärmung gezwungen hatte.

Deshalb entwickelten die Argonauten fünf mathematische Tests, um festzustellen, ob ein Wert der Enderwärmung durch verdoppeltes CO2 aus dem Vorhersagebereich der Klimawissenschaftler von 2 °C bis 5,7 °C möglich war.

Test 1 basierte auf den Berechnungen des Teams, die zeigten, dass nach Korrektur des Fehlers der Klimawissenschaftler der wahre Bereich der Enderwärmung durch verdoppeltes CO2 1,05 bis 1,5 °C beträgt, mit einer mittleren Schätzung von 1,25 °C.

Selbst die geringste Vorhersage der Klimaforscher, 2 °C, scheitert bei diesem Test (Abb. 10).

Abbildung 10: Die neuesten offiziellen Vorhersagen der endgültigen Erwärmung oder ECS (Sherwood et al. 2020), verglichen mit der von Monckton of Brenchley et al. korrigierten ECS.

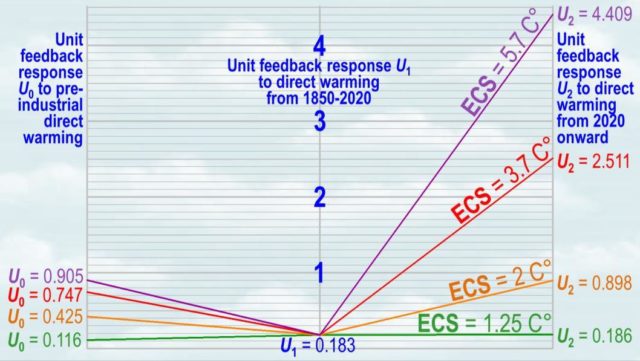

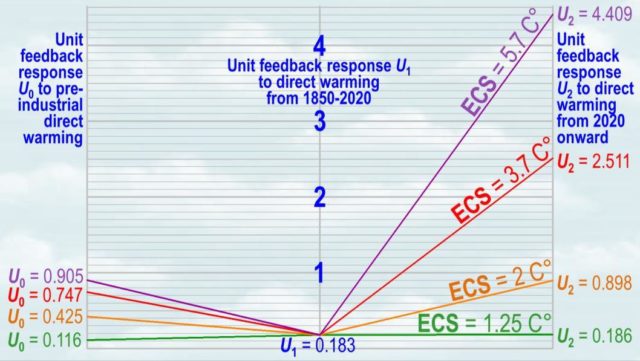

Die Tests 2-5 basieren auf Unit-Feedback-Reaktionen (UFR), d.h. Rückmeldungen pro 1 °C direkter Erwärmung.

Test 2 geht davon aus, dass die UFRs als Reaktion auf die direkte Treibhausgas-Erwärmung mit der Erwärmung der Oberfläche wachsen.

Die UFR ab 2020 sollte die UFR von 1850-2020 übertreffen, die wiederum die vorindustrielle UFR übertreffen sollte.

Doch selbst UFRs auf der Grundlage der geringsten Vorhersage der Klimatologen (ECS) von 2°C durch verdoppeltes CO2 basieren, scheitern bei diesem Test (siehe Einbruch der orangefarbenen Linie in Abb. 11).

Alle Vorhersagen über 2 °C fallen in Test 2 noch stärker durch.

Abbildung 11: Rückkopplungs-Reaktionen der Einheit U0 ≤ U1 ≤ U2 (solche pro 1 °C direkter Treibhauserwärmung) sollten mit der Erwärmung zunehmen. Sie tun genau das unter der Annahme einer Enderwärmung von 1,25°C durch verdoppeltes CO2 (equilibrium climate sensitivity, oder ECS: die grüne Linie). Basierend auf der vorhergesagten ECS ≥ 2°C in aktuellen Klimamodellen geht die Reihe jedoch unweigerlich nach unten statt nach oben.

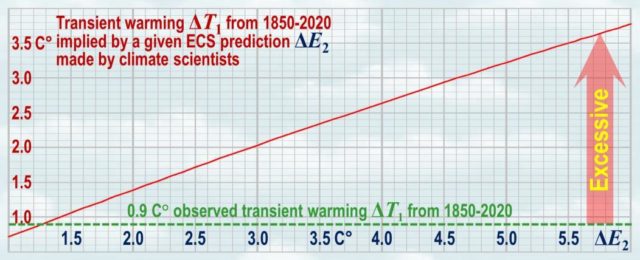

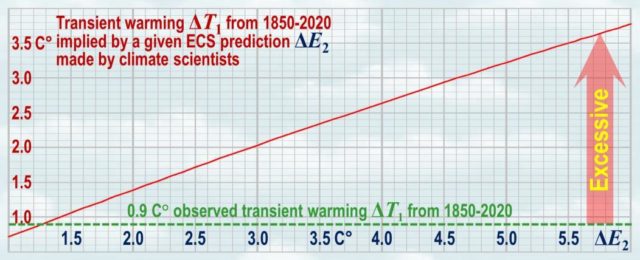

Test 3 ermittelt, wie stark sich die Erderwärmung zwischen 1850 und 2020 hätte sein sollen, wenn eine gegebene Vorhersage der endgültigen Erwärmung durch verdoppeltes CO2 (ECS) zutreffen würde. Von 1850-2020 gab es eine gemessene globale Erwärmung von 0,9 °C. Allerdings impliziert selbst die vorhergesagte abschließende Erwärmung um 2 °C durch verdoppeltes CO2 (ECS) eine Erwärmung um 1,4 °C von 1850-2020, was wiederum das Eineinhalbfache der Erwärmung um 0,9 °C in diesem Zeitraum darstellt.

Test 3: Bei der mittleren ECS von 1850-2020 von 3,7 °C hätte es nicht 0,9 °C, sondern 2,5 °C Erwärmung geben müssen.

Die Obergrenze der Enderwärmung von 5,7°C würde eine Erwärmung um 3,6 °C von 1850-2020 bedeuten: das Vierfache der realen 0,9 °C (Abb. 12).

Somit fallen alle Vorhersagen der Klimawissenschaftler in Test 3 durch.

Abbildung 12: Alle derzeitigen Prognosen der Enderwärmung (ECS) von 2°C oder mehr aufgrund einer CO2-Verdoppelung im Zeitraum 1850 bis 2020 liegen weit über den gemessenen 0,9°C.

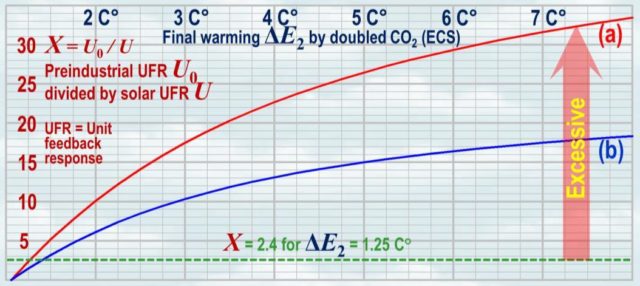

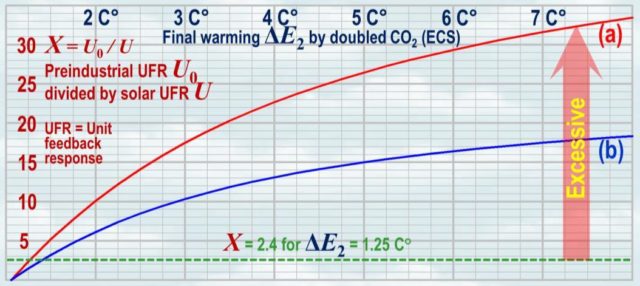

Test 4 leitet den vorindustriellen UFR und den durch die Emissionstemperatur ausgelösten UFR aus einer ECS-Vorhersage ab und nimmt deren Verhältnis X.

Selbst die von Klimawissenschaftlern prophezeite untere Grenze der Bandbreite von 2 °C impliziert einen vorindustriellen UFR, der zehnmal so hoch ist wie der UFR bei der Emissionstemperatur. Bei 1,25 °C ECS ist sie nur 2,4-mal so hoch.

Bei größeren Vorhersagen wächst der Überschuss rasch an (Abb. 13).

Abbildung 13: Der Anstieg des Basis-UFR-Verhältnisses X (das vorindustrielle UFR geteilt durch die Emissions-Temperatur UFR), der durch die vorhergesagte Enderwärmung ΔE2 impliziert wird, verdoppelte das CO2, wobei die Emissionstemperatur (a) 267,6 K und (b) 255,3 K beträgt.

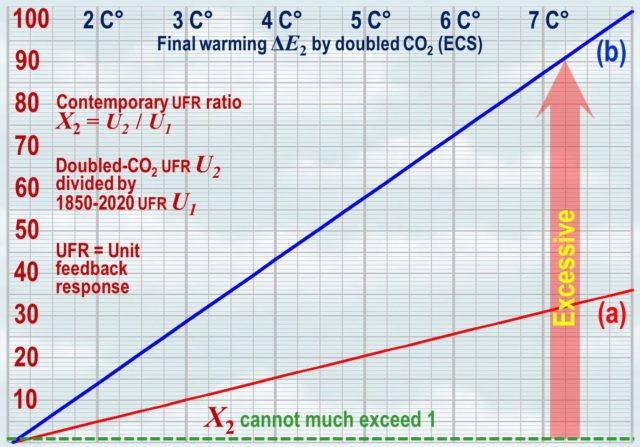

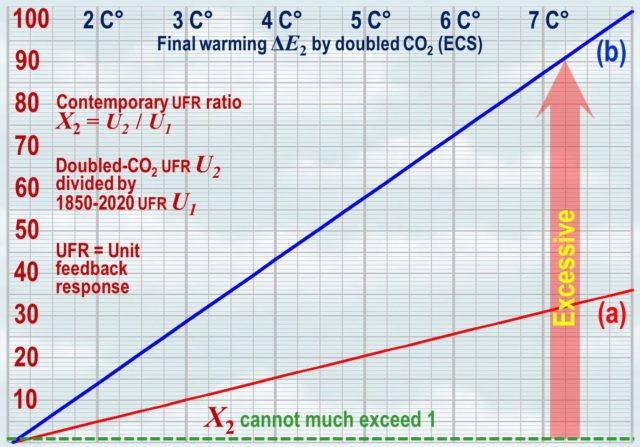

Test 5 leitet die verdoppelten CO2– und 1850-2020 UFR-Werte aus einer gegebenen ECS-Vorhersage ab und nimmt deren Verhältnis X2.

Auch hier ist selbst bei 2 °C vorhergesagter ECS die Verdoppelung von CO2–UFR das 5-fache von 1850-2020 UFR.

Bei 3,7 °C vorhergesagter ECS im mittleren Bereich ist der verdoppelte CO2–UFR 14-mal so hoch wie der 1850-2020 UFR.

Bei 5,7 °C vorhergesagter ECS des oberen Bereichs ist der verdoppelte CO2–UFR-Wert 24-mal so hoch wie der von 1850-2020 UFR.

Werte von X2 weit über 1 sind unmöglich.

Der gesamte Bereich der ECS-Vorhersagen der Klimaforscher fällt in Test 5 durch.

Abbildung 14: Der Anstieg des zeitweiligen UFR-Verhältnisses X2 (das von den UFR-Klimawissenschaftlern verdoppelte CO2-Verhältnis geteilt durch das UFR-Verhältnis 1850-2020), das sich aus der vorhergesagten Enderwärmung ΔE2 durch den gesamten Bereich der ECS ergibt, verdoppelte das CO2, wobei die Emissionstemperatur (a) 267,6 K und (b) 255,3 K beträgt, fallen die Vorhersagen fallen in Test 5 durch.

Dementsprechend versagt das gesamte Spektrum der aktuellen Vorhersagen zur globalen Erwärmung in allen fünf Tests; und wie die Abbildungen 10 bis 14 zeigen, ist das Versagen umso größer, je höher die Vorhersage ist. Im Gegensatz dazu entspricht die vom Team berechnete Enderwärmung von 1,25 °C durch verdoppeltes CO2, die als Grundlage für Test 1 dient, den Tests 2-5.

Wie die Klimamodelle die Zunahme des Wasserdampfes in der oberen Atmosphäre überbewerteten

Nachdem die Argonauten den physikalischen Fehler der Klimawissenschaftler korrigiert und mit Hilfe der fünf Tests theoretisch festgestellt hatten, dass die Klimamodelle eine um das Dreifache zu hohe globale Erwärmung vorhersagen, suchten sie nach einer physikalischen Diskrepanz zwischen der Art und Weise, wie die Modelle das Verhalten eines relevanten Aspektes des Klimas simulieren, und dessen gemessenem, realen Verhalten.

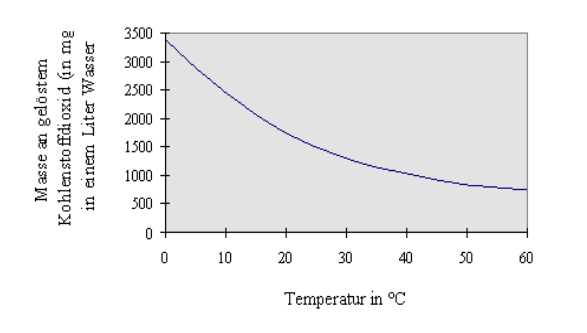

Da Klimamodelle die vorindustrielle Rückkopplungsreaktion um 3200% überbewerten, begannen die Argonauten zu untersuchen, wie die Modelle die Wasserdampfrückkopplung darstellen, die von den Klimawissenschaftlern als der mit Abstand wichtigste Rückkopplungsprozess im Klima angesehen wird, löst dieser doch alle oder fast alle Netto-Rückkopplungsreaktionen aus.

Tatsächlich wurde eine bemerkenswerte Diskrepanz zwischen den Vorhersagen der Modelle und der beobachteten Realität festgestellt. Klimamodelle sagen voraus, dass sich die tropische Mitteltroposphäre in 10.000 m Höhe mehr als doppelt so schnell erwärmen dürfte wie die Oberfläche. In Wirklichkeit gibt es jedoch keinen solchen Hotspot. Die tropische obere Atmosphäre erwärmt sich nur ein wenig schneller als die Oberfläche. Alle Modelle waren falsch. Wo immer die Daten aus der realen Welt zeigen, dass die Modelle falsch sind, sind die Daten zu bevorzugen. Irgendwo lauert ein großer Fehler.

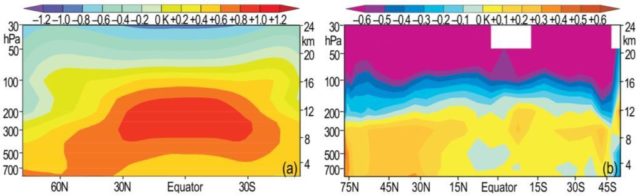

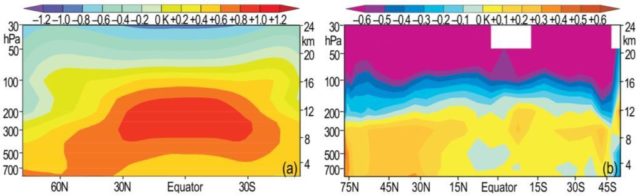

Abb. 15a (IPCC (2007, Abb. 9.1c) sagt diesen tropischen Hotspot in der Mitte der Troposphäre voraus, aber es gibt keinen Hotspot im realen vertikalen Temperaturprofil von bis zu 26.000 Metern Höhe, gemessen von Millionen von Ballonsensoren (Abb. 15b: Lanzante et al. 2006)

Abbildung 15: (a) prophezeites und (b) gemessenes vertikales Temperaturprofil der Atmosphäre

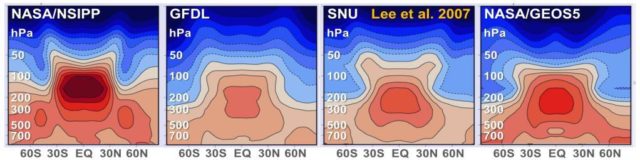

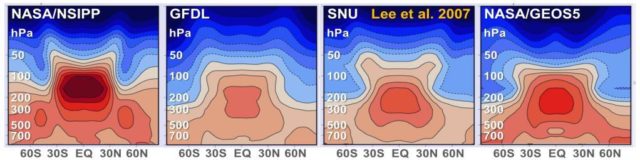

Der Hotspot wird von vielen einschlägigen Klimamodellen simuliert (Abbildung 16). Fehlt dieser, kann die Wasserdampf-Rückkopplung nicht so substantiell sein wie von den Modellen simuliert. Warum aber fehlt dieser prophezeite Hotspot?

Abbildung 16 Der Hotspot in vier Modellen (Lee at al. 2007: jedes Farbband repräsentiert 1°C)

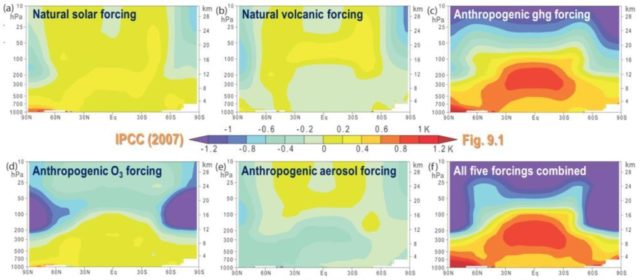

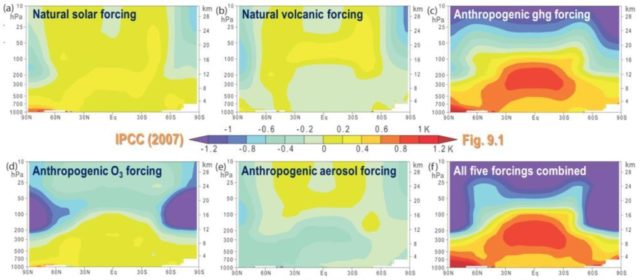

IPCC 2007 (Abb. 9.1: hier Abb. 17) nahm an, dass der Hotspot der Fingerabdruck der vom Menschen verursachten Erwärmung sei.

Natürliche Einflüsse durch die Sonne, Vulkane, künstliches Ozon (O3) und Aerosole schienen den Hotspot nicht zu verursachen, wohl aber die vom Menschen verursachte Treibhausgas-Erwärmung.

Doch das IPCC hatte sich geirrt. Klimawissenschaftler sagen nun, dass der Hotspot ein Zeichen der globalen Erwärmung wäre, wie auch immer verursacht.

Abbildung 17: Der imaginäre Hotspot als Fingerabdruck der vom Menschen verursachten globalen Erwärmung.

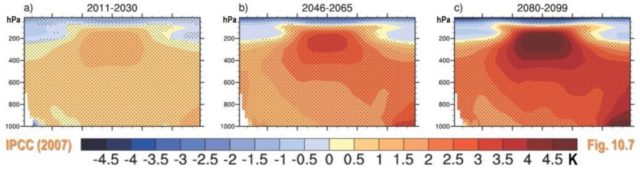

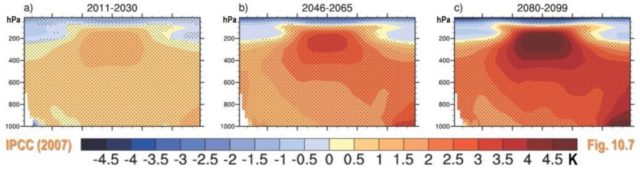

Aber der Hotspot ist und bleibt abwesend. IPCC 2007 (Abbildung 10.7, hier Abbildung 18) prophezeite, dass sich der Hotspot mit der Zeit und der globalen Erwärmung ausbilden werde. Aber das IPCC hatte sich erneut geirrt.

Abbildung 18: Der Hotspotsoll sich angeblich im Zuge der Erwärmung bilden.

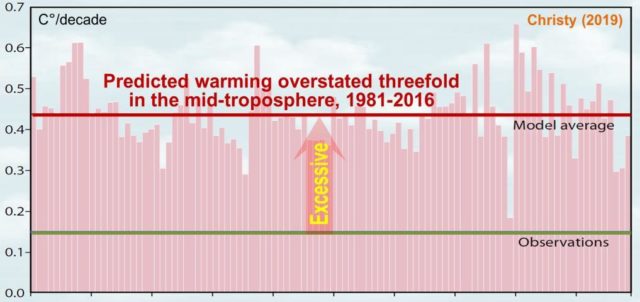

Obwohl das IPCC eine rasche Erwärmung der tropischen Oberluft vorhersagte, wurde sie in den Modellen von 1981-2016 im Vergleich zu den Daten aus der realen Welt um das Dreifache überbewertet (Christy 2019: hier Abb. 19).

Die Modelle wurden so programmiert, dass sie davon ausgehen, dass Wasserdampf, wie CO2, Methan, Distickstoffoxid und Ozon, in der gesamten Atmosphäre gut vermischt wäre. Das ist natürlich Unsinn.

Abbildung 19: Die Modelle überbewerten die Erwärmung der tropischen mittleren Troposphäre um das Dreifache zu hoch.

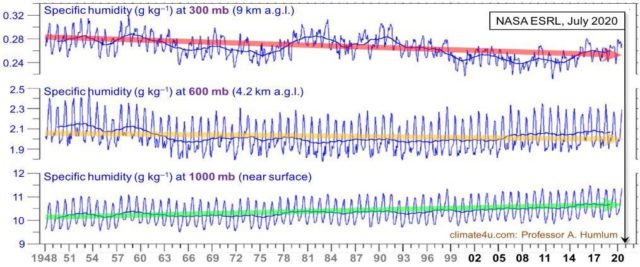

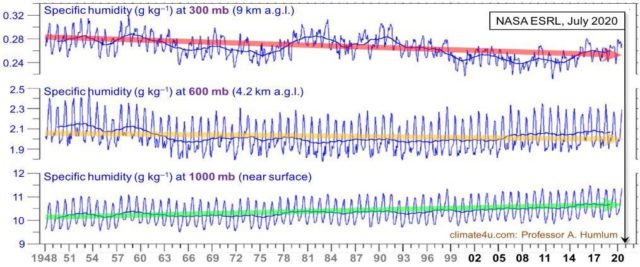

Die Modelle sagen voraus, dass der Wasserdampf in allen Höhenlagen zunehmen wird. Das ist falsch. In der mittleren Troposphäre sinkt die spezifische Feuchtigkeit seit 70 Jahren (NASA ESRL 1948-2020: hier Abb. 20).

Kein Hot Spot bedeutet eine geringe Wasserdampfrückkopplung und sehr geringe Erwärmung, was die Analyse des Teams bestätigt und belegt, dass sie mit den Beobachtungen in der realen Welt übereinstimmt.

Abbildung 20: In der mittleren Troposphäre nimmt die spezifische Feuchtigkeit ab (Kalnay et al. 1996).

Schlussfolgerung: Der moralische Imperativ lautet: Zugang zu bezahlbarem Strom für alle!

Nachdem der schwerwiegende physikalische Fehler der Klimaforscher korrigiert worden war, beträgt die globale Erwärmung ein Drittel dessen, was prophezeit worden ist, kohärent mit der realen Erwärmung, die ein Drittel der von ihnen vorhergesagten beträgt, und kohärent mit dem Rückgang des Wasserdampfes in der mittleren tropischen Troposphäre und mit dem Fehlen des vorhergesagten Hot Spots.

Aufgrund des Fehlers vergeben viele Banken keine Kredite mehr an Entwicklungsländer für Kohlekraftwerke: ab 2010 die Weltbank; ab 2015 Credit Agricole, Citibank, ANZ und Goldman Sachs; ab 2016 JP Morgan, Deutsche Bank, PNC, Credit Suisse, ABN Amro, Standard Chartered, US Bancorp, Commerzbank und Barclays; ab 2017 DZ Bank und NAB; ab 2018 DBS; ab 2019 sogar die Afrikanische Entwicklungsbank.

Doch laut Weltgesundheitsorganisation sterben 4 Millionen Menschen pro Jahr in Haushalten ohne Strom durch das Einatmen von Kochfeuerrauch und 500.000 Frauen pro Jahr bei der Geburt – nur zwei der zahlreichen Ursachen für vorzeitigen Tod durch fehlenden Zugang zu Elektrizität. Die Internationale Energieagentur definiert „Zugang“ als nicht mehr als die Kapazität, eine 60-Watt-Glühbirne vier Stunden täglich zu benutzen. Eine Milliarde Menschen haben keinen Zugang zu elektrischer Energie – eine Entwicklungspriorität, die heutzutage sicher und erschwinglich durch Kohleverstromung erfüllt werden kann.

Die ungerechtfertigte Furcht vor einer großen, raschen und gefährlichen globalen Erwärmung hat Mittel für Umweltverbesserungen verschlungen, die für erschwingliche und praktikable Lösungen für die vielen realen Umweltprobleme hätten ausgegeben werden müssen, die sich aus Armut und Elend in den Entwicklungsländern ergeben – Lösungen wie die universelle, erschwingliche, kontinuierliche, zuverlässige, kohle- und gasbefeuerte Elektrifizierung, die jetzt wieder möglich ist.

Nach der Korrektur des Fehlers wird die Indoktrination von Kindern über die globale Erwärmung von Cannow eingestellt. Viele haben ihre Kindheit durch grundlose Angst ruiniert, manche haben sich sogar aus Verzweiflung umgebracht.

Es gibt viele wirkliche Umweltprobleme, aber die langsame, leichte und insgesamt vorteilhafte Erwärmung, die nach der Korrektur des langjährigen und kostspieligen Fehlers der Klimawissenschaftler zu erwarten ist, gehört nicht dazu.Die Palette von Klimaregeln, Beschränkungen, Steuern, Auflagen, Konferenzen, Reden und Verträgen ist unnötig. Die vom Menschen verursachte globale Erwärmung verursachte, verursacht keinen „Klima-Notstand und wird dies auch niemals verursachen“. Es ist alles vorbei.

References

Akasofu S-I (2013) On the present halting of global warming. Climate 1(1):4–11.

Aldrin M, Horden M, Guttorp P, Skeie RB, Myhre G, Berntsen TK (2012) Bayesian estimation of climate sensitivity based on a simple climate model fitted to observations of hemispheric temperature and global ocean heat content. Environmetrics 23:253–271. https://doi.org/10.1002/env.2140

Andrews T, Gregory JM, Webb MJ, Taylor KE (2012) Forcing, feedbacks and climate sensitivity in CMIP5 coupled atmosphere– ocean climate models. Geophys Res Lett 39:L09712. https://doi.org/10.1029/2012GL051607

Arrhenius S (1906) Die vermutliche Ursache der Klimaschwankungen (“The possible cause for climate variability”) Meddelanden från K Vetenskapsakademiens Nobelinstitut 1(2):1ff

Bates JR (2016) Estimating climate sensitivity using two-zone energy–balance models. Earth Space Sci 3(5):207–225. https://doi.org/10.1002/2015EA000154

Black HS (1934) Stabilized feedback amplifiers. Bell System Tech J 1–18

Bode HW (1945) Network analysis and feedback amplifier design. Van Nostrand Reinhold, New York, 31–43

Callendar GS (1938) The artificial production of carbon dioxide and its influence on temperature. Q.J.R. Met. Soc. 64(275), 223– 240. https://doi.org/10.1002/qj.49706427503

Charney JG, Arakawa A, Baker DJ, Bolin B, Dickinson RE, Goody RM, Leith CE, Stommel HM, Wunsch CI, (1979) Carbon

Dioxide and Climate: A Scientific Assessment Report of an Ad-Hoc Study Group on Carbon Dioxide and Climate. Climate Research Board, Assembly of Mathematical and Physical Sciences, National Research Council, Woods Hole, Massachusetts Christy J (2019) The tropical skies: falsifying climate alarm. Global Warming Policy Foundation, London.

Hansen J, Lacis A, Rind T, Russel G, Stone P, Fung I, Ruedy R, Lerner J (1984) Climate sensitivity 1984: Analysis of feedback mechanisms. In: Climate Processes and Climate Sensitivity (AGU Geophysical Monograph 29). Hansen J Takahashi T (eds).

American Geophysical Union 130-163

IPCC (1990) Climate change – The IPCC Assessment: Report prepared for the Intergovernmental Panel on Climate change by Working Group 1. Houghton JT, Jenkins GJ, Ephraums JJ (eds). Cambridge University Press

IPCC (2001) Climate Change 2001: The scientific basis Contribution of Working Group I to the Third Assessment Report of the Intergovernmental Panel on Climate Change. Houghton JT et al (eds). Cambridge University Press

IPCC (2007) Climate Change 2007: The physical science basi.s Contribution of Working Group I to the Fourth Assessment Report of the Intergovernmental Panel on Climate Change. Solomon S et al (eds). Cambridge University Press

IPCC (2013) Climate change 2013: The physical science basis. Contribution of Working Group I to the Fifth Assessment Report of the Intergovernmental Panel on Climate Change. Stocker TF et al (eds). Cambridge University Press

Kalnay E, Kanamitsu M, Kistler R, Collins W, Deaven D, Gandin L, Iredell M, Saha S, White G, Woollen J, Zhu Y, Chelliah M,

Ebisuzaki W, Higgins W, Janowiak J, Mo KC, Ropelewski C, Wang J, Leetmaa A, Reynolds R, Jenne R, Joseph D (1996) The NCEP/NCAR Reanalysis 40–year Project. Bull Amer Meteor Soc 77:437–471

Lacis AA, Schmidt GA, Rind D, Ruedy RA (2010) Atmospheric CO2: principal control knob governing Earth’s temperature. Science

330: 356–359

Lacis AA, Hansen JE, Russel GL, Oinas V, Jonas J (2013) The role of long-lived greenhouse gases as principal LW control knob that governs the global surface temperature for past and future climate change. Tellus B 65:19734: https://doi.org/10.3402/tellusb.v65i0.19734

Lanzante JR, Peterson TC, Wentz FJ, Vinnikov KY (2006) CCSP synthesis and assessment report 11. In: Temperature Trends in the lower atmosphere: steps for understanding and reconciling differences. US Climate Change Science Program and Subcommittee on

Global Change Research (Karl TR, Hassol SJ, Miller CD, Murray WL, eds.). National Oceanographic & Atmospheric Administration, National Climatic Data Center, Asheville North Carolina

Lee MI, Suarez MJ, Kang IS, Held IM, Kim D (2007) A moist benchmark calculation for the atmospheric general-circulation models. J Clim 21:4934–4954

Lewis N, Curry JA (2015) The implications for climate sensitivity of AR5 forcing and heat uptake estimates. Clim Dyn 45:1009–

1023. https://doi.org/10.1007/s00382–014–2342–y

Lindzen RS, Choi Y-S (2011) On the observational determination of climate sensitivity and its implications. Asia-Pacific J Atmos Sci 47(4):337–290. https://doi.org/10.1007/s13143–011–0023–x

Meehl GA, Senior CA, Eyring V, Flato G (2020) Context for interpreting equilibrium climate sensitivity and transient climate response from the CMIP6 Earth system models. Sci Adv 6(26). https://doi.org/10.1126/sciadv.aba1981

HadCRUT4 dataset: metoffice.gov.uk/hadobs/hadcrut4/data/current/time_series/HadCRUT.4.6.0.0.monthly_ns_avg.txt (accessed

November 2020)

Otto A, Otto F, Boucher O et al (2013) Energy budget constraints on climate response. Nat Geosci 6:415–416. https://doi.org/10.1038/ngeo1836

Schlesinger ME (1988) Feedback analysis of results from energy balance and radiative–convective models In: MacCracken MC, Luther FM (eds). The potential climatic effects of increasing carbon dioxide. US Dept of Energy, Washington DC, pp 280–319

Sherwood SC, Webb MJ, Annan JD, Armour KC, Forster PM, Hargreaves JC, Hegerl G, Klein SA, Marvel KD, Rohling EJ, Watanabe M, Andrews T, Braconnot P, Bretherton CS, Foster GL, Hausfather Z, von der Heydt AS, Knutti R, Mauritsen T, Norris JR, Proistosescu C, Rugenstein M, Schmidt GA, Tokarska KB, Zelinka MD (2020) An assessment of Earth’s climate sensitivity using multiple lines of evidence. Rev Geophys. https://doi.org/10.1029/2019RG000678

Skeie RB, Berntsen T, Aldrin M, Holden M, Myhre G (2014) A lower and more constrained estimate of climate sensitivity using updated observations and detailed radiative forcing time series. Earth Syst Dyn 5:139–175

Soon WW-H, Connolly R, Connolly M (2015) Re-evaluating the role of solar variability on Northern Hemisphere temperature trends since the 19 century. Earth-Sci Rev 150:409–452. https://doi.org/10.1016/j.earscirev.2015.08.010

Spencer RW, Braswell WD (2014) The role of ENSO in global ocean temperature changes during 1955–2011 simulated with a 1D climate model. Asia–Pacific J Atmos Sci 50(2):229–237

UAH dataset: monthly global mean land and sea lower-troposphere temperature anomalies (accessed November 2020). http://www.nsstc.uah.edu/data/msu/v6.0/tlt/uahncdc_lt_6.0.txt

Wu T, Hu A, Gao F, Zhang J, Meehl GA (2019) New insights into natural variability and anthropogenic forcing of global/regional climate evolution. Clim Atmos Sci 2(18). https://doi.org/10.1038/s41612–019–0075–7

Zelinka MD, Myers TA, McCoy DT, Po-Chedley S, Caldwell PM, Ceppi P, Klein SA, Taylor KE (2020) Causes of higher climate sensitivity in CMIP6 models. Geophys Res Lett. https://doi.org/10.1029/2019GL085782

Autoren (die Argonauten):

Christopher Monckton of Brenchley (monckton@mail.com) is a former adviser to Margaret Thatcher on science and policy at 10 Downing Street. He discovered climate scientists’ error and gathered the Argonauts to investigate it.

Dr Dietrich Jeschke is Professor of Control Theory at the Flensburg University of Applied Sciences.

Dr Willie Soon is an award-winning astrophysicist at the Harvard-Smithsonian Center for Astrophysics.

Dr David Legates is Professor of Climatology at the University of Delaware and a former State Climatologist. He is currently Executive Director of the U.S. Global Change Research Program.

Dipl.-Ing. Michael Limburg is a control engineer and climate specialist at the Europäisches Institut für Klima und Energie.

Alex Henney (alexhenney@aol.com) advises governments worldwide on the global electricity market and grid development.

He conceived the idea for this plain man’s guide and wrote the first draft.

John Whitfield is a control engineer. He designed and built the test apparatus on which this research was verified. His work was later confirmed by a similar test apparatus at a government physical laboratory.

James Morrison is an environmental consultant who once sold wind turbines to Napa Valley wineries.

Dr Tom Sheahen is a physicist and alumnus of the Massachusetts Institute of Technology.

William Rostron is an award-winning control engineer who designed and programmed the world-leading integrated control system at the Oconee Nuclear Facility, Seneca, South Carolina.

Acknowledgements

The Argonauts thank Mr William Bailey, Professor Matt Briggs, Mr Edward Bullerdieck, the late Professor Freeman Dyson,

Professor Chris Essex, Professor Pat Frank, Professor Dr Hermann Harde, Mr Michael Haseler, President Václav Klaus,

Professor Dr Mojib Latif, Mr Nic Lewis, Professor Adrian Mathias, The Viscountess Monckton of Brenchley, Dr Benoît Rittaud, Academician Dr Vladimir Semenov, Professor Nir Shaviv, Dr Roger Taguchi, Mr George White and Academician Dr

Nina Zaytseva for discussions, Professor Ray Bates, The Baron Clanmorris of Newbrook, Dr Michael Connolly, Dr Ronan

Connolly, Professor Will Happer, Dr David Heald, Professor Murry Salby and the

Global Warming Policy Foundation for pre-submission reviews; Professor Maria da Assunção Ferreira Pedrosa de Araújo, The Rev. David Foster, Mr G. Edward Griffin, Ms Pamela Matlack-Klein, the late Professor Nils-Axel Mörner, Mr Hal Shurtleff, the Cambridge Union Society, the Charles University at Prague, the Government of Colombia, the Committee for a Constructive Tomorrow, the Government of the Czech Republic, the Deutscher Bundestag, the Europäisches Institut für Klima und Energie, the European Parliament, Hancock Prospecting, the Heartland Institute, the Hong Kong and Shanghai Banking Corporation, the International Committee on Geoethics, the Moscow City Government, the Oxford Union Society, the St Andrews University Union, the Conference of the Parties to the United Nations Framework Convention on Climate Chance and the U.S. House of Representatives for facilitating discussion of these and related ideas at international conferences; and Professor Antonino Zichichi for having provided, at the Centre for Scientific Culture in Erice, Sicily, the high-level scientific forum from which these ideas sprang. Those acknowledged may or may not endorse the Argonauts’ conclusions.

Übersetzt von Chris Frey EIKE

Bemerkung: Wer die Übersetzung überprüfen will, der klicke auf das beigefügte PDF im Original. Die über die Formatierungen in dieser Übersetzung hinaus gehenden Formatierungen konnten nicht mit übernommen werden.

climate-error-guide