Aktuelle Corona-Berichterstattung

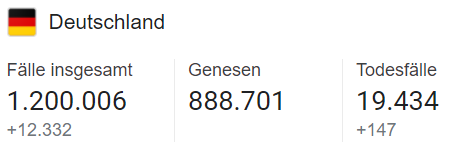

Wenn man der Berichterstattung und unseren Politikern glauben möchte, „rast“ Deutschland auf eine Covid-Katastrophe zu. Vor allem steigen die Sterbezahlen immer schlimmer. Bereits aktuell gilt die Sterberate als „unzumutbar“:

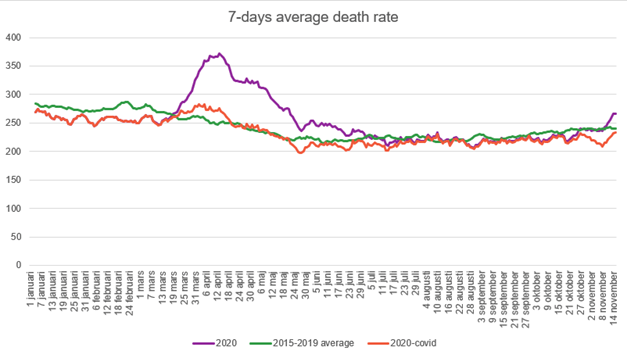

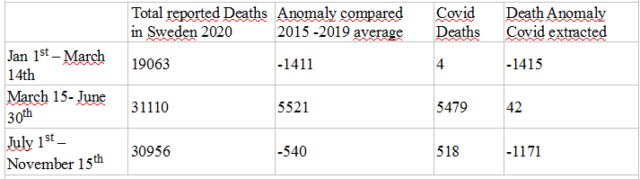

Bild 1 Screenshot vom 03.12.2020

Handelsblatt online, 06.12.2020: „Es braucht jetzt konsequentes Vorgehen“, sagte Söder der „Bild am Sonntag“. „Wir können die hohen Todeszahlen in Deutschland nicht hinnehmen. Die Ansteckungszahlen sind weiterhin zu hoch.

Der Spiegel 06.12.2020: Corona: Bayern ruft erneut Katastrophenfall aus

Bild 2 Screenshot

Die statistischen Zahlen zum 07.12.2020

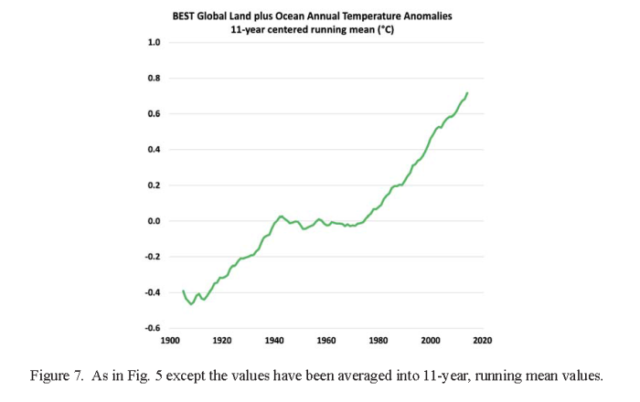

Seit wann hat Deutschland wirklich so etwas wie eine „Übersterblichkeit?

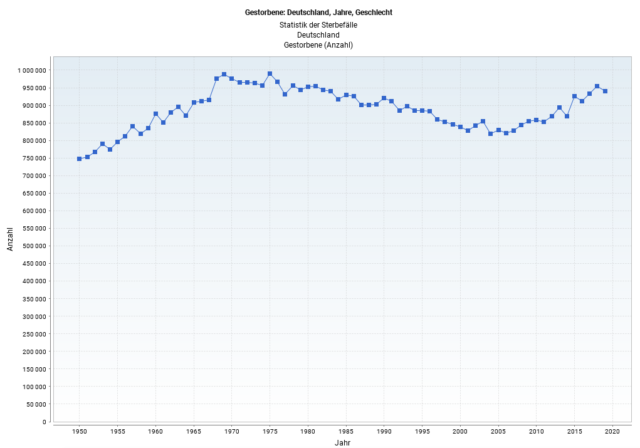

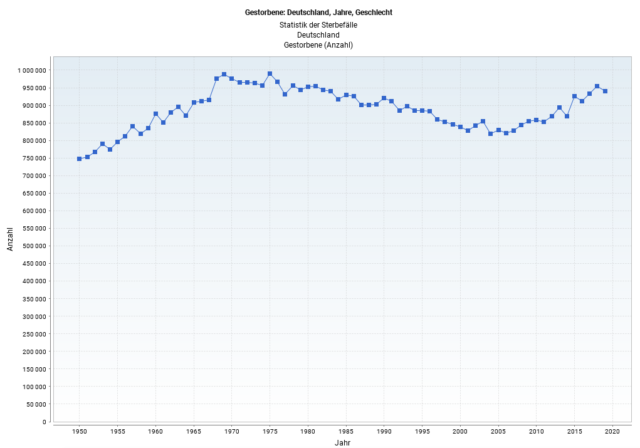

Interessant ist dazu eine Sterbezahlengrafik des Statistischen Bundesamtes mit den Sterbewerten seit 1950. Danach steigen die Sterbezahlen seit 2005 kontinierlich an (Anmerkung: Die Grafik ist nicht Einwohnerzahl-bereinigt).

Von 2005 bis 2019 hat die Anzahl jährlich Vertorbener insgesamt um ca. 130.000 Fälle zugenommen, bei fast gleich gebliebener Einwohnerzahl (2005: 82,5 Mio.; 2019: 83 Mio.). Das sind zusätzlich 356 Fälle/Tag oder 2.493/Woche.

Bild 3 Deutschland, Verlauf jährliche Sterbefälle-seit 1950. Quelle: Statistisches Bundesamt

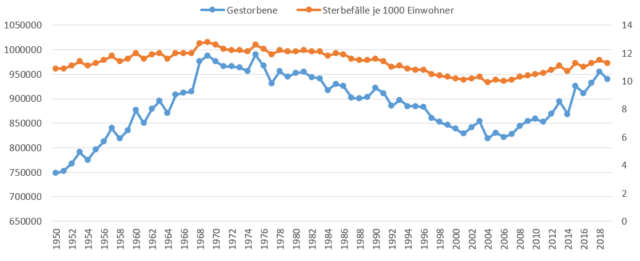

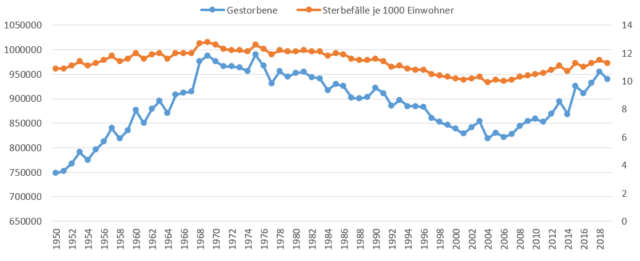

Dazu die Sterbefälle zusätzlich mit den Relativwerten, um die Bevölkerungszahl zu berücksichtigen:

Bild 4 Deutschland, Sterbefälle-Verlauf seit 1950. Grafik vom Autor erstellt. Datenquelle: Statistisches Bundesamt

Laut RKI sind im Jahr 2020 bisher 19.434 Personen an, oder eher mit Corona verstorben. Zum Jahresende hochgerechnet können es noch zwischen 20 …. 21.000 Personen werden.

Bild 5 Corona. Stand 07.12.2020

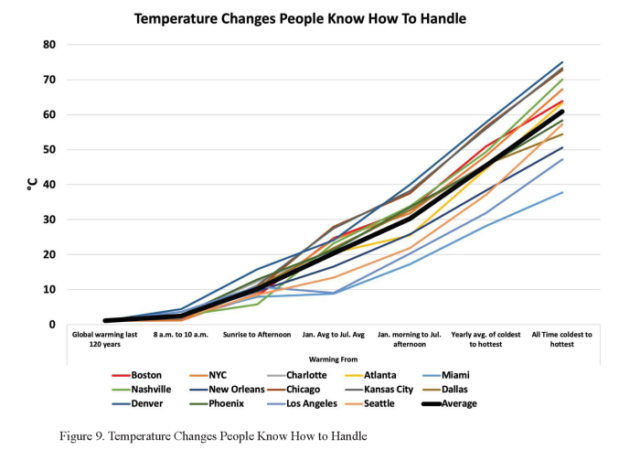

Damit beträgt die diesjährige „Corona“-Sterbezahl ca. 15 % der seit dem Jahr 2005 erhöhten, jährlichen Gesamt-Sterberate. Wobei beachtet werden muss, dass es im Jahr 2020 keine deklarierten Influenza-Fälle gibt, so als wäre die in vergangenen Jahren (zuletzt 2017/2018) hoch-tödliche Grippe mit 25.000 Verstorbenen (Angabe RKI) plötzlich verschwunden.

„Dröselt“ man die Sterbefälle weiter auf, sieht man, dass aufgrund der sich stetig verändernden Alterspyramide vor allem die Sterblichkeit ab 70 jährlich zunimmt. Bei der Altersgruppe ab 70 Jahren sind dies jährlich ca. +200.000 Personen.

Geht man davon aus, dass vom Corona-Versterben vorwiegend diese Altersgruppe betroffen ist, beträgt deren Corona-„Überversterben“ gerade einmal 10 % der typischen, jährlichen, durch die Alterspyramide bedingten Mortalitätssteigerung:

Bild 6 Deutschland Sterbezahlen. Vom Autor erstellt. Datenquelle: Statistisches Bundesamt

Übersterblichkeit

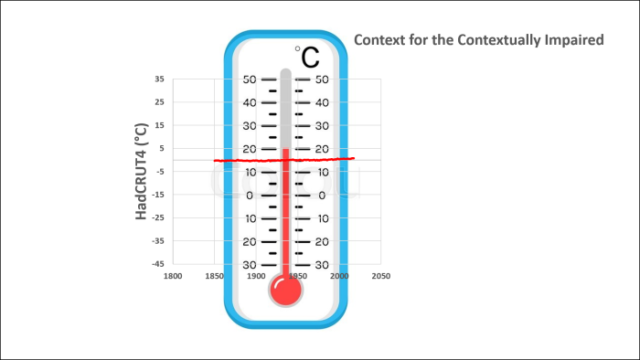

Eine deklarierte Sterblichkeit, welche zu extremen, zusätzlichen Maßnahmen Anlass gibt, sollte man annehmen, ist erst gegeben, wenn die Sterberate die der gängigen – und bisher nie zu Sondermaßnahmen führenden – Grippewellen erheblich überschreitet. Und das muss sich in der Gesamt-Sterberate – und nicht nur in Zuweisungen von Sterbezahlen auf eine bestimmte Krankheit – auch zeigen.

Allerdings ist das nicht Konsens, denn das Statistische Bundesamt behauptet, eine Übersterblichkeit wäre bereits gegeben, wenn der Mittelwert der vorhergehenden, letzten vier Jahre (bereits geringfügig) überschritten ist. Wie es auf diese Definition kommt (und damit noch schlimmere Grippejahre davor ausblendet) wird nicht erklärt.

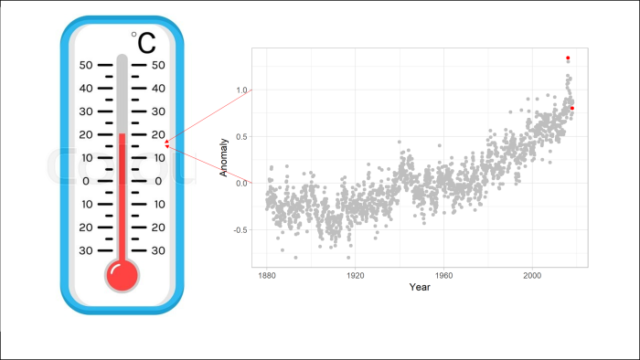

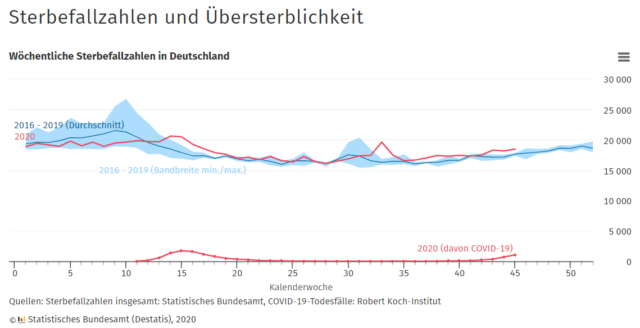

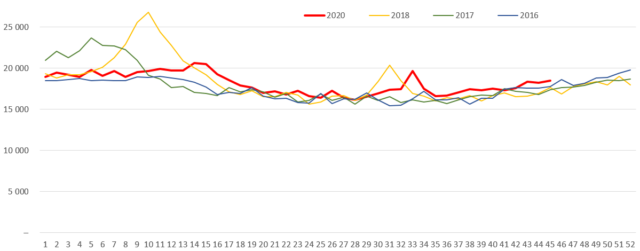

Die sich daraus (bewusst) ergebenden, unterschiedlichen Aussagen zeigen die folgenden Grafiken.

Zuerst das Bild des Sterbeverlaufs, wie ihn das Statistische Bundesamt auf ihrer Homepage darstellt

Diese Darstellung ist ganz bewusst angelegt. Warum zeigt sich in den folgenden, anhand der gleichen Daten erstellten Grafiken:

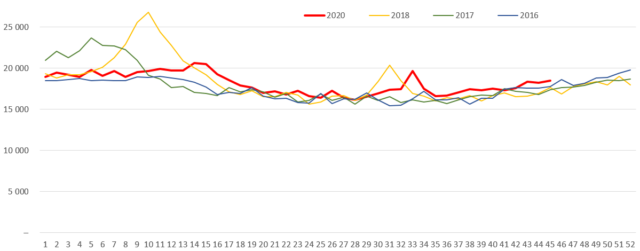

Bild 8 Verlauf Sterbezahlen von Bild 7 mit den Einzeljahren. Grafik vom Autor erstellt. Datenquelle: Statistisches Bundesamt

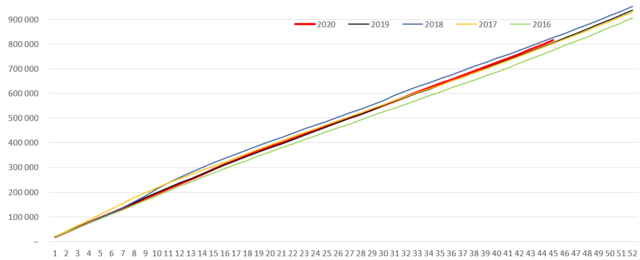

Kopiert man die 5 Jahre nicht parallel in eine Jahresscheibe, sondern stellt den gesamten Zeitverlauf in einer Linie dar, relativiert sich das schlimme Corona-Pandemiejahr auf das, was es ist: Vollkommen unspektakulär.

Bild 9 Verlauf absolute Sterbezahlen von Bild 8 in der jährlichen Reihenfolge (den fehlenden Dez. 2020 in Rot weitergeführt). Grafik vom Autor erstellt

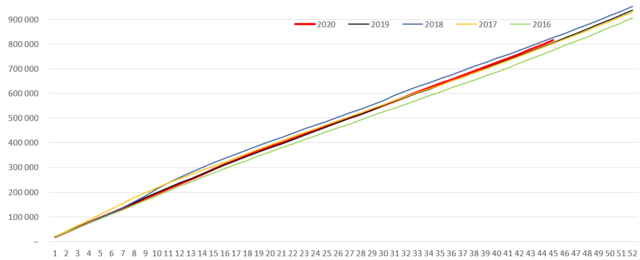

Das bleibt auch so wenn man die Jahre vergleichend aufsummiert:

Bild 10 Verlauf Sterbezahlen von Bild 7 als jährliche Summierung. Grafik vom Autor erstellt.

Nach diesen Grafiken gewinnt man den Eindruck, dass viele „Corona-Verstorbene“ auch ohne Corona verstorben wären. Denn sonst müssten sie ja in den Grafiken als zusätzliche Mengen deutlich erkennbar werden. Zumindest der Autor kann dies aber nicht feststellen.

Zur Erinnerung nochmals ein Vergleich „üblicher“ Sterbezahlen von „Pandemien“ die damals als „normal“ empfunden wurden und zu keinerlei politischen Maßnahmen führten (Anmerkung: Doch, es wurde ein Pandemie-Strategieplan erstellt, der als er gebraucht wurde sofort versagte):

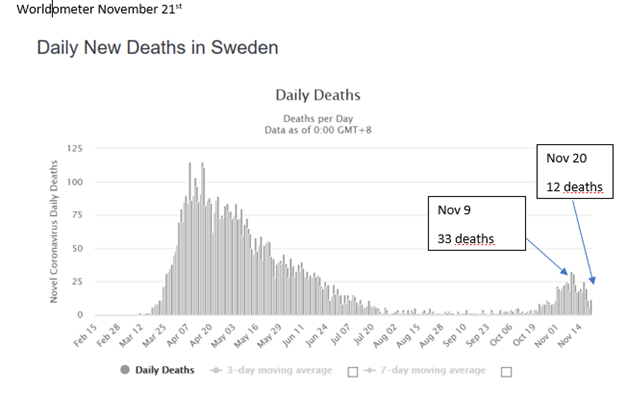

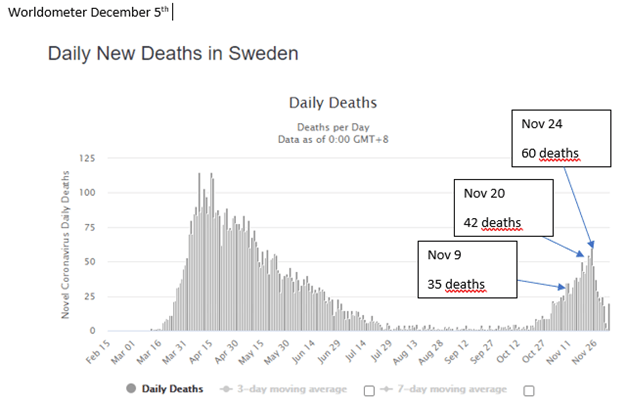

Corona 10.12.2020 20.460 (an oder mit) Corona Verstorbene.

Spiegel, 20.04.2020: Historische Pandemien Als die Grippe in Nachkriegsdeutschland wütete

Bis zu 50.000 Westdeutsche sowie einige Tausend Ostdeutsche fielen der sogenannten Hongkong-Grippe zwischen 1968 und 1970 zum Opfer (Zufügung: Auf die heutige Einwohnerzahl hochgerechnet: ca. 67.000) … Die andere – die sogenannte Asiatische Grippe – hatte rund zehn Jahre zuvor 30.000 Menschen (Zufügung: Auf die heutige Einwohnerzahl hochgerechnet: ca. 39.000) in Bundesrepublik und DDR dahingerafft …

Lungenärzte im Netz: Während der letzten großen Grippe-Epidemie von 1995/96 mit etwa 8,5 Millionen Erkrankungsfällen starben allein in Deutschland ca. 30.000 Menschen an den Folgen der Influenza ...

Ärzteblatt.de, 30. September 2019: Berlin – Die außergewöhnlich starke Grippewelle 2017/18 hat nach Schätzungen rund 25.100 Menschen in Deutschland das Leben gekostet.

Fallzahlen im Corona-Hotspot, Stadt Fürth

Dieses beschauliche Städtchen ist inzwischen ein Corona-Hoch-Risikogebiet. Warum, weiß niemand, denn lange passierte dort fast nichts. Aber Nichtwissen ist bei Corona immer noch Standard.

Corona in Zahlen: Die rechnerische Letalitäts- oder Todesrate (gemessen in Todesfällen durch Infektionen) ist derzeit am höchsten in den folgenden Landkreisen:

Tirschenreuth mit 7,63%

Odenwaldkreis mit 5,41%

Straubing mit 5,35%

Wolfsburg mit 5,34%

Fürth mit 4,43%

Nun eine Betrachtung zur Corona-Mortalität in einem solchen Hochrisiko-Hotspot:

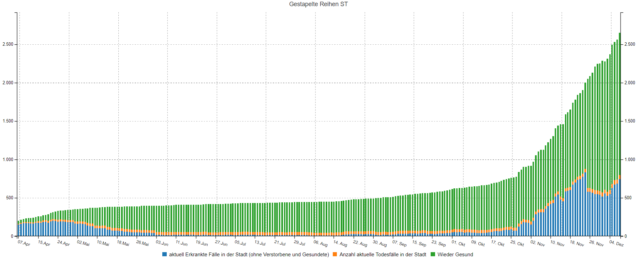

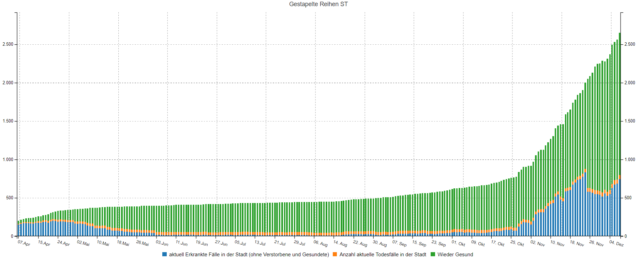

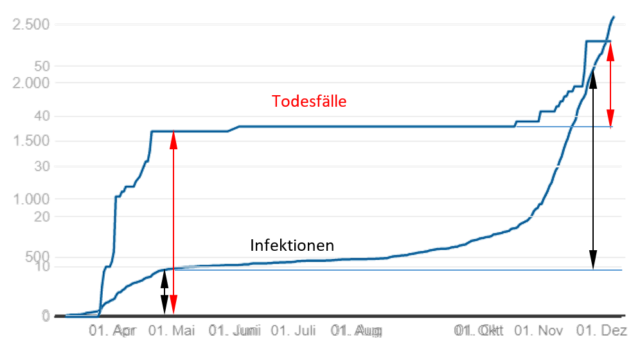

Bild 11 Stadt Fürth. Verlauf der Corona-Fallzahlen. Beachten: „aktuell Erkrankte Fälle“ sind Tageswerte. „Todesfälle“(Orange)/“Wieder Gesund“ sind kumulierte Werte. Quelle kosy

03. Juni: Summe Todesfälle: 37

29. Okt: Summe Todesfälle: 38

08. Dez.: Summe Todesfälle: 55

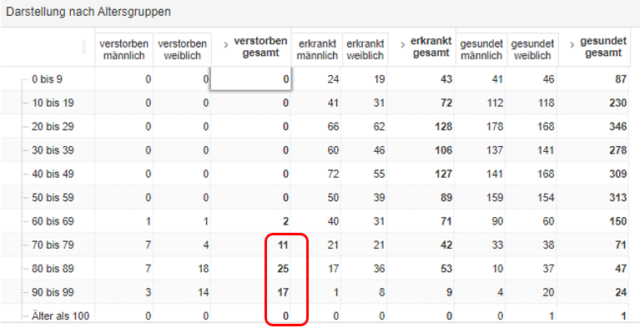

Dazu die Tabelle der aktuellen Fallzahlen:

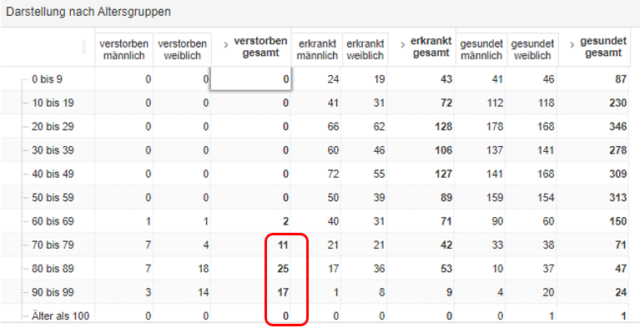

Bild 12 Stadt Fürth. Corona-verstorben gesamt 55 Personen, davon 53 ab 70 Jahre alt. Abfrage 08.12.2020. Quelle: kosy

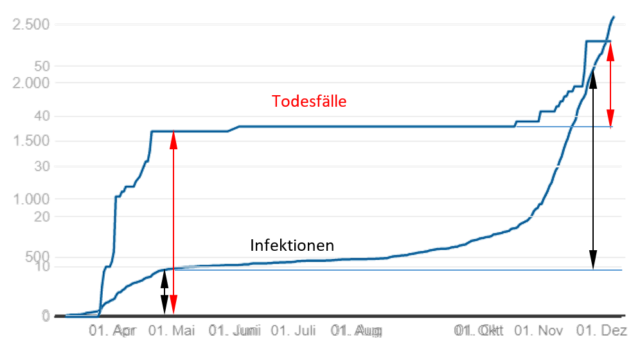

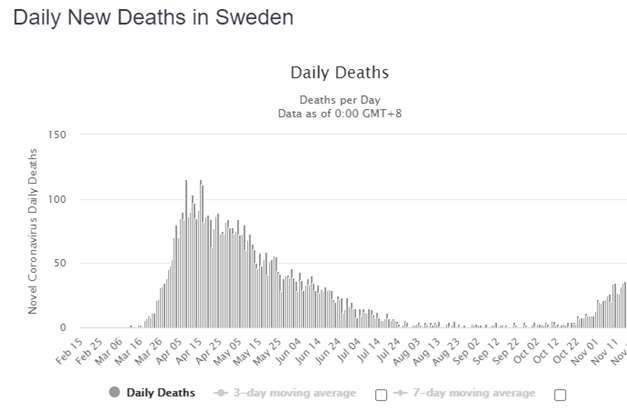

Nun der Vergleich Infektionen (Fallzahl) und Mortalität. Deutlich erkennbar verläuft die „zweite Welle“ gegenüber der ersten im Mortalitätsgeschehen mehr als wesentlich „glimpflicher“.

Bild 13 Stadt Fürth, Verlauf Corona-Infektionen und –Todesfälle. Grafik vom Autor durch übereinander kopieren erstellt. Quelle: Corona-in-Zahlen.de

Dazu der statistische Vergleich mit „Standard-“ Mortalität:

Deutschland

Jahr 2018: Einwohnerzahl: 82,8 Mio. Einschl. KW 49 verstorben: 897.408 Personen.

Davon waren über 70 Jahre alt: 765.980 Personen (anteilig 85,4 % der Verstorbenen)

Fürth

Einwohnerzahl: 128.500. Davon statistisch im Jahr 2018 bis einschl. KW 49 verstorben: 1.392 Personen, über 70 Jahre alt: 1.188 Personen .

2020 einschl. KW 49 an Corona verstorben: 55 Personen (davon 53 ab70 Jahren).

Der Corona-Anteil beträgt somit bisher ca. 4,63 % der statistischen Gesamt-Sterbezahl der über 70-Jährigen.

Intelligente Lösungen

Die unfehlbare Merkel ist unter dem üblichen Jubel der Medien wieder damit durchgekommen, rein emotionale Brachialmaßnahmen durchzusetzen, deren Wirkung – die Fallzahlen steigen trotzdem – außer den schlimmen Folgen kaum erkennbar bleibt. Der nur noch nachäffende Landesvater Söder hat sie (weil sie ja kein Ergebnis zeigen), sofort nochmals verschärft, da ihm die „Erziehung“ seiner Untertanen besonders am Herzen liegt. Fachlich beraten lässt er sich dabei von einem Corona-Ethikrat, dem eine ehemalige Regional-Bischöfin vorsteht.

Dabei zeigt der im Gegensatz zur GRÜNEN Führungsriege oft mit intelligenten Ansätzen aneckende – und deshalb immer wieder kurz vor dem Parteirauswurf stehende – Bürgermeister von Thüringen schon seit längerem, wie Lösungen aussehen können:

Tagesspiegel 09.12.2020: Boris Palmer über Tübingens Corona-Sonderweg: „Wir haben zuletzt bei den über 75-Jährigen keine Fälle mehr“

In Tübingens Klinik gibt es kaum Corona-Patienten. OB Palmer erklärt, mit welchen Maßnahmen die Älteren in der Pandemiegeschützt werden. Ein Interview.

Wir haben uns zum Ziel gesetzt, die Älteren besonders zu schützen, weil für sie die Gefahr durch Corona mit Abstand am höchsten ist. Deswegen haben wir im September damit begonnen, das Personal in den Altenheimen regelmäßig zu testen.

Im Oktober haben wirSchnelltestsgekauft, seither werden Besucher und Bewohner regelmäßig getestet.

So ist es uns gelungen, das Eindringen des Virus in die Alten- und Pflegeheime in unserer Stadt bisher vollständig zu verhindern. Wir haben insgesamt eine niedrige Sieben-Tage-Inzidenz, die letzten drei Wochen lag die um die 100 Fälle pro 100.000 Einwohner. Bei den über 75-Jährigen haben wir zuletzt überhaupt keine Fälle mehr gehabt. Deshalb hat auch unsereUni-Klinik nur sehr wenige Corona-Patienten.

Sie sagen, es gebe bei den über 75-Jährigen keine Fälle. Gilt das nur für die Altersheime oder auch für Alte, die noch zu Hause wohnen?

Bei den Menschen in den Heimen hatten wir gar keine Fälle. Aber auch die Mitarbeiter der mobilen Pflegedienste werden regelmäßig getestet, so dass wir das Einschleppen des Virus in die Privatwohnungen der Alten verhindern konnten.

Artikel, die einem ganz aktuell erscheinen, aber schon Jahre alt sind

Der mediale „Beschuss“ mit Pandemie-Fallzahlen und immer neuen, schlimmeren Darstellungen lässt meinen, so etwas wäre wohl einzigartig – deshalb die erforderlichen, extremen Maßnahmen – und früher noch nie vorgekommen.

Die folgenden Artikel sind schon alt und älter, erschienen aber in „schöner“ Regelmäßigkeit. Man fragt sich, warum unsere Politik damals keine Notstände ausgerufen hat.

Der Tagesspiegel 09.01.2000: Krankenhäuser überfüllt – Patienten liegen auf Pritschen in den Gängen

Nach Großbritannien und Deutschland hat die Grippewelle jetzt auch Italien erreicht. Die Krankenhäuser in Mailand, Florenz und Venedig sind nach Presseberichten vom Sonntag derart überfüllt, dass praktisch keine Betten mehr frei sind. In vielen Hospitälern müssten die Kranken auf Pritschen auf den Gängen liegen. In Mailand war es über Stunden nicht möglich, einen Krankenwagen zu rufen: Patienten, die im Krankenhaus keine Aufnahme fanden, blockierten die Einsätze. Die Zeitung „La Repubblica“ meldete, allein in Turin seien zehn ältere Menschen an den Folgen der Virusgrippe gestorben. Derzeit würden 250 000 Fälle pro Woche registriert. Dabei sei der Höhepunkt der Grippewelle erst Ende Januar zu erwarten. Man rechne mit bis zu acht Millionen Kranken … In Deutschland nimmt die Zahl der Fälle ebenfalls zu. Vor allem Baden-Württemberg, Bayern und Thüringen sind betroffen …

Welt 19.02.2013: Grippewelle hat Köln fest im Griff

In Köln werden nicht nur die Betten auf den Intensivstationen knapp – auch die Blutkonserven werden weniger. Grund dafür ist die grassierende Grippe.

Bettenknappheit in Kölner Krankenhäusern. Aufgrund der vielen Grippekranken sind die Intensivstationen komplett überfüllt. Zeitweise sind die Krankenhäuser sogar so überlastet, dass sie keine neuen Patienten mehr aufnehmen können. Operationen müssen aufgrund der angespannten Lage verschoben werden.

Gegenüber der „Kölnischen Rundschau“ sagte der Chef der Anästhesie und Intensivstation in Hohenlind, dass zeitweise elf von 14 Intensivbetten mit Infektionspatienten belegt waren. Grund dafür ist nicht nur das Influenza-Virus, sondern auch ein aggressives Virus, das Atemwegserkrankungen bis hin zum Lungenversagen verursacht. Infolge dessen müssen die – meist älteren – Betroffenen zum Teil beamtet werden.

… Grippewellen seien nichts Ungewöhnliches, sagt Anne Bunte gegenüber Welt online. Saisonal würden sie immer wieder auftreten.

SZ 13. Februar 2015:Vor dem Kollaps

Alarmstimmung in Bayerns Kliniken: Der Patientenansturm ist so groß, dass die Notaufnahmen an vielen Häusern aktuell völlig überlastet sind. „Momentan ist die Situation – auch durch die Grippewelle – extrem angespannt, wir stehen mit dem Rücken zur Wand“, sagt Günter Niklewski, der Ärztliche Direktor des Klinikums Nürnberg. „Voll, voll, alles voll“, sagt er bei seiner Rückkehr aus der Notaufnahme, „wir kommen derzeit an die Kante von dem, was noch geht.“ Niklewski steht mit diesem Problem nicht alleine, selbst in der Landeshauptstadt München, die über mehr Versorgungsangebote verfügt, geraten immer mehr Häuser an ihre Kapazitätsgrenze und melden sich in der Rettungsdienstleitstelle ab – Botschaft: „Wir haben kein Notfallbett mehr.“

Ärzteblatt 7. Februar 2017: Grippewelle sorgt für überlastete Kliniken

Nachdem die Grippewelle in Frankreich bereits für eine Überlastung der Krankenhäuser und zu verschobenen Operationen geführt hat, scheint die Grippewelle nun auch die ersten Kliniken in Deutschland zu treffen. Bereits gestern hatte das Städtische Krankenhaus in Görlitz Patienten vorerst abweisen müssen. Nun klagen die Notaufnahmen mehrerer Kliniken in Nürnberg und München über Überlastung

… „Es ist extrem schwierig im Moment. Uns ist keine vergleichbare Situation in dem Ausmaß aus den vergangenen Jahren bekannt.“ Der Bayerische Rundfunk hatte zuerst über die Engpässe berichtet.

Immer wieder müssten Kliniken in Nürnberg ihre Notaufnahmen zeitweise schließen, sagte Reißmann. Teils müssten Patienten auf Krankenhäuser in Erlangen und im Nürnberger Land verteilt werden. „Die Rettungswagen sind derzeit lange unterwegs, bis sie die Patienten unterbringen.“

nordbayern.de 22.02.2018: Grippe-Welle grassiert: Krankenhäuser sind überlastet Zahl der Influenzafälle in der Region steigt immer weiter an

NÜRNBERG – Die diesjährige Grippewelle hat die Region jetzt mit voller Kraft erfasst. Etliche Krankenhäuser können schon keine Influenza-Patienten mehr aufnehmen. Viele Kliniken haben sich wegen voller Betten bereits von der Rettungsleitstelle abgemeldet …

Es bleibt nur die Schlussfolgerung übrig: Damals gab es keine Bilder aus Bergamo mit medienwirksam, auf einem langen Militär-Lastwagenkorso abtransportierten Särgen. Meldungsarten, auf die unsere Kanzlerin (und deren höfische Umgebung) grundsätzlich mit panischen Entscheidungen reagiert.

Es ist also angebracht, weiterhin daran zu zweifeln, dass in Berlin (und leider auch in Bayern) von Vernunft getrieben entschieden wird.

Der GRÜNE Bürgermeister von Tübingen hat es gerade treffend beschrieben: Tagesspiegel, 08.12.2020: … Die Berlinerinnen und Berliner sind einer aktuellen Umfrage zufolge ziemlich unzufrieden mit dem Krisenmanagement des Berliner Senats. Können Sie das verstehen?

Da steht mir kein Urteil zu, aber ich habe ja schon mal gesagt, was ich als Privatmensch denke, wenn ich nach Berlin komme: Vorsicht, Sie verlassen jetzt den funktionierenden Teil Deutschlands …