„Globale Abkühlung wird uns alle umbringen“

Versuche des berüchtigten William Connolley, der in einem vergeblichen Versuch, die Geschichte mit der willkürlichen Veränderung von 5428 Wikipedia-Einträgen zu verändern und den „Global Cooling Scare“ aus dem Internet zu löschen, scheiterten. Wie James Delingpole in The Telegraph erklärt, verwandelte Connolley Wikipedia systematisch in eine Maschine, welche die vom Menschen verursachte globale Erwärmung vor sich her peitschte (Delingpole, 2009). Er schrieb Artikel zur globalen Erwärmung, zum Treibhauseffekt, zu Klimamodellen und zur globalen Abkühlung um. Dabei versuchte er, die mittelalterliche Warmzeit und die kleine Eiszeit auszulöschen. Auf den Seiten von Wikipedia machte er berühmte Klimawissenschaftler, die der vom Menschen verursachten globalen Erwärmung skeptisch gegenüberstanden, wie Richard Lindzen, Fred Singer, Willie Soon und Sallie Baliunas, nieder. Außerdem hinderte er die Menschen daran, seine Lügen zu korrigieren.

William Connolley ist mit Michael Mann und seinem Hockeyteam befreundet, zu welchem auch Phil Jones und Raymond Bradley gehören. Er ist auch Mitbegründer der alarmistischen Website Realclimate.org. Offensichtlich sorgte Connolley dafür, dass Mann und Bradley bei Wikipedia glühendes Lob erhielten, bis er 2009 gefeuert und als Wikipedia-Administrator abgesetzt wurde (Delingpole, 2009).

Es überrascht uns nicht, dass Connolley als Koautor der von Fachkollegen begutachteten Studie „The Myth of the 1970s Global Cooling Scientific Consensus“ in BAMS [= Bulletin of the American Meteorological Society] auftaucht, das von Thomas Peterson, William Connolley und John Fleck verfasst wurde (Peterson, Connolley, & Fleck, 2008). Das Papier ist Unsinn und macht keinen Unterschied, weil Fakten stur sind. Dass die Studie die Begutachtung bestanden hat, zeigt, wie korrupt die Klimawissenschaft geworden ist. Die Einleitung darin liest sich so:

In den 1970er Jahren gab es keinen wissenschaftlichen Konsens darüber, dass die Erde auf eine bevorstehende Eiszeit zusteuerte. Tatsächlich dominierte die Möglichkeit einer anthropogenen Erwärmung schon damals die von Experten begutachtete Literatur“. (Peterson, Connolley, & Fleck, 2008)

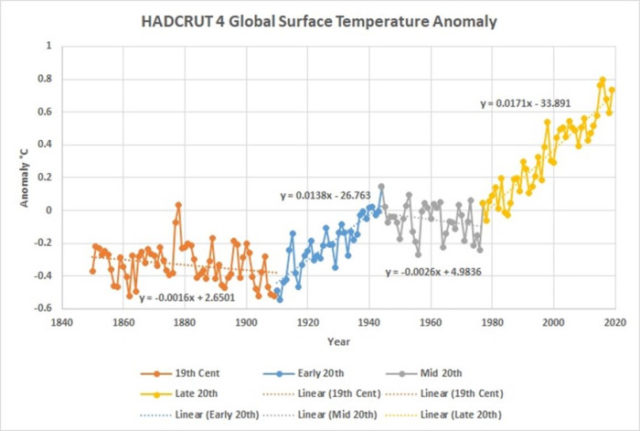

Abbildung 1. Rekonstruktion der globalen Durchschnittstemperatur seit 1850 seitens U.K. Met Office Hadley Centre und der Climatic Research Unit (CRU) an der University of East Anglia. Sie zeigt, wie auch andere Rekonstruktionen, eine globale Abkühlung um etwa 0,09°C (0,16°F) von 1944 bis 1977.

Die globale Abkühlungsangst der 1960er und 1970er Jahre war vorhanden: Sowohl Klimawissenschaftler als auch die Öffentlichkeit befürchteten, dass sich der globale Abkühlungstrend, der in den 1940er Jahren begann (siehe Abbildung 1), fortsetzen und die Welt sehr kalt werden, vielleicht sogar zu einer Gletscherperiode zurückkehren würde, wie sie vor etwa 11.700 Jahren zu Beginn des Holozäns endete.

Die Studie von Peterson, et al. sucht sich ebenso sorgfältig wie willkürlich 71 Studien heraus und behauptet, dass nur sieben davon zwischen 1965 und 1979 der „Konsens“-Position widersprachen, der zufolge die globale Erwärmung in der Zukunft stattfinden würde. Sie fanden 20, die eine neutrale Position vertraten und 44, die mit dem Konsens über die globale Erwärmung übereinstimmten. Aber die Welt kühlte sich damals ab und zwar seit 1944. Kenneth Richard untersuchte dies und erweiterte den Zeitrahmen auf 1960 bis 1989. Richard fand 285 Studien, die nicht mit der „Konsens“-Position übereinstimmten, dass die globale Erwärmung in der Zukunft stattfinden würde (Richard, 2016).

Von diesen 285 Beiträgen diskutierten 156 die Abkühlung seit 1940 und sagten eine zukünftige Abkühlung voraus. Sieben versuchten zu zeigen, dass CO2 die Abkühlung verursachen könnte. Eine vollständige Liste der Beiträge kann von Kenneth Richards Beitrag heruntergeladen werden. Die Panikmacher fälschten die Zahlen, um einen 97%igen Konsens darüber zu zeigen, dass der Mensch die globale Erwärmung verursacht hat, dann fälschten sie auf die gleiche Weise den Konsens über die globale Kühlung.

Angus McFarlane nahm die von Kenneth Richard und Peterson u.a. erstellten Datenbanken, führte sie zusammen (es gab 16 Duplikate) und führte dann eine eigene unabhängige Suche durch. Er fand zwei weitere relevante Studien, die nicht bereits in einer der beiden Datenbanken enthalten waren. Dann eliminierte er die Studien, die außerhalb des ursprünglichen Zeitraums von 1965-1979 von Peterson et al. lagen.

McFarlanes Datenbank ist kleiner als die von Richard und enthält nur 190 relevante Arbeiten, aber das sind 119 mehr als die von Peterson u.a. gefundenen, und sie decken den gleichen Zeitraum ab. McFarlanes Durchsicht der Arbeiten ergab, dass 86 eine künftige Abkühlung, 58 eine neutrale und 46 eine Erwärmung vorhersagten. Von den 86 Abkühlungs-Studien sagten 30 eine mögliche neue „Eiszeit“ voraus. Streng genommen befinden wir uns nun aber in einer Eiszeit, was bedeutet, dass eine neue Eiszeit gemeint ist, in der sich das Eis zu einem neuen großen neuen Maximum ausdehnt wie vor 19.000 Jahren im letzten großen Gletschermaximum. Die 86 Abkühlungs-Studien machen 45% der Gesamtzahl aus. Wenn wir die neutralen Papiere ignorieren, wie es John Cook, et al. (Cook, et al., 2013) in seiner 97%-Konsensstudie taten, dann machen die Abkühlungspapiere 65% der Papiere aus, die eine Stellungnahme abgegeben haben. Wenn wir Cooks Regeln verwenden, können wir bequemerweise behaupten, dass es 1979 einen globalen Konsens bzgl. Abkühlung gab.

Als sich jedoch der Abkühlungstrend Mitte des zwanzigsten Jahrhunderts umkehrte und zu einem Erwärmungstrend wurde, dauerte es nicht lange, bis sich auch der „Konsens“ umkehrte. Der globale Oberflächentemperatur-Trend änderte sich um 1977 in Erwärmung (etwa 0,017°C/Jahr, wie in der Grafik dargestellt), und die von Experten begutachteten Klimastudien von 1977-1979 änderten sich in ein Verhältnis von 52% pro Erwärmung zu 48% pro Abkühlung, eine knappe Mehrheit der Erwärmungs-Studien, wobei die neutralen Studien ignoriert wurden. In den 1980er Jahren änderten sich der Trend in den Studien schnell auf Pro-Erwärmung.

[Hervorhebung vom Übersetzer]

Mitte der siebziger Jahre berichtete die Presse, dass ein Konsens von Klimawissenschaftlern glaubte, die Welt kühle sich ab und die Abkühlung werde sich fortsetzen (Struck, 2014). Artikel über den Abkühlungskonsens erschienen in Newsweek, Time, der New York Times und National Geographic. Eine bahnbrechende Geschichte von Peter Gwynne in Newsweek vom 28. April 1975 war typisch (Gwynne, 1975). Sie trug den Titel „The Cooling World“. Im überhitzten Stil der Newsweek beginnt der Artikel: „Es gibt unheilvolle Anzeichen dafür, dass sich die Wettermuster der Erde dramatisch zu verändern begonnen haben“. Später in dem Artikel erklärt Gwynne atemlos: „… das Klima der Erde scheint sich abzukühlen … und die daraus resultierenden Hungersnöte könnten katastrophal sein“. Zu Gwynne’s zitierten Quellen gehören die National Academy of Sciences, Murray Mitchell (NOAA), George Kukla (Columbia University), James McQuigg (NOAA’s Center for Climatic and Environmental Assessment) (Gwynne, 1975).

Anders als viele seiner Kollegen änderte George Kukla von der Columbia University und dem Lamont-Doherty Earth Observatory seine Ansicht über einen langfristigen globalen Abkühlungstrend nicht. Als er am 31. Mai 2014 traurigerweise verstarb, glaubte er immer noch, dass in der Zukunft, vielleicht in 5.000 Jahren, eine neue massive Eiszeit beginnen würde. Javier Vinós sagt in seinem Blogbeitrag über „The next glaciation“ (Vinós, 2018) voraus, dass die nächste große Eiszeit in 1500 bis 2500 Jahren beginnen würde. Es ist ein Glück, dass beide Vorhersagen weit in der Zukunft liegen.

Wenn die nächste globale Abkühlungsperiode beginnt, was unvermeidlich der Fall sein wird – werden Klimawissenschaftler dann mehr Studien bzgl. globaler Abkühlung schreiben? Warum sollten wir Klimawissenschaftlern glauben, die sagen, dass sich die Welt jetzt gefährlich erwärmt, während sie noch vor 50 oder 60 Jahren sagten, dass sie sich gefährlich abkühlt? Eine vernünftige Frage. Welche direkten Beweise sind aufgetaucht, die sie überzeugt haben, den Kurs umzukehren? Wir hatten einen Konsens für die Abkühlung, als sich die Welt abkühlte, jetzt haben wir einen Konsens für die Erwärmung, und die Welt erwärmt sich. Ist das alles, was es dazu zu sagen gibt? Beides sind Hypothesen – was lässt sie zu Fakten oder Theorien werden?

Hypothesen sind spekulative Ideen. Ein echter Wissenschaftler fragt: „Ist das so? Sagen Sie mir, warum Sie das denken!“ Mit einem strengen wissenschaftlichen Verfahren muss nachgewiesen werden, warum beobachtete Ereignisse wie die globale Erwärmung oder Abkühlung eintreten. Zu zeigen, dass sie potenziell gefährlich sind, erfordert sogar noch mehr Arbeit.

Konsens ist eine politische Sache. Die Öffentlichkeit bildet eine Konsensmeinung, stimmt dann ab und erlässt Gesetze oder Regeln, die diese Meinung reflektieren. In der Wissenschaft entwickeln wir zunächst eine Hypothese oder einen Gedanken, der ein beobachtetes Naturphänomen, wie z.B. eine Erwärmung oder Abkühlung, erklärt. Der nächste Schritt ist der Versuch, dies zu widerlegen. Wenn das nicht gelingt, überlebt die Hypothese. Wir veröffentlichen, was wir getan haben, und andere versuchen, die Hypothese zu widerlegen; wenn auch sie das nicht schaffen, überlebt sie. Wenn dies lange genug so weitergeht, wird der Gedanke zu einer Theorie. Eine wissenschaftliche Theorie überlebt einfach, sie wird nie bewiesen, sie muss immer einer Prüfung unterzogen werden.

Wir haben bereits erwähnt, dass sieben der von Angus McFarlane und Kenneth Richard untersuchten Papiere darauf hinwiesen, dass CO2 eine globale Abkühlung verursachen könnte. Ein gutes Beispiel ist Sherwood Idsos Beitrag von 1984 im Journal of Climatology. Das Papier trägt den Titel [übersetzt] „Was ist, wenn ein Anstieg des atmosphärischen CO2 einen umgekehrten Treibhauseffekt hat?“ (Sherwood Idso, 1984). Idso spekuliert, dass zusätzliches CO2 die Pflanzen dazu veranlassen wird, in trockenere Gebiete zu ziehen, weil zusätzliches CO2 bewirkt, dass die Pflanzen weniger Wasser für ihr Wachstum verbrauchen. Idso glaubt, dass dies die Albedo (Reflexionsvermögen) der Erde so verändern könnte, dass die Temperaturen sinken. In ähnlicher Weise spekulierten Richard Lindzen und Yong-Sang Choi, dass zusätzliches CO2 die Luftfeuchtigkeit in den Tropen und damit die Bewölkung erhöhen würde (Lindzen & Choi, 2011). Extrem kleine Veränderungen der durchschnittlichen Bewölkung können tagsüber einen großen kühlenden Effekt haben.

Peter Webster präsentiert eine interessante Diskussion über Sherwood Idsos Arbeit in seiner Klimawandel-Studie „The Carbon Dioxide/Climate Controversy: Some Personal Comments on Two Recent Publications“ (Webster, 1984). Neben einer interessanten Diskussion über die Emotionen, die mit der Debatte über den vom Menschen verursachten Klimawandel verbunden sind, können wir aus Websters Diskussion und Idsos Papier ersehen, wie wenig wir wirklich über die Auswirkungen von zusätzlichem CO2 in der realen Welt wissen. Winzige Veränderungen in der Albedo der Erde, sei es durch Bewölkung oder durch die Verteilung von Pflanzen, können einen großen Unterschied machen.

Empirische Schätzungen der ECS (die Veränderung der Lufttemperatur aufgrund der Verdoppelung der CO2-Konzentration) haben nie mit theoretischen Berechnungen aus Klimamodellen übereingestimmt. Die empirischen Werte (wie die von Idso oder die von Lindzen und Choi) sind normalerweise nur etwa halb so groß wie die Modellschätzungen und können wie die von Idso sogar negativ sein. Dies ist wahrscheinlich, weil den Modellen etwas fehlt – u. A. vielleicht mögliche zukünftige Veränderungen der Albedo durch wechselnde Bewölkungsverhältnisse und die Verbreitung von Pflanzen.

This post is condensed and modified from my new book, Politics and Climate Change: A History.

To download the post bibliography click here

Link: https://wattsupwiththat.com/2020/11/05/global-cooling-will-kill-us-all/

Übersetzt von Chris Frey EIKE