Der nationale Temperatur-Index der USA – beruht er auf Daten oder auf Korrekturen?

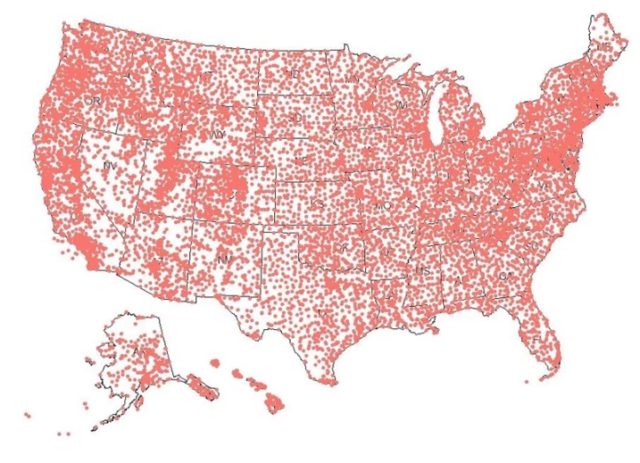

GHCN-Daily enthält die qualitäts-geprüften Rohdaten, die anschließend korrigiert und dann zum Auffüllen von GHCN-Monthly, einer Datenbank mit Monatsdurchschnittswerten, sowohl roh als auch endgültig, verwendet werden. Am 10. Oktober 2020 habe ich Version 4.0.1 der GHCN-Monats-Datenbank heruntergeladen. Zu diesem Zeitpunkt zählte sie weltweit 27.519 Stationen, und 12.514 (45%) davon befanden sich in den Vereinigten Staaten, einschließlich Alaska und Hawaii. Von den 12.514 US-Stationen befanden sich 11.969 in „CONUS“ [= CONtinental USA], den zusammen hängenden 48 Bundesstaaten. Die aktuelle Stationsabdeckung ist in Abbildung 1 dargestellt.

Abbildung 1. Die Abdeckung durch die GHCN-Wetterstation in den Vereinigten Staaten ist sehr gut, mit Ausnahme von Nordalaska. Es gibt zwei Stationen im westlichen Pazifik, die nicht abgebildet sind.

Wir haben mehrere Fragen zur landgestützten Temperaturaufzeichnung, die die langfristige (~170 Jahre) globale Temperaturaufzeichnung dominiert. Die landgestützten Messungen dominieren, weil die Angaben zur Temperatur über den Ozeanen sehr spärlich sind, bis etwa 2004 bis 2007, als das ARGO-Netzwerk von Bojen vollständig genug war, um gute Daten zu liefern. Aber sogar noch 2007 war der Gitterfehler an der Meeresoberfläche größer als die festgestellte Erwärmung des Ozeans.

Erwärmung der Ozeane

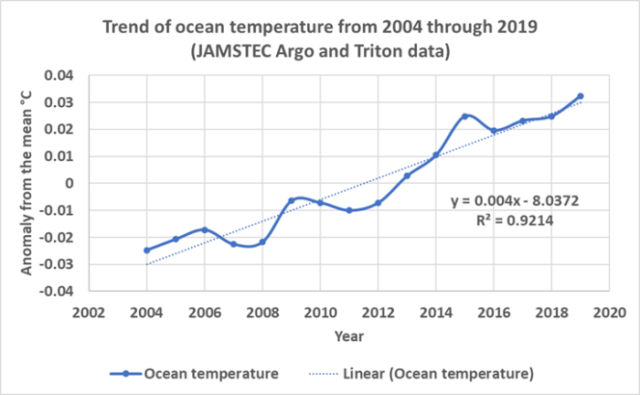

Wir haben geschätzt, dass sich die 71% der Erdoberfläche bedeckenden Ozeane mit einer Rate von 0,4°C pro Jahrhundert erwärmen, basierend auf dem in Abbildung 2 gezeigten linearen Trend der kleinsten Quadrate. Dies ist eine sehr grobe Schätzung und beruht nur auf Daten aus den Jahren 2004 bis 2019 und auf Temperaturen aus den oberen 2.000 Metern der Ozeane. Die Daten vor 2004 sind so spärlich, dass wir sie nicht verwenden wollten. Der Fehler in dieser Schätzung beträgt etwa ±0,26°C von der Oberfläche bis 2.000 Meter, und darunter ist er unbekannt.

Die Argo-Messungen der Meerestemperatur der oberen 2.000 Meter ergeben eine ziemlich konstante Temperatur von 2,4°C. Wir nahmen also eine Temperatur von 0,8°C bei einer durchschnittlichen Meerestiefe von 3.688 Metern und darunter an. Im Zusammenhang damit liegt der Gefrierpunkt des Meerwassers bei 2900 PSI (etwa 2.000 Meter oder 2.000 Dezibar) bei -17°C. Der Wert von 0,8°C stammt aus tiefen Argo-Daten, wie sie von Gregory Johnson und Kollegen beschrieben wurden (Johnson, Purkey, Zilberman, & Roemmich, 2019). Es gibt nur sehr wenige Messungen von Tiefsee-Temperaturen, und jede Schätzung weist erhebliche mögliche Fehler auf (Gasparin, Hamon, Remy, & Traon, 2020). Die Anomalien in Abbildung 2 basieren auf diesen Annahmen. Die berechneten Temperaturen wurden aus dem Mittelwert der Ozeantemperaturen von 2004 bis 2019 in Anomalien umgerechnet. Die zur Erstellung von Abbildung 2 verwendeten Daten stammen aus Jamstec. Ein R-Programm zum Lesen und Plotten der Jamstec-Daten kann hier heruntergeladen werden, die Zip-Datei enthält auch eine Tabellenkalkulation mit weiteren Details. Unsere Berechnungen gehen von einer durchschnittlichen Gesamttemperatur des Ozeans im Zeitraum 2004-2019 von 4,6°C aus.

Abbildung 2. Eine Darstellung des globalen Rasters der Ozeantemperaturen von JAMSTEC. Es ist hauptsächlich aus ARGO-Floats und Triton-Bojendaten aufgebaut. Jamstec ist die Quelle des Gitters, das zur Berechnung dieser Anomalien verwendet wird.

Die beobachtete Erwärmung der Ozeane ist keineswegs alarmierend und ziemlich linear und zeigt keine Anzeichen einer Beschleunigung. Die Ozeane enthalten 99,9% der thermischen Energie („Wärme“) auf der Erdoberfläche, die Atmosphäre enthält den größten Teil des Rests. Dies erschwert es der Erdoberfläche, sich sehr stark zu erwärmen, da die Ozeane als Wärmeregulator wirken. Verschiedene Berechnungen und Konstanten bezüglich der in den Ozeanen und der Atmosphäre gespeicherten Wärme finden Sie in einer Tabelle, die ich hier vorbereitet habe. Referenzen sind in der Tabelle enthalten. Die Ozeane steuern die Erwärmung mit ihrer hohen Wärmekapazität, d.h. mit der Menge an thermischer Energie, die erforderlich ist, um die durchschnittliche Temperatur der Ozeane um ein Grad zu erhöhen. Die Wärmeenergie, die benötigt wird, um die Temperatur der Atmosphäre um 1000 Grad C zu erhöhen, würde die durchschnittliche Meerestemperatur nur um ein Grad erhöhen.

Ich erwähne dies nur, weil die landgestützten Wetterstationen uns zwar wertvolle Informationen über das Wetter liefern, aber nur sehr wenig über den Klimawandel. Längerfristige Veränderungen des Klimas erfordern viel mehr Informationen über die Erwärmung der Ozeane, als uns derzeit zur Verfügung stehen. Dennoch wollen wir die in den Vereinigten Staaten gesammelten GHCN-Daten einmal unter die Lupe nehmen.

Die GHCN-Stationsdaten

In den USA und im Rest der Welt machen die landgestützten Wetterstationen den größten Teil der durchschnittlichen Temperaturaufzeichnungen des 19. und 20. Jahrhunderts aus. Es ist wichtig zu wissen, wie genau sie sind und welchen Einfluss die Korrekturen haben, die in Bezug auf die beobachtete Erwärmung angewendet werden. Es ist viel Arbeit geleistet worden, um Probleme mit den landgestützten Daten zu dokumentieren. Anthony Watts und Kollegen dokumentierten 2011 mit ihrem Projekt für Landstationen zahlreiche Probleme mit der Stationsauswahl und -ausrüstung. Wichtige Informationen zu dieser Studie von John Neison-Gammon können hier und hier eingesehen werden. Die Veröffentlichung im Journal of Geophysical Research finden Sie hier. Viele der radikalen Veränderungen im US-Temperaturindex der NOAA und in der zugrunde liegenden Datenbank im Zeitraum zwischen 2009 und 2014 sind auf die Arbeit von Watts und seinen Kollegen zurückzuführen, die von Matthew Menne von der NOAA in seinem Einführungspapier zur Version 2 des U.S. Historical Climatology Network (USHCN) beschrieben wurde:

„Darüber hinaus gibt es Hinweise darauf, dass ein großer Teil der HCN-Standorte in Bezug auf die vom U.S. Climate Reference Network verwendeten Standortklassifizierungskriterien schlechte Bewertungen haben (persönliche Mitteilung von A. Watts 2008; siehe auch www.surfacestations.org)“. (Menne, Williams, & Vose, 2009)

Menne, et al. bestätigten Watts und Kollegen in ihrem Einführungspapier zum überarbeiteten USHCN-Stationsnetz, was darauf hindeutet, dass das Projekt der Oberflächenstationen ein wichtiger Grund für die Revision war. USHCN war eine qualitativ hochwertige Teilmenge des gesamten Wetterstationsnetzes des Cooperative Observer Program (COOP) der NOAA). Die USHCN-Stationen wurden laut Matthew Menne auf der Grundlage ihrer räumlichen Abdeckung, Aufzeichnungslänge, Datenvollständigkeit und historischen Stabilität ausgewählt. Zur Bereinigung der ausgewählten Aufzeichnungen wurde eine Reihe von Qualitätskontrollprüfungen und Korrekturen entwickelt, die in den Veröffentlichungen von Matthew Menne und Kollegen beschrieben sind. Aus der Hauptstudie stammt das Zitat oben, aber er schrieb auch einen Beitrag zur Beschreibung ihres paarweisen Homogenisierungs-Algorithmus, abgekürzt „PHA“ (Menne & Williams, 2009a). Stationen mit Problemen, wie sie von Watts u.a. gefunden und dokumentiert worden waren, wurden aus USHCN entfernt. Infolgedessen schrumpften die ursprünglichen 1218 USHCN-Stationen bis 2020 auf ~832. Die abgebauten Stationen wurden nicht ersetzt, die Werte wurden statistisch anhand von Daten benachbarter Stationen „aufgefüllt“.

Anfang 2014 wurde die Teilmenge USHCN als Quelldaten für den Nationalen Temperaturindex aufgegeben und durch eine gerasterte Version von GHCN ersetzt, aber die für USHCN entwickelten Korrekturen wurden beibehalten. Sie wurden nur auf alle 12.514 U.S.-GHCN-Stationen angewandt und nicht auf die kleinere USHCN-Untermenge von 1.218 Stationen (oder weniger).

NOAA scheint dem in einer anderen Webseite über GHCN-Daily-Verfahren zu widersprechen. Auf dieser Seite heißt es, dass GHCN-Daily keine Anpassungen für historische Stationsänderungen oder tageszeitliche Verzerrungen enthält. Aber sie merken an, dass GHCN-Monthly dies tut. Es scheint also, dass die Korrekturen nach der Extraktion der täglichen Daten und während der Erstellung des monatlichen Datensatzes vorgenommen werden. Die NOAA manipuliert die GHCN-Tagesrohdaten nicht, aber wenn sie sie extrahieren, um den GHCN-Monatsdatensatz zu erstellen, wenden sie einige dramatische Korrekturen an, wie wir sehen werden. Einige NOAA-Webseiten weisen darauf hin, dass die Korrekturen der Tageszeitverzerrung für spätere Versionen von GHCN-Monatlich entfallen sind, aber die meisten sagen ausdrücklich, dass sie immer noch verwendet werden, so dass wir annehmen, dass genau das immer noch der Fall ist. Eine der beunruhigendsten Erkenntnisse war, wie oft und wie radikal die NOAA ihre „Korrektur“-Verfahren zu ändern scheint.

Die Entwicklung des US-Temperaturindex‘

Der aktuelle US-amerikanische „National Temperature Index“ bezieht Daten aus den Fünf-Kilometer-Rastern des GHCN-Monatsdatensatzes. Der monatliche gerasterte Datensatz wird nClimGrid genannt und besteht aus einem Satz von Kartengittern und enthält keine tatsächlichen Stationsdaten. Die Gitternetze werden mittels „klimatologisch unterstützter Interpolation“ (Willmott & Robeson, 1995) erstellt. Die Gitter werden verwendet, um einen monatlichen Durchschnittstemperatur-Datensatz, nClimDiv genannt, zu füllen. Dieser wird dann zur Erstellung des Index‘ verwendet.

Gegenwärtig ist die NOAA-Basisperiode für nClimDiv-, USHCN- und USCRN-Anomalien 1981-2010. Wir haben unsere Stationsanomalien, die unten dargestellt sind, unter Verwendung derselben Basisperiode konstruiert. Wir akzeptierten alle Stationen, die während der Basisperiode mindestens 12 Monatswerte hatten, und lehnten Stationen mit weniger Werten ab. Dadurch verringerte sich die Anzahl der CONUS-Stationen von 11.969 auf 9.307. In dieser Studie wurden keine Stationen interpoliert oder „aufgefüllt“.

Einige Quellen haben vorgeschlagen, dass Daten außerhalb des GHCN-Daily-Datensatzes verwendet werden könnten, um die nClimDiv-Monatsraster und den Temperaturindex zu erstellen, insbesondere einige nahegelegene kanadische und mexikanische Monatsdurchschnitte. NOAA/NCEI erwähnen dies jedoch kaum auf ihrer Website. nClimDiv enthält Klimadaten, einschließlich Niederschlag und einen Dürreindex, sowie die monatliche Durchschnittstemperatur. Wie bereits erwähnt, werden an den Daten der GHCN-Station dieselben Korrekturen vorgenommen, die auch im älteren USHCN-Datensatz verwendet wurden. Auf der NOAA-Website liest man:

„Die erste (und einfachste) Verbesserung des nClimDiv-Datensatzes besteht in der Aktualisierung des zugrunde liegenden Stationsnetzes, das jetzt zusätzliche Stationsdatensätze und zeitnahe Bias-Korrekturen enthält (d.h. diejenigen, die im U.S. Historical Climatology Network Version 2 verwendet werden)“ Quelle

Neben dem neuen vollständig korrigierten GHCN-Monatsdatensatz und dem kleineren USHCN-Satz korrigierter Stationsdaten gab es früher noch einen dritten Datensatz, den ursprünglichen NOAA-climate divisional-Datensatz. Wie GHCN-Daily und nClimDiv verwendete diese ältere Datenbank das gesamte COOP-Stationsnetz. Die im älteren Klimaabteilungsdatensatz (in Fenimore u.a. „TCDD“ genannt) verwendeten COOP-Daten waren jedoch unkorrigiert. Dies wird in einem Whitepaper von Chris Fenimore und Kollegen erläutert (Fenimore, Arndt, Gleason, & Heim, 2011). Darüber hinaus wurden die Daten in dem älteren Datensatz einfach nach Klimaeinteilung und Bundesstaat gemittelt, sie waren nicht gerastert, wie nClimDiv und USHCN. Es gibt einige neue Stationen in nClimDiv, aber die meisten sind die gleichen wie in TCDD. Der Hauptunterschied zwischen den beiden Datensätzen sind die Korrekturen und die Rasterung. Daten aus dieser früheren Datenbank sind in den Abbildungen 6 und 7 unten als blaue Linie eingezeichnet.

Die einfachen Mittelwerte, die zur Zusammenfassung des TCDD verwendet wurden, ignorierten Veränderungen in der Höhe, Stationsverschiebungen und andere Faktoren, die in vielen Bereichen falsche interne Trends (Diskontinuitäten) einführten. Das neuere nClimDiv-Team für die monatliche Datenbank behauptet, die Stationsdichte und -höhe mit ihrer „klimatologisch gestützten Interpolations“-Rastermethode explizit zu berücksichtigen (Fenimore, Arndt, Gleason, & Heim, 2011). Die Methode liefert den vollständig korrigierten und gerasterten nClimGrid Fünf-Kilometer-Rasterdatensatz.

nClimDiv ist nützlicher, da die Gradienten innerhalb der Vereinigten Staaten in Bezug auf Temperatur, Niederschlag und Dürre genauer sind und weniger Diskontinuitäten enthalten. Aber, wie wir bereits in früheren Beiträgen erklärten, ist nClimDiv, wenn nClimDiv auf einen jährlichen gleichzeitigen Temperaturrekord der Vereinigten Staaten (CONUS) reduziert wird, dem Rekord des älteren, offiziellen Temperaturrekords namens USHCN sehr ähnlich, wenn beide auf die gleiche Weise gerastert werden. Dies mag daran liegen, dass nClimDiv zwar viel mehr Wetterstationen hat, auf diese jedoch dieselben Korrekturen angewandt werden wie auf die USHCN-Stationen. USHCN hat zwar weniger Stationen, aber sie sind von höherer Qualität und haben längere Aufzeichnungen. Die zusätzlichen nClimDiv-Stationen ändern, wenn sie auf die gleiche Weise wie die USHCN-Stationen verarbeitet werden, nichts, zumindest nicht auf nationaler und jährlicher Ebene. Wie in einem früheren Beitrag [in deutscher Übersetzung hier] erwähnt, spielt das schnellere Umrühren des Dungs mit leistungsfähigeren Computern und Milliarden von Dollar für weit verbreitete Durchschnittswerte keine Rolle.

Es gibt gute Gründe für all die Korrekturen, die die NOAA auf die Daten anwendet. Der Gridding-Prozess verbessert zweifellos den Nutzen der Daten intern. Künstliche Kartierungsdiskontinuitäten werden geglättet und Trends werden klarer erkennbar. Aber die Korrekturen und der Gridding-Prozess sind statistischer Natur, sie tragen nicht zur Verbesserung der Genauigkeit des Nationalen Temperaturindex bei. Wenn ein spezifisches Problem mit einem bestimmten Thermometer festgestellt und behoben wird, wird die Genauigkeit verbessert. Wenn die Ursache nicht bekannt ist und die Messwerte mit Hilfe benachbarter Thermometer oder eines statistischen Algorithmus „angepasst“ oder „aufgefüllt“ werden, sehen die resultierenden Tabellen besser aus, sind aber nicht genauer.

Der Übergang von USHCN zu nClimDiv für den National Temperature Index

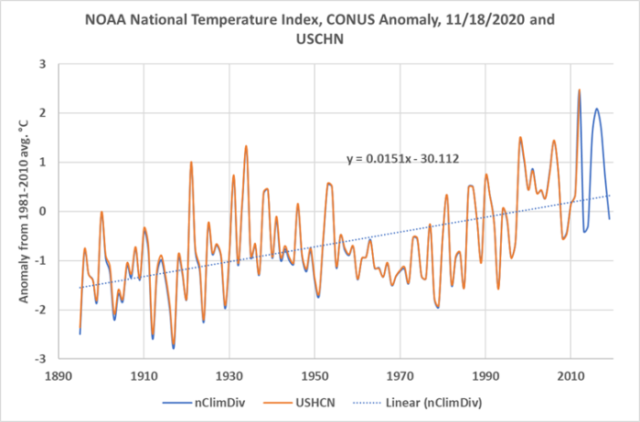

Wie viel des nationalen Temperaturindex-Trends ist auf die tatsächliche Erwärmung zurückzuführen und wie viel auf die Korrekturen und die Rastermethode? Wie groß ist der Fehler in den endgültigen Schätzungen der Temperaturanomalien? Jahrzehntelange Kritik und die Revisionen der NOAA an der Berechnung haben diese Frage nicht beantwortet oder das Ergebnis verändert. Abbildung 3 zeigt den Nationalen Temperaturindex, extrahiert von der NOAA-Website am 18. November 2020. Sowohl die USHCN- als auch die nClimDiv-Berechnungen sind eingezeichnet. Erinnern Sie sich an die Steigung der Linie der kleinsten Quadrate, 1,5°C pro Jahrhundert, sie wird später im Beitrag wichtig sein.

Abbildung 3. Die nClimDiv- und USHCN-Klimaanomalien gegenüber dem Durchschnitt der Jahre 1981-2010. Die Daten wurden von ihrer Website heruntergeladen. Beide aufgezeichneten Datensätze stammen aus Gitternetzen, nicht aus Stationsdaten.

Es ist seit langem bekannt, dass der Nationale Temperaturindex nicht den zugrunde liegenden veröffentlichten Daten folgt. Anthony Watts hat dies berichtet, ebenso wie Jeff Masters, Christopher Burt und Ken Towe. Die Probleme bestehen sowohl in den GHCN-Daten als auch in den USHCN-Daten, wie von Joseph D’Aleo berichtet. Brendan Godwin argwöhnt, dass die heute verwendeten „Homogenisierungs“-Algorithmen (siehe die Diskussion über PHA oben) daran schuld sind. Wenn die „korrigierten“ Daten einen ganz anderen Trend aufweisen als die Rohdaten, sollte man skeptisch sein.

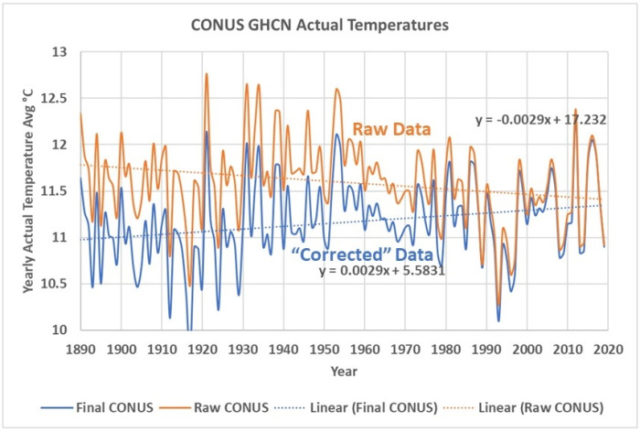

Anthony Watts glaubt nicht, dass die zugrunde liegenden Probleme mit dem vollständigen COOP-Netzwerk von Wetterstationen behoben sind, wie er hier im vergangenen Jahr erklärte. Er glaubt, dass die NOAA das Problem „unter den Teppich kehrt“. Die in Abbildung 3 dargestellten Daten sind vollständig korrigiert und gerastert, es handelt sich nicht um eine Darstellung von Stationsdaten. In Abbildung 4 sind die vollständig korrigierten Stationsdaten in Blau und die Rohdaten in Orange aus dem CONUS-Teil des GHCM-Monatsheftes eingezeichnet. Dies sind die gleichen Daten, die zur Erstellung der in Abbildung 3 gezeichneten nClimDiv-Kurve verwendet wurden, aber bei Abbildung 4 handelt es sich um die tatsächlichen Stationsdaten.

Abbildung 4. Die orangefarbene Linie ist die unkorrigierte monatliche Durchschnittstemperatur, die in der NOAA-Terminologie als „qcu“ bezeichnet wird. Die blaue Linie ist korrigiert oder die „qcf“ der NOAA.

Abbildung 4 zeigt die tatsächlichen Messungen von den Stationen, es sind keine Anomalien und die Daten sind nicht gerastert. Die Rohdaten zeigen, dass sich CONUS um 0,3°C pro Jahrhundert abkühlt, während die korrigierten Daten zeigen, dass sich CONUS um 0,3°C Grad pro Jahrhundert erwärmt. Diese Linien sind, wie alle eingepassten Linien in diesem Beitrag, Excel-Trendlinien der kleinsten Quadrate. Die Linien dienen lediglich dazu, den wahrscheinlichsten linearen Trend in den Daten zu identifizieren, daher ist das R2 irrelevant, wir versuchen nicht, Linearität zu demonstrieren.

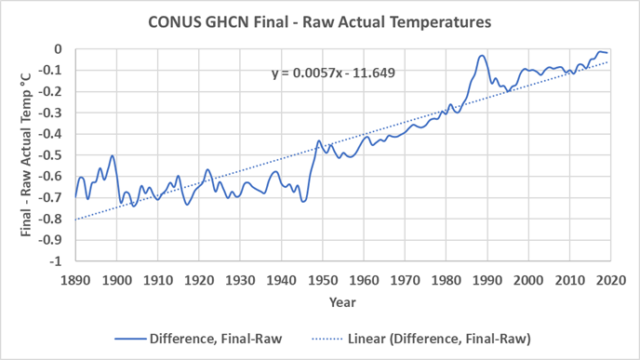

Der Unterschied zwischen den beiden Kurven in Abbildung 4 ist in Abbildung 5 dargestellt. Die Steigung der Differenz ist ein Erwärmungstrend von 0,57°C pro Jahrhundert. Dies ist der Anteil der Erwärmung in Abbildung 3, der direkt auf die Korrekturen der Messungen zurückzuführen ist.

Abbildung 5. Damit wird die Differenz (Final-Raw) zwischen den beiden tatsächlichen Stationstemperaturkurven in Abbildung 4 dargestellt. Man erkennt, dass die Differenz zwischen den Trends der End- und Rohkurve seit 1890 etwa 0,8°C beträgt, was in etwa der behaupteten Erwärmung der Welt in diesem Zeitraum entspricht.

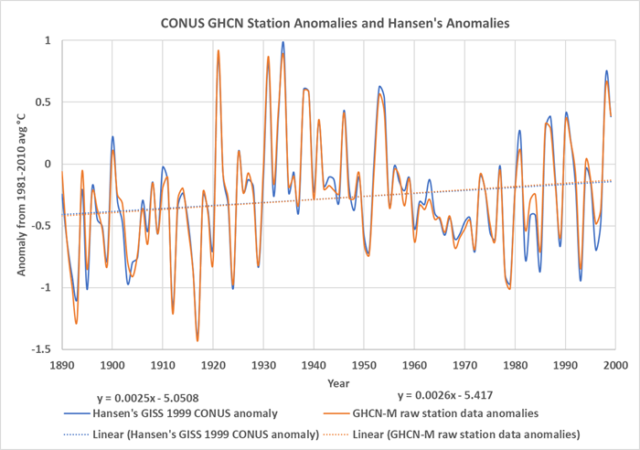

Vielen Lesern wird Abbildung 4 bekannt vorkommen. Steven Goddards Real Science-Blog veröffentlichte im Jahr 2012 eine NASA-GISS-Version der CONUS-Rohdatenanomalien aus dem Jahr 1999. Der von ihm verwendete Datensatz ist inzwischen von der NASA-Website gelöscht worden, aber eine Kopie kann hier heruntergeladen werden und ist in Abbildung 6 zusammen mit den aktuellen (Oktober 2020) GHCN-M-Rohdaten eingezeichnet. Wir wechseln von den tatsächlichen Temperaturmessungen in Abbildung 4 zu den Anomalien der Wetterstation vom Mittelwert 1981-2010 in Abbildung 6.

Abbildung 6. Die NASA GISS-CONUS-Temperaturanomalien von 1999 im Vergleich zu den GHCN-M-Roh-CONUS-Temperaturanomalien von 2020. Die NASA-Anomalien von 1999 sind um 0,32°C nach unten verschoben, so dass die Mittelwerte von 1890 bis 1999 übereinstimmen. Dies dient dazu, die Grundlinienunterschiede auszugleichen. Man beachte, dass die Trends der kleinsten Quadrate sehr genau übereinstimmen. Hansens Daten zeigen einen Erwärmungstrend von 0,25°C pro Jahrhundert und die modernen Daten zeigen eine Erwärmung von 0,26°C pro Jahrhundert. Die Gleichungen für die Linien befinden sich in der Legende. Siehe den Text für die Datenquellen.

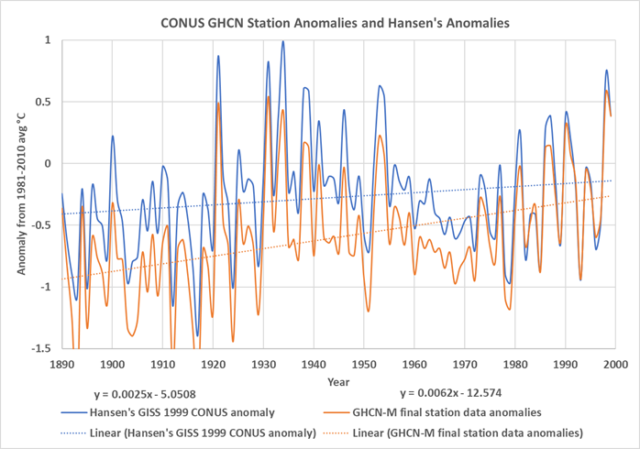

Sowohl die aktuellen Daten als auch die Daten von 1999 zeigen eine Erwärmung von etwa 0,25°C pro Jahrhundert. Abbildung 7 zeigt die gleichen GISS 1999 Rohdatenanomalien im Vergleich zu den 2020 GHCN-M Endtemperaturanomalien. Alle drei Darstellungen deuten darauf hin, dass es in den Jahren 1931 und 1933 in den angrenzenden US-Bundesstaaten genauso warm wie oder wärmer war als heute. Die verschiedenen Korrekturen, die auf die Rohdaten angewendet wurden und die tatsächlichen Temperaturen in Anomalien verwandeln, haben den Effekt, den Unterschied zwischen den 1930er Jahren und heute zu verringern, aber sie beseitigen ihn nicht, zumindest nicht in den Stationsdaten selbst. Wenn die Daten gerastert werden, wie es in Abbildung 3 der Fall war, kehrt sich der Trend vollständig um, und die modernen Temperaturen sind plötzlich viel wärmer als in den 1930er Jahren. Die Daten von 1999 zeigen erneut eine Erwärmung von 0,25°C pro Jahrhundert, aber die korrigierten Daten zeigen eine Erwärmung von 0,6°C pro Jahrhundert. Dies ist der in Abbildung 5 dargestellten Erwärmung sehr ähnlich, d.h. der Erwärmung, die allein auf die Korrekturen zurückzuführen ist.

Abbildung 7. Die endgültigen und vollständig korrigierten Stationsdaten von GHCN-M für 2020 werden mit den NASA/GISS CONUS-Anomalien von 1999 verglichen. Die Gleichungen für die Linien befinden sich in der Legende.

Die blauen Linien der GISS-Anomalie von 1999 in den Abbildungen 6 und 7 sind identisch, die orangefarbene Linie in Abbildung 6 sind Rohdaten und die orangefarbene Linie in Abbildung 7 sind endgültige, korrigierte Daten. Die größten Korrekturen liegen in den früheren Zeiten und die kleineren Korrekturen liegen in den jüngeren Temperaturen.

Der in WUWT schreibende Witzbold und rundum gute Kerl Dave Middleton kommentierte dies 2016:

„Ich sage nicht, dass ich weiß, dass die Anpassungen falsch sind; aber immer, wenn eine Anomalie ausschließlich auf Datenanpassungen zurückzuführen ist, wird bei mir die rote Flagge gehisst.“ Middleton, 2016

Ich stimme zu, Logik und gesunder Menschenverstand legen nahe, dass Dave zu Recht skeptisch ist.

James Hansen schrieb 1999 über dieses Thema:

Was geschieht mit unserem Klima? War die Hitzewelle und Dürre im Osten der Vereinigten Staaten 1999 ein Zeichen der globalen Erwärmung?

Empirische Beweise unterstützen die Vorstellung kaum, wonach das Klima auf eine extremere Hitze und Dürre zusteuert. Die Dürre von 1999 betraf ein kleineres Gebiet als die Dürre von 1988, als der Mississippi fast ausgetrocknet war. Und 1988 war eine vorübergehende Unannehmlichkeit im Vergleich zu den wiederholten Dürreperioden während der „Dust Bowl“ in den 1930er Jahren, die einen Exodus aus den Prärien verursachte, wie in Steinbecks „Trauben des Zorns“ beschrieben wird. Quelle.

Nun, hier stimme ich mit Hansen vollkommen überein.

Zeke von rankexploits.com, der „Tafel“, versuchte, die Korrekturen im Jahr 2014 zu verteidigen. Er erklärt uns, dass USHCN und GHCN zunächst um den Time-of-Measurement Bias („TOB“) [etwa: Messzeitpunkt] korrigiert werden, dann werden die Stationen mit ihren Nachbarn verglichen, und ein paarweiser Homogenisierungsalgorithmus (PHA) wird verwendet, um vermutete Anomalien zu glätten. Diese sind vermutlich auf Stationsverschiebungen, Änderungen in der Stationsumgebung oder Geräteänderungen zurückzuführen. Schließlich werden fehlende Stationsdaten ergänzt, wobei benachbarte Stationen als Anhaltspunkt dienen. Der letzte Schritt zur Erstellung von nClimDiv ist die Rasterung der Daten.

Zeke stellt fest, dass die Korrekturen der TOB und der PHA nicht wirklich notwendig sind, da der Rasterungsprozess allein wahrscheinlich Gleiches bewirken wird. Da ich nicht alle Details all dieser Glättungsoperationen für statistische Daten verstehe, werde ich keine Stellungnahme zu Zekes Kommentar abgeben. Aber aus einer allgemeinen Mapping-Perspektive hat er einen Punkt. Sie wollen einen Datensatz kartieren, der den Messungen so nahe wie möglich kommt. Wenn man drei Glättungsalgorithmen auf die Messungen anwenden, bevor man sie konturiert und rastert, was haben wir dann? Was bedeutet dieser Algorithmus?

Wir werden hier nicht auf die Einzelheiten der NOAA-Korrekturen eingehen, sie sind statistischer Natur und keine Korrekturen an spezifischen Instrumenten zur Korrektur bekannter Probleme. Es handelt sich also um verschiedene Arten von Glättungsoperationen, die nacheinander auf die Messungen angewendet werden. Die TOB-Korrektur wird von Thomas Karl und Kollegen beschrieben (Karl, Williams, Young, & Wendland, 1986). NOAA mittelt die minimalen und maximalen Tagestemperaturen, um die durchschnittliche Tagestemperatur abzuleiten, daher ist es wichtig, ob die beiden Temperaturmessungen vom Min-Max-Thermometer um Mitternacht oder zu einer anderen Tageszeit aufgezeichnet werden. Wenn Berechnungen mit Monatsdurchschnitten durchgeführt werden, ist dieser Unterschied sehr gering. Einige NOAA-Webseiten legen nahe, dass die TOB-Korrektur für neuere Versionen von GHCN-Monatsblatt entfallen ist, andere sagen, dass sie immer noch verwendet wird. So oder so macht sie wahrscheinlich keinen großen Unterschied in GHCN-Monatlich oder nClimDiv.

Die zweite Korrektur ist der paarweise Homogenisierungsalgorithmus oder PHA. Dieser Algorithmus vergleicht jede Station mit ihren Nachbarn, um festzustellen, ob es ungewöhnliche Anomalien gibt, und versucht dann, diese zu beheben. Dieser Prozess ist ein rein statistischer Glättungsalgorithmus. Er wird von Matthew Menne und Claude Williams beschrieben (Menne & Williams, 2009a). Dieses Verfahren wird definitiv in der neuesten Version von GHCN-Monthly verwendet.

Der letzte Schritt im Glättungsprozess ist das Auffüllen fehlender Werte mit Daten von Nachbarstationen. Dies geschieht vor der Rasterung, so dass mehr Rasterzellen gefüllt werden. Das Auffüllen wird wahrscheinlich noch in der neuesten Version durchgeführt.

Zeke weist darauf hin, dass die grafische Darstellung der tatsächlichen Temperaturen, wie wir es in Abbildung 4 getan haben, irreführend sein kann. Im Laufe der letzten 130 Jahre sind Stationen verschoben, hinzugefügt, entfernt worden, und die räumliche Verteilung der Stationen hat sich verändert. Die mittlere Höhe der Stationen hat sich im Laufe der Zeit verändert. Diese Veränderungen wirken sich auf die Stationsanomalien weniger stark aus als die absoluten Temperaturen. Das ist richtig, und dies erklärt einen Teil der Differenz zwischen Abbildung 4 und den Abbildungen 6 und 7. Ab einem bestimmten Punkt spielt die Anzahl der Stationen keine Rolle mehr, wie in Abbildung 3 zu sehen ist. Wir beginnen unsere Beobachtungen im Jahr 1890 oder 1895, weil wir dann davon ausgehen, dass genügend Stationen in CONUS vorhanden sind, um einen aussagekräftigen Mittelwert zu erhalten. Der USHCN-Datensatz umfasst 143 Stationen im Jahr 1890 und 608 Stationen im Jahr 1895, und dies sind die Stationen mit den längsten Aufzeichnungen und der besten Platzierung.

Schlussfolgerungen und Diskussion

Zekes nächster Punkt ist, dass Goddard seine Daten nicht gerastert hat. Er hat sich also nicht mit der ungleichmäßigen Verteilung der Stationen und der sich im Laufe der Zeit verändernden Verteilung der Stationen befasst. Dies sind echte Probleme, die sich zwar auf interne Trends innerhalb von CONUS auswirken, aber die Rasterung und die anderen Korrekturen glätten die Daten nur. Keine dieser Operationen verbessert die Genauigkeit. Tatsächlich ist es wahrscheinlicher, dass sie die Genauigkeit verringern. Wenn wir Karten von CONUS-Daten zur Ermittlung von Trends innerhalb des Landes verwenden würden, würde ich Zeke zustimmen und die Daten glätten. Aber hier geht es uns nur um den nationalen Temperaturindex, der außerhalb von CONUS liegt. Der Index ist eine Durchschnittstemperatur für das ganze Land, keine statistische Glättung oder Rasterung wird ihn verbessern. Die Verwendung von Anomalien gegenüber den tatsächlichen Temperaturen ist wichtig, ansonsten nicht.

Ein Mittelwert der Anomalien der Stationsdaten ist geeigneter als die Verwendung eines Gitters zur Erstellung eines nationalen durchschnittlichen Temperaturtrends. Der Mittelwert kommt den tatsächlichen Beobachtungen so nahe wie möglich. Die Korrekturen und die Rasterung entfernen uns mit mehreren verwirrenden Schritten von den Messungen.

Wenn die Korrekturen bekannte Probleme in den Instrumenten beheben würden, würde das der Genauigkeit helfen. Aber sie sind statistischer Natur. Sie machen die Stationsmessungen glatter, wenn sie kartiert werden, und sie glätten Diskontinuitäten. Meiner Meinung nach hat die NOAA es übertrieben. TOB, PHA, Ausfüllung und Rasterung sind ein Overkill. Dies ist in Abbildung 7 und beim Vergleich von Abbildung 3 mit Abbildung 6 oder Abbildung 5 leicht zu erkennen. Entspricht der endgültige Trend in Abbildung 3 eher den Messungen (Abbildung 6) oder den Netzkorrekturen in Abbildung 5? Der Jahrhundert-Trend der Daten beträgt 0,25°, die Korrekturen addieren dazu 0,35° und der „klimatologische Rasteralgorithmus“ fügt nochmals 0,9° hinzu! Es lohnt sich, noch einmal zu sagen, dass die Art der statistischen Operationen, die wir diskutieren, nichts zur Verbesserung der Genauigkeit des Nationalen Temperaturindexes beitragen, und sie reduzieren dieselbe wahrscheinlich.

CONUS ist ein gutes Gebiet, um zu überprüfen, ob die „Korrekturen“ an den Stationsdaten und die Wirksamkeit des Temperatur-Gridding-Prozesses gerechtfertigt sind. Die aktuelle Stationsabdeckung ist sehr dicht, wie in Abbildung 1 zu sehen ist, und man würde erwarten, dass die gerasterten Daten recht gut mit den Stationsdaten übereinstimmen. Abbildung 3 sieht wie die orangefarbene „Endkurve“ in Abbildung 7 aus, aber sie ist irgendwie steiler, und das sagt alles, was ma wissen muss.

Dave Middleton und ich sind (in meinem Fall „war“) schon seit langer Zeit im Öl- und Gasgeschäft tätig. Zusammen haben wir mehr kartografierte BS gesehen, als man auf den Lagerplätzen von Kansas City finden konnte. Mein interner BS-Meter zeigt rote Linien, wenn ich eine Wäscheliste mit Glättungsalgorithmen, Korrekturalgorithmen, Bias-Anpassungen usw. höre. Ich möchte schreien: „Halten Sie Ihre &#$@ing Karten und Berechnungen so nah wie möglich an den echten Daten!“

Im ersten Teil dieses Postens habe ich darauf hingewiesen, dass wir zur Untersuchung des Klimawandels mehr über die Erwärmung der Ozeane und die Verteilung und den Transport von Wärmeenergie in den Ozeanen wissen müssen. Landgestützte Wetterstationen helfen bei der Vorhersage des Wetters, aber nicht des Klimas. Wir streiten viel über relativ kleine Unterschiede in den Landoberflächentemperaturen. Diese Argumente sind interessant, aber aus der Sicht des Klimawandels spielen sie keine große Rolle. Die Ozeane kontrollieren das, die Atmosphäre über Land hat wenig damit zu tun. Die Rohdaten von GHCN-Daily zu nehmen und sie durch vier verschiedene Glättungsalgorithmen (TOB, PHA, Infilling und Gridding) laufen zu lassen, ist, bei allem Respekt, lächerlich. Meine Empfehlung? Glauben Sie nichts davon, auch nicht, dass es bzgl. des Klimas eine große Rolle spielt.

Ein besserer Indikator für den Klimawandel oder die globale Erwärmung ist der in Abbildung 2 dargestellte Trend der Erwärmung der Ozeane. Beachten Sie, dass der Trend der letzten 16 Jahre nur 0,4°C pro Jahrhundert beträgt. Vergleicht man dies mit den landgestützten CONUS-Messungen der letzten 130 Jahre, so sagen sie 0,25°C voraus, wie in Abbildung 6 dargestellt, aber der vollständig „korrigierte“ NOAA-Wert beträgt 1,5°C, wie in Abbildung 3 dargestellt. Wem glauben Sie wirklich?

Ich benutzte R für die Berechnungen, die in den Abbildungen dargestellt sind, aber Excel, um die Diagramme zu erstellen. Wenn Sie die Details meiner Berechnungen überprüfen möchten, können Sie meinen GHCN R-Quellcode hier herunterladen.

None of this is in my new book Politics and Climate Change: A History but buy it anyway.

You can download the bibliography here

Übersetzt von Chris Frey EIKE