Die schwierige, nimmer endende Fehlerdiskussion! Oder wie gut sind historische meteorologische Temperaturdaten? Wie wurden sie ermittelt, wie zusammengestellt und wie verarbeitet? (Teil 1)

Teil 2 hier und Teil 3 hier

Mein Beitrag über zwei kleine Anfragen der AfD (hier) zur ungelösten Problematik der absoluten globalen Mitteltemperatur in jüngerer historischer Zeit – die Pariser Klimaübereinkunft bezieht sich sogar auf „Werte vorindustrieller Zeit“ ohne diese auch nur ansatzweise zu beziffern- hat eine große, manchmal hitzige, Diskussion ausgelöst. Mit aktuell 127 Kommentaren und über 3000 Aufrufen (Stand 27.4.20 12:00 Uhr) gehört er sicher zur Klasse der Meistgelesenen. Soweit so gut.

Die z.T. hitzigen Kommentare zeigen m.E.n. aber auch, dass viele Leser mit der zugrunde liegenden, manchmal komplizierten, meteorologischen Messtechnik nicht so vertraut sind, wie sie der Artikel vielleicht voraussetzt. Das hat zur Folge, dass sie nicht auf Anhieb verstehen, warum der Artikel Versäumnisse – gar Falschinformationen- der Bundesregierung – beanstandet.

Sie vertrauen dabei auf ihre eigenen, oft in wissenschaftlicher Arbeit gemachten Erfahrungen aus eigener Anwendung der Messtechnik und ihrer Behandlung von Messdaten. Diese stimmen aber – so meine eigene Erfahrung – wenig bis nicht mit den hier angewendeten Methoden und Verfahren, insbesondere bei der Erstellung und Bewertung von Zeitreihen, überein. Und sind deshalb in ihrer Schlichtheit selten auf diese Messdaten anzuwenden.

Dies voraus geschickt will ich die Leser jetzt ein wenig in die meteorologische Messtechnik von Temperaturdaten und deren Auswertung einführen. Dabei sollen die alten wissenschaftlichen Grundsätze gelten, klassifiziere erst und vergleiche dann, aber vergleiche immer nur Vergleichbares.

Zunächst schauen wir uns an, wie, wo, wann und wie oft die historischen Temperaturdaten gemessen und vorverarbeitet wurden.

Dann werden wir uns die Bildung von Anomalien aus diesen bereits vorverarbeiteten Daten und die sich daraus ergebenden Besonderheiten anschauen und zum Schluss die Bildung von Zeitreihen, und wie diese auf Fehlerkompensation bzw. Nichtkompensation Einfluss nehmen.

Was nicht behandelt wird.

Gänzlich außen vor lassen wir hier den magischen Trick der Klimaforscher, aus bekannten absoluten Unsicherheiten der Messwerte durch Bildung von Anomalien aus vielen Temperaturdaten statistische Wahrscheinlichkeiten werden zu lassen, die sich mit der bekannten Wahrscheinlichkeitsverteilung der Normalverteilung über ein oder zwei Sigma berechnen ließen. Darüber hat Kip Hansen eine sehr eindrückliche Kritik geschrieben. Sie finden Sie hier unter dem Titel„Der „Trick“ anomaler Temperatur-Anomalien“

Weil es das Thema viel zu weit ausdehnen würde, lassen wir auch die merkwürdige Behauptung des Stammvaters aller Klimaängste, James Hansen außen vor, der in einem paper zusammen mit seinem Kollegen Lebedeff 1987[2] behauptet, es wäre möglich auch mit einer sehr geringen Zahl von ca. 80 Gitterzellen gleicher Fläche von 2500 x 2500 km die Temperaturentwicklung der gesamten Erde zu bestimmen. Und dies obwohl in den meisten Zellen nur sehr wenige, in anderen überhaupt keine Messstationen vorhanden waren. Dieser Artikel war die Grundlage und ist es noch heute, für die Behauptung, dass die Anomalienbildung und deren Korrelation über große Flächen hinweg aussagefähig für die Temperaturentwicklung sehr große Flächen seien. Diese Idee, die jeder Korrelations- und Fehlerrechnung widerspricht, wird hier unter dem Titel Von Korrelationen, Trends bei Anomalien! besprochen

Und ebenfalls lassen wir die Erkenntnis von Dresdner Statistikern außen vor, die nachwiesen, dass selbst echt zufällige Fehler, sofern sie sich in Daten finden, die für autokorreliert sind und in entsprechenden Zeitreihen verwendet werden, systematische Komponenten in der Größe von einigen Zehntel Grad entwickelten. Details dazu finden Sie im Artikel mit dem Titel „Konfidenz-Intervalle* für zeitliche Mittelwerte bei langfristigen Korrelationen: eine Fallstudie zu Anomalien der Temperatur auf der Erde“

Am Schluss der Vorbemerkung erlaube ich mir noch den Hinweis auf die Tatsache, dass mit der Bildung von raum- und zeitüberspannenden Durchschnittswerten, die darin enthaltenen Temperaturwerte ihre physikalische Bedeutung als Temperatur verlieren. Es entsteht stattdessen irgendeine Art von Index. Er ist für statistische Zwecke begrenzt brauchbar, wenn man die Randbedingungen beachtet, aber keine physikalische energetisch relevante Größe mehr. Wer dazu genaueres wissen möchte, der sei auf den schöne Beitrag von C. Essex und R. McKittrick von 2006 verwiesen mit dem schönen Titel „Does A Global Mean Temperature exist“[3]

Wie, wo und wann wurden die historischen meteorologischen Messdaten gewonnen?

- Thermometer

Am Anfang stand und steht das Thermometer. Dabei ist es zunächst egal, ob es ein mechanisches oder ein elektronisches ist, obwohl jede Art einen erheblichen Einfluss auf die (systematischen) Fehler hat, natürlich auch auf die erzielbare Genauigkeit.

- Messumgebung

Doch mindestens ebenso wichtig ist die Messumgebung. Diese wird bestimmt durch das Gehäuse (Messhütte), welches das Thermometer vor verfälschenden Umgebungseinflüssen, wie Strahlung, Wind oder Niederschlag aber auch Beschädigung schützen soll, aber auch in starkem Maße von der unmittelbaren Umgebung. Um vergleichbare Ergebnisse wenigstens annähernd zu erreichen, muss dies bestimmten überall vergleichbaren Standards genügen und sorgfältig gebaut und gepflegt werden.

- Messregime

Und auch das Messregime ist von entscheidender Bedeutung, nämlich wann und wie oft, von wem und wie das Thermometer abgelesen wird.

- Die geografische und zeitliche Abdeckung

Und da das Wetter- wie das Klimageschehen nicht an nationalen Grenzen haltmacht, muss die geografische Abdeckung mit Messstationen gesichert sein, und das sowohl nach Zahl als auch nach Ort und Zeit. Alle drei Anforderungen werden erst seit dem Aufkommen der Satelliten hinreichend erfüllt. Dabei tauscht man die Vorzüge der Satellitenmessung gegen einen enormen Nachteil ein, denn man musste einen unangenehmen Kompromiss akzeptieren. Es ist die sehr schlechte vertikalen Auflösung. Eine Satellitenmessung ist daher immer der Mittelwert von Temperaturänderung über eine Distanz von ca. 5000 m. (z.B. der lower troposphere)

- Was geschieht mit den meteorologischen Messdaten? Die Weiterverarbeitung!

Bis zur „Erfindung“ der Idee von der Notwendigkeit einer weltweiten Mitteltemperatur, gab es nur wenige Meteorologen, die die vorhandenen Messdaten nutzen wollten, um evtl. aus ihnen eine weltweite Mitteltemperatur zu extrahieren. Man begnügte sich damit – nachdem solche großartigen Wissenschaftler der Meteorologie wie Köppen die Definition von Klimazonen etabliert hatten- für diese Klimazonen oder Regionen Mitteltemperaturen und deren Jahresgänge zu berechnen. Normalerweise dienten die meteorologischen Messdaten aber vor allem der örtlichen Wettervorhersage und bez. ihrer Langzeit-Analyse auch dazu ggf. lokale Klimaänderungen im Nachhinein zu erkennen.

Anmerkung: Achten Sie mal auf die örtlichen Wetterberichte, dort wird man ihnen so gut wie nie die erwartetet Durchschnittstemperatur der nächsten Tage nennen, sondern ausschließlich deren Maxima und Minimawerte.

Dazu erstellte man Zeitreihen (hier Temperatur-Ganglinien) entweder aus absoluten Werten oder von Anomalien je nach Bedarf, deren erzielbare Genauigkeit für die gewünschten Zwecke völlig ausreichte.

Zu 1. Thermometer

Abbildung 1 zeigt eine klassische, deutsche Wetterhütte (erweiterter Stevenson Screen) und (rechts) ein darin befindliches modernes Thermometerensemble gezeigt, wie es immer noch in vielfältiger Vewendung ist. Die senkrechten Thermometer sind (links) das Assmansche Aspirationthermometer zur Temperaturmessung, rechts daneben ein befeuchtetes und belüftetes Psychrometer zur Messung der Luftfeuchte. Quer darunter befinden sich zwei liegende Thermometer zur Messung von Max. und Min. Temperaturen. Die runde Plastiktrommel enthält den Federmotor mit Ventilator zur Erzeugung des Luftstromes mit Ø 2,5 m/s vor und während der Messung. Im März 2009 vom Autor im Metereologischen Institut der Freien Universität Berlin aufgenommen

Obwohl schon Galileo erste Versuche unternahm mit einem Thermometer meteorologische Messungen zu machen, und sich danach ein ziemlicher Wildwuchs an solchen Thermometer ausbreitete, weil viele Landesfürsten die aufkommende Meteorologie aus naheliegenden Gründen für äußerst wichtig hielten, kann man erst ab 1892 von einem Standardinstrument für meteorologische Zwecke sprechen. Es handelt sich dabei um das zwangsbelüftete Assmansche (Quecksilber gefüllte) Aspirationsthermometer (linkes, senkrechtes Thermometer). Die zuvor verwendeten tlw. mit Alkohol gefüllten Thermometer mit mehr als ± 1 Kelvin Gesamt-Unsicherheit wurden nach und nach weltweit ersetzt. In den angelsächsisch orientierten tlw. auch regierten Ländern setzte sich hingegen oft zusätzlich das Max-Min-Thermometer durch.

Doch allein die Wahl des Thermometers, sein jeweiliger Zustand, seine Montage, sein Betrieb und seine Ablesung sorgen für eine ganze Reihe von zufälligen wie systematischen Fehlern. Diese wurden vielfach sorgfältig untersucht, aber nur in geringer Anzahl auch quantitativ bestimmt und damit überhaupt erst theoretisch korrigierbar.

Zu 2. Messumgebung

Für die Messumgebung war von Anfang an klar, dass dieses zuallerst eine Art Schutzhütte sein sollte, von denen besonders im 19 Jahrhundert eine ganze Reihe von Konstruktionen erprobt wurden, wobei sich letztendlich die erweiterte englische Hütte als Standard durchsetzte. Doch bis dahin waren die (wenigen) Messergebnisse praktisch unvergleichbar, weil die Hütte auf ihre eigene Art die Messergebnisse beeinflusste.

Abbildung 2 Darstellung der zum Ende des 19. Jahrhunderts und bis heute verwendeten Hüttentypen bzw. Screens von links: französische Hütte, daneben (kaum erkennbar) Mitarbeiter zum Größenvergleich, daneben (Original) Stevenson Hütte, dann Wildsche Hütte, dann mehrere erweiterte Stevenson Hütten und moderne runde kleine Screens. (Quellen. Linkes Bild [Sprung, 1890] rechtes Bild: KNMI Messfeld von van der Meulen für die Zeit von 1989-1995)

Praktisch unkorrigiert, obwohl seit langem bekannt, ist der systematische Fehler, der allein durch die Wärmeträgheit der Hütte entsteht, und der ca + 1 bis 2 Kelvin zu jedem Ergebnis der eigentlich gesuchten Außentemperatur hinzuaddiert. Praktischerweise definieren jedoch die Meteorologen die Temperatur in der Hütte[4], als die gesuchte Außentemperatur. Woraus geschlossen werden muss, dass jede durch diese Messungen gewonnene absolute Temperatur im Mittel im 1 bis 1,5 Kelvin gegenüber der wahren Außentemperatur zu hoch sein muss.

Abbildung 3(links): Englische Hütte und moderne Messstation am Messort Detroit Lakes USA, kurz vorher aufgenommen und ins Netz gestellt am 25.07.07 von A. Watts; (rechts) Temperaturverlauf aus der GISS Datenbank zur Messstelle Detroit Lakes USA

Beispiel für den Zustand und Umgebung einer meteorologische US Messstation sowie deren Zeitreihe ihrer Jahresmittelwerte, die vom Projektteam untersucht wurde. Man beachte den Sprung ab etwa dem Jahr 2000 und die Entlüftungen der Klimaanlagen in unmittelbarer Nähe.

Nicht weniger Einfluss hat die unmittelbare Umgebung in der die Messhütte.

Zur Klärung dieses Sachverhaltes hat sich der Meteorologe und Betreiber des inzwischen weltweit erfolgreichsten Klimarealisten- Blogs Wattsupwiththat Antony Watts große Meriten erworben. Er rief 2007 das SurfaceStationorg. Netzwerk ins Leben, das 2009 erfolgreich mit einer Veröffentlichung [5]abgeschlossen wurde. Freiwillige im ganzen Land untersuchten über 850 der 1200 meteorologischen Messstationen, die von der US-Wetter- und Ozeanbehörde NOAA betrieben wurden.

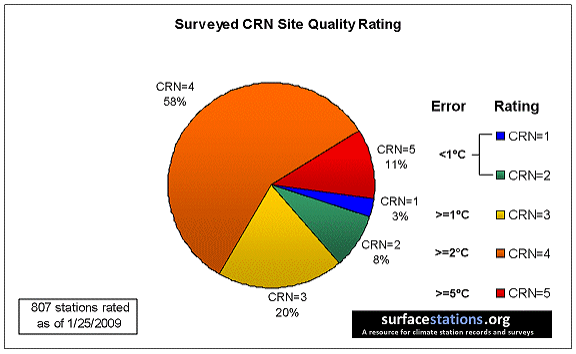

Abbildung 4 Untersuchung von bisher (Ende Februar 2009) 854 von 1221 offiziell verwendeten Messstationen der unterschiedlichsten Art. Man beachte, dass nur 3 % aller Stationen dem Standard voll entsprechen, weitere 8 % können evtl. noch als dem Standard genügend zugeordnet werden. Die restlichen 89 % zeigen jedoch potentielle Abweichungen nach den Vorgaben der CRN von mindestens 1 °C (20 %) über 2 °C ( 58% ) bis 5 °C (11%).

Auswertung der Überprüfung von 807 US Messstationen in Bezug auf die offizielle Einstufung ihrer Qualität und Umgebung (CRN).

Das Ergebnis war erschreckend. Der Zustand der Messstationen und damit die Messergebnisse waren miserabel. 89 % von ihnen lagen oberhalb der Fehlerklasse 2, was bedeutet, dass sie > 2 ° C bis > 5 °C fehlerhafte Ergebnisse zeigten. Nur 3 % lagen gleich oder unterhalb von 1 °C. Und noch schlimmer war, dass diese Stationen für die gesamte Welt sozusagen als Goldstandard in Punkto Qualität galten. D.h. die vom IPCC und ihren Zuarbeitern immer wieder herangezogenen Daten aus den anderen Kontinenten waren mit hoher Wahrscheinlichkeit noch schlechter.

Es würde hier zu weit gehen, die vielfältigen Fehlerquellen allein der landbasierten Messstationen aufzulisten, daher beschränke ich mich auf zwei kurze Ergänzungen.

- Selbst bei identischer Konstruktion von Hütte und Messinstrument, ergeben sich große Unterschiede allein durch das Material und seinen Anstrich, bzw. dessen Veränderung über der Zeit, z.B. durch Alterung

- Sind die landbasierten Messungen schon oft mit mehr (systematischen) Fehlern behaftet als ein Hund Flöhe hat, so ist das bei den seegestützten Messungen noch weit schlimmer. Und weil das Land nur 29 % der Erdoberfläche bedeckt, aber 71 % der Erde Ozeane sind, ist dieser Umstand eigentlich noch schlimmer. Denn dort sind die Messungen wirklich nur punktuell, d.h. äußerst selten sowohl in räumlicher als auch in zeitlicher Hinsicht. Ein wenig wird dieser Mangel gelindert durch die Tatsache, dass statt der eigentlich gesuchten Lufttemperatur, stattdessen, als Proxy, die Temperatur der Seewasser Oberfläche (SST Sea Water Surface Temperature) verwendet wird. Wegen der großen Wärmeträgheit und guten -Leitfähigkeit des Wassers deckt ein Messpunkt im Vergleich zum Land viel größere Gebiete ab.

Wer Interesse daran hat, diese Fehler etwas genauer behandelt zu sehen, der sei auf das Video „Wie glaubwürdig sind die Zeitreihen historischer Klimadaten“ (hier) verwiesen, dass einige der wichtigsten Aspekte zu diesen Fehlern aufzeigt.

Ende Teil 1

[1] https://www.wsj.com/articles/SB10001424052970204422404576594872796327348#printMode

[2] HANSEN, JAMES LEBEDEFF, SERGEJ (1987) Global Trends of Measured Surface Air Temperature. JOURNAL OF GEOPHYSICAL RESEARCH 92:13345 13372.

[3] Essex, C, Mc Kittrick, R. Andresen, B. (2006) Does A Global Temperature Exist? Non-Equilibrium Thermodynamics

[4] Weischet [Weischet, 1995] S115 – S 109 ff

[5] Is the U.S. Surface Temperature Record Reliable? By Antony Watts SurfaceStations.org ISBN 13: 978-1-934791-29-5

Für alle, die diese Information am Stück lesen wollen hier das Ganze als pdf Die schwierige nimmer endende Fehlerdiskussion