[Hinweis: Der folgende lange Beitrag ist an einigen Stellen gekürzt. Anm. d. Übers.]

Die Studie wirft ein grelles Licht auf die politischen Probleme beim IPCC. Um die Debatte um ACRIM vs. PMOD in den richtigen Zusammenhang zu bringen und zu zeigen, warum diese undurchsichtige und komplizierte wissenschaftliche Debatte wichtig ist, müssen wir auch das Politik-Durcheinander innerhalb des IPCC und des UNFCCC beleuchten.

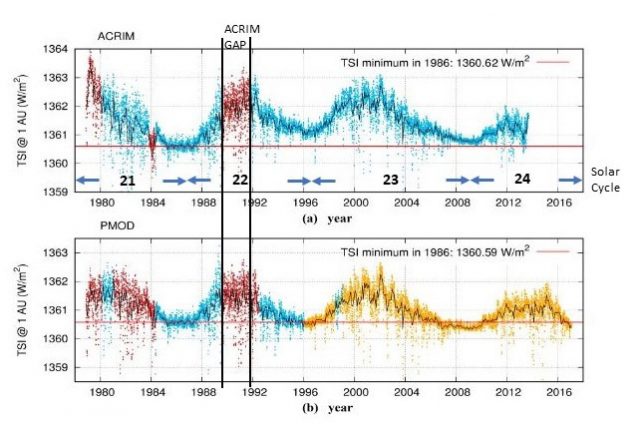

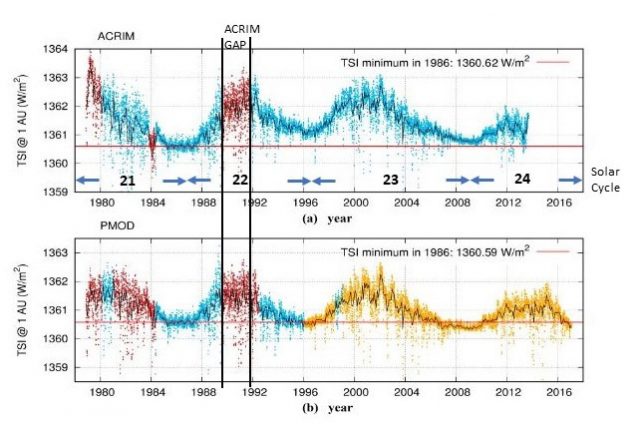

Das Komposit der TSI-Aufzeichnung von ACRIM zeigt eine Zunahme der Sonnenaktivität von den 1980er Jahren bis etwa zum Jahr 2000. Danach flacht sie ab und beginnt bald abzunehmen. Das ACRIM-Komposit wurden von Richard Willson in einem Artikel für das Magazin Science bereits im Jahre 1997 vorgestellt (Willson1997). Dieses Komposit wurde im Jahre 2014 von Scafetta und Willson aktualisiert (Scafetta and Willson 2014).

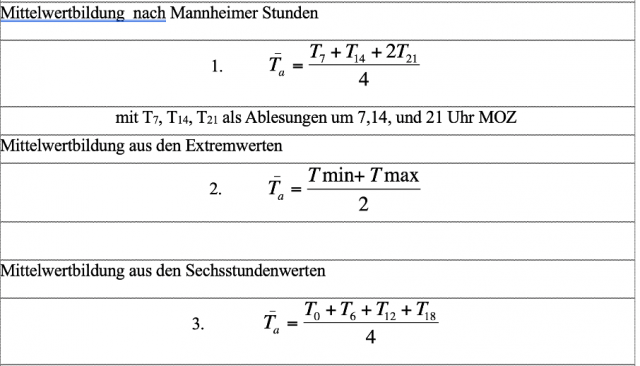

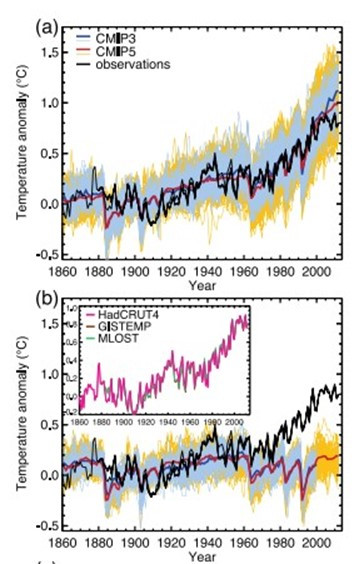

Im darauf folgenden Jahr 1998 wurde von Claus Fröhlich und Judith Lean (Fröhlich und Lean 1998) ein rivalisierendes Komposit eingeführt. Darin gehen die gleichen Daten ein, doch bekommen sie eine abnehmende Sonnenaktivität von 1986 bis 1997 heraus. Claus Fröhlich arbeitete am Physikalisch-Meteorologisches Observatorium Davos (PMOD). Die beiden Komposits werden in Abbildung 1 verglichen:

Abbildung 1: Vergleich der TSI-Komposits nach ACRIM und PMOD. Der Graph der ACRIM-TSI (oben) zeigt eine Zunahme von 1986 bis 1997, was mit dem leicht abnehmenden Trend des Graphen des PMOD-Komposits kontrastiert. Der größte Teil dieser Differenz zwischen beiden ist die Art und Weise, wie die „ACRIM-Lücke“ von Mitte 1989 bis August 1991 dargestellt wird. Quelle: Modifiziert aus Scafetta, Willson and Lee et al. 2019, darin deren Abbildung 3

Es gab drei ACRIM-Satelliten, deren Messungen genau und allgemein unbestritten sind – außer von der PDMO-Gruppe. Bei dem Disput zwischen ACRIM und PDMO geht es darum, wie die „ACRIM-Lücke“ von Mai 1989 bis August 1991 zu interpretieren ist. Die Lücke hatte sich aufgetan, nachdem die Challenger-Katastrophe den Start des ACRIM2-Instrumentes verzögert hatte. Ein weiterer signifikanter Unterschied ist, dass das PMOD-Team es vorzog, die Virgo-Ergebnisse an Stelle von ACRIM3 zu nutzen.

…

[Hier wird der Streit mit gegenseitigen Zitaten weiter erläutert]

Es scheint, dass Judith Lean politisch motiviert war, das ACRIM-Komposit in Frage zu stellen. Aber es steckt mehr dahinter, und um das zu erläutern, müssen wir kurz auf die einzelnen IPCC-Klimawandel-Berichte eingehen. Wir man sehen wird, konnte das IPCC nur auf eine einzige Art und Weise berechnen, ein wie großer Anteil des Klimawandels dem Menschen geschuldet und welcher Teil natürlichen Ursprungs ist, nämlich indem das IPCC die natürliche Komponente modellierte und von den Beobachtungen subtrahierte, um die menschliche Komponente abzuleiten. Die natürliche Komponente ist sehr komplex und wirkt über verschiedene Zeitmaßstäbe. Sie wird hauptsächlich bestimmt durch die solare Variabilität und ozeanische Oszillationen. Beide sind noch kaum verstanden, und das IPCC sowie die CMIP-Modelle können beides nicht genau modellieren. Das IPCC führt viele Forschungen in allen möglichen Bereichen durch, aber wir wollen uns hier nur auf den wichtigsten Bereich konzentrieren, nämlich: Wie groß ist der Einfluss des Menschen auf das Klima?

Der erste IPCC-Bericht

Das IPCC ist eine unabhängige Körperschaft, ins Leben gerufen unter der Aufsicht der WMO und des UNEP. Sein selbst gestecktes Ziel ist:

Das IPCC ist die internationale Körperschaft, um die Wissenschaft bzgl. des Klimawandels zu untersuchen. Es wurde im Jahre 1988 durch die WMO und das UNEP gegründet, um politische Entscheidungsträger mit regelmäßigen Abschätzungen auf der wissenschaftlichen Grundlage des Klimawandels zu versorgen, dessen Auswirkungen und zukünftige Risiken, sowie Optionen zur Anpassung und Abschwächung (IPCC 2020)

Das UNFCCC (United Nations Framework Convention on Climate Change), welches nicht direkt mit dem IPCC verbunden ist, sagt Folgendes zur Mission des IPCC:

Das IPCC untersucht die wissenschaftlichen, technischen und sozio-ökonomischen Informationen, die relevant sind für das Verständnis der Risiken des vom Menschen verursachten Klimawandels (UNFCCC 2020).

Dem IPCC selbst zufolge untersucht dieses die Risiken des Klimawandels ohne jede Erwähnung von dessen Ursache. Es berät sowohl hinsichtlich Abschwächung (vorzugsweise durch Einschränkung fossiler Treibstoffe) als auch hinsichtlich Anpassung wie etwa mit Deichen, Air Conditioning, Heizung usw. Dem UNFCCC dagegen zufolge soll es (das IPCC) den vom Menschen verursachten Klimawandel untersuchen, was ein großer Unterschied zur Verlautbarung des IPCC ist. In ähnlicher Weise unterscheiden sich beide Agenturen auch bei der Definition des Begriffs „Klimawandel“. Das politisch ausgerichtete UNFCCC definiert diesen als

eine Änderung des Klimas, welche direkt oder indirekt menschlichen Aktivitäten zugeordnet werden kann (UN 1992)

Das kontrastiert mit der IPCC-Definition von „Klimawandel“, die weniger politisch und mehr wissenschaftlich ist:

Eine Änderung des Klimazustands, der … längere Zeit andauert, normalerweise Dekaden oder noch länger. Klimawandel kann natürlichen internen Prozessen oder externen Antrieben geschuldet sein, oder auch persistenten anthropogenen Änderungen der Zusammensetzung der Atmosphäre oder des Landverbrauchs (IPCC 2012)

Man kann leicht erkennen, dass UNFCCC und IPCC einen potentiellen Konflikt haben. Tatsächlich ist es ja so, dass wenn das IPCC zu dem Ergebnis kommt, dass der Mensch überhaupt keinen signifikanten Einfluss auf das Klima hat, das UNFCCC keine Berechtigung seiner Existenz hat. Im Ersten IPCC-Bericht 1990 (FAR) war man sich unsicher, ob globale Erwärmung natürliche oder anthropogene Ursachen habe. Die Schlussfolgerung lautete:

Die globale mittlere Temperatur ist während der letzten 100 Jahre um 0,3°C bis 0,6°C gestiegen … die Größenordnung dieser Erwärmung stimmt im Großen und Ganzen mit den Prognosen von Klimamodellen überein, ist aber gleichzeitig von gleicher Größenordnung wie die natürliche Klimavariabilität. … Die eindeutige Auffindung eines verstärkten Treibhauseffektes durch Beobachtungen ist für über ein Jahrzehnt oder noch länger unwahrscheinlich (IPCC 1992, S. 6)

Angesichts der großen Bandbreite von Meinungen innerhalb der wissenschaftlichen Gemeinschaft und des Fehlens jedweder solider Belege für den menschlichen Einfluss auf das Klima ist diese Schlussfolgerung logisch. Aber diese brachte politische Probleme für das UNFCCC mit sich. Der einzige Grund für dessen Existenz war der vom Menschen verursachte Klimawandel. Falls das IPCC die anthropogene Ursache nicht finden kann, steckte man in Schwierigkeiten. Auf die Wissenschaftler wurde enormer Druck ausgeübt, in Folgeberichten den Klimawandel menschlichen Aktivitäten zuzuordnen.

[Hervorhebung vom Übersetzer]

Der politische Standpunkt zu jener Zeit wird eindeutig mit dem folgenden Ausspruch von Senator Tim Wirth auf dem Erd-Klimagipfel in Rio im Jahre 1992 belegt:

„Wir müssen auf dem Thema globale Erwärmung weiter herumreiten. Selbst wenn die Theorie der globalen Erwärmung falsch ist, tun wir das Richtige hinsichtlich Wirtschafts- und Umweltpolitik“ (National Review Editors 2010)

Der zweite IPCC-Bericht SAR

Alle nachfolgenden Berichte haben dann Klimawandel und globale Erwärmung dem Menschen zugeordnet. Der Zweite Zustandsbericht (SAR) überschritt diese Grenze mit der folgenden Schlussfolgerung:

„Die Übersicht über alle Belege zeigt einen wahrnehmbaren menschlichen Einfluss auf das globale Klima!“ (IPCC 1996, S. 4)

Ronan und Michael Conolly (Conolly & Conolly 2019) erklären, dass diese Feststellung Eingang in den SAR gefunden hatte, weil Ben Santer, Leitautor des SAR-Kapitels zu den Ursachen des Klimawandels, einige unveröffentlichte und nicht begutachtete Arbeiten von ihm selbst vorgestellt hatte, in denen er behauptet, einen „Fingerabdruck“ des menschlichen Einflusses auf die globale Erwärmung gefunden zu haben. Seine Beweise umfassten Messungen, die von 1963 bis 1988 troposphärische Erwärmung und stratosphärische Abkühlung zeigten. Dies passte zu einer Prognose der für den SAR herangezogenen Klimamodelle. Vermeintlich würde zusätzliches Kohlendioxid in der Atmosphäre die Erwärmung in der Troposphäre und die Abkühlung in der Stratosphäre zunehmen lassen. Er stellte keine Verbindung her zwischen diesen Messungen und menschlichen Emissionen von Kohlendioxid oder derartigen Emissionen allgemein her, sondern er sagte einfach, dass sich so etwas Ähnliches zeigt wie von den Modellen prognostiziert.

Es waren schwache Beweise, und obwohl das Ganze nicht begutachtet und nicht einmal zur Veröffentlichung eingereicht worden war, wurde es angenommen. Weiter unten räumt die Studie ein, dass man die relative Größenordnung des natürlichen und des menschlichen Einflusses auf das Klima nicht quantifiziert hatte. Man hat einfach eine statistisch signifikante Ähnlichkeit zwischen einigen Beobachtungen und den Modellprognosen gezeigt.

Der politische Druck seitens des UNFCCC bzgl. der Verantwortung des Menschen war unerbittlich, und man musste etwas tun. Es gab einige hartnäckige Gerüchte, dass jemand heimlich den Text im SAR verändert hatte, nachdem die Autoren den Text bereits abgenickt hatten, und zwar auf eine Art und Weise, dass obige Schlussfolgerung gestützt und abweichende Ergebnisse gelöscht wurden. Das kann so sein, muss es aber nicht.

Unglücklicherweise löste die Studie von Santer (Santer et al. 1996), nachdem sie schließlich veröffentlicht worden war, einen Sturm an Kritik aus. Im Einzelnen wiesen Patrick Michaels und Paul Knappenberger (Michaels and Knappenberger 1996) darauf hin, dass der troposphärische „Hot Spot“, den Santer als den „Fingerabdruck“ des menschlichen Einfluss genannt hatte, sofort verschwand, wenn man den Zeitraum verfügbarer Daten von 1963 bis 1987 auf den Gesamtzeitraum dieser Daten ausdehnte, 1958 bis 1995. Mit anderen Worten, es sah so aus, als ob Santer für seinen „Fingerabdruck“ cherry-picking betrieben habe.

Neben der Rosinenpickerei mit den Daten gab es aber noch weitere Probleme bei Santers Interpretation. Die Erwärmungs- und Abkühlungstrends, die sie gefunden zu haben glaubten, könnten auch natürlichen Ursprungs sein, wie Dr. Gerd-Rainer Weber erklärte. Der Anfang von Santers willkürlich gewähltem Zeitraum war gekennzeichnet durch Vulkanismus und das Ende desselben durch starke El Ninos.

Der dritte Zustandsbericht TAR

Das IPCC war zutiefst brüskiert worden nach der Enthüllung, dass Santer et al. die Daten im SAR manipuliert hatte, aber man brauchte immer noch einen wie auch immer gearteten Weg, um die Menschen für den Klimawandel verantwortlich zu machen. Man fand eine andere Studie, welche perfekt für diesen Zweck geeignet schien, und hob diese im TAR lang und breit auf den Schild.

…

[Gemeint war natürlich der „Hockeyschläger“. Über diesen sowie dessen völlige Entlarvung als Betrug ist anderswo schon sehr viel geschrieben worden. Daher wird die erneute Beschreibung davon in dieser Übersetzung übersprungen. – Anm. d. Übers.]

Der vierte Zustandsbericht AR 4

Zu der Zeit,als der vierte Bericht verfasst wurde, war der Hockeyschläger umfangreich diskreditiert, und im Lichte dieses Vorgangs hat der Leitautor des relevanten Kapitels (Kapitel 6) Keith Briffa eingeräumt, dass die jüngste Erwärmung nicht ungewöhnlich sei. Er schrieb:

„Einige der seit Erscheinen des TAR durchgeführte Studien zeigen eine größere vielhundertjährige Temperatur-Variabilität während der letzten 1000 Jahre als im TAR beschrieben (IPCC 2001, Kapitel 6, Seite 1)

Es ist ein schwaches Einräumen des Scheiterns, wie man erwarten konnte, aber er gibt zu, dass der Stiel des Hockeyschlägers zu flach verlief und dass die Temperaturen während der Mittelalterlichen Warmzeit höher gelegen haben könnten als heute. Dieses Eingeständnis nahm den Wind aus den Segeln des TAR und es stellte sich die Frage, was kann man jetzt machen? Es schien keinerlei Daten zu geben, welche den Gedanken stützen, dass die Menschen globale Erwärmung verursachen.

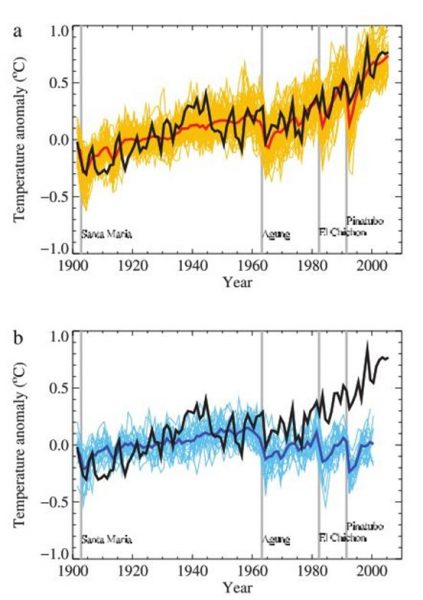

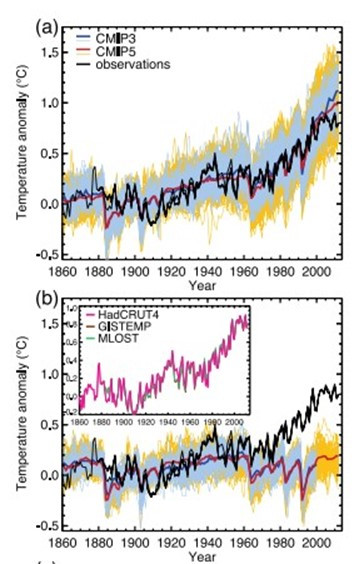

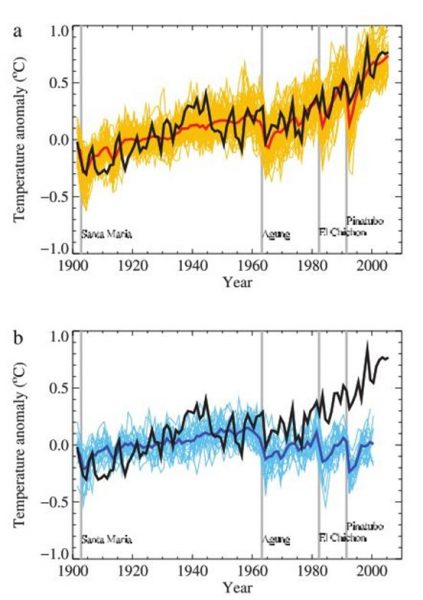

Das IPCC entschloss sich, im AR4 viel mehr die Klimamodelle in den Vordergrund zu schieben als Paläo-Temperatur-Rekonstruktionen, atmosphärische „Fingerabdrücke“ oder irgendwelche andere Beobachtungsdaten. Seit nunmehr zwanzig Jahren hatte man nach Belegen gesucht dafür, dass die Menschen der Hauptgrund für die jüngste Erwärmung seien, und man hat keine gefunden. Aber jetzt „entdeckte“ man, dass falls man die Klimamodelle ganz ohne irgendwelche menschlichen Klima-Antriebe laufen ließ, die berechneten globalen Temperaturen flach verliefen. Dies erkennt man in Abbildung 3 b:

Abbildung 3: Die IPCC-Modellberechnung des menschlichen Einflusses auf das Klima. Zwei Modell-Mittel werden in beiden Graphiken gezeigt. Die blaue Kurve stammt aus dem AR4, CMIP3, die rote Kurve aus dem AR5, CMIP5. Beide werden mit Beobachtungen verglichen (schwarz). Die obere Graphik zeigt Modelle unter Einbeziehung sowohl menschlicher als auch natürlicher Antriebe, die untere Graphik ausschließlich natürliche Antriebe. (Quelle: IPCC 2013, Kap. 10, S. 879).

Man ließ die Modelle also laufen, und bei der Modellrechnung mit menschlichen und natürlichen Einflüssen (Abb. 3a) zeigte sich, dass die Temperaturen steigen. Na bitte! Wir haben die menschlich verursachte globale Erwärmung belegt und brauchen keine Beobachtungsdaten mehr! Damit schrieben sie triumphierend:

„Der größte Teil des beobachteten Anstiegs der globalen mittleren Temperatur seit Mitte des 20. Jahrhunderts geht sehr wahrscheinlich auf die beobachtete Zunahme von anthropogenen Treibhausgasen in der Atmosphäre zurück“ (IPCC 2007, S. 10)

Wir haben den Vergleich zwischen Modellergebnissen und Beobachtungen aus AR 5 bereits in Abbildung 3 gezeigt. In Abbildung 4 zeigen wir die dem AR 4 entsprechende Abbildung:

Abbildung 4: Vergleich des Modells einer natürlichen Erwärmung allein (b) und einer Erwärmung aus natürlichen plus menschlichen Ursachen (a) sowie Beobachtungen in schwarz. Quelle: IPCC 2007, S. 684)

In diesen Klima-Simulationen sind die einzigen natürlichen Antriebe, welche irgendeinen Unterschied machen, Vulkanausbrüche. Solare und ozeanische Variationen werden über den gesamten untersuchten Zeitraum auf Null gesetzt. Die Vulkanausbrüche sind in Abbildung 4 gekennzeichnet. Das Fehlen eines robusten Modells des natürlichen Klimawandels kann man daran erkennen, dass die Beobachtungen von 1910 bis 1944 nur schlecht zu den Simulationen passen, sowohl in Abbildung 3 als auch in Abbildung 4. Angesichts der reichlichen Literatur, in welcher ein signifikanter solarer Einfluss (Soon, Connolly and Connolly 2015) sowie ein solcher von natürlichen ozeanischen Oszillationen belegt wird (Wyatt and Curry 2014), kann man leicht jedwede Berechnung eines menschlichen Antriebs in Zweifel ziehen, welcher aus den Abbildungen 3 und 4 abgeleitet wird. Folglich ist die Schlussfolgerung im AR 4 und die ähnliche Schlussfolgerung im AR 5 mit ähnlicher Logik fragwürdig.

Der fünfte Zustandsbericht AR 5

Der AR5 ist im Wesentlichen eine Überarbeitung des AR 4 – man macht das Gleiche und führt die gleichen Verfahren durch. Es werden keinerlei neue Daten präsentiert, welche eine menschliche Mitwirkung am Klimawandel stützen; die gleichen Modelle werden bis auf ein paar minimale Änderungen hier und da laufen gelassen, und man kommt im Wesentlichen zu der gleichen Schlussfolgerung aus den gleichen Gründen wir im AR 4:

Über die Hälfte des beobachteten Anstiegs der globalen mittleren Temperatur (GMST) von 1951 bis 2010 ist sehr wahrscheinlich der beobachteten Zunahme anthropogener Treibhausgase (GHG) geschuldet (IPCC 2013, S. 869)

TSI und das IPCC

Soon, Connolly & Connolly 2015 identifizierten viele valide und begutachtete Rekonstruktionen der Sonnenaktivität (hier), welche einen Großteil der Erwärmung seit 1951 und davor erklären können. Diese Rekonstruktionen wurden samt und sonders vom IPCC ignoriert.

Zur gleichen Zeit, als der AR 4 geschrieben wurde, war die anerkannte Sonnenaktivität (TSI) als Komposit von Satellitenmessungen der Solarstrahlung, also ACRIM in Abbildung 1 (Willson 1997). Es zeigte einen zunehmenden Trend der Sonnenaktivität von den 1980er bis zu den 1990er Jahren. Dies stützt den Gedanken, dass zumindest ein Teil der Erwärmung auf die zunehmende Sonnenaktivität zurückzuführen ist. Scafetta und Willson schrieben 2014:

Unsere Analyse bietet eine Validierung erster Ordnung des ACRIM TSI-Komposits nebst dessen Aufwärtstrend um 0,037% pro Dekade während der solaren Zyklen 21 und 22 (1986 bis 1997). Die Implikationen einer zunehmenden TSI während der globalen Erwärmung der letzten beiden Jahrzehnte des 20. Jahrhunderts sind, dass ein solarer Antrieb ein signifikant größeren Faktor ist als in den CMIP5-Klimamodellen repräsentiert (Scafetta und Willson 2014).

Wir wir oben gesehen haben, leitete Judith Lean die Entwicklung des rivalisierenden PMOD TSI-Komposits und räumte ein, dass die Gründe zumindest teilweise politischer Natur waren. Fröhlich und Lean folgern, dass es unwahrscheinlich sei, dass TSI irgendeine globale Erwärmung verursacht hat. Dann sagen sie, dass sie nicht genügend Daten haben, um sich da sicher zu sein. Während das ACRIM-Komposit zu jener Zeit mehr anerkannt war, fand aber auch das PMOD-Komposit viel Unterstützung.

…

[Im Folgenden wird dieser Gegensatz noch ausführlich und mit vielen technischen Details ausgeführt. Auf die Übersetzung dieses Teils wird hier verzichtet. Damit kommen wir zu den…]

Conclusions

Es scheint, als ob sich das IPCC in eine Sackgasse manövriert hat. Man war nicht in der Lage, aus Beobachtungen irgendwelche Belege abzuleiten, dass der Mensch zum Klimawandel beiträgt, und noch weniger einen menschlichen Einfluss auf das Klima. Man reduzierte alles auf die Erzeugung von Klimamodellen und auf die Messungen zwischen diesen Modellen, welche menschliche Antriebe umfassen und denjenigen, bei denen das nicht der Fall ist. Dieses Verfahren fand Eingang sowohl in den AR 4 als auch in den AR 5 – es war in beiden Berichten ähnlich, genau wie auch die Ergebnisse. AR 5 war nichts weiter als eine Wiederholung des AR 4 ohne jede bedeutenden Verbesserungen oder zusätzliche Belegen.

Es sieht so aus, als ob es hinsichtlich der Ergebnisse in beiden Berichten ein signifikantes Problem war, Rekonstruktionen mit geringer solarer Variabilität eingehen zu lassen und die genauso gestützten Rekonstruktionen hoher solarer Variabilität zu ignorieren. Dies reduziert die berechnete natürliche Komponente des Klimawandels und vergrößert die berechnete menschliche Komponente. Teil des Problems mit den Rekonstruktionen geringer solarer Variabilität ist, dass sie „frisiert“ worden waren, um zum PMOD TSI-Komposit zu passen, welches ebenfalls ein Proxy-Modell zur Grundlage hat. Folglich hat man ein Modell herangezogen, um Satellitenmessungen zu verändern und diese dann zur Kalibrierung eines Proxy-Modells benutzt. Das Proxy-Modell wird dann zurück datiert bis zum Jahr 1700. Nicht sehr überzeugend.

Scafetta et al. haben in ihrer Studie das PMOD-Verfahren umgekehrt. Sie verwendeten die unstrittigen TSI-Beobachtungen vor und nach der ACRIM-Lücke, um empirisch die niederfrequente Komponente des TSI-Proxymodells zu adjustieren, um die Lücke zu schließen. Ihr Verfahren lässt ausdrücklich zu, dass den Modellen eine gering variierende Komponente in den Regionen mit ruhiger Sonne fehlt, was eine Variation von solarem Minimum zu solarem Minimum ermöglicht. Sie nahmen das Problem der ACRIM-Lücke in Angriff, ohne die TSI-Aufzeichnungen minderer Qualität von Nimbus7/ERBS oder ERBS/ERBE zu verwenden. Sie haben einfach evaluiert, wie die Proxy-Modelle die ACRIM-Lücke schließen. Die Proxy-Modelle unterschätzten die TSI-Zunahme bis zum Höhepunkt des Sonnenzyklus‘ 22 und überschätzten die Abnahme. Probleme gab es auch bei der ordentlichen Rekonstruktion der Sonnenzyklen 23 und 24.

Scafetta et al. justierten dann die Modelle, um die Diskrepanz zu korrigieren (anstatt die Daten zu verändern!) und erzeugten ein TSI-Komposit, welches gut zum ACRIM-Komposit passte sowie zu einem weiteren Komposit von Thierry Dudok de Wit (Dudok de Wit, et al. 2017). Sowohl das neue Komposit als auch das Dudok de Wit-Komposit zeigen einen zunehmenden Trend von 1986 bis 1997, genau wie das ACRIM-Komposit und ganz anders als das PDMO-Komposit.

Das neue Komposit zeigt eine Zunahme der TSI um 0,4 W/m² von 1986 bis 1996 und eine doppelt so starke Zunahme von 1980 bis 2002. Nach 2002 zeigt sich eine Abnahme. Das entspricht dem ACRIM-Komposit. Das PMOD-Komposit zeigt von 1986 bis 1996 eine Abnahme. PMOD scheint durch diese Studie diskreditiert, und es wird interessant sein, die entsprechenden Diskussionen während der nächsten Jahre zu verfolgen.

Die Bibliographie zu diesem Beitrag steht hier.

Dieser Beitrag wurde durch viele hilfreiche Vorschläge von Dr. Willie Soon und Dr. Ronan Connolly verbessert.

Link: https://wattsupwiththat.com/2020/04/20/ipcc-politics-and-solar-variability/

Übersetzt von Chris Frey EIKE