[Hinweis: Die Übersetzung wird bei ausführlich dargestellten Details der Berechnung gekürzt, jeweils gekennzeichnet durch …]

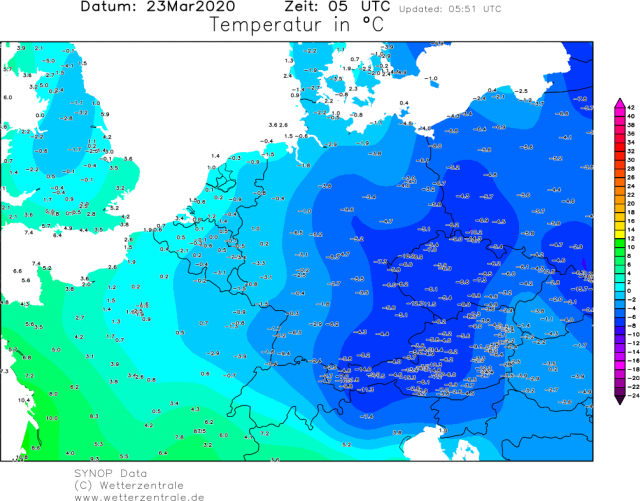

Mitten in all der Angst* um 1,5°C oder 2,0°C Erwärmung verglichen mit irgendeiner mythischen Zeit, als das Klima vermeintlich ,stabil‘ und (relativ) unbeeinflusst vom Menschen war, verlieren wir die Tatsache aus dem Auge, dass wir eine bessere Grundlage haben – jetzt. Ein Vorteil, ,jetzt‘ als Grundlinie zukünftiger Klimaänderungen zu nehmen ist, dass wir über gute Beobachtungen verfügen, um das Klima von ,jetzt‘ zu beschreiben.

Während sich die meisten Klima-Projektionen auf das Jahr 2100 beziehen, ist der Zeitraum 2020 bis 2050 aus verschiedenen Gründen bedeutsam:

[*Das Wort „angst“ steht so im Original! An. d. Übers.]

1. Es ist der Zeitraum, in welchem die Vorgaben des UNFCCC bzgl. Emissions-Reduktionen erfüllt werden müssen.

2. Viele finanzielle und infrastrukturelle Entscheidungen werden in dieser zeitlichen Größenordnung getroffen.

3. Die tatsächliche Klimaentwicklung über diesen Zeitraum wird die Punkte 1. und 2. beeinflussen; ,Überraschungen‘ können gegenteilige Auswirkungen haben als nach den Punkten 1. und 2. beabsichtigt.

Globale Klimamodelle haben wenig zu bieten, wenn es um zeitliche Größenordnungen von Jahrzehnten geht. Für diesen Zweck berechnen die CMIP5- und CMIP6-Modelle initialisierte Simulationen bis zu 35 Jahren im Voraus. Dekaden-Ergebnisse von CMIP6 liegen mir noch nicht vor, aber der Punkt ist, dass sie die Atlantische Multidekadische Oszillation AMO für 8 bis 10 Jahre im Voraus halbwegs abbilden können, sonst jedoch nichts weiter.

Ich habe zuvor die Interpretation der CMIP5-Simulationen kritisiert als tatsächlich Klimawandel-Szenarien – stattdessen zeigen diese Simulationen die Empfindlichkeit des Klimas auf verschiedene Emissions-Szenarien. Sie lassen Szenarien der solaren Variabilität und von Vulkanausbrüchen außen vor, und sie korrigieren Phase und Amplitude der multidekadischen Variabilität mit ozeanischen Zirkulationen. Begründet wird die Nichtberücksichtigung dieser Faktoren damit, dass deren Antrieb geringer ist als der Emissions-Antrieb. In multidekadischer Größenordnung muss das aber nicht unbedingt stimmen.

Und in er CMIP6-Ära haben wir jetzt ausreichende Informationen, mit welchen wir plausible Szenarien des Antriebs durch Vulkane und Sonne im 21 Jahrhundert erzeugen können, ebenso wie für die AMO.

Ich habe ein semi-empirisches Verfahren entwickelt, um Klimawandel-Szenarien des 21. Jahrhunderts zu beschreiben, welche sich nur indirekt auf Klimamodelle stützen. Multiple Szenarien werden entwickelt für jeden Treiber in der Vorhersage (natürlich und anthropogen), mit der Betonung auf plausiblen Szenarien (anstatt auf Extrem-Szenarien, die nicht völlig ausgeschlossen werden können).

Anmerkung: Im Folgenden werden viele Referenzen genannt. Mir fehlt die Zeit, eine vollständige Bibliographie zusammenzustellen, aber die Wichtigsten sind mit Hyperlinks hinterlegt.

Vom Menschen verursachte globale Erwärmung

Beim hier angewendeten Verfahren werden so weit wie möglich die neuen Informationen berücksichtigt, wie sie in das CMIP6 eingehen: neue Emissions-Szenarien und neue Überlegungen hinsichtlich der Sensitivität der Klimamodelle auf CO2.

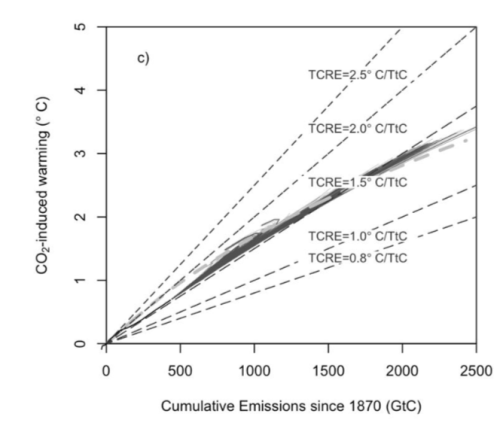

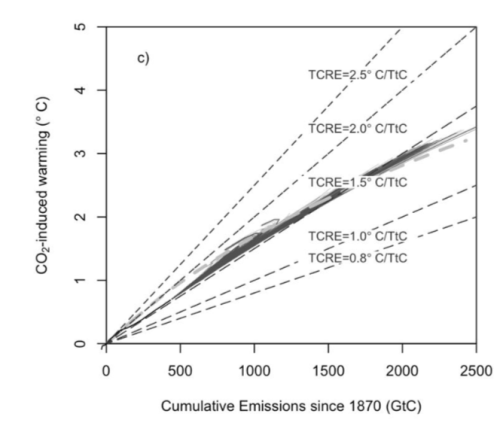

Ähnlich wie im jüngsten SR1.5-Report des IPCC wird nicht versucht, Ergebnisse des CMIP6 Earth System Model heranzuziehen. Folgt man dem SR1.5-Report, werden Szenarien der globalen Erwärmung angetrieben von Szenarien sich kumulierender Emissionen. Die individuellen kumulativen Emissions-Szenarien zwischen 2020 und 2050 werden dann übertragen in eine globale Temperaturzunahme mittels einer Palette von Werten der Transient Climate Response auf Cumulative Carbon Emissions (TCRE). Zur Verdeutlichung betrachte man die folgende Graphik:

Abbildung 1: CO2-induzierte Erwärmung als Funktion kumulativer Emissionen und TCRE. Nach Millar et al.

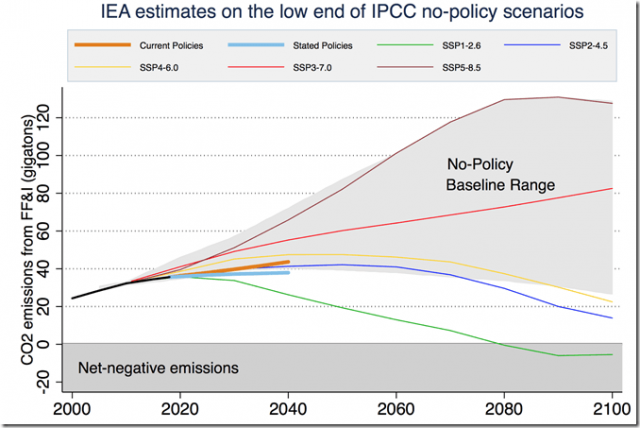

Für den demnächst erscheinenden AR 6 des IPCC wurde ein neuer Satz von Emissions-Szenarien (SSP) erstellt.

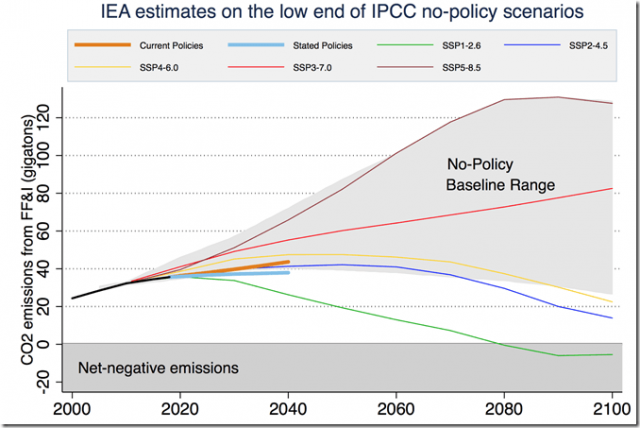

Der World Energy Outlook Report der IEA stellt die kurzfristigen SSP-Projektionen bis 2040 in Frage. Man untersuchte drei Szenarien: ein derzeitiges Politik-Szenario (CPS), bei welchem von den Ländern keine neuen Klima- und Energie-politische Maßnahmen ergriffen werden, ein erklärtes Politikszenario (STPS), bei dem die Verpflichtungen aus dem Pariser Abkommen erfüllt werden, und ein Szenario für nachhaltige Entwicklung (SDS), bei dem die rasche Eindämmung die Erwärmung am Ende des 21. September auf deutlich unter 2°C begrenzt. Sowohl das IEA CPS- als auch das STPS-Szenario können als Business-as-usual-Szenario betrachtet werden, bei dem entweder die derzeitige Politik oder die derzeitigen Verpflichtungen weitergeführt, aber danach keine weiteren klimapolitischen Maßnahmen ergriffen werden.

In Abbildung 2 werden die Projektionen der IEA bzgl. Emissionen durch fossile Treibstoffe verglichen mit im AR 6 des IPCC angeführten Szenarien. Die Graphik zeigt, dass die IEA-Projektionen zwischen dem SSP2-RCP4.5-Szenario und dem SSP4-RCP6.0-Szenario liegen, während das STPS-Szenario der IEA etwas unter SSP2-RCP4.5 liegt:

Abbildung 2: Jährliche CO2-Emissionen aus Industrie und durch fossile Treibstoffe bei den Szenarien CPS und STPS im Vergleich zur Bandbreite zugrunde liegender Szenarien zusammen mit einem Abschnitt der Grundlinie und Abschwächungs-Szenarien, die im demnächst erscheinenden AR 6 des IPCC gewählt worden sind. Ritchie and Hausfather (2019) https://thebreakthrough.org/issues/energy/3c-world

Die Umrechnung von Emissions-Szenarien in einen globalen Temperaturanstieg werden normalerweise mit Simulationen von globalen Klimamodellen durchgeführt. Die CMIP6-Simulationen jedoch, in welche die neuen SSP-Szenarien nebst deren Analyse eingehen, sind derzeit im Gange. Im jüngsten SR1.5-Report des IPCC wurden Werte der kurzzeitigen Reaktion des Klimas [Transient Climate Response TCR] auf kumulative Kohlenstoff-Emissionen TCRE gewählt und zur globalen Temperaturänderung auf kumulative Emissionen bei den SSP-Szenarien in Relation gestellt.

Wie stark sich die Welt laut Projektion durch die Emissionen erwärmt, ist in etwa linear proportional zu kumulativen Kohlenstoff-Emissionen (Matthews et al. 2018). Diese Relation zwischen Temperatur und kumulativen Emissionen wird allgemein als TCRE bezeichnet [transient climate response to cumulative carbon emissions]

Für einen gegebenen TCRE-Wert können wir die über eine zukünftige Periode zu erwartende Erwärmung berechnen als Reaktion auf kumulative Kohlenstoff-Emissionen.

…

Projektionen der natürlichen Klima-Variabilität

Szenarien der Variationen/Änderungen im Zeitraum 2030 bis 2050 sind Folgende:

● Solare Variationen

● Vulkanausbrüche

● Variabilität von Ozean-Zirkulationen im Zeitmaßstab von Jahrzehnten

Hinsichtlich der Solar-Szenarien im 21. Jahrhundert gibt es zwei Komplexe:

● Wie stark wird sich die gesamt-solare Einstrahlung (TSI) ändern und

● Wie viel Erwärmung bringt ein spezifischer TSI-Wert.

Dem AR 5 des IPCC zufolge ist der Einfluss der Sonne auf unser Klima seit vorindustriellen Zeiten hinsichtlich des Strahlungsantriebs sehr gering im Vergleich zur Variation des Strahlungsantriebs durch zusätzliche anthropogene Treibhausgase: 0,05 W/m² vs. 2,29 W/m². Die Botschaft des AR 5 lautet also, dass Änderungen der Sonnenaktivität praktisch vernachlässigbar sind im Vergleich zum anthropogenen Antrieb.

Diese Interpretation wird jedoch immer mehr in Frage gestellt:

● Es gibt substantiell keine Übereinstimmung bzgl. der Trends der Sonnenaktivität, nicht einmal während der Satelliten-Ära. In vielen Studien aus dem vergangenen Jahrzehnt wurde behauptet, dass die Sonnenaktivität in der zweiten Hälfte des 20. Jahrhunderts höher war als zu jeder anderen Zeit während der letzten 10.000 Jahre. In einigen Studien wird behauptet, dass die Sonne mindestens zu 50% zu der globalen Erwärmung nach 1850 beigetragen hat.

● Im AR 5 des IPCC wurden nur die direkten solaren Auswirkungen auf die globalen Temperaturen berücksichtigt. Es stellte sich heraus, dass die Energie-Änderung des 11-jährigen Sonnenzyklus‘ größenordnungsmäßig 1,0 bis 1,5 W/m² beträgt. Das ist um fast eine Größenordnung mehr als man von der solaren Einstrahlung allein erwarten kann, und es zeigt, dass der Einfluss der Sonnenaktivität durch atmosphärische Prozesse verstärkt wird. Zu Letzteren zählen: Änderungen der solaren UV-Strahlung; Eindringen energetischer Partikel, Auswirkungen des atmosphärisch-elektrischen Feldes auf die Wolkenbildung, Änderungen der Bewölkung durch solar beeinflusste kosmische Strahlung, große relative Änderungen in deren magnetischem Feld, Stärke des Sonnenwindes.

● Relationen zwischen solaren Variationen und dem Erdklima gibt es viele, und sie sind kompliziert. Die meisten davon wirken im lokalen und regionalen Maßstab, und viele sind nicht linear. Starke solare Einflüsse wurden im Pazifik und dem Indischen Ozean und auch in der Arktis gefunden, neben anderen Regionen.

Wie von Svensmark (2019) zusammengefasst zeigen Satellitendaten, dass die TSI um bis zu 0,05% bis 0,07% im Verlauf eines Zyklus‘ variiert. An der Obergrenze der Atmosphäre bringt diese Variation etwa 1 W/m² von einer Solarkonstanten um 1361 W/m². An der Oberfläche macht das nur 0,2 W/m² aus nach Berücksichtigung der Geometrie und der Albedo. Modellsimulationen und Beobachtungen haben eine Reaktion der globalen Temperatur auf TSI-Änderungen über den 11-jährigen Sonnenzyklus von etwa 0,1°C gezeigt (Matthes et al. 2017).

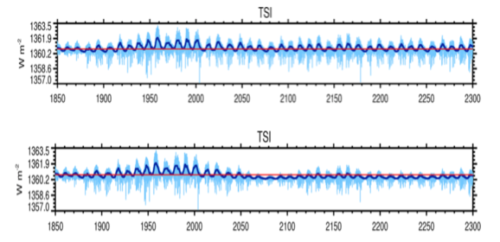

Der gegenwärtige Zyklus 24 ist der schwächste Sonnenfleckenzyklus seit 100 Jahren und der dritte, der einem Trend abnehmender solarer Zyklen zeigt. Gelangt die Sonne gegenwärtig in ein neues Grand Minimum oder lediglich in einer Periode geringer Sonnenaktivität? Viele Solarphysiker gehen davon aus, dass im 21. Jahrhundert eher Ersteres der Fall ist: ein Minimum im Jahrhundert-Niveau. Viele nehmen ein Minimum an, welches vergleichbar ist mit dem Dalton- oder sogar dem Maunder-Minimum.

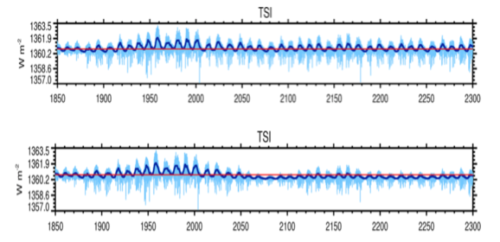

In den CMIP5-Modellen gehen die Klima-Projektionen von einem stationären Sonnen-Szenario aus, indem einfach der Sonnenzyklus 23 wiederholt wird. Dieser erstreckte sich von April 1996 bis Juni 2008 und war der drittstärkste Sonnenzyklus seit 1850. Eindeutig ist ein solches stationäres Szenario nicht repräsentativ für die wahre Sonnenaktivität, welche von Zyklus zu Zyklus Variationen und Trends aufzeigt. Daher werden in den CMIP6-Modellen realistischere Szenarien der zukünftigen Sonnenaktivität entwickelt, welche Variabilität in allen zeitlichen Größenordnungen aufweisen (Matthes et al. 2017). Matthes et al. präsentieren die folgenden beiden Szenarien (Abbildung 3): Ein Referenz-Szenario und ein Szenario des Maunder-Minimums in der zweiten Hälfte des 21. Jahrhunderts:

Abbildung 3: CMIP6-Szenarien des solaren Antriebs (TSI): Referenz-Szenario (oben); Szenario eines Maunder-Minimums (unten). Von Matthes et al. (2017)

Falls es zu einem Minimum von der Größenordnung des Maunder-Minimums im 21. Jahrhundert kommt, wie viel Abkühlung würde dies bewirken? Wie von Svensmark zusammengefasst zeigen sich in der Mehrheit aller Rekonstruktionen nur geringe Änderungen des Signals der Solarstrahlung: seit dem Maunder-Minimum soll die TSI um etwa 1 bis 2 W/m² zugenommen haben, was mit 0,18 W/m² an der Erdoberfläche korrespondiert. Das ist von gleicher Größenordnung wie die Amplitude des 11-jährigen Sonnenzyklus‘. Jones et al. (2012) verwendeten ein einfaches Klimamodell, mit welchem sie schätzten, dass die wahrscheinliche Minderung der Erwärmung bis zum Jahr 2100 durch ein Ereignis von der Größenordnung eines Maunder-Minimums zwischen 0,06°C und 0,1°C betragen dürfte. Fuelner und Rahmstorf (2010) schätzten, dass ein derartiges weiteres solares Minimum äquivalent zum Dalton und zum Maunder-Minimum eine Abkühlung von jeweils 0,09°C bzw. 0,26°C auslösen würde. Meehl et al. (2013) gingen von einer Abkühlung eines Maunder-Minimums von 0,3°C aus.

Bei diesen Berechnungen werde jedwede indirekte solare Auswirkungen ignoriert, welche diese Zahlen um einen Faktor 3 bis 7 größer machen würden. Shaviv (2008) zog die Ozeane als Kalorimeter heran, um die Variationen des Strahlungsantriebs in Zusammenhang mit dem Sonnenzyklus zu messen. Er fand heraus, dass die in die Ozeane einfallende Energie über einen Sonnenzyklus 5 bis 7 mal größer ist als die TSI-Änderung von 0,1%, was die notwendige Existenz eines Verstärkungs-Mechanismus‘ impliziert. Scafetta (2013) zeigte, dass die seit dem Mittelalter beobachtete große klimatische Variabilität nur dann korrekt interpretiert werden kann, wenn die klimatischen Auswirkungen der Sonnenvariabilität auf das Klima von den Klimamodellen stark unterschätzt worden ist, und zwar um einen Faktor von 3 bis 6. Svensmark (2019) argumentierte nach der Untersuchung von Bohrloch-Temperaturen seit der Mittelalterlichen Warmzeit ähnlich und fand einen Verstärkungs-Faktor von 5 bis 7 bei der Erwärmung, die durch einen Abfall der TSI erwartet werden kann. Falls man einen Verstärkungsfaktor dieser Größenordnungen einbringt, kann man bei einem Maunder-Minimum eine Abkühlung bis zu 1°C (oder sogar noch mehr) erwarten.

Drei Szenarien der solaren Variabilität werden hier betrachtet:

●Gar keine Variabilität (CMIP5)

●Ein CMIP6-Referenz-Szenario mit einem Verstärkungsfaktor 2 durch indirekte solare Auswirkungen.

●Szenario eines Maunder-Minimums (CMIP6) mit einem Verstärkungsfaktor 4 durch indirekte solare Auswirkungen.

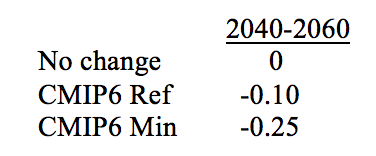

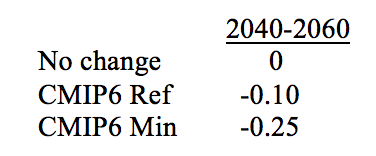

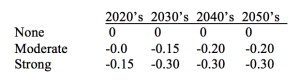

Tabelle 3: Szenarien einer solaren Abkühlung relativ zum Sonnenzyklus des CMIP5:

Vulkane

Vulkane

Die CMIP5-Klimamodell-Simulationen enthielten für das 21. Jahrhundert keinerlei Strahlungsantrieb durch zukünftige Vulkanausbrüche. Während diese nicht vorhersagbar sind, ist die Annahme eines Vulkan-Strahlungsantriebs von Null im 21. Jahrhundert ein schlechter Ausgangspunkt. Auch die Annahme, dass der Vulkan-Strahlungsantrieb aus dem 20. Jahrhundert sich einfach wiederholt, ist keine gute Annahme.

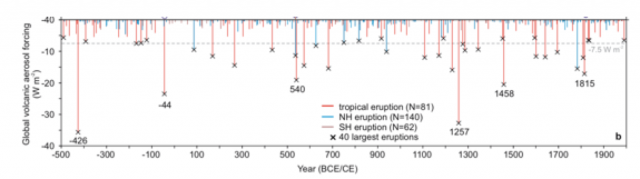

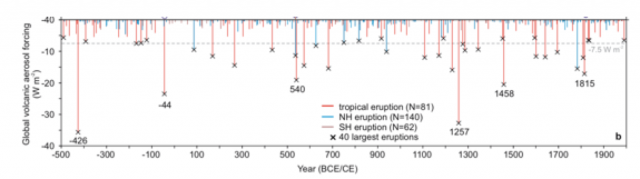

Im vorigen Jahrzehnt wurden zwei grundlegende paläoklimatische Rekonstruktionen von Vulkanausbrüchen während der letzten Jahrtausende vorgelegt. Gao et al. (2008) untersuchten Eisbohrkerne und erstellten eine Rekonstruktion des Sulfat-Ausstoßes durch diese Ausbrüche. Eine Rekonstruktion aus jüngerer Zeit von Sigl et al. (2015) folgt hier, dargestellt in Termen eines Strahlungsantriebs durch globale vulkanische Aerosole. Diese Rekonstruktionen stellten sie vor dem Hintergrund der relativ geringen Vulkanaktivität seit Mitte des 19. Jahrhunderts ins Verhältnis:

Abbildung 4: Rekonstruktion des globalen Strahlungsantriebs durch vulkanische Aerosole der letzten 2500 Jahre. Aus: Sigl et al. (2015).

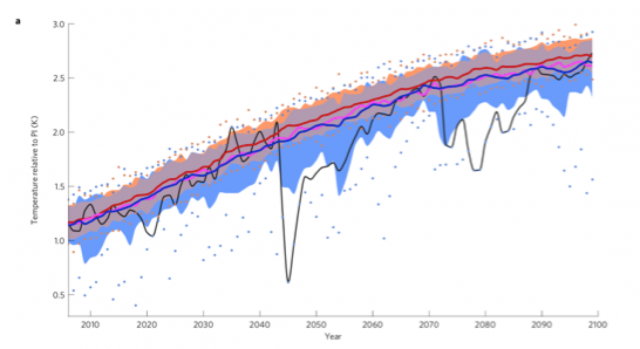

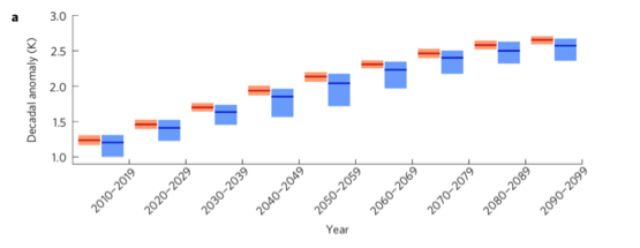

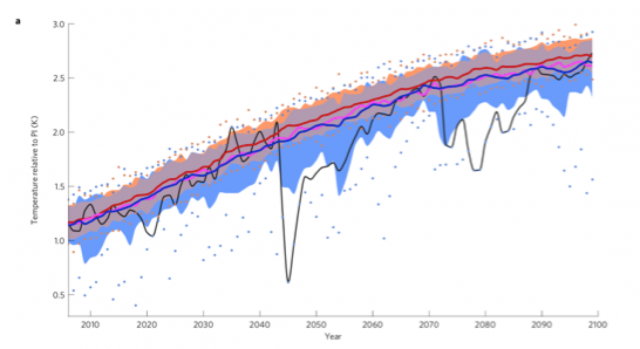

Weil Vulkanausbrüche unvorhersagbare Ereignisse sind, wurden sie allgemein aus den Klima-Projektionen für das 21. Jahrhundert ausgeklammert. Die jüngsten Projektionen spezifizieren den zukünftigen vulkanischen Antrieb als Null oder als konstanten Hintergrundwert. Bethke et al. (2017) erkundeten, wie sechzig vulkanische zukünftige Szenarien [volcanic futures] in Konsistenz mit den Eisbohrkernen die Projektionen der Klima-Variabilität unter dem RCP4.5-Szenario des Norwegian Earth System Model (NorESM; ECS=3.2C) beeinflussen. Ein gehäuftes Auftreten starker Ausbrüche in den Tropen hat zu nachhaltigen Kaltperioden wie der Kleinen Eiszeit beigetragen, während längerfristige Auswirkungen auf das Klima durch Anomalien des ozeanischen Wärmegehaltes sowie Änderungen der Ozean-Zirkulationen moderiert werden. Extreme vulkanische Aktivität kann potentiell ausgedehnte Kaltphasen auslösen.

Abbildung 5: Jährlicher GMST-Mittelwert*. Ensemble-Mittelwert (durchgezogen) von VOLC (stochastischer vulkanischer Antrieb; blau), VOLC-CONST (Mittel des vulkanischen Antriebs von 1850 bis 2000; violett) und NO-VOLC (rot/orange) mit der 5% bis 95%-Bandbreite (schattiert) sowie Minima/Maxima des Ensembles (Punkte) für VOLC und NO-VOLC; Entwicklung des extremsten Members (schwarz). Nach Bethke et al. (2017).

[*GMST = Global Mean Surface Temperature]

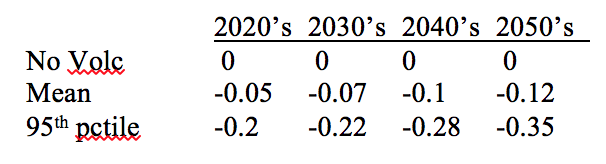

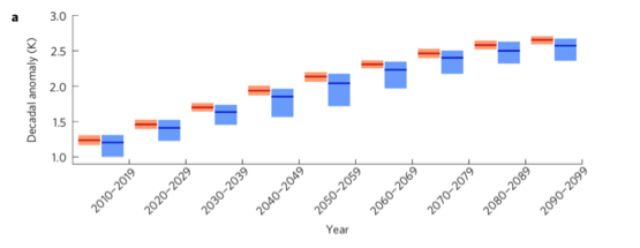

Auf der Grundlage der Ergebnisse von Bethke et al. (2017) werden drei vulkanische Szenarien für Abkühlung betrachtet, bezogen auf die in Abbildung 5 gezeigten Dekadenwerte:

● Kein Antrieb

● 50. Perzentilwert: mittlerer Antrieb

● 95. Perzentilwert: starker Antrieb

Abbildung 6: Dekadische GMST-Mittelwerte relativ zur präindustriellen Zeit. Ensemble-Mittel (durchgezogen) mit Bandbreite 5% bis 95% (schattiert) bei VOLC (blau) und NO-VOLC (rot).

Interne Variabilität

Interne Variabilität

Variationen der globalen mittleren Temperatur sind auch verknüpft mit der multidekadischen internen Variabilität der großräumigen Ozean-Zirkulationen. Allerdings ist die Trennung der internen Variabilität von der erzwungenen Variabilität nicht immer einfach infolge Unsicherheiten bei den externen Antrieben.

Es wurde geschätzt, dass die multidekadische interne Variabilität (Größenordnung 50 bis 80 Jahre) von Höhepunkt zu Höhepunkt eine Amplitude bis zu 0,3°C bis 0,4°C aufweisen kann (Tung und Zhou 2012), was etwa die Hälfte der Erwärmung bis zum Ende des 20. Jahrhunderts ausgelöst hat.

…

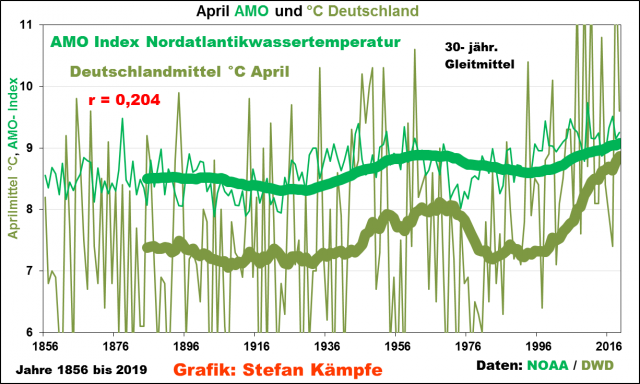

Aus den meisten Analysen war hervorgegangen, dass die Atlantische Multidekadische Variabilität die Temperaturen global und auf der Nordhemisphäre hauptsächlich beeinflusst. Die Identifizierung der ENSO als Treiber von Variationen der globalen mittleren Temperatur oder ein Signal der Reaktion darauf bleiben umstritten, mit sich widersprechenden Ergebnissen.

…

Berücksichtigt man die multidekadische Variabilität nicht bei Prognosen der zukünftigen Erwärmung unter verschiedenen Antriebs-Szenarien, besteht das Risiko der Überschätzung der Erwärmung im Verlauf der nächsten zwei bis drei Jahrzehnte, wenn die Atlantische Multidekadische Oszillation (AMO) wahrscheinlich ihre Kaltphase durchläuft.

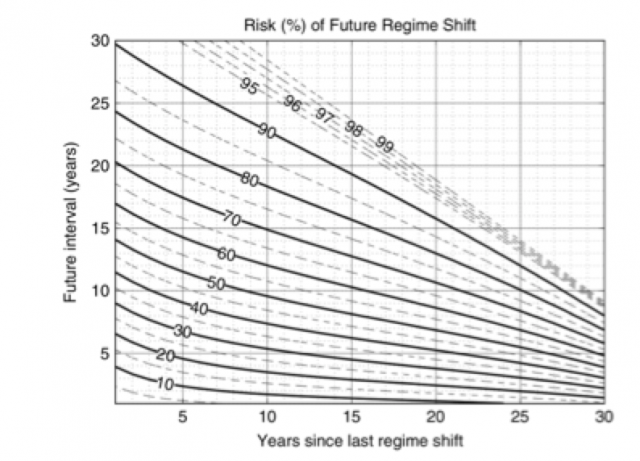

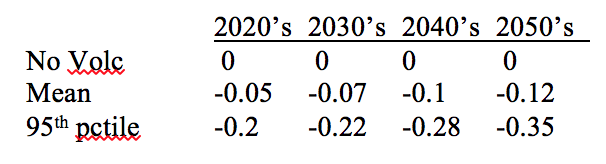

Die Analyse historischer und paläoklimatischer Aufzeichnungen legt nahe, dass ein Übergang in die kalte Phase der AMO vor 2050 zu erwarten ist. Enfield und Cid-Serrano (2006) verwendeten paläoklimatische Rekonstruktionen der AMO, um eine probabilistische Projektion der nächsten AMO-Verschiebung zu entwickeln. Abbildung 7 zeigt die Wahrscheinlichkeit einer AMO-Verschiebung im Verhältnis zur Anzahl der Jahre seit dem letzten Phasenwechsel. Der letzte Phasenwechsel fand 1995 statt; daher sind im Jahr 2020 seit dem letzten Phasenwechsel 24 Jahre vergangen. Abbildung 7 zeigt, dass eine Verschiebung in die kalte Phase innerhalb der nächsten 15 Jahre erwartet wird, wobei die Wahrscheinlichkeit, dass die Verschiebung im Verlauf der nächsten 6 Jahren stattfindet, 50% beträgt.

Abbildung 7: Wahrscheinlichkeiten eines Phasenwechsels der AMO relativ zur Anzahl der Jahre nach dem letzten Phasenwechsel. Nach Enfield und Cid-Serrano (2006)

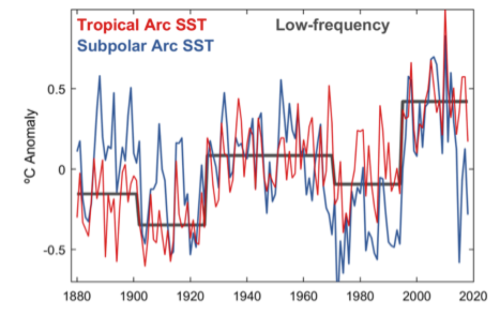

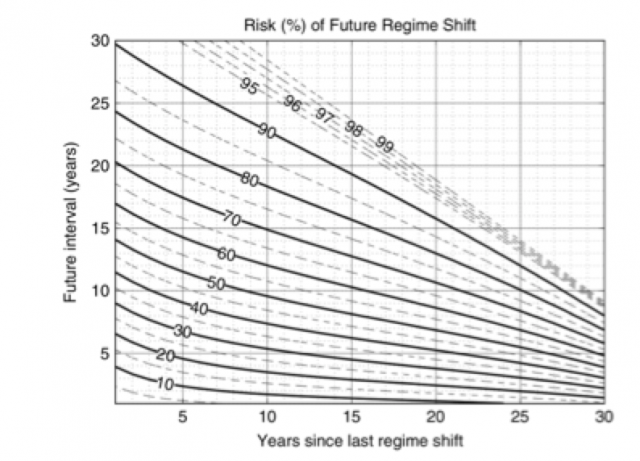

Der Zeitpunkt eines Wechsels der AMO in die Kaltphase ist nicht vorhersagbar. Er hängt bis zu einem gewissen Ausmaß von der unvorhersagbaren Variabilität des Wetters ab (Johnstone 2020). Seine Analyse zeigt, dass Änderungen niedriger Frequenz der Wassertemperatur (SST) im Nordatlantik seit dem Jahr 1880 objektiv definiert werden können als eine Reihe alternierender Phasenwechsel mit abrupten (~1 Jahr) Übergängen während der Jahre 1902, 1926, 1971 und 1995 (Abbildung 8). Diese abrupten Änderungen (seit 1880) betonen längere quasi-stabile Perioden von 24 Jahren (1902bis 1925), 45 Jahren (1926 bis 1970) und 24 Jahren (1971 bis 1994). Die jüngste und wärmste Phase seit Beginn der Reihe dauerte nunmehr von 1995 bis 2019 (25 Jahre). Voran gegangene Wechsel in die Kaltphase in den Jahren 1902 und 1971 wiesen ähnliche Amplituden (-0,2°C) auf, welche längeren Perioden relativer Wärme folgten (1880 bis 1901, 1926 bis 1970). Eine Verschiebung in die Kaltphase innerhalb kürzerer Zeit (~5 Jahre) könnte vorläufig aus einem starken Rückgang der SST im subpolaren Nordatlantik gefolgert werden, ein Verhalten, welches ein Vorzeichen einer breiteren Abkühlung des Nordatlantiks sein kann auf der Grundlage eines frühen subpolaren Auftauchens des jüngsten Wechsels in die Kaltphase im Jahre 1971.

Abbildung 8: Jährliche SST-Anomalien im subpolaren (blau) und tropischen (rot) Nordatlantik. Eine starke subpolare Abkühlung im Jahre 2015 ist klar erkennbar (Johnstone 2020).

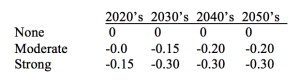

Auf der Grundlage obiger Analysen lassen sich die in Tabelle 5 gezeigten drei Szenarien einer globalen Temperaturänderung in Verbindung mit der AMO ableiten.

Tabelle 5: Dekadische Szenarien einer Temperaturänderung im Zuge der internen Variabilität (°C) bei einem Übergang der AMO in die Kaltphase:

Integrale Szenarien der Temperaturänderung: 2050

Integrale Szenarien der Temperaturänderung: 2050

Die finale integrale Temperaturänderung ist die Summe der Temperaturänderungen, die angetrieben werden durch

● Emissionen (4 Szenarien)

● Vulkane (3 Szenarien)

● Solar (3 Szenarien)

● AMO (3 Szenarien)

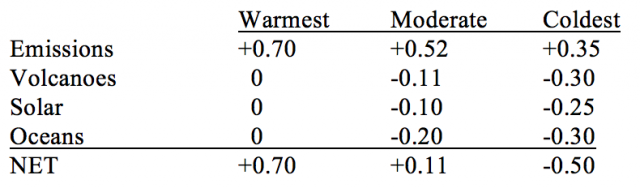

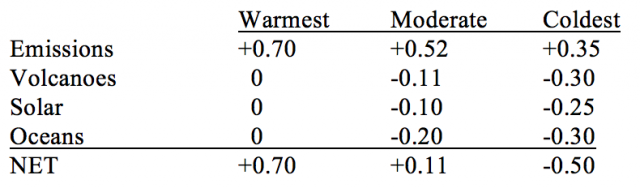

Es gibt 108 mögliche Kombinationen dieser Szenarien. Tabelle 6 zeigt die Szenarien jeweils mit extrem hoher und niedriger Erwärmung plus das Szenario bei Heranziehen der Mittelwerte.

Tabelle 6: Integrale Szenarien der einer Änderung der globalen Mitteltemperatur von 2020 bis 2050:

Alle Komponenten der natürlichen Variabilität deuten auf Abkühlung im Zeitraum 2020 bis 2050. Individuell ist nicht zu erwarten, dass diese Terme bei den moderaten Szenarien groß sind. Wenn man jedoch deren Amplituden summiert, nähert man sich der Amplitude der Erwärmung in Verbindung mit der Erwärmung, die verbunden ist mit moderaten Werten der TCRE -1,35°C und 1,65°C. Falls die natürliche Abkühlung über den erwarteten Wert hinausgeht oder der TCRE am unteren Ende liegt (1,0°C bis 1,35°C), dann dürfte es insgesamt zu Abkühlung kommen.

Alle Komponenten der natürlichen Variabilität deuten auf Abkühlung im Zeitraum 2020 bis 2050. Individuell ist nicht zu erwarten, dass diese Terme bei den moderaten Szenarien groß sind. Wenn man jedoch deren Amplituden summiert, nähert man sich der Amplitude der Erwärmung in Verbindung mit der Erwärmung, die verbunden ist mit moderaten Werten der TCRE -1,35°C und 1,65°C. Falls die natürliche Abkühlung über den erwarteten Wert hinausgeht oder der TCRE am unteren Ende liegt (1,0°C bis 1,35°C), dann dürfte es insgesamt zu Abkühlung kommen.

…

Conclusions

Drei grundlegende Folgerungen gibt es:

● Wir fangen an, die Unsicherheit bei der Stärke der Erwärmung durch Emissionen einzuengen, welche wir bis zum Jahr 2050 erwarten können.

● Alle drei Zustände der natürlichen Variabilität – Solar, Vulkane, interne Variabilität – neigen während der nächsten 3 Jahrzehnte zu Abkühlung

● Abhängig von den relativen Magnituden der von Emissionen angetriebenen Erwärmung im Vergleich zur natürlichen Variabilität sind Jahrzehnte ohne Erwärmung oder sogar mit Abkühlung mehr oder weniger plausibel.

…

Aber was ist mit der 2. Hälfte des 21. Jahrhunderts bis 2100? Unsicherheiten hinsichtlich Emissionen sind dann sehr viel größer. Die Solar-Szenarien des CMIP6 (Referenz und Maunder) zeigen stärkere Abkühlung während der 2. Hälfte des 21. Jahrhunderts. Vulkanausbrüche könnten dann stärker sein (oder auch nicht). Nach der projizierten Kaltphase der AMO kann man eine Rückkehr zur Warmphase erwarten, aber es gibt kein Vertrauen bei der Projektion entweder einer warmen oder einer kalten AMO-Phase im Jahre 2100.

Unabhängig von der Größenordnung von Vulkanausbrüchen besteht die große Unsicherheit in indirekten Auswirkungen der Sonne. Auf der Grundlage der von mir gesichteten Literatur scheinen UV-Effekte auf das Klima mindestens so stark zu sein wie TSI-Effekte. Ein Faktor von 2 bis 4 mal TSI scheint mir vollkommen plausibel, und es gibt auch ernsthafte Argumente für sogar noch höhere Werte. Ich möchte hier auch noch einmal betonen, dass fast alle Schätzungen von ECS/TCR auf der Grundlage von Beobachtungen keinerlei Berücksichtigung von Unsicherheiten der indirekten Auswirkungen der Sonne finden. Scafetta (2013) hat derartige Effekte bei einer Schätzung der ECS berücksichtigt und kam auf einen ECS-Wert von 1,35°C.

Weder die Auswirkungen der AMO noch indirekte solare Effekte sind bei der Analyse der Ursachen der Erwärmung seit 1950 berücksichtigt worden.

…

Link: https://wattsupwiththat.com/2020/02/16/plausible-scenarios-for-climate-change-2020-2050/

Übersetzt von Chris Frey EIKE