Aktuell reden alle von der sogenannten „zweiten Welle“, allen voran das Robert-Koch-Institut (RKI) und, dauerpräsent, Professor Christian Drosten. Es wird die drohende Anflutung neuer schwer an Covid-19 Erkrankter nach einer zu frühen Öffnung des Lockdowns beschworen. Aber zumindest für Deutschland darf gefragt werden: Wie sah eigentlich die erste „Welle“ aus – und trifft die Metapher von einer “Welle“ überhaupt zu?

Seit März werden Krankenstationen und Intensivabteilungen geräumt, um Platz zu schaffen für die vielen neuen Covidkranken. Deren Zahl wurde astronomisch hoch eingeschätzt, die Warner sprachen von hunderttausenden zu erwartenden Toten. Doch in sehr vielen Krankenhäusern – nicht allen – und deren Intensivabteilungen herrscht seitdem Leere, und manche melden sogar Kurzarbeit an (auf den Skandal, dass viele Behandlungspflichtige abseits Covid nicht stationär behandelt wurden, sei an dieser Stelle gar nicht eingegangen).

Dennoch hören die Panikmeldungen nicht auf, wie beispielsweise vor zwei Wochen ein dramatischer Aufruf eines bekannten schweizerischen Herzchirurgen, der über katastrophale Zustände in Intensivabteilungen und infiziertes Pflegepersonal berichtete. Genauso schrecken Berichte über gestorbene Pfleger, Ärztinnen und Kinder auf. Doch so gut wie nie werden dazu genaue Zahlen und Umstände genannt, um dies einordnen zu können.

Im Falle des Herzchirurgen machte ich eine Probe aufs Exempel und rief in seiner Klinik in Zürich an. Dort gab man mir die Auskunft, die Betten, die man für Covid frei gehalten habe, seien weitgehend gar nicht belegt. Auch Erkrankungssfälle des Personals seien nicht bekannt. Die gleiche entspannte Lage im 30 Kilometer entfernten Kantonspital Winterthur, welches ich gut kenne. Was soll man davon halten?

Ausbreitungsgeschwindigkeit seit sechs Wochen im Sinken

Tatsache ist, in Deutschland gab es keine auffallende erste Welle. Wieso soll es dann eine zweite geben? „Für eine Übersterblichkeit mit auffälligen Abweichungen nach oben in den Monaten Januar bis März 2020 haben wir aktuell keine Hinweise“, sagt das Statistische Bundesamt. Aktuell sind wir sogar in einer Untersterblichkeit im Vergleich zu anderen Jahren. Warum ist es in anderen Ländern anders? Darauf gehe ich weiter unten in diesem Text ein.

Tatsache ist, die Ausbreitungsgeschwindigkeit ist bereits um den 9. März im Sinken. Dies geht aus der inzwischen ausgiebig diskutierten Kurve des Robert-Koch-Institutes (Abb.4) bezüglich des Reproduktionsfaktors „R“ hervor. Unter dem Schlüsselwert 1 liegt R schon seit dem 20. März, also drei Tage vor dem Lockdown, so das RKI. Als Stefan Homburg, Professor für Öffentliche Finanzen und Direktor des Instituts für Öffentliche Finanzen der Leibniz Universität Hannover, dies feststellte, wurde er in Medien teilweise verunglimpft (inzwischen hat sich beispielsweise die dpa entschuldigt). Sehr anschaulich werden die Zusammenhänge in Verbindung mit der von Homburg angeführten Kurve auch im sehenswerten Coronovideo Nr. 35 des Hals-Nasen-Ohren-Arztes und Kollegen Bodo Schiffmann erläutert. Beachten Sie auch seinen Hinweis auf eine stattgefundene Massenveranstaltung, nämlich die Hamsterkäufe nach den Schulschließungen. Schauen Sie hier am besten ab Minute 5:30.

Dazu passt auch dieser aufschlussreiche Beitrag auf Telepolis,der sich auf Aussagen der WHO bezieht, die selbst zugibt, dass für die Lockdown-Strategie keinerlei wissenschaftliche Evidenz existiert. Die Autoren, drei Soziologieprofessoren, schließen mit diesem Satz:

„Eine weniger naheliegende Lösung läge dahingegen in der Hoffnung auf die kombinierte Wirksamkeit einzeln wirkungsloser Maßnahmen und in dem Versuch, diese Hypothese im Rahmen eines Ereignisses zu überprüfen, das dann als das größte, teuerste und verheerendste Sozialexperiment in die Geschichte der Menschheit eingehen könnte.“

Versagen beim Schutz der Risikogruppen in den Pflegeheimen

Ich möchte noch einmal auf einen bisher zu wenig beachteten Abschnitt im erwähnten RKI-Artikelhinweisen. Die Bundeskanzlerin gab selbst stets das Ziel R 1 als angestrebten Zustand aus. Nun da R unter 1 liegt, heißt es plötzlich von ihr, dies reiche nicht, er müsste noch weiter sinken. Was schreibt das RKI selbst zur Ursache des nicht weiter sinkenden R-Wertes:

„Ein Grund dafür, dass der Rückgang der Neuerkrankungen trotz der gravierenden Maßnahmen nur relativ langsam passiert, ist, dass sich das Virus nach dem 18. März stärker auch unter älteren Menschen ausbreitet und wir zunehmend auch Ausbrüche in Pflegeheimen und Krankenhäusern beobachten. Ein weiterer Aspekt ist aber auch, dass in Deutschland die Testkapazitäten deutlich erhöht worden sind und durch stärkeres Testen ein insgesamt größerer Teil der Infektionen sichtbar wird. Dieser strukturelle Effekt und der dadurch bedingte Anstieg der Meldezahlen, kann dazu führen, dass der aktuelle R-Wert das reale Geschehen etwas überschätzt“

Noch einmal einfach gesagt: Mit dieser Aussage räumt das RKI ein Versagen beim Schutz der Risikogruppen in den Pflegeheimen ein. Wie dieser Schutz hätte aussehen müssen, habe ich in dieser Beitragsreihe seit Mitte März mehrfach thematisiert. Zusätzlich schreibt das RKI auch, dass ein Zusammenhang zwischen der Zahl der Testungen und der Reproduktionsrate besteht und deswegen R aktuell tiefer liege.

In diesem Zusammenhang wird auch eine neue Publikation von Professor Christof Kuhbandner vom Institut für Experimentelle Psychologie an der Universität Regensburg spannend. Sie ist anscheinend noch nicht offiziell zur Veröffentlichung freigegeben, aber dennoch verfügbar. Sie beantwortet plausibel die Frage, warum man nur sehr eingeschränkt von einer ersten „Welle“ sprechen kann.

Ein neues Licht auf die omnipräsenten Kurven der Neuinfizierten

Anhand eines anschaulichen Beispiels sei gezeigt, um was es geht. Nehmen wir an, wir haben einen großen Garten. Darin verstecken wir hundert Ostereier. Die Ostereier stehen für die gerade zu diesem Zeitpunkt Neuerkrankten. Nun schicken wir ein Kind in den Garten, welches genau eine Minute hat, um Eier zu finden. Es findet ein Ei. Die Minute steht für einen Corona-Test und das gefunden Ei für die in der Statistik angegebenen Neuerkrankungen.

Hätten wir dem Kind zwei Minuten Zeit gegeben, dann hätte es theoretisch zwei Eier gefunden. Bei vier Minuten vier Eier und bei acht Minuten acht Eier. Das ergibt ein scheinbar exponentielles Wachstum der Eierzahlen, aber nur, weil die Zahl der Minuten (also Coronatests) exponentiell wächst. In Wirklichkeit bleibt die Zahl der tatsächlich Neuerkrankten, nämlich die 100 versteckten Eier, konstant.

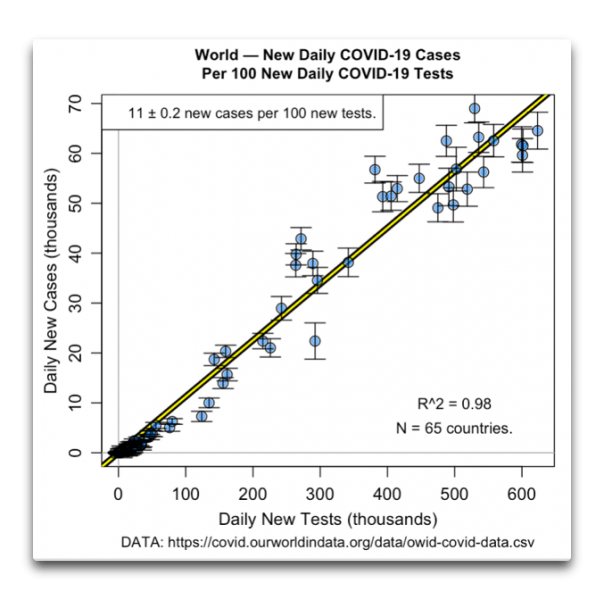

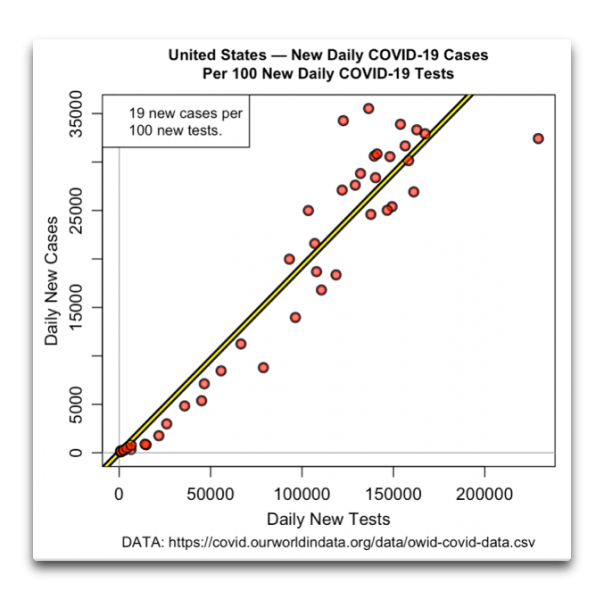

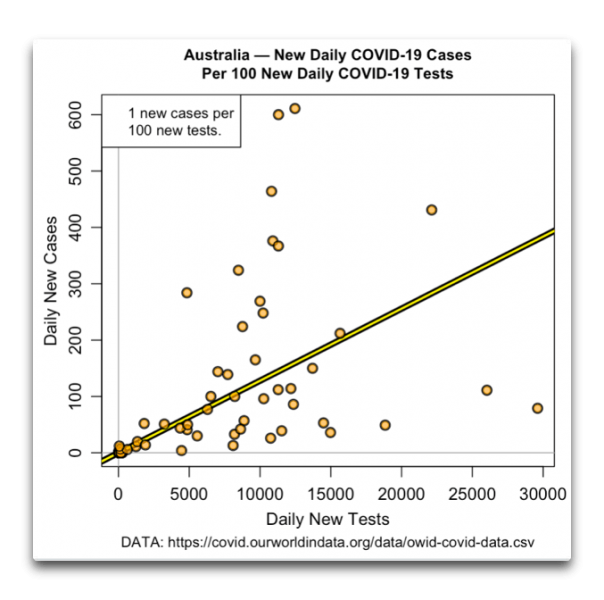

Wer nun die üblichen Kurven der Neuerkrankten (die mit positiven Testergebnis) betrachtet, muss deshalb dazu immer auch die Gesamtzahl aller Tests (auch der negativen) erfahren, sonst sagt diese Kurve nichts aus. Denn wenn bei einem exponentiellen Wachstum der Neuerkrankungen die Kurve der Testzahlen dazu parallel verläuft, besteht überhaupt kein exponentielles Wachstum, sondern R = 1.

Erst wenn die Kurve der Neuentdeckten steiler als die der Testzahlen ist, liegt ein exponentielles Wachstum vor. Ist die Kurve ansteigend, aber flacher als die der Testzahlen, sinkt in Wirklichkeit die Zahl der Neuinfizierten. Das wirft ein völlig neues Licht auf die omnipräsenten Kurven der Neuinfizierten, auf die sich alle Augen konzentrieren. Folgt man der Publikation von Christoph Kuhbandner, müssen sie alle modifiziert werden anhand der jeweils steigenden Testzahlen. Eigentlich verblüffend einfach und logisch, aber man muss anscheinend erst darauf kommen.

Der Regensburger Professor hat nun die bestehenden Kurven neu berechnet, in der Annahme, die Zahl der Tests wäre konstant geblieben. Was kam dabei heraus? Für Deutschland ein viel geringeres, nicht exponentielles Wachstum mit Sinken seit der 13. Kalenderwoche. So betrachtet, verliert bezüglich des Ausbreitungsrisikos Covid-19 seinen Schrecken. Dagegen spricht eben nicht, dass es schwere Fälle gegeben hat und in einzelnen Hotspots auch beachtliche Fallzahlen. Das gilt für andere Infektionen, die jedes Jahr ihr Unwesen treiben, allerdings genauso. Auch für Österreich, Belgien, Frankreich, Italien und die USA gelten die gleichen Beobachtungen.

Trugschlussanfälliges Horrorszenario

Nun eine weitere, sehr spannende Schlussfolgerung. Kuhbandner stellt fest, dass in allen Ländern, die Kurve der offiziellen Neuinfektionen (positiv Getesteten) ziemlich parallel verläuft mit der Zahl der Toten. Das verwundert, denn ab einem positiven Testergebnis aufgrund erster Symptome und einem Versterben an Covid sollte mindestens ein zeitlicher Abstand von 14 Tagen bestehen. Der Anstieg der Todesfälle müsste also zeitlich später verlaufen als der Anstieg der Neuerkrankten. Nämlich etwa 14 Tage.

Was bedeutet diese fehlende zeitliche Verzögerung der Kurven? Kuhbandner nennt zwei Schlussfolgerungen. Wären alle aufgeführten Todesfälle tatsächlich an Covid gestorben, dann hätte man 14 Tage vorher einen vergleichbaren Anstieg an Neuerkrankten sehen müssen. Da dies nicht der Fall ist, könnte es sein, dass viele als Covidtote Gemeldete erst kurz vor oder während des Sterbens positiv getestet wurden, weil sie sich erst kurz davor infiziert hatten. Dies wiederum erklärt die Obduktionsergebnisse des Hamburger Pathologen Professor Klaus Püschel, der feststellte, dass viele der Covidtoten eigentlich nicht wirklich an Covid gestorben sind, sondern mit oder als allerletztem Sterbeimpuls.

Eine weitere Überlegung von Christoph Kuhbandner ist ebenfalls erwägenswert. Er stellt fest, dass nur ein kleiner Teil der Getesteten positiv war. In Deutschland nur etwa sieben Prozent. In Italien wurden hauptsächlich Patienten mit ernsten Lungensymptomen getestet, aber auch hier waren nur 20 Prozent positiv. Könnte es sein, dass viele der in Bergamo Verstorbenen gar nicht an Corona, sondern an anderen Infektionen der Atemwege gestorben sind, wie zum Beispiel durch Influenza? Auch in den USA starben von den 6.427 Covidtoten zwischen 22.03. und 11.04. „nur“ 2.925 an einer Lungenerkrankung. Während in diesem Zeitraum insgesamt 10.006 Menschen an einer Lungenentzündung verstarben. Das bedeutet, nur ein geringerer Teil der an Atemwegserkrankung Verstorbenen in den USA verstarben tatsächlich an Covid. Übrigens, trotz der täglichen Schreckensmeldungen aus den USA herrscht dort im Vergleich zu 2019 eine Untersterblichkeit.

Wie immer man gerade die letzten Überlegungen einordnet, und auch wenn diese Publikation viel Kritik auf sich ziehen wird, die Grundthesen, die auf den offiziellen Zahlenangaben beruhen, erlauben auf jeden Fall die Aussage, dass aus epidemiologischer Sicht die Gefährlichkeit von Covid-19 nach heutigem Stand offenbar stark überschätzt wird. Der letzte Satz von Kuhbandners Publikation lautet:

„Es scheint äußerst wichtig zu sein, sich dieses statistischen Trugschlusses bewusst zu werden, um der extremen Furcht entgegenzuwirken, die durch das trugschlussanfällige Horrorszenario ausgelöst wird, dass es bald Millionen von Coronavirus-Infektionen und Todesfällen geben könnte“.

(“Becoming aware of this statistical fallacy seems to be extremely important in order to counteract the extreme fear that is induced by the fallacy-prone horror scenario that there may be soon millions of coronavirus infections and deaths.)”

Ein natürliches Ablaufdatum von Covid?

Nachdem auch mich die Bilder aus Italien schockierten und ich mir ausmalte, was diese Entwicklung zu bedeuten hat, wurde ich als Arzt intuitiv stutzig. Wenn Covid wirklich die angedrohte katastrophale Seuche wäre, dann hätte sich die Infektion schon weit vor der Abriegelung in anderen Städten ausbreiten und ähnliche Katastrophen wie in Bergamo anrichten müssen, was aber in diesem Maße nicht geschah (womit ich die Entwicklung mitnichten relativieren will). Diese schlichte Beobachtung spricht an sich schon für ein natürliches Ablaufdatum von Covid, so wie es eine Grippeepidemie auch hat.

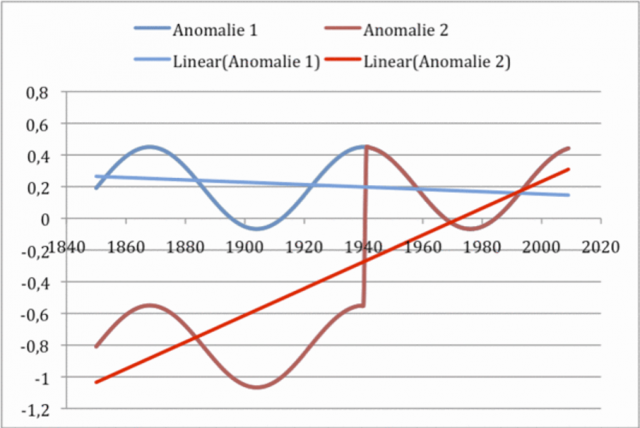

Dazu passt die bereits im Bericht zur Coronalage vom 22.04.2020 vorgestellte Arbeit des israelischen Mathematikers und Analysten Ben-Israel, der in allen Ländern völlig unabhängig zu den Maßnahmen einen Epidemieverlauf mit Anstieg von sechs Wochen ermittelte, der danach zügig abfällt. Man kann nur spekulieren warum, ob schnelle Immunität, jahreszeitliches Klima, oder was es immer ist. Selbst wenn es punktuell zu Überbelastungen kam, sie verbreiteten sich eben nicht über das ganze Land. All dies geschah weit vor jedem Lockdown.

Allerdings spielte es eine Rolle, wie viele Menschen zum Zeitpunkt der hohen Virusinfektiösität infiziert wurden und auf welches Gesundheitssystem diese trafen. Und hier gibt es an den Hotspots starke Länderunterschiede. Dazu noch die vorher besprochenen Beobachtungen von Professor Kuhbandner und der inzwischen erhärtete Verdacht, dass viele Coronatote und auch die meisten Spätfolgen der Überlebenden auf eine falsche Beatmungstechnik zurückzuführen sind. So, wie sie wahrscheinlich in den schlimmsten betroffenen Ländern häufig angewandt wurde.

Es ist komplex, und es wird dazu in den nächsten Jahren sehr viele wissenschaftliche Publikationen geben, die immer präziser erklären können, was eigentlich passiert ist. Manches wird überraschend sein. Wir in Deutschland hatten ganz sicher das Glück, dass die Karnevalsfolgen – und auch die solcher Aktionen wie die der bayrischen Kommunalwahlen – unser im Vergleich gut aufgestelltes Gesundheitssystem bei weitem nicht überlasten konnten und dass die Lungenärzte des Verbandes pneumologischer Kliniken so vehement auf die Fehler bei der Beatmungstechnik hinwiesen.

Wieder wird mit apokalyptischen Zahlen gewarnt

Und dennoch wird jetzt vor der zweiten Welle gewarnt und wieder mit apokalyptischen Zahlen. Wie das ängstliche Kaninchen wird auf dem Lockdown beharrt, bis der rettende Impfstoff gefunden sei, um diesen dann im Hauruckvefahren ohne akzeptable Testung bei einer bereits abklingenden Infektion einzusetzen. Einen solch unnötigen wie gefährlichen Impfstoff hatten wir schon einmal, 2009 während der Schweinegrippe. Meine Patienten werde ich davor schützen.

Die Schweinegrippe-Panik diente auch als ein Impfstoff-PR-Theater, als die Harmlosigkeit im Vergleich mit normalen Influenza Epidemien schon längst klar war und die Regierung zu recht auf gekauften, gefährlichen Impfstoffen im Wert von 500 Millionen € sitzen blieb (die später zum großen Teil verbrannt wurden). Als dies alles schon klar war, legte übrigens ein Virologe namens Professor Christian Drosten im Mai 2010 den Panikgang ein und riet dringend zur Impfung. Hersteller des riskanten Impfstoffes war GlaxoSmithKline. Ein paar Jahre zuvor hatte Christian Drosten den GlaxoSmithKline-Förderpreis für Klinische Infektiologie erhalten.

Meine Risiko-Analyse der Zahlen möchte ich so zusammenfassen: Das vorhandene epidemiologische Wissen ist ausreichend, um die Ausbreitungsgefahr von Covid-19 als gut beherrschbar einzuschätzen. Auch die Sterblichkeit liegt wohl viel niedriger als angenommen. Die klassischen Schutzmaßnahmen reichen völlig aus: Händewaschen, Isolierung Erkrankter, eventuell auch ihres Umfeldes, und der Empfehlung an Risikogruppen, körperliche Nähe und größere Menschenansammlungen zu meiden.

Als Sicherheitsanker empfiehlt sich noch der hoffentlich bald professionellere Schutz von Pflegeheimen. Mit wachsendem Wissen über die Verbreitung und Wirkung des Virus, die selbstverständlich auch negative Überraschungen beinhalten können, wachsen die Chancen weiter, angemessen damit umzugehen. Völlig unangemessen dagegen ist die Einleitung eines Lockdown und vor allem das beratungsresistente Festhalten daran.

Hätten die vielen kompetenten und unabhängig agierenden Wissenschaftler eine größere Bühne in der Öffentlichkeit und müssten nicht um berufliche Konsequenzen fürchten, wenn sie ihre Meinung frei äußern, wäre eine solche Analyse der Lage längst Allgemeingut, und der immense Schaden des Lockdowns, der erst richtig auf uns zurollen wird, hätte zumindest teilweise vermieden werden können. Die öffentliche Dominanz regierungskonformer Wissenschaftsfunktionäre und Medien schwächt so die Widerstandsfähigkeit unserer Gesellschaft, in einer Krise um die besten Lösungen zu streiten.

Ein herzliches Danke

Bedanken möchte ich mich an dieser Stelle einmal für die vielen unterstützenden und kundigen Zuschriften, die mein eigenes Verstehen enorm bereicherten. Herzlichen Dank dafür. Beim letzten Beitrag habe ich vergessen zu erwähnen, dass er bei Gefallen bitte weiterverbreitet werden soll. Deshalb bekam ich Anfragen, ob man dies auch weiterhin dürfe. Selbstverständlich gerne. Auch wenn mir manchmal die Plattformen nicht gefallen, auf denen meine Beiträge dann auftauchen. Denn Richtiges bleibt richtig, auch wenn es von – je nach Gusto – den „Falschen“ verbreitet wird.

PS.

Ursprünglich wollte ich heute die Sicht der Praktiker, vor allem der Lungenärzte und Pathologen schildern – und wie sie die Gefährlichkeit der Krankheit namens Covid-19 am einzelnen Patienten erleben. Dies hole ich im nächsten Beitrag nach.

Der Beitrag erschien zuerst bei ACHGUT hier

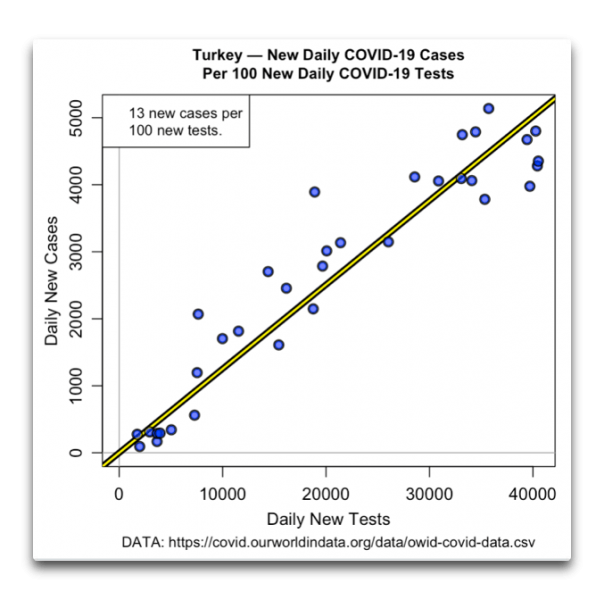

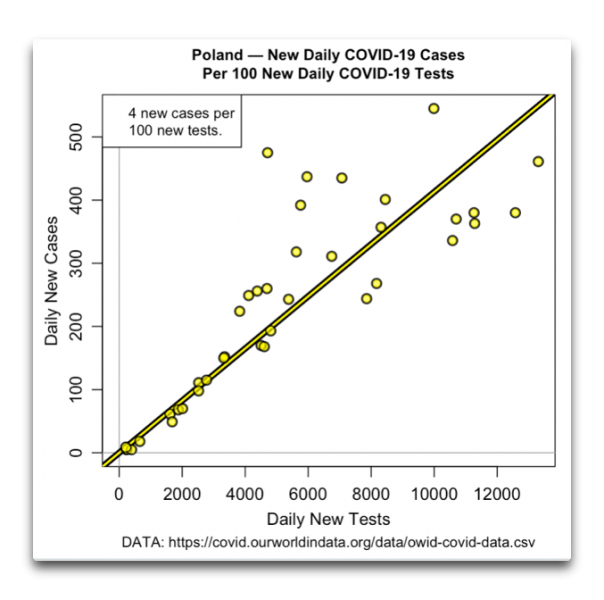

Abbildung 2. Streudiagramm, Australien – täglich neue Tests im Vergleich zu täglich neuen Fällen,. Die gelb / schwarze Linie ist ein linearer Trend.

Abbildung 2. Streudiagramm, Australien – täglich neue Tests im Vergleich zu täglich neuen Fällen,. Die gelb / schwarze Linie ist ein linearer Trend.