Livestream Übertragung der 13. IKEK in München

Live-Stream der 13. EIKE-Konferenz 2. Tag aus München:

<

Live-Stream der 13. EIKE-Konferenz 2. Tag aus München:

<

Abstract

In dieser Studie geht es um die Beziehungen zwischen der Temperatur an der Erdoberfläche von 1850 bis heute und den langfristigen Temperatur-Prophezeiungen globaler Erwärmung. Eine entscheidende Komponente dieser Analyse ist die Berechnung des Verlaufs der Erwärmung. Die Berechnung entfernt aus den aufgezeichneten Daten Fehler bei den Temperaturmessungen und -fluktuationen infolge kurzfristiger Wetterereignisse. Die Ergebnisse zeigen, dass die mittlere Erwärmungsrate an der Erdoberfläche über die letzten 170 Jahre weniger als 0,07°C pro Dekade beträgt. Die Erwärmungsrate an der Erdoberfläche korreliert nicht mit der Rate der Zunahme von CO2 durch Emissionen fossiler Treibstoffe. Die eingebildete Bedrohung exzessiver zukünftiger Temperaturen könnte aus der Falschinterpretation von 40 Jahren zunehmender Intensität des Klimatreibers ENSO im östlichen Pazifik resultieren. Die ENSO-Aktivität erreichte im Jahre 2016 mit der höchsten jemals aufgezeichneten Temperatur-Anomalie. Die Erwärmungsrate der Erdoberfläche ist seit dem Jahr 2006 um 41 Prozent gesunken.

Abschnitt 1 – Introduction

Die Ergebnisse dieser Studie zeigen, dass die gegenwärtige Bewegung zur Abschwächung der globalen Erwärmung voreilig sein kann. Sowohl die höchsten Wärmeströmungen, die jemals im östlichen Pazifik aufgezeichnet worden waren, als auch technologisch fortgeschrittene Verfahren zur Messung der Ozean-Temperaturen begannen zufällig beide Ende der 1970er Jahre. Diese Studie beschreibt, wie beides zusammen gespielt haben könnte, um zu langfristigen Temperatur-Prophezeiungen zu führen, die zu hoch sind.

Monatliche Temperatur-Anomalien von HadCRUT4

Für diese Analyse wurden sowohl die Version HadCRUT4.6.0.0 monatlicher globaler Zeitreihen von Temperatur-Anomalien herangezogen als auch der NASA-Datensatz des Goddard Institute for Space Studies der globalen mittleren jährliche Land- und Wassertemperatur-Anomalien von 1880 bis 2018. Die Ergebnisse gleichen sich im Wesentlichen. Danach wurde mit den HadCRUT4-Daten gearbeitet, weil die Zeitreihe länger ist und weil die monatlichen globalen Temperatur-Anomalien leichter nach Excel transferiert werden können.

Erst während der letzten Jahre haben hoch auflösende Satelliten gleichzeitig gemessene Daten vom Festland, dem Ozean und der Atmosphäre erfasst (Palmer, P.I. 2018). Die Satelliten NOAA-6 und NOAA-7 wurden im Dezember 1979 bzw. im Jahre 1981 gestartet. Beide waren mit speziellen Mikrowellen-Sensoren ausgestattet, um präzise Anomalien der Wassertemperatur im Gebiet des Ostpazifik und in den ENSO-Regionen zu messen (Spencer et al. 1990).

Die ersten Analysen der hoch aufgelösten Satellitendaten zeigten ein bemerkenswertes Ergebnis. Spencer et al. (1990) folgerten daraus: „Der Zeitraum der Analyse (1979 bis 1984) zeigt, dass die nord- und südhemisphärischen troposphärischen Temperatur-Anomalien (aus dem sechs-Jahre-Mittel) in längerzeitlichen Maßstäben positiv und über kürzere Zeiträume negativ korrelieren. Die ENSO von 1983 dominiert die Aufzeichnung, wobei die Anfang 1983 zonal gemittelten Temperaturen in den Tropen bis zu 0,6°C über dem Mittelwert der verbleibenden Jahre lagen. Diese natürlichen Variationen sind viel größer als man sie von verstärkten Treibhausgas-Anteilen erwartet, und daher ist es wahrscheinlich, dass eine deutlich längere Periode mit Satellitenmessungen sich akkumulieren muss, um Aufschluss über längerfristige Trends zu geben“.

Karl et al. (2015) behaupteten, dass die vergangenen 18 Jahre mit stabilen globalen Temperaturen dem Gebrauch von verzerrten Bojen-Daten in den Ozeanen geschuldet ist. Die Autoren schreiben, dass eine „Bias-Korrektur die Berechnung der mittleren Differenz zwischen gesammelten Bojen- und Schiffsmessungen involvierte. Die mittlere Differenz betrug global -0,12°C. Diese Korrektur wurde an die Bojen-Messwerte der Wassertemperatur in jedem Gitterquadrat in der ERSST-Version 4 angebracht“. Diese Analyse ist nicht konsistent mit der Interpretation des nunmehr 18-jährigen Stillstandes bzgl. globaler Erwärmung. Die hier folgende Diskussion des ersten Derivativs einer Trendlinie der Temperatur-Anomalie zeigt die Rate der Erwärmung relativ stabil und nahezu frei von Rauschen, die im Jahre 2006 ihren Höhepunkt erreichte und seitdem eine Abnahme des Anstiegs bis heute.

[Es folgen zwei Absätze mit längeren Ausführungen zu den einzelnen Temperatur-Auswertungen, die hier übersprungen werden.]

…

Analyse von Temperatur-Anomalien

Alle in dieser Studie herangezogenen Temperaturmessungen sind berechnete Temperatur-Anomalien und keine absoluten Temperaturen. Eine Temperatur-Anomalie ist hier die Differenz der gemessenen absoluten Temperatur zu einer zugrunde liegenden Mitteltemperatur – in diesem Falle die mittlere jährliche Temperatur von 1961 bis 1990. Mit diesem Konversionsverfahren sollen die Auswirkungen auf Temperaturen relativ zur Umgebung der Messstation minimiert werden (d. h. Tallagen oder Bergspitzen). Damit sollen regionale Temperaturtrends besser erkannt werden.

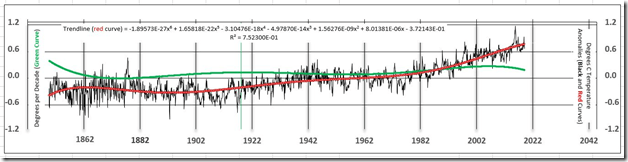

In Abbildung 1 stellt die schwarze Kurve die monatliche mittlere Temperatur-Anomalie an der Erdoberfläche dar. Der gezackte Verlauf der schwarzen Temperatur-Anomalie-Kurve ist dem Rauschen in den Daten geschuldet (Ungenauigkeiten der Messungen und zufällige kurzzeitige Wetterereignisse). Die rote Kurve repräsentiert eine Excel sixth-degree polynomial best fit-Trendlinie der Temperatur-Anomalien. Bei diesem Verfahren wird das hochfrequente Rauschen entfernt. Die grüne Kurve, aus der Trendlinie abgeleitet, ist die wichtigste Kurve, die aus den globalen mittleren Temperatur-Anomalien abgeleitet worden ist. Die Kurve ist eine Zeitreihe der Differenzen von Monat zu Monat der mittleren Temperatur mit der Einheit Änderung in Grad Celsius pro Monat. Diese sehr kleinen Zahlen sind mit 120 multipliziert worden, um die Einheiten in Grad pro Dekade umzurechnen (linke vertikale Achse der Graphik). Grad pro Dekade ist eine Maßzahl der Rate, mit welcher die Temperatur auf der Erde steigt oder sinkt. Manchmal wird das auch als die Kurve der Erwärmung (oder Abkühlung) der Erdoberfläche angesehen. Die Temperaturwerte der grünen Kurve sind hinsichtlich der Größenordnung ähnlich der Größenordnung der rauschbefreiten Temperaturschätzungen seitens der University of Alabama in Huntsville UAH (Christy, J. R., 8. Mai 2019). Die grüne Kurve wurde zuvor nicht bekannt gemacht und ist entscheidend für die Analyse langzeitlicher Temperaturtrends.

Abbildung 1: Die schwarze Kurve repräsentiert die HadCRUT4-Zeitreihe der mittleren monatlichen globalen Anomalien der Land- und Wassertemperaturen (1850 bis zur Gegenwart). Anomalien sind Abweichungen der monatlichen mittleren Temperaturen vom Mittel der Jahre 1961 bis 1990 in Grad Celsius. Die rote Kurve ist die Trendlinie im HadCRUT4-Datensatz, ein Excel sixth-degree polynomial best fit der Temperatur-Anomalie. Die grüne Kurve ist die erste Ableitung der Trendlinie, welche sich aus der Konversion der Einheit Grad pro Monat zu Grad C pro Dekade ergibt, das heißt, es ist die Steigung der Trendlinien-Kurve.

Eine Erwärmung um 0,038°C pro Dekade müsste signifikant zu- oder abnehmen, um für eine Prognose einer langfristigen Änderung der Erdtemperatur zu taugen. Falls die Temperatur an der Erdoberfläche kontinuierlich von heute an mit einer Rate von 0,038°C pro Dekade steigen würde, gäbe es in 100 Jahren einen Anstieg von nur 0,4°C, was nicht gerade eine Bedrohung für die Menschheit darstellt.

Die Schätzung der 0,038°C pro Dekade liegt wahrscheinlich jenseits der Genauigkeit von Temperaturmessungen von 1850 bis 1979. Jüngsten statistischen Analysen zufolge bewegt sich die 95%-Bandbreite der Unsicherheit der globalen mittleren Temperatur während der letzten 140 Jahre zwischen 0,05°C bis 0,15°C. Das heißt, dass 95 von 100 Messungen innerhalb der Bandbreite der Unsicherheits-Schätzungen liegen (Lenssen, N. J. L., et al. 2019). Von 1850 bis 1979 war es nur zu einer sehr geringen Erwärmung gekommen.

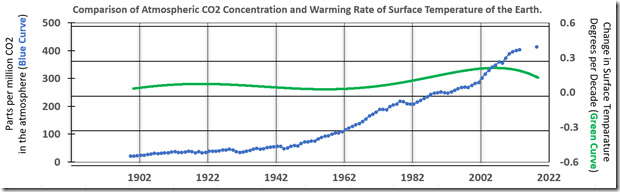

In Abbildung 2 zeigt die grüne Kurve die Erwärmungskurve, das heißt eine Zeitreihe der Änderungsrate der Temperatur auf der Erde in Grad Celsius pro Dekade. Die blaue Kurve ist eine Zeitreihe der CO2-Konzentration in ppm in der Atmosphäre. Die grüne Kurve verläuft von 1900 bis 1979 in etwa glatt und steigt dann leicht infolge des niederfrequenteren Rauschens, welches in den Temperatur-Anomalien von 40 Jahren El Nino-Aktivität verbleibt. Die Erwärmungskurve ist seit dem Jahr 2000 bis heute leicht rückläufig. Die CO2-Konzentration nahm von 1943 bis 2019 stetig zu. Es gibt keine Korrelation zwischen einer steigenden CO2-Konzentration in der Atmosphäre und einer relativ stabilen, geringen Erwärmungsrate an der Erdoberfläche von 1943 bis 2019:

Abbildung 2: Die grüne Kurve ist das erste Derivativ der Trendlinie, übertragen in die Einheit Grad Celsius pro Dekade. Es ist also die Rate der Temperaturänderung an der Erdoberfläche. Siehe Abbildung 1 mit der gleichen Kurve zusammen mit dem Verlauf der Temperatur-Anomalien und der Trendlinie. Die blau gepunktete Kurve zeigt die Gesamt-CO2-Emissionen durch fossile Treibstoffe in der Atmosphäre. Der Zeitrahmen zeigt lediglich Emissionen ab dem Jahr 1900, und die insgesamt erfassten Millionen Tonnen Kohlenstoff sind konvertiert zu ppm CO2 für die Graphik. Der einzelne blaue Punkt ist dem jüngsten NOAA-Report entnommen und repräsentiert den Wert von 414,7 ppm CO2 im Mai 2019. Es gibt keine Korrelation zwischen den beiden Kurven.

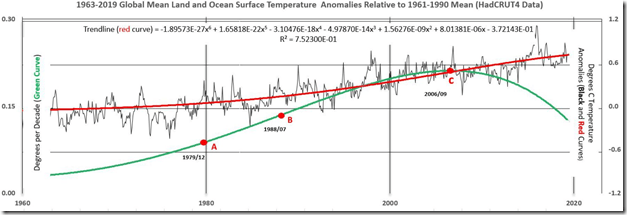

In Abbildung 3 ist die Temperaturspitze vom Dezember 1979 (Punkt A) verbunden mit einem schwachen El Nino-Ereignis. Während der folgenden 39 Jahre war es zu fünf sehr starken derartigen Ereignissen gekommen, wobei das letzte davon 2015-16 die höchste, jemals aufgezeichnete El Nino-Intensität aufwies. Die höchste monatliche globale Temperatur-Anomalie jemals war mit 1,111°C im Februar 2016 aufgetreten. Seitdem zeigten die monatlichen globalen Temperatur-Anomalien einen Rückgang um 35 Prozent auf 0,724°C im August 2019, nachdem der El Nino sich in seiner Intensität abgeschwächt hatte.

Abbildung 3: Ein vergrößerter Ausschnitt aus Abbildung 1 von 1963 bis 2019 mit modifizierten vertikalen Skalen, um bedeutende Änderungen des Verlaufs der grünen Kurve hervorzuheben.

Die Punkte A, B und C markieren sehr signifikante Änderungen des Verlaufs der grünen Erwärmungskurve (Werte auf der linken vertikalen Achse).

1. Die Werte der grünen Kurve nahmen in jedem Monat von 0,085°C pro Dekade im Dezember 1979 (Punkt A) auf 0,136°C im Juli 1988 zu (Punkt B). Das ist eine Zunahme der Erwärmungsrate um 60% innerhalb von fast 9 Jahren. Die Erwärmungkurve ist aufwärts konkav. Punkt A markiert einen schwachen El Nino und den Beginn zunehmender ENSO-Intensität.

2. Von Juli 1988 bis September 2006 nahm die Erwärmungsrate zu von 0,136°C pro Dekade auf 0,211°C pro Dekade (Punkt C). Das ist eine Zunahme um 55% innerhalb von 18 Jahren, aber nur etwa die Hälfte der Rate insgesamt der 9 Jahre zuvor infolge einer Abnahme der Zunahme-Rate jeden Monat. Der Punkt Juli 1988 auf der X-Achse ist ein Wendepunkt, an welchem die Erwärmungkurve abwärts konkav verläuft.

3. Punkt C (September 2006) markiert ein sehr starkes El Nino-Ereignis und den Spitzenwert des fast 40 Jahre langen vorübergehenden ENSO-Erwärmungstrends, was der grünen Kurve das Aussehen eines stilisierten S verleiht. Die Erwärmungsrate hat jeden Monat abgenommen seit dem Spitzenwert von 0,211°C im September 2006 auf 0,125°C im August 2019, das ist eine Abnahme um 41 Prozent innerhalb von 13 Jahren.

Abschnitt 2: Wahrheit und Konsequenzen

Die „Hockeyschläger-Graphik“, welche von den Medien häufig als Beleg für eine außer Kontrolle geratene globale Erwärmung während der letzten 20 Jahre herangezogen worden ist, wird durch die gegenwärtigen Temperaturaufzeichnungen nicht gestützt. Die Graphik taucht in den Printmedien auch nicht mehr auf.

Keines der 102 Klimamodelle der Mitteltemperatur der mittleren Troposphäre zeigt in ausreichender Art und Weise eine Prognose zukünftiger Temperaturen, welche zu Änderungen der Umweltpolitik Anlass geben. Die Modelle beginnen in den 1970er Jahren, also zu Beginn eines Zeitraumes, in welchem die stärkste ENSO jemals kulminierten, und bis zum Jahr 2015 liegt die mittlere prognostizierte Temperatur aller Modelle fast 2,4 mal höher als die gemessene troposphärische Temperatur-Anomalie im Jahre 2015 (Christy, J. R. May 8, 2019). Die wahre Geschichte der globalen Klimaänderung muss erst noch geschrieben werden.

Die höchste Erwärmung während der ENSO war im September 2006 mit 0,211°C pro Dekade aufgetreten. Die höchste jemals gemessene mittlere globale Temperatur betrug 1,111°C im Februar 2016. Diese Fälle sind möglicherweise verbunden mit einer Zunahme von Qualität und Messdichte von Ozean-Temperaturen der beiden zuvor erwähnten erdumlaufenden MSU-Satelliten. Frühere ENSO-Ereignisse hoher Intensität könnten wegen des Fehlens fortschrittlicher Satellitenbeobachtungen über den Ozeanen nicht erfasst worden sein.

Der Gebauch einer Temperatur-Trendlinie zur Entfernung hochfrequenten Rauschens eliminiert nicht die vorübergehenden Auswirkungen von Komponenten der ENSO-Erwärmung mit längeren Wellenlängen während der letzten 40 Jahre. Daher wird bei den Schätzungen der Ewärmungsrate jenes Zeitraumes in dieser Studie immer noch Hintergrund-Rauschen des ENSO vorhanden sein. A noise-free signal for the past 40 years probably lies closer to 0.038 degrees C per decade, the average rate of warming from 1850 to the beginning of the ENSO in 1979 than the average rate from 1979 to the present, 0.168 C degrees per decade.* Die höhere Zahl enthält unkorrigierte Residual-ENSO-Effekte.

[*Für diesen Ausschnitt aus dem Original habe ich keine vernünftige Übersetzung zustande bekommen. Anm. d. Übers.]

Foster und Rahmstorf (2011) zogen mittlere jährliche Temperaturen aus fünf Datensätzen heran, um die mittlere Erderwärmung von 1979 bis 2010 abzuschätzen. Das aus dem Rohmaterial entfernte Rauschen wird ENSO-Aktivitäten, Vulkanausbrüchen und solaren Variationen zugeordnet. Vom Ergebnis heißt es, dass es ein Rauschen-adjustierter Verlauf der Temperatur-Anomalie ist. Die mittlere Erwärmung der fünf Datensätze über 32 Jahre beläuft sich auf 0,16°C pro Dekade im Vergleich zu den 0,17°C pro Dekade in dieser Studie aus 384 monatlichen Punkten, abgeleitet aus dem Derivativ der Temperatur-Trendlinie. Foster und Rahmstorf (2011) nehmen an, dass der Erwärmungstrend linear ist auf der Grundlage nur einer mittleren Schätzung, und ihre Daten überdecken auch nur 32 Jahre. Dreißig Jahre wird allgemein als der minimale Zeitraum angesehen, um einen Punkt in einem Trend zu definieren. Dieser Zeitraum von 32 Jahren enthält die höchste beobachtete ENSO-Aktivität jemals und ist nicht lang genug, um einen Trend zu definieren. Die Erwärmungskurve in dieser Studie über fast 170 Jahre ist gekrümmt (grüne Kurven in den Abbildungen 1 und 3). Sie wird definiert durch 2032 monatliche Punkte, abgeleitet aus dem Derivativ der Temperatur-Trendlinie. Von 1979 bis 2010 variiert die Erwärmung zwischen 0,08°C und 0,20°C pro Dekade. Der Erwärmungstrend ist nicht linear.

Die vermeintliche Bedrohung durch exzessive zukünftige Temperaturen kann einer Unterschätzung der ungewöhnlich großen Auswirkungen der jüngsten ENSO auf natürliche globale Temperaturanstiege geschuldet sein. Fast 40 Jahre einer natürlichen, vorübergehenden Erwärmung durch den höchsten jemals beobachteten ENSO könnte fehlinterpretiert worden sein dahingehend, dass eine Erwärmung aufgrund anthropogener Aktivitäten angenommen wurde. Es gibt keinerlei Beweise für einen signifikanten anthropogenen Beitrag zu den gemessenen Temperaturen während der letzten 40 Jahre.

Caltech verkündete jüngst den Beginn eines 5-Jahre-Projektes zusammen mit vielen anderen Forschungszentren zur Entwicklung eines neuen Klimamodells „von der Grundlinie an“ (Perkins 2018). Während dieser fünf Jahre sollte sich das Verständnis der Welt bzgl. der Ursachen von Klimawandel erheblich verbessern.

Das wissenschaftliche Zielt muss es sein, die Bandbreite der Unsicherheit von Prognosen mittels besserer Daten und besseren Modellen immer mehr einzuengen, bis eine menschliche Intervention sinnvoll erscheint. Wir haben Zeit, das hinzubekommen. Ein rationales Umweltschutz-Programm und eine dynamische Ökonomie können koexistieren. Die Herausforderung besteht darin, den Wissenschaftlern die Zeit und die Freiheit zu gewähren, ohne Einmischung von Interessengruppen zu arbeiten.

[Hervorhebung vom Übersetzer]

Acknowledgments and Data

All the raw data used in this study can be downloaded from the HadCRUT4 and NOAA websites. http://www.metoffice.gov.uk/hadobs/hadcrut4/data/current/series_format.html

References

1. Boden, T.A., Marland, G., and Andres, R.J. (2017). National CO2 Emissions from Fossil-Fuel Burning, Cement Manufacture, and Gas Flaring: 1751-2014, Carbon Dioxide Information Analysis Center, Oak Ridge National Laboratory, U.S. Department of Energy, doi:10.3334/CDIAC/00001_V2017.

2. Christy, J. R., May 8, 2019. The Tropical Skies Falsifying Climate Alarm. Press Release, Global Warming Policy Foundation. https://www.thegwpf.org/content/uploads/2019/05/JohnChristy-Parliament.pdf

3. Foster, G. and Rahmstorf, S., 2011. Environ. Res. Lett. 6 044022

4. Golden Gate Weather Services, Apr-May-Jun 2019. El Niño and La Niña Years and Intensities. https://ggweather.com/enso/oni.htm

5. HadCrut4 dataset. http://www.metoffice.gov.uk/hadobs/hadcrut4/data/current/series_format.html

6. Karl, T. R., Arguez, A., Huang, B., Lawrimore, J. H., McMahon, J. R., Menne, M. J., et al.

Science 26 June 2015. Vol. 348 no. 6242 pp. 1469-1472. http://www.sciencemag.org/content/348/6242/1469.full

7. Mann, M., Bradley, R. and Hughes, M. (1998). Global-scale temperature patterns and climate forcing over the past six centuries. Nature, Volume 392, Issue 6678, pp. 779-787.

8. Mckitrick, R. Department of Economics, University of Guelph. http://www.rossmckitrick.com/uploads/4/8/0/8/4808045/mckitrick_comms_on_karl2015_r1.pdf, A First Look at ‘Possible artifacts of data biases in the recent global surface warming hiatus’ by Karl et al., Science 4 June 2015

9. Mears, C. and Wentz, F. (2016). Sensitivity of satellite-derived tropospheric

temperature trends to the diurnal cycle adjustment. J. Climate. doi:10.1175/JCLID-

15-0744.1. http://journals.ametsoc.org/doi/abs/10.1175/JCLI-D-15-0744.1?af=R

10. Morice, C. P., Kennedy, J. J., Rayner, N. A., Jones, P. D., (2012). Quantifying uncertainties in global and regional temperature change using an ensemble of observational estimates: The HadCRUT4 dataset. Journal of Geophysical Research, 117, D08101, doi:10.1029/2011JD017187.

11. Lenssen, N. J. L., Schmidt, G. A., Hansen, J. E., Menne, M. J., Persin, A., Ruedy, R, et al. (2019). Improvements in the GISTEMP Uncertainty Model. Journal of Geophysical Research: Atmospheres, 124, 6307–6326. https://doi.org/10. 1029/2018JD029522

12. NOAA Research News: https://research.noaa.gov/article/ArtMID/587/ArticleID/2461/Carbon-dioxide-levels-hit-record-peak-in-May June 4, 2019.

13. Palmer, P. I. (2018). The role of satellite observations in understanding the impact of El Nino on the carbon cycle: current capabilities and future opportunities. Phil. Trans. R. Soc. B 373: 20170407. https://royalsocietypublishing.org/doi/10.1098/rstb.2017.0407.

14. Perkins, R. (2018). https://www.caltech.edu/about/news/new-climate-model-be-built-ground-84636

15. Spencer, R. W., Christy, J. R. and Grody, N. C. (1990). Global Atmospheric Temperature Monitoring with Satellite Microwave Measurements: Method and Results 1979–84. Journal of Climate, Vol. 3, No. 10 (October) pp. 1111-1128. Published by American Meteorological Society.

——————

Übersetzt von Chris Frey EIKE

Der übliche Dummspruch der Investoren

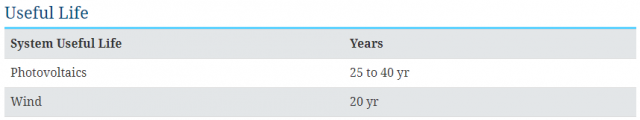

Mit einer wirtschaftlichen Lebensdauer von oft nur 10-12 Jahren (anstatt der von Herstellern und Befürwortern propagierten 25 Jahre für die wirtschaftliche Nutzung ) werden in den nächsten zehn Jahren in Ländern wie Deutschland Hunderttausende Tonnen „Problemmüll“ zurückbleiben, die die Landschaft verschandeln. Mit Hunderten von WKAs, die völlig kaputt sind, sind die Deutschen bereits von der harten und giftigen Realität der sogenannten „grünen“ Besessenheit ihrer Regierung getroffen worden.

Und sie sind damit nicht die einzigen.

Die Windindustrie in Iowa hat kaum ein Jahrzehnt überdauert und die alten Windkraftanlagen liefern bereits Tausende Tonnen Sondermüll auf Deponien .

Zusätzlich zu 10-15 Tonnen Kunststoff- und Glasfaserflügeln befinden sich im Turm und in der Gondel eine Ansammlung ungesunder Kunststoffe, Öle, Schmiermittel, Metalle und noch mehr Glasfasern. Im Fundament ein 400-500 m³ großes Stück Stahlbeton.

Wie Isaac Orr weiter unten ausführlich ausführt, hat die Verschrottung der umweltzerstörenden, schmutzigen und oft auch giftiger sogenannte „sauberer Energieerzeugung“ einen atemberaubenden Preis.

Die Beseitigung einer einzelnen Windkraftanlage rechnet sich auf über 500.000 USD

Center of the American Experiment

Isaac Orr; 3. Oktober 2019

Es sieht so aus, als ob in Minnesota ein sehr teures Durcheinander zu beseitigen ist, wenn die derzeit im Bundesstaat betriebenen Windkraftanlagen das Ende ihrer auf 20 Jahre angesetzten Nutzungsdauer erreichen.

Laut den von Xcel Energy für den Nobles Wind-Park eingereichten Unterlagen wird für die Stilllegung pro WKA etwa 445.000 US-Dollar angesetzt, in Preisen für 2009. Auf das Jahr 2019 hochgerechnet, bedeutet das inzwischen rund 532.000 USD für jede der 134 in Betrieb befindlichen Windkraftanlagen. Damit ergeben sich die Gesamtkosten für die Stilllegung des Nobles-Projekts auf USD 71 Millionen. Xcel gab jedoch auch an, dass diese Schätzungen konservativ waren, was hoffen lässt, dass dies die High-End-Kosten für die Stilllegung darstellt.

Auch bei anderen Windenergieanlagen fallen sechsstellige Stilllegungskosten an. Den Unterlagen für die Windparkanlagen Palmer’s Creek in Chippewa County, Minnesota, zufolge würde die Stilllegung der 18 an diesem Standort betriebenen Windturbinen 7.385.822 USD kosten, was 410.000 USD pro WKA entspricht.

Man würde meinen, eine solche Summe würde zu einem gründlichen Rückbau führen, aber man kann sich irren.

Laut dem Nobles Wind-Dokument umfassen „die Restaurierungsarbeiten die Entfernung sämtlicher mit dem Projekt in Zusammenhang stehender Materialien und Ausrüstungsgegenstände bis zu einer Tiefe von 48 Zoll [~ 1,22 m]und sind nicht auf diese beschränkt.“

Dies bedeutet, dass Xcel die Baustelle nur bis zu einer Tiefe von vier Fuß [~ 1,2 m]saniert und die meisten massiven Betonfundamente, die bis zu 15 Fuß [~4,5m] tief sind und zur Verankerung der Windanlagentürme verwendet werden, auf unbestimmte Zeit im Boden verbleiben.

Die Website Renewable Technology gibt an, dass Nobles Wind ein umfangreiches unterirdisches Kabelsystem nutzt , das in einer Tiefe von vier Fuß verlegt ist und die Generatoren mit einem zentralen Umspannwerk verbindet. Die Dokumente von Xcel waren nicht spezifisch genug, um zu bestimmen, ob diese Kabel entfernt werden, aber das Windparkprojekt von Palmer gibt ausdrücklich an, dass Kabel, die tiefer als 4 Fuß sind, nicht entfernt werden:

Windenergieanlagen und Sonnenkollektoren erhalten häufig eine Ausnahmegenehmigung, obwohl sie erhebliche Umweltschäden verursachen können. Im Gegensatz dazu, haben liberale Politiker und Interessengruppen den Ersatz einer alternden Ölpipeline durch einen neueren und sichereren Ersatz weiterhin verzögert.

Diese Doppelmoral ist ein Nachteil für die Minnesotaner, die mehr für ihre Energie und auch für die Umwelt zahlen müssen.

Übersetzt durch Andreas Demmig

Filthy Future: The Staggering Cost of Cleaning Up ‘Clean’ Energy’s Toxic Mess

Zum Thema

Teure Hinterlassenschaften – Die Rückbaukosten von Windrädern

Als Naturwissenschaftler, der sich gern in sein Studierstübchen zurückzieht, ist man doch sehr überrascht, plötzlich im Mittelpunkt zu stehen und als Übeltäter, Unbelehrbarer, Rechter oder sogar Nazi beschimpft zu werden.

Die Sprachlosigkeit der öffentlich rechtlichen Medien, das Verständnis der obersten Staatsführung und der meisten Parteien für Schulschwänzen und Blockaden des öffentlichen Raumes provozieren mich zur Frage „Ist die Freiheit der Forschung in Deutschland noch gegeben?

Journalisten, Aktivisten, Wikipedia und sogar Politiker gehen locker mit Begriffen um, die an dunkle Zeiten deutscher Geschichte erinnern. An diesen Personenkreis und ihren Jüngern auf den Straßen möchte ich mich wenden. Es geht mir um den Begriff „Klima-Leugner“.

Dieser Begriff überschreitet eine rote Linie. Ihr wollt Antifaschisten sein, aber warum benutzt Ihr eine Formulierung, die auch aus der Nazizeit stammen könnte?

Ich denke es ist Zeit, dass ich mich hier als Wissenschaftler zu Wort melde und einmal beschreibe wie der Wissenschafts-Betrieb funktioniert. Doch zunächst: Warum ist „Klima-Leugner“ eine Diffamierung/Verleugnung, eine herabsetzende Bezeichnung anders denkender Wissenschaftler!

Was zeichnet einen Leugner aus:

„Der Leugner erklärt etwas Offenkundiges wider besseres Wissen für unwahr oder nicht vorhanden.“

Um diesen Tatbestand zu erfüllen, müssen zwei Bedingungen zutreffen: Der Betreffende ist ein Lügner (wider besseren Wissen) und der anthropogen bedingte Klimawandel ist eine Tatsache (Offenkundiges)!

Ist der anthropogen bedingte Klimawandel eine Tatsache? Nein, es ist nur eine naturwissenschaftliche These und kein mathematisches Gesetz.

Aus der Korrelation von Ereignissen können Wissenschaftler Hypothesen aufstellen, die bei der mehrfachen Wiederholung durch andere Wissenschaftler zu einer bestätigten These werden können.

In dieser Phase befinden wir uns gerade. Es spielt keine Rolle wie viele Zustimmungen und wie viele Ablehnungen es gibt, bei der Wissenschaft geht es immer, oder sollte es zumindest, um Wahrheit und nicht um Demokratie.

Schon allein das Argument einer 97-99%igen Zustimmung zum Klimawandel zeigt Euren deutlichen Wunsch nach einer Diktatur. Gab es in der DDR nicht immer Wahlergebnisse von 99,X %? Wollt ihr eine Gleichschaltung der Wissenschaft mit 100%iger Zustimmung?

Fakt, es gibt Zustimmung zur These „Der menschengemachten globalen Erwärmung“. Es gibt (erhebliche) Forschungsgelder für etablierte Klima-Institute und gemeinnützige Vereine, als selbsternannte Retter der Welt (großzügig mit Steuergeldern ausgestattet). Das reicht völlig aus für den letzten Schritt.

(Nur am Rande, Klima-Skeptiker müssen sich aus eigene Tasche oder durch Spenden finanzieren und müssen um ihre Anstellung bangen, wenn Sie noch in Lohn und Brot sind.)

Ob aus dieser These ein naturwissenschaftliches „Gesetz“ wird, entscheidet nun ein Praxis-Test über einen sehr langen Zeitraum.

Und hier liegt die Krux in der Klimatologie. Wir sprechen hier von sehr langen Zeiträumen. Vielleicht wird erst in 100 oder 200 Jahren endgültig entschieden sein, wer hier Recht hatte. Und auch das angeblich 30-jährige Kriterium als Abtrennung des Klimas gegenüber dem Wetter verdient einer Klarstellung. Bei Warmzeiten von 10.000 und Kaltzeiten von 100.000 Jahren sind 30 Jahre nur eine Sekunde in der Zeitskala der Klimatologen. Ich bin kein Prophet, aber es kann noch viele Jahre dauern, bis hier eine Klärung eintritt.

Selbst allgemein anerkannte naturwissenschaftliche „Gesetze“ sind nicht in Stein gemeißelt und es gibt keine Garantie für die Ewigkeit. Es reicht ein einziger Wissenschaftler, der alles einreißen kann, bemerkte einst Albert Einstein. Und er musste das doch wissen, stand er Anfang des 20. Jahrhunderts mit seiner allgemeinen Relativitätstheorie noch sehr einsam in der Welt der Physik.

Ich könnte noch viele andere Thesen aufführen, wie die „Vitalismus-Theorie (vis vitalis)“ in der Chemie oder die „Lorentzsche Äthertheorie“ in der Physik, die sang und klanglos untergingen. Oder, wie viele Jahrhunderte mussten Schüler das geozentrische Weltbild als allgemein anerkanntes „Gesetz“ pauken? Waren Johannes Kepler und Galileo Galilei auch Leugner, also Lügner?

Warum also die Verleugnung, Diskriminierung und die offensichtliche Angst vor Klima-Skeptikern? Der Zug zur Energiewende ist in der Bundesrepublik Deutschland doch längst abgefahren. Die wenigen, größtenteils in die Jahre gekommenen Klima-Skeptiker werden ihn nicht aufhalten können. Es ist zu befürchten, dass alles so kommt wie in deutscher Geschichte zuvor. Erst wenn alles in Scherben liegt, werden die „Aktivisten“ von einst begreifen, dass sie den falschen Propheten gefolgt sind, und natürlich ist dann immer nur der andere schuld.

An der Sprache erkennt man die Diktatur. Habt Ihr nichts aus Victor Klemperers Buch „LTI“ zur Sprache des Dritten Reiches gelernt? Wieso kann die Grünen-Chefin, Annalena Baerbock, fordern, dass „Klima-Leugner“ aus den Medien zu verbannen sind, ohne Euren Aufschrei?

Der Flyer der „Klima-Aktivisten“ zeigt „EIKE“ in Flammen. Nur die EIKE-Seite? Eine Wiederholung der Bücherverbrennung? Oder sogar die Klima-Skeptiker selbst?

Die Antifa-Demonstranten fordern ganz offen die „Planwirtschaft“. Habt Ihr denn gar nichts aus der Geschichte gelernt? Glaubt Ihr wirklich eine grüne DDR.2 ist eine bessere Welt und was ist mit Bündnis 90 innerhalb der Grünen? Schon vergessen? Tristesse, Spitzel, Stasi und eine allwissende und allmächtige Partei. Die Partei, die Partei hat immer Recht! Ist es das, was Ihr wollt?